Ollama模型的配置选择

摘要: Ollama本地AI模型存在多个版本且磁盘占用差异显著(几GB到几十GB),主要原因包括模型架构演变、参数规模差异、量化精度格式(如FP16到INT2可缩小6倍体积)及微调变体。量化技术通过降低权重位数实现压缩,4位量化(Q4_K_M)在性能与体积间达到最佳平衡。选择模型需结合硬件条件(如内存大小)和任务需求(编程/写作/研究),并通过Ollama命令管理存储。合理选择量化版本(如8B模型

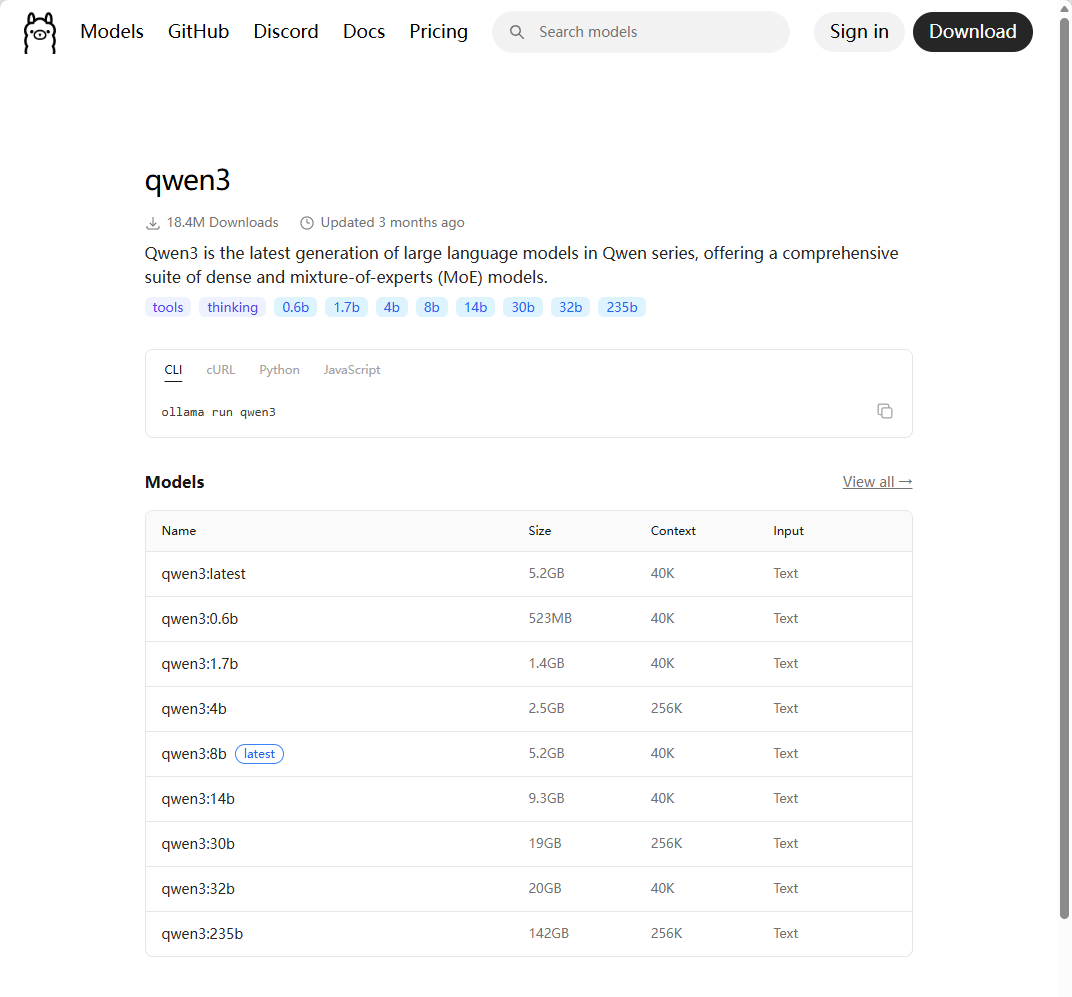

如果你最近使用过Ollama来运行本地AI模型,可能会被一个现象困扰:同一个模型竟然有那么多不同版本,而且它们的磁盘占用差异大得惊人——从几GB到几十GB不等。这就像走进一家冰淇淋店,发现“香草味”就有50种不同的配方,从迷你杯到家庭装应有尽有。

今天,我们将深入探讨这个现象背后的技术原因,帮助你做出更明智的模型选择。

一、为什么模型版本如此之多?

1.1 模型架构的演变

想象一下,AI模型就像汽车。同一品牌(如Llama)有不同代(Llama2、Llama3),每代又有不同型号(7B、13B、70B参数)。Ollama上的版本多样性主要源于:

- 参数规模差异:70亿参数 vs. 700亿参数,计算需求完全不同

- 精度格式差异:这是造成大小差异的最大因素(我们稍后详细探讨)

- 微调变体:基础模型、指令调优版、代码专用版、聊天优化版等

- 量化级别:同一模型的不同“压缩”程度

1.2 精度格式的“魔术”

精度格式是影响模型大小的关键因素。让我们看一个直观的例子:

Llama3 8B模型的不同格式:

llama3:8b-fp16:全精度,约16GBllama3:8b-q8_0:8位量化,约8.5GBllama3:8b-q4_0:4位量化,约4.5GBllama3:8b-q2_K:2位量化,约2.5GB

同样的“智力水平”,大小差异超过6倍!这就像同一本百科全书的不同印刷版本:精装本、平装本和袖珍本。

二、磁盘占用差异的因素

2.1 精度位数:从FP32到INT2

精度位数决定了每个参数占用多少存储空间:

| 精度格式 | 每参数位数 | 相对大小 | 质量保留 | 典型用途 |

|---|---|---|---|---|

| FP32 (全精度) | 32位 | 100% | 100% | 研究、训练 |

| FP16/BF16 | 16位 | 50% | ~99.9% | 高质量推理 |

| Q8_0 (8位) | 8位 | 25% | ~99% | 平衡性能 |

| Q4_K_M (4位) | 4位 | 12.5% | ~95% | 日常使用 |

| Q2_K (2位) | 2位 | 6.25% | ~85% | 极度受限环境 |

技术解释:量化通过减少表示每个权重所需的位数来压缩模型。例如,将权重从可能值(0.000…1.000)的连续范围映射到离散的16或256个值。

2.2 参数数量:模型的“大脑容量”

参数数量是模型复杂度的直接指标:

Llama3:8b → 80亿参数 → 约4-16GB (取决于量化)

Llama3:70b → 700亿参数 → 约35-140GB (取决于量化)

70B模型不仅是8B模型的8.75倍参数,而且由于注意力机制复杂度增加,实际计算和存储需求增长更快。

2.3 词汇表大小:模型的“词典”

更大的词汇表意味着更多嵌入向量,直接影响模型大小:

- 小型模型词汇表:约32,000词元

- 大型模型词汇表:可达200,000+词元

词汇表每增加一倍,可能增加数百MB的存储需求。

2.4 上下文长度:模型的“记忆跨度”

长上下文模型需要存储更多KV(键值)缓存:

- 4K上下文 vs. 128K上下文

- 长上下文版本可能需要额外10-30%的存储空间

三、量化

3.1 量化如何工作?

量化不是简单的“四舍五入”。现代量化技术包括:

- 权重分组量化:将权重分组,每组使用独立的缩放因子

- 混合精度量化:对敏感层保持较高精度(如注意力输出层)

- 激活校准:基于典型输入动态调整量化参数

3.2 不同量化方法的比较

以Llama3 8B为例:

模型版本 磁盘占用 推理速度 质量评分

llama3:8b-fp16 15.8 GB 慢 10/10

llama3:8b-q8_0 8.5 GB 中等 9.8/10

llama3:8b-q4_K_M 4.5 GB 快 9.5/10

llama3:8b-q3_K_M 3.5 GB 很快 9.0/10

llama3:8b-q2_K 2.5 GB 极快 8.0/10

有趣的事实:Q4_K_M通常被认为是“甜点”选择,在质量和大小间取得最佳平衡。

四、如何选择?

4.1 根据硬件选择

内存受限环境(<8GB RAM):

- 推荐:2-4位量化的7B模型

- 示例:

llama3:8b-q4_K_M(4.5GB)

中端系统(16-32GB RAM):

- 推荐:4位量化的13B-34B模型

- 示例:

mixtral:8x7b-q4_0(26GB)

高性能系统(>32GB RAM):

- 推荐:高精度大模型

- 示例:

llama3:70b-q4_K_M(39GB)

4.2 根据用途选择

- 编程助手:CodeLlama系列,量化不低于Q4

- 创意写作:需要较高精度,建议Q6或更高

- 研究实验:全精度模型,确保结果准确性

- 实时对话:轻量化模型,优先推理速度

4.3 实用检查清单

选择模型前问自己:

- 我的可用磁盘空间是多少?

- 我的系统RAM有多少?(模型通常需要略大于磁盘占用的RAM)

- 我主要用模型做什么任务?

- 我对响应速度的要求有多高?

- 我是否需要最新模型,还是稳定版本即可?

五、管理模型

5.1 Ollama命令小贴士

# 查看已安装模型

ollama list

# 显示模型详细信息

ollama show llama3:8b

# 删除不需要的模型

ollama rm llama3:8b-fp16

# 只保留标签,不删除模型数据

ollama cp llama3:8b my-llama3-copy

5.2 存储优化策略

- 使用符号链接:将模型库指向大容量驱动器

- 定期清理:删除不常用的高精度版本

- 分层存储:常用模型放SSD,归档模型放HDD

- 共享模型目录:在多用户系统中共享基础模型

希望这篇博客帮助你理解了Ollama模型宇宙的复杂性。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)