收藏必备|AI Agent两大核心范式详解(ReAct+Ralph Loop),小白程序员必看大模型学习指南

本文全面拆解AI Agent两大核心范式——ReAct经典的“思考-行动-观察”闭环与Ralph Loop颠覆性的“无限自主迭代”新模式,帮小白程序员快速吃透大模型Agent的核心逻辑。ReAct擅长短任务与动态规划,却受限于上下文爆炸、过早停止等痛点;而Ralph Loop凭借强制持续迭代的“暴力美学”,完美破解长任务、复杂编程场景的核心难题,实现真正的自主纠错闭环。

本文全面拆解AI Agent两大核心范式——ReAct经典的“思考-行动-观察”闭环与Ralph Loop颠覆性的“无限自主迭代”新模式,帮小白程序员快速吃透大模型Agent的核心逻辑。ReAct擅长短任务与动态规划,却受限于上下文爆炸、过早停止等痛点;而Ralph Loop凭借强制持续迭代的“暴力美学”,完美破解长任务、复杂编程场景的核心难题,实现真正的自主纠错闭环。文章深度对比两种范式的核心差异、优缺点及实操选型场景,不仅梳理Agent从“可控推理”到“自主闭环”的迭代脉络,更搭配大模型全套学习资源,助力程序员从零入门大模型,快速掌握前沿技术红利。

作为程序员或大模型小白,在使用AI编程工具、探索大模型应用时,你是否经常遇到这些棘手问题?

- 过早退出:AI自以为完成任务就停止工作,实际结果未达预期,甚至存在明显漏洞;

- 单次提示脆弱:复杂编程、系统设计等任务,无法通过一次提示完成,需要反复手动干预引导;

- 重新提示成本高:每次纠错、补充引导都要重复说明上下文,浪费大量开发与学习时间;

- 上下文断裂:会话重启后,之前的所有操作进展、思考逻辑和任务上下文全部丢失,需重新开始。

其实这些问题的根源只有一个:LLM(大语言模型)的自我评估机制并不可靠,它只会在主观判断“任务完成”时退出,而非达到我们设定的客观可验证标准。

值得庆幸的是,AI Agent的发展已走过关键迭代期,从最初“思考-行动-观察”的经典闭环(ReAct范式),成功演进到“无限自主迭代”的Ralph Loop新模式,彻底打通了大模型在复杂场景应用的核心壁垒。今天,我们不仅吃透这两大范式,更会给大家送上大模型入门到实战的全套免费学习资源,帮小白快速上手、程序员高效进阶。

本文核心价值的在于“理论+实操+学习指引”,既讲清两大范式的核心原理、优缺点、适用场景,拆解Ralph Loop如何解决ReAct在长任务、复杂编程中的痛点,也揭示AI Agent从“可控推理”到“自主闭环”的底层逻辑,同时搭配全套大模型学习资料,为不同基础的学习者提供明确的学习路径和Agent选型参考,小白能看懂、程序员能复用。

一、ReAct 范式:AI Agent 的 “思考 - 行动 - 观察” 经典闭环(2022)

- 核心起源与定义

ReAct(Reasoning + Acting)由普林斯顿大学与谷歌研究院于 2022 年 10 月提出,是 ICLR 2023 的重磅论文成果,它首次将推理过程与行动执行紧密结合,打破了此前 LLM “推理与行动分离” 的局限,奠定了现代 AI Agent 的基础架构范式。

核心定义:让 LLM 通过“思考(Thought)→行动(Action)→观察(Observation)” 的循环迭代 ,与外部环境 / 工具动态交互,逐步推进任务直至完成,模拟人类解决问题的自然认知过程。

- 经典执行流程(以 “查询苹果今日股价” 为例)

| 步骤 | 核心内容 | 示例 |

|---|---|---|

| 思考(Thought) | 分析任务需求,规划下一步行动 | “需要获取苹果公司实时股价,应调用股票查询 API” |

| 行动(Action) | 执行具体操作,调用外部工具 | 调用get_stock_price(ticker="AAPL") |

| 观察(Observation) | 获取工具返回结果,形成反馈 | 工具返回 “192.5 美元,上涨 0.8%” |

| 循环(Loop) | 根据观察结果调整策略,继续迭代 | 若数据完整则整理回答,否则补充调用其他 API |

- ReAct 的核心优势与致命痛点

优势

1、高适应性:无需预先知道完整解决方案,能根据环境反馈动态调整路径,适合不确定性强的任务;

2、可解释性:显式输出思考过程,便于人类理解 Agent 决策逻辑,降低调试难度;

3、工具协同:无缝衔接外部工具(搜索、代码执行、数据库查询等),扩展 LLM 能力边界。

痛点(长任务 / 复杂场景下尤为明显)

1、上下文爆炸:每次迭代需将完整历史记录重新输入 LLM,token 消耗呈指数级增长,成本高、效率低;

2、过早停止:LLM 常因 “自我感觉良好” 提前退出,满足于 “差不多就行” 的结果,无法完成需要持续优化的复杂任务;

3、迭代动力不足:缺乏内置的 “自我纠错” 机制,遇到错误时难以主动反思并改进,依赖人类干预;

4、效率瓶颈:每轮工具调用都需暂停等待响应,整体执行速度受限,不适合长时间运行的任务。

二、迭代中间态:从 ReAct 到 Ralph Loop 的过渡方案

在 ReAct 与 Ralph Loop 之间,AI Agent 领域出现了多种优化范式,核心都是解决 ReAct 的痛点,为 Ralph Loop 的诞生奠定基础:

- ReWOO(Reasoning Without Observation):推理与行动分离

微软研究院 2023 年提出,核心是将推理过程与工具调用完全解耦:

先让 LLM 生成完整推理链与所有工具调用计划;

并行执行所有工具调用,减少等待时间;

最后整合所有工具返回结果,生成最终答案。

优势:大幅降低 token 消耗,提升执行效率;

不足:缺乏动态反馈,不适合需要根据中间结果调整策略的任务。

- Reflexion(反思机制):赋予 Agent “错题本”

核心是引入自我反思能力,让 Agent 从失败中学习:

执行任务→复盘结果→提炼经验(如 “某 API 调用参数错误”);

将经验存储为 “动态记忆”,用于下一轮尝试;

实验证明:在 HumanEval 代码生成任务中,Reflexion 能将准确率提升 20%+。

优势:具备跨任务学习能力,减少重复错误;

不足:反思过程仍依赖 LLM,增加额外计算成本,且反思质量受模型能力限制。

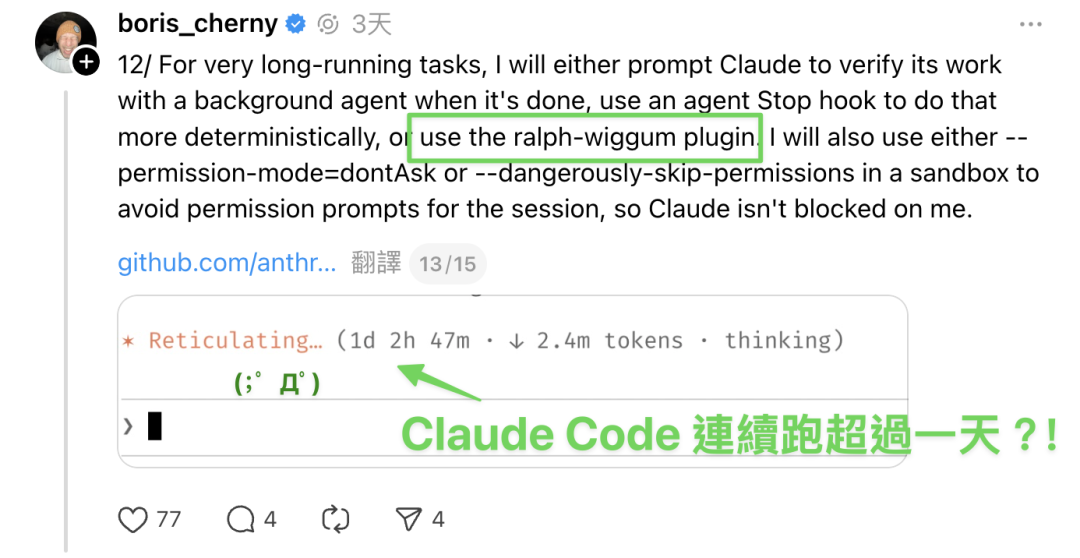

三、Ralph Loop:AI Agent 的 “暴力迭代” 革命(2026 年初爆发)

- 核心起源与哲学

Ralph Loop(也称 Ralph Wiggum Loop)源自 CloudNativeClaudeCode 社区,名字取自《辛普森一家》中 “永不放弃” 的小孩 Ralph Wiggum,寓意“不管挫折,持续迭代”(persistently iterating despite setbacks)。

核心哲学:“简单即强大”—— 用最朴素的 Bash 循环,强制 AI 在持续迭代中工作,直到任务真正完成,而非 “感觉完成”。

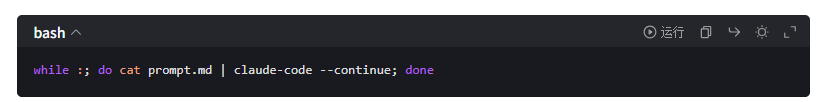

- 极简实现原理(一行 Bash 命令的奇迹)

这行命令的背后,是 Ralph Loop 的三大核心机制:

| 机制 | 作用 | 实现方式 |

|---|---|---|

| 无限循环 | 强制 AI 持续工作,永不主动停止 | Bash 的while :死循环,直到满足退出条件 |

| Stop Hook 拦截 | 阻止 AI 过早退出,延长工作时间 | 拦截 Claude Code 的退出请求,重新喂入相同 Prompt |

| 环境感知 | 让 AI 看到自己的历史工作成果 | 保留文件系统修改与 git 历史记录,每次迭代都能读取之前的代码 / 测试结果 |

| 完成承诺 | 定义明确的退出标准,避免无限循环 | 设置--completion-promise "DONE"参数,AI 输出指定短语时才停止 |

- 完整执行流程(以编程任务为例)

任务初始化:用户输入任务描述(如 “开发一个 Todo 应用,通过所有测试用例”),设置最大迭代次数(如–max-iterations 50)和完成承诺(如 “All tests passed!”);

首次执行:Claude Code 开始编写代码、运行测试,生成初步结果;

退出拦截:当 Claude 试图退出时,Stop Hook 检查是否满足完成承诺;

结果反馈:若未完成,将报错信息 + 当前代码状态 + 原始任务重新喂入 Claude;

迭代优化:Claude 读取自己的历史工作,分析错误原因,修改代码、重新测试;

循环终止:直到所有测试通过(输出完成承诺)或达到最大迭代次数,循环结束。

- Ralph Loop 的革命性价值

彻底解决 “过早停止” 问题:强制 AI 持续迭代,直到任务真正完成,适合需要 “死磕到底” 的复杂任务(如编程、系统设计);

零上下文负担:无需存储完整历史记录,AI 通过文件系统与 git 历史感知进度,大幅降低 token 消耗,成本显著降低;

自主纠错闭环:错误不再是中断点,而是学习数据,形成 “试错→优化→再试错→再优化” 的自主迭代循环;

24/7 无间断工作:无需人类干预,AI 可在后台持续运行数小时甚至数天,适合通宵完成大型项目;

极简架构:核心逻辑仅需一行 Bash 命令,无需复杂的记忆管理或反思模块,工程实现难度低。

四、ReAct vs Ralph Loop:核心差异与选用指南

- 两大范式的核心对比表

| 对比维度 | ReAct | Ralph Loop |

|---|---|---|

| 核心哲学 | “边想边做,动态调整”,模拟人类决策过程 | “死磕到底,持续迭代”,暴力美学解决复杂问题 |

| 迭代动力 | 基于推理的主动规划,每步都有明确思考 | 基于外部循环的被动推进,依赖环境反馈纠错 |

| 上下文管理 | 显式传递完整历史记录,token 消耗大 | 隐式通过文件系统感知历史,token 消耗极小 |

| 停止机制 | 自我判断任务完成度,易过早停止 | 严格遵循完成承诺,不达标永不停止 |

| 适用场景 | 短任务、需要动态规划的工具调用场景(如信息检索、数据分析) | 长任务、需要持续优化的复杂场景(如编程、系统设计、PCB 设计) |

| 执行效率 | 每轮工具调用需等待,整体速度较慢 | 无间断执行,适合长时间运行,累计效率高 |

| 调试难度 | 可解释性强,思考过程显式输出 | 可解释性较弱,需通过文件历史追溯决策路径 |

- 选型建议

优先选 ReAct:任务目标明确、步骤可预测、需要频繁工具交互(如 “查询北京天气并推荐适合的户外活动”);

优先选 Ralph Loop:任务复杂、需要持续优化、可通过客观标准验证结果(如 “编写一个 REST API,通过所有单元测试”);

混合使用:在长任务中,先用 ReAct 做整体规划,再用 Ralph Loop 执行具体模块的持续优化,兼顾效率与质量。

五、AI Agent 迭代范式的未来发展方向

- 智能融合:Ralph Loop + 反思机制

将 Reflexion 的 “自我反思” 能力融入 Ralph Loop,让 AI 不仅能 “持续迭代”,还能 “聪明地迭代”—— 从历史错误中提炼规律,避免重复踩坑,提升迭代效率。

- 模块化架构:解耦循环与执行

把 Ralph Loop 的循环机制与具体执行逻辑分离,开发通用的 “迭代引擎”,适配不同 LLM(GPT-4、Claude、Gemini 等)和任务类型,降低使用门槛。

- 效率优化:动态调整迭代策略

引入 “智能调度” 机制,根据任务进度调整迭代频率与深度 —— 前期快速探索,后期精细优化,平衡速度与质量。

- 安全护栏:防止失控与滥用

为 Ralph Loop 添加安全边界,如资源限制(CPU / 内存使用)、内容审核、成本控制,避免 AI 在无限循环中做出危险操作或产生巨额费用。

AI Agent 的迭代逻辑 —— 从 “可控推理” 到 “自主闭环”

从 ReAct 到 Ralph Loop 的演进,本质是 AI Agent 从 “人类监督下的工具使用者”,向 “自主工作的独立实体” 的转变,核心驱动力是解决长任务、复杂场景下的效率与质量问题。

Ralph Loop 的极简设计证明:有时最简单的方法反而最有效—— 与其花费大量精力优化 LLM 的推理能力,不如用一个 Bash 循环强制它持续工作,直到任务真正完成。这种 “暴力美学” 的背后,是对 AI Agent 本质的深刻理解:持续迭代的能力,比单次推理的准确性更重要。

对创业公司与开发者而言,这一演进路径提供了明确的实践指南:根据任务特性选择合适的 Agent 范式,用最小的成本实现最大的价值。

让 AI 真正成为 “不知疲倦的牛马”,解放人类的核心创造力。

Ralph:Me fail English? That’s unpossible!

AI Agent的发展也正需要这种:即使失败也要坚持下去的勇气~

那么,如何系统的去学习大模型LLM?

到2026年,大型语言模型将不再是“实验性工具”,而将成为核心基础设施。 过去三年,大型语言模型(LLM)已从研究实验室走向生产系统,为客户支持、搜索、分析、编码助手、医疗保健工作流程、金融和教育等领域提供支持。但在这股热潮背后,一些重要的事情正在发生:

企业不再招聘“人工智能爱好者”,而是招聘大语言模型LLM工程师。在2026年迅速成为排名前五的科技职业之一。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

为了让大家不浪费时间踩坑!2026 年最新 AI 大模型全套学习资料已整理完毕,不管你是想入门的小白,还是想转型的传统程序员,这份资料都能帮你少走 90% 的弯路

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

大模型资料包分享

1、 AI大模型学习路线图(含视频解说)

2、从入门到精通的全套视频教程

3、学习电子书籍和技术文档

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

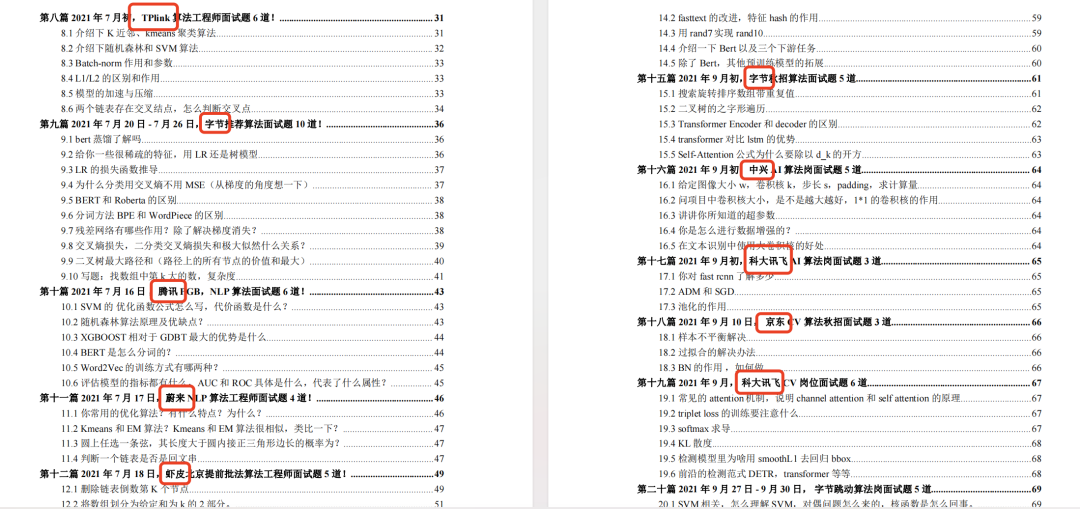

5、各大厂大模型面试题目详解

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献476条内容

已为社区贡献476条内容

所有评论(0)