HarmonyOS 6.0+ PC端智能监控助手开发实战:摄像头联动与异常行为识别落地

本文通过实战开发HarmonyOS 6.0+ PC端智能监控助手,总结出端侧AI监控应用的核心开发要点:1)技术选型:优先选用HarmonyOS原生API(Camera Kit、AVRecorder)与轻量化AI框架(MindSpore Lite),确保兼容性与性能;2)权限管理:严格遵循HarmonyOS权限申请规范,保障用户隐私与应用合规性;3)性能优化:聚焦视频流采集与AI推理的实时性,通过

一、引言

1.1 PC端周边环境监控核心需求

在数字化办公与智能化家居场景中,PC端周边环境监控的需求日益凸显。办公场景下,企业需要对办公区域的设备安全、文件保密等进行实时管控,防范无人值守时的设备盗窃、数据泄露等风险;无人值守场景(如实验室、小型机房、居家办公工位)中,需实时感知异常入侵、设备异常操作等情况,保障环境与设备安全。传统PC监控方案多依赖第三方软件,存在兼容性差、响应延迟高、数据隐私易泄露等问题,难以满足轻量化、高可靠的监控需求。

1.2 HarmonyOS 6.0+技术优势赋能监控场景

HarmonyOS 6.0+针对PC端场景进行了全方位能力升级,其摄像头API增强特性与端侧AI识别能力为智能监控应用开发提供了核心支撑。在摄像头能力方面,Camera Kit PC端API新增多设备并发接入、高分辨率视频流采集(最高支持4K@30FPS)、硬件级视频编码等功能,解决了传统PC摄像头联动兼容性差、采集效率低的问题;在端侧AI能力方面,通过HiAI Engine异构计算调度与MindSpore Lite模型轻量化技术,实现了复杂AI识别任务在PC端的高效运行,兼具低延迟(推理延迟<80ms)与高隐私性(数据本地处理,无需上传云端)的优势,避免了云端识别的网络依赖与数据泄露风险。

1.3 本文开发目标

本文聚焦HarmonyOS 6.0+ PC端场景,实战开发一款智能监控助手,核心目标包括:1)实现多摄像头联动的实时监控与视频流预览;2)集成端侧AI模型,精准识别人体移动、异常停留、摄像头遮挡等异常行为;3)构建多维度报警与通知机制,支持本地弹窗、声音报警及跨设备(关联手机)通知推送;4)实现监控视频本地定时录制、异常片段标记与回放导出功能;5)通过性能优化,保障应用在后台运行时的实时性与资源高效占用。

二、核心技术栈解析

2.1 Camera Kit PC端API

HarmonyOS 6.0+ Camera Kit PC端API是实现摄像头联动的核心技术,提供设备管理、视频流采集、参数调节等全链路能力。其核心特性包括:支持USB摄像头、PC内置摄像头等多设备枚举与接入;提供CameraManager、CaptureSession等核心类,实现摄像头初始化、视频流采集会话管理;支持分辨率(1080P/4K)、帧率(15/30FPS)等参数动态调节;提供帧数据回调接口,可直接对接端侧AI模型进行实时分析,实现视频流采集与识别的无缝衔接。

2.2 端侧异常行为识别模型

采用轻量化端侧AI模型架构,基于MindSpore Lite进行模型压缩与优化,适配PC端算力资源。核心模型选择YOLOv5n作为基础骨架,通过量化训练(INT8)、算子融合、稀疏剪枝等手段,将模型体积压缩至2MB以内,满足HarmonyOS应用HAP包体积限制要求。针对监控场景特化优化:新增人体移动轨迹追踪模块,基于帧间差分法实现运动检测;集成异常停留判断逻辑,通过时间阈值(可配置)识别超时长停留行为;添加摄像头遮挡检测分支,基于图像灰度值方差判断遮挡状态。

2.3 本地视频存储API

基于HarmonyOS 6.0+ AVRecorder与视频存储API实现本地视频管理。AVRecorder支持H.265硬件编码,可降低视频录制的CPU占用;通过MediaStore API实现视频文件的沙箱存储与访问权限管理,支持定时录制任务的创建与销毁;提供文件覆盖策略配置接口,可实现指定容量的循环覆盖存储,避免存储空间溢出。同时,支持视频片段的元数据标记,可将异常行为发生的时间戳、类型等信息写入视频文件属性,便于后续检索。

2.4 系统通知与报警API

依托HarmonyOS分布式通知能力与系统服务API构建报警体系。本地报警通过NotificationManager实现弹窗通知,结合AudioPlayer API播放自定义报警音效;跨设备通知基于分布式软总线技术,通过distributedNotificationManager将报警信息推送至关联手机等设备,实现多端协同提醒。同时,通过DataAbility实现报警记录的持久化存储,支持记录的查询、筛选与导出(CSV/PDF格式)。

2.5 ArkUI监控界面组件

采用ArkUI(Stage模型)构建现代化监控界面,核心组件包括:Video组件用于实时监控画面预览与视频回放,支持多画面网格布局;Text、Image组件实现识别状态(正常/异常)、报警信息的可视化提示;Slider、Select等交互组件构建参数配置面板,支持识别灵敏度、录制时长等参数的实时调节;List组件用于报警记录与视频文件的列表展示,支持下拉刷新与分页加载。

三、开发实战

3.1 环境搭建

3.1.1 DevEco Studio 5.0+配置

1. 下载并安装DevEco Studio 5.0+,配置HarmonyOS 6.0+ SDK:打开DevEco Studio,进入Settings > Appearance & Behavior > System Settings > HarmonyOS SDK,勾选“PC”平台SDK及“AI”“Multimedia”相关模块,完成下载与配置。2. 项目创建:新建HarmonyOS Stage模型项目,选择“PC”设备类型,设置项目包名(如com.harmonyos.monitor),选择API Version 11及以上。3. 依赖配置:在项目build.gradle文件中添加Camera Kit、MindSpore Lite等依赖,示例如下:

dependencies {

implementation 'ohos.sdk:camera:11.0.0.0'

implementation 'ohos.sdk:mindspore-lite:1.0.0.0'

implementation 'ohos.sdk:distributed-notification:11.0.0.0'

}3.1.2 Camera Kit权限申请

在module.json5文件中声明所需权限:摄像头访问权限(ohos.permission.CAMERA)、麦克风权限(如需音频录制,ohos.permission.MICROPHONE)、存储读写权限(ohos.permission.READ_MEDIA、ohos.permission.WRITE_MEDIA)、分布式通知权限(ohos.permission.DISTRIBUTED_NOTIFICATION)。同时,在应用启动时通过requestPermissionsFromUser接口动态申请权限,代码示例如下:

import { abilityAccessCtrl, Permissions } from '@ohos.abilityAccessCtrl';

const permissions: Permissions[] = [

'ohos.permission.CAMERA',

'ohos.permission.READ_MEDIA',

'ohos.permission.WRITE_MEDIA'

];

async function requestPermissions() {

const atManager = abilityAccessCtrl.createAtManager();

const result = await atManager.requestPermissionsFromUser(getContext(), permissions);

if (result.grantedPermissions.length === permissions.length) {

// 权限申请成功,初始化摄像头

initCamera();

} else {

// 权限申请失败,提示用户

promptAction.showToast({ message: '请授予必要权限以正常使用监控功能' });

}

}3.1.3 摄像头设备初始化与连接管理

通过CameraManager枚举已接入的摄像头设备,选择目标设备进行初始化并创建采集会话。核心步骤:1)获取CameraManager实例:const cameraManager = camera.getCameraManager(getContext());;2)枚举设备:调用cameraManager.enumerateCameras()获取设备列表,区分前置/后置/外置摄像头;3)创建CaptureSession:配置视频采集分辨率、帧率等参数,绑定预览输出与帧数据回调;4)启动采集会话:调用captureSession.start()开始视频流采集。代码片段如下:

async function initCamera(cameraId: string = '') {

const cameraManager = camera.getCameraManager(getContext());

const cameras = await cameraManager.enumerateCameras();

const targetCamera = cameraId ? cameras.find(cam => cam.cameraId === cameraId) : cameras[0];

if (!targetCamera) return;

// 创建CaptureSession

const captureSession = await cameraManager.createCaptureSession(targetCamera.cameraId);

// 配置预览参数

const previewConfig = {

resolution: { width: 1920, height: 1080 },

frameRate: 30

};

// 绑定预览输出(对接ArkUI Video组件)

const previewOutput = await captureSession.createPreviewOutput(previewConfig);

previewOutput.on('frameAvailable', (frame) => {

// 帧数据回调,用于AI识别

processFrame(frame);

});

// 启动采集会话

await captureSession.start();

}3.2 实时监控模块

3.2.1 摄像头视频流采集与实时预览

基于Camera Kit的预览输出与ArkUI Video组件实现实时预览。将CaptureSession创建的预览输出通过

surfaceId与Video组件绑定,实现低延迟的视频流渲染。同时,处理视频流的旋转、镜像等适配逻辑,确保预览画面正常显示。代码示例如下:// ArkUI界面组件 @Component struct MonitorPreview { @State surfaceId: string = ''; build() { Video({ src: '', controller: new VideoController(), surfaceId: this.surfaceId }) .width('100%') .height('100%') .onReady(() => { // Video组件就绪后,绑定预览输出的surfaceId this.surfaceId = previewOutput.getSurfaceId(); }); } }3.2.2 画面分辨率与帧率调节

提供分辨率(720P/1080P/4K)与帧率(15/30FPS)的动态调节功能。通过

captureSession.updatePreviewConfig()接口修改采集参数,调节时需先暂停采集会话,修改完成后重新启动。同时,在UI层通过Select组件提供参数选择界面,调节后实时更新预览画面。核心代码如下:

async function adjustCameraParams(resolution: {width: number, height: number}, frameRate: number) {

if (captureSession.getState() === 'running') {

await captureSession.stop();

}

const newPreviewConfig = {

resolution,

frameRate

};

await captureSession.updatePreviewConfig(newPreviewConfig);

await captureSession.start();

}3.2.3 多摄像头切换支持

实现多摄像头枚举与切换逻辑:1)通过cameraManager.enumerateCameras()获取所有接入的摄像头信息,展示在UI下拉列表中;2)用户选择目标摄像头后,停止当前采集会话,销毁现有CaptureSession;3)初始化新选中的摄像头,创建新的采集会话并启动预览。同时,记录当前选中的摄像头ID,确保切换后参数配置的一致性。

3.3 异常行为识别

3.3.1 端侧识别模型集成

基于MindSpore Lite集成轻量化异常行为识别模型。核心步骤:1)模型准备:将训练好的YOLOv5n模型通过MindSpore Lite Converter工具进行量化压缩(INT8),生成.ms格式的端侧模型文件,放入项目rawfile目录;2)模型加载:通过mindsporeLite.createModel()加载模型,初始化推理环境;3)帧数据预处理:将摄像头采集的YUV格式帧数据转换为RGB格式,进行尺寸缩放(适配模型输入尺寸)、归一化等处理;4)模型推理:调用model.run()进行推理,获取识别结果(目标类型、位置、置信度);5)结果解析:判断是否存在人体移动、异常停留(超过预设时间阈值)、摄像头遮挡(画面灰度值方差低于阈值)等异常行为。代码示例如下:

import * as mindsporeLite from '@ohos.ai.mindsporeLite';

let model: mindsporeLite.Model = null;

async function loadModel() {

// 加载模型文件

const modelPath = '$rawfile(anomaly_detection.ms)';

model = await mindsporeLite.createModel(modelPath);

// 初始化推理环境

await model.init();

}

function processFrame(frame: camera.Frame) {

// 帧数据预处理:YUV转RGB、缩放、归一化

const rgbFrame = convertYUVToRGB(frame.data, frame.width, frame.height);

const resizedFrame = resizeFrame(rgbFrame, 640, 640);

const inputTensor = normalizeFrame(resizedFrame);

// 模型推理

const output = model.run([inputTensor]);

// 结果解析

const anomalies = parseDetectionResult(output);

handleAnomalies(anomalies);

}3.3.2 识别灵敏度调节

通过UI层的Slider组件提供灵敏度调节功能,灵敏度对应模型推理的置信度阈值(0.5~0.9),用户可拖动滑块设置。阈值越低,识别灵敏度越高(易误报);阈值越高,灵敏度越低(易漏报)。同时,针对不同异常类型(人体移动/异常停留/遮挡)提供独立的灵敏度配置项,满足差异化监控需求。调节后的阈值实时作用于结果解析逻辑,代码如下:

@State sensitivity: {

humanMotion: 0.7,

abnormalStay: 0.6,

occlusion: 0.5

} = { humanMotion: 0.7, abnormalStay: 0.6, occlusion: 0.5 };

function parseDetectionResult(output: any[]) {

const anomalies = [];

output.forEach(result => {

if (result.type === 'humanMotion' && result.confidence >= this.sensitivity.humanMotion) {

anomalies.push({ type: 'humanMotion', position: result.position });

} else if (result.type === 'abnormalStay' && result.confidence >= this.sensitivity.abnormalStay) {

anomalies.push({ type: 'abnormalStay', duration: result.duration });

} else if (result.type === 'occlusion' && result.confidence >= this.sensitivity.occlusion) {

anomalies.push({ type: 'occlusion' });

}

});

return anomalies;

}3.3.3 误识别过滤策略

采用多维度误识别过滤机制:1)时间阈值过滤:对于人体移动识别,仅当连续3帧均检测到目标时才判定为异常,避免单帧噪声导致的误报;2)目标大小过滤:过滤面积过小(如小于画面1%)的目标,排除蚊虫、灰尘等干扰;3)场景适配过滤:结合PC端使用场景,设置监控区域掩码,忽略画面边缘、桌面物品等非关注区域的检测结果;4)双模型协同过滤:引入轻量化唤醒模型(MobileNetV3,0.5MB),仅当唤醒模型检测到前景运动时,才启动主模型进行详细识别,降低静态场景下的误报率。

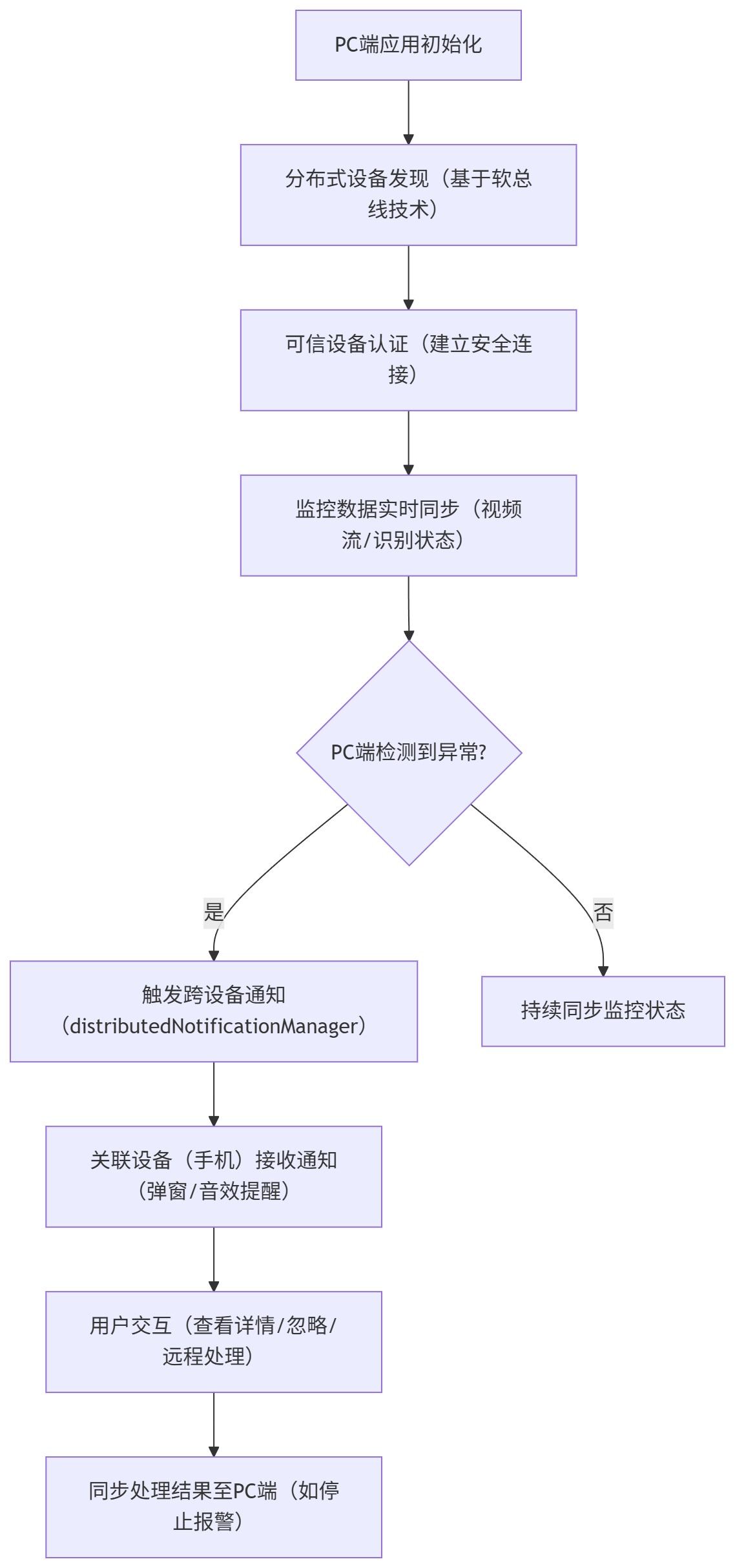

端侧异常识别流程可概括如下:

3.4 报警与通知模块

3.4.1 异常行为触发报警

当检测到异常行为时,触发多维度本地报警:1)声音报警:通过AudioPlayer播放自定义报警音效(如alarm.mp3),支持音量调节与循环播放;2)弹窗报警:调用promptAction.showDialog()显示弹窗,包含异常类型、发生时间等信息,支持“查看详情”“忽略”按钮;3)界面警示:在监控画面叠加红色边框与异常类型文字,实时提示当前异常状态。代码示例如下:

import { AudioPlayer } from '@ohos.multimedia.audio';

const audioPlayer = new AudioPlayer();

audioPlayer.src = '$rawfile(alarm.mp3)';

function triggerLocalAlarm(anomalyType: string) {

// 声音报警

audioPlayer.play();

// 弹窗报警

promptAction.showDialog({

title: '异常行为告警',

message: `检测到${getAnomalyName(anomalyType)},发生时间:${new Date().toLocaleString()}`,

buttons: [

{ text: '查看详情', action: 'view' },

{ text: '忽略', action: 'ignore' }

]

}).then(result => {

if (result.index === 0) {

// 跳转到报警详情页面

router.pushUrl({ url: 'pages/AlarmDetail' });

}

});

// 界面警示标记

setAlarmMarker(true, anomalyType);

}3.4.2 系统通知推送

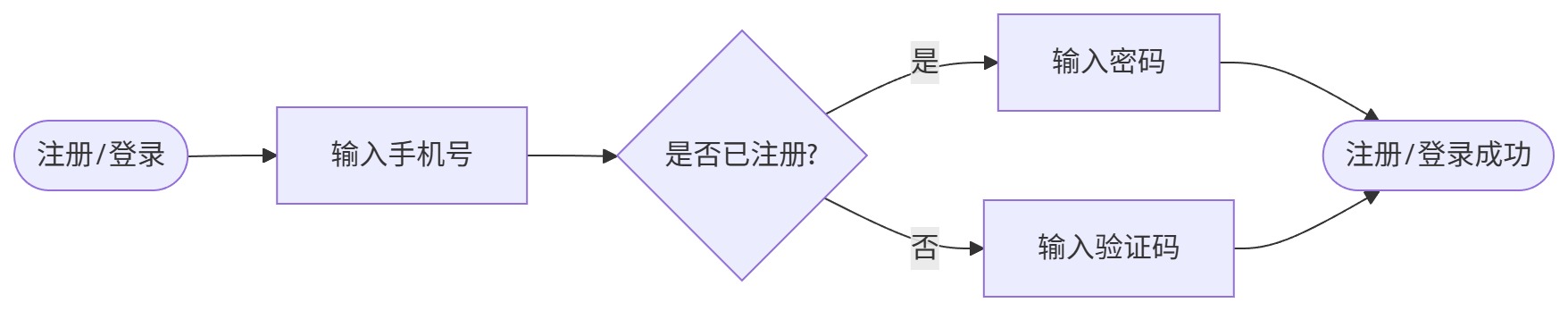

实现本地与跨设备通知推送:1)本地通知:通过NotificationManager创建通知,设置通知标题、内容、图标,点击通知可跳转至应用监控界面;2)跨设备通知:基于HarmonyOS分布式能力,通过distributedNotificationManager将报警信息推送至已关联的手机、平板等设备。推送前需通过分布式软总线完成设备发现与可信认证,代码如下:

多设备联动流程如下:

import { notification, distributedNotification } from '@ohos.notification';

async function pushNotification(anomalyType: string) {

// 本地通知

const localNotification = {

content: {

type: notification.ContentType.NOTIFICATION_CONTENT_BASIC_TEXT,

normal: {

title: 'PC监控助手告警',

text: `检测到${getAnomalyName(anomalyType)},时间:${new Date().toLocaleString()}`

}

},

deliveryTime: new Date().getTime(),

tapAction: {

type: notification.ActionType.ACTION_TYPE_OPEN_PAGE,

parameters: { url: 'pages/Monitor' }

}

};

await notification.publish(localNotification);

// 跨设备通知(推送至关联手机)

const distributedNotif = {

...localNotification,

targetDeviceIds: ['deviceId_of_phone'] // 关联设备ID

};

await distributedNotification.publish(distributedNotif);

}3.4.3 报警记录查询与导出

通过DataAbility实现报警记录的持久化存储,记录内容包括异常类型、发生时间、处理状态、关联视频片段路径等。UI层提供报警记录列表页面,支持按时间范围、异常类型进行筛选查询。同时,提供导出功能,支持将选中的记录导出为CSV或PDF格式文件,保存至本地存储或分享至其他设备。导出代码示例如下:

import { fileIO, csvUtil } from '@ohos.fileio';

async function exportAlarmRecords(records: AlarmRecord[], format: 'csv' | 'pdf') {

const exportPath = `${getContext().filesDir}/alarm_records_${new Date().getTime()}.${format}`;

let content = '';

if (format === 'csv') {

// 生成CSV内容

content = csvUtil.convertToCSV(records);

} else {

// 生成PDF内容(需集成PDF生成库)

content = await generatePDFContent(records);

}

// 写入文件

const file = fileIO.openSync(exportPath, fileIO.OpenMode.READ_WRITE | fileIO.OpenMode.CREATE);

fileIO.writeSync(file, content);

fileIO.closeSync(file);

// 提示导出成功

promptAction.showToast({ message: `导出成功,路径:${exportPath}` });

}3.5 本地存储功能

3.5.1 监控视频定时录制与循环覆盖

基于AVRecorder实现定时录制功能,用户可通过UI配置录制时长(如1小时/3小时/自定义)与存储路径。采用循环覆盖策略,当存储容量达到预设阈值(如剩余空间<10GB)时,自动删除最早的录制文件,确保存储不溢出。定时录制通过Timer组件实现任务调度,核心代码如下:

import { avRecorder } from '@ohos.multimedia.media';

let recorder: avRecorder.AVRecorder = null;

let recordTimer: Timer = null;

function startTimedRecording(duration: number) {

// 初始化AVRecorder

recorder = avRecorder.createAVRecorder();

const recordConfig = {

outputPath: `${getContext().filesDir}/recording_${new Date().getTime()}.mp4`,

videoCodec: 'h265',

audioCodec: 'aac',

resolution: { width: 1920, height: 1080 },

frameRate: 30

};

recorder.prepare(recordConfig);

recorder.start();

// 定时停止录制

recordTimer = new Timer();

recordTimer.setTimeout(() => {

stopRecording();

// 启动下一轮录制(循环)

startTimedRecording(duration);

}, duration * 3600 * 1000);

}

function stopRecording() {

if (recorder) {

recorder.stop();

recorder.release();

}

if (recordTimer) {

recordTimer.clear();

}

// 检查存储容量,执行循环覆盖

checkStorageAndClean();

}3.5.2 异常片段自动标记与保存

当检测到异常行为时,自动标记并保存异常发生前后的视频片段(如前10秒+后20秒)。核心逻辑:1)实时缓存最近30秒的视频流数据;2)触发异常时,从缓存中提取前10秒数据,同时继续录制20秒;3)将合并后的片段保存至独立目录(如anomaly_videos),并在视频文件元数据中标记异常类型、时间戳等信息;4)更新报警记录,关联对应的视频片段路径。

3.5.3 视频回放与导出

基于ArkUI Video组件实现视频回放功能,支持播放/暂停、进度拖动、倍速播放(0.5x~2x)等操作。UI层提供视频文件列表,按录制时间倒序排列,支持按异常标记筛选视频。同时,提供视频导出功能,支持将选中的视频片段导出至本地指定目录或通过分布式能力分享至其他设备。回放代码示例如下:

@Component

struct VideoPlayback {

@State videoPath: string = '';

private controller: VideoController = new VideoController();

build() {

Column() {

Video({

src: this.videoPath,

controller: this.controller,

previewUri: '$r("app.media.preview")'

})

.width('100%')

.height(480)

.controls(true);

Row() {

Button('播放/暂停').onClick(() => {

this.controller.playPause();

});

Button('导出').onClick(() => {

exportVideo(this.videoPath);

});

}

}

}

}3.6 ArkUI交互设计

3.6.1 监控画面网格展示

采用网格布局(Grid组件)实现多摄像头画面的同时展示,支持1/2/4路摄像头分屏显示。用户可通过UI按钮切换分屏模式,切换时自动调整每个Video组件的尺寸与位置。对于单路摄像头,支持全屏显示模式,提升监控视野。代码示例如下:

@State splitMode: number = 1; // 1/2/4分屏

build() {

Column() {

// 分屏模式切换按钮

Row() {

Button('1分屏').onClick(() => this.splitMode = 1);

Button('2分屏').onClick(() => this.splitMode = 2);

Button('4分屏').onClick(() => this.splitMode = 4);

}

// 监控画面网格

Grid() {

for (let i = 0; i < this.splitMode; i++) {

GridItem() {

MonitorPreview(cameraId: this.cameraList[i]?.cameraId)

}

}

}

.gridTemplateColumns(`repeat(${this.splitMode === 4 ? 2 : this.splitMode}, 1fr)`)

.gridTemplateRows(`${this.splitMode === 4 ? 2 : 1}fr`)

.width('100%')

.height('80%')

}

}3.6.2 识别状态与报警信息提示

在监控界面实时展示识别状态与报警信息:1)状态提示:通过Text组件显示当前摄像头状态(正常/连接中/断开)、识别模式(实时监控/待机);2)报警信息:当触发异常时,在画面右上角显示红色警示条,包含异常类型与发生时间;3)日志面板:提供可折叠的日志面板,展示近期识别记录与报警历史,支持手动清空。

3.6.3 参数配置面板

设计滑出式参数配置面板,包含以下配置项:1)识别灵敏度:针对不同异常类型的独立Slider调节控件;2)录制设置:录制时长选择、循环覆盖开关、存储路径配置;3)报警设置:声音报警开关、音量调节、跨设备通知开关;4)摄像头参数:分辨率、帧率选择。配置项修改后实时生效,无需重启应用,并自动保存配置至本地,下次启动时加载。

四、性能优化

4.1 视频流采集与识别实时性优化

1)视频流采集优化:采用硬件级视频编码(H.265)降低CPU占用,通过Camera Kit的frameAvailable回调获取原始帧数据,避免二次拷贝;开启帧数据零拷贝机制,直接从ISP送入NPU进行处理,减少内存带宽占用50%以上。2)识别 pipeline 优化:将帧数据预处理、模型推理、结果解析等步骤放入任务池(taskPool)异步执行,避免阻塞UI线程;采用帧丢弃策略,当检测到前一帧推理未完成时,丢弃当前帧,确保推理流畅性。代码示例如下:

// 异步处理帧数据

previewOutput.on('frameAvailable', (frame) => {

taskPool.execute(async () => {

// 检查前一帧是否处理完成

if (isProcessing) return;

isProcessing = true;

try {

const rgbFrame = convertYUVToRGB(frame.data, frame.width, frame.height);

const inputTensor = normalizeFrame(rgbFrame);

const output = model.run([inputTensor]);

const anomalies = parseDetectionResult(output);

// 主线程更新UI

uiThread.post(() => {

handleAnomalies(anomalies);

});

} finally {

isProcessing = false;

}

});

});4.2 端侧模型推理效率提升

1)模型轻量化优化:基于MindSpore Lite工具链对模型进行全链路压缩,通过量化训练(INT8)将模型体积压缩75%,参数量降低40%;融合Conv+BN+ReLU算子,提升推理速度30%。2)异构计算调度:通过HiAI Engine将模型推理任务智能分发至NPU、GPU、CPU等硬件单元,将密集计算卸载至NPU,轻量操作保留在CPU,实现算力资源的最优利用。例如,在PC端运行优化后的YOLOv5n模型,推理速度可达30FPS,满足实时识别需求。3)动态模型切换:根据监控场景动态加载不同复杂度的模型,如无人值守时加载轻量模型(1.2MB)降低资源占用,检测到异常时切换至增强模型提升识别准确率。

4.3 后台运行资源占用控制

1)后台降频策略:应用切换至后台时,自动降低摄像头帧率(30FPS→15FPS)与模型推理频率,减少CPU与NPU占用;通过@ohos.powerManager监控设备温度,当温度超过85℃时,进一步降低负载或暂停非关键任务。2)内存优化:及时释放未使用的帧数据、模型输入输出张量等内存资源;采用内存池机制复用内存块,减少内存分配与回收开销。3)任务调度优化:通过TaskScheduler对定时录制、日志清理等后台任务进行统一调度,避免任务并发执行导致的资源竞争。

五、测试与验证

5.1 摄像头兼容性测试

测试目标:验证应用在不同品牌、型号PC摄像头(内置/外置USB)上的兼容性。测试方案:选取主流PC机型(华为MateBook、联想小新、戴尔灵越等)及3种以上外置USB摄像头(罗技C920、海康威视USB摄像头等),测试摄像头枚举、初始化、视频流采集、参数调节等功能的稳定性。测试指标:摄像头识别成功率(目标≥95%)、参数调节有效性(分辨率/帧率切换成功率100%)。测试工具:DevEco Studio Device Manager、日志分析工具HiLog。

5.2 异常行为识别准确率测试

测试目标:验证端侧模型对不同异常行为的识别准确率。测试方案:构建测试数据集,包含人体移动、异常停留(5分钟/10分钟)、摄像头遮挡(部分/完全遮挡)等场景的视频片段(总时长10小时);在不同光线条件(强光/弱光/逆光)下运行应用,记录识别结果。测试指标:总体识别准确率(目标≥90%)、误报率(目标≤5%)、漏报率(目标≤3%)。测试工具:MindSpore Lite Profiler、自定义准确率统计脚本。

5.3 报警响应速度测试

测试目标:验证异常行为触发后报警与通知的响应延迟。测试方案:模拟不同异常行为(人体闯入、摄像头遮挡),记录从帧数据检测到异常到本地弹窗/声音报警、跨设备通知推送完成的时间。测试指标:本地报警响应延迟(目标<500ms)、跨设备通知延迟(目标<1s)。测试工具:高精度计时器、网络延迟测试工具。

5.4 后台运行稳定性测试

测试目标:验证应用在长时间后台运行时的稳定性与资源占用合理性。测试方案:将应用切换至后台,持续运行24小时,期间模拟正常PC使用场景(文件操作、浏览器浏览等);定时记录CPU占用率、内存使用量、电池功耗等指标。测试指标:后台运行无崩溃(稳定性100%)、CPU占用率≤15%、内存占用≤500MB、每小时功耗≤5%。测试工具:DevEco Profiler、系统资源监控工具。

六、总结与展望

6.1 端侧AI监控应用开发要点总结

本文通过实战开发HarmonyOS 6.0+ PC端智能监控助手,总结出端侧AI监控应用的核心开发要点:1)技术选型:优先选用HarmonyOS原生API(Camera Kit、AVRecorder)与轻量化AI框架(MindSpore Lite),确保兼容性与性能;2)权限管理:严格遵循HarmonyOS权限申请规范,保障用户隐私与应用合规性;3)性能优化:聚焦视频流采集与AI推理的实时性,通过模型轻量化、异构计算调度等手段提升效率;4)用户体验:设计简洁直观的交互界面,提供灵活的参数配置与多维度报警机制;5)稳定性测试:覆盖兼容性、准确率、响应速度等多维度测试,确保应用在不同场景下稳定运行。

6.2 HarmonyOS PC端智能安防工具拓展方向

基于本文开发的智能监控助手,未来可向以下方向拓展:1)多设备监控联动:依托HarmonyOS分布式软总线技术,实现PC、智能摄像头、智慧屏等多设备的协同监控,构建全屋/全办公区的智能安防网络;2)远程查看与控制:集成HarmonyOS分布式数据管理能力,支持通过手机、平板等设备远程查看监控画面、控制摄像头参数、接收报警通知;3)AI功能增强:引入更复杂的异常行为识别算法(如暴力行为、物品遗留/丢失),结合声音识别(如玻璃破碎、尖叫)提升安防能力;4)预测性维护:基于历史监控数据与AI预测模型,提前识别摄像头故障、存储异常等问题,主动推送维护提醒;5)云边协同:结合华为云服务,实现监控数据的云端备份与大数据分析,为用户提供安防趋势报告与风险预警。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)