安防监控AI-人脸与行为识别标注完全指南

本文全面解析安防监控AI的数据标注,涵盖人脸检测、姿态估计与行为识别三大核心任务。文章详细阐述了标注要素、规范策略及质量控制方法,并结合智慧园区、商场客流、校园安全等实战案例展示应用场景。同时,强调隐私合规在数据处理中的关键地位。通过TjMakeBot专业工具支持,助力开发者构建高质量、合规的安防数据集,提升AI模型性能与安全性。

🔐 引言:智能安防的数据挑战

安防监控是AI落地最成熟的领域之一。根据IDC的数据,2025年全球智能视频监控市场规模已突破500亿美元,中国市场占比超过40%。从机场、车站的人脸识别闸机,到商场、园区的行为分析系统,AI正在重新定义安防行业的边界。

然而,安防AI的高精度要求对数据标注提出了严峻挑战:

- 人脸识别需要在复杂光照、多角度、遮挡等条件下保持高准确率

- 行为识别需要理解人体姿态、动作序列和场景语义

- 隐私合规要求在数据处理全流程中保护个人信息

本文将深入探讨安防监控AI的标注技术,涵盖人脸检测、人脸关键点、人体姿态、行为识别等多个维度,帮助你构建高质量的安防数据集。

🎯 安防AI标注的核心任务

1. 人脸检测与识别

人脸检测(Face Detection):

定位图像中所有人脸的位置,输出边界框坐标。

标注要素:

- 边界框(Bounding Box):包含完整人脸的最小矩形

- 置信度(Confidence):人脸存在的确定程度

- 遮挡程度(Occlusion):人脸被遮挡的比例

人脸关键点(Facial Landmarks):

标注人脸的关键特征点,用于人脸对齐和表情分析。

常用关键点方案:

- 5点:左眼中心、右眼中心、鼻尖、左嘴角、右嘴角

- 68点:详细的面部轮廓、眉毛、眼睛、鼻子、嘴巴

- 106点:更精细的面部特征,适合美颜、换脸等应用

人脸属性(Face Attributes):

标注人脸的各种属性信息:

- 性别(Gender):男/女

- 年龄段(Age Group):儿童/青年/中年/老年

- 表情(Expression):中性/微笑/惊讶/愤怒/悲伤等

- 配饰(Accessories):眼镜/口罩/帽子等

- 姿态角度(Pose):俯仰角/偏航角/翻滚角

2. 人体检测与姿态估计

人体检测(Person Detection):

定位图像中所有人体的位置。

标注要素:

- 全身边界框:包含完整人体

- 可见部分框:只包含可见的身体部分

- 遮挡标记:标注被遮挡的身体部位

人体关键点(Body Keypoints):

标注人体骨骼的关键节点,用于姿态估计。

COCO格式17点方案:

0: 鼻子 (nose)

1: 左眼 (left_eye)

2: 右眼 (right_eye)

3: 左耳 (left_ear)

4: 右耳 (right_ear)

5: 左肩 (left_shoulder)

6: 右肩 (right_shoulder)

7: 左肘 (left_elbow)

8: 右肘 (right_elbow)

9: 左腕 (left_wrist)

10: 右腕 (right_wrist)

11: 左髋 (left_hip)

12: 右髋 (right_hip)

13: 左膝 (left_knee)

14: 右膝 (right_knee)

15: 左踝 (left_ankle)

16: 右踝 (right_ankle)

每个关键点需要标注:

- 坐标(x, y)

- 可见性(visible/occluded/not_labeled)

3. 行为识别

动作分类(Action Classification):

识别人物正在进行的动作类型。

安防场景常见动作:

- 正常行为:行走、站立、坐下、交谈、使用手机

- 可疑行为:徘徊、张望、尾随、聚集

- 异常行为:奔跑、摔倒、打架、翻越、闯入

时序行为标注(Temporal Action Annotation):

在视频中标注动作的起止时间。

标注格式:

{

"video_id": "camera_01_20260130",

"actions": [

{

"action": "walking",

"person_id": 1,

"start_frame": 0,

"end_frame": 150,

"start_time": "00:00:00",

"end_time": "00:00:05"

},

{

"action": "running",

"person_id": 1,

"start_frame": 151,

"end_frame": 300,

"start_time": "00:00:05",

"end_time": "00:00:10"

}

]

}

💡 标注策略与最佳实践

策略1:人脸标注规范

边界框标注规则:

规则1:框的范围

- 包含完整的人脸区域(从发际线到下巴)

- 包含耳朵(如果可见)

- 不包含过多背景(边距控制在人脸宽度的10%以内)

规则2:遮挡处理

- 遮挡<30%:正常标注完整人脸框

- 遮挡30%-70%:标注可见部分,标记为"部分遮挡"

- 遮挡>70%:标注可见部分,标记为"严重遮挡"

规则3:特殊情况

- 侧脸(>45°):标注可见的面部区域

- 模糊人脸:如果能辨认是人脸,仍需标注

- 照片/海报中的人脸:根据项目需求决定是否标注

关键点标注规则:

规则1:精确定位

- 眼睛:标注瞳孔中心

- 鼻子:标注鼻尖最突出点

- 嘴巴:标注嘴角和上下唇中点

规则2:遮挡处理

- 被遮挡的关键点:标注推测位置,标记为"occluded"

- 完全不可见:标记为"not_visible"

规则3:一致性

- 同一视频中的同一人,关键点位置应保持连贯

- 避免帧间跳动

属性标注规则:

年龄段划分:

- 儿童:0-12岁

- 青少年:13-17岁

- 青年:18-35岁

- 中年:36-55岁

- 老年:56岁以上

表情分类:

- 中性:无明显表情

- 高兴:嘴角上扬,可能露齿

- 惊讶:眉毛上扬,嘴巴张开

- 愤怒:眉头紧锁,嘴唇紧闭

- 悲伤:眉头下垂,嘴角下拉

- 恐惧:眼睛睁大,嘴巴微张

- 厌恶:鼻子皱起,上唇上扬

策略2:人体姿态标注规范

关键点定位原则:

关节点定位:

- 肩膀:肩关节中心点

- 肘部:肘关节弯曲处

- 手腕:手腕关节中心

- 髋部:髋关节中心(裤腰位置)

- 膝盖:膝关节中心

- 脚踝:踝关节中心

面部点定位:

- 鼻子:鼻尖

- 眼睛:眼球中心

- 耳朵:耳廓中心

遮挡与可见性标注:

可见性等级:

- 2:完全可见,可以精确定位

- 1:被遮挡但可推断位置

- 0:不可见,无法推断

遮挡类型:

- 自遮挡:被自己身体其他部位遮挡

- 他人遮挡:被其他人遮挡

- 物体遮挡:被场景中的物体遮挡

- 出界:超出图像边界

多人场景处理:

人物ID分配:

- 每个人分配唯一ID

- 同一视频中保持ID一致

- 新出现的人分配新ID

重叠处理:

- 分别标注每个人的完整骨架

- 被遮挡的关键点标记可见性

- 记录遮挡关系

策略3:行为标注规范

动作边界定义:

动作开始:

- 准备动作开始的第一帧

- 例如:跑步从脚离地开始

动作结束:

- 动作完成的最后一帧

- 例如:跑步到脚落地静止

过渡处理:

- 两个动作之间的过渡帧

- 可以标注为前一个动作或后一个动作

- 保持标注一致性

复合动作处理:

同时进行的动作:

- 例如:边走边打电话

- 标注主要动作(走路)

- 附加标注次要动作(打电话)

连续动作:

- 例如:走路→跑步→停下

- 分别标注每个动作段

- 确保时间连续无重叠

异常行为标注:

异常行为类型:

- 摔倒:人体从站立/行走状态突然倒地

- 打架:两人或多人肢体冲突

- 翻越:跨越围栏、护栏等障碍物

- 闯入:进入禁止区域

- 徘徊:在同一区域长时间停留或来回走动

标注要素:

- 行为类型

- 涉及人员ID

- 起止时间

- 发生位置(区域标注)

- 严重程度(轻微/中等/严重)

策略4:质量控制

人脸标注质量检查:

检查项目:

□ 边界框是否完整包含人脸

□ 边界框是否过大(包含过多背景)

□ 关键点位置是否准确

□ 遮挡标记是否正确

□ 属性标注是否合理

质量指标:

- 边界框IoU > 0.9

- 关键点误差 < 3像素

- 属性准确率 > 95%

姿态标注质量检查:

检查项目:

□ 关键点是否在正确的解剖位置

□ 骨骼连接是否合理(无交叉、无异常长度)

□ 可见性标注是否正确

□ 多人场景ID是否正确分配

质量指标:

- 关键点误差 < 5像素

- 骨骼长度比例合理

- ID一致性 > 99%

行为标注质量检查:

检查项目:

□ 动作分类是否正确

□ 时间边界是否准确

□ 是否有遗漏的动作

□ 多人动作是否正确关联

质量指标:

- 分类准确率 > 95%

- 时间边界误差 < 0.5秒

- 漏标率 < 3%

📊 实战案例分析

案例1:智慧园区人脸门禁系统

项目背景:

某科技园区需要部署人脸识别门禁系统,支持10,000+员工的快速通行,要求识别准确率>99.5%,通行速度<1秒。

数据需求:

- 每人采集多角度、多光照条件的人脸图像

- 需要处理戴口罩、戴眼镜等遮挡情况

- 需要区分真人和照片/视频攻击

标注方案:

第一阶段:基础人脸数据(2周)

采集规格:

- 每人采集20张照片

- 角度:正面、左侧15°、右侧15°、俯视15°、仰视15°

- 光照:正常光、强光、逆光、侧光

- 表情:中性、微笑

标注内容:

- 人脸边界框

- 5点关键点

- 人员ID

- 采集条件标签

第二阶段:遮挡数据(1周)

采集规格:

- 戴口罩(医用口罩、N95口罩)

- 戴眼镜(普通眼镜、墨镜)

- 戴帽子(棒球帽、毛线帽)

- 组合遮挡

标注内容:

- 人脸边界框(包含遮挡物)

- 可见关键点

- 遮挡类型和程度

- 人员ID

第三阶段:活体检测数据(1周)

采集规格:

- 真人视频(眨眼、转头、张嘴)

- 攻击样本(照片、视频、3D面具)

标注内容:

- 真人/攻击标签

- 攻击类型

- 动作序列标注

使用TjMakeBot的优势:

- AI自动检测人脸位置,人工只需微调

- 批量导入人员信息,自动关联ID

- 支持视频逐帧标注,保持ID一致性

项目成果:

- 标注数据量:200,000+张图片

- 标注准确率:99.2%

- 模型识别准确率:99.7%

- 活体检测准确率:99.5%

案例2:商场客流行为分析

项目背景:

某连锁商场希望通过AI分析顾客行为,优化店铺布局和营销策略。需要识别顾客的行走路径、停留时间、互动行为等。

标注任务:

任务1:人体检测与跟踪

- 检测画面中所有顾客

- 跨摄像头跟踪同一顾客

- 记录行走轨迹

任务2:姿态估计

- 标注人体17个关键点

- 用于分析顾客姿态(站立、弯腰、蹲下等)

任务3:行为识别

- 浏览:在货架前停留观看

- 拿取:从货架拿取商品

- 放回:将商品放回货架

- 试用:试穿/试用商品

- 交谈:与店员或同伴交谈

- 结账:在收银台付款

标注流程:

第一步:视频预处理

- 将监控视频按小时切分

- 筛选有效片段(有顾客活动)

- 统一视频格式和分辨率

第二步:人体检测标注

- 使用AI预标注人体边界框

- 人工审核和修正

- 分配跟踪ID

第三步:姿态标注

- 对关键帧进行姿态标注

- 使用插值算法生成中间帧

- 人工检查异常帧

第四步:行为标注

- 标注每个顾客的行为序列

- 记录行为起止时间

- 标注行为发生的区域

第五步:质量审核

- 交叉验证标注一致性

- 专家审核异常样本

- 生成质量报告

项目成果:

- 标注视频时长:500+小时

- 标注人体数量:100,000+

- 行为标注数量:50,000+

- 行为识别准确率:91.3%

业务价值:

- 发现热门区域和冷门区域

- 优化商品陈列位置

- 识别高价值顾客行为模式

- 提升转化率15%

案例3:校园安全异常行为检测

项目背景:

某市教育局为全市中小学部署AI安全监控系统,需要实时检测校园内的异常行为,包括打架、摔倒、翻越围墙等。

核心挑战:

- 异常行为样本稀少(正常:异常 > 1000:1)

- 需要快速响应(检测延迟<3秒)

- 误报率要求极低(避免频繁误报)

数据策略:

1. 正常行为数据

- 来源:日常监控录像

- 规模:10,000+小时

- 标注:抽样标注,每小时抽取10分钟

2. 异常行为数据

- 来源:历史事件录像 + 模拟演练

- 规模:500+小时

- 标注:全量精细标注

3. 数据增强

- 对异常行为视频进行增强

- 时间拉伸/压缩

- 镜像翻转

- 亮度/对比度调整

异常行为标注规范:

打架行为:

- 定义:两人或多人之间的肢体冲突

- 特征:推搡、拳打、脚踢、扭打

- 标注:涉及人员、起止时间、严重程度

摔倒行为:

- 定义:人体从站立状态突然倒地

- 特征:身体失去平衡、快速下落、倒地不起

- 标注:摔倒人员、摔倒时间、是否自行起身

翻越行为:

- 定义:跨越围墙、护栏等障碍物

- 特征:攀爬、跨越、跳跃

- 标注:翻越人员、翻越位置、翻越方向

聚集行为:

- 定义:多人在同一区域异常聚集

- 特征:人数>5人、持续时间>3分钟

- 标注:聚集区域、人数、持续时间

项目成果:

- 覆盖学校:200+所

- 标注视频:2,000+小时

- 异常检测准确率:94.5%

- 误报率:<2%

- 平均响应时间:1.8秒

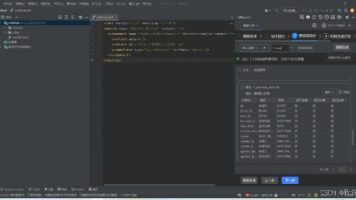

🛠️ TjMakeBot安防标注功能

人脸标注工具

自动人脸检测:

- AI自动定位图像中的所有人脸

- 支持多人脸同时检测

- 自动生成边界框

关键点标注:

- 支持5点、68点、106点方案

- 智能吸附功能,提高标注精度

- 批量复制关键点模板

属性标注:

- 预设属性选项,快速选择

- 支持自定义属性

- 批量修改属性

人体姿态工具

骨架标注:

- 可视化骨架连接

- 关键点拖拽调整

- 自动检测异常姿态

视频跟踪:

- 自动跟踪同一人物

- ID管理和切换

- 轨迹可视化

行为标注工具

时间轴标注:

- 可视化时间轴

- 拖拽调整时间边界

- 多轨道并行标注

动作模板:

- 预设常见动作类型

- 快捷键快速标注

- 支持自定义动作

隐私保护

数据脱敏:

- 人脸自动模糊

- 敏感区域遮挡

- 元数据清理

访问控制:

- 分级权限管理

- 操作日志记录

- 数据加密存储

⚖️ 隐私与合规考量

数据采集合规

知情同意:

- 在数据采集区域设置明显告示

- 获取数据主体的明确同意

- 提供退出机制

最小必要原则:

- 只采集必要的数据

- 限制数据保存期限

- 定期清理过期数据

数据处理合规

数据脱敏:

- 训练数据与个人身份解耦

- 使用匿名ID替代真实身份

- 敏感属性进行模糊处理

访问控制:

- 严格的权限管理

- 操作留痕可追溯

- 定期安全审计

模型部署合规

用途限制:

- 明确AI系统的使用范围

- 禁止未授权的用途

- 建立滥用举报机制

透明度:

- 公开AI系统的能力和局限

- 提供人工复核渠道

- 接受监管部门审查

💬 结语

安防监控AI是一个技术与伦理并重的领域。高质量的数据标注是构建可靠AI系统的基础,而合规的数据处理则是赢得公众信任的前提。

核心要点回顾:

- 人脸标注:精确的边界框、准确的关键点、合理的属性分类

- 姿态标注:标准的关键点定义、正确的可见性标注、一致的ID管理

- 行为标注:清晰的动作定义、准确的时间边界、完整的事件记录

- 质量控制:多级审核、交叉验证、持续改进

- 隐私合规:知情同意、数据脱敏、访问控制

TjMakeBot为安防AI标注提供了专业的工具支持,从人脸检测到行为识别,从单帧标注到视频跟踪,帮助你高效构建安防数据集,同时确保数据处理的合规性。

让AI守护安全,从负责任的数据标注开始!

📚 相关阅读

- 数据标注中的认知偏差-如何避免标注错误

- 视频标注新方法-从视频到帧的智能转换

- 小团队如何高效协作标注-5个实战策略

- 从LabelImg到TjMakeBot-标注工具的进化史

- 医疗影像AI标注-精度要求与合规挑战

- 工业质检AI:缺陷检测标注的5个关键技巧

- 自动驾驶数据标注-L4-L5级别的数据挑战

- 免费vs付费标注工具:如何选择最适合你的?

- YOLO数据集制作完整指南:从零到模型训练

- 告别手动标注-AI聊天式标注如何节省80%时间

- 为什么很多AI项目失败?数据标注质量是关键

- 扑克牌游戏类型、人数,发牌和出牌自动识别与分析的AI模型

关键词:安防AI、人脸识别、行为识别、姿态估计、监控分析、智能安防、TjMakeBot

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)