【AI赋能资讯分发】用户行为推荐+分布式存储+热点算法深度解析

本系统通过采集用户浏览、点击、点赞等行为数据,利用机器学习算法构建用户画像,实现个性化推荐。同时,采用分布式存储架构处理海量数据,确保系统的高可用性和扩展性。内容质量评估模型则运用自然语言处理技术,对资讯进行多维度评分,避免低质内容传播。实时热点追踪算法结合时间衰减和流行度指标,动态捕捉社会热点,实现即时响应。整体而言,本文从系统架构入手,深入剖析各模块的技术原理、实现流程和优化策略,提供可落地的

【精选优质专栏推荐】

- 《AI 技术前沿》 —— 紧跟 AI 最新趋势与应用

- 《网络安全新手快速入门(附漏洞挖掘案例)》 —— 零基础安全入门必看

- 《BurpSuite 入门教程(附实战图文)》 —— 渗透测试必备工具详解

- 《网安渗透工具使用教程(全)》 —— 一站式工具手册

- 《CTF 新手入门实战教程》 —— 从题目讲解到实战技巧

- 《前后端项目开发(新手必知必会)》 —— 实战驱动快速上手

每个专栏均配有案例与图文讲解,循序渐进,适合新手与进阶学习者,欢迎订阅。

文章概述

本文介绍了一种基于用户行为分析的个性化资讯分发系统,该系统整合了推荐引擎、分布式存储、内容质量评估模型以及实时热点追踪算法,旨在为用户提供精准、高效的资讯推送服务。在当今信息爆炸的时代,用户面临海量内容的选择难题,而传统分发模式往往忽略个体差异,导致用户体验不佳。本系统通过采集用户浏览、点击、点赞等行为数据,利用机器学习算法构建用户画像,实现个性化推荐。同时,采用分布式存储架构处理海量数据,确保系统的高可用性和扩展性。内容质量评估模型则运用自然语言处理技术,对资讯进行多维度评分,避免低质内容传播。实时热点追踪算法结合时间衰减和流行度指标,动态捕捉社会热点,实现即时响应。整体而言,本文从系统架构入手,深入剖析各模块的技术原理、实现流程和优化策略,提供可落地的实践代码示例,并讨论常见误区及解决方案。

引言

在数字化时代,资讯分发已成为连接用户与内容的桥梁。随着移动互联网的普及,用户每天接触的资讯量呈指数级增长,但如何从海量数据中筛选出符合个人兴趣的内容,成为行业痛点。传统的内容分发往往依赖编辑人工 curation 或简单规则-based 推送,无法适应用户动态偏好,导致点击率低下和用户流失。个性化资讯分发系统的出现,正是为了解决这一问题,它通过数据驱动的方式,实现“千人千面”的内容推荐。

本系统以用户行为分析为核心,构建推荐引擎,同时融入分布式存储来应对大数据挑战。内容质量评估模型确保推送内容的可靠性和价值,而实时热点追踪算法则捕捉瞬息万变的热点事件。这种多模块协同的架构,不仅提升了系统的实时性和准确性,还降低了运营成本。根据相关研究,如Netflix的个性化推荐实践,该类系统可将用户留存率提高30%以上。本文将系统地阐述该系统的设计思路、技术方案和实施细节,为从业者提供全面指导。

技术方案

个性化资讯分发系统的技术方案围绕四个核心模块展开:用户行为分析推荐引擎、分布式存储系统、内容质量评估模型以及实时热点追踪算法。这些模块相互协作,形成一个闭环生态。

推荐引擎采用混合推荐策略,结合协同过滤和内容-based 方法,利用用户历史行为数据生成个性化列表。分布式存储则选用Hadoop分布式文件系统(HDFS)和Apache Spark作为计算框架,确保数据的高效存储和处理。内容质量评估模型基于BERT等预训练语言模型,进行语义理解和质量评分。实时热点追踪算法运用时间衰减函数和流行度指标,实现对热点的动态监测。

在整体架构上,系统采用微服务设计,前端通过API Gateway接入用户请求,后端模块间通过消息队列(如Kafka)实现异步通信。这种方案不仅提高了系统的可扩展性,还便于模块独立升级。根据行业实践,如阿里巴巴的智能推荐服务,该架构能处理每日亿级用户行为数据,确保毫秒级响应。

流程介绍

个性化资讯分发系统的运行流程可分为数据采集、处理、推荐生成和反馈优化四个阶段。

首先,数据采集阶段通过埋点技术捕获用户行为,如页面停留时间、分享动作等,这些数据实时流入Kafka队列。随后,处理阶段利用Spark进行ETL(Extract-Transform-Load)操作,将原始数据清洗并存储至HDFS。推荐生成阶段激活引擎,根据用户画像计算相似度,结合内容质量评估和热点追踪结果,形成推送列表。最后,反馈优化阶段收集用户交互反馈,更新模型参数,实现闭环迭代。

整个流程强调实时性和离线计算的结合:实时路径处理即时行为,离线路径每日批量训练模型。这种设计确保了系统的鲁棒性,在高峰期也能稳定运行。

核心内容解析

用户行为分析的推荐引擎是系统的基础,它通过深度挖掘用户交互数据,实现精准推送。引擎首先构建用户画像,利用向量空间模型表示用户偏好,例如将浏览历史转化为TF-IDF向量,然后运用协同过滤算法计算用户间相似度。基于用户的协同过滤假设相似用户有相似兴趣,因此通过余弦相似度公式cos(θ) = (A·B) / (|A||B|)找出邻居用户,并推荐其喜好内容。同时,内容-based 推荐补充了冷启动问题,通过提取资讯的关键词和主题标签,匹配用户历史向量。这种混合策略避免了单一算法的局限性,提升了推荐的多样性和准确率。在实际应用中,引擎还融入矩阵分解技术,如SVD(Singular Value Decomposition),将用户-内容矩阵降维,减少噪声影响,从而在海量数据中高效运算。

分布式存储在系统中扮演数据基石角色,它处理资讯和行为日志的存储与检索。采用HDFS的分布式架构,将数据分片存储于多个节点,确保高可用性和容错性。例如,当节点故障时,NameNode自动切换备份,DataNode通过心跳机制维持一致性。结合Spark的RDD(Resilient Distributed Datasets)抽象,系统实现并行计算,如在用户行为分析中,对日志进行MapReduce操作,快速聚合点击率指标。这种存储方案不仅支持横向扩展,还优化了I/O瓶颈,通过内存计算加速查询速度。在推荐场景下,分布式存储允许实时更新用户向量,避免了传统数据库的单点压力,确保系统在亿级数据规模下的稳定性。

内容质量评估模型聚焦于过滤低质资讯,确保推送内容的价值性。模型基于预训练的BERT框架,进行多维度评估,包括语义连贯性、事实准确性和情感中立性。首先,通过注意力机制捕捉文本上下文,生成嵌入向量,然后利用分类头输出分数。例如,对一篇资讯,模型计算其与标准语料的相似度,并检测潜在偏见,如使用KL散度衡量分布差异。这种方法超越了传统关键词匹配,实现了语义级理解。在实践中,模型还集成反馈循环,用户举报机制作为监督信号,fine-tune 参数,提高评估精度,从而减少假新闻传播的风险。

实时热点追踪算法则赋予系统动态响应能力,它通过监控社交媒体和搜索趋势,捕捉新兴事件。算法采用时间衰减模型,如热度分数H = Σ (互动量 / (当前时间 - 发布时间)^α),其中α为衰减因子,通常设为1.5,以模拟热点衰减规律。同时,结合聚类算法如DBSCAN,对关键词进行分组,识别突发话题。这种算法不仅追踪热度峰值,还预测趋势演变,通过ARIMA时间序列模型分析历史数据,预估未来流行度。在资讯分发中,该算法与推荐引擎融合,确保热门内容优先推送,提升用户黏性。

这些模块的协同形成了系统的核心竞争力,通过数据流转实现端到端优化。

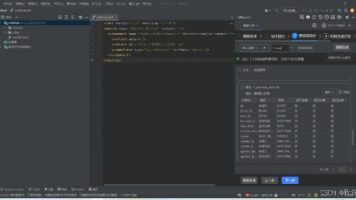

实践代码

以下是Python实现的推荐引擎核心部分示例,使用Scikit-learn库构建协同过滤模型。代码包括用户行为数据处理、相似度计算和推荐生成,带有详细注释。

import numpy as np

from sklearn.metrics.pairwise import cosine_similarity

from sklearn.decomposition import TruncatedSVD

import pandas as pd

# 步骤1: 加载用户行为数据(假设CSV格式,列包括user_id, item_id, rating)

def load_data(file_path):

"""

加载用户-内容交互数据。

参数:

file_path: 数据文件路径。

返回:

DataFrame: 用户行为数据框。

"""

data = pd.read_csv(file_path)

# 数据清洗:去除无效记录

data = data.dropna()

return data

# 步骤2: 构建用户-内容矩阵

def build_matrix(data):

"""

将行为数据转换为矩阵形式。

参数:

data: 用户行为DataFrame。

返回:

matrix: 用户-内容评分矩阵(稀疏)。

user_map, item_map: 用户和内容ID映射。

"""

users = data['user_id'].unique()

items = data['item_id'].unique()

user_map = {u: i for i, u in enumerate(users)}

item_map = {it: j for j, it in enumerate(items)}

matrix = np.zeros((len(users), len(items)))

for _, row in data.iterrows():

u_idx = user_map[row['user_id']]

it_idx = item_map[row['item_id']]

matrix[u_idx, it_idx] = row['rating'] # rating可为点击/点赞分数

return matrix, user_map, item_map

# 步骤3: 矩阵分解降维

def decompose_matrix(matrix, n_components=50):

"""

使用SVD降维,减少噪声。

参数:

matrix: 原矩阵。

n_components: 保留维度数。

返回:

reduced_matrix: 降维后矩阵。

"""

svd = TruncatedSVD(n_components=n_components)

reduced_matrix = svd.fit_transform(matrix)

return reduced_matrix

# 步骤4: 计算用户相似度并生成推荐

def recommend(user_id, matrix, user_map, item_map, top_n=10):

"""

基于协同过滤生成推荐列表。

参数:

user_id: 目标用户ID。

matrix: 降维矩阵。

user_map, item_map: ID映射。

top_n: 推荐数量。

返回:

recommendations: 推荐内容ID列表。

"""

if user_id not in user_map:

return [] # 新用户冷启动处理

u_idx = user_map[user_id]

similarities = cosine_similarity([matrix[u_idx]], matrix)[0]

# 排除自身,选相似用户

similar_users = np.argsort(similarities)[-top_n-1:-1][::-1]

# 聚合相似用户喜好内容

rec_items = set()

for sim_u in similar_users:

user_items = np.where(matrix[sim_u] > 0)[0] # 非零评分内容

rec_items.update(user_items)

# 转换为实际ID

recommendations = [list(item_map.keys())[list(item_map.values()).index(it)] for it in rec_items]

return recommendations[:top_n]

# 示例使用

if __name__ == "__main__":

data = load_data('user_behavior.csv')

matrix, user_map, item_map = build_matrix(data)

reduced_matrix = decompose_matrix(matrix)

recs = recommend(1, reduced_matrix, user_map, item_map)

print("推荐内容:", recs)

此代码可扩展至分布式环境,如使用PySpark处理大规模数据。

常见误区与解决方案

在构建个性化资讯分发系统时,常见误区包括忽略数据隐私、过度依赖单一算法以及存储瓶颈导致的性能衰退。

首先,数据隐私误区:许多系统收集用户行为时未遵守GDPR等法规,易引发泄露风险。解决方案是通过差分隐私技术添加噪声,或采用联邦学习框架,仅传输模型梯度而非原始数据,确保合规性。

其次,算法单一性误区:仅用协同过滤可能导致“过滤气泡”,用户仅见相似内容。解决方案是引入多样性指标,如Intra-List Similarity,在推荐列表中强制加入异质内容,平衡准确与探索。

最后,存储瓶颈误区:在高并发下,传统数据库易崩溃。解决方案迁移至分布式系统,如使用Cassandra的NoSQL存储,支持线性扩展,并结合缓存层(如Redis)加速热数据访问。

总结

个性化资讯分发系统通过整合用户行为分析推荐引擎、分布式存储、内容质量评估模型和实时热点追踪算法,实现了高效、智能的内容推送。该系统不仅提升了用户满意度,还为平台带来了更高的 engagement 和 revenue。

更多推荐

已为社区贡献37条内容

已为社区贡献37条内容

所有评论(0)