别再只会单任务微调了!多任务微调让模型能力翻倍

大语言模型从单任务到多任务的微调技术演进 摘要:大语言模型通过预训练获得通用知识,但需微调适应特定任务。单任务微调虽能提升特定任务表现,但会导致灾难性遗忘。多任务微调通过同时训练多个任务,在保持通用能力的同时提升特定任务表现。核心挑战包括数据配比、负迁移和格式统一,需采用平方根采样等策略平衡任务权重。多任务微调可增强模型泛化能力,实现紧凑部署和均衡发展,是构建企业级AI的重要技术。LLaMA-Fa

从单任务到多任务的跨越

大语言模型在预训练阶段学习到了丰富的语言知识和世界知识,但这些知识是通用而分散的。要让模型在实际应用中发挥作用,通常需要对模型进行微调,使其适应特定的任务需求。最常见的微调方式是单任务微调,即针对一个具体的任务(如文本分类、问答、摘要生成等)收集标注数据,然后对模型进行微调。单任务微调的效果通常很好,模型在该任务上的表现可以显著提升。然而,单任务微调也有其局限性——模型在微调后往往会出现能力退化的问题,即模型在其他任务上的表现下降。

这种能力退化现象被称为灾难性遗忘(Catastrophic Forgetting)。当模型在特定任务上进行微调时,模型的权重会朝着优化该任务的方向调整,这可能导致模型之前学习到的通用能力被覆盖。例如,一个经过代码微调的模型可能变得不太擅长自然语言对话;一个经过医学问答微调的模型可能在通用常识问答上表现下降。灾难性遗忘的限制使得单任务微调难以满足实际应用的需求,因为在大多数场景下,我们期望模型不仅能够在特定任务上表现出色,还能够保持其通用能力。

多任务微调(Multi-task Fine-tuning)提供了一种解决灾难性遗忘的思路。与单任务微调不同,多任务微调同时使用多个任务的标注数据进行训练,模型在学习特定任务能力的同时,也在复习和巩固其他任务的能力。从理论上讲,多任务训练可以让模型学会如何在不同任务之间进行平衡,避免过度优化某个任务而忽视其他任务。更重要的是,多任务微调后的模型往往展现出更好的泛化能力——模型能够处理训练时未见过的任务,或者在相关任务上表现出色。

多任务微调的核心挑战

多任务微调虽然听起来简单,但实际实施时面临着诸多挑战。首要的挑战是数据混合问题。在多任务训练中,不同任务的数据如何混合直接影响训练效果。如果某个任务的数据量过大,模型会过度偏向该任务;如果某个任务的数据量过小,模型可能无法学习到该任务的能力。确定各任务数据的混合比例是一个需要大量实验的工程问题。

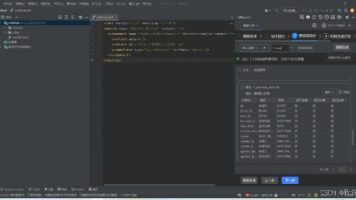

一种常用的数据混合策略是等比例混合,即每个任务的每个批次中包含相同数量的样本。这种方法简单直观,但忽略了不同任务的数据量和学习难度差异。另一种策略是按数据规模比例混合,大任务的数据量多,小任务的数据量少,按比例混合可以保证各任务的相对权重。更精细的策略会考虑任务的学习速度——对于学习快的任务减少采样权重,对于学习慢的任务增加采样权重。LLaMA-Factory Online多任务训练模块提供了灵活的数据混合配置,支持多种混合策略的组合使用,开发者可以根据具体需求进行调整。

任务间的负迁移是另一个需要关注的问题。虽然多任务学习的初衷是让任务之间相互促进,但在某些情况下,不同任务之间可能存在冲突,模型在学习一个任务的同时可能损害另一个任务的表现。这种负迁移现象在任务之间的输入或输出分布差异较大时更容易发生。缓解负迁移的方法包括任务分组、梯度隔离等。任务分组将相关任务放在同一组中训练,不相关任务分开训练;梯度隔离通过修改优化算法,防止某个任务的梯度主导更新方向。

多任务数据的格式统一也是一个需要解决的问题。不同任务的数据格式可能不同——有的任务是输入-输出格式,有的是对话格式,有的是选择题格式。在多任务训练中,需要将这些不同格式的数据统一为模型可以处理的形式。常用的做法是设计统一的任务模板(Prompt Template),将不同任务的数据转换为统一的输入-输出格式。这个模板不仅需要能够容纳不同任务的内容,还需要包含任务指示信息,让模型知道当前处理的是什么任务。设计一个好的任务模板是多任务训练成功的关键因素之一。

数据配比与训练策略

多任务微调中,数据配比是最核心也最棘手的问题。不同任务的数据规模可能相差数个数量级——常见的任务如文本分类可能有数万条样本,而专业领域的任务可能只有数千条甚至数百条样本。如何在保证各任务都有足够数据的同时,又不让大数据量的任务淹没小数据量的任务,需要精心设计数据配比方案。

一种经验性的数据配比方法是平方根采样(Square Root Sampling)。其基本思想是,每个任务的采样概率与其数据量的平方根成正比,而不是与数据量成正比。这种方法可以有效缓解数据量差异带来的不平衡问题。例如,任务A有10000条数据,任务B有100条数据。如果按数据量比例采样,任务A的采样概率是任务B的100倍;如果按平方根比例采样,任务A的采样概率是任务B的10倍,差异大大缩小。平方根采样是一个好的起点,但实际应用中可能需要根据任务特点和实验结果进行进一步调整。

除了采样概率,数据的多样性也至关重要。同一任务内的数据应该覆盖各种不同的情况,避免模型过拟合到数据的某些特定模式。在构建多任务数据集时,需要注意数据的多样性和代表性。如果某个任务的数据高度相似(如都围绕同一主题),即使数据量很大,模型学到的东西也可能很有限。相反,即使某个任务的数据量较小,但如果数据覆盖了任务的各种情况,模型也能够学到有效的知识。

多任务训练的技巧还包括任务轮换(Task Rotation)和课程学习(Curriculum Learning)。任务轮换是指在训练过程中定期切换主任务,保持模型对各任务都有响应。课程学习是指按照任务的难度或学习曲线安排训练顺序,先学习简单的任务,再学习复杂的任务。这些技巧可以帮助模型更好地学习多任务,减少任务间的干扰。LLaMA-Factory Online多任务训练框架支持这些高级训练策略的灵活配置,开发者可以在平台上进行实验,找到最适合自己任务的训练方案。

多任务微调的应用价值

多任务微调在实际应用中具有重要的价值。首先,多任务微调后的模型可以作为更强的基座模型,用于各种下游任务的进一步微调。相比于单任务微调的模型,多任务微调的模型具有更好的泛化能力和更平稳的学习曲线,在新的任务上通常能够取得更好的效果。这种迁移学习的优势使得多任务微调成为构建企业级AI能力的重要环节。

其次,多任务微调可以实现更紧凑的模型部署。在传统方案中,每个任务可能需要部署一个单独的模型,这带来了维护成本高、资源占用大、推理延迟长等问题。通过多任务微调,可以将多个任务的能力融合到同一个模型中,实现一个模型服务多种需求。这种方案不仅降低了系统复杂度,还减少了推理时的计算开销。

此外,多任务微调有助于模型能力的均衡发展。在实际应用中,用户的需求是多样且变化的,他们可能在一个对话中同时提出不同类型的问题。如果模型在某些任务上表现很差,即使其他任务表现再好,用户体验也会受到影响。通过多任务微调,可以让模型在各个任务上都达到可接受的水平,提供更一致的用户体验。

多任务微调是大模型后训练的重要技术,它能够让模型从单面手变成多面手,更好地满足实际应用中的多样化需求。虽然多任务微调在实施过程中面临着数据配比、任务干扰等挑战,但通过合理的策略设计和工具支持,这些问题都可以得到有效解决。[LLaMA-Factory Online](https://www.llamafactory.com.cn/register?utm_source=jslt_csdn_ldd)提供了完整的多任务微调解决方案,包括数据混合配置、任务模板设计、训练策略优化等功能,帮助开发者快速构建高质量的多任务模型。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)