2026年AI法规更新:软件测试从业者的策略大调整

2026年全球AI监管进入严苛时代,中欧新法规将AI安全纳入法定框架,要求全生命周期风险管理。这推动测试行业从功能验证扩展到数据安全、算法偏见等维度,测试从业者角色升级为AI治理工程师。法规带来三大变革:测试范围扩展、时效性提升和责任边界扩大。应对策略包括技术升级(AI赋能工具)、流程优化(测试左移)、能力建设(跨职能协作)和持续改进。未来测试将趋向自治化、全球化,从业者需前瞻布局,把握专业发展机

法规浪潮下的测试行业转型

2026年标志着全球AI监管的转折点,中国新修订的《网络安全法》已于1月1日正式实施,首次将AI安全纳入法定框架,要求企业对AI系统进行全生命周期风险管理,违规处罚可达千万级罚款。 欧盟《人工智能法案》也在同期开出首张2亿欧元罚单,针对聊天机器人因测试疏漏导致的伦理危机。 这些变化不仅增加了软件测试从业者的合规压力,更重塑了测试工作的核心范畴——从传统功能验证扩展到数据安全、算法偏见和实时监控等维度。 本文将从专业视角解析2026年AI法规的关键更新,分析其对测试工作流的影响,并提出可落地的策略优化方案,助力测试团队从被动响应转向主动治理。

一、2026年AI法规核心更新与行业背景

2026年全球AI监管进入严苛时代,立法趋势从自愿准则转向硬法约束。中国《网络安全法》新增“人工智能安全监管”条款,强调国家支持AI基础理论研发与安全治理并重,要求建立全链路数据防护机制。 例如,法规明确企业对开源AI工具的数据泄露承担连带责任,测试案例必须覆盖数据外发权限、动态加密和异常操作预警。 同时,欧盟《人工智能法案》对高风险AI系统(如招聘或医疗应用)实施准入制,强制内容透明度(如AI生成文本需带数字水印),违规处罚可达年收入4%。 美国州级法案(如加州SB1047)推动数据跨境限制,而联合国框架倡导互操作性标准,这些变化形成全球性合规压力网。 对测试从业者而言,法规的核心要求可概括为三点:

-

动态防护义务:测试需覆盖AI系统全生命周期,包括设计、部署和监控阶段,而非仅上线前验证。

-

伦理与安全集成:新增强制性伦理测试认证,如中国《人工智能系统可测试性认证管理办法》要求所有AI系统上线前通过严格审查,聚焦透明度、公平性和可追溯性。

-

实时响应机制:法规强调风险监测的即时性,测试团队必须确保AI系统能实时适应新规,例如欧盟法案新增漏洞扫描要求后,AI响应延迟率需低于10%。

这些更新源于AI技术快速普及的衍生风险。2025年数据显示,生成式AI衍生虚假信息、数据隐私侵犯等事件激增40%,如某AI大模型在测试疏漏下生成违背军人形象的误导性内容,引发社会公序良俗危机。 若不及时调整测试策略,企业不仅面临巨额罚款,还可能触发刑事风险(如非法侵入计算机系统罪),测试从业者的专业角色正从质量保证者升级为AI治理工程师。

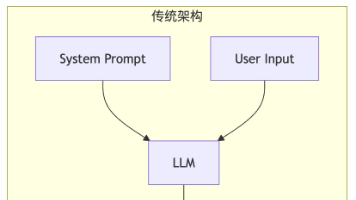

二、法规对软件测试工作的颠覆性影响

AI法规更新直接重塑测试工作流,引入多维挑战。首先,测试范围大幅扩展。传统功能验证(如UI和性能测试)已不足够,法规要求覆盖数据安全、算法偏见和伦理一致性等新维度。 例如,《生成式AI服务管理暂行办法》强制测试用例包括内容标识(如虚假信息检测)和版权侵权扫描,遗漏高风险场景(如青少年心理危机输入)可导致系统输出有害响应,引发类似欧盟2亿欧元罚单事件。 其次,测试时效性要求提升。法规强调“动态防护”,测试需从静态脚本转向实时监控。案例显示,AI系统对新法规知识(如2026年网络安全法第20条)的召回误差率达20%,若未集成持续测试机制,可能导致跨境数据传输违规。 最后,责任边界扩大。测试团队需对第三方工具(如开源AI库)的数据泄露承担连带责任,要求测试案例验证跨场景数据流的安全性。

具体影响可归纳为三大工作流变革:

-

测试设计转型:用例生成需采用风险驱动方法(如STRIDE威胁建模),优先级矩阵将“人身安全影响”设为P0级。例如,针对心理健康聊天机器人,测试必须模拟极端场景(如用户输入“我活不下去了”),验证安全协议触发率100%。

-

工具链重构:传统自动化工具(如Selenium)需升级为AI赋能方案(如Sentinel MentalGuard),以增强心理安全测试,并嵌入CI/CD流水线实现实时合规扫描。 市场数据显示,2026年AI测试工具需求增长30%,测试从业者应优先采购支持ISO/IEC 5338标准的解决方案。

-

协作模式进化:测试从孤立活动转向跨职能整合。法规要求测试团队与法务、伦理部门共建“AI安全委员会”,制定《测试合规指南》,明确禁止红线(如大规模监控)。 忽视协作可能导致测试盲点,如某金融公司因AI未识别新数据驻留法而违规。

三、软件测试从业者的四维应对策略

面对法规压力,测试团队需构建系统性策略框架,兼顾合规与效率。策略核心是“测试左移”和“AI赋能”,确保风险预防而非事后补救。

1. 技术升级:嵌入法规合规性驱动测试

-

风险导向测试设计:采用OWASP AI安全指南,开发用例覆盖法规特定要求。例如,针对数据安全新规,设计测试验证动态加密(如AES-256)和审计机制;针对伦理条款,使用工具如IBM AI Fairness 360扫描算法偏见,确保公平性偏差低于5%。 测试数据需模拟真实场景,如输入“军人、文身”提示词验证内容合规性,避免生成误导性图片。

-

AI自治测试工具整合:部署生成式AI模型(如GPT-4o)自动生成覆盖率95%的测试用例,并通过强化学习模拟用户行为,减少漏报率40%。 结合自愈脚本工具(如Testim.io)修复UI变更,维护成本降低63%。市场推荐方案包括MLflow(模型管理)和DeepChecks(数据验证),确保测试高效且符合ISO/IEC 5338。

2. 流程优化:构建抗脆弱测试体系

-

短期行动:在CI/CD流水线嵌入伦理测试阶段,实现“合规即代码”。例如,自动化脚本生成实时合规报告,监控法规知识时效性(如新规响应延迟率)。 同时,组织欧盟AI法案工作坊,提升团队对高风险系统要求的认知。

-

长期战略:推动测试左移至设计阶段,通过威胁建模(如STRIDE框架)在需求分析时识别AI特有风险(如深度伪造),降低后期修复成本50%。 建立月度“测试—开发—合规”评审会,同步风险并调整用例。

3. 能力建设与跨职能协作

-

技能提升:测试从业者需掌握新技术(如可解释性框架SHAP)和软技能(如伦理决策),参加“AI测试工程师”资格考试(2026年纳入国家职业标准)。 年度培训应覆盖法规更新(如中国网络安全法细则)和工具应用(如Sauce Labs)。

-

组织变革:成立跨部门AI安全委员会,联合法务制定测试红线。案例中,金融企业通过监管合作预认证AI模型,测试报告需包含合规清单(如算法备案记录),避免整改处罚。

4. 案例驱动的持续改进

-

教训吸取:分析欧盟罚单事件,测试团队主导第三方审计避免自查盲点。涉事聊天机器人因遗漏压力测试(如青少年情绪输入)导致伦理危机,事后整改通过关键词库更新和语义识别优化阻断违规内容。

-

最佳实践:在中国合规实践中,企业采用红队演练验证系统抗攻击能力,并结合多Agent协议缩短测试周期70%。

四、未来展望:测试作为合规核心驱动力

2026年AI法规将持续演进,测试从业者需前瞻布局三大趋势。首先,测试自治将主导行业,AI算法成本降低60%,推动测试从“劳动密集型”转向“智能密集型”,到2030年市场规模突破千亿。 其次,全球化标准互认加速(如ISO/IEC 5338),测试需适应跨境合规要求,避免如美国数据限制法案的冲突。 最后,测试角色升级为战略伙伴,通过“测试驱动AI治理”确保创新与安全的平衡。 从业者应持续学习(如年度伦理培训),并参与国际标准制定,以保持竞争力。

结语:拥抱变革,引领AI治理新时代

2026年AI法规更新不仅是挑战,更是测试行业专业化的契机。通过技术、流程和协作的全面优化,测试从业者能化合规压力为创新动力,为智能时代筑牢安全防线。

精选文章

更多推荐

已为社区贡献428条内容

已为社区贡献428条内容

所有评论(0)