解决算力瓶颈,给多模态瘦身!Token压缩完整图谱与选型指南

北京大学等联合团队深入剖析了多模态大模型Token压缩技术的全貌,从视觉编码器、投影器到语言模型的全链路优化策略,并揭示高效多模态智能的未来演进路径。给多模态大模型瘦身已成为解决算力瓶颈的关键。Token压缩技术通过剔除视觉冗余,在保留核心语义的同时实现了训练与推理效率的指数级提升。北京大学等联合团队深入剖析了多模态大模型Token压缩技术的全貌,从视觉编码器、投影器到语言模型的全链路优化策略,并

北京大学等联合团队深入剖析了多模态大模型Token压缩技术的全貌,从视觉编码器、投影器到语言模型的全链路优化策略,并揭示高效多模态智能的未来演进路径。

给多模态大模型瘦身已成为解决算力瓶颈的关键。

Token压缩技术通过剔除视觉冗余,在保留核心语义的同时实现了训练与推理效率的指数级提升。

北京大学等联合团队深入剖析了多模态大模型Token压缩技术的全貌,从视觉编码器、投影器到语言模型的全链路优化策略,并揭示高效多模态智能的未来演进路径。

给开发者提供了多模态Token压缩技术的完整图谱与选型指南。

多模态大模型的算力围城

多模态大模型(MLLMs)通过整合视觉与语言能力,展现了惊人的感知与推理水平,如GPT-4o、LLaVA和Qwen-VL等系统已能处理复杂的开放式问答与文档理解任务。

这些强大的能力背后伴随着高昂的计算成本。

高分辨率图像与长视频会产生数以千计的视觉Token,而多轮对话与思维链推理进一步拉长了历史上下文。

由于Transformer架构中的注意力机制具有二次方复杂度,随着序列长度增加,内存消耗与延迟呈现爆炸式增长,这直接限制了模型的扩展性与实际部署。

多模态的效能与计算效率之间存在着天然的张力。

为了构建更高效的MLLMs,在保留关键跨模态语义的前提下,减少模型处理的Token数量,这就是Token压缩技术。

压缩操作瞄准了空间结构上的冗余(如重复的背景区域)、时间上的连续性(如视频帧间的相似性)以及模态间的对齐(如与文本无关的视觉信息)。

通过这些手段,原本冗长的序列被精简为短小精悍的语义载体。

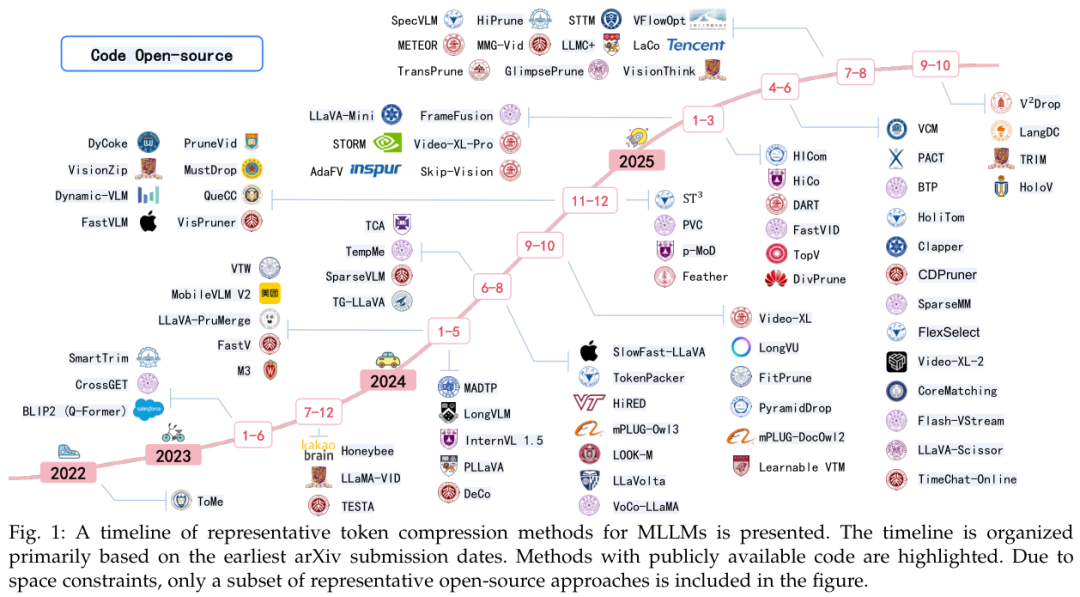

Token压缩最初源于纯视觉领域的ViT补丁丢弃与合并,现已演变为横跨视觉流、文本流及其融合层的复杂体系。

从早期的空间图像压缩,到如今面向长视频理解的极高压缩比技术,该领域在2024年后经历了爆发式增长。

如何在激进的压缩与细粒度的定位、时序连贯性之间取得平衡,是当前研究的核心。

压缩不仅仅是简单的删除,它是一个复杂的决策过程:在哪里压、怎么压、保留什么。

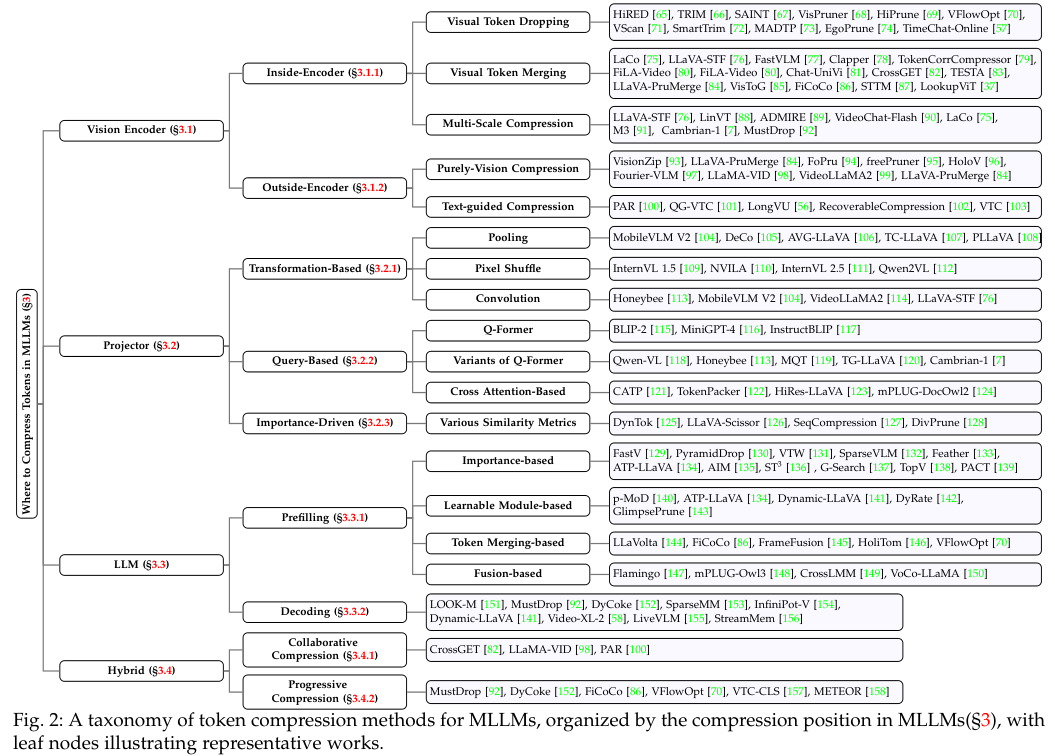

根据在模型中的应用位置,可以将现有的压缩技术系统地分为在视觉编码器、投影器以及大型语言模型这三个关键组件上的操作。

源头减负与语义筛选

视觉数据的冗余度天生远高于文本,一张高分辨率图像切分出的Patch Token数量往往是文本Token的数十倍。

如果将这些Token简单地与文本拼接,后续LLM的处理成本将无法承受。

视觉编码器(Vision Encoder, VE)作为处理视觉输入的第一站,在此处进行压缩能够产生贯穿整个系统的连锁效率增益。

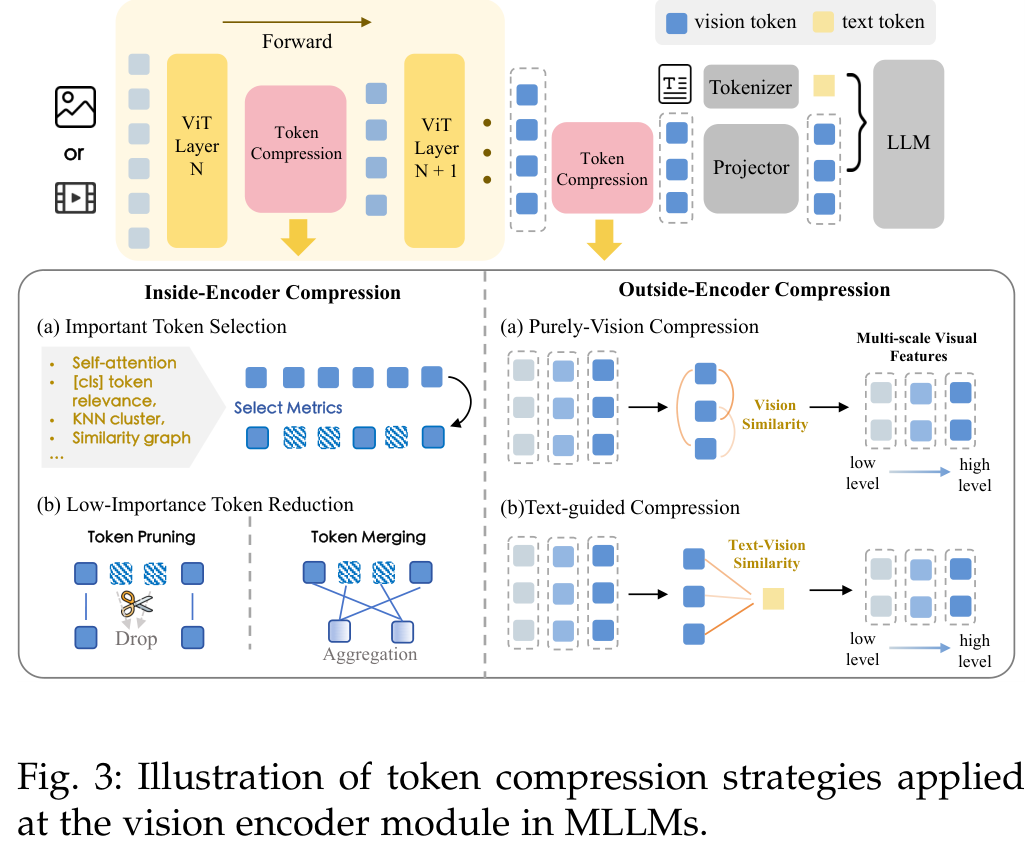

视觉编码器内的压缩(Inside-VE)直接改变了编码器内部的Token流向。

这种设计需要在模型早期阶段就减少自注意力的计算复杂度,并缩短Token的传播路径。

核心挑战在于如何识别不重要的Token,以及如何在多层网络中协调压缩策略以利用多尺度特征。

视觉Token丢弃是其中一种直观策略,它遵循“排序+Top-K”的范式,计算Token的重要性得分并丢弃低分者。

相似度评分是常用的衡量标准,如TRIM和SAINT等方法通过计算Token与全局表征(如CLS Token)的相似度,将高度相似的Token视为冗余并剔除。

这种方法利用了图像中相邻或背景区域往往具有重复信息的特性。

另一种流派利用注意力权重,VisPruner和HiPrune利用ViT中的注意力图来评估Token对整体理解的贡献。

单纯依赖注意力图可能会偏向显著性目标而忽略背景上下文,因此HoloV引入了全局视觉上下文来平衡前景与背景Token的保留。

还有一些方法利用启发式规则,如EgoPrune针对第一视角视频,利用几何稳定性优先保留运动相关区域,剔除静态背景。

视觉Token合并则采取了更温和的手段。

与直接删除不同,合并操作将相似的Token聚合成紧凑的表征,既减少了数量又保留了原始信息。

其基本原理是利用邻近冗余性:空间上相邻的Patch或时间上连续的帧往往包含高度重复的信息。

ToMe引入了二分图软匹配算法,在Transformer层之间高效地合并相似Token。

除了空间邻近,语义相似度也是合并的依据,FiCoCo等方法通过聚类将语义相似的Patch抽象为代表性Token。

这种软性策略特别适合那些需要保留全局语境但又要降低分辨率的场景。

多尺度压缩解决了单一尺度难以兼顾全局与细节的问题。

大部分MLLM提取ViT倒数第二层的特征,但这可能丢失低层纹理或高层语义。

LLaVA-STF提取多层ViT特征,通过卷积融合空间与语义信息。

METEOR采用分层策略,浅层基于相似度剪枝,深层基于注意力保留,实现了层级自适应压缩。

FastVLM则设计了混合视觉编码器,利用低分辨率分支处理全局信息,高分辨率分支捕捉细节,在极低的开销下实现了高效的目标检测。

视觉编码器输出后、进入投影器之前的压缩(Outside-VE)提供了即插即用的灵活性。

这里分为纯视觉压缩与文本引导压缩。

纯视觉方法如VisionZip,完全依赖视觉内容的自我相似性进行筛选,这种方法通用性强,不受用户指令干扰。

文本引导方法则更加智能,利用用户的查询(Query)来筛选视觉信息。

PAR将查询解析为实体和动作,以此重新加权视觉Token;QG-VTC计算问题与视觉的相似度,能够实现4倍到8倍的压缩且性能损失极小。

虽然文本引导能精准定位相关区域,但在视觉编码完成前,跨模态交互尚未充分建立,可能会引入偏差。

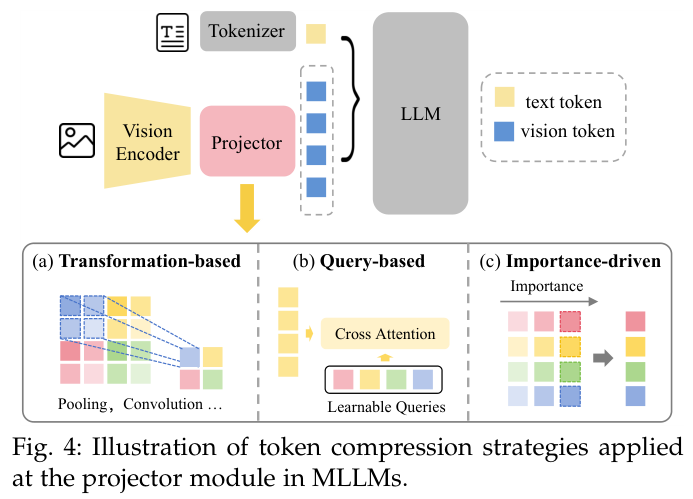

投影器作为信息瓶颈

投影器(Projector)是连接视觉编码器与LLM的桥梁,负责将视觉特征对齐到语言空间。

它天然适合作为信息的漏斗,将海量视觉嵌入压缩为少量的查询Token。

投影器的压缩策略主要分为基于变换、基于查询和基于重要性三类。

基于变换的压缩采用确定性的数学变换来减少Token数量,不依赖复杂的注意力机制。

池化(Pooling)是最简单有效的方法,MobileVLM V2提出的轻量级下采样投影器(LDP)利用2x2平均池化有效减少了Token数,同时促进了更快的收敛。

Pixel Shuffle则通过重排操作,将高分辨率的空间Token转换为通道维度更深的少量Token,这在InternVL 1.5等模型中得到了应用,实际上是用通道数换取了序列长度的缩减。

卷积不仅能下采样,还能通过可学习的卷积核整合局部信息,比单纯的池化更能保留特征细节,如Honeybee中的C-Abstractor结合了卷积与池化以增强局部上下文建模。

基于查询的压缩是目前最主流且灵活的范式,其代表是Q-Former。

Q-Former引入了一组可学习的查询向量(Query Queries),通过交叉注意力机制与冻结的视觉特征交互。

这些查询向量像探针一样,从海量视觉信息中提取出与任务最相关的特征,并将其压缩为固定数量的输出Token。

这种方法实现了极高的压缩比(数百个Token压为几十个),还充当了高效的视觉-语言对齐器。

Qwen-VL简化了这一结构,仅使用单层交叉注意力就达到了很好的效果。

为了解决Q-Former可能丢失细粒度空间信息的问题,Honeybee提出了保持局部性的变体,而MQT则允许动态调整查询数量以适应不同复杂度的图像。

有些方法放弃了可学习查询,转而使用交叉注意力机制直接筛选原始Token。

TokenPacker采用由粗到细的策略,先将下采样后的特征作为查询点,再通过交叉注意力从高分辨率特征中注入细节。

HiRes-LLaVA也利用下采样特征作为查询来聚合原始视觉信息。

这种方法的优势在于查询本身就携带了图像的先验信息,比随机初始化的查询向量更容易训练。

基于重要性的压缩在投影阶段通过评估Token价值来进行筛选。

DynTok利用视频帧内的信息密度差异,自适应地对视觉Token进行分组和合并,在高信息密度区域保留更多Token,在低信息密度区域进行高倍压缩。

LLaVA-Scissor提出语义连接组件(SCC)概念,将压缩视为图分割问题,避免了仅关注显著性物体而忽略背景语义的常见偏差。

SeqCompression的研究表明,基于聚类和聚合的策略通常优于单纯的剪枝,因为聚合能保留被合并Token的平均特征,而非直接丢弃。

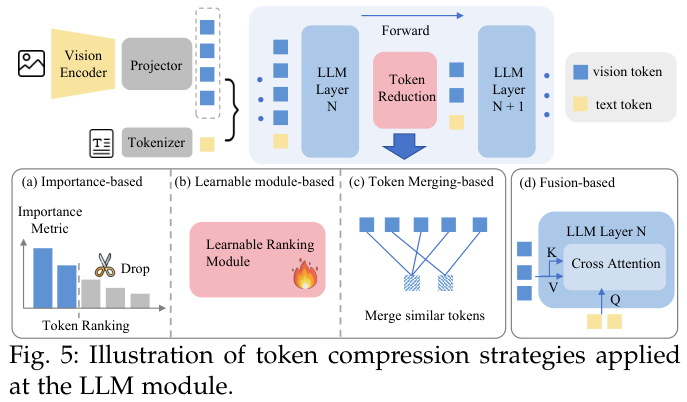

上下文管理与KV缓存优化

当视觉Token进入LLM后,它们与文本Token拼接成长序列。

由于LLM参数量巨大,这一阶段的计算成本最为高昂。

LLM层面的压缩主要针对两个阶段:预填充(Prefilling)和解码(Decoding)。

预填充阶段的压缩旨在减少首个前向传递过程中的Token数量。

一旦在浅层移除了某个视觉Token,深层将无法再访问该区域的信息,这对算法的鲁棒性提出了极高要求。

基于重要性的方法通过计算注意力分数来排名。

FastV观察到视觉Token在LLM深层的注意力分数远低于文本Token,表明存在极大的稀疏性,因此在第二层就根据注意力分数裁减了一半的视觉Token。

PyramidDrop发现视觉Token的冗余度随层数加深而增加,因而提出了多阶段递进式剪枝。

这里存在一个注意力偏差(Attention Bias)问题:Feather发现位于序列末尾的视觉Token往往会获得不成比例的高注意力分数(由于RoPE位置编码的衰减特性)。

为了修正这一点,Feather在计算重要性时移除了位置编码的影响。

AdaTP则引入额外的文本编码器来计算文本-视觉相似度,从而提供更平衡的重要性度量。

VScan选择从中间层而非浅层开始剪枝,以避开浅层注意力分布不稳定的问题。

Flash Attention兼容性是另一个技术难题。

Flash Attention的设计使得注意力分数无法直接获取。

如果为了排名而强行计算完整注意力图,会严重拖累推理速度。

虽然可以在特定层重新计算注意力,但这增加了延迟。

PACT和TopV等方法尝试绕过注意力分数,转而使用特征相似度、空间距离或隐藏层范数来评估Token重要性,从而保持硬件效率。

可学习模块为LLM内的压缩引入了动态能力。

p-MoD训练了一个轻量级预测器来决定每个Token的去留。

GlimpsePrune在ViT层面就预测Token在LLM中的重要性。

LLaVolta则采用Token合并策略,通过平均池化逐步降低Token数量,并通过多阶段训练来缓解信息丢失。

解码阶段的压缩主要针对KV Cache(键值缓存)。

长文本生成会积累巨大的KV Cache,占用大量显存。

在多模态场景下,视觉Token占据了Cache的大部分。

LOOK-M通过累积注意力分数来保留重要的KV对。

MustDrop在预填充阶段就丢弃了部分视觉Token的KV,解码阶段仅保留剩余部分。

SparseMM识别出对视觉理解至关重要的注意力头,并为其分配更多预算,而对非视觉头进行激进压缩。

Video-XL-2提出了双层KV解码,根据当前查询动态选择从稀疏还是密集KV表示中检索信息。

视频时空压缩挑战与长程依赖

视频引入了时间维度,使得数据量呈爆炸式增长。

处理视频不仅要压缩空间,还要利用跨帧的时间冗余。

固定时空压缩通过预定义的规则减少Token。

Convolution-based方法如VideoLLaMA2利用3D卷积或2D卷积融合相邻帧特征。

Qwen2.5-VL采用了3D卷积在空间上4倍下采样、时间上2倍下采样。

这些方法简单高效,但缺乏灵活性。

动态时空压缩根据内容动态调整。

TESTA和DyCoke利用帧间相似度合并冗余Token。

InTI引入轻量级网络预测动态权重以融合空间上同位置的Token。

LongVU采用三级压缩流水线,最终利用时间依赖的空间剪枝,以首帧为锚点,丢弃后续帧中高度相似的区域。

混合策略结合了全局与局部视角。

PruneVid和Chat-UniVi采用全局事件聚类与局部帧级聚合。

LongVLM在片段内进行局部Token合并,并在全视频范围内提取全局语义。

SlowFast-LLaVA借鉴了行为识别的双流架构:慢速通路保留高空间细节但低帧率,快速通路处理高帧率但低空间分辨率,从而兼顾细节与动态。

长视频理解需要处理数千甚至数万帧。

MovieChat利用滑动窗口结合长短时记忆机制。

Video-XL引入视觉摘要Token(VST)将帧压缩为极简的语义点,支持处理2048帧。

Video-XL-Pro通过重构任务增强了VST的动态捕捉能力。

为了保持时间结构,PVC和TimeChat-Online使用了相对时间戳或绝对位置编码。

STORM利用Mamba状态空间模型注入时间感知,同时捕获空间与时间依赖。

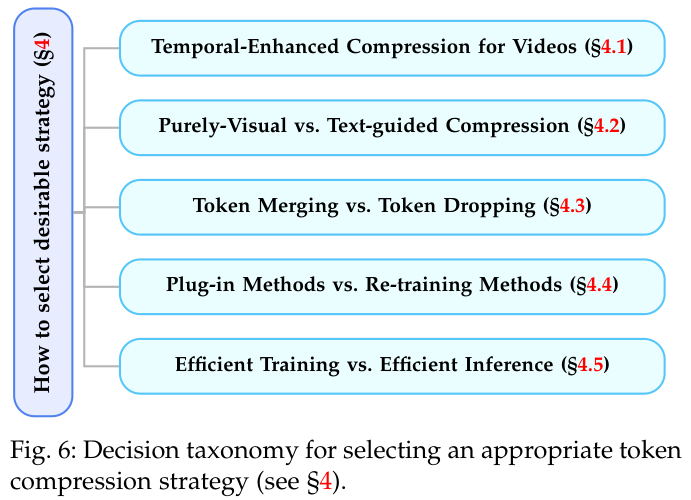

选型指南与未来演进方向

在选择Token压缩策略时,需要权衡多个维度。

纯视觉 vs. 文本引导:纯视觉方法(如VisionZip)通用性强,适合多轮对话和视频流,因为它们不依赖特定指令,一次压缩多次使用。

文本引导方法(如FastV)能实现极高压缩比且精准定位,但每次新查询都需要重新计算,适合单轮高精度问答。

合并 vs. 丢弃:合并(如ToMe)是软策略,保留了整体语义,适合密集或低层特征;丢弃(如PyramidDrop)是硬策略,能极大地稀疏化模型,适合高层语义,但风险在于可能丢失细微线索。

未来的趋势是自适应混合,即根据冗余类型动态切换。

插件式 vs. 重训练:插件式方法(如FastV)无需训练,部署成本低,但性能上限受限,且常依赖注意力分数等启发式规则。

重训练方法(如Q-Former, DeCo)引入可学习参数,性能天花板更高,适应性更强,但开发成本高,模型迁移性差。

高效训练 vs. 高效推理:高效训练(如LLaVA-OneVision的线性插值)旨在降低训练成本;高效推理(如KV Cache压缩)旨在降低延迟。

混合策略正在兴起,例如先用轻量级池化减少训练开销,再结合重训练的投影器优化语义,最后在推理时配合KV剪枝。

尽管进展迅速,领域内仍面临挑战:

- 缺乏理论基础:目前的压缩多基于经验或启发式规则,缺乏因果性或泛化性的理论证明。

- 任务自适应性不足:现有方法往往对所有图像应用固定压缩比,忽略了简单图像(如单物体)与复杂图像(如文档)的信息密度差异。

- 细粒度任务退化:在OCR或文档理解等需要精确空间结构的任务上,激进压缩往往导致性能大幅下降。

未来的研究将向着内容自适应压缩、强化学习驱动的动态策略以及统一的评估框架发展。

Token压缩技术已从单一模块的优化演变为全系统的协同设计。

它不仅是应对长上下文的权宜之计,更是通向高效多模态智能的必经之路。

通过在视觉编码器中去粗存精,在投影器中语义浓缩,在LLM中动态剪枝,我们正在构建更轻量、更敏捷、更强大的下一代多模态大模型。

更多推荐

已为社区贡献193条内容

已为社区贡献193条内容

所有评论(0)