我弃用了鼠标:如何用60行Python代码通过手势控制电脑

本文介绍如何使用 OpenCV 和 MediaPipe 构建“少数派报告”式交互界面的分步指南。实时手部追踪实战:用MediaPipe推理管道替代物理输入(作者使用Gemini AI生成的图片)我们生活在一个拥有自动驾驶汽车和人工智能语言模型的时代,然而我们与机器连接的主要物理接口却在五十年间毫无变化。令人惊讶的是,我们至今仍在使用道格·恩格尔巴特(Doug Engelbart)于20世纪60年代

本文介绍如何使用 OpenCV 和 MediaPipe 构建“少数派报告”式交互界面的分步指南。

实时手部追踪实战:用MediaPipe推理管道替代物理输入

(作者使用Gemini AI生成的图片)

我们生活在一个拥有自动驾驶汽车和人工智能语言模型的时代,然而我们与机器连接的主要物理接口却在五十年间毫无变化。令人惊讶的是,我们至今仍在使用道格·恩格尔巴特(Doug Engelbart)于20世纪60年代初发明的计算机鼠标进行点击和拖拽操作。几周前,我决定挑战这一惯例,用Python编写代码来实现改变。

对数据科学家和机器学习工程师而言,这个项目不仅仅是一个炫酷的小把戏—它更是一堂应用计算机视觉的实战课程。我们将构建一个实时流水线:输入非结构化的视频流(像素),依次应用机器学习模型提取特征(手部关键点),最终将其转化为具体的操作指令(移动光标)。本质上,这是下一代人机交互(Human-Computer Interaction)的一个“Hello World”示例。

目标是什么?只需挥动手掌即可控制鼠标光标。一旦启动程序,窗口将显示你的网络摄像头画面,并实时叠加手部骨架。你电脑上的光标会跟随你食指的移动而移动。这几乎就像隔空移物—你无需触碰任何物理设备,就能操控数字对象。

概念:教Python"看"

为了将物理世界(我的手)与数字世界(鼠标光标)连接起来,我们决定将问题分为两部分:眼睛和大脑。

1.眼睛—网络摄像头(OpenCV):第一步是实时获取摄像头视频。我们将使用OpenCV来完成这项任务。OpenCV是一个功能强大的计算机视觉库,可让 Python访问并处理来自网络摄像头的帧。我们的代码通过 cv2.VideoCapture(0) 打开默认摄像头,然后持续逐帧读取视频。

2.大脑—手部关键点检测(MediaPipe):为了分析每一帧画面、识别出手部并定位手上的关键点,我们采用了谷歌的MediaPipe Hands解决方案。这是一个预训练的机器学习模型,能够接收一张手部图像,并预测出该手部上21个三维关键点(关节和指尖)的位置。简单来说,MediaPipe不仅能告诉你“这里有一只手”,还能精确指出图像中每个指尖和指关节的具体位置。一旦获得这些关键点,主要挑战就基本解决了:只需选择你想要的关键点,并使用其坐标即可。

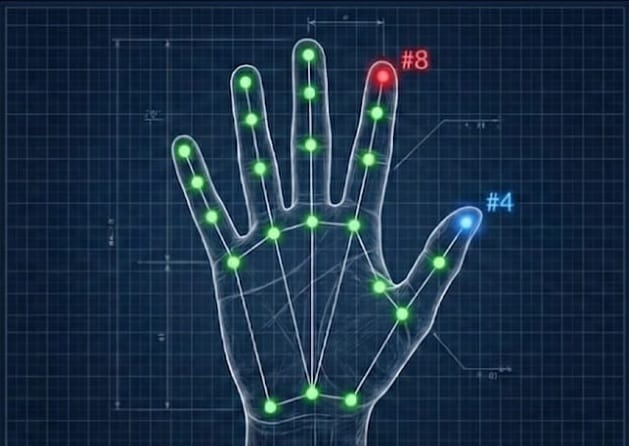

骨架密钥:MediaPipe实时追踪21个手部关键点。我们使用食指指尖(#8)进行光标移动,使用拇指指尖(#4)进行点击检测

(作者使用Gemini AI生成的图片)

也就是说,我们将每一帧摄像头画面传给MediaPipe,它会输出手上 21 个点的 (x, y, z) 坐标。为了控制光标,我们将跟踪编号为 #8 的关键点(即食指指尖)的位置。(如果我们后续要实现点击功能,可以检查编号 #8 与编号 #4(拇指指尖)之间的距离,以识别“捏合”手势。)目前,我们只关注移动:只要找到食指指尖的位置,基本上就可以将其映射到鼠标指针应当移动的位置。

MediaPipe的魔力

MediaPipe Hands负责处理手部检测和关键点估计中最困难的部分。该解决方案利用机器学习,仅凭单帧图像即可预测出 21 个手部关键点。

此外,它是预训练好的(实际上是在超过 30,000 张手部图像上训练而成),这意味着我们无需自己训练模型。我们只需在Python中直接调用MediaPipe的手部追踪“大脑”:

mp_hands = mp.solutions.hands

hands = mp_hands.Hands(max_num_hands=1, min_detection_confidence=0.7)此后,每当一个新的帧通过hands.process() 处理时,它就会返回检测到的手部列表及其对应的21个关键点。我们会将这些关键点渲染到画面上,以便直观地验证其是否正常工作。关键之处在于,对于每只手,我们可以获取hand_landmarks.landmark[i](i 从 0 到 20),每个关键点都包含归一化的 (x, y, z) 坐标。具体而言,食指指尖对应 landmark[8],拇指指尖对应 landmark[4]。借助 MediaPipe,我们已经免去了自行推断手部姿态几何结构这一艰巨任务。

环境配置

你不需要超级计算机—一台带摄像头的普通笔记本电脑就足够了。只需安装以下 Python 库:

pip install opencv-python mediapipe pyautogui numpy

- opencv-python:处理网络摄像头视频流。OpenCV允许我们实时捕获帧并在窗口中显示。

- mediapipe:提供手部追踪模型(MediaPipe Hands)。它能检测手部并返回21个关键点。

- pyautogui:一个跨平台的GUI自动化库。我们将用它来移动屏幕上的实际鼠标光标。例如,pyautogui.moveTo(x, y) 可立即将光标移动到位置 (x, y)。

- numpy:用于数值运算,主要是将摄像头坐标映射到屏幕坐标。我们使用 numpy.interp 将值从摄像头帧尺寸缩放到完整显示器分辨率。现在,我们的环境已准备就绪,可以将全部逻辑写入单个文件(例如 ai_mouse.py)。

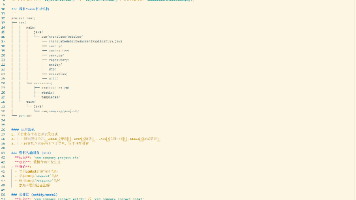

代码实现

核心逻辑异常简洁(不到 60 行)。以下是完整的 Python 脚本:

import cv2

import mediapipe as mp

import pyautogui

import numpy as np

# --- CONFIGURATION ---

SMOOTHING = 5 # Higher = smoother movement but more lag.

plocX, plocY = 0, 0 # Previous finger position

clocX, clocY = 0, 0 # Current finger position

# --- INITIALIZATION ---

cap = cv2.VideoCapture(0) # Open webcam (0 = default camera)

mp_hands = mp.solutions.hands

# Track max 1 hand to avoid confusion, confidence threshold 0.7

hands = mp_hands.Hands(max_num_hands=1, min_detection_confidence=0.7)

mp_draw = mp.solutions.drawing_utils

screen_width, screen_height = pyautogui.size() # Get actual screen size

print("AI Mouse Active. Press 'q' to quit.")

while True:

# STEP 1: SEE - Capture a frame from the webcam

success, img = cap.read()

if not success:

break

img = cv2.flip(img, 1) # Mirror image so it feels natural

frame_height, frame_width, _ = img.shape

img_rgb = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

# STEP 2: THINK - Process the frame with MediaPipe

results = hands.process(img_rgb)

# If a hand is found:

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

# Draw the skeleton on the frame so we can see it

mp_draw.draw_landmarks(img, hand_landmarks, mp_hands.HAND_CONNECTIONS)

# STEP 3: ACT - Move the mouse based on the index finger tip.

index_finger = hand_landmarks.landmark[8] # landmark #8 = index fingertip

x = int(index_finger.x * frame_width)

y = int(index_finger.y * frame_height)

# Map webcam coordinates to screen coordinates

mouse_x = np.interp(x, (0, frame_width), (0, screen_width))

mouse_y = np.interp(y, (0, frame_height), (0, screen_height))

# Smooth the values to reduce jitter (The "Professional Feel")

clocX = plocX + (mouse_x - plocX) / SMOOTHING

clocY = plocY + (mouse_y - plocY) / SMOOTHING

# Move the actual mouse cursor

pyautogui.moveTo(clocX, clocY)

plocX, plocY = clocX, clocY # Update previous location

# Show the webcam feed with overlay

cv2.imshow("AI Mouse Controller", img)

if cv2.waitKey(1) & 0xFF == ord('q'): # Quit on 'q' key

break

# Cleanup

cap.release()

cv2.destroyAllWindows()该程序在每一帧中持续重复相同的三步流程:看(SEE)→想(THINK)→动(ACT)。首先,它从摄像头抓取一帧;然后,应用MediaPipe识别手部并绘制关键点;最后,代码获取食指指尖位置(关键点 #8),并据此移动光标。

由于摄像头帧和你的显示器具有不同的坐标系统,我们首先借助numpy.interp将指尖位置转换为整个屏幕的分辨率,然后调用 pyautogui.moveTo(x, y) 移动光标。为了提升移动的稳定性,我们还引入了少量平滑处理(对一段时间内的位置取平均值),以减少抖动。

运行效果

通过python ai_mouse.py 运行脚本。“AI鼠标控制器”窗口将弹出,并显示你的摄像头画面。将手放在摄像头前,你会看到一个彩色骨架(手部关节和连线)叠加在你的手上。接着,移动你的食指,鼠标光标便会平滑地在屏幕上实时跟随你的手指移动。

一开始,这感觉有些奇怪—某种程度上,就像隔空移物。但几秒钟后,你就会习惯。由于程序内置了插值和平滑效果,光标的移动完全符合你对手指动作的预期。因此,即使系统偶尔短暂无法检测到你的手,光标也会保持静止,直到重新检测到为止。总体而言,它的效果令人惊叹。(如需退出,只需在OpenCV窗口中按下q键。)

结论:交互界面的未来

这个项目仅用了大约60行Python代码,却展示了一个相当深刻的理念。

最初,我们受限于打孔卡,随后是键盘,再之后是鼠标。如今,你只需挥挥手,Python就能理解这作为一条指令。随着业界聚焦于空间计算(spatial computing),基于手势的控制已不再是科幻未来的幻想—它正成为我们与机器交互方式的现实。

数字骨架实时追踪手部,将动作转化为光标移动。

(作者使用 Gemini AI 生成的图像)

当然,这个原型还不足以替代你的鼠标用于竞技游戏(至少现在还不行)。但它让我们瞥见了人工智能如何消除意图与行动之间的鸿沟。

下一个挑战:“捏合”点击

顺理成章的下一步,就是将这个演示升级为实用工具。你可以通过检测“捏合”手势来实现“点击”功能:

- 计算关键点 #8(食指指尖)与关键点#4(拇指指尖)之间的欧氏距离。

- 当该距离小于某个阈值(例如 30 像素)时,触发 pyautogui.click()。

去尝试吧!做出一些看似魔法的东西。

参考文献

MediaPipe Hands(Google):手部关键点检测模型及文档

OpenCV-Python文档:网络摄像头捕获、帧处理和可视化工具

PyAutoGUI文档:编程化光标控制与自动化 API(如 moveTo、click 等)

NumPy文档:numpy.interp() 用于将摄像头坐标映射到屏幕坐标

道格·恩格尔巴特与计算机鼠标(历史背景):鼠标作为现代交互界面基准的起源

更多推荐

已为社区贡献172条内容

已为社区贡献172条内容

所有评论(0)