医疗数据测试:在合规前提下验证AI诊断

医疗AI测试面临技术精准性与法规合规性的双重挑战,需构建韧性测试体系。技术维度需处理数据噪声、时序完整性,并验证诊断准确性(AUC-ROC>0.9)和实时性(响应<2秒)。合规性测试要求100%数据脱敏、95%模型可解释性覆盖,并按安全等级递增测试强度。实践案例显示,通过合成数据扩充和边缘案例测试,模型召回率从68%提升至89%。现代测试工程师需兼具技术、法规和伦理能力,建立持续监控和

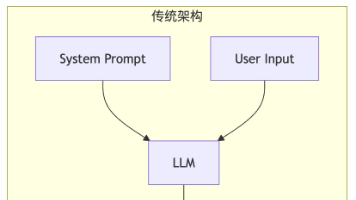

引言:双重挑战下的测试新范式

在医疗AI诊断领域,测试从业者面临双重挑战:既要确保算法在复杂生物数据中的精准性(如上海交大研究显示,AI需整合多源异构医疗信息以实现诊断准确率提升近30%),又需在严苛的合规框架下操作(如FDA要求算法变更需预定义并自动化验证)。这种平衡要求测试策略必须同步覆盖技术有效性与法规符合性。

一、医疗数据测试的核心技术维度

-

数据质量验证的独特性

-

噪声与偏差处理:医疗数据常含设备噪声、录入错误及样本偏差(如农村患者数据缺失导致模型失效),需设计对抗性测试用例:

# 示例:生成对抗性数据测试模型鲁棒性 def inject_noise(clean_data, noise_level=0.3): # 添加高斯噪声模拟设备误差 noisy_data = clean_data + np.random.normal(0, noise_level, clean_data.shape) return noisy_data -

时序数据完整性验证:电子病历中的时间序列关系(如用药记录与检验结果的时间逻辑)需通过状态机模型校验连续性。

-

-

性能测试的关键指标

指标类型

医疗场景要求

测试工具示例

诊断准确性

AUC-ROC >0.9 (肿瘤诊断)

Scikit-learn, PyTorch Lightning

实时性

影像诊断响应<2秒

Locust负载测试框架

失效容错

置信度低于阈值时启动人工复核

Custom Fallback Hooks

二、合规性测试的刚性框架

-

监管矩阵的三层防护

-

数据合规:依据《生成式AI服务管理暂行办法》,训练数据需满足:

-

患者信息脱敏率100%(如DICOM影像删除EXIF元数据)

-

跨境数据传输通过安全评估(如采用联邦学习本地化处理)

-

-

算法透明性:FDA强制要求提供模型决策追溯能力,测试需验证:

-

SHAP/LIME可解释性覆盖率≥95%

-

错误诊断案例的决策路径可审计

-

-

变更控制:预定义更新规则(如数据漂移阈值Δ<5%)并自动化回归测试

-

-

安全等级对应的测试深度

IEC 62304标准将系统按风险分级,测试强度随之递增:graph LR A[安全等级C-可能致残/致死] --> B(需求/代码/单元测试覆盖率100%) B --> C[动态故障树分析FTA] A --> D[5000+小时可靠性压力测试]

三、工程实践:从测试案例到风险防控

案例:智能肿瘤诊断系统(ITDS)的合规验证

-

挑战:初始数据集城市样本占比92%,导致农村患者误诊率升高23%

-

测试干预:

-

合成数据扩充:使用GAN生成少数族裔影像数据平衡样本

-

边缘案例强化:针对低分辨率CT影像设计专项测试集

-

伦理审查:引入独立医学伦理委员会评估假阴性风险

-

-

成果:模型在边缘案例的召回率从68%提升至89%,通过FDA De Novo认证

测试团队角色进化:现代医疗AI测试工程师需兼具:

-

技术能力:构建数据漂移监控流水线(如Prometheus+Alertmanager实时监测AUC下降)

-

法规意识:持续跟踪HIPAA、GDPR、中国《数据安全法》更新并转化测试用例

-

伦理担当:主导“AI误诊应急预案”设计(包括责任追溯与系统熔断机制)

结论:构建韧性测试体系的核心原则

医疗AI测试已超越传统软件质量保障,成为风险控制的核心枢纽。成功的测试框架必须实现:

-

技术-合规双轨并行:每项性能测试需同步输出合规证据链(如数据脱敏日志->隐私合规报告)

-

持续监控优于单次验证:建立生产环境性能哨兵(如周级AUC波动告警)

-

跨学科协作制度化:强制测试团队参与临床需求评审,前置化风险识别(如误诊法律后果模拟)

唯有将测试置于产品全生命周期核心,方能推动医疗AI安全抵达临床一线。

精选文章

更多推荐

已为社区贡献369条内容

已为社区贡献369条内容

所有评论(0)