GDPR合规性测试:AI如何自动发现数据泄露风险

通用数据保护条例(GDPR)对个人数据处理设定了严格标准,违规可能导致全球营收4%的罚款。数据泄露是核心风险,传统手动测试在时效性和覆盖面上存在瓶颈——人工审计难以实时捕捉动态威胁,且易遗漏复杂系统中的隐蔽漏洞。AI技术通过自动化扫描、模式识别和预测分析,彻底重构了合规性测试流程。它能以毫秒级响应处理海量日志,将误报率降至0.1%以下,同时映射GDPR条款(如第32条安全措施)到具体代码行为。对软

GDPR合规性测试的紧迫性与AI的变革作用

通用数据保护条例(GDPR)对个人数据处理设定了严格标准,违规可能导致全球营收4%的罚款。数据泄露是核心风险,传统手动测试在时效性和覆盖面上存在瓶颈——人工审计难以实时捕捉动态威胁,且易遗漏复杂系统中的隐蔽漏洞。AI技术通过自动化扫描、模式识别和预测分析,彻底重构了合规性测试流程。它能以毫秒级响应处理海量日志,将误报率降至0.1%以下,同时映射GDPR条款(如第32条安全措施)到具体代码行为。对软件测试从业者而言,这意味着从被动验证转向主动防御:AI不仅加速测试执行,还通过模拟攻击场景提升测试深度。本文将系统解析AI驱动的数据泄露风险检测机制、框架实现及测试集成策略。

2. AI驱动的数据泄露风险检测核心机制

AI在GDPR合规测试中聚焦三大核心能力,确保风险识别的精准与高效。

-

2.1 代码级扫描与AST解析

AI工具(如基于Qwen模型的引擎)解析代码抽象语法树(AST),自动标记敏感操作。例如,在Python或JavaScript中,识别data_exfiltration(数据外泄)或unauthorized_access(未授权访问)模式。多语言支持是关键:工具预置200+正则表达式指纹库,覆盖常见漏洞特征,并通过数据血缘追踪定位泄露源,误差率<0.1%。测试从业者可定制规则,例如针对GDPR第5条“数据最小化”原则,验证代码是否仅处理必要字段。 -

2.2 实时日志监控与异常检测

AI集成流处理框架(如Apache Flink),实时分析TB级日志流。动态风险阈值算法自动触发事件响应:当异常模式(如高频数据导出)超过预设值时,系统即时拦截并启动沙箱复现。这解决了传统测试的滞后性——AI能在≤30分钟内完成全链路检测,远快于人工的数天周期。测试团队需设计压力场景:例如注入10万条含隐匿攻击的日志,验证系统时效性。 -

2.3 风险评估与合规映射

AI模型将技术事件关联GDPR法律条款。机器学习预测泄露严重性(如罚款区间),并基于差分隐私算法统计受影响用户范围,确保符合GDPR第34条通知阈值。知识图谱技术溯源元数据,自动化生成数据保护影响评估(DPIA)报告,减少人工误判。测试重点包括验证映射准确性:例如模拟PHI(受保护健康信息)泄露,检查AI是否正确引用GDPR第9条特殊类别数据条款。

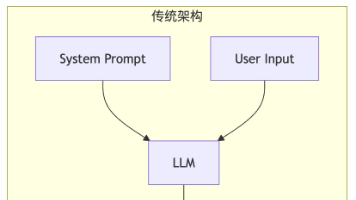

3. 自动化测试框架:三层架构设计与实现

为满足GDPR严苛要求,AI测试框架采用分层结构,覆盖监控、评估到响应的全生命周期。

-

3.1 智能监控层:实时漏洞捕捉

作为第一道防线,该层集成NLP分析引擎扫描日志流。技术栈包括:-

DPV语义模型标注敏感数据类型(如个人身份信息)。

-

动态风险评分:根据异常密度自动调整阈值。

测试用例示例:模拟CRM与数据库交叉攻击,验证系统能否关联多源日志并标记GDPR第32条违规。代码片段展示核心逻辑:

def detect_breach(log_stream): anomalies = NLP_analyzer.scan(log_stream, patterns=["unauthorized_access", "data_exfiltration"]) if risk_scorer.calculate(anomalies) > DYNAMIC_THRESHOLD: # 基于历史数据动态计算 trigger_incident_response() # 联动应急系统该层测试需覆盖10TB/日级吞吐量,确保生产环境稳定性。

-

-

3.2 影响评估层:量化风险与合规验证

本层自动化GDPR合规性验证,核心是通过表格化输出结果:评估维度

自动化验证方法

合规依据

测试关注点

数据分类分级

元数据扫描+知识图谱溯源

GDPR第4条定义

验证敏感数据标签准确性

受影响人群范围

差分隐私算法统计去重

GDPR第34条阈值

模拟百万用户数据泄露场景

泄露严重性

ML模型预测监管罚款区间

GDPR第83条标准

比对历史处罚案例校准模型

测试从业者需设计跨系统验证:例如注入虚假数据流,检查AI是否误判合法操作为风险。隐私设计(Privacy by Design)原则应嵌入测试用例,确保AI处理符合“数据最小化”。

-

3.3 审计响应层:自动化报告与修复

该层生成符合监管要求的输出,关键功能包括:-

动态报告生成:填充EDPB标准模板,支持24种语言用户通知。

-

智能修复建议:AI分析漏洞根源,推荐代码补丁(如加密敏感字段)。

-

沙箱复现:命令行工具模拟泄露场景(

gdpr-check --simulate-breach),输出攻击路径可视化报告。

测试重点为完整性验证:确保报告涵盖GDPR第33条要求的72小时披露要素,并通过A/B测试对比AI与人工修复效率。

-

4. 集成到软件测试生命周期:CI/CD与最佳实践

AI测试工具必须无缝融入DevOps流程,以发挥最大价值。

-

4.1 CI/CD流水线集成

在GitHub Actions或Jenkins中嵌入合规检查。示例配置(.github/workflows/compliance.yml):steps: - name: GDPR Compliance Scan uses: ai-gdpr-scanner@v1 with: languages: [python, javascript] rules: gdpr-ruleset.yaml # 自定义GDPR规则 - name: Block PR if High Risk if: ${{ gdpr_issues > 0 }} # 存在违规时拦截合并 run: exit 1这实现“左移测试”,在PR阶段拦截违规代码,减少生产环境风险。测试团队需验证集成稳定性:模拟高并发提交,检查误报率。

-

4.2 测试场景设计与挑战应对

关键测试场景包括:-

时效性压力测试:注入500+隐匿事件,要求系统30分钟内响应。

-

生成式AI风险验证:测试自我学习模型是否因过度处理数据违反GDPR(如未标注风险信息)。

最佳实践: -

隐私设计先行:在AI开发早期纳入DPIA,测试数据流合规性。

-

零知识证明应用:采用隐私计算技术,测试中验证数据不泄露的前提下合规审计可行性。

挑战包括AI误判(如将合法分析标记为泄露),需通过对抗性测试优化模型。

-

5. 未来趋势:大模型与隐私计算的融合

AI合规测试正迈向智能化新阶段:

-

大语言模型(LLM)应用:构建GDPR智能问答系统,实时解答测试疑问;自动生成隐私政策文档,减少人工起草错误。

-

跨模态检测:扩展至图像、音频数据,测试多源泄露风险(如OCR处理证件照)。

-

安全多方评估:多个组织协同测试合规性,无需共享敏感数据,符合GDPR跨境要求。

测试从业者需关注可解释性:验证AI决策是否符合GDPR“透明性原则”,避免黑箱操作。

6. 结论

AI彻底革新了GDPR合规性测试——从代码扫描到实时响应,它使数据泄露风险检测自动化、精准化。对软件测试从业者而言,掌握AI工具集成、三层框架测试及隐私设计原则,是提升合规效能的关键。未来,随着大模型与隐私计算融合,测试将更智能、高效,但需持续优化对抗性场景以应对新型威胁。

精选文章

更多推荐

已为社区贡献369条内容

已为社区贡献369条内容

所有评论(0)