无服务器架构测试:AI跟踪冷启动性能

摘要:无服务器架构的冷启动问题(首次触发延迟200ms-2s)已成为性能瓶颈,尤其在突发流量场景。AI技术通过动态预暖、异常检测等方案优化冷启动测试:1)构建多维度测试场景(闲置期/突发并发);2)建立AI跟踪指标体系(启动时间/错误率);3)验证资源调优与架构解耦策略。实战案例显示AI可使冷启动率下降70%,延迟优化40%。未来趋势指向边缘计算和标准化测试框架,测试工程师需掌握云原生工具链,推动

冷启动测试在无服务器架构中的核心地位

无服务器架构(Serverless)通过事件驱动和按需资源分配,大幅简化了运维复杂度,但其特有的冷启动(Cold Start)问题——即闲置函数首次触发时的初始化延迟——已成为性能瓶颈的关键因素。冷启动延迟直接影响用户端响应时间(如API首响)和SLA达标率,在电商秒杀或实时数据分析等场景中尤为突出。传统测试方法依赖手动场景建模,难以应对动态流量变化,而AI技术的引入正逐步重塑测试范式。本文从测试工程师视角,系统解析AI驱动的冷启动性能跟踪框架,覆盖测试设计、指标采集、优化验证及韧性保障,为从业者提供实战指南。

一、冷启动性能的测试挑战与AI介入价值

冷启动本质是资源初始化过程,涉及容器加载、依赖注入和运行时启动,延迟通常在200ms-2s区间,突发流量下可激增数倍。测试工程师面临的挑战包括:

-

场景复杂性:低流量期触发、版本更新或突发并发(如100+请求)导致冷启动率波动,需模拟多维度边界条件。

-

指标量化难:端到端延迟(End-to-End Latency)和初始化时间(Init Duration)受网络、依赖服务等外部变量干扰。

-

成本效益平衡:资源预配(如内存从256MB提升至1024MB)可加速启动40-60%,但过度配置会增加成本。

AI技术通过机器学习模型预测流量模式,实现:

-

动态预暖:基于历史数据训练模型,自动调度保活函数(如定时触发

keep_warm函数),减少冷启动率。 -

异常检测:实时监控指标偏离(如错误率突增),识别冷启动失败根因(如依赖服务超时)。

二、AI驱动的冷启动测试框架设计

测试框架需整合传统工具与AI算法,分三阶段实施:

-

测试场景建模

-

触发条件设计:

-

时间维度:模拟闲置期(如30分钟/2小时)后的首次调用,验证资源回收策略。

-

并发维度:通过压力工具生成突发请求(如每秒100+),监测自动扩展延迟。

-

-

依赖链注入:在测试用例中嵌入数据库连接或外部API调用,评估依赖加载占比(例如:使用

serverless-analyze-bundle扫描冗余库)。

-

-

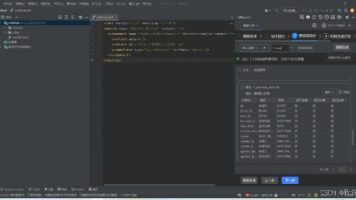

性能指标体系与AI跟踪

指标类型

采集工具

AI应用场景

启动时间

Datadog, Prometheus

预测内存配置与启动速度关系曲线

错误率

CloudWatch

异常模式识别与根因分析

恢复时间

Jaeger链路追踪

优化预暖间隔阈值

AI模型(如LSTM)可处理时序数据,输出冷启动风险热力图,指导测试重点区域。

-

优化策略验证

-

资源调优测试:对比不同内存配置(128MB vs 3008MB)下的延迟,量化性能增益。

-

架构解耦:将单体函数拆分为微服务,降低单点冷启动影响(如异步处理耗时操作)。

-

Init-Less模式:采用容器预热技术(如Docker镜像缓存),减少冷启动开销,测试需验证缓存命中率。

-

三、实战案例:AI在冷启动测试中的效能验证

以电商大促场景为例,测试团队实施以下流程:

-

问题复现:模拟闲置10分钟后1000并发请求,冷启动延迟达1.8s,SLA达标率跌破90%。

-

AI干预:

-

部署流量预测模型,提前15分钟触发预热函数,冷启动率下降70%。

-

使用镜像分层技术(分离依赖层与业务代码),启动时间优化40%。

-

-

结果验证:端到端延迟稳定在200ms内,错误率<0.1%,通过CI/CD集成实现持续测试。

四、未来趋势与测试工程师行动指南

冷启动优化正向智能化、标准化演进:

-

边缘计算集成:在CDN节点部署函数,减少地理延迟,测试需覆盖多区域场景。

-

韧性框架:采用CNCF Serverless Workflow规范,建立基准测试模型。

测试从业者应: -

技能升级:掌握云原生工具链(如Kubernetes+Serverless组合)。

-

协作机制:与开发团队共享测试数据,推动代码瘦身和依赖优化。

结语

AI赋能的冷启动测试不仅提升性能可见性,更驱动无服务器架构的可靠性飞跃。测试工程师需从被动监控转向主动预测,将冷启动纳入核心测试用例库,确保架构在成本与性能间取得最优平衡。

精选文章

更多推荐

已为社区贡献379条内容

已为社区贡献379条内容

所有评论(0)