AI如何精准赋能研发效能度量:从数据到洞察的实践之路

本文探讨了AI技术在研发效能度量中的应用框架。传统度量方式存在数据丰富但洞察匮乏的问题,而AI技术能够通过模式识别和预测分析,将原始数据转化为可行动的深度洞察。文章提出四层实践框架:数据层整合多源异构数据,特征工程层计算效能指标,AI模型层实现智能分析与预测,洞察层形成闭环反馈。实践案例展示了预测需求交付周期的简化模型实现,同时指出需关注数据隐私、模型偏差等问题。AI赋能的效能度量旨在发现改进机会

在数字化竞争日益激烈的今天,研发效能已成为企业核心竞争力的关键。然而,传统的度量方式常陷入“数据丰富,洞察匮乏”的窘境:我们收集了大量提交次数、构建时长、缺陷数量等数据,却难以回答“团队效率究竟如何提升”、“瓶颈到底在哪里”等本质问题。人工智能技术的成熟,为破解这一难题提供了全新视角。本文旨在探讨一种基于AI的研发效能度量实践框架,展示如何将原始数据转化为可行动的深度洞察。

一、传统度量体系的瓶颈与AI的破局点

传统的研发效能度量,如代码行数、工时消耗,已被证明易于扭曲行为,引发“绩效焦虑”而非效能提升参考[1]。而更为先进的DORA(研发与运维能力)指标(部署频率、变更前置时间等)虽指明了方向,但在复杂项目中,其数据采集、归因分析和改进建议的生成仍高度依赖人工,难以规模化、实时化。

AI的破局点在于其模式识别、预测与归因分析能力。它能够处理多维、海量的研发数据,自动识别出人眼难以察觉的相关性与因果关系,从而将度量从“描述过去”推进到“诊断现在”乃至“预测未来”。

二、构建AI赋能的效能度量实践框架

以下是一个四层实践框架,以实现从数据到洞察的闭环。

1. 数据层:多源异构数据的规范化治理

AI分析的质量根植于数据质量。需整合来自项目管理(Jira)、代码仓库(Git)、CI/CD(Jenkins)、监控(APM)等多源头的数据。关键步骤是建立统一的研发事件标准模型,将一次代码提交、一个需求卡片、一次构建都转化为带有一致属性的“事件”,并解决不同系统间的ID映射问题(如将Git提交与Jira Issue关联)。这是后续所有分析的基础。

2. 特征工程层:从原始事件到效能特征

此层目标是计算具有业务意义的度量指标与特征。例如:

- 效率特征:计算基于“完成流”的需求交付周期时间(从开发启动到上线),而非简单的任务耗时。

- 质量特征:不仅统计缺陷数量,更计算缺陷逃逸率(生产环境缺陷数/所有环境发现缺陷总数),并关联到引入该缺陷的代码变更集。

- 协作特征:分析代码评审响应时长、模块间耦合度变化等。

- 预测性特征:为后续AI模型准备特征,如代码变更的复杂度(通过代码差异分析)、开发者的近期工作负载等。

3. AI模型层:嵌入智能分析与预测

在此层引入AI模型,实现智能洞察:

- 聚类分析识别模式:无监督学习可用于对开发任务或团队工作进行聚类,自动发现高耗时任务的共性模式(例如,是否总与某些特定模块或第三方服务集成相关)参考[2]。

- 回归模型预测交付风险:基于历史数据(如需求规模、技术栈、团队稳定性等特征)训练模型,预测新需求的可能交付周期及其置信区间。当预测周期显著超出期望时,系统可提前预警。

- 根因分析定位瓶颈:当检测到部署频率下降或变更失败率上升时,关联规则挖掘或因果推断模型可以分析同期其他维度的变化(如代码评审活动骤减、特定微服务变更激增),辅助定位最可能的根本原因。

4. 洞察与行动层:可视化与反馈闭环

将AI的分析结果转化为可理解的洞察。例如,在效能看板中,不仅展示当前周期时间,更标注“AI识别到本周周期时间中位数延长,主要与‘支付服务’模块的变更相关,建议关注该模块的近期重构任务”。更重要的是,建立行动跟踪机制,将基于洞察的改进措施(如“优化支付服务的集成测试”)录入系统,并持续追踪其后的效能指标变化,形成“度量-洞察-行动-验证”的完整闭环。

三、实践案例:预测需求交付周期的简易实现

以下以Python为例,演示一个极度简化的预测模型构建思路,旨在说明流程可行性。

|

python |

输出示例:

|

plain text |

(注:此示例数据高度简化且完美线性,仅为演示流程。实际应用中需处理更复杂特征、数据清洗、调优及验证。)

四、挑战与合规性考量

实施AI赋能的效能度量需谨慎应对以下挑战:

- 数据隐私与安全:必须对数据进行匿名化或聚合处理,确保分析不追踪到具体个人行为,符合《个人信息保护法》等相关法规。

- 模型偏差与公平性:需定期审计AI模型,防止其学习并固化历史中不合理的协作模式或偏见,避免对特定成员或团队产生不公平评估。

- 工具而非标尺:必须向团队明确,AI度量是发现改进机会的工具,而非绩效考核的标尺。其目标是赋能团队,而非监控个人。

结论

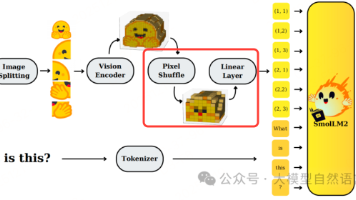

将AI引入研发效能度量,绝非为了制造更复杂的监控仪表盘,其核心价值在于将管理者的经验直觉转化为可量化、可验证的数据智能。通过上述框架实践,团队能够从海量数据中自动识别瓶颈、预测风险、定位根因,从而将宝贵的精力从“分析数据”转向“解决问题”,真正实现研发效能的持续、精准提升。未来,随着多模态AI的发展,结合代码语义、沟通文本等非结构化数据的分析,将使这一洞察体系变得更加立体和强大。

参考文献

[1] Forsgren N, Humble J, Kim G. 加速:精益软件和DevOps的科学[M]. 人民邮电出版社,2019.

[2] 麦肯锡全球研究院. 人工智能在软件开发生命周期中的应用潜力分析报告[R]. 2022.

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)