AI应用落地实战: 基于 GitLab Webhook + LLM 实现自动化 AI 代码审查助手

当今AI技术飞速发展,极大地提升了各行各业的生产效率。在研发领域,将AI应用于代码审查环节,实现GitLab平台上Merge Request(MR)的自动代码诊断,不仅能提升评审效率、保障代码质量,还能降低人工评审的人力成本,是一个落地性极强、性价比突出的AI DevOps场景。本文将详细介绍这套方案的实现思路、核心步骤与完整代码,帮助你快速落地自动化AI代码审查。

一、背景与需求

在团队使用GitLab进行协作开发时,Merge Request(MR,对应GitHub的Pull Request/PR) 是代码合并前的核心质量把控环节。开发人员提交代码变更后,需要通过代码评审确认代码的规范性、逻辑正确性、性能合理性,避免潜在Bug流入生产环境。

传统的人工代码评审存在明显短板:

- 效率低下,评审进度依赖评审人员的时间与精力,容易成为项目迭代的瓶颈;

- 质量不均,评审结果受评审人员的技术经验、专注度影响,难以保证评审标准的统一性;

- 重复劳动,大量简单的代码规范、语法问题需要评审人员反复指出,浪费宝贵的人力资源。

因此,我期望实现一套自动化AI代码审查方案,在用户提交或更新MR时,自动触发AI对代码变更进行分析,生成专业的诊断报告与修改建议,并自动同步到GitLab MR页面的评论区,为人工评审提供强力辅助,实现"AI初筛+人工精审"的高效评审模式。

二、方案核心流程与架构

1. 核心工作流程

当用户在GitLab项目中提交或更新MR时,系统将自动完成以下闭环流程:

- GitLab触发Webhook通知:GitLab监测到MR事件(创建、更新)后,通过配置好的Webhook向后端服务发送HTTP POST请求,携带MR相关完整信息;

- 后端服务接收与解析:Python Flask后端服务接收请求,验证请求合法性,筛选目标事件(MR的open/reopen/update),提取MR编号、项目信息等关键数据;

- 获取MR代码变更(Diff):通过GitLab开放API,拉取该MR的最新代码差异内容(哪些文件被修改、新增、删除,以及具体的代码变动);

- LLM大模型代码诊断:将格式化后的Diff内容与Commit信息传入LLM大模型接口,由AI进行代码问题诊断(规范、Bug、性能等)与修改建议生成;

- 自动添加MR AI评论:再次调用GitLab开放API,将AI生成的评审结果以Markdown格式添加到MR的评论区,供开发人员与评审人员查看参考。

2. 整体架构图

三、前置准备工作

在开始实现代码前,需要完成以下准备工作,确保各环节能够正常打通:

-

GitLab 项目与权限准备

- 拥有一个可操作的GitLab项目(公有云或自托管均可),建议创建测试项目

test进行验证; - 生成GitLab Personal Access Token:进入个人设置 →

Access Tokens,勾选api权限(必须),生成后妥善保存(仅显示一次),用于调用GitLab API; - 确保项目支持创建MR,且拥有该项目的开发者及以上权限。

- 拥有一个可操作的GitLab项目(公有云或自托管均可),建议创建测试项目

-

GitLab Webhook 配置

- 进入GitLab项目 →

Settings→Webhooks; - 填写URL:后端服务接收Webhook的地址(需公网可访问或内网打通GitLab,格式如

https://你的域名/api/gitlab/mr-webhook); - 勾选触发事件:仅勾选

Merge Request events(避免无关事件干扰); - 配置Secret Token(推荐):设置一个随机复杂字符串,与后端代码中的

WEBHOOK_SECRET保持一致,用于验证请求合法性; - 可选关闭

SSL verification(仅测试环境,生产环境建议配置合法HTTPS证书并开启验证); - 点击

Add webhook完成配置,可后续使用Test功能发送测试请求。

- 进入GitLab项目 →

-

后端服务环境准备

- 安装Python 3.8及以上版本;

- 安装所需依赖包:

pip install flask python-gitlab requests openai - 确保后端服务能够访问GitLab服务器与LLM API接口(网络通畅,无防火墙拦截)。

-

LLM API 准备

- 拥有一个可用的LLM OpenAPI接口(支持OpenAI标准格式更佳),如ChatGPT、文心一言、通义千问等;

- 获取LLM API的访问地址(

base_url)、API Key与支持的模型名称,确保能够通过HTTP请求调用并返回有效结果。

四、完整实现代码

Python 实现代码(基于 Flask + python-gitlab)

python-gitlab 是一个功能强大的 Python 包,专门用于与 GitLab 服务器的 API 进行交互。它为开发者提供了编程方式自动化管理 GitLab 实例的能力,无需手动通过网页界面操作。

python-gitlab 介绍地址:https://pypi.org/project/python-gitlab/

本方案提供两个版本的实现代码,简化版用于快速验证核心功能,完整版支持配置文件、日志记录,更适合生产环境部署。

1. 简化版(快速验证)

创建app_simple.py,直接修改配置项即可运行:

from flask import Flask, request, jsonify

import gitlab

import requests

import os

app = Flask(__name__)

# ===== 配置区域(直接修改为你的实际信息)=====

GITLAB_URL = 'https://gitlab.example.com' # 你的GitLab地址

PRIVATE_TOKEN = 'glpat-你的GitLab私人令牌' # 有api权限的Token

PROJECT_PATH = 'group/test' # 你的项目路径(如username/test或group/test)

LLM_API_URL = 'https://你的llm-api地址/generate' # 你的LLM接口地址

LLM_API_KEY = '你的LLM-API-KEY' # LLM接口鉴权Key(可选)

WEBHOOK_SECRET = '你的WebhookSecretToken' # 与GitLab Webhook配置一致(可选)

# 初始化GitLab客户端

gl = gitlab.Gitlab(GITLAB_URL, private_token=PRIVATE_TOKEN)

project = gl.projects.get(PROJECT_PATH)

# ===== 辅助函数:调用LLM接口获取评审建议 =====

def call_llm_api(diff_content):

headers = {

'Content-Type': 'application/json',

}

if LLM_API_KEY:

headers['Authorization'] = f'Bearer {LLM_API_KEY}'

# 构造专业的代码审查Prompt

prompt = f"""

你是一个资深的AI代码审查助手,具备丰富的多语言开发经验与代码规范认知。

请分析下面的GitLab MR代码变更(Diff),完成以下评审内容:

1. 指出潜在的Bug、语法错误、逻辑漏洞;

2. 检查代码是否符合通用编程规范,是否具备良好的可读性与可维护性;

3. 给出具体、可落地的修改建议,避免空泛的表述;

4. 若代码无明显问题,可说明"代码变更符合规范,暂无明显优化点"。

代码变更(Diff)如下:

{diff_content}

"""

payload = {

"prompt": prompt,

"max_tokens": 2000 # 可根据需要调整返回内容长度

}

try:

response = requests.post(LLM_API_URL, json=payload, headers=headers, timeout=30)

response.raise_for_status() # 抛出HTTP请求异常

result = response.json()

return result.get("suggestion", "AI 暂无具体审查建议。")

except Exception as e:

return f"调用LLM API失败:{str(e)}"

# ===== Flask路由:接收GitLab Webhook =====

@app.route('/api/gitlab/mr-webhook', methods=['POST'])

def gitlab_mr_webhook():

# 步骤1:验证Webhook Secret(可选,提升安全性)

received_sig = request.headers.get('X-Gitlab-Token')

if WEBHOOK_SECRET and received_sig != WEBHOOK_SECRET:

return jsonify({"error": "无效的Webhook密钥,请求拒绝"}), 403

# 步骤2:解析请求数据

try:

data = request.json

except Exception as e:

return jsonify({"error": "无法解析请求JSON数据"}), 400

# 步骤3:筛选Merge Request事件与目标操作

event_type = data.get('object_kind')

if event_type != 'merge_request':

return jsonify({"info": "非Merge Request事件,忽略"}), 200

action = data.get('object_attributes', {}).get('action')

if action not in ['open', 'reopen', 'update']:

return jsonify({"info": f"MR操作{action}暂不处理,忽略"}), 200

# 步骤4:提取MR核心信息

mr_iid = data.get('object_attributes', {}).get('iid')

if not mr_iid:

return jsonify({"error": "未找到MR编号(IID)"}), 400

# 步骤5:获取MR Diff并调用LLM

try:

# 获取MR对象与最新Diff

mr = project.mergerequests.get(mr_iid)

diffs = mr.diffs.list()

if not diffs:

return jsonify({"info": "该MR暂无代码变更内容"}), 200

latest_diff = diffs[0]

diff_content = latest_diff.diff

if not diff_content:

return jsonify({"info": "该MR Diff无有效内容"}), 200

# 调用LLM获取审查建议

ai_suggestion = call_llm_api(diff_content)

# 步骤6:自动添加MR评论

comment_body = f"🤖 **AI 代码审查建议(自动生成):**\n\n{ai_suggestion}"

mr.notes.create({'body': comment_body})

return jsonify({"success": True, "message": "AI审查评论已成功添加到MR"}), 200

except Exception as e:

return jsonify({"error": f"处理MR失败:{str(e)}"}), 500

# ===== 启动服务 =====

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000, debug=False) # 生产环境关闭debug

2. 完整版(生产环境)

完整版支持配置文件分离、完善日志记录、兼容OpenAI标准接口,更适合实际部署。

步骤1:创建配置文件config.json

{

"gitlab": {

"url": "https://gitlab.example.com",

"private_token": "glpat-你的GitLab私人令牌",

"project_path": "group/test"

},

"llm": {

"api_base_url": "https://api.openai.com/v1",

"api_key": "你的LLM API Key",

"model": "gpt-3.5-turbo"

},

"webhook": {

"secret": "你的Webhook Secret Token"

}

}

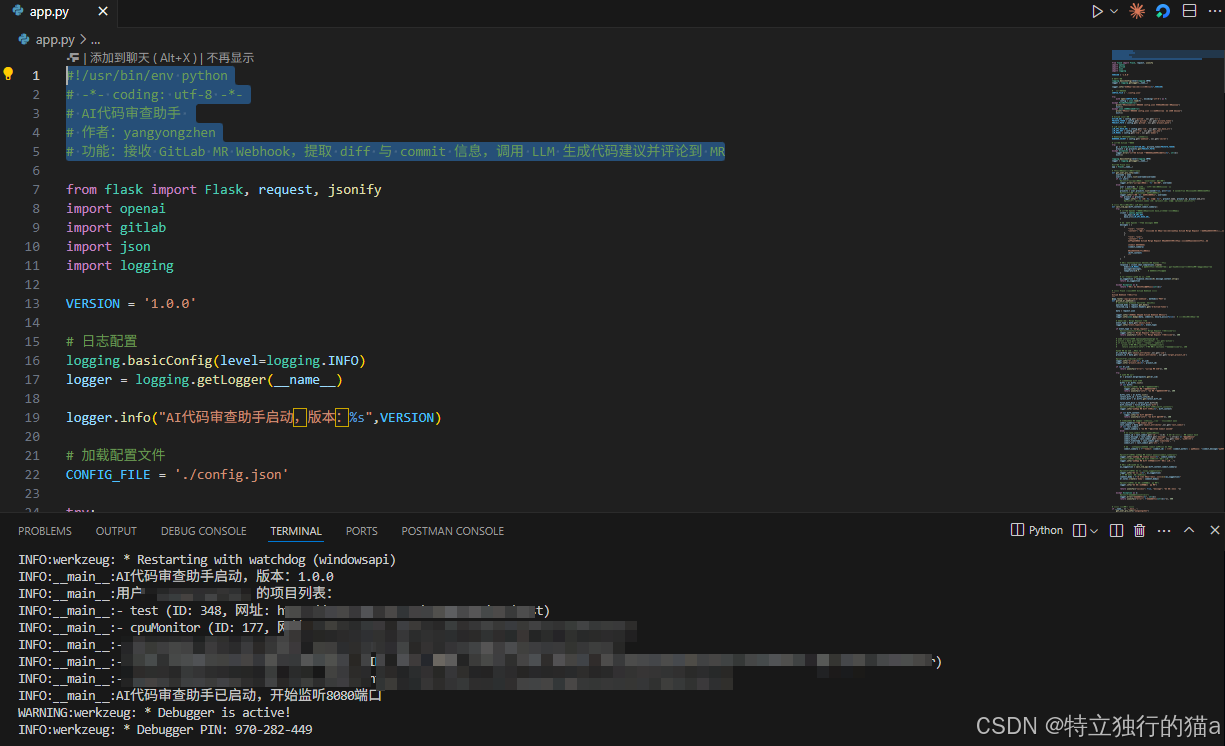

步骤2:创建完整版代码app_full.py

#!/usr/bin/env python

# -*- coding: utf-8 -*-

# AI代码审查助手

# 作者:yangyongzhen

# QQ:534117529

# blog:https://blog.csdn.net/qq8864

# 功能:接收 GitLab MR Webhook,提取 diff 与 commit 信息,调用 LLM 生成代码建议并评论到 MR

from flask import Flask, request, jsonify

import openai

import gitlab

import json

import logging

# 配置信息

VERSION = '1.0.0'

CONFIG_FILE = './config.json'

# 日志配置(生产环境可调整为文件输出)

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s',

datefmt='%Y-%m-%d %H:%M:%S'

)

logger = logging.getLogger("GitLab-AI-CodeReview")

# ===== 加载配置文件 =====

try:

with open(CONFIG_FILE, 'r', encoding='utf-8') as f:

config = json.load(f)

logger.info("配置文件加载成功")

except FileNotFoundError:

logger.error("错误:配置文件config.json不存在,请先创建并填写正确信息")

exit(1)

except json.JSONDecodeError:

logger.error("错误:配置文件config.json格式非法,不符合JSON规范")

exit(1)

# ===== 提取配置项 =====

# GitLab配置

GITLAB_URL = config.get('gitlab', {}).get('url')

PRIVATE_TOKEN = config.get('gitlab', {}).get('private_token')

PROJECT_PATH = config.get('gitlab', {}).get('project_path')

# LLM配置

LLM_API_BASE_URL = config.get('llm', {}).get('api_base_url')

LLM_API_KEY = config.get('llm', {}).get('api_key')

LLM_MODEL = config.get('llm', {}).get('model')

# Webhook配置

WEBHOOK_SECRET = config.get('webhook', {}).get('secret')

# ===== 初始化核心客户端 =====

# 初始化GitLab客户端

try:

gl = gitlab.Gitlab(GITLAB_URL, private_token=PRIVATE_TOKEN)

gl.auth() # 验证Token有效性

project = gl.projects.get(PROJECT_PATH)

logger.info("GitLab客户端初始化成功,项目:%s", PROJECT_PATH)

except Exception as e:

logger.error("GitLab客户端初始化失败:%s", str(e))

exit(1)

# 初始化OpenAI兼容客户端(支持自定义LLM接口)

try:

llm_client = openai.OpenAI(

api_key=LLM_API_KEY,

base_url=LLM_API_BASE_URL

)

logger.info("LLM客户端初始化成功,模型:%s", LLM_MODEL)

except Exception as e:

logger.error("LLM客户端初始化失败:%s", str(e))

exit(1)

# 初始化Flask应用

app = Flask(__name__)

# ===== 辅助函数:调用LLM接口生成代码审查建议 =====

def call_llm_api(diff_content, commit_summary):

try:

# 构造结构化的对话消息

messages = [

{

"role": "system",

"content": "你是一个专业的AI代码审查助手,具备丰富的软件开发与代码评审经验。请针对GitLab MR的代码变更,提供具体、详实、可落地的审查意见,包含:1. 潜在Bug与逻辑漏洞;2. 代码规范与可读性问题;3. 性能优化与可维护性建议;4. 若无明显问题,说明代码合规性。回复使用Markdown格式,语言简洁专业。"

},

{

"role": "user",

"content": f"""

请评审以下GitLab MR的代码变更内容:

## Commit 信息

{commit_summary}

## 代码变更(Diff)

{diff_content}

"""

}

]

# 调用LLM接口

response = llm_client.chat.completions.create(

model=LLM_MODEL,

messages=messages,

temperature=0.6, # 降低随机性,提升评审稳定性

max_tokens=3000

)

# 提取并返回评审结果

ai_suggestion = response.choices[0].message.content.strip()

return ai_suggestion

except Exception as e:

error_msg = f"LLM接口调用失败:{str(e)}"

logger.error(error_msg)

return error_msg

# ===== 核心路由:接收GitLab Webhook请求 =====

@app.route('/api/gitlab/mr-webhook', methods=['POST'])

def gitlab_mr_webhook():

# 步骤1:验证Webhook密钥

received_sig = request.headers.get('X-Gitlab-Token')

if WEBHOOK_SECRET and received_sig != WEBHOOK_SECRET:

logger.warning("无效的Webhook请求,密钥验证失败")

return jsonify({"error": "无效的Webhook密钥"}), 403

# 步骤2:解析请求数据

try:

data = request.json

logger.info("收到Merge Request事件,开始处理")

except Exception as e:

logger.error("无法解析请求JSON数据:%s", str(e))

return jsonify({"error": "无法解析JSON数据"}), 400

# 步骤3:筛选事件类型与操作

event_type = data.get('object_kind')

if event_type != 'merge_request':

logger.info("非Merge Request事件,忽略处理")

return jsonify({"info": "非Merge Request事件,忽略"}), 200

action = data.get('object_attributes', {}).get('action')

if action not in ['open', 'reopen', 'update']:

logger.info("MR操作%s暂不处理,忽略", action)

return jsonify({"info": f"MR操作{action}暂不处理,忽略"}), 200

# 步骤4:提取MR核心信息

mr_iid = data.get('object_attributes', {}).get('iid')

if not mr_iid:

logger.error("未提取到MR的IID编号")

return jsonify({"error": "未找到MR IID"}), 400

# 步骤5:提取Commit信息(辅助AI评审)

commit_summary = "暂无Commit关联信息"

last_commit = data.get('object_attributes', {}).get('last_commit')

if last_commit:

commit_id = last_commit.get('id', '')[:8]

commit_message = last_commit.get('message', '无提交信息').strip()

commit_author = last_commit.get('author', {}).get('name', '未知作者')

commit_summary = f"Commit ID:{commit_id} | 作者:{commit_author} | 提交信息:{commit_message}"

# 步骤6:处理MR Diff与AI评审

try:

# 获取MR对象与最新Diff

mr = project.mergerequests.get(mr_iid)

diffs = mr.diffs.list()

if not diffs:

logger.info("MR %s暂无代码变更内容", mr_iid)

return jsonify({"info": "该MR暂无变更内容"}), 200

latest_diff = diffs[0]

diff_content = latest_diff.diff

if not diff_content:

logger.info("MR %s的Diff无有效内容", mr_iid)

return jsonify({"info": "该Diff无内容"}), 200

# 调用LLM生成评审建议

logger.info("MR %s:开始调用LLM进行代码审查", mr_iid)

ai_suggestion = call_llm_api(diff_content, commit_summary)

# 自动添加MR评论

comment_body = f"🤖 **AI 代码审查建议(自动生成)**\n\n---\n{ai_suggestion}\n\n---\n> 本评论由AI代码审查助手自动生成,版本:{VERSION}"

mr.notes.create({'body': comment_body})

logger.info("MR %s:AI审查评论已成功添加", mr_iid)

return jsonify({"success": True, "message": "AI评论已添加至MR"}), 200

except Exception as e:

error_msg = f"处理MR {mr_iid}失败:{str(e)}"

logger.error(error_msg)

return jsonify({"error": error_msg}), 500

# ===== 启动服务 =====

if __name__ == '__main__':

logger.info("AI代码审查助手启动成功,版本:%s,监听端口:8080", VERSION)

app.run(host='0.0.0.0', port=8080, debug=False)

后台运行:

五、部署与测试步骤

1. 部署后端服务

- 将代码与配置文件上传至服务器(云服务器、内网服务器均可);

- 安装依赖:

pip install -r requirements.txt(可创建requirements.txt整理依赖); - 启动服务:

python app_full.py(生产环境建议使用Gunicorn+Nginx部署,避免Flask内置服务器的性能瓶颈); - 验证服务可访问:访问

http://服务器IP:8080,若返回404则说明服务启动正常(仅监听指定Webhook路由)。

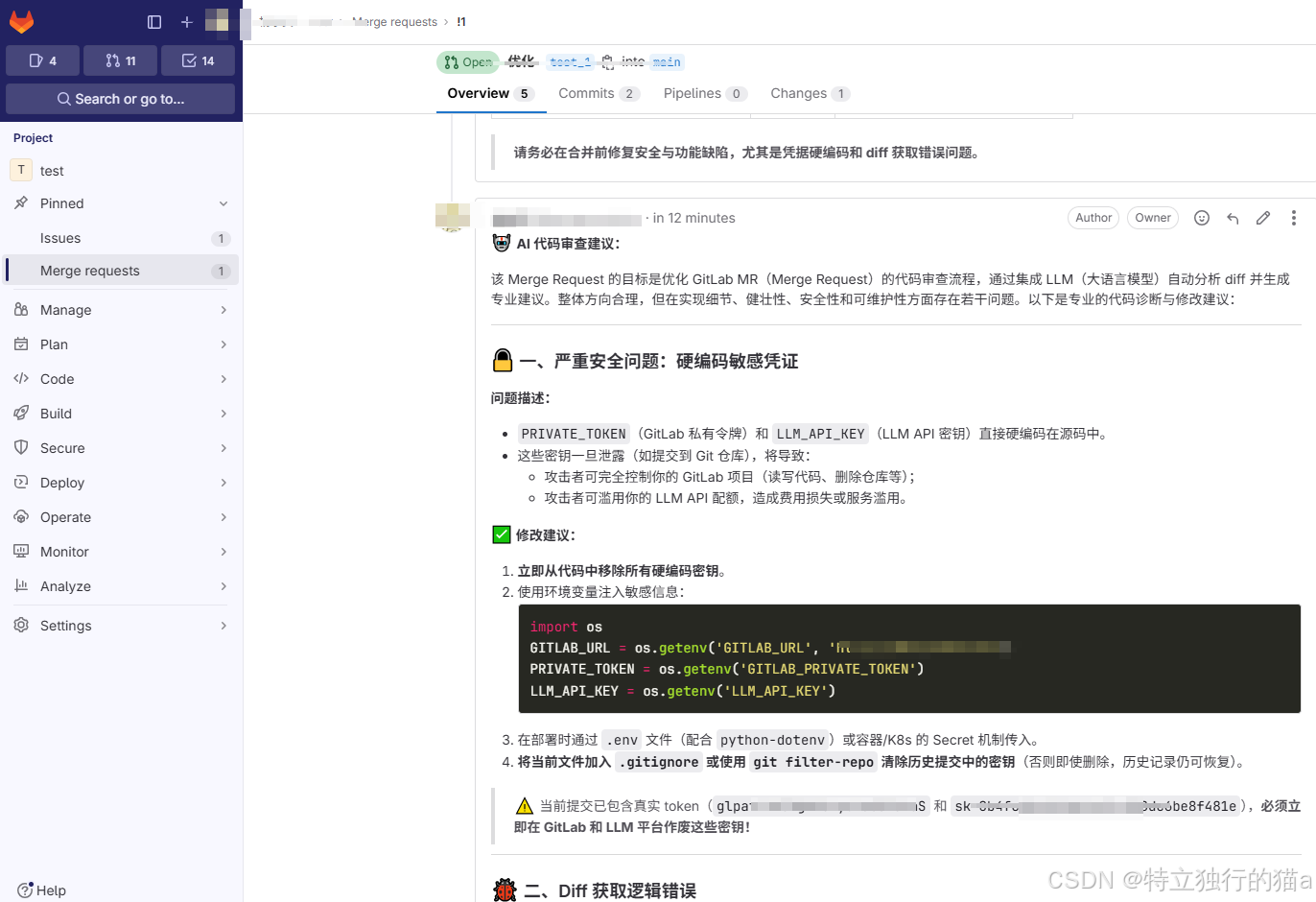

2. 测试完整流程

- 创建GitLab MR:在测试项目

test中,创建新分支并修改代码,提交后创建Merge Request; - 触发Webhook:MR创建成功后,GitLab将自动向配置的Webhook地址发送请求;

- 查看服务日志:观察服务器端的日志输出,确认是否成功接收请求、调用LLM、添加评论;

- 验证MR评论:返回GitLab的MR页面,查看评论区是否出现AI自动生成的审查建议;

- 测试更新场景:修改分支代码并推送,更新MR,验证AI是否重新生成最新审查建议。

3. 常见问题排查

- Webhook触发失败:检查GitLab Webhook配置的URL是否可访问、密钥是否一致、事件是否勾选正确;

- GitLab API调用失败:检查私人令牌是否拥有

api权限、项目路径是否正确、网络是否通畅; - LLM接口调用失败:检查API Key是否有效、接口地址是否正确、请求格式是否符合LLM要求;

- 评论未显示:检查MR的IID是否正确、后端服务是否拥有项目的评论权限。

六、方案优化与扩展

1. 生产环境优化建议

- 异步处理:引入Celery+Redis实现异步任务处理,避免LLM调用耗时导致Webhook请求超时;

- 日志持久化:将日志输出至文件或ELK堆栈,便于后续问题排查与审计;

- 权限精细化:使用项目级Token替代个人Token,降低权限泄露风险;

- 限流与去重:添加MR处理限流机制,避免频繁更新导致重复调用LLM,节省API费用;

- 错误重试:对LLM调用、GitLab API调用添加重试机制,提升方案的健壮性。

2. 功能扩展方向

- 指定文件/目录审查:支持配置忽略无关文件(如配置文件、日志文件),仅审查源代码;

- 多语言针对性审查:根据变更文件的后缀名(.py、.java、.js等),构造针对性的Prompt,提升评审准确性;

- 审查结果分级:将AI评审结果分为"严重问题"、“优化建议”、"无问题"三个等级,便于人工聚焦核心问题;

- 集成代码质量工具:结合SonarQube等工具,将静态扫描结果与AI评审结果融合,提升审查全面性;

- Issue自动关联:针对评审出的严重Bug,自动创建GitLab Issue并关联至MR。

七、方案优势与价值总结

1. 核心优势

| 优势 | 详细说明 |

|---|---|

| 🤖 全自动化 | 无需人工干预,MR提交/更新后自动触发审查,提升评审效率 |

| 🧠 智能化评审 | 借助LLM的强大能力,覆盖语法、逻辑、规范、性能等多维度审查,弥补人工经验不足 |

| ⚡ 实时性反馈 | 代码变更后立即获得AI评审建议,缩短开发与评审的迭代周期 |

| 📝 可追溯性 | AI评审结果保存在MR评论区,便于后续复盘、追溯问题修改记录 |

| 🔒 安全可控 | 支持Webhook密钥验证、权限精细化配置,保障代码与请求的安全性 |

| 💰 低成本落地 | 依赖开源工具与低成本LLM接口,部署简单,无需大量基础设施投入 |

2. 应用价值

- 对团队:提升代码质量整体水平,降低生产环境Bug率,减少人工评审的人力成本;

- 对新人:提供专业的代码修改建议,帮助新人快速熟悉编码规范,提升技术能力;

- 对管理者:实现代码审查的标准化、自动化,便于团队研发流程的管控与优化;

- 对DevOps:丰富DevOps生态的自动化环节,实现"AI+DevOps"的深度融合,提升研发效能。

八、总结

本方案通过GitLab Webhook + GitLab开放API + Python Flask + LLM大模型的组合,实现了自动化AI代码审查的完整闭环,落地难度低、性价比高,适合各类研发团队引入。无论是中小型团队提升代码质量,还是大型团队实现评审标准化,这套方案都能提供有力的支撑。

随着LLM技术的不断发展,AI代码审查的准确性与全面性还将持续提升,未来有望进一步替代人工完成大部分重复性的代码审查工作,让研发人员将更多精力投入到核心业务逻辑的设计与优化中,真正实现AI赋能研发的价值。

参考链接

https://blog.csdn.net/gitblog_00257/article/details/155378706

https://copilot.tencent.com/chat

https://www.doubao.com/chat

https://iflow.cn/

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)