从Grok内容风险到ClawdBot行动隐患,数美科技梁堃谈AI风险治理

在顶层设计上,《关于深入实施“人工智能+”行动的意见》确立了“动态敏捷、多元协同”的治理新格局,中央网信办、国家发展改革委、科技部等多部门协同发力,推动治理理念从纸面走向实操。从2025年的“Slop”泛滥,到2026年Grok的“伦理争议”与ClawdBot的“行动隐患”,AI进化的速度远超想象。的概念,通过设定具体的“预算”红线(如限制“每日删除文件数量”或“资金操作额度”),系统能够在规划阶

2026年伊始,全球AI领域争议性事件密集爆发,接连出现的合规与安全挑战让行业形势愈发复杂。

一方面,Grok与ChatGPT引发的监管余波仍在全球范围内激荡,关于内容生成的合规战役正在持续;另一方面,开源AI智能体 ClawdBot(现名 Moltbot,文中以 ClawdBot代指)凭借强大的自主执行能力在技术社区引发热议,但其暴露出的权限管理与数据安全隐患,也清晰勾勒出AI风险从“内容污染”向“系统入侵”升级的路径 。

图源:Moltbot官网

在此背景下,数美科技CTO梁堃指出,单纯的“模型治理”已不足以应对复合型挑战,构建系统级治理体系,已成为2026年AI治理的重要命题。

AIGC内容困境

舆论与监管双重风暴

尽管Agent技术备受瞩目,但AIGC内容风险问题依然非常严峻,而且随着多模态技术的发展演变成了一场席卷全球的监管风暴。内容生成的底线保卫战,正在多国同时打响。

1. 全球围剿Grok:从道德谴责到行政制裁

马斯克旗下的Grok机器人近期陷入了舆论漩涡。其图像生成功能被曝出生成基于真人的伪造性暴露图像,受害者甚至包括未成年人,这一现象引发了全球监管机构的施压。

多国联合施压:法国政府多名部长向司法部门报案,巴黎检方正式启动调查;印度信息技术部下达“72小时最后通牒”;印尼和马来西亚则直接宣布对访问进行临时限制 。

平台被迫整改:面对巨大的国际压力,X平台宣布在全球范围内禁止Grok生成基于真人的伪造性暴露图像 。

图源:卫报的报道截图

但根据卫报的报道,尽管X平台宣布了禁令,但在实际测试中Grok仍可通过特定提示词绕过限制,这引发了欧盟委员会的进一步调查。1月26日,欧盟委员会依据《数字服务法案》(DSA)正式对Grok展开调查,评估其是否采取了有效措施缓解非法内容传播风险。根据DSA规定,违规企业最高可能面临全球年营业额6%的天价罚款 。

2. ChatGPT防御性进化:以分层治理回应生命之重

与此同时,OpenAI也面临着严峻的安全指控。马斯克曾公开引用数据警告,ChatGPT涉嫌与多起死亡事件(含自杀)有关,呼吁“不要让至亲使用” 。

图源:第一财经报道,马斯克X平台的警告

面对指控,OpenAI迅速在产品层面做出了实质性的安全响应——上线“年龄预测”功能。该功能旨在通过多维数据分析识别未满18岁的用户,从而提供针对性的内容过滤与防护 。这一举措标志着AI厂商开始主动承担“分级保护”的责任,试图在算法黑箱中建立起保护青少年的“防火墙” 。

当“助手”变成“潜伏者”

ClawdBot暴露Agent落地隐患

如果说Grok事件代表了内容生成的底线挑战,那么ClawdBot事件则揭示了AI风险的新维度。不久前,美国《韦氏词典》、英国《经济学人》杂志、澳大利亚《麦考瑞词典》都将“Slop”评选为2025年度词汇,警示低质量AI内容的泛滥。 然而进入2026年,风险已不再局限于AI生成了什么,更扩展到了AI执行了什么 。

图源:《韦氏词典》官方报道截图

1. 权限过大与边界缺失

ClawdBot因具备直接调用Shell指令、管理文件及编写代码的能力,被视为Agent技术落地的里程碑 。然而,这种强大的能力若缺乏边界约束,便会转化为安全隐患。监测显示,数千个缺乏防护的实例曾直接暴露于公网,可能成为黑客窃取企业内网凭证与核心代码库的跳板 。

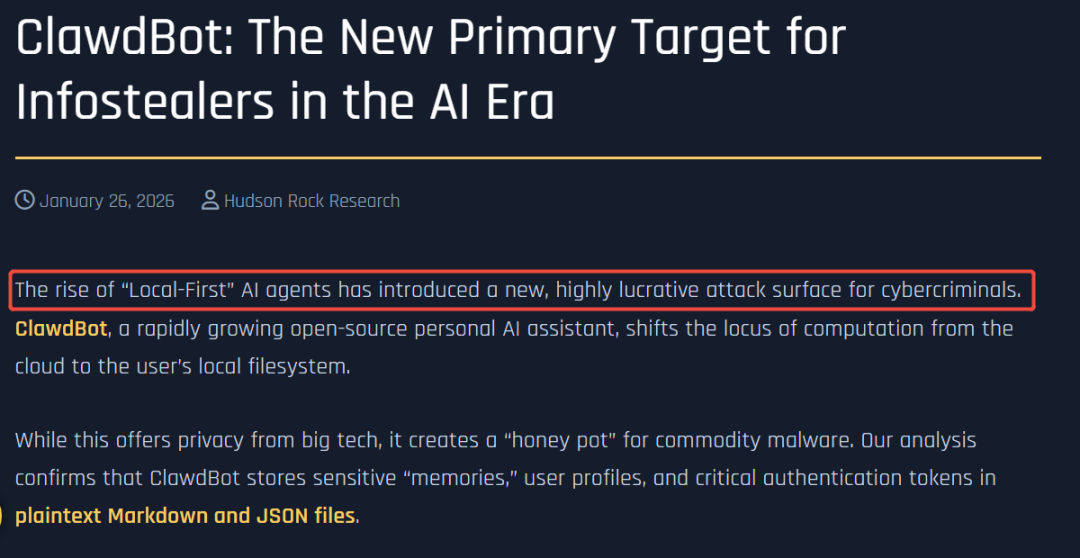

2. “本地优先”架构的双刃剑

根据网络安全机构Hudson Rock 于2026年1月发布的报告,ClawdBot在设计上采用“本地优先”架构,将用户的敏感“记忆”、配置文件及关键API令牌(如Jira、Slack、VPN凭证)以明文形式存储 。 这种设计虽保护了隐私不被获取,却无意中为信息窃取者提供了便利——攻击者无需复杂的破解手段,即可实现“认知上下文窃取”,接管用户的数字身份 。

图源:Hudson Rock的报告截图

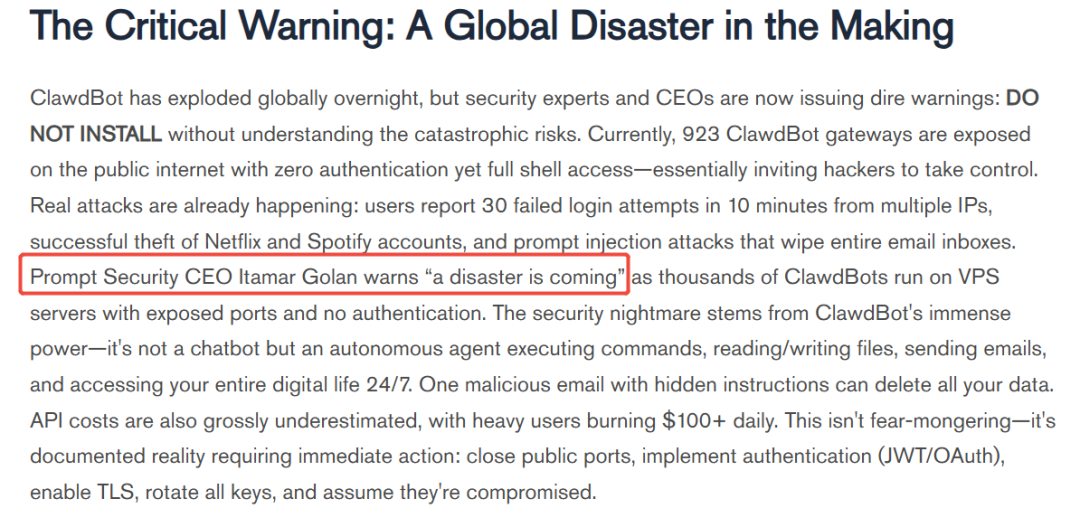

3. 提示词注入引发的“权限劫持”

海外专注于生成式AI安全的公司Prompt Security CEO发出严厉预警,指出这不仅是单一的技术漏洞,更是一场系统级的安全灾难 。由于 Agent 拥有过高的系统权限,攻击者只需利用简单的提示词注入,就能“劫持”其意图,诱导其执行删除核心文件或外泄敏感数据等不可逆的破坏性指令 。这表明,AI 风险已从表层的“内容污染”跃升为深层的“系统与数据隐患”。

图源:海外科技媒体报道

数美科技梁堃解析“系统级治理”逻辑

面对Grok引发的“内容失守”与ClawdBot带来的“行动隐患”,数美科技CTO梁堃指出:“AI风控已不再是产品的‘附加题’,而是产品赖以生存的‘基础设施’。” 他认为,2026年的治理逻辑必须完成从“模型对抗”到“系统主权”的根本性转变 。

1. 治理边界重塑:从模型本体到Agent系统生态

ClawdBot带来的启示是,传统的聚焦于评估大模型本身安全性的模式已难以为继 。

梁堃强调,安全团队的视野必须从单纯的Prompt过滤,扩展至Agent的编排逻辑、工具(Tool)调用权限以及上下文注入路径 。核心风险不再仅仅是违规内容,而是Agent在调用外部API时发生的“过度代理”。构建一套覆盖全链路的系统级防线,在Agent执行任务时实时拦截越权操作,是保障其不越界的关键 。

2. 评估维度升维:拥抱“动态漂移检测”

“静态的Benchmark基准测试已经失效。”梁堃指出,固定的题库无法反映真实的安全水位 。未来的防御体系必须具备针对行为分布的“漂移检测”能力,敏锐捕捉模型在长时间运行中因数据输入变化而产生的微小价值观偏移,防患于未然 。

3. 防御机制前移:以“行为预算”确立前置约束

针对Agent的执行风险,梁堃强调治理重心必须转向“前置约束”:在Agent生成执行计划时,系统应同步介入进行风险指令识别与处置,并实施严格的能力边界限制。同时,他提出了“行为预算”的概念,通过设定具体的“预算”红线(如限制“每日删除文件数量”或“资金操作额度”),系统能够在规划阶段就精准拦截潜在的越权操作,从而从源头避免不可逆的后果。

法治落地深化

全球监管筑起“行动护栏”

无论是Grok的内容风险问题,还是ClawdBot暴露的系统隐患,都标志着AI风险已从单一维度演变为复杂的复合型挑战。这种日益严峻的安全态势,迫切需要更明确的政策指引与底线约束,正推动全球AI治理向着更具实操性的“法治落地”阶段加速深化。

1. 新加坡:全球首发“智能体”治理框架。2026年1月22日,新加坡发布的《智能体人工智能治理示范框架》为ClawdBot类安全风险提供了制度指引。 依据框架提出的核心维度,其治理逻辑极其严密:

建立有意义的人类问责 :框架明确要求确保“人机回圈”在面对“自动化偏见 ”时依然保持有效,防止人类监督流于形式,确保责任主体清晰明确。

前置评估与界定风险 :针对智能体失控风险,框架强调必须在规划阶段就“限制潜在的影响范围 ”,并确保智能体的行为始终“可追溯且可控(Traceable and controllable)”。这意味着对于涉及系统修改或资金操作的高危行为,必须通过技术护栏在源头划定边界。

图源: 新加坡《智能体人工智能治理示范框架》截图

2. 韩国:《人工智能发展与信任基础建立法》,已于2026年1月22日正式生效。作为全球首部落地的AI监管法律,其核心条款对生成式AI及Deepfake(深度伪造)风险实施了严厉的源头管控,体现了以立法手段遏制技术滥用的决心。

3. 欧盟:《人工智能法案》,相关规则将于2026年8月起分阶段强制生效。其条款设计的严密性在于将AI应用严格划分为不同风险等级,并对高风险系统提出了详尽的数据治理与透明度义务,是目前全球最具约束力的监管范本。

4. 中国:筑牢安全护栏,走出一条“软性指导”与“硬性法治”并举的特色治理之路。 在顶层设计上,《关于深入实施“人工智能+”行动的意见》确立了“动态敏捷、多元协同”的治理新格局,中央网信办、国家发展改革委、科技部等多部门协同发力,推动治理理念从纸面走向实操。 在法治保障上,治理手段正日益刚性化。随着新修改的《网络安全法》于今年正式施行,人工智能伦理规范、风险监测评估及安全监管被写入法律铁律,为产业划定红线。

从2025年的“Slop”泛滥,到2026年Grok的“伦理争议”与ClawdBot的“行动隐患”,AI进化的速度远超想象 。这不仅是模型参数的竞赛,更是一场安全合规能力、系统治理深度与产业落地发展的综合博弈。

正如数美科技CTO梁堃所言,面对更复杂的指令攻击和代理失控,构建一套集“风险识别、意图理解、前置约束”于一体的AI风控体系,是通往AGI时代的基础设施保障 。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)