LangChain解读

LangChain 是一个,核心定位是「连接大语言模型(LLM)与外部资源的中间件」。它并非替代 LLM,而是通过模块化设计,让开发者快速构建 “LLM + 数据 + 工具” 的端到端 AI 应用 —— 本质是为 Python 程序员提供一套标准化的接口、工具链和最佳实践,避免重复开发 “LLM 调用、数据加载、流程控制” 等通用逻辑。核心特点:模块化:所有组件可拆分、替换(如切换 OpenAI

LangChain解读

一、什么是 LangChain?

LangChain 是一个 基于 Python/JavaScript 的开源框架,核心定位是「连接大语言模型(LLM)与外部资源的中间件」。它并非替代 LLM,而是通过模块化设计,让开发者快速构建 “LLM + 数据 + 工具” 的端到端 AI 应用 —— 本质是为 Python 程序员提供一套标准化的接口、工具链和最佳实践,避免重复开发 “LLM 调用、数据加载、流程控制” 等通用逻辑。

核心特点:

-

模块化:所有组件可拆分、替换(如切换 OpenAI / 本地化 LLM、更换数据库)

-

可扩展性:支持自定义组件(如专属数据加载器、工具函数)

-

流程化:内置链(Chain)和代理(Agent)机制,简化复杂业务逻辑串联

二、LangChain 主要解决什么问题?

没有 LangChain 时,Python 开发者使用 LLM 会面临以下痛点:

-

LLM 调用碎片化:不同 LLM(OpenAI、Anthropic、本地化模型)接口不统一,切换成本高;

-

数据割裂:LLM 无法直接访问外部数据(数据库、PDF、API),只能依赖训练数据;

-

逻辑串联复杂:单轮 LLM 调用无法满足多步骤任务(如 “查询数据库→分析结果→生成报告”);

-

工具集成繁琐:手动对接 LLM 与工具(计算器、搜索引擎、API)需处理异常、上下文传递等细节。

LangChain 的解决方案:

-

统一 LLM 接口:用

llms模块封装各类模型,切换时仅需修改 1 行代码; -

数据接入标准化:通过

document_loaders加载多源数据,embeddings模块处理向量转换; -

流程自动化:用

Chain串联多步骤,Agent实现动态决策; -

工具生态丰富:内置数百种工具(数据库、云服务、第三方 API),支持自定义扩展。

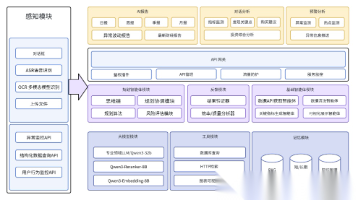

三、LangChain 的核心组成

LangChain 的核心组件按 “数据流转 + 逻辑控制” 分层,各组件可单独使用或组合:

| 组件模块 | 核心作用 | 常用类 / 函数(Python) |

|---|---|---|

| Models(模型) | 封装 LLM / 嵌入模型 / 聊天模型 | OpenAI、ChatOpenAI、HuggingFaceEmbeddings |

| Prompts(提示) | 提示词模板、格式化、动态生成 | PromptTemplate、FewShotPromptTemplate |

| Chains(链) | 串联多步骤操作(如 “提示 + LLM + 输出处理”) | LLMChain、SequentialChain、RetrievalQA |

| Data Connection(数据连接) | 加载 / 转换 / 存储外部数据 | PyPDFLoader(加载 PDF)、Chroma(向量库) |

| Agents(代理) | 基于用户需求动态调用工具 / 链,自主决策 | AgentExecutor、ChatZeroShotAgent |

| Tools(工具) | 封装可被 Agent/Chain 调用的外部功能 | SerpAPI(搜索引擎)、SQLDatabaseToolkit |

| Memory(记忆) | 存储对话历史 / 中间状态,支持上下文复用 | ConversationBufferMemory、ConversationSummaryMemory |

核心逻辑链路:用户需求 → Prompt 模板格式化 → Chain/Agent 调度 → 调用 Models+Tools+Data → 结合 Memory 返回结果

四、LangChain 的应用场景

-

智能问答系统:接入私有文档(PDF / 知识库),实现 “基于文档的精准问答”(如企业内部知识库问答、PDF 解析问答);

-

对话机器人:支持多轮对话、上下文记忆,可对接工具(如客服机器人查询订单、天气机器人调用天气 API);

-

数据处理与分析:连接数据库(SQL/Excel),用自然语言生成 SQL 查询、分析结果并生成报告(如 “查询近 3 个月销售额并可视化”);

-

自动化工作流:串联多工具完成复杂任务(如 “爬取网页数据→分析内容→生成 PPT→发送邮件”);

-

LLM 应用快速原型:快速切换 LLM 模型、验证业务逻辑,降低从 “想法到产品” 的开发成本;

-

本地化部署:支持对接开源 LLM(如 Llama 2、Qwen),实现私有化部署(无网络依赖)。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)