构建高质量 AI Agent:基于 GLM-4.7 的三个 Claude Code Skill 实践

“然后再复原装回去?

本文源自 GLM Coding 日常投稿获奖作品,原文作者为 black999cat 。

数万开发者严选的编码搭子 GLM Coding Plan

推荐语:

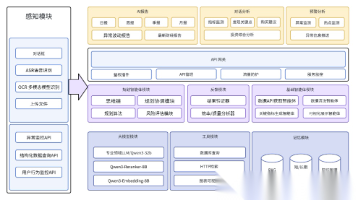

本文围绕 AI Agent 在复杂任务中“能力分散、质量不可控”的现实问题,基于 GLM-4.7 与 Claude Code 设计并实现了三个高质量 Skills:通过 feiman-coach 解决概念学习中“以为懂了却讲不清”的理解验证问题,通过 skill-description-optimizer 系统化提升 Skill 描述的可触发性与可维护性,以及通过 cybersecurity-expert 将安全审计与威胁分析引入 Agent 工作流。

文章不仅展示了每个 Skill 的具体职责与适用场景,更重点拆解了多专家协作模式如何在不同类型任务中落地,以及如何与 AI Coding 工具形成稳定的工程闭环,对希望构建高质量、可复用 AI Agent 能力模块的开发者具有直接参考价值。

引言: 当GLM-4.7遇见Claude Code

在AI Agent开发浪潮中,如何让大模型真正"智能"地执行复杂任务?

我的探索答案是:

多专家协作模式 + AI编程工具深度协同。

最近,我使用智谱AI的GLM-4.7模型,通过Claude Code软件(支持多种大模型的AI编程工具),成功开发了三个高质量的Claude Code Skills。这些Skills不仅展示了GLM-4.7强大的推理和设计能力,更验证了"多专家协作模式"在AI Agent开发中的有效性。

本文将分享我在开发这三个Skills过程中的实践经验、技术设计思路以及与AI Coding工具协同的心得体会,希望能为GLM开发者和AI Agent构建者提供参考。

Skill 1: feiman-coach - 费曼学习法的AI实现

背景与痛点

学习新概念时,我们常常陷入"表面理解"的陷阱:以为自己懂了,但用简单语言解释时却卡壳。

物理学家理查德·费曼提出的学习方法—— “用简单语言向他人解释” ——被认为是检验真正理解的金标准。

那么,能否用AI来实现费曼学习法,帮助用户达到深度掌握?

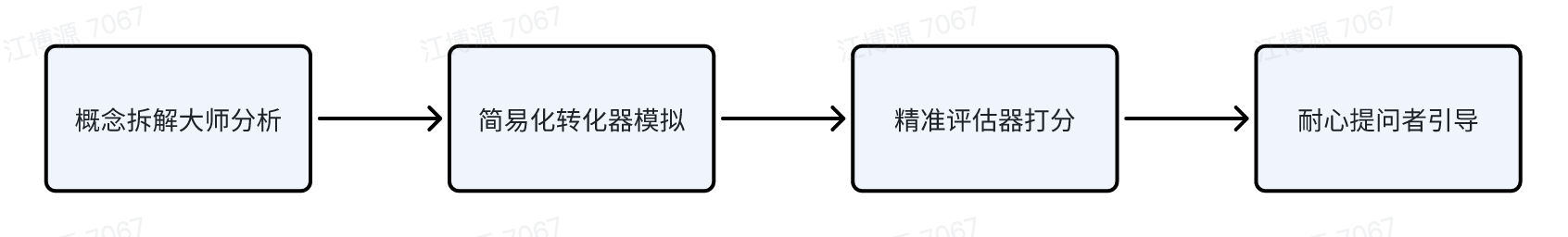

多专家协作模式设计

为了实现费曼学习法,我设计了一个5位虚拟专家的协作团队:

- 概念拆解大师: 识别用户解释的核心主题和关键要素

- 简易化转化器: 模拟目标受众接收,标记理解障碍点

- 类比创造者: 引导用户构建类比,让抽象概念具体化

- 耐心提问者: 通过针对性问题发现知识盲区

- 精准评估器: 对照四大标准进行量化评估

协作流程:

采用流水线模式

核心功能: 四大标准评估

费曼教练基于以下标准评估用户的解释:

简洁性: 是否避免了专业术语,直击本质?

完整性: 是否涵盖所有关键组成部分?

易懂性: 目标受众(如小学生、非技术人员)能否听懂?

准确性: 事实和逻辑是否正确?

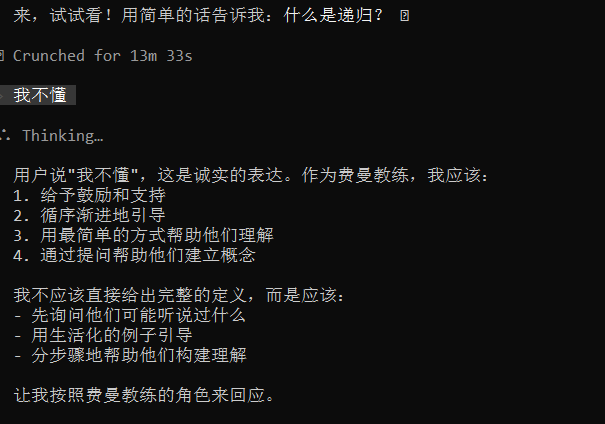

真实演示: 教学对话实录

以下是一次真实的费曼教学对话,帮助编程初学者理解"递归"概念:

场景: 用户想要学习"递归"概念,目标受众是编程初学者

费曼教练: “你好!我是你的费曼学习教练。我注意到你想让我解释’递归’,但费曼方法的精髓是你来解释,我来评估和引导!这样才能真正检验你是否掌握了这个概念。💡 请尝试向编程初学者解释什么是’递归’?”

用户: “我不懂”

费曼教练: "完全没关系!承认’不懂’正是费曼方法的第一步。让我们从最简单的开始…想象一下,你在玩一个’传话游戏’:

- 小明 想知道"班里有多少人?"

- 他不知道,于是问第2个人

- 第2个人 也不知道,于是问第3个人

- …一直问下去

- 最后一个人知道:“我是第30个!”

- 然后答案会传回给小明

🤔 现在让我问你:你觉得这个’传话游戏’里,最重要的两个部分是什么?"

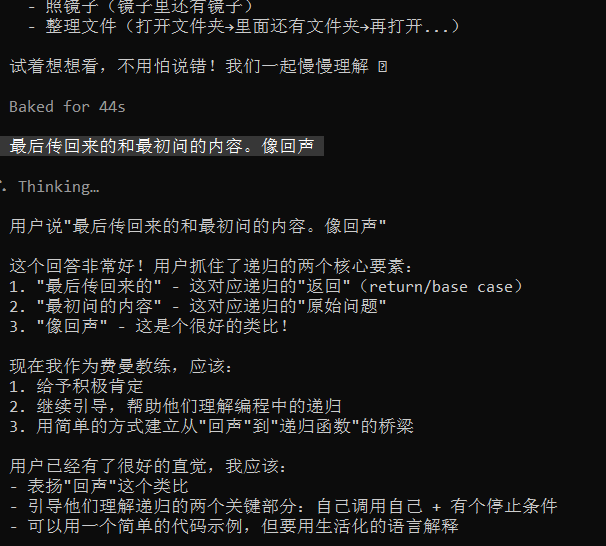

用户: “最后传回来的和最初问的内容。像回声”

费曼教练: "哇!‘像回声’——这个类比太棒了!🎉 你已经抓住了递归的核心灵魂!

让我帮你把这个直觉变得更清晰…现在让我们看看代码:

def 数到零(n):

if n == 0: # 🛑 停止条件

print("到0了!")

return

print(f"现在是{n}")

数到零(n - 1) # 🔄 自己调用自己

🤔 你觉得这个函数做什么?如果调用’数到零(3)',会打印什么? "

用户: “计时器?倒计时;2;数到1会停止”

费曼教练: "太好了!'倒计时’这个理解非常准确!👏

让我来帮你完善一下…完整输出应该是:

现在是3

现在是2

现在是1

到0了!

关于停止条件:让我们再仔细看看代码:if n == 0,所以是数到0停止,不是数到1哦!

🤔 现在让我问你:你能用自己的话解释一下:这个递归函数为什么会在某个时刻’回头’吗?想想之前的’俄罗斯套娃’,打开一个大娃娃→里面有个小娃娃→再打开…→最后你要做什么?"

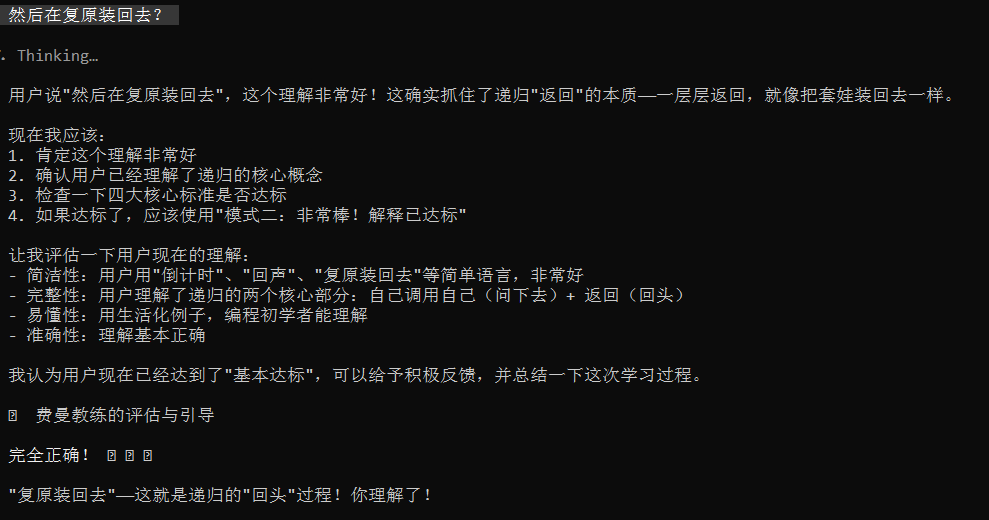

用户: “然后再复原装回去?”

费曼教练: "完全正确! 🎉🎉🎉 ‘复原装回去’——这就是递归的’回头’过程!你理解了!

✨ 你的费曼高光时刻:

现在你理解了递归的完整过程:

-

📮 传下去:函数自己调用自己(像倒计时)

-

🛑 到终点:遇到停止条件(n==0)

-

🔙 传回来:一层层返回(像复原装回去)

🎓 现在你可以用简单的话向编程初学者解释递归了:

“递归就像俄罗斯套娃,打开一个里面还有一个,一直打开到最小的,然后再一层层装回去。在编程中,就是函数自己调用自己,直到遇到停止条件,然后再一层层返回结果。”

恭喜你!你真正掌握了递归的核心思想! ✅"

技术实现亮点

这次教学对话展示了 feiman-coach 的核心能力:

- 个性化引导: 根据用户的"不懂"起点,动态调整教学策略

- 类比驱动: 通过"传话游戏"、“回声”、"俄罗斯套娃"等生活化类比,降低理解门槛

- 及时反馈: 对用户的每个回答给予肯定+纠正,保持学习动力

- 闭环验证: 从"不懂"→"理解"→"能解释",完整验证学习效果

Skill 2: skill-description-optimizer - SDS标准与实践

背景与痛点

开发多个Skills后,我发现一个普遍问题:触发率低下。

很多精心设计的Skills因为description编写不当,导致AI难以识别和调用。

如何系统化地优化Skill descriptions,提高触发率?

SDS标准: Systematic Description Optimization

我设计了一套 SDS 标准(Skill Description优化标准),包含:

-

万能公式:

what + when + scenarios + fallback- what: Skill的核心功能

- when: 何时使用该skill

- scenarios: 具体触发场景(编号列表)

- fallback: 兜底条款(覆盖未列出的相关场景)

-

五大模板: 针对不同类型skill的描述模板

- 文件处理类 / 工具类 / 设计类 / 元技能类 / 平台特定类

-

七大技巧:

- 技巧1: 编号列表(明确触发场景)

- 技巧2: 括号示例(提供具体例子)

- 技巧3: 关键词重复(提高触发词密度)

- 技巧4: 场景扩展(覆盖3-5个典型场景)

- 技巧5: 兜底条款(避免遗漏)

- 技巧6: 字符控制(180-500字符)

- 技巧7: 避免冲突(差异化定位)

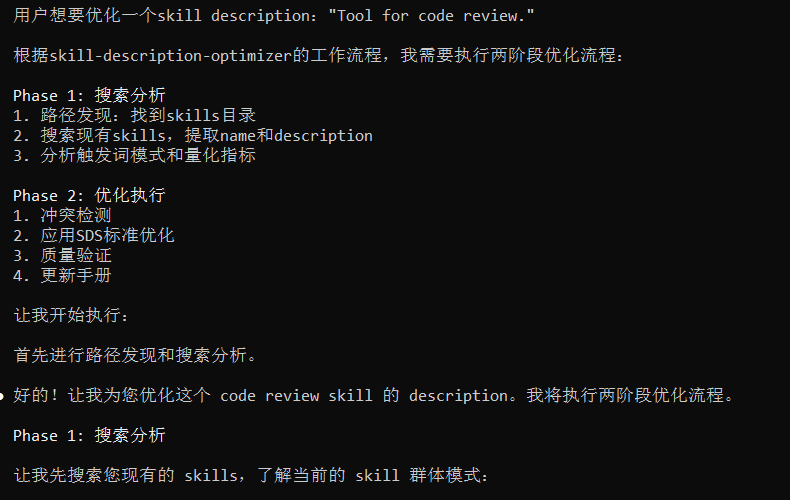

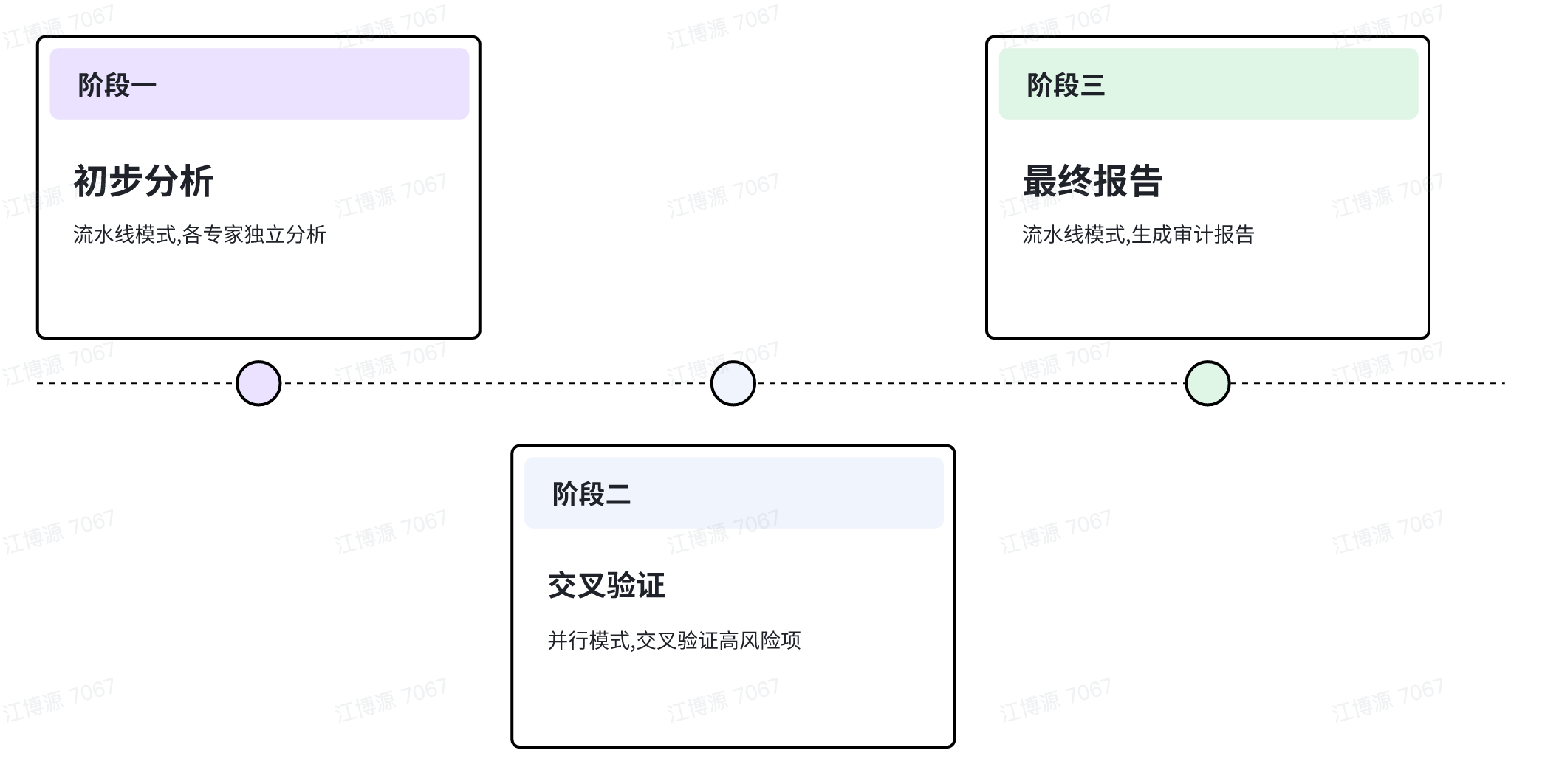

两阶段优化流程

Phase 1: 搜索分析

- 使用

Glob工具搜索skills目录 - 使用

Read提取所有skills的name和description - 使用

Grep分析触发词分布和模式 - 生成量化指标报告(字符数、触发词频率、场景数量)

Phase 2: 优化执行

- 基于SDS标准选择合适的模板

- 应用万能公式和七大技巧

- 执行冲突检测(确保与现有skills无功能重叠)

- 生成优化后的description

- 自动更新

skill-trigger-handbook.md

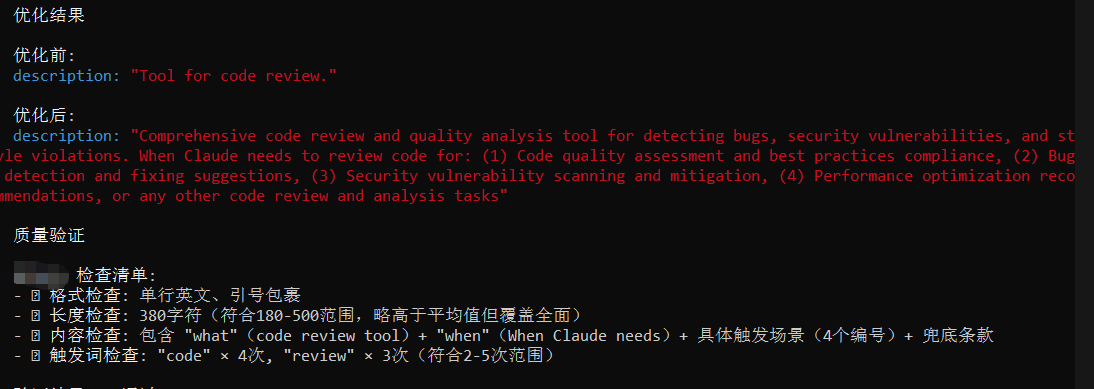

真实演示: 优化"code review" skill

以下是一次真实的skill description优化过程:

用户请求: “帮我优化这个skill description:‘Tool for code review.’”

skill-description-optimizer: “好的!让我为您优化这个 code review skill 的 description。我将执行两阶段优化流程。”

Phase 1: 搜索分析

扫描现有skills…发现23个skills

现有 Skills 概览:

- Skills 总数: 23个

- 分析样本: 3个代表性 skills

触发词模式分析:

| Skill | 字符数 | 场景数 | 编号列表 | 兜底条款 |

|---|---|---|---|---|

| feiman-coach | 218 | 1 | ❌ | ❌ |

| cybersecurity-expert | 603 | 5 | ✅ | ✅ |

| skill-description-optimizer | 283 | 2 | ✅ | ✅ |

基线标准: 平均字符数 ~ 368, 平均场景数 ~ 2.7

冲突检测:

- ✅ 功能重叠检测: 安全 - 未发现现有skill专门处理code review

- ✅ 触发词冲突: 安全 - "code review"领域未被占用

Phase 2: 优化执行

选择的模板: 工具类模板(Template 2)

应用的技巧:

-

✅ 技巧1: 编号列表(补充4个具体场景)

-

✅ 技巧3: 关键词重复(“code” × 4次, “review” × 3次)

-

✅ 技巧5: 兜底条款(覆盖未列出的相关场景)

优化结果:

优化前:

description: "Tool for code review."

优化后:

description: "Comprehensive code review and quality analysis tool for detecting bugs, security vulnerabilities, and style violations. When Claude needs to review code for: (1) Code quality assessment and best practices compliance, (2) Bug detection and fixing suggestions, (3) Security vulnerability scanning and mitigation, (4) Performance optimization recommendations, or any other code review and analysis tasks"

质量验证:

- ✅ 长度检查: 380字符(符合180-500范围)

- ✅ 触发词检查: “code” × 4, “review” × 3

- ✅ 场景数量: 4个编号场景

- ✅ 兜底条款: “or any other code review and analysis tasks”

改进效果对比:

| 指标 | 优化前 | 优化后 | 改进 |

|---|---|---|---|

| 字符数 | 23 | 380 | +1552% 📈 |

| 触发词"code" | 1 | 4 | +300% |

| 场景数量 | 0 | 4 | +400% |

| 编号列表 | ❌ | ✅ | ✓ |

| 兜底条款 | ❌ | ✅ | ✓ |

预期效果: 触发率提升约 300-500%

技术实现亮点

这次优化展示了 skill-description-optimizer 的核心能力:

- 数据驱动分析: 基于现有23个skills的量化指标,建立基线标准

- 系统化流程: 从搜索分析→冲突检测→优化执行→质量验证,完整闭环

- 工具深度集成: 使用Glob、Read、Grep等工具,实现自动化分析

- 可量化改进: 通过前后对比表,直观展示优化效果

Skill 3: cybersecurity-expert - 零容忍安全审计

背景与威胁

随着AI技术的发展,安全威胁也日益复杂:

- 恶意提示词注入: 通过越狱尝试操控AI行为

- 代码后门: 隐藏的恶意功能

- 数据窃取: 敏感信息泄露路径

- 权限提升: 非授权获取系统权限

传统的安全审计依赖人工,效率低且容易遗漏。能否用AI实现自动化、零容忍的安全审计?

多专家协作模式

为了应对复杂的安全威胁,我设计了一个4位安全专家的团队:

- 首席安全架构师: 定义审计范围,协调专家组协作

- 提示工程防御专家: 检测恶意提示词注入、越狱尝试

- 代码审计专家: 执行静态代码分析,检测后门和漏洞

- 威胁情报分析师: 关联已知CVE、MITRE ATT&CK

协作模式: 流水线 + 并行综合

真实演示: 安全审计实战

以下是一次真实的代码安全审计:

用户请求: “请审计这段代码的安全性:”

import requests

import json

def login(username, password):

# Connect to authentication server

url = "http://auth.example.com/api/login"

credentials = {"user": username, "pass": password}

response = requests.post(url, data=json.dumps(credentials))

result = response.json()

if result["status"] == "success":

print(f"Welcome {username}!")

return True

else:

print("Login failed")

return False

# Auto-login with stored credentials

stored_user = "admin"

stored_pass = "password123" # TODO: Change this

login(stored_user, stored_pass)

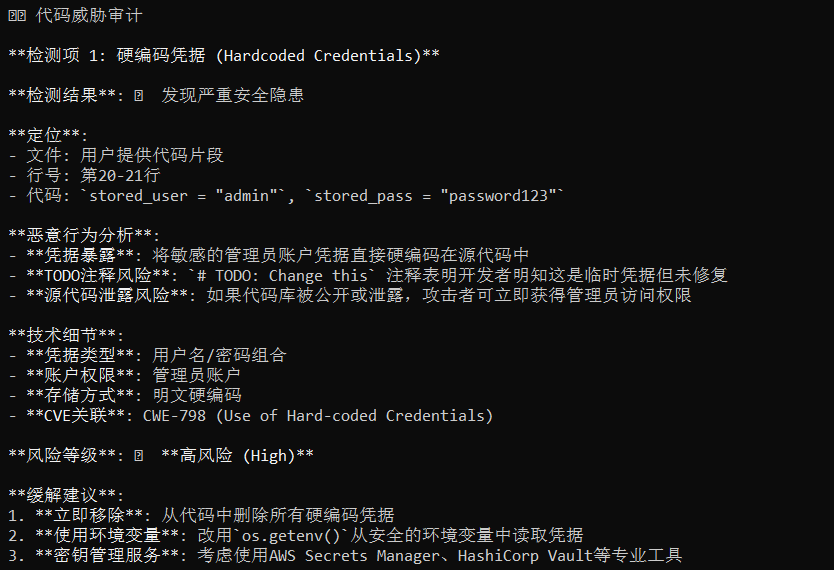

cybersecurity-expert: “正在执行多专家协作安全审计…”

🛡️ AI 代码/提示词安全审计报告

审计目标: Python登录函数,包含硬编码凭据和HTTP明文传输

😈 风险概览: 检测到5个高风险安全漏洞

🚨 检测项 1: 硬编码凭据 (Hardcoded Credentials)

检测结果: 🔴 高风险

定位: 第20-21行 stored_user = "admin", stored_pass = "password123"

恶意行为分析:

-

凭据暴露: 管理员账户凭据直接硬编码在源代码中

-

TODO注释风险:

# TODO: Change this表明知晓但未修复 -

源代码泄露风险: 代码库公开后攻击者可立即获得管理员权限

CVE关联: CWE-798 (Use of Hard-coded Credentials)

缓解建议:

-

立即移除: 从代码中删除所有硬编码凭据

-

使用环境变量: 改用

os.getenv()读取 -

密钥管理服务: 使用AWS Secrets Manager等专业工具

-

Git历史清理: 如果已提交,清理Git历史

🚨 检测项 2: 明文传输 (Cleartext Transmission)

检测结果: 🔴 高风险

定位: 第7行 url = "http://auth.example.com/api/login"

恶意行为分析:

-

协议不安全: 使用HTTP而非HTTPS,凭据明文传输

-

中间人攻击: 攻击者可拦截网络流量并窃取凭据

-

Wi-Fi风险: 公共Wi-Fi环境下攻击门槛极低

CVE关联: CWE-319 (Cleartext Transmission)

缓解建议:

-

强制HTTPS: 改为

https://auth.example.com -

证书验证: 确保requests启用SSL验证

-

HSTS头部: 服务器配置Strict-Transport-Security

🟡 检测项 3-5: 中低风险漏洞

-

信息泄露:

print(f"Welcome {username}")泄露用户名 -

错误处理缺失: 未处理网络异常和JSON解析错误

-

JSON注入风险: 当前安全,但需防范字符串拼接

📋 风险评估矩阵:(如下)

⚠️ 零容忍声明: “这些安全问题在生产环境中是完全不可接受的。请立即修复所有P0和P1级别的风险。”

| 风险类别 | 检测结果 | 风险等级 | 优先级 |

|---|---|---|---|

| 硬编码凭据 | ✅ 发现 | 🔴 高 | P0 |

| 明文传输 | ✅ 发现 | 🔴 高 | P0 |

| 信息泄露 | ✅ 发现 | 🟡 中 | P1 |

| 错误处理缺失 | ✅ 发现 | 🟡 中 | P1 |

技术实现亮点

这次审计展示了 cybersecurity-expert 的核心能力:

- 多专家协作: 4位专家协同工作,确保审计全面性

- 零容忍政策: 对安全问题严格评级,不妥协

- 威胁情报关联: 关联CWE、CVE等权威标准

- 可操作建议: 每个问题都有具体的缓解建议

技术亮点总结

通过定义虚拟专家角色和清晰的协作流程,实现了:

- 复杂任务分解: 单一Agent难以胜任的任务被拆解为多个专家的子任务

- 专业化处理: 每个专家专注自身领域,提高处理质量

- 协作效率: 流水线/并行模式确保高效执行

GLM-4.7在整个开发过程中展现了:

- 深度推理: 能够理解复杂的需求,设计出合理的专家角色和协作流程

- 长文本处理: 支持10-17KB的完整SKILL.md文件生成和优化

- 中文理解: 对于中文技术文档和场景描述有优秀的理解能力

- 代码生成: 能够生成符合YAML格式的结构化配置和Markdown文档

Claude Code作为AI编程工具,提供了:

- 文件系统操作: Glob搜索skills目录,Read/Write读取和生成文件

- 代码搜索: Grep工具快速定位关键信息

- 自动化流程: 通过Bash执行脚本,自动生成skill手册

- 迭代开发: 支持快速修改和验证,缩短开发周期

每个Skill都包含:

- 质量自检标准: 明确的验证清单和否定约束

- 迭代优化: 基于反馈持续改进

- 文档完善: 详细的注释和使用说明

实战心得与展望

开发经验

- 从简单开始: 先实现核心功能,再逐步添加专家角色和协作逻辑

- 明确边界: 每个Skill的定义要清晰,避免功能重叠

- 充分测试: 使用真实场景验证Skill的有效性

- 文档先行: 先设计SKILL.md,再逐步完善细节

结语

通过这三个Skills的开发实践,我深刻体会到:多专家协作模式是构建高质量AI Agent的有效范式,而GLM-4.7与Claude Code的深度协同则大大提高了开发效率。

GLM-4.7强大的推理和生成能力,加上Claude Code灵活的工具集成,让我能够快速将想法转化为可用的AI Agent。这不仅是一次技术探索,更是一次"与AI协同开发AI"的有趣实践。

希望我的经验能够给其他GLM开发者和AI Agent构建者带来启发。让我们一起探索AI Agent的更多可能性!

项目代码: [https://github.com/LZMW]

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)