大二没听懂的课,非要等到 AI 时代才来“还债”吗

不,它只知道在 12288 维的超高维空间里,“猫”的向量和“吃鱼”的向量紧紧贴在一起,而和“吃电池”的向量相隔一个银河系。如果说特征值分解只能处理简单的“方阵”,那 SVD 就是它的终极加强版,能处理任何乱七八糟的数据矩阵。这个稳定状态,就是这个矩阵的。如果你只学编程语言,你是一个优秀的剑客,招式凌厉,能写出漂亮的 Java/Python。即便你从未搜过“二次元”,但 SVD 发现你喜欢的几部电

🔴 序言:那场长达四年的“数学骗局”

在大多数程序员的记忆里,线性代数是一场枯燥的噩梦: 无休止的行列式展开、算到想吐的逆矩阵、毫无意义的克莱姆法则……在那时的我们看来,这门课除了用来混学分,能有什么用?

但今天,我想请你看清线代背后的真实世界。

真相是:在 AI 统治的时代,微积分处理的是“局部变化”,而线性代数处理的是“万物关系”。

如果说代码是逻辑的骨架,那么线性代数就是上帝编写宇宙时使用的标准库(API)。OpenAI 的 GPT-4 本质上是一个巨大的矩阵乘法器;Google 万亿市值的基石,其实只是一个矩阵的特征向量。

今天,我们跳过那些枯燥的公式,用程序员的视角,重构你的数学观。

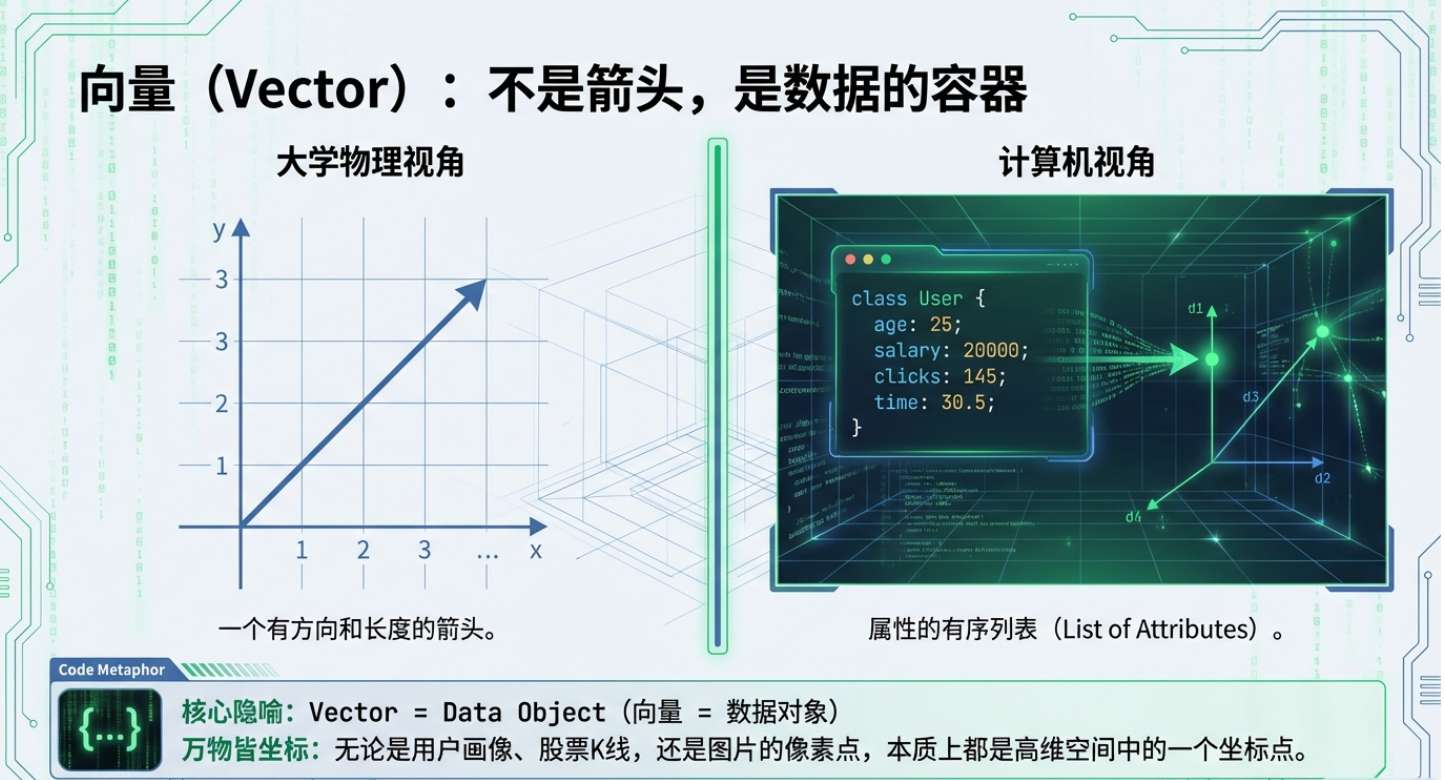

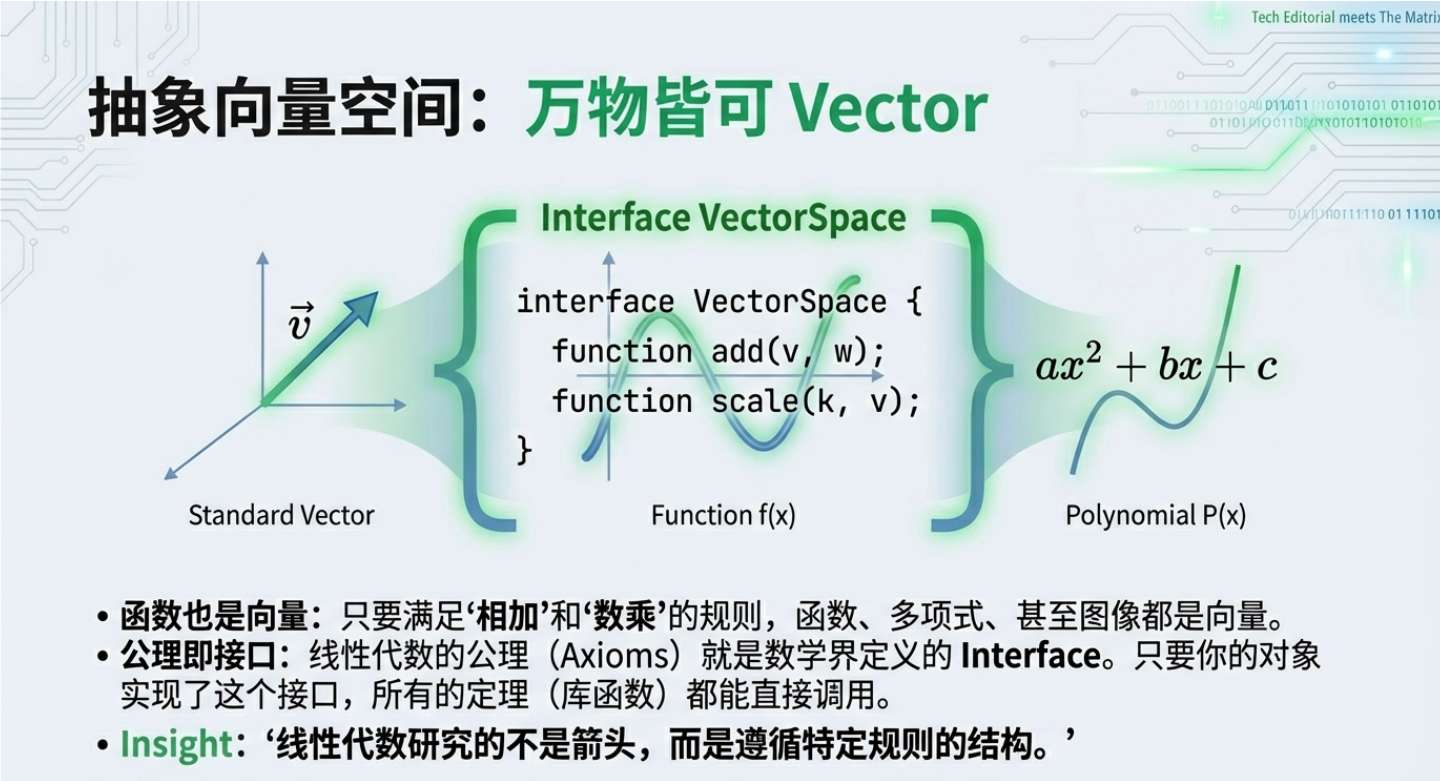

🧱 一、 向量 (Vector):万物的“数字基因”

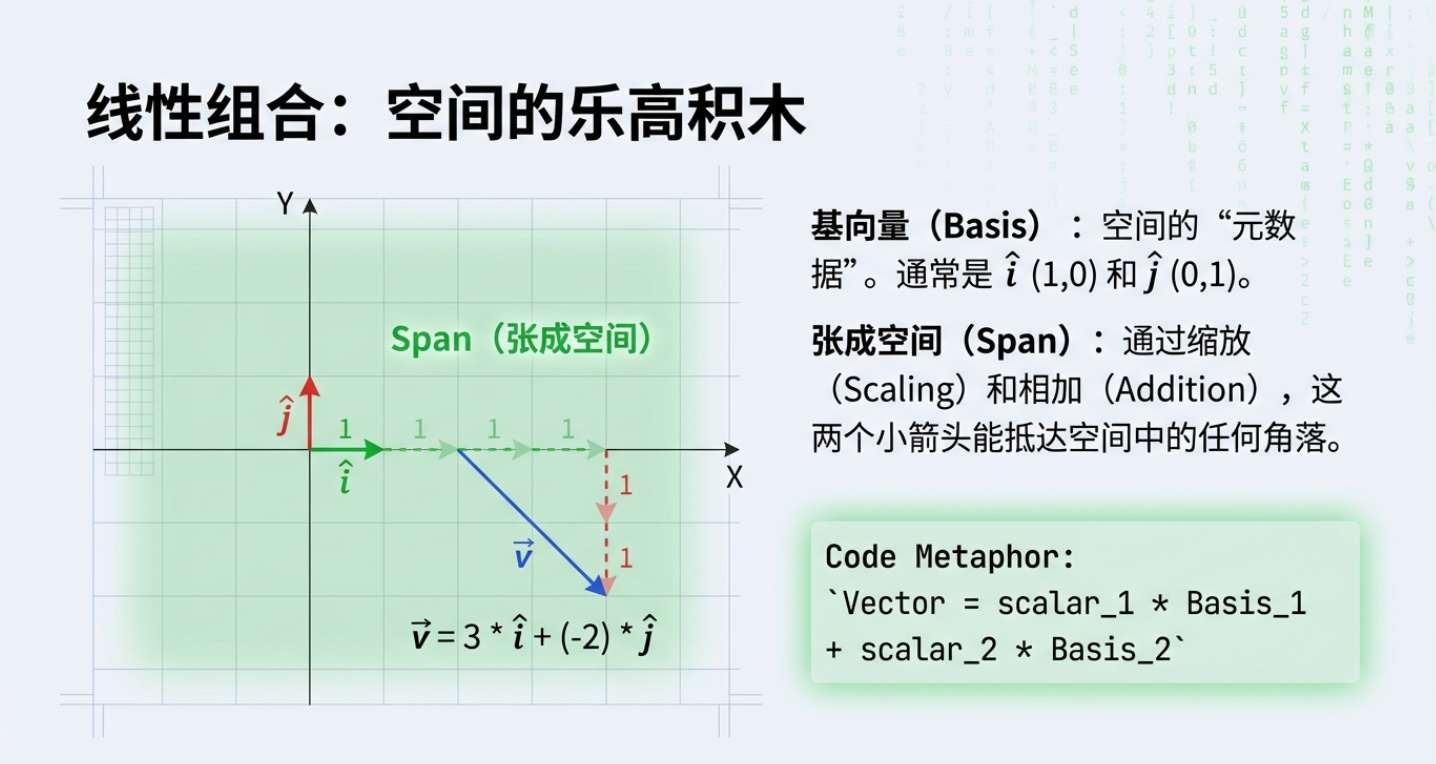

❌ 课本视角: 向量是既有方向又有长度的箭头,或者一列数字。 ✅ 极客视角: 向量是现实世界在数字空间的“全息投影”。

你现在的代码里可能有一个 User 对象,包含 [年龄, 薪水, 消费力, 活跃度]。在 CRUD 程序员眼里,这是一个 List 或 Array;但在 AI 眼里,这是一个 4 维空间里的坐标点。

为什么要这么理解?因为一旦万物皆坐标,世界就有了“距离”。

-

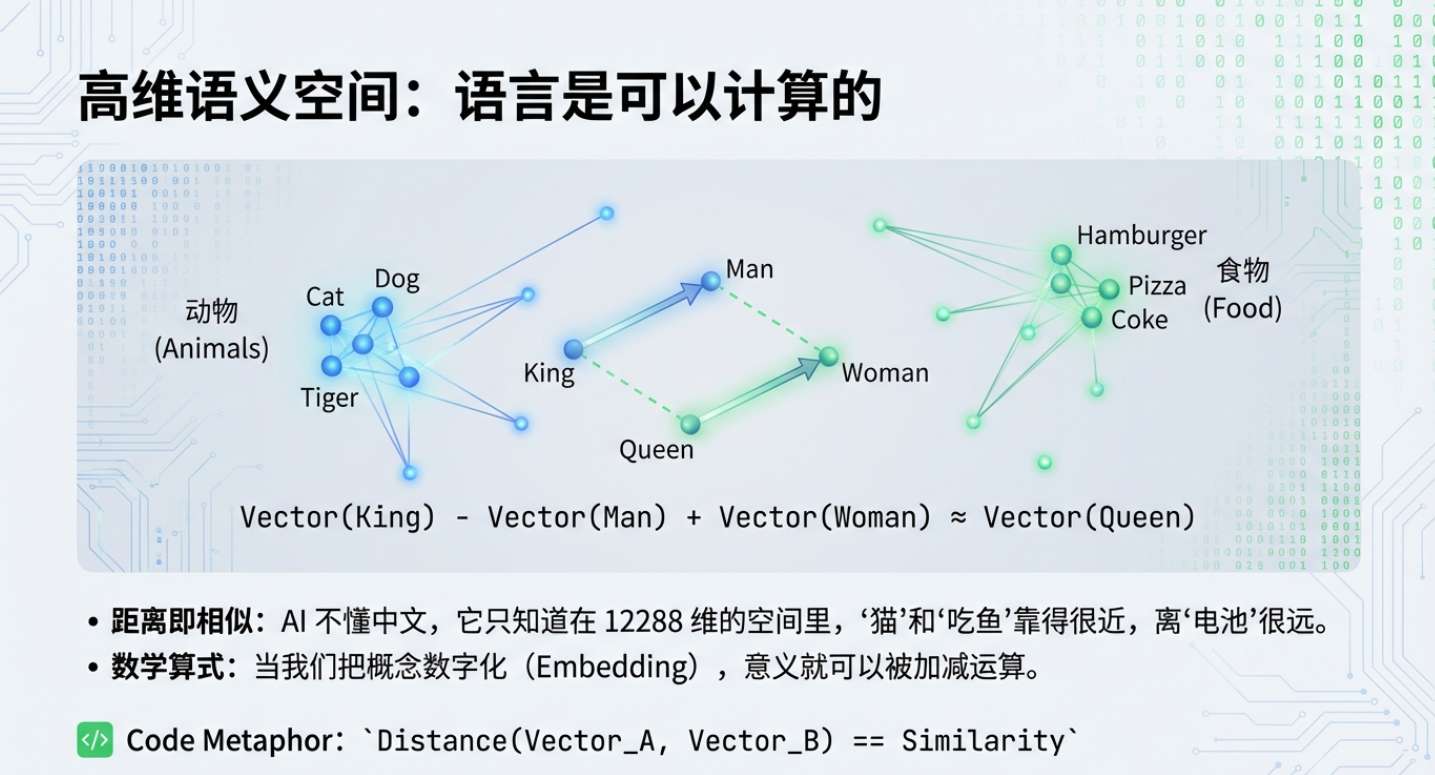

推荐系统的真相: 淘宝为什么知道你喜欢红轴键盘?因为它把你转化成了向量 A,把键盘转化成了向量 B。它不需要懂什么是键盘,它只需要计算 Distance(A, B)。距离越近,你的钱包越危险。 -

大模型的直觉: ChatGPT 真的懂中文吗?不,它只知道在 12288 维的超高维空间里,“猫”的向量和“吃鱼”的向量紧紧贴在一起,而和“吃电池”的向量相隔一个银河系。

这就是所谓“语义理解”的数学本质:空间上的邻近性。

# 所谓语义理解,本质上是空间几何运算

v_king = np.array([...]) # 国王的向量

v_man = np.array([...]) # 男人的向量

v_woman = np.array([...]) # 女人的向量

# 见证奇迹:在向量空间里,逻辑是可以加减的

v_result = v_king - v_man + v_woman

# 结果竟然惊人地接近 v_queen (女王) 的坐标

顿悟时刻: 语言不再是孤立的符号,它们是可以在数学空间里像乐高一样自由拼装的实体。

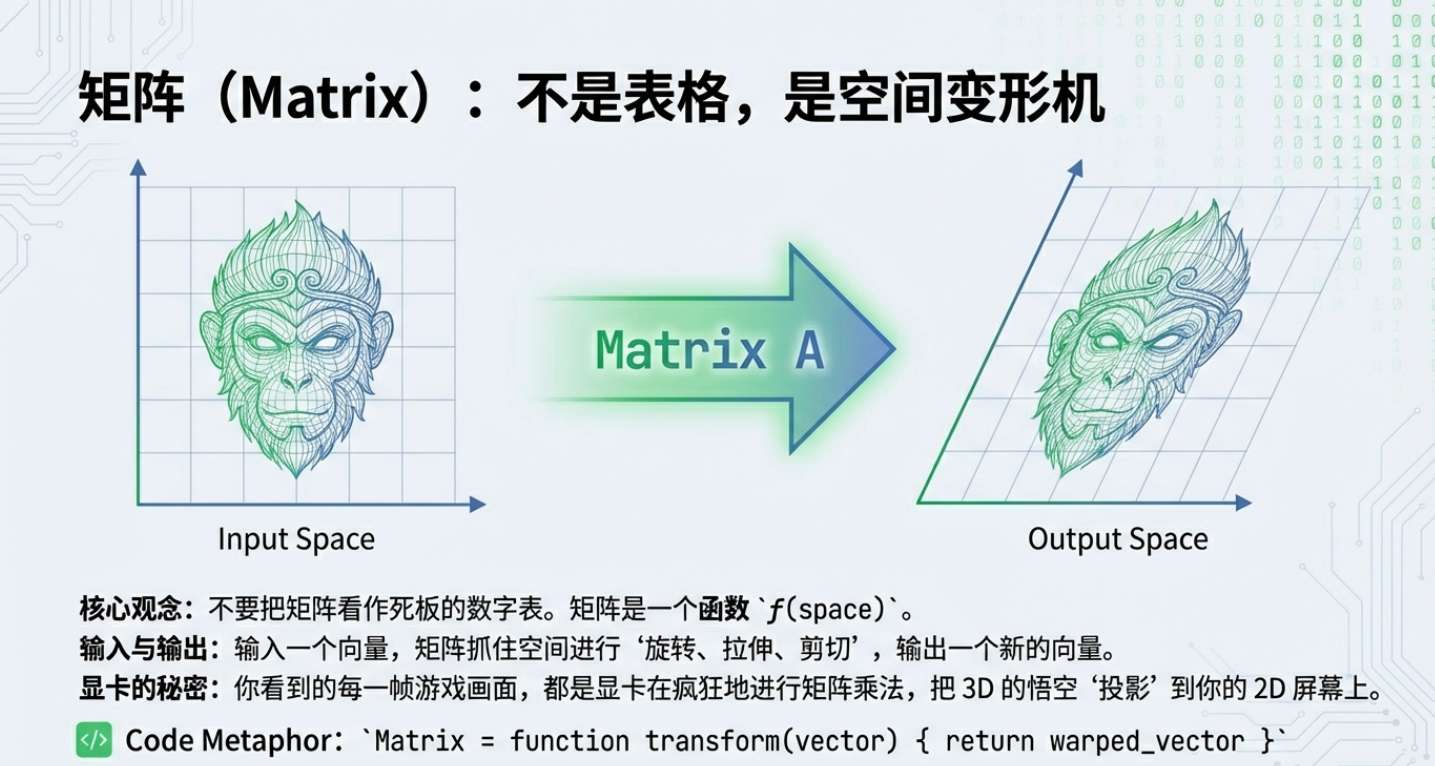

🏭 二、 矩阵 (Matrix):折叠空间的“现实扭曲场”

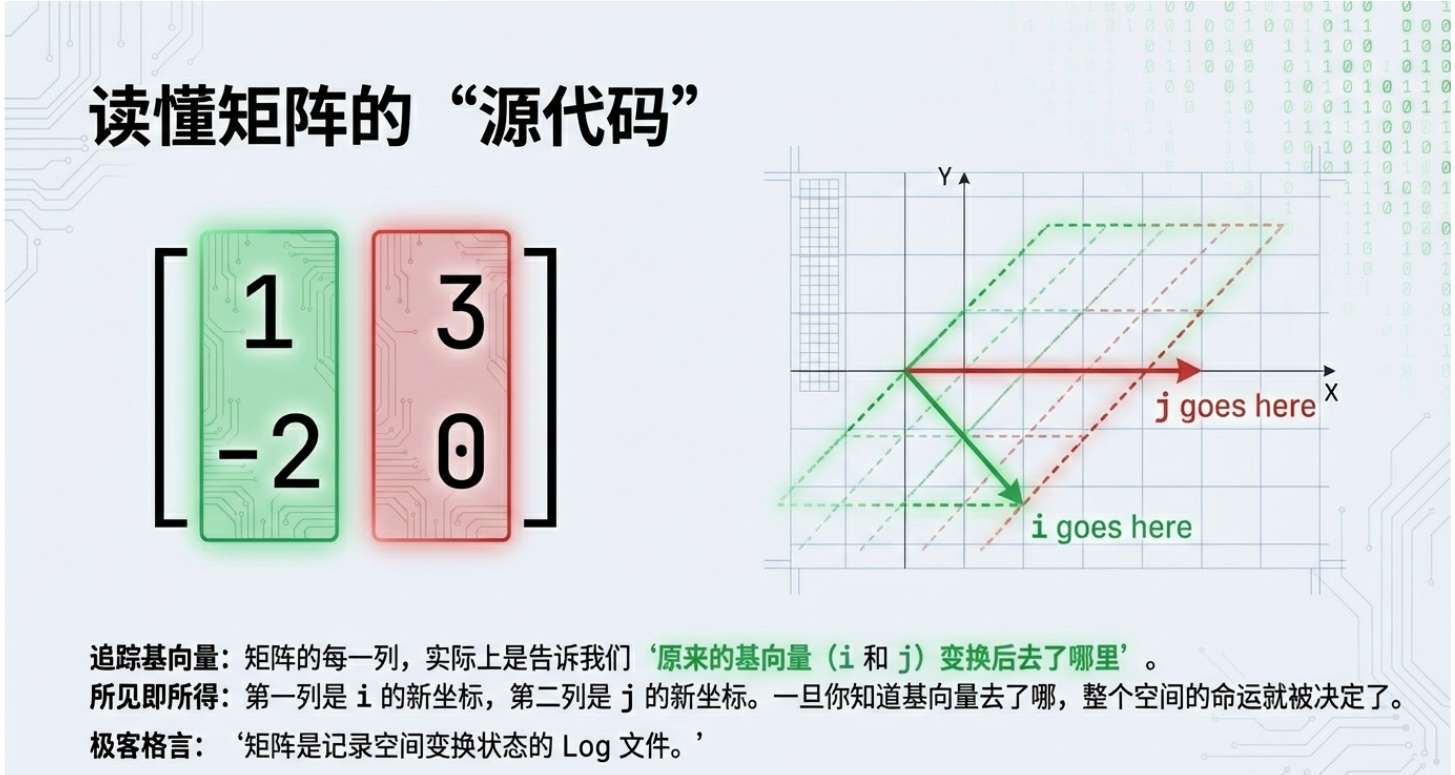

❌ 课本视角: 一个 m 行 n 列的数字表格。 ✅ 极客视角: 矩阵不是静态的表格,它是一台“空间变形机”。

当你将一个向量 乘以矩阵 (即 ),本质上是把这个向量丢进了 制造的“力场”里。输出的结果,是这个向量被旋转、拉伸、甚至剪切后的样子。

-

为什么显卡(GPU)卖那么贵? 你在玩《黑神话:悟空》时,悟空挥动金箍棒的每一帧,后台都是显卡在对上百万个三角形顶点进行矩阵乘法。

-

平移矩阵让悟空位移; -

旋转矩阵让视角随鼠标转动; -

投影矩阵把 3D 的悟空“拍扁”显示在 2D 屏幕上。 老黄(黄仁勋)卖的不是芯片,是极致的空间变形效率。

-

-

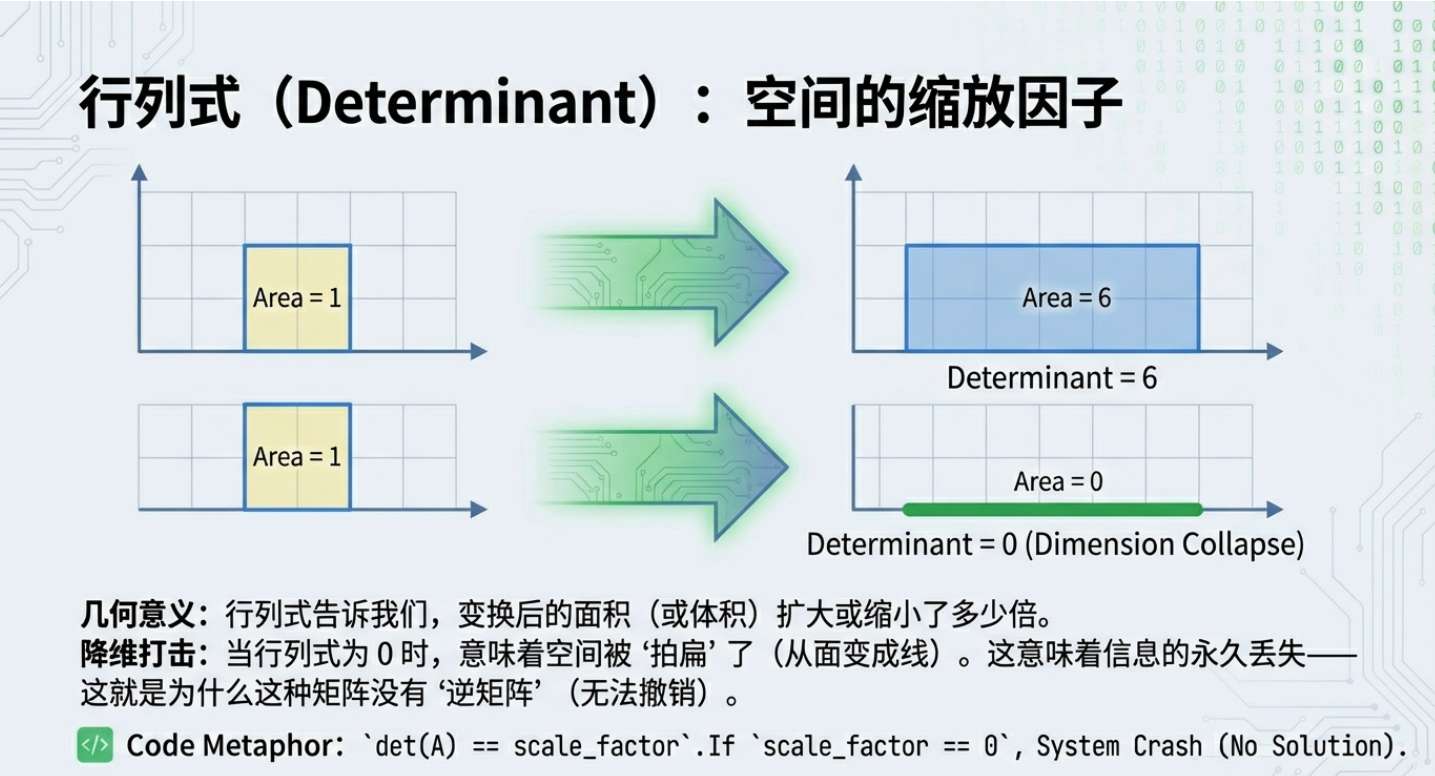

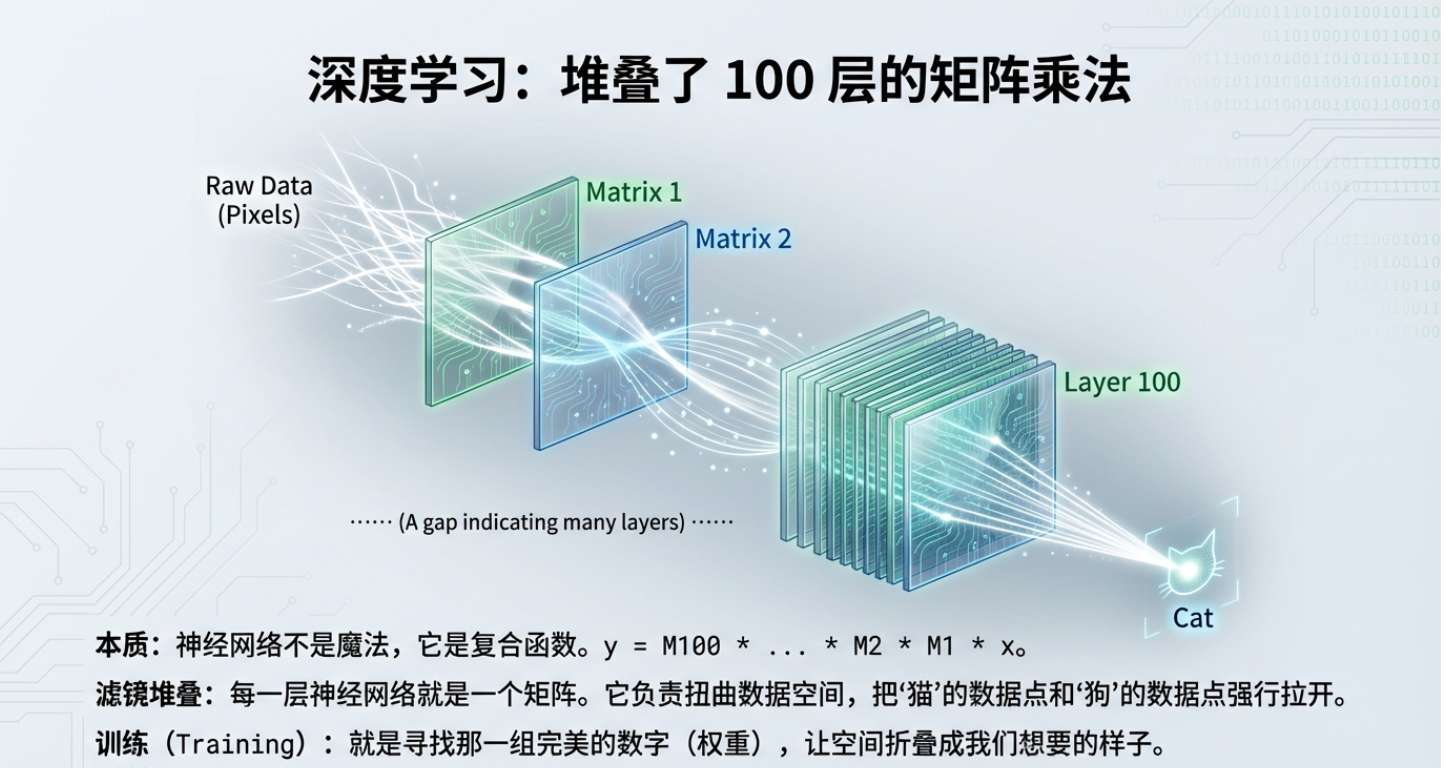

深度学习的“暴论”: 所谓的深度学习(Deep Learning),剥掉它玄学的外壳,约等于“堆叠了一百层的矩阵乘法”。 每一层神经网络,就是一个矩阵 。数据输入,被扭曲、折叠、提取特征,最后输出结果。你训练 AI 的过程,就是在寻找那个能把垃圾数据映射成正确答案的“黄金参数矩阵”。

🧭 三、 特征值与特征向量 (Eigen):寻找“系统的主轴”

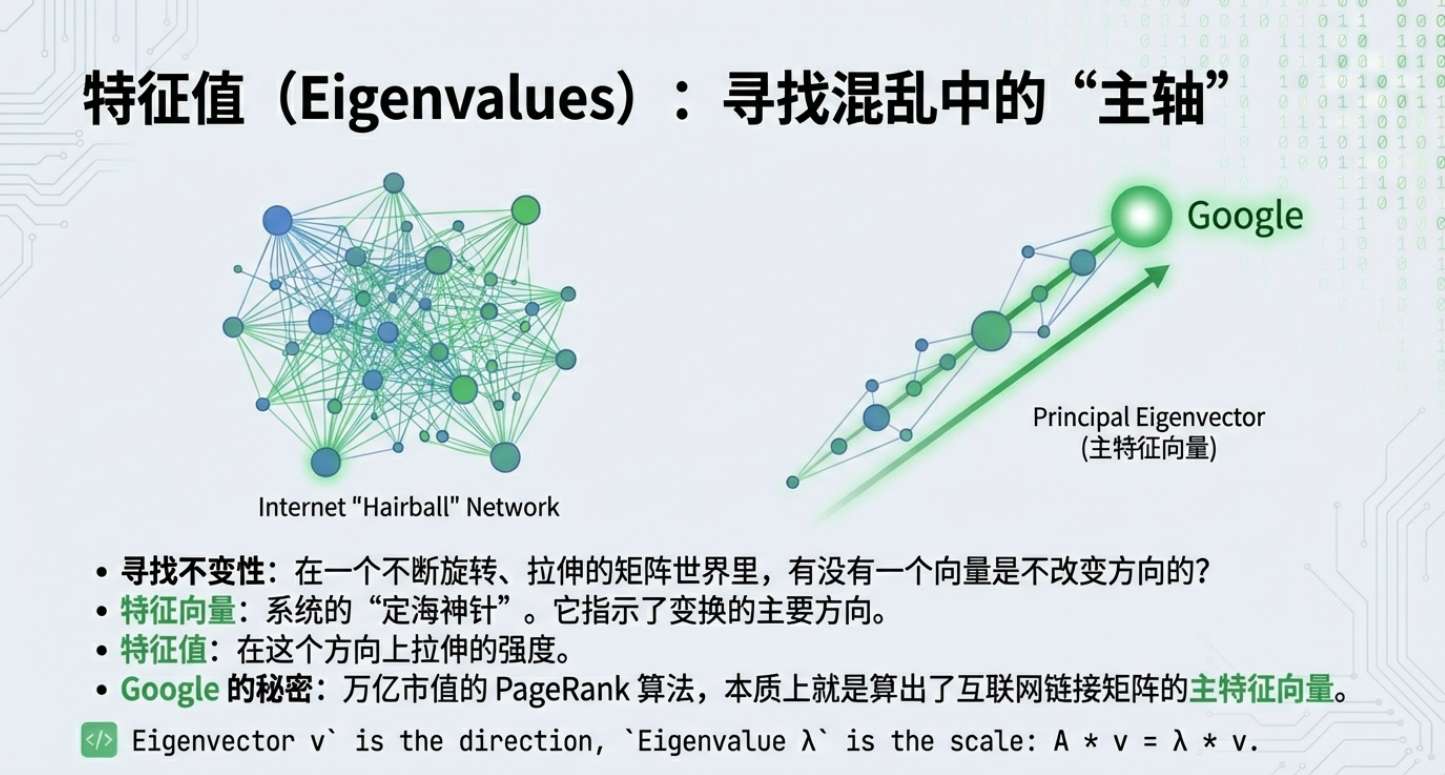

❌ 课本视角: ,求 和 (然后陷入挂科的恐惧)。 ✅ 极客视角: 它们是一个复杂系统的“灵魂”和“主轴”。

-

那个价值万亿的“特征向量” 想象互联网是一个巨大的图,每个网页是一个点,链接是线。这可以画成一个天文数字级别的矩阵。 如果你模拟一个用户在网上随机跳转,最终用户的分布会收敛到一个稳定的状态。这个稳定状态,就是这个矩阵的主特征向量。谁在这个向量里的数值最大,谁就是互联网的“权重之王”。 Larry Page 把这个算法命名为 PageRank,后来他的公司改名叫 Google。

-

在人脸识别中的应用 你的脸有几万个像素,数据太冗余了。但通过计算“特征脸(Eigenfaces)”,我们可以发现所有人脸的差异其实只集中在几个特定的方向(如眼距、脸型)。 只保留这几个“特征向量”,扔掉其他 99% 的废数据,依然能精准识别你是谁。这就是“降维打击”的数学原理。

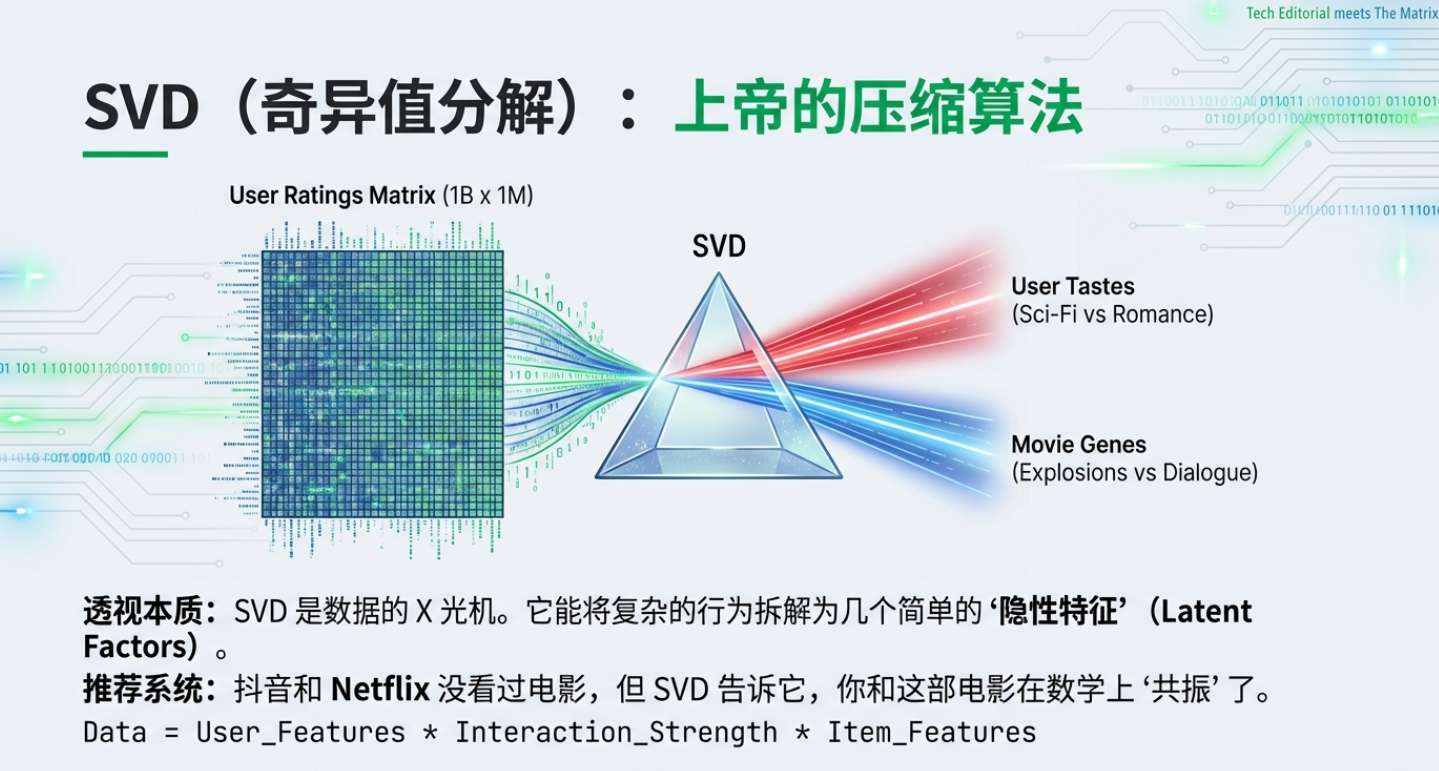

📉 四、 奇异值分解 (SVD):上帝的压缩算法,与人性拆解

❌ 课本视角: 一种复杂的矩阵分解方法 。 ✅ 极客视角: 数据的“X光机”,透视看似杂乱数据下的“本质”。

如果说特征值分解只能处理简单的“方阵”,那 SVD 就是它的终极加强版,能处理任何乱七八糟的数据矩阵。

-

推荐系统的核心秘密 Netflix 或抖音有一个巨大的矩阵:行是 10 亿用户,列是千万部视频。里面的数字是你观看的时长。 通过 SVD 分解,算法能自动提取出人类无法定义的“隐因子(Latent Factors)”。 即便你从未搜过“二次元”,但 SVD 发现你喜欢的几部电影在数学上都有一个共同的隐性特征。 抖音不需要懂什么是“萌系”,它只需要通过矩阵分解,发现你和这类视频在数学上“共振”了。

-

这就是“降维打击” SVD 告诉我们:这个世界看似复杂,其实底层的逻辑线条非常简单。它剥离噪音,直达本质。算法对你的“懂”,本质上是对你进行了一次精准的矩阵分解。

🎯 五、 结语:数学是代码的“内功”

如果你只学编程语言,你是一个优秀的剑客,招式凌厉,能写出漂亮的 Java/Python。 但如果你懂线性代数,你就是练成了“易筋经”的气宗高手。

在 AI 爆发的今天,API 会变,框架会变,语言会变。但矩阵运算不会变,向量空间不会变。掌握了线性代数,你就掌握了数字世界最底层的“物理法则”。

当你回顾线性代数,你会发现:原来世界不是一行行代码组成的,而是一个不断旋转、坍缩、变换的巨大矩阵。

🎁 给程序员的“不痛苦”行动指南:

-

别去买考研书! 那会劝退你。去搜 "3Blue1Brown" 的《线性代数的本质》,那是目前地球上最好的可视化教程。 -

去玩 Python: 打开 Jupyter Notebook,用 numpy.dot感受矩阵乘法。 -

去写代码: 试着手写一个最简单的神经网络(不调包),你会发现,那真的只是几行矩阵运算而已。

彩蛋: 你当年线代挂科了吗?欢迎在评论区聊聊你被线代折磨的瞬间。

本文由 mdnice 多平台发布

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)