【必收藏】智能体上下文工程全攻略:从Prompt到架构的14个核心设计模式

随着大模型技术的爆发,上下文工程已成为智能体开发的核心能力,但很多程序员(尤其是入门小白)仍对其概念模糊、不知如何落地。话不多说,直接开干!通俗来讲,上下文工程既是一门注重实操的技术,也是一门讲究策略的艺术,其核心逻辑很简单:在大模型执行任务的关键节点,以最适配的格式,提供最核心的信息,让LLM少走弯路、精准输出。

随着大模型技术的爆发,上下文工程已成为智能体开发的核心能力,但很多程序员(尤其是入门小白)仍对其概念模糊、不知如何落地。

今天,我们抛开晦涩理论,用程序员能看懂的类比、分步拆解的方式,把上下文工程的核心逻辑、实操方法讲透,小白也能快速上手,建议收藏备用!

话不多说,直接开干!

—

通俗来讲,上下文工程既是一门注重实操的技术,也是一门讲究策略的艺术,其核心逻辑很简单:在大模型执行任务的关键节点,以最适配的格式,提供最核心的信息,让LLM少走弯路、精准输出。

关于上下文工程,Andrej Karpathy曾有一段精准表述,直击核心:

想要真正掌握上下文工程,第一步必须先理清两个核心概念——上下文和智能体,这也是很多小白入门时最容易混淆的点,建议记牢:

如今的AI智能体,早已超越了单纯的聊天机器人,成为能自主感知任务、调用工具、完成决策的独立系统(比如我们常用的AI代码助手、自动化办公工具,本质都是智能体)。而支撑智能体高效运转的核心,就是各类上下文。

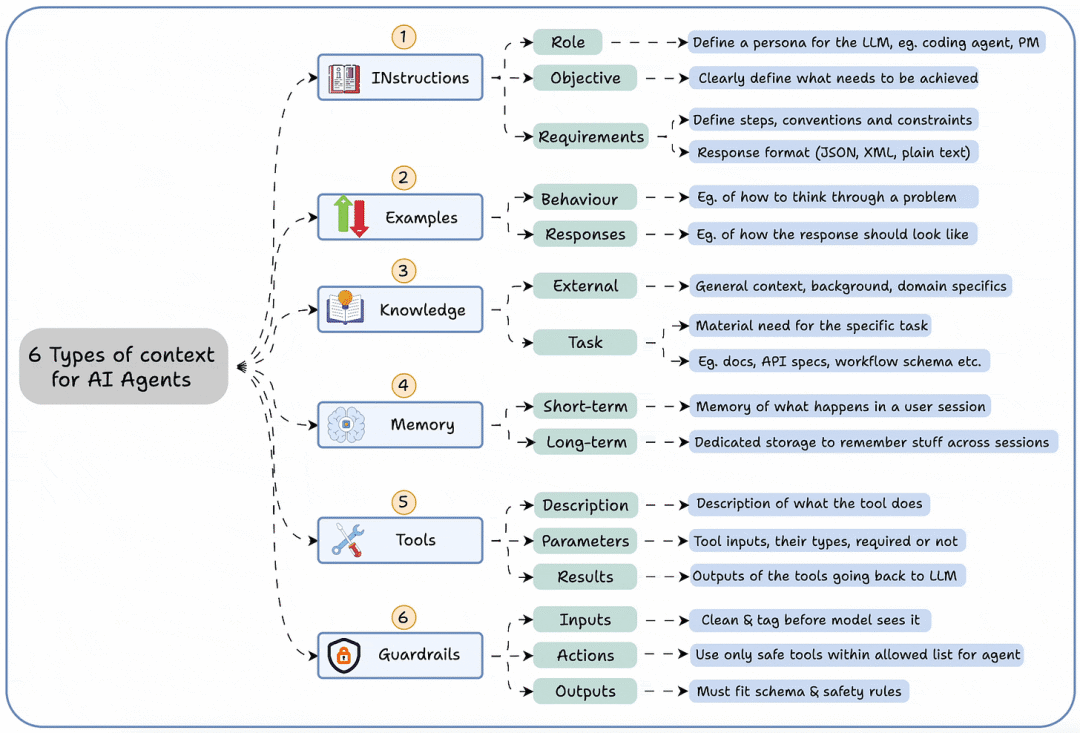

下图清晰总结了智能体正常运作所需的6种核心上下文类型,覆盖从任务指令到风险控制的全流程,小白可直接对照理解:

> 注:在人工智能领域,“上下文”通常指模型处理任务时参考的额外信息,如用户输入的背景、历史对话数据、任务相关知识库等;“智能体”则指能够自主感知环境、决策并行动的AI系统,基于大语言模型开发的各类程序,都属于智能体范畴。这两个概念是理解上下文工程的基础,务必吃透。

这6种核心上下文分别是:

- 指令:明确智能体的核心任务的要求(比如“生成Python排序代码”“总结文档核心观点”);

- 示例:通过具体案例,引导智能体掌握输出格式、执行逻辑(小白入门必用,降低Prompt编写难度);

- 知识:支撑任务完成的专业信息(比如代码开发所需的语法规则、行业报告所需的行业数据);

- 记忆:存储任务过程中的历史信息(比如多轮对话中的用户需求、之前执行的步骤,避免重复劳动);

- 工具:智能体可调用的外部能力(比如代码运行环境、数据库查询工具、网页检索工具);

- 护栏:明确智能体的输出边界(比如“禁止生成违规内容”“代码需符合PEP8规范”)。

这也告诉我们一个关键结论:想要让智能体高效工作,仅仅简单输入一句“提示词(Prompt)”是远远不够的,必须对输入的上下文进行系统性“工程化”设计——就像程序员写代码时要优化逻辑、减少冗余一样,上下文也需要精心设计。

这里给大家分享一个程序员极易理解的类比,瞬间吃透上下文工程的核心逻辑:

- 如果把大语言模型(LLM)比作计算机的CPU(负责核心运算、处理任务);

- 那么上下文窗口,就相当于计算机的RAM(内存,负责存储当前正在处理的数据、指令)。

而上下文工程,本质上就是程序员在“编写”这部分RAM——通过精准设计上下文的内容、格式和输入时机,让LLM(CPU)能快速获取所需信息,高效完成任务,避免因“内存不足”(上下文缺失)或“内存冗余”(上下文杂乱)导致输出偏差。

理解了核心逻辑,接下来就是最关键的实操部分:上下文工程的4个基本阶段,小白可按步骤学习、落地,每一步都搭配具体解读,避免踩坑。

> 补充说明:这个CPU与RAM的类比,非常适合程序员理解上下文工程的价值——CPU再强,没有合适的RAM支撑(存储关键数据、指令),也无法高效运转;同理,LLM再强大,没有经过工程化设计的上下文,也难以输出精准、可用的结果。我们做上下文工程,就是优化“RAM”的存储内容,让“CPU”发挥最大价值。

上下文工程的4个核心阶段,环环相扣、缺一不可,分别是:

- 编写上下文:提前规划、存储任务所需的核心信息;

- 读取上下文:在合适的时机,将存储的上下文拉入上下文窗口;

- 压缩上下文:筛选冗余信息,降低token消耗,提升效率;

- 隔离上下文:分割不同类型的上下文,避免相互干扰。

下面我们逐一拆解每个阶段的核心逻辑、实操方法,搭配小白易懂的解读,看完就能上手尝试:

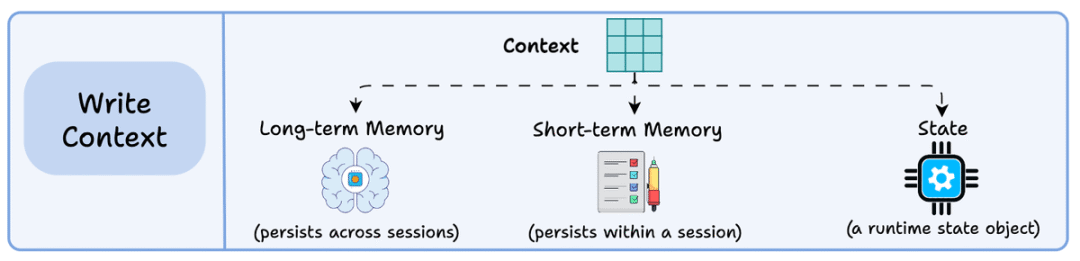

1) 编写上下文:提前“储备”关键信息,避免临时手忙脚乱

编写上下文,核心是“提前规划、持久存储”——将智能体执行任务所需的关键信息,存储在上下文窗口之外(避免占用窗口容量),后续根据任务需求随时调用,帮助智能体更高效地完成任务,尤其适合复杂任务(比如多步骤代码开发、长篇文档生成)。

> 【小白重点】:上下文窗口(context window)指大语言模型处理输入时能考虑的最大文本长度,类似于计算机内存的容量限制——超过这个长度,模型就无法正常处理。而智能体(agent)是能自主感知、决策、行动的AI系统,比如聊天机器人、AI代码助手等。编写上下文,就是提前把关键信息“存好”,不用每次都输入到窗口里,节省容量、提升效率。

具体实操时,我们可以将上下文存储在以下3个位置,根据任务场景灵活选择(小白优先掌握前两种):

- 长期记忆:跨会话持久保存,适合反复使用的核心信息(比如常用的代码模板、固定的输出格式、行业知识库);

- 短期记忆:仅在当前会话内持久保存,适合一次性任务的临时信息(比如当前任务的需求细节、多轮对话中的临时约定);

- 状态对象:存储任务执行过程中的实时状态(比如“当前已完成代码编写,下一步进行调试”),适合多步骤、自动化任务。

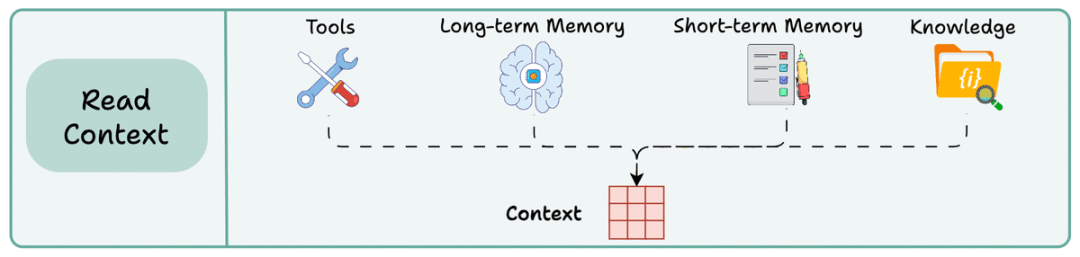

2) 读取上下文:按需“调取”信息,让模型精准获取所需

读取上下文,核心是“按需调取、精准输入”——将之前编写并存储好的上下文,在合适的任务节点,拉入上下文窗口,让LLM能够访问这些信息,辅助推理、生成结果。简单说,就是“需要什么,就调取什么”,不做无用功。

> 【小白重点】:上下文窗口是大语言模型(LLM)一次性能处理的文本序列的最大长度,不同模型的窗口容量不同(比如GPT-3.5是4k/16k token,GPT-4是32k/128k token)。将上下文拉入窗口,就是让模型“看到”这些信息,从而基于这些信息完成任务——比如编写Python代码时,调取对应的语法规则和代码示例,模型就能生成更规范、更贴合需求的代码。

实操中,上下文的调取来源主要有3类,覆盖大部分开发场景,小白可直接参考:

- 工具:调用外部工具获取的实时信息(比如通过网页检索获取最新的API文档、通过数据库查询获取所需数据);

- 内存:之前存储在长期/短期记忆中的信息(比如反复使用的代码模板、用户之前明确的需求偏好);

- 知识:提前整理好的专业知识库(比如本地文档、向量数据库中的行业资料、技术手册,适合需要专业支撑的任务)。

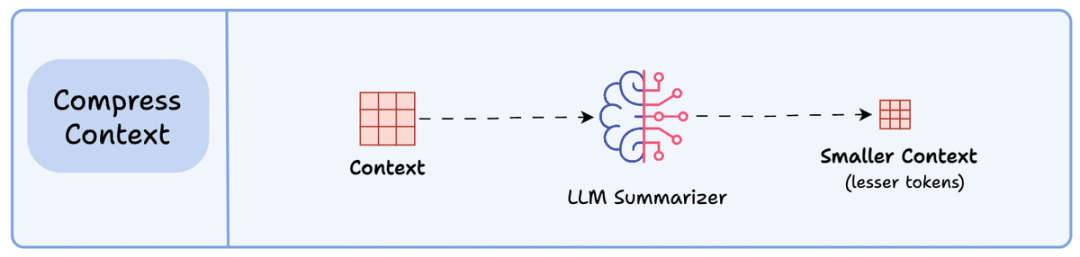

3) 压缩上下文:精简冗余信息,降低成本、提升效率

压缩上下文,核心是“去粗取精、保留核心”——调取的上下文可能包含重复、冗余的信息(比如多轮工具调用的重复结果、知识库中的冗余段落),这些信息会占用大量token,增加使用成本,还可能干扰模型的判断,因此需要进行压缩处理,只保留任务所需的核心token。

> 【小白重点】:补充3个关键概念,避免混淆:① 知识:用于存储任务所需专业信息的数据库,包括普通文档、向量数据库(专门处理高维向量数据,常用于机器学习中的相似性搜索,小白可先了解,后续再深入);② 压缩上下文:一种核心优化技术,通过筛选、总结,保留对当前任务最重要的信息,删除冗余内容,既能减少token消耗、降低成本,也能让模型更快抓住核心,提升输出效率;③ token:大语言模型处理文本时的基本单位,通常对应单词或子词(比如“Python”是1个token,“人工智能”是2个token),模型的窗口容量、使用成本,都以token为单位计算。

举个程序员熟悉的例子:比如我们调用工具检索某款框架的API文档,得到的结果可能包含大量无关的历史版本信息、冗余的注释,此时就需要通过“上下文总结”,提取出当前任务所需的API参数、调用示例,删除冗余内容,再将压缩后的信息输入给LLM——这样既能节省token,也能让模型快速掌握核心,避免被无关信息干扰。

小白入门时,可优先使用“关键信息提取”“简洁总结”两种方式压缩上下文,无需复杂操作,重点是“保留核心、删除冗余”。

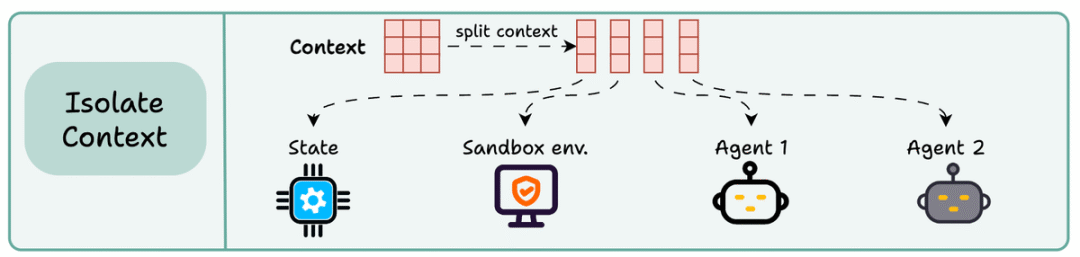

4) 隔离上下文:分割信息边界,避免相互干扰

隔离上下文,核心是“分类存储、边界清晰”——将不同类型、不同任务的上下文分割开来,避免不同信息相互干扰,让智能体能够精准识别、调用对应上下文,尤其适合复杂任务、多任务并行的场景(比如同时处理代码开发和文档生成两个任务,就需要将两类任务的上下文隔离)。

实操中,有3种流行且易落地的实现方式,小白可按需选择,入门优先掌握第一种:

- 多智能体(或子智能体)拆分:为不同的任务模块,设置独立的智能体,每个智能体配备专属的上下文(比如一个智能体负责代码编写,一个负责代码调试,各自的上下文互不干扰);

- 沙盒环境隔离:使用沙盒环境存储和执行代码相关的上下文,避免代码执行过程中,无关上下文干扰运行结果(比如代码调试时,只保留调试相关的上下文,删除无关的对话、文档信息);

- 状态对象隔离:通过状态对象,明确当前任务的执行阶段,只调取对应阶段的上下文(比如“代码编写阶段”只调取语法规则、示例,“调试阶段”只调取错误排查相关的上下文)。

看到这里,相信大家已经理清了上下文工程的核心逻辑:当我们构建一个上下文工程工作流时,本质上是在搭建一个“上下文管道”——从信息的编写、调取,到压缩、隔离,每一步都围绕“让LLM在正确的时间、以正确的格式,看到正确的信息”展开。

这也是上下文工程的核心价值所在,其实和我们程序员日常的“代码优化”逻辑高度一致:

就像我们做特征工程(数据科学中的核心步骤),会筛选、构造对模型有用的特征,删除无用、冗余的特征,以此提升机器学习模型的性能;做上下文工程,也是同样的道理——我们通过设计、优化大语言模型的上下文,删除无用信息、保留核心内容、理清信息边界,让LLM能够精准响应需求,输出符合预期的结果。

> 补充类比:特征工程是数据科学中预处理数据的关键步骤,通过选择和构造相关特征来提升模型性能;类比到上下文工程,就是通过设计输入上下文的结构和内容,优化大语言模型的输出——两者核心逻辑一致,都是“去芜存菁、精准适配”,程序员可以结合自己熟悉的特征工程,快速理解上下文工程的思路。

其实上下文工程没有大家想象的那么晦涩、复杂,不需要高深的理论基础,核心就是“围绕任务需求,优化上下文的全流程”,小白从4个核心阶段入手,逐步实操、反复练习,就能快速掌握。

小白/程序员如何系统学习大模型LLM?

作为在一线互联网企业深耕十余年的技术老兵,我经常收到小白和程序员朋友的提问:“零基础怎么入门大模型?”“自学没有方向怎么办?”“实战项目怎么找?”等问题。难以高效入门。

这里为了帮助大家少走弯路,我整理了一套全网最全最细的大模型零基础教程。涵盖入门思维导图、经典书籍手册、实战视频教程、项目源码等核心内容。免费分享给需要的朋友!

👇👇扫码免费领取全部内容👇👇

1、我们为什么要学大模型?

很多开发者会问:大模型值得花时间学吗?答案是肯定的——学大模型不是跟风追热点,而是抓住数字经济时代的核心机遇,其背后是明确的行业需求和实打实的个人优势:

第一,行业刚需驱动,并非突发热潮。大模型是AI规模化落地的核心引擎,互联网产品迭代、传统行业转型、新兴领域创新均离不开它,掌握大模型就是拿到高需求赛道入场券。

第二,人才缺口巨大,职业机会稀缺。2023年我国大模型人才缺口超百万,2025年预计达400万,具备相关能力的开发者岗位多、薪资高,是职场核心竞争力。

第三,技术赋能增效,提升个人价值。大模型可大幅提升开发效率,还能拓展职业边界,让开发者从“写代码”升级为“AI解决方案设计者”,对接更高价值业务。

对于开发者而言,现在入门大模型,不仅能搭上行业发展的快车,还能为自己的职业发展增添核心竞争力——无论是互联网大厂的AI相关岗位,还是传统行业的AI转型需求,都在争抢具备大模型技术能力的人才。

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

2、大模型入门到实战全套学习大礼包分享

最后再跟大家说几句:只要你是真心想系统学习AI大模型技术,这份我耗时许久精心整理的学习资料,愿意无偿分享给每一位志同道合的朋友。

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

部分资料展示

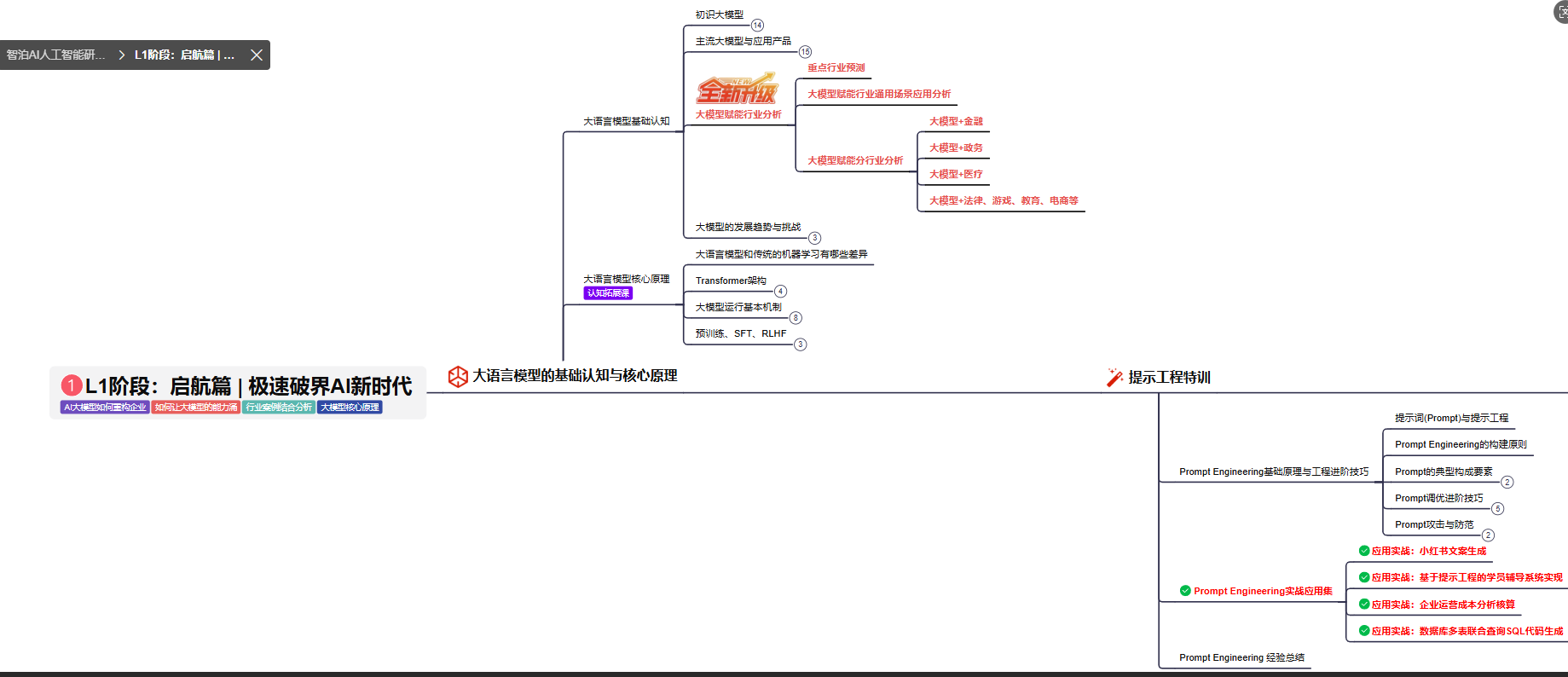

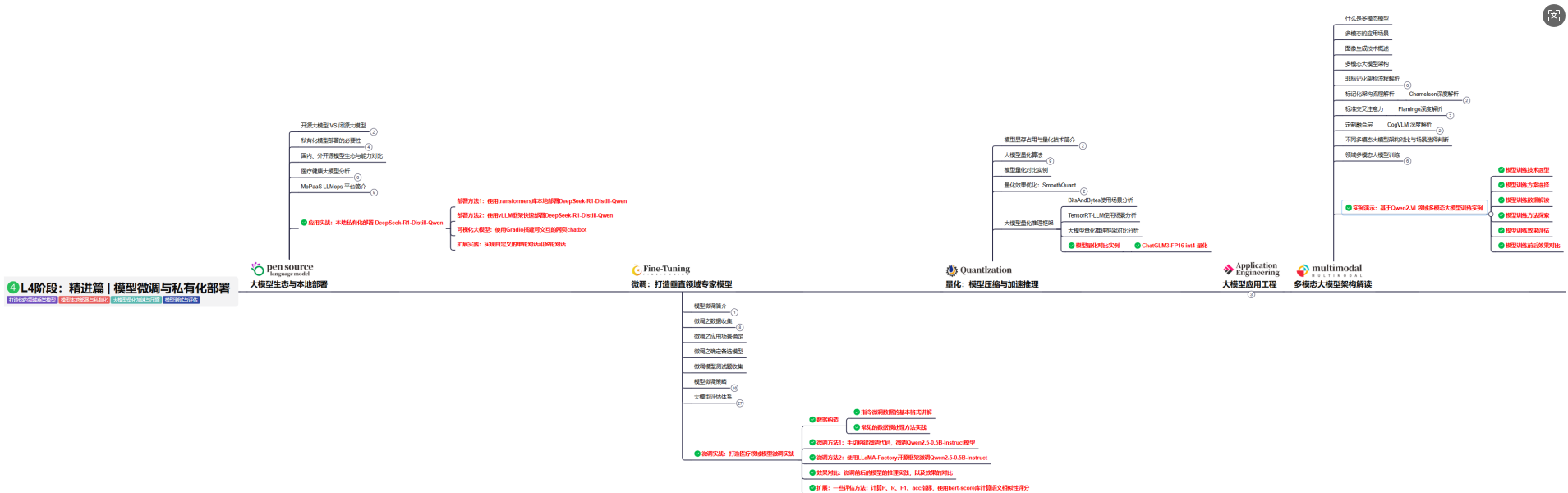

2.1、 AI大模型学习路线图,厘清要学哪些

对于刚接触AI大模型的小白来说,最头疼的问题莫过于“不知道从哪学起”,没有清晰的方向很容易陷入“东学一点、西补一块”的低效困境,甚至中途放弃。

为了解决这个痛点,我把完整的学习路径拆解成了L1到L4四个循序渐进的阶段,从最基础的入门认知,到核心理论夯实,再到实战项目演练,最后到进阶优化与落地,每一步都明确了学习目标、核心知识点和配套实操任务,带你一步步从“零基础”成长为“能落地”的大模型学习者。后续还会陆续拆解每个阶段的具体学习内容,大家可以先收藏起来,跟着路线逐步推进。

L1级别:大模型核心原理与Prompt

L1阶段: 将全面介绍大语言模型的基本概念、发展历程、核心原理及行业应用。从A11.0到A12.0的变迁,深入解析大模型与通用人工智能的关系。同时,详解OpenAl模型、国产大模型等,并探讨大模型的未来趋势与挑战。此外,还涵盖Pvthon基础、提示工程等内容。

目标与收益:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为AI应用开发打下坚实基础。

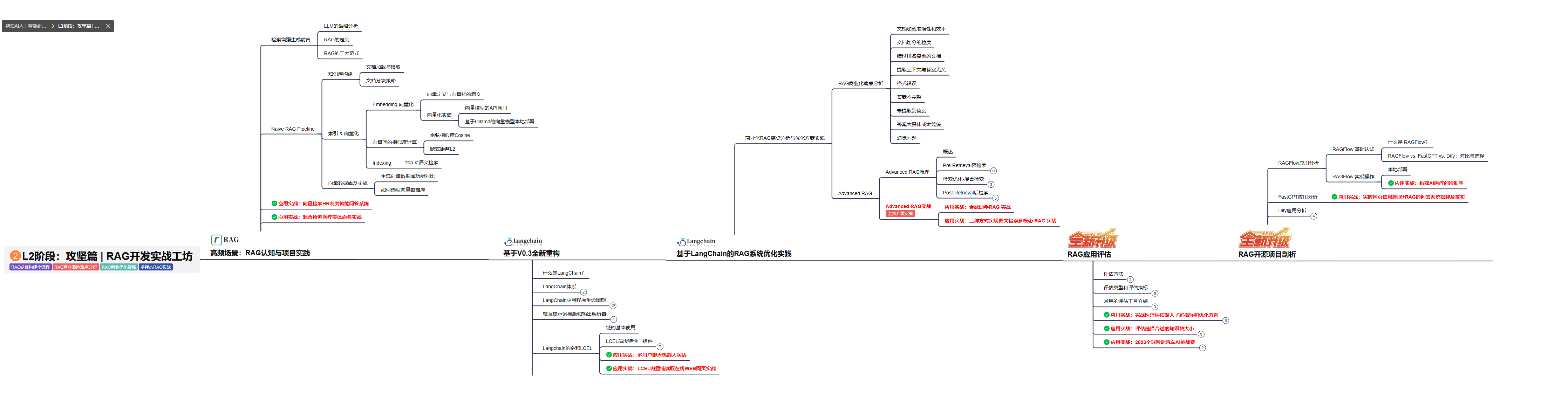

L2级别:RAG应用开发工程

L2阶段: 将深入讲解AI大模型RAG应用开发工程,涵盖Naive RAGPipeline构建、AdvancedRAG前治技术解读、商业化分析与优化方案,以及项目评估与热门项目精讲。通过实战项目,提升RAG应用开发能力。

目标与收益: 掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

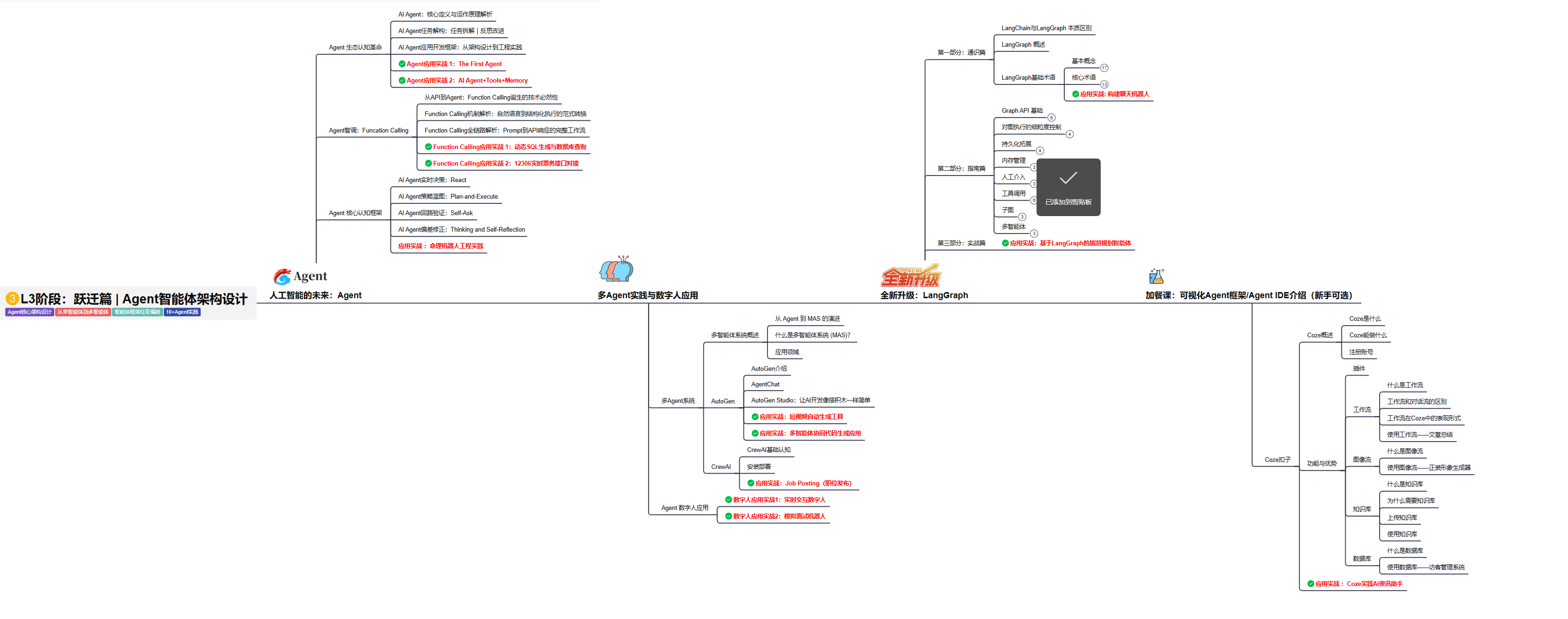

L3级别:Agent应用架构进阶实践

L3阶段: 将 深入探索大模型Agent技术的进阶实践,从Langchain框架的核心组件到Agents的关键技术分析,再到funcation calling与Agent认知框架的深入探讨。同时,通过多个实战项目,如企业知识库、命理Agent机器人、多智能体协同代码生成应用等,以及可视化开发框架与IDE的介绍,全面展示大模型Agent技术的应用与构建。

目标与收益:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

L4级别:模型微调与私有化大模型

L4级别: 将聚焦大模型微调技术与私有化部署,涵盖开源模型评估、微调方法、PEFT主流技术、LORA及其扩展、模型量化技术、大模型应用引警以及多模态模型。通过chatGlM与Lama3的实战案例,深化理论与实践结合。

目标与收益:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

2.2、 全套AI大模型应用开发视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

2.3、 大模型学习书籍&文档

收录《从零做大模型》《动手做AI Agent》等经典著作,搭配阿里云、腾讯云官方技术白皮书,帮你夯实理论基础。

2.4、 AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

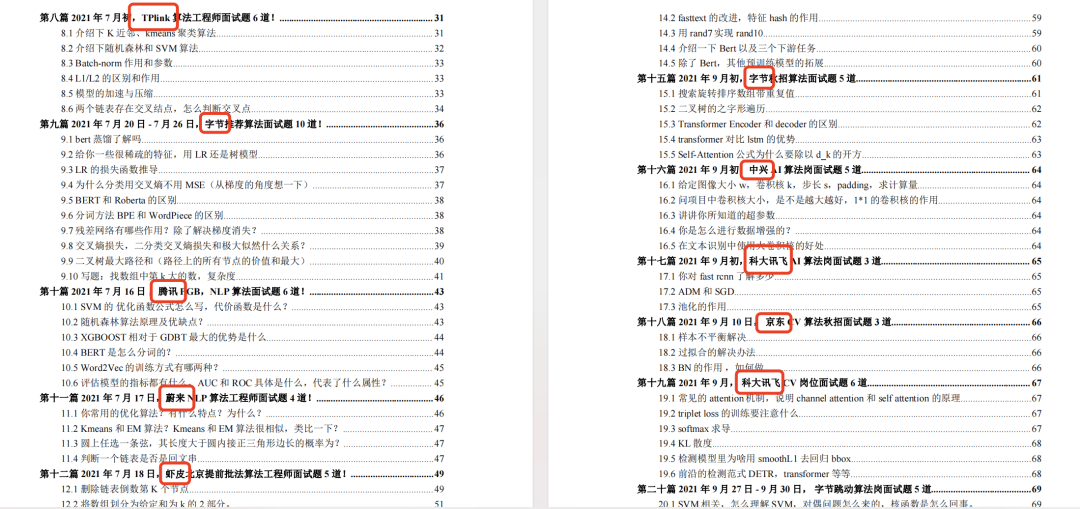

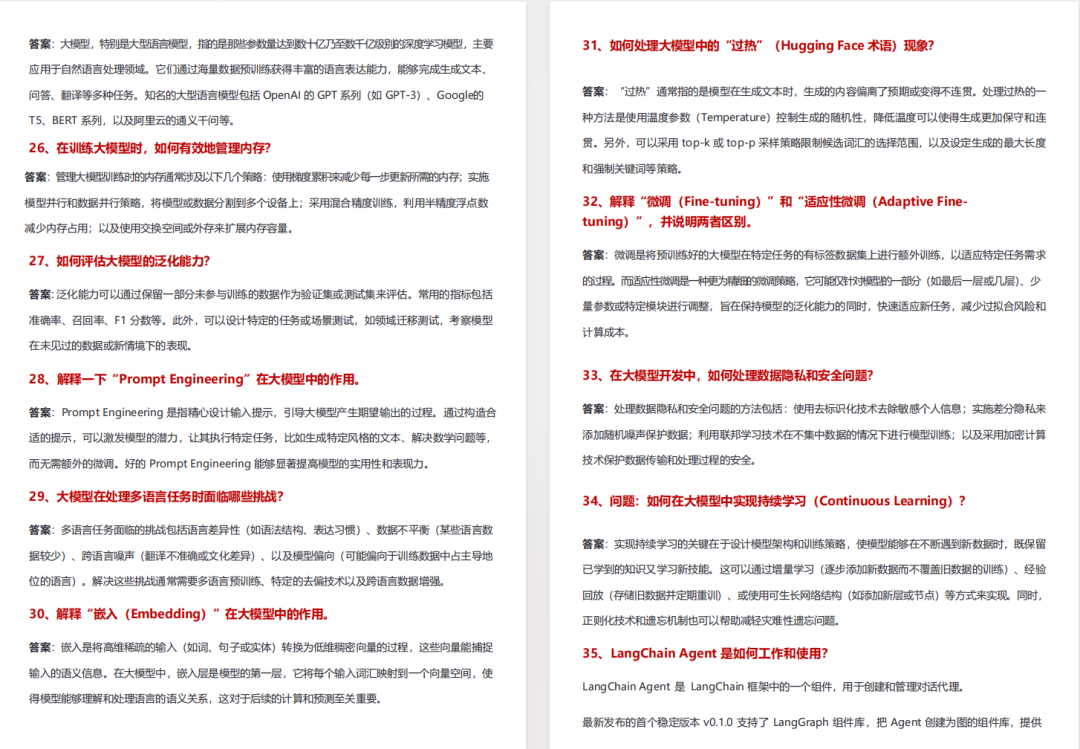

2.5、大模型大厂面试真题

整理了百度、阿里、字节等企业近三年的AI大模型岗位面试题,涵盖基础理论、技术实操、项目经验等维度,每道题都配有详细解析和答题思路,帮你针对性提升面试竞争力。

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

2.6、大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献469条内容

已为社区贡献469条内容

所有评论(0)