基于Seedance WebGL WebRTC构建实时AI视频编辑全链路技术拆解

本文探讨了视频创作与AI特效生成领域的关键技术,聚焦于Seedance视频生成模型、WebGL渲染、实时音视频处理、智能字幕生成以及多轨道编辑技术。这些技术共同构筑了现代视频制作的核心框架,帮助创作者从概念到成品实现高效转型。文章首先介绍视频创作的演进背景,然后阐述技术方案和整体流程。随后,通过核心内容解析深入剖析各模块的原理与应用,提供实践代码示例以供落地。本文旨在为技术从业者和内容创作者提供详

【精选优质专栏推荐】

- 《AI 技术前沿》 —— 紧跟 AI 最新趋势与应用

- 《网络安全新手快速入门(附漏洞挖掘案例)》 —— 零基础安全入门必看

- 《BurpSuite 入门教程(附实战图文)》 —— 渗透测试必备工具详解

- 《网安渗透工具使用教程(全)》 —— 一站式工具手册

- 《CTF 新手入门实战教程》 —— 从题目讲解到实战技巧

- 《前后端项目开发(新手必知必会)》 —— 实战驱动快速上手

每个专栏均配有案例与图文讲解,循序渐进,适合新手与进阶学习者,欢迎订阅。

文章概要

本文探讨了视频创作与AI特效生成领域的关键技术,聚焦于Seedance视频生成模型、WebGL渲染、实时音视频处理、智能字幕生成以及多轨道编辑技术。这些技术共同构筑了现代视频制作的核心框架,帮助创作者从概念到成品实现高效转型。文章首先介绍视频创作的演进背景,然后阐述技术方案和整体流程。随后,通过核心内容解析深入剖析各模块的原理与应用,提供实践代码示例以供落地。本文旨在为技术从业者和内容创作者提供详实指导,推动AI驱动的视频创新。

引言

在数字化时代,视频已成为信息传播的主要载体。从短视频平台到专业影视制作,内容创作者面临着日益复杂的挑战:如何高效生成高质量视频、添加引人入胜的特效,并确保跨平台兼容性。传统视频创作依赖手动编辑和后期处理,耗时耗力,而人工智能的介入彻底改变了这一格局。Seedance作为ByteDance推出的先进视频生成模型,标志着AI在视频领域的突破,它支持从文本或图像生成多镜头视频,实现了语义理解与动态运动的融合。结合WebGL渲染技术,创作者可在浏览器中实时应用3D特效,提升交互性。同时,实时音视频处理、智能字幕生成和多轨道编辑技术进一步优化了制作流程,确保音频同步、字幕准确以及多层编辑的灵活性。这些技术的集成,不仅降低了门槛,还提高了生产效率。本文将系统剖析这些元素,帮助读者理解如何构建一个完整的AI辅助视频创作系统。

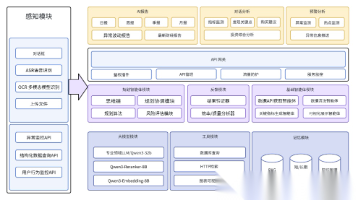

技术方案

视频创作与AI特效生成的整体技术方案围绕AI模型与图形渲染的协同展开。首先,Seedance视频生成模型担任内容生成的核心,它基于Transformer架构,支持文本到视频(Text-to-Video)和图像到视频(Image-to-Video)的转换,能够输出1080p高清视频,强调运动平滑性和细节丰富度。其次,WebGL渲染技术利用浏览器GPU加速,实现特效的实时叠加,如粒子效果或光影模拟,避免了传统软件的资源开销。实时音视频处理则采用WebRTC和FFmpeg等框架,确保低延迟传输和处理,适用于直播场景。智能字幕生成依赖语音识别AI模型,如Whisper或自定义神经网络,自动提取音频并生成多语言字幕。多轨道编辑技术通过软件如DaVinci Resolve或自定义编辑器,支持多层音频视频轨道同步,允许独立调整而不影响整体。该方案强调模块化设计,各部分可独立优化或集成,形成端到端的视频管道。

流程介绍

视频创作与AI特效生成的流程可分为五个阶段:需求分析、内容生成、特效渲染、音视频处理与编辑、最终输出。

首先,在需求分析阶段,创作者定义主题、脚本和风格,例如指定“一个舞者在城市夜景中跳舞”的文本提示。

其次,内容生成阶段利用Seedance模型输入提示或图像,生成基础视频片段,模型会自动处理多镜头叙事和运动稳定性。

接着,特效渲染阶段通过WebGL将生成视频导入浏览器画布,应用自定义着色器实现效果叠加,如添加光效或变形。

第四阶段涉及实时音视频处理和智能字幕生成:提取音频流,进行噪声抑制和同步;同时,AI分析音频生成字幕,并嵌入视频轨道。

最后,多轨道编辑阶段在编辑软件中整合所有元素,调整轨道顺序、音量和过渡效果,最终导出MP4格式。该流程强调迭代优化,确保从生成到输出的无缝衔接。

核心内容解析

Seedance视频生成模型作为AI特效生成的基础,其原理源于扩散模型与Transformer的结合。该模型首先通过语义编码器解析输入提示,将文本转换为高维特征向量,然后在潜在空间中逐步添加噪声并去噪,生成视频帧序列。与传统GAN模型不同,Seedance强调多镜头一致性,通过引入时空注意力机制,确保帧间运动平滑,避免了常见的抖动问题。例如,在生成一个5秒1080p视频时,模型可处理复杂指令如“人物从静止到奔跑”,并维持物理真实性。这种方法不仅提高了生成效率,还支持本地音频整合,提升叙事深度。

WebGL渲染技术则为特效添加提供了高效的浏览器级解决方案。它基于OpenGL ES标准,利用JavaScript API访问GPU,实现实时图形计算。在视频创作中,WebGL将视频帧作为纹理加载到3D画布上,通过顶点着色器和片元着色器应用效果。例如,粒子系统可模拟烟雾或光芒,通过矩阵变换控制粒子位置和速度。这种渲染方式的优势在于低延迟:无需外部插件,即可在Web环境中处理复杂特效,如视频风格迁移,将普通镜头转化为卡通或科幻风格。同时,WebGL支持多缓冲区渲染,避免了帧率下降,确保在移动设备上的兼容性。

实时音视频处理是确保视频流畅的关键环节,其核心在于低延迟编码和解码技术。采用H.264或VP9编解码器,结合WebRTC协议,实现点对点传输。在处理过程中,首先捕获原始音视频流,然后应用数字信号处理算法进行噪声抑制和回声消除。例如,使用傅里叶变换分析音频频谱,滤除背景噪声;对于视频,则通过运动估计补偿帧间差异,维持30fps以上帧率。这种实时性特别适用于直播或互动视频创作,允许创作者在生成特效的同时监控音频同步,避免后期调整的繁琐。

智能字幕生成依赖先进的语音到文本模型,实现自动化与高准确率。该技术首先通过卷积神经网络提取音频特征,然后利用循环神经网络或Transformer解码成文本序列。以Whisper模型为例,它支持多语言识别,准确率可达95%以上。在视频创作中,字幕生成不仅仅是转录,还包括时间戳对齐和风格定制:AI分析音频节奏,自动分割字幕块,并根据视频内容建议强调效果,如加粗关键词。这种智能性大大提升了可访问性,尤其在多语境视频中,确保字幕与画面同步,提升观众体验。

多轨道编辑技术则为后期整合提供了灵活框架。它允许将视频、音频和特效置于独立轨道上,支持非破坏性编辑。例如,在DaVinci Resolve中,用户可创建数百轨道,通过复合剪辑合并子轨道,实现复杂叙事如多机位切换。该技术的原理在于时间线管理:每个轨道维护独立的时序和参数,编辑时可锁定无关轨道,避免误操作。同时,集成AI工具可自动对齐音频波形,确保唇音同步。这种多轨道方法不仅提高了效率,还便于协作,允许多人同时编辑不同部分,最终合成高质量视频。

这些技术的协同应用形成了闭环:Seedance生成基础内容,WebGL添加视觉特效,实时处理优化传输,智能字幕增强包容性,多轨道编辑完善结构。通过这种方式,视频创作从手工劳动转向AI赋能,显著降低了成本并扩展了创意边界。

实践代码

以下提供一个简化的实践代码示例,使用Python结合OpenCV和WebGL(通过Three.js的JavaScript桥接)实现基本视频生成与特效渲染。

代码分为生成视频和WebGL渲染两部分。

# 导入必要库

import torch

from diffusers import StableVideoDiffusionPipeline # 模拟Seedance的视频生成模型

import cv2

import numpy as np

# 第一部分:使用AI模型生成基础视频

# 加载Seedance类似模型(这里用Stable Video Diffusion作为代理)

pipe = StableVideoDiffusionPipeline.from_pretrained(

"stabilityai/stable-video-diffusion-img2vid-xt", # 替换为实际Seedance模型如果可用

torch_dtype=torch.float16,

variant="fp16"

)

pipe.enable_model_cpu_offload() # 优化内存使用

# 输入图像或文本提示生成视频

# 假设输入一张图像作为种子

image = cv2.imread("input_image.jpg") # 加载输入图像

image = cv2.resize(image, (1024, 576)) # 调整尺寸以匹配模型要求

# 生成视频帧序列

generator = torch.manual_seed(42)

frames = pipe(image, num_frames=25, generator=generator).frames[0] # 生成25帧视频

# 保存生成的视频

height, width, _ = frames[0].shape

video_writer = cv2.VideoWriter("generated_video.mp4", cv2.VideoWriter_fourcc(*'mp4v'), 5, (width, height))

for frame in frames:

video_writer.write((frame * 255).astype(np.uint8)) # 转换为uint8并写入

video_writer.release() # 释放写入器

# 第二部分:实时音视频处理与智能字幕生成

# 使用OpenCV捕获视频并添加字幕(模拟AI字幕生成)

cap = cv2.VideoCapture("generated_video.mp4") # 打开生成的视频

fourcc = cv2.VideoWriter_fourcc(*'mp4v')

out = cv2.VideoWriter("processed_video.mp4", fourcc, 5, (int(cap.get(3)), int(cap.get(4))))

# 模拟智能字幕:假设已从音频提取文本列表和时间戳

subtitles = [("Hello, world!", 0, 5), ("AI effects in action.", 5, 10)] # (文本, 开始帧, 结束帧)

frame_count = 0

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# 实时处理:应用简单滤镜模拟噪声抑制

frame = cv2.GaussianBlur(frame, (5, 5), 0) # 模糊处理作为示例

# 添加字幕

for text, start, end in subtitles:

if start <= frame_count <= end:

cv2.putText(frame, text, (50, 50), cv2.FONT_HERSHEY_SIMPLEX, 1, (255, 255, 255), 2)

out.write(frame)

frame_count += 1

cap.release()

out.release()

# 第三部分:WebGL渲染特效(JavaScript示例,需在浏览器中运行)

# 在HTML中嵌入Three.js实现粒子效果

"""

<!DOCTYPE html>

<html>

<head>

<script src="https://threejs.org/build/three.js"></script>

</head>

<body>

<script>

// 初始化场景

const scene = new THREE.Scene();

const camera = new THREE.PerspectiveCamera(75, window.innerWidth / window.innerHeight, 0.1, 1000);

const renderer = new THREE.WebGLRenderer();

renderer.setSize(window.innerWidth, window.innerHeight);

document.body.appendChild(renderer.domElement);

// 加载视频作为纹理

const video = document.createElement('video');

video.src = 'processed_video.mp4'; // 加载处理后的视频

video.load();

video.play();

const videoTexture = new THREE.VideoTexture(video);

// 创建平面几何体

const geometry = new THREE.PlaneGeometry(16, 9);

const material = new THREE.MeshBasicMaterial({ map: videoTexture });

const plane = new THREE.Mesh(geometry, material);

scene.add(plane);

camera.position.z = 10;

// 渲染循环

function animate() {

requestAnimationFrame(animate);

renderer.render(scene, camera);

}

animate();

// 添加粒子特效(模拟AI特效)

const particles = new THREE.BufferGeometry();

const particleCount = 5000;

const positions = new Float32Array(particleCount * 3);

for (let i = 0; i < particleCount * 3; i++) {

positions[i] = (Math.random() - 0.5) * 20; // 随机位置

}

particles.setAttribute('position', new THREE.BufferAttribute(positions, 3));

const particleMaterial = new THREE.PointsMaterial({ color: 0xFFFFFF, size: 0.05 });

const particleSystem = new THREE.Points(particles, particleMaterial);

scene.add(particleSystem);

// 更新粒子位置,实现动态效果

function updateParticles() {

const positions = particles.attributes.position.array;

for (let i = 0; i < particleCount * 3; i += 3) {

positions[i + 1] += 0.01; // 向上移动

if (positions[i + 1] > 10) positions[i + 1] = -10; // 重置

}

particles.attributes.position.needsUpdate = true;

}

// 在animate中调用

// animate函数中添加: updateParticles();

</script>

</body>

</html>

"""

# 注意:JavaScript部分需独立运行,可与Python生成的文件结合使用。

# 多轨道编辑可在DaVinci Resolve中手动实现,此代码聚焦生成与渲染。

常见误区与解决方案

在视频创作中,一个常见误区是过度依赖AI生成模型而忽略输入质量,导致输出视频语义不准。例如,使用模糊提示时,Seedance可能产生不一致的运动。解决方案是通过细化提示,如添加具体描述“人物穿着红色衣服,背景为夜空”,并结合图像输入提升准确性。

另一个误区是WebGL渲染时忽略浏览器兼容性,导致特效在移动端卡顿。解决方案是优化着色器代码,使用LOD(细节层次)技术,根据设备性能动态调整粒子数量,并测试多平台。

实时音视频处理中,延迟过高是常见问题,常因网络波动引起。解决方案采用自适应比特率编码,结合WebRTC的拥塞控制机制,确保在弱网环境下维持质量。

智能字幕生成可能出现识别错误,尤其在噪音环境中。解决方案预处理音频,使用噪声抑制算法如谱减法,并人工校对关键部分。

多轨道编辑时,轨道同步偏差是痛点。解决方案利用波形对齐工具,如DaVinci Resolve的自动同步功能,或自定义脚本比较音频峰值实现精确匹配。

这些解决方案强调预防与迭代,确保项目顺利推进。

总结

视频创作与AI特效生成技术正处于快速发展阶段,Seedance模型、WebGL渲染等创新工具极大拓展了创作者的能力边界。通过本文的剖析,我们看到这些技术不仅提升了效率,还开启了新颖的表达形式。

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)