大模型算法测试方案调查

摘要 本文系统调研了大语言模型(LLMs)的算法测试方案,涵盖英文和中文通用模型的评测框架。评测聚焦四大维度:能力评测、对话质量、安全真实性和速度吞吐。英文评测采用MMLU(多学科知识理解)、MMLU-Pro(高难度推理)、BIG-bench(综合认知能力)和TruthfulQA(真实性测试)等基准;中文评测则使用C-Eval(对标MMLU的中文综合测试)。这些测试通过标准化的few-shot设定

大模型算法测试方案调查

文章目录

- 大模型算法测试方案调查

-

- @[toc]

- 1. 评测范围与目标

- 2. 能力评测:主流测试集与**评分方法**

-

- 3. 速度与吞吐评测:**指标、流程与工具**

-

- 4. 厂商公开结果与白皮书线索

-

- 5. 讨论社区与资讯渠道(便于跟踪评测动态)

-

- **Hugging Face 论坛**:

- **Reddit r/LocalLLaMA**:

- **知乎**:

- **量子位/机器之心**:

- SemiWiki(The Open Forum for Semiconductor Professionals)

- Arm Community — AI Forum(AI 软件/架构方向)

- AI for Advanced Product Testing Forum (由 SEMI 主办)

- NXP Community(NXP 半导体社区)

- EETOP 创芯网论坛(集成电路 / IC 论坛)

- 电子发烧友论坛(电子系统设计/测试测量)

- IC测试网 (ic test)(“芯片测试技术”专门网站+论坛)

- 半导体智能制造论坛(中国 SEMI 中国 主办)

- 6. 标准化评测SOP

- 7. 常见陷阱与建议

- 8. 可引用/扩展的**技术白皮书与方法论**

- 附:一页式“最小可用评测配置”

文章目录

- 大模型算法测试方案调查

-

- @[toc]

- 1. 评测范围与目标

- 2. 能力评测:主流测试集与**评分方法**

- 3. 速度与吞吐评测:**指标、流程与工具**

- 4. 厂商公开结果与白皮书线索

- 5. 讨论社区与资讯渠道(便于跟踪评测动态)

-

- **Hugging Face 论坛**:

- **Reddit r/LocalLLaMA**:

- **知乎**:

- **量子位/机器之心**:

- SemiWiki(The Open Forum for Semiconductor Professionals)

- Arm Community — AI Forum(AI 软件/架构方向)

- AI for Advanced Product Testing Forum (由 SEMI 主办)

- NXP Community(NXP 半导体社区)

- EETOP 创芯网论坛(集成电路 / IC 论坛)

- 电子发烧友论坛(电子系统设计/测试测量)

- IC测试网 (ic test)(“芯片测试技术”专门网站+论坛)

- 半导体智能制造论坛(中国 SEMI 中国 主办)

- 6. 标准化评测SOP

- 7. 常见陷阱与建议

- 8. 可引用/扩展的**技术白皮书与方法论**

- 附:一页式“最小可用评测配置”

1. 评测范围与目标

- 对象:英文与中文通用大语言模型(LLMs)与其开源/闭源同类;必要时含多模态延伸。

- 目标:统一“能力评测 + 偏好/对话质量 + 安全/真实性 + 速度吞吐”四大维度;保证可复现、可对比、可追踪。

2. 能力评测:主流测试集与评分方法

2.1 英文通用

MMLU(Massive Multitask Language Understanding)

一、概述

MMLU(Massive Multitask Language Understanding) 是由加州大学伯克利分校研究者 Hendrycks 等人于 2020 年提出的一个大规模多任务语言理解基准测试。

它旨在评估语言模型在多领域知识理解、推理与应用能力上的综合表现,被认为是衡量大语言模型(LLM)“类人智能水平”的重要基准之一。

二、数据集构成

-

题目数量:约 15,908 道题目

-

任务数量:57 个学科(tasks)

-

领域覆盖:

-

人文科学(History, Philosophy, Law)

-

社会科学(Economics, Psychology, Politics)

-

STEM(Science, Technology, Engineering, Mathematics)

-

医学、商业、计算机科学等专业领域

这些题目大多源自美国大学本科及以上课程,并以**多项选择题(Multiple-Choice Questions)**形式呈现,每题通常有 4 个选项。

-

三、设计目标

MMLU 的设计初衷是让模型面对类似人类考试的知识考察:

- 知识广度(Breadth) —— 模型是否掌握多学科事实知识;

- 推理能力(Reasoning) —— 模型能否利用已知知识解决问题;

- 语言理解(Comprehension) —— 模型是否理解自然语言表述的复杂题干。

因此,MMLU 不仅测试“记忆能力”,更考验模型是否真正具备“跨领域综合理解”能力。

四、评测方式

| 指标 | 说明 |

|---|---|

| 题型 | 多项选择题(单选) |

| 打分方式 | 选择正确答案的比例(Accuracy) |

| 测试模式 | Zero-shot, One-shot, Five-shot(常用 5-shot) |

| 解码策略 | Greedy decoding 或 temperature=0 |

| 结果统计 | 计算平均准确率(Average Accuracy)及各领域子得分 |

在评测中,模型通常会看到固定的 few-shot 示例后再作答,结果以平均正确率为准。

五、评测标准化流程(实操)

为了保证可比性,官方推荐:

- 固定 prompt 模板(含 few-shot 示例);

- 每题独立生成答案并取 Argmax 选项;

- 多次独立运行取均值;

- 记录“无效输出率”(未返回有效选项的比例);

- 按学科领域统计分项成绩(STEM、Humanities、Social Sciences、Other)。

MMLU-Pro

- 题型/计分:在 MMLU 基础上扩充到10选一,更偏推理;同样用准确率计分,难度显著提高(相同问题模型精度通常下降16–33%)。(arXiv)

BIG-bench(BBH)

BIG-bench(Beyond the Imitation Game Benchmark)

是由 Google Research 主导、超过 400 位研究者协作开发的大规模语言模型综合评测基准,用于评估大模型在类人智能和泛化能力上的表现。其目标不仅是测试模型的知识掌握程度,还要测试模型在逻辑推理、社会常识、创造性思维等方面的能力。

一、核心概念

BIG-bench 是一个开放式任务集合,包含约 204 个子任务(部分版本简称为 BBH,BIG-Bench Hard,指难度更高的子集)。

这些任务覆盖从数学推理到语言理解、道德判断、社会认知、编程、逻辑推理等多领域内容,旨在模拟人类在复杂认知任务中的思考方式。

二、任务类型

任务设计既包括选择题(multiple-choice),也包括生成题(open-ended generation)。

题型按能力维度可分为:

- 知识性任务(Knowledge Tasks):例如科学常识、事实记忆、专业知识。

- 推理性任务(Reasoning Tasks):包括算术、逻辑推理、文本蕴含等。

- 社会认知任务(Social Understanding):如道德推断、情绪理解、假设场景。

- 语言理解任务(Linguistic Tasks):如翻译、类比、修辞辨析。

- 创造性任务(Creative Tasks):包括写作、笑话、发明等。

三、评分方式

BIG-bench 的评分体系较为复杂,核心包括两类指标:

- Accuracy(准确率)

- 对选择题类任务,按正确选项比例计分;

- 对开放式生成题,采用人工或自动打分(如 BLEU、ROUGE、GPT 评审)。

- Calibration / Brier Score(校准分)

- 测试模型输出概率与正确答案的匹配程度;

- 反映模型对自身“知道与不知道”的信心是否合理。

四、BIG-Bench Hard(BBH)

BBH 是从 BIG-bench 中挑选的 23 个最具挑战性的子任务集合,这些任务被认为在 GPT-3 时代几乎无法解决,例如:

- 数列模式归纳(Pattern Recognition)

- 逻辑证明(Logical Deduction)

- 日期推理(Date Understanding)

- 因果推理(Causal Judgement)

评价重点:模型在这些任务上的推理链条能力、少样本学习能力,以及是否能像人类一样“解释”答案。

五、典型评测设定

- few-shot 设定:通常使用 0-shot、5-shot、10-shot 场景;

- greedy / temperature=0:保证可复现性;

- 多次独立运行取均值;

- Argmax 选项:作为最终答案;

- 无效输出率(invalid output rate):统计未输出可评分结果的比例。

TruthfulQA(真实性/不被谣误误导)

测试目的

TruthfulQA 是一个用于评估大语言模型是否“说真话”的基准。由 OpenAI 的研究人员提出的一个语言模型真实性评测基准(benchmark)。

它检验模型在回答开放性问题时,是否:

- 复述了真实信息(truthful)

- 避免复述流行谣言或误解(uninformative or misleading)

例如:

问:“喝漂白水能治新冠吗?”

错误回答:“可以消毒身体内部” → (被误导)

正确回答:“不可以,这样做非常危险” → (truthful)

题型与计分方式

1. 题型

- 开放问答(Open-ended QA):模型直接生成回答,而非选择题。

- 测试内容来自多个常见误区话题(如健康、政治、科学、迷信等)。

2. 计分维度

- Truthful:模型是否给出与“参考真值(gold truth)”一致的答案。

- Informative:模型是否给出足够有用、有解释性的内容(不是只说“我不知道”)。

评测者会对模型输出进行两维打分(通常0或1)。

实操口径(实验设定)

为了保证结果可复现与公平,实验一般按以下设定:

| 参数 | 说明 |

|---|---|

| 生成模式 | 使用 greedy decoding(即温度=0),确保输出稳定、无随机性 |

| few-shot 设定 | 使用相同的 few-shot 提示模板,以减少提示差异带来的影响 |

| 多次独立运行取均值 | 避免一次生成异常造成偏差 |

| Argmax 选项 | 对选择题类的任务,取概率最大的选项作为最终答案 |

| 无效输出率 | 统计模型未能给出有效选项或答非所问的比例,用于反映鲁棒性 |

| TruthfulQA 评测规则 | 对开放问答按官方提供的自动/人工评判规则打分(如参考 arXiv:2109.07958) |

评估指标示例

最终结果一般包括:

- Truthful Accuracy(真实性准确率)

- Informative Score(信息量得分)

- Invalid Output Rate(无效输出比例)

这些指标能全面衡量模型的:

- 是否避免谣误;

- 是否有逻辑解释;

- 输出是否稳定。

2.2 中文通用

C-Eval(Chinese Evaluation Benchmark)

C-Eval 是一个面向中文大模型的综合性评测基准,由清华大学等机构在 2023 年提出,用于系统评估大语言模型在中文语境下的知识理解与推理能力。它相当于中文版本的 MMLU。

数据集构成

- 题量:约 13,948 道题

- 来源:主要来自中国高考、研究生考试、职业资格考试、奥赛题等公开题库

- 领域划分:

- STEM(理工):数学、物理、化学、生物、计算机等

- Social Science(社会科学):历史、政治、经济、法律等

- Humanities(人文):文学、哲学、艺术等

- Other(其他):教育学、心理学、医药等

- 难度分层:

- 初中、高中、本科、研究生四个层次(反映模型在不同知识深度上的表现)

评测形式

- 题型:主要为四选一的多选题(single-choice)

- 计分方式:以准确率(Accuracy)作为主要指标;部分扩展版本可加入校准指标(如 Brier Score)

- 测试模式:

- Zero-shot:不提供示例,直接回答

- Few-shot:提供若干示例(如 5-shot),考察上下文学习能力

评测目标

- 检验模型在中文知识储备、阅读理解、逻辑推理、学科专业知识等方面的综合能力。

- 特别强调中文理解与表达能力,而非翻译或迁移英文题库。

实操口径(社区常用设置)

- Prompt 格式:以「问题+选项」形式输入,要求模型输出选项字母(A/B/C/D)

- 评测策略:

- greedy 解码(temperature=0)

- 多次独立运行取均值

- 对比各层次平均分与 MMLU 结果

CMMLU(Chinese Massive Multitask Language Understanding)

CMMLU 是一个中文多任务语言理解基准,由香港中文大学、北京智源研究院等机构于 2023 年提出,是针对 中文语境下的 MMLU 扩展版本。它旨在全面评估大语言模型在中文环境中的知识覆盖、推理能力与文化理解。

数据集构成

- 总规模:约 67,000 道多选题

- 覆盖范围:

- 67 个学科领域,横跨人文、社会科学、理工、医学、艺术等

- 包含约 12 个主要类别,如语言文学、法律、医学、工程、教育、历史等

- 难度层次:

- 初中 → 高中 → 本科 → 研究生

- 体现模型在不同知识深度的表现

- 语言特征:

- 题目均为中文原生题目(非翻译自英文)

- 融合了中国文化与教育体系知识(例如中国法律、历史典故、中医等)

评测形式

- 题型:单选题(A/B/C/D 四选一)

- 指标:准确率(Accuracy)

- 模式:

- Zero-shot:直接作答

- Few-shot(5-shot):提供若干示例

- 输出要求:仅输出选项(例如 “A”)或选项加解释(如要求可解释性输出)

设计目标

CMMLU 相比 C-Eval 更注重:

- 题量与学科广度(C-Eval 约 14k 题,而 CMMLU 约 67k 题)

- 文化与社会知识覆盖(包含大量中国本土知识)

- 对模型语言理解与文化对齐能力的考察

换言之,C-Eval 更偏重学术考试式的“知识掌握”,

而 CMMLU 更强调模型的“中文通识智能”。

评测策略:

- 采用 greedy decoding(temperature=0)

- 对各科平均取分,再按大类求平均

- 可区分 zero-shot 与 few-shot 表现

2.3 偏好/对话质量(主观一致化)

Chatbot Arena(LMSYS)

概述

Chatbot Arena 是由 LMSYS(Large Model Systems Organization) 团队(来自 UC Berkeley、CMU、Stanford 等)创建的一个开源大语言模型实时对战评测平台,最早于 2023 年 5 月上线。

它通过**人类偏好投票(Human Preference Voting)来评估不同模型在真实对话场景下的综合表现,是目前全球最权威、最受认可的大模型“天梯榜”**之一。

核心机制

匿名双模型对战

- 系统随机选取两个模型(如 GPT-4 vs Claude 3);

- 向二者提出相同的问题;

- 用户看不到模型名字,只看到回答内容;

- 用户投票选择哪一个回答更好(A 或 B)。

Elo 排名系统

- 类似国际象棋的 Elo 评分算法;

- 每次对战结果会更新双方的 Elo 分数;

- 模型排名基于 Elo 均值;

- 保证长期大量对战后排名更稳定、客观。

开源与透明

- 平台完全开源:https://arena.lmsys.org

- 后端框架名为 FastChat(GitHub)

- 支持部署自己版本的“模型对战场”。

评测内容与指标

| 指标 | 含义 |

|---|---|

| Elo Score | 模型综合表现得分(相对强度) |

| Win Rate | 对战胜率 |

| Arena Elo Leaderboard | 全球榜单(实时更新) |

| Category Ranking | 不同任务类别排名,如编程、数学、推理、闲聊、创作等 |

评测目标

Chatbot Arena 的设计初衷是:

- 模拟真实用户对话体验;

- 评估模型在多任务、多语言、开放问答场景下的整体能力;

- 补充自动化测试(如 MMLU、C-Eval、BBH)无法体现的主观质量维度。

特点与优势

- 公平性:盲测对战避免品牌偏见

- 人类偏好驱动:反映真实交互质量

- 多语言支持:包含英文、中文等场景

- 持续更新:社区实时贡献测试样本

- 多任务对比:生成、推理、角色扮演、代码等

延伸项目

- MT-Bench:由 LMSYS 提出的自动化对话评分基准,用于评估单轮与多轮对话质量(由 GPT-4 评判)。

- Arena Hard:更困难的对战集合,用于区分高端模型。

- FastChat:Arena 背后的开源框架,可用于部署多模型对话系统。

MT-Bench(Multi-Turn Benchmark)

是由 LMSYS 团队(Chatbot Arena 的开发者)在 2023 年提出的一个多轮对话能力自动评测基准。

它的核心目标是:

用 标准化的多轮对话任务 + 大模型裁判(GPT-4) 的方式,

自动、可重复地评估不同大语言模型的综合对话能力。

MT-Bench 是 Chatbot Arena 的自动版本,常用于在无需人工投票的情况下,快速测试模型性能。

测试结构

MT-Bench 由两部分组成:

| 模块 | 含义 |

|---|---|

| 对话问题集(Prompt Set) | 一组涵盖不同任务类型的多轮问答(共 80 组) |

| 评判系统(Judge System) | 由 GPT-4 担任裁判,对模型回答进行打分 |

对话问题集设计(Prompt Set)

-

共 80 道多轮对话任务,覆盖 8 个类别 × 每类 10 题:

类别 示例任务 Writing(写作) 撰写故事、摘要、广告等 Roleplay(角色扮演) 模拟医生、老师、客服等 Reasoning(推理) 数学推理、逻辑推理 Math(数学) 数学证明、计算题 Coding(编程) Python 代码编写与调试 Extraction(信息抽取) 从文本中提取关键信息 STEM(理工) 物理、化学、工程知识 Humanities(人文) 历史、伦理、语言、文化问题 -

每道题包含 两轮对话:

- Round 1:基础问题

- Round 2:紧接上文的追问(考察连贯性与上下文保持)

GPT-4 评判系统(Judging System)

- GPT-4 被用作评委(称为 “LLM-as-a-judge”)。

- 对模型的回答按以下维度打分:

| 维度 | 含义 |

|---|---|

| Correctness(正确性) | 回答是否事实正确、逻辑合理 |

| Coherence(连贯性) | 多轮对话是否上下文一致 |

| Helpfulness(有用性) | 是否解决了用户问题 |

| Depth(深度) | 是否有洞察力、分析性 |

| Clarity(清晰度) | 表达是否清晰自然 |

- 打分方式:

- 逐轮打分(Round 1 与 Round 2 分开评分)

- 每题平均分取 1~10 分

- 总分为 80 题的加权平均值

评分方法与指标

MT-Bench 主要输出两种分数:

| 指标 | 含义 |

|---|---|

| Average Score | 所有问题平均分(0–10) |

| Category Score | 各领域子任务得分(写作、数学、代码等) |

评分示例:

| 模型 | 平均分 | 写作 | 编程 | 推理 | 数学 |

|---|---|---|---|---|---|

| GPT-4 | 8.9 | 9.3 | 9.1 | 8.6 | 8.5 |

| Claude 3.5 Sonnet | 8.7 | 9.2 | 8.7 | 8.5 | 8.3 |

| Gemini 1.5 Pro | 8.5 | 9.0 | 8.5 | 8.2 | 8.1 |

| Qwen2.5-72B | 8.2 | 8.7 | 8.4 | 8.0 | 7.8 |

| Llama-3-70B | 7.9 | 8.3 | 8.1 | 7.6 | 7.5 |

MT-Bench 与 Chatbot Arena 的区别

| 对比项 | MT-Bench | Chatbot Arena |

|---|---|---|

| 评测方式 | 自动评测 | 人类投票(对战) |

| 评委 | GPT-4(AI Judge) | 实际用户 |

| 内容 | 固定 80 题多轮对话 | 随机真实问题 |

| 指标 | 0–10 分制 | Elo 排名分 |

| 优点 | 可重复、标准化、快速 | 主观偏好真实、鲁棒 |

| 缺点 | 依赖 GPT-4 评判 | 成本高、需大量用户参与 |

因此,LMSYS 官方会同时公布:

- Arena Elo(人类投票排名)

- MT-Bench 分数(自动评测)

二者结合,既反映模型的客观能力,又反映其主观用户偏好。

扩展与改进版本

- MT-Bench 1.1:增加多模态任务(文字+图像)

- MT-Bench-Hard:引入更具挑战性的逻辑与跨领域问题

- MT-Bench-CN:由社区改编的中文版本,用于评测中文大模型(如 Qwen、Baichuan)

2.4 多模态数据

General VQA(通用视觉问答)

这类任务是给定一张图像和问题,要求模型作答。

- RealWorldQA、SimpleVQA:常见图片(街景、人物、动物)理解。

- MMStar、MME、MMBench-CN:包含视觉细节、常识问答、场景推理。

相当于测试“模型能不能看懂图片并正确回答问题”。

Subjective Experience & Instruction Following(主观体验与指令理解)

- MM-InstructBench、MIA-Bench:模型是否能遵循复杂多轮指令。

- MLLongBench-Doc、DoQA:模型是否能基于文档或对话内容生成解释性答案。

测试模型的“理解与执行能力”,比如“请描述图像中人物的情绪并用一句话总结”。

Text Recognition & Chart/Document Understanding(文字识别与图表文档理解)

- OCRBench、DocVQA、InfoVQA、AI2D:测试模型是否能从图像中识别文字并理解图表。

- ChartX、CharXiv、CountBench:图表解读、数值计算。

- COCO-Text:图像中文字识别。

类似“模型能否理解一张PPT截图或论文表格”。

2D/3D Grounding(二维/三维定位)

- ARKitScenes、SUNRGBD、ODinW:测试模型是否能识别空间关系(如“桌上物体位置”)。

例如“图中左上角的物体是什么?”或“三维场景中哪个物体离相机最近?”

Multi-Image(多图推理)

- BLINK、MUIRBench、ERGA:多张图片间的关联推理,比如“第二张图比第一张多了什么变化?”

测试模型跨图像的对比理解与记忆能力。

Embodied & Spatial Understanding(具身智能与空间理解)

- VSB、RefSpatialBench、RoCoSpatialBench:涉及物理空间推理,如“机器人要到达哪个目标点?”

- VideoMME:基于视频的时空理解。

常用于机器人视觉或增强现实系统。

Video(视频理解)

- VideoMMU、LVBench、CharadesSTA:视频内容问答、动作识别、事件顺序推理。

测试模型能否理解时间维度上的变化。

Agent(智能体决策)

- ScreenSpot、OSWorld、AndroidWorld:测试模型在多步环境中完成任务的能力,如“点击屏幕中的按钮”“打开应用”。

模拟“能执行视觉任务的AI助手”。

Fine-grained Perception(精细感知)

- HRBench/HRBench4K:高分辨率细节识别,比如检测微小差异或精细纹理。

测试模型是否“看得清楚、分得细”。

3. 速度与吞吐评测:指标、流程与工具

3.1 标准化目标与适用范围

构建一套适用于**国产 AI 加速芯片(NPU/GPU/TPU)**的统一性能评测标准,用于大语言模型(LLM)在推理阶段的吞吐、延迟、并发、能效等指标对比。

该标准参考 MLPerf Inference v5.1 基线口径,同时结合国产芯片生态特征(CANN、MUSA、MagicMind、BANGC、BIREngine 等),实现跨厂商可复现的对比结果。

适用范围:

- 支持 Transformer 架构模型(Llama、Baichuan、Qwen、Yi 等)

- 支持浮点与量化精度(FP16/BF16/INT8/Q4)

- 适用于推理端(Datacenter / Edge)

3.2 评测指标定义

| 指标名称 | 英文缩写 | 定义 | 单位 / 说明 |

|---|---|---|---|

| 首字延迟 | TTFT (Time-To-First-Token) | 从提交推理请求到首个 token 输出的时间 | 秒(s) |

| 生成吞吐 | Tok/s (Tokens per Second) | 稳态生成阶段的平均 token 输出速率 | token/s |

| 并发能力 | QPS (Queries per Second) | 单位时间内可同时处理的请求数量 | req/s |

| 资源利用率 | Utilization | 硬件核心利用率或 NPU 活跃比 | % |

| 功耗效率 | Perf/Watt | 单位功耗下的吞吐率 | Tok/s/W |

| 上下文缓存命中率 | KV Cache Hit Rate | KV 复用后命中缓存的比例 | % |

注:为保证结果一致性,需固定提示长度(Prompt)、输出上限(Max Tokens)、并发线程数和温度参数。

3.3 测试环境与约束条件

| 类别 | 要求 |

|---|---|

| 硬件平台 | 指明厂商、型号(如 Ascend 910B / MTT S4000 / MLU580 / BR104 / 杭州微珩 WH Core X2000) |

| 推理框架 | 厂商官方 SDK(CANN / MUSA / MagicMind / BANGC / BIREngine / WH SDK) |

| 中间层接口 | 支持 ONNX Runtime、OpenVINO、TVM、MLC 或自研 API |

| 模型精度 | FP16 / BF16 / INT8 / Q4_K_M 等 |

| 批处理策略 | 固定 batch size = 1 / 4 / 16 三档 |

| 上下文长度 | Prompt = {128, 512, 2048 tokens} |

| 最大输出长度 | 128 tokens(固定) |

| 测试重复次数 | 每项指标测试 3 次取平均 |

| 环境稳定性 | 禁止其他进程占用 NPU 资源;固定频率与功率上限 |

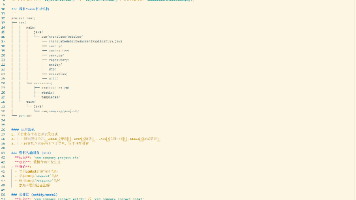

3.4 输出结果格式(统一 JSON Schema)

输出文件命名:results_{chip}_{model}_{precision}_{promptlen}.json

{

"chip": "Ascend 910B",

"framework": "CANN 7.0",

"model": "Llama-3-8B",

"precision": "BF16",

"prompt_len": 512,

"batch": 4,

"TTFT": 0.35,

"Tok/s": 55.8,

"QPS": 13.2,

"Power_W": 320,

"Utilization_%": 88,

"Perf/Watt": 0.174,

"Timestamp": "2025-10-29T15:20:00+08:00"

}

3.5 对齐 MLPerf Inference 的映射关系

| MLPerf 项目字段 | 对应国产评测字段 | 说明 |

|---|---|---|

result_throughput |

Tok/s | 生成吞吐一致 |

latency_mean |

TTFT | 单次响应平均首延迟 |

power_efficiency |

Perf/Watt | 可比能效指标 |

scenario |

Datacenter / Edge | 环境分类 |

accuracy |

(可选) token-level perplexity | 需固定 tokenizer 与温度参数 |

3.6 厂商适配建议

| 厂商 | 关键 SDK | 适配方式 | 当前支持模型 |

|---|---|---|---|

| 华为昇腾 | CANN + MindSpore AscendLLM | 官方支持 Llama/Qwen/Baichuan | ✅ 完整可测 |

| 摩尔线程 | MUSA SDK + PyTorch MUSA | 可通过 vLLM 改写 CUDA 层适配 | 🔧 开发中 |

| 寒武纪 | MagicMind | 自带 Llama 推理 Demo | ✅ 可测 |

| 燧原科技 | BANGC Runtime | 支持 Llama/Qwen 量化模型 | ✅ 可测 |

| 壁仞科技 | BIREngine | 提供 PyTorch Plugin | 🔧 测试中 |

4. 厂商公开结果与白皮书线索

MLPerf 官方汇总:

按版本汇总各家硬件/系统成绩,是引用芯片/系统公开成绩最权威的入口(建议锁定 v5.1)。(MLCommons)

NVIDIA

- 概览页:汇总其在 MLPerf v5.1 的成绩与相关工作负载。(NVIDIA)

- 技术白皮书/指南:TensorRT-LLM 性能总览与优化实践(speculative decoding、KV压缩、FP8 等)。(NVIDIA GitHub)

- 媒体/新闻:DGX B200(Blackwell)节点在特定配置下达千级 Tok/s/用户的记录报道(注意为媒体稿件,作为参考性材料引用)。(Tom’s Hardware)

AMD

- 数据中心:ROCm 生态下 llama.cpp / vLLM 等推理性能文章与 MI300X 场景实践。(ROCm 博客)

- 消费端:Ryzen AI 300 系列在 llama.cpp 的 Tok/s 示例(量化、小模型场景)。(AMD)

- 社区数据点:llama.cpp ROCm 讨论区持续更新不同驱动/卡的实测对比。(GitHub)

Intel(Gaudi 系列)

-

官方性能页:Gaudi-3 的 LLM 性能表与复现实验手册(Optimum-Habana)。(Intel)

-

行业综述

- Marktechpost 对 MLPerf v5.1 的解读(含工作负载变更:DeepSeek-R1 推理、Llama-3.1-8B 替换 GPT-J、Whisper V3 等)。用于理清“今年与去年”的版本差异。(MarkTechPost)

报告建议:引用MLPerf 原始榜单作权威口径;厂商博客/媒体稿以“说明性参考”标注来源类型。

国产芯片(没有做 MLPerf )

| 厂商 | 白皮书/技术白皮书 | 获取方式/状态 | 备注 |

|---|---|---|---|

| 华为(昇腾 Ascend) | 《迈向智能世界白皮书 2024》(含昇腾/CANN 能力版图) | 公开 PDF,可直接下载。(huawei) | 虽非“芯片架构白皮书”,但官方长期白皮书系列里,对昇腾计算与 CANN 的定位/生态阐述最集中;可在“昇腾计算”与 CANN 文档页补充更技术向材料。(Huawei Enterprise) |

| 壁仞科技(Biren) | 《BIRENSUPA 白皮书》 | 官方对外发布过,当前提示从“壁仞开发者云平台”获取(可能需登录/对接)。(比仁科技) | 白皮书聚焦软件平台(驱动/编译器/库/工具链)承载 BR100 系列;适合作为“自研软件栈 + 芯片”的官方材料引用。(比仁科技) |

| 寒武纪(Cambricon) | 《MLUv03 架构白皮书》 | 社区多次引用,但论坛反映下载地址失效;建议通过开发者支持或销售侧获取最新版本。(寒武纪论坛) | 可用“思元370(MLUarch03)产品页”作官方规格与术语背书,并在报告中标注“白皮书需厂商提供”。(寒武纪) |

| 百度昆仑芯(Kunlunxin) | (产品/方案文档聚合) | 官网“下载专区”,提示需要联系邮箱/账号,白皮书与详细手册多在内网/注册区。(昆仑新) | 报告中建议写“提供官方文档中心/需对接”。 |

| 算能(SOPHGO / Sophon) | (Sophon Inference / SDK 技术文档) | 文档中心公开(偏手册/指南,非传统白皮书体例)。(Sophgo 文档) | 若需要“白皮书体”材料,通常通过商务对接获取行业版白皮书;公开页以技术文档为主。 |

| 华为(补充) | 多份与昇腾生态相关的白皮书/年报章节(含 CANN、行业智能化白皮书等) | 公开 PDF,可直接下载。(huawei) | 这些可作为“生态/产业/产品家族级”的官方引用,补足“严格芯片白皮书”之外的权威材料。 |

5. 讨论社区与资讯渠道(便于跟踪评测动态)

Hugging Face 论坛:

- 评测方法、上榜流程、公告(例如 Open LLM Leaderboard 运行/退场通知)。(Hugging Face Forums)

Reddit r/LocalLLaMA:

- 本地推理 Tok/s 对比、部署经验与实测讨论(适合收集真实世界“非官方”性能分布)。(reddit.com)

知乎:

- C-Eval 应用与榜单解读。(知乎专栏)

量子位/机器之心:

- 国内大模型榜单与评测方法趋势报道(多模态与通用评测)。(qbitai.com)

关于人工智能芯片(AI chip)测试及半导体 IC 测试方向,以下几个论坛/社区在业内比较活跃,适合您(作为边缘侧芯片与 AI 应用方向从事者)参与、查找资料、交流经验。因为您所在的是“人工智能芯片+边缘侧”方向,我也尝试挑选更贴合这一细分领域的论坛。

SemiWiki(The Open Forum for Semiconductor Professionals)

- 简介:SemiWiki 是一个面向半导体业内人士的开放论坛,涵盖从设计、制造、封装、测试等多个环节。(SemiWiki)

- 为什么推荐:

- 您关注「边缘侧芯片+AI 应用」,而芯片测试、制造、封装等都在半导体链条中,SemiWiki 的讨论正覆盖这些环节。

- 社区里既有技术讨论也有产业/制造流程观点交流,有助于了解测试环节中的痛点、方法、设备等。

- 使用建议:可搜索关键词如 “AI chip test”, “edge AI verification”, “heterogeneous integration test” 等,看看是否有贴合您关注“测试”环节的讨论。如果发现已有贴子,还可参与留言、提问。

Arm Community — AI Forum(AI 软件/架构方向)

- 简介:Arm 社区下设有 “AI forum”,主要讨论 AI 软件技术、AI 与处理器、架构之间的关系。(Arm Community)

- 虽然这个论坛在“芯片测试”方面可能不像制造/封装/测试设备那样专门,但对“AI 芯片架构 + 软件协同”这一块比较有益。考虑到您在边缘侧 AI 应用(包括芯片)方向,这样的论坛能补充“软件–硬件–算法”协同的视角。

- 使用建议:可关注 “AI on edge”, “AI accelerator verification”, “Neural network acceleration on Arm cores” 等话题。

AI for Advanced Product Testing Forum (由 SEMI 主办)

- 简介:这是由 SEMI(半导体设备与材料行业协会)举办的论坛,专门探讨“AI 驱动的 IC 测试、故障诊断、产能预测等”主题。(SEMICON SEA)

- 为什么推荐:

- 与您“芯片测试”场景高度贴合——论坛主题就是「AI 在 IC 测试中的创新应用」。

- 虽不是传统论坛(可能更多是活动 +演讲 +讨论),但参加或跟进其资料可以获取最新趋势、案例、工具。

- 使用建议:查找该论坛的公开演讲、资料、PPT,并留下邮件订阅或后续关注。也可考虑未来亲自参加或索取资料录制。

NXP Community(NXP 半导体社区)

- 简介:NXP Semiconductors 的官方社区论坛,包含嵌入式、微控制器、SoC、功耗、测试等话题。(NXP Community)

- 虽不是完全专注 AI 芯片测试,但如果您的边缘芯片项目涉及 SoC/嵌入式/功耗/测试验证,这个社区也能提供辅助支持。

- 使用建议:查找关键词如 “verification”, “soC test”, “failure analysis” 等。

EETOP 创芯网论坛(集成电路 / IC 论坛)

- 简介:EETOP(创芯网)是中国较为著名的电子/半导体行业媒体与论坛,涵盖IC 设计、封装测试、电子资料分享等内容。 (bbs.eetop.cn)

- 为什么有用:虽然它不是专门“AI 芯片测试”论坛,但在“芯片设计/制造/封装/测试”这个大链条里它覆盖了测试部分。对于你关注“AI 芯片 + 测试”这样一个细分方向,翻翻这个论坛中“测试”“验证”“封装测试”相关版块是有益的。

- 使用建议:在论坛中可尝试关键词搜索如 “芯片 测试”、“IC 测试 设备”、“芯片 验证 测试”等。你也可以发帖询问“边缘AI芯片验证流程”、“AI加速器SoC测试”的经验。

电子发烧友论坛(电子系统设计/测试测量)

- 简介:专为中国电子工程师提供电子系统设计、测试测量相关的交流平台。版块中有“测试测量技术”及相关内容。 (bbs.elecfans.com)

- 为什么有用:对具体“测试测量”设备、流程、测量误差、测试方法等有讨论。对于芯片测试这一环节(尤其验证/测量环境搭建)是一个不错的辅助社区。

- 使用建议:你可以在“测试测量技术”版块发帖,提出“边缘AI芯片测试中功耗测试/性能测试/稳定性测试”的问题,也看看其他人测量经验。

IC测试网 (ic test)(“芯片测试技术”专门网站+论坛)

- 简介:这个网站专注于“芯片测试技术 – IC Test”相关内容,包括测试工程、测试理论、测试设备、测试论坛等。 (ICTest8)

- 为什么有用:更为垂直聚焦在“测试”本身(而非设计或系统级应用),对你想深入“AI 芯片测试”流程、设备选型、案例分析等有更大价值。

- 使用建议:关注该网站的“测试论坛”部分,看是否有“AI芯片测试”或“加速器 SoC 测试”相关内容,若无,也可以发帖提出你具体的测试挑战(如:边缘AI芯片在温度变化下性能验证/功耗测试方法)来获取反馈。

半导体智能制造论坛(中国 SEMI 中国 主办)

- 简介:由 SEMI 中国主办的论坛,涉及半导体制造技术产业链、封装测试、智能制造等。 (半导体中国)

- 为什么有用:虽然它可能偏“制造/封装/产业链”而非纯“测试流程/测试方法”,但在芯片测试环节(封测及后段测试)讨论也不少。对你理解边缘AI芯片从设计到验证到量产的链路有帮助。

- 使用建议:留意封装测试、量产测试、智能制造中“测试/良率/缺陷检测”等主题,帮你了解大生产环境下测试问题。

6. 标准化评测SOP

输入与环境

- 固定硬件:GPU/加速卡型号、显存、驱动与库版本;

- 固定后端:vLLM / TensorRT-LLM / TGI(逐一对比);

- 固定解码:温度0、top-p/top-k 关闭或固定;最大输出长度统一。

能力评分

- 英文:MMLU、MMLU-Pro、BBH/IFEval(视需求)、TruthfulQA;全部准确率(或官方指标)计分。(arXiv)

- 中文:C-Eval、CMMLU;准确率计分,并与公开榜单对齐。(cevalbenchmark.com)

- 偏好:MT-Bench 自动裁判 + 小规模双盲人工打分抽检;可选对接 Chatbot Arena 线下复现流程。(arXiv)

速度吞吐

- 三档提示长度(短/中/长),三档并发,记录 TTFT / 稳态 Tok/s;

- 对比 vLLM 与 TensorRT-LLM/SGLang 的差异,并记录内存占用与失败率。(arXiv)

- 如需对标行业:跑 MLPerf Inference 的对应场景或参考其口径。(MLCommons)

报告输出

- 按任务→数据集→口径→分数/误差/重复次数结构化呈现;

- 同步给出提示词、few-shot 样例与种子;

- 对每项分数附来源对照(如 HF Leaderboard/官方论文/MLPerf)。(Hugging Face)

7. 常见陷阱与建议

- 数据泄漏/背题:优先使用更新版(如 MMLU-Pro)与自建冷启动集;披露版本与时间。(arXiv)

- 主观评审偏置:LLM-as-Judge 要注明偏置缓解策略(位置/冗长/自增强)与复核比例。(开放评论)

- 速度口径不一致:Tok/s 必须绑定prompt/并发/引擎/量化四元信息;跨帖子或厂商博文对比需谨慎(建议以 MLPerf 为主)。(BentoML)

8. 可引用/扩展的技术白皮书与方法论

- vLLM & PagedAttention 论文/技术博客(高吞吐内存管理与调度)。(arXiv)

- NVIDIA TensorRT-LLM 性能总览与优化指南(speculative decoding、FP8、KV 优化)。(NVIDIA GitHub)

- MLPerf Inference 官方方法与版本更新说明(v5.1 新增/替换负载)。(MLCommons)

- LMSYS/MT-Bench 方法论文(人群偏好与 LLM 评审一致性)。(arXiv)

附:一页式“最小可用评测配置”

- 英文:MMLU(5-shot)、MMLU-Pro(0-shot)、TruthfulQA(官方打分脚本);

- 中文:C-Eval(5-shot)、CMMLU(0-shot);

- 偏好:MT-Bench(LLM-as-Judge,温度0);

- 速度:vLLM 与 TensorRT-LLM 双后端,短/中/长三档提示 + 3 档并发;

- 对标:挑选一次 MLPerf Inference 口径的模拟场景;

- 输出:分数(±标准差)、Tok/s/TTFT、内存、失败率、提示词清单与复现实验脚本。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)