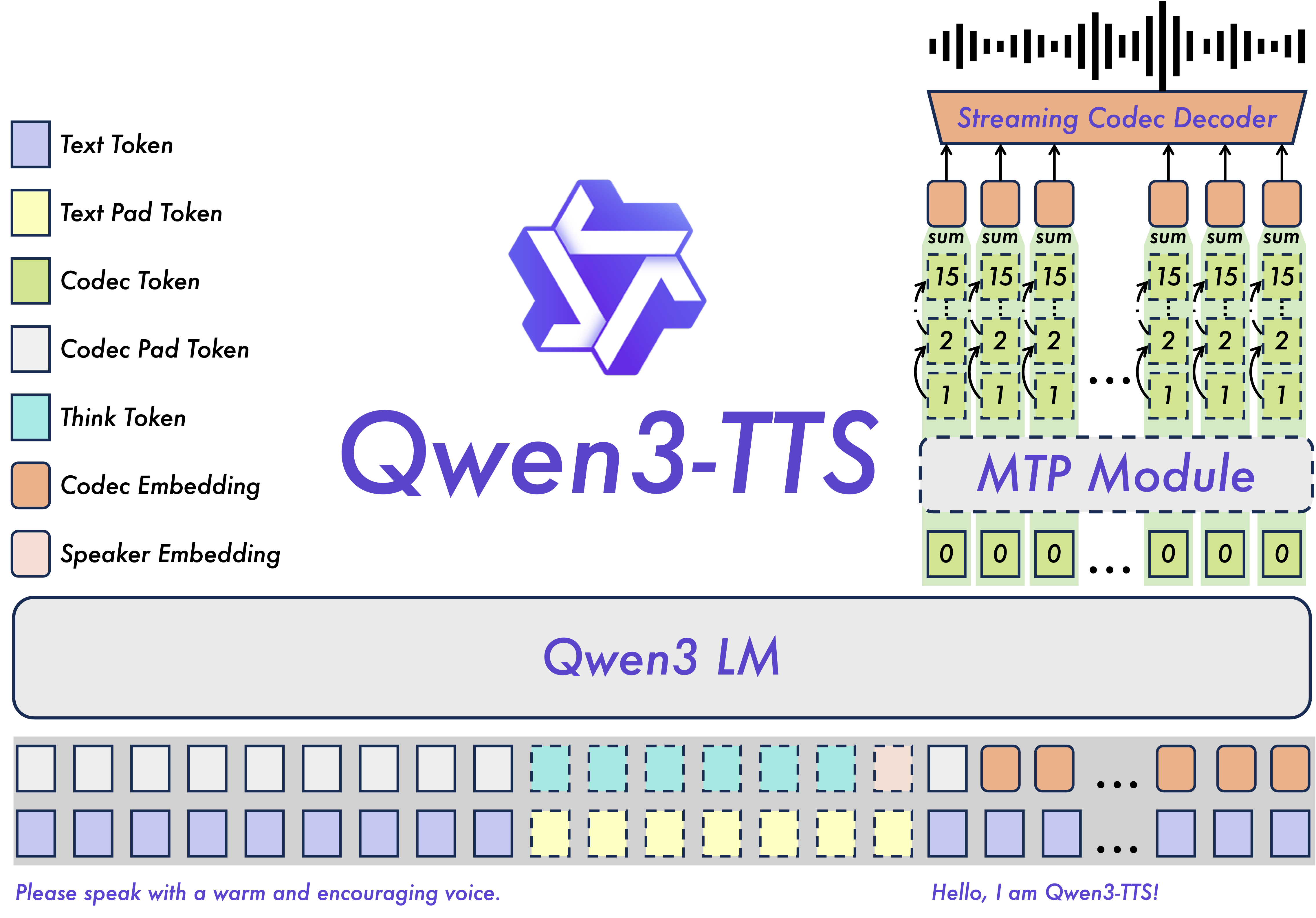

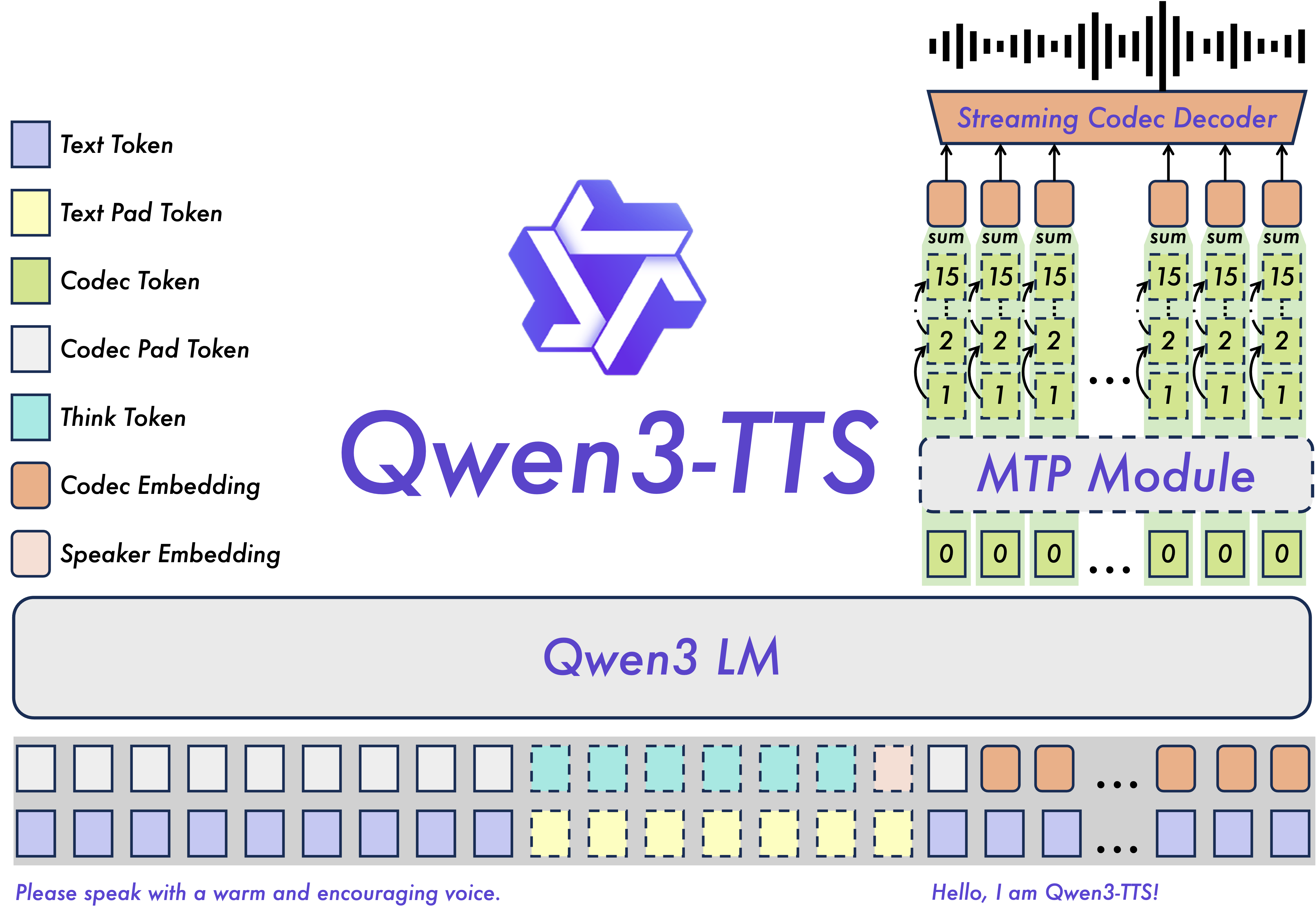

Qwen3-TTS 完整指南:开源文本转语音模型详解

阿里巴巴Qwen团队发布开源文本转语音模型Qwen3-TTS,提供1.7B和0.6B两个版本,支持10种语言和49+种音色。该模型具备3秒语音克隆、97毫秒低延迟等核心功能,性能优于竞品,采用Apache2.0许可可商用。硬件要求从4GB到12+GB VRAM不等,支持量化优化和微调,适用于内容创作、对话式AI等多种场景。

引言

2026年1月,阿里巴巴Qwen团队发布了Qwen3-TTS,一个真正好用的开源文本转语音模型。如果你想了解它的技术细节、硬件要求,以及怎么用它来做实际的事情,这篇文章就是为你准备的。

Qwen3-TTS是什么?

简单说,Qwen3-TTS就是一个真正能跨语言工作的文本转语音模型。它是开源的(Apache 2.0许可),基于500多万小时的语音数据训练,有两个版本可选:

- 1.7B版本:功能完整,质量最好,但需要更多GPU(6-8GB VRAM)

- 0.6B版本:轻量级选项,质量也不错,硬件要求低(4-6GB VRAM)

两个版本都能在Hugging Face和GitHub上找到。1.7B占4.54GB,0.6B占2.52GB。

Qwen3-TTS模型规格与参数详解

模型变体对比

| 方面 | 1.7B模型 | 0.6B模型 |

|---|---|---|

| 参数数量 | 17亿 | 6亿 |

| 存储大小 | 4.54 GB | 2.52 GB |

| 所需VRAM | 6-8 GB | 4-6 GB |

| 性能表现 | 峰值质量 | 均衡效率 |

| 适用场景 | 生产环境、高质量 | 演示、资源受限 |

核心技术:Qwen3-TTS-Tokenizer-12Hz

Qwen3-TTS用了一个自研的分词器,能在压缩语音的同时保留质量。看看这些数据就知道有多牛:

- STOI:0.96(可懂度几乎完美)

- UTMOS:4.16(听起来很自然)

- 说话人相似度:0.95(保留你的声音特征)

- PESQ宽带:3.21

- PESQ窄带:3.68

简单说:音频质量几乎无损。压缩过程中没有丢失什么重要的东西。

Qwen3-TTS硬件要求详解

GPU和VRAM要求

Qwen3-TTS-1.7B模型:

- 最低VRAM:6 GB

- 推荐VRAM:8 GB

- 最优VRAM:12+ GB

Qwen3-TTS-0.6B模型:

- 最低VRAM:4 GB

- 推荐VRAM:6 GB

- 最优VRAM:8+ GB

推荐GPU硬件

- 入门级:NVIDIA GTX 1070或同等产品(8 GB VRAM)

- 中端:NVIDIA RTX 3060或更高(12 GB VRAM)

- 生产环境:NVIDIA RTX 4080或A100(16+ GB VRAM)

系统要求

- Python:3.8或更高版本

- CUDA:支持CUDA的兼容GPU

- 存储:模型权重需要3-5 GB

- 内存:推荐16 GB+系统内存

性能优化技巧

为了减少GPU内存使用并提高性能:

- FlashAttention 2:推荐用于以

torch.float16或torch.bfloat16加载的模型 - 量化:GPTQ-Int8可以将内存占用减少50-70%

- 批处理:针对您的硬件优化批量大小

Qwen3-TTS五大核心功能

1. 自然语言语音设计

使用自然语言描述创建自定义声音。您可以指定:

- 音色特征:"深沉的男声"或"明亮的女声"

- 韵律控制:"慢速强调说话"或"快节奏充满活力的表达"

- 情感基调:"温暖友好"或"专业权威"

- 角色属性:"年轻科技爱好者"或"经验丰富的叙述者"

2. 3秒语音克隆

Qwen3-TTS-VC-Flash支持仅需3秒音频输入的快速语音克隆:

- 克隆任何声音用于个性化应用

- 在所有内容中保持一致的声音

- 为失去语言能力的个人创建声音

- 跨多种语言进行内容本地化

3. 超低延迟流式传输

双轨混合流式生成架构实现:

- 首包延迟:低至97毫秒

- 端到端合成延迟:实时应用中低于100毫秒

- 适合对话式AI、实时翻译和交互式语音应用

4. 多语言支持(10种语言)

Qwen3-TTS支持10种主流语言,质量达到母语水平:

- 中文 - 普通话和多种方言

- 英语 - 美式、英式和国际变体

- 日语(日本語) - 自然的韵律和语调

- 韩语(한국어) - 准确的发音和节奏

- 德语(Deutsch) - 精确的发音

- 法语(Français) - 地道的口音和连读

- 俄语(Русский) - 复杂的语音处理

- 葡萄牙语(Português) - 巴西和欧洲变体

- 西班牙语(Español) - 拉丁美洲和欧洲西班牙语

- 意大利语(Italiano) - 地区口音支持

5. 49+种高质量音色

Qwen3-TTS提供超过49种专业制作的音色:

- 性别多样性:男性、女性和中性声音

- 年龄范围:从年轻成人到老年说话者

- 角色特征:专业、休闲、充满活力、平静、权威

- 情感范围:快乐、悲伤、愤怒、中性、兴奋

- 地区特征:各种口音和说话风格

Qwen3-TTS性能基准与对标分析

多语言词错误率(WER)

Qwen3-TTS在多种语言上实现了最先进的性能:

| 语言 | Qwen3-TTS WER | 性能表现 |

|---|---|---|

| 平均(10种语言) | 1.835% | 业界最佳 |

| 英语 | 有竞争力 | 母语级别 |

| 中文 | 行业领先 | 卓越准确度 |

| 意大利语 | 同类最佳 | 异常出色 |

| 法语 | 优于竞品 | 超越对手 |

说话人相似度分数

- 10种语言平均:0.789

- 超越:MiniMax和ElevenLabs

- 跨语言适应性:异常出色

长文本生成稳定性

- 能够合成10分钟以上自然流畅的语音

- 长音频上无质量下降

- 保持一致的说话人特征

Qwen3-TTS安装与快速开始

安装步骤

# 从Hugging Face安装 pip install transformers torch # 克隆仓库 git clone https://github.com/QwenLM/Qwen3-TTS.git cd Qwen3-TTS # 安装依赖 pip install -r requirements.txt # 可选:安装FlashAttention 2以优化性能 pip install -U flash-attn --no-build-isolation

基本使用示例

from qwen_tts import Qwen3TTSModel import soundfile as sf # 加载模型 model = Qwen3TTSModel.from_pretrained("Qwen/Qwen3-TTS-12Hz-1.7B-CustomVoice") # 使用自定义音色生成语音 wavs, sr = model.generate_custom_voice( text="你好,这是Qwen3-TTS在说话。", language="Chinese", speaker="Xiaoming" ) # 保存音频 sf.write("output.wav", wavs[0], sr)

语音克隆示例

from qwen_tts import Qwen3TTSModel # 加载用于语音克隆的基础模型 model = Qwen3TTSModel.from_pretrained("Qwen/Qwen3-TTS-12Hz-1.7B-Base") # 从3秒音频样本克隆声音 wavs, sr = model.generate_voice_clone( text="您的文本内容", voice_sample_path="voice_sample.wav", language="Chinese" )

Qwen3-TTS实际应用场景

内容创作和媒体制作

- 有声书叙述:角色对话的多种声音

- 播客制作:跨集的一致声音

- 视频配音:多语言内容本地化

- 在线教育:多语言的引人入胜的教育内容

对话式AI和虚拟助手

- 客户服务机器人:自然的自动化支持

- 语音助手:个性化语音交互

- 交互式IVR系统:增强的呼叫者体验

- 智能家居设备:多语言语音控制

无障碍解决方案

- 屏幕阅读器:为视障用户增强无障碍访问

- 沟通辅助:为语言障碍人士恢复语音

- 语言学习:使用母语级声音进行发音练习

- 翻译服务:使用自然声音的实时多语言翻译

游戏和娱乐

- 角色声音:动态NPC对话生成

- 互动叙事:自适应叙事体验

- 虚拟影响者:跨平台的一致品牌声音

- 元宇宙应用:逼真的虚拟形象声音

Qwen3-TTS与竞品对比

全面对比表

| 功能 | Qwen3-TTS | GPT-4o Audio | ElevenLabs |

|---|---|---|---|

| 开源 | ✅ Apache 2.0 | ❌ 专有 | ❌ 专有 |

| 语言 | 10种主流语言 | 多语言 | 5000+种语言 |

| 音色 | 49+种声音 | 多种声音 | 5000+种声音 |

| 语音克隆 | 3秒快速克隆 | 可用 | 高质量克隆 |

| 首包延迟 | 97毫秒 | 低 | 不定 |

| WER性能 | 最先进 | 有竞争力 | 良好 |

| 定价 | 免费(自托管) | $0.015/分钟 | 高级定价 |

| 情感控制 | 自然语言指令 | 情感控制功能 | 无与伦比的深度 |

Qwen3-TTS的关键优势

1. 成本效益

- 开源模型消除许可费用

- 自托管选项实现完全成本控制

- API定价与商业替代方案具有竞争力

2. 多语言卓越性

- 跨多种语言的优异WER分数

- 竞品无法匹敌的广泛中文方言支持

- 多语言内容的自然代码切换

3. 定制自由度

- 完全模型访问权限用于微调

- 无限制的语音克隆

- 自定义应用的集成灵活性

4. 低延迟性能

- 实时应用的97毫秒首包延迟

- 交互式体验的流式生成

- 针对对话式AI用例优化

Qwen3-TTS常见问题解答

我可以商业使用Qwen3-TTS吗?

可以!Qwen3-TTS采用Apache 2.0许可证发布,允许商业使用。您可以在商业应用中使用它,无需许可费用。

1.7B和0.6B模型有什么区别?

1.7B模型提供峰值性能和质量,而0.6B模型更轻量级,适合资源受限的环境。根据您的硬件能力和质量要求选择。

我需要多少VRAM?

- 0.6B模型:最低4-6 GB VRAM

- 1.7B模型:最低6-8 GB VRAM

- 推荐:12+ GB以获得最优性能

我可以微调Qwen3-TTS吗?

可以!Qwen3-TTS的开源性质允许在自定义数据集上进行微调。这使您能够为特定用例或语言创建专门的模型。

总结

Qwen3-TTS代表了开源文本转语音技术的重要里程碑。凭借其卓越的多语言性能、广泛的音色选项、超低延迟和强大的语音克隆能力,它为专有解决方案提供了令人信服的替代方案。

该模型在Apache 2.0许可证下的开源性质使最先进的TTS技术民主化,使开发人员、研究人员和企业能够在没有许可限制的情况下构建创新的语音应用。

无论您是创建有声书、构建对话式AI还是开发无障碍解决方案,Qwen3-TTS都提供了成功所需的工具和灵活性。

资源和链接

-

官方博客:Qwen3-TTS发布公告

-

GitHub仓库:QwenLM/Qwen3-TTS

-

Hugging Face模型:Qwen/Qwen3-TTS-12Hz-1.7B-Base

-

文档:Qwen AI文档

-

社区:Qwen Discord 和 GitHub讨论 ## Link

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)