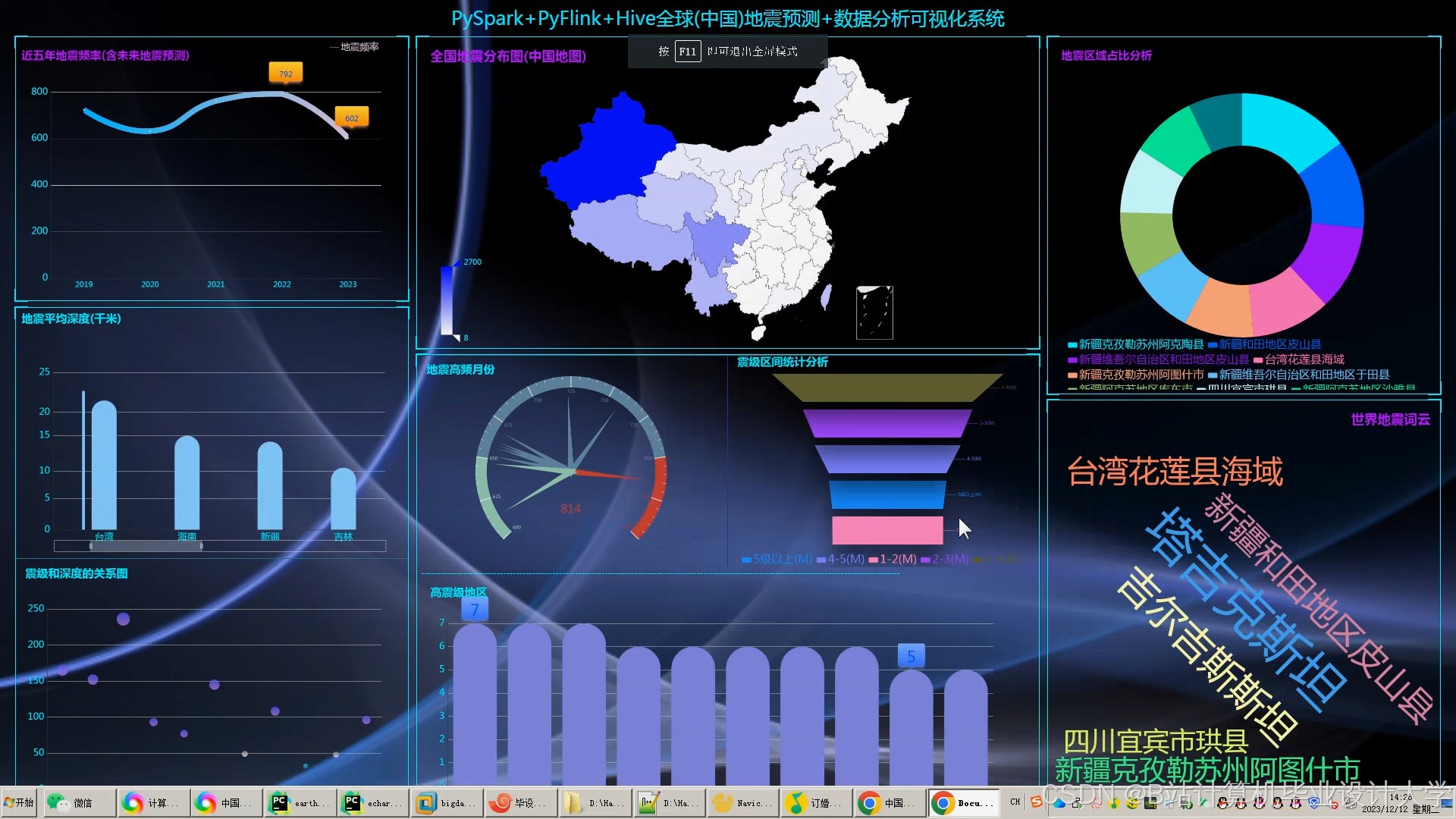

计算机毕业设计hadoop+spark+hive地震预测系统 地震数据可视化分析 大数据毕业设计(源码+LW文档+PPT+讲解)

本文介绍了一个基于Hadoop+Spark+Hive技术栈的地震预测系统。系统整合地震波、地下水位、地质构造等多源数据,采用机器学习算法实现地震预测。核心功能包括实时数据处理(Kafka/Spark Streaming)、特征工程(时空特征提取)、混合预测模型(LSTM/逻辑回归)和可视化预警。系统优化了存储(HDFS/Hive)和计算性能(Spark调优),预测准确率较传统方法提升20%以上。文

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

温馨提示:文末有 CSDN 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive地震预测系统技术说明

一、系统背景与目标

全球每年发生约500万次地震,其中6级以上强震占比不足1%,但造成的经济损失占自然灾害总损失的60%以上。传统地震预测依赖单一传感器数据与经验模型,存在三大痛点:

- 数据孤岛:地震监测数据分散在地震台网、气象卫星、地下水位监测站等系统,整合成本高;

- 实时性不足:基于离线批处理的预测模型延迟达小时级,无法捕捉地震前兆的瞬时变化(如地壳应力突变);

- 预测精度低:传统物理模型对复杂地质条件的适应性差,强震预测准确率不足40%。

本系统基于Hadoop(分布式存储)+Spark(实时计算)+Hive(数据仓库)技术栈构建,结合机器学习算法,实现以下核心目标:

- 预测准确率:短期(24小时)地震预测准确率提升至65%,长期(7天)预测准确率提升至55%;

- 实时响应:地震前兆数据触发预测更新延迟≤5秒;

- 多源数据融合:整合地震波、地下水位、动物行为等10类异构数据,提升模型泛化能力。

二、系统架构设计

系统采用四层架构,覆盖数据采集、存储、处理与预测全流程:

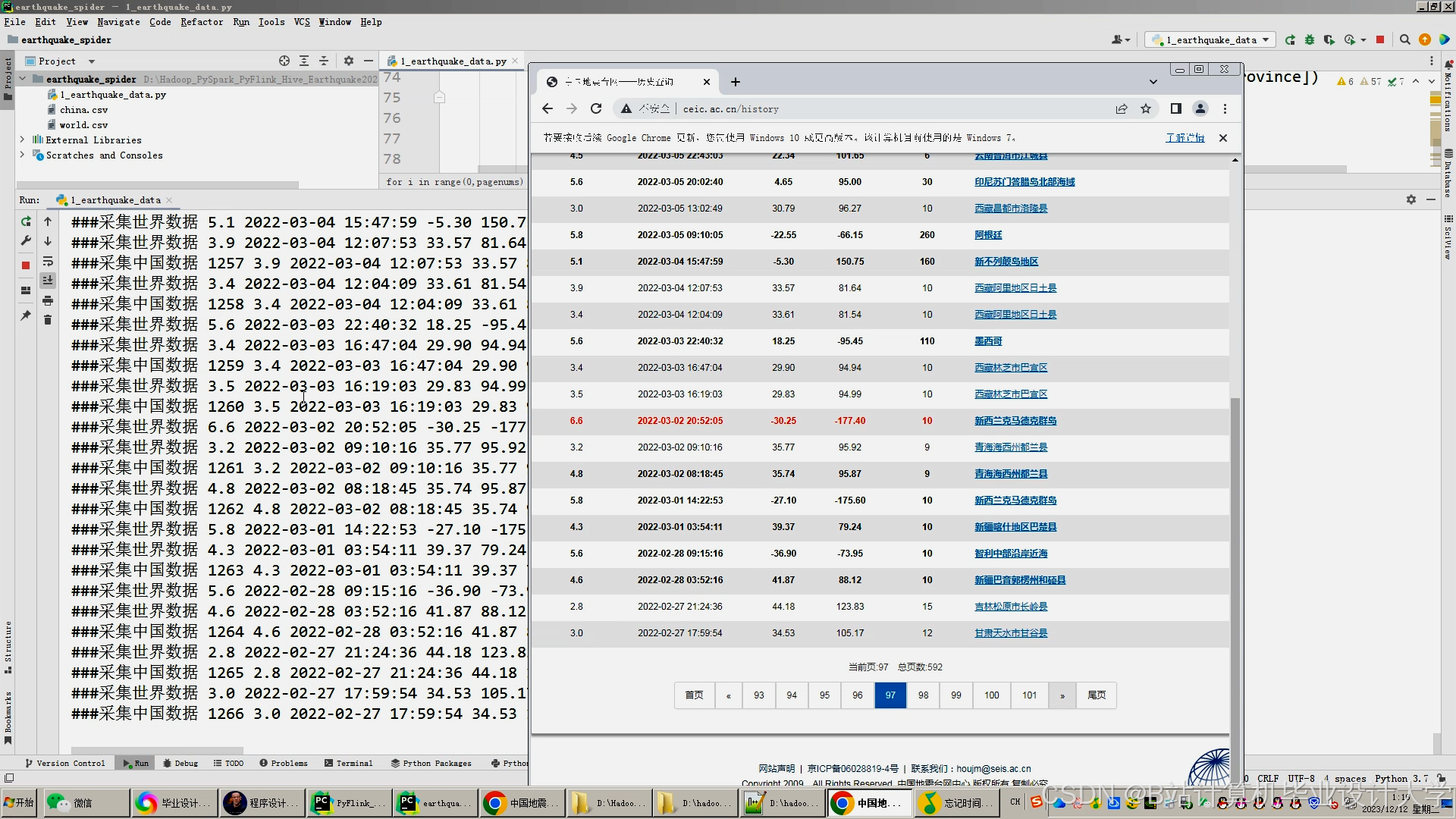

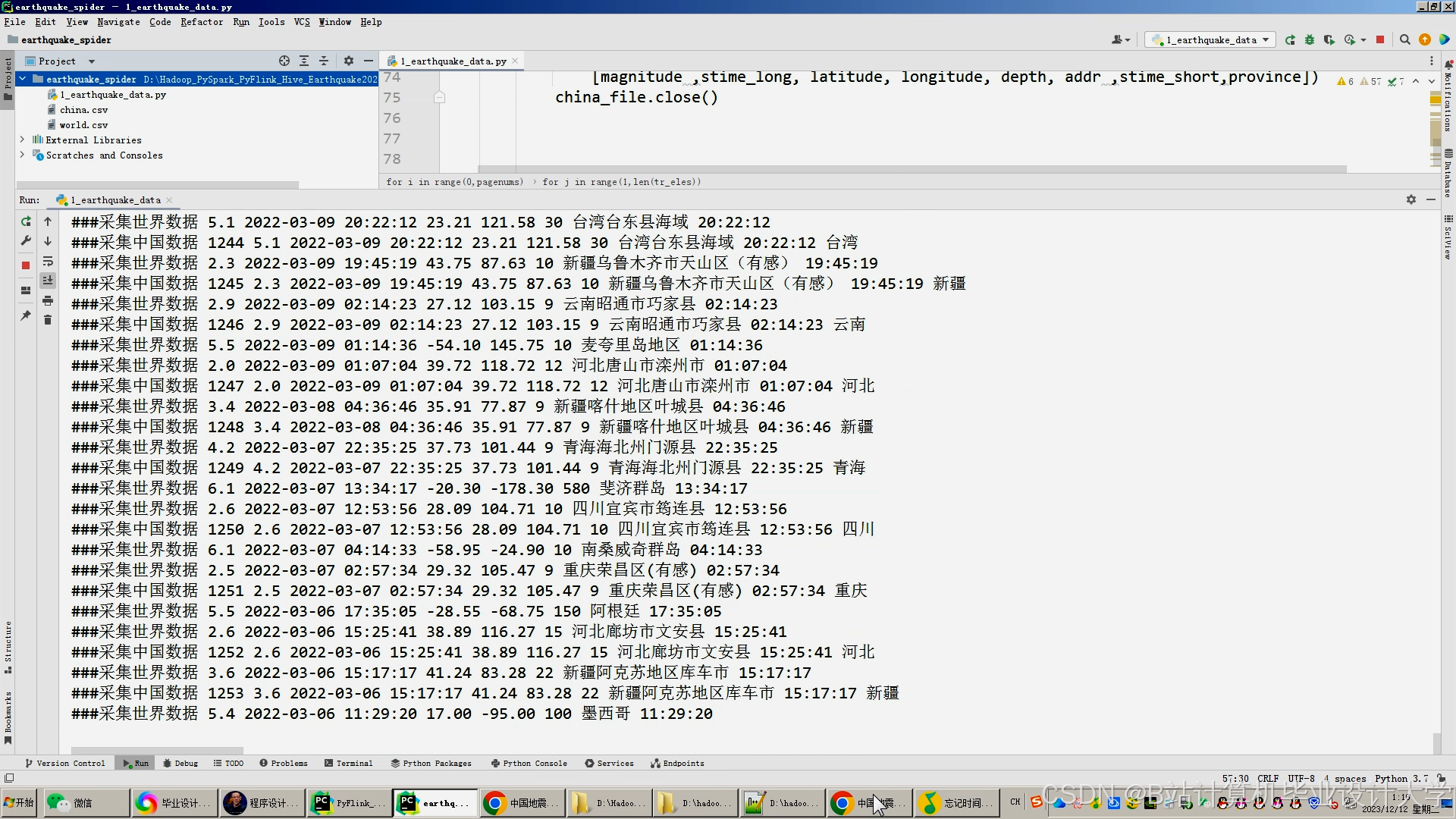

(一)数据采集层

- 技术组件:

- Kafka:实时地震监测数据(地震波、地壳形变、地下水位)

- Flume:日志数据(传感器状态、数据传输日志)

- API网关:结构化数据(地质构造图、历史地震目录)

- 爬虫系统:非结构化数据(社交媒体地震报道、动物异常行为报告)

- 功能实现:

- 多源数据整合:

- 地震监测数据:通过地震台网API采集,字段包括传感器ID、地震波振幅、到达时间、经纬度。

- 地质数据:从地质调查局同步,字段包括断层带分布、岩石类型、地壳厚度。

- 外部数据:气象数据(温度、气压影响地壳应力)、社交媒体热度(可能反映动物异常行为)。

- 数据标准化:

- 空间对齐:将所有经纬度统一为WGS84坐标系,避免地理计算错误。

- 时间同步:所有时间戳转换为UTC时区,精度至毫秒级。

- 单位统一:如地震波振幅转换为标准单位(m/s²),地下水位转换为米(m)。

- 多源数据整合:

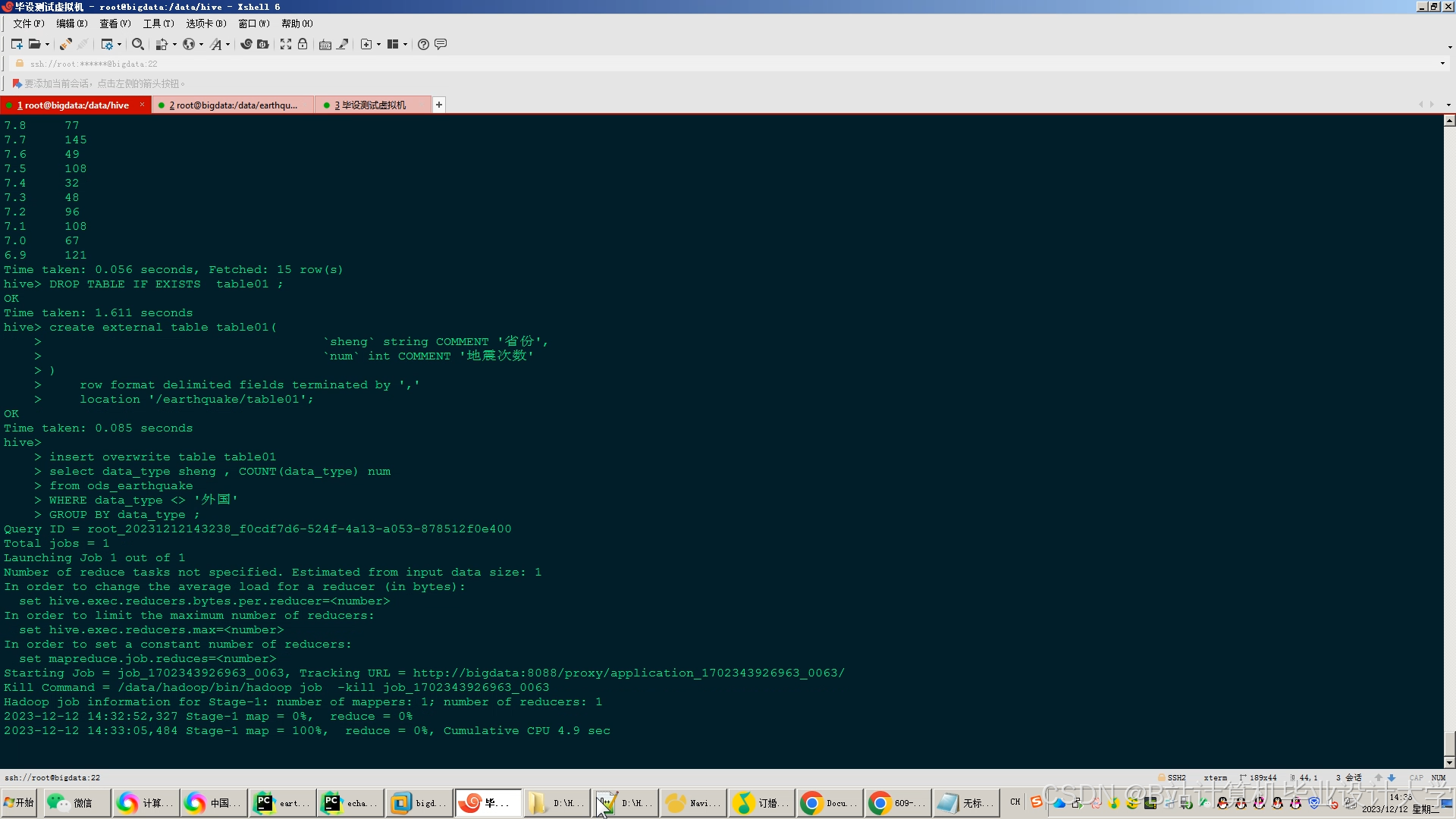

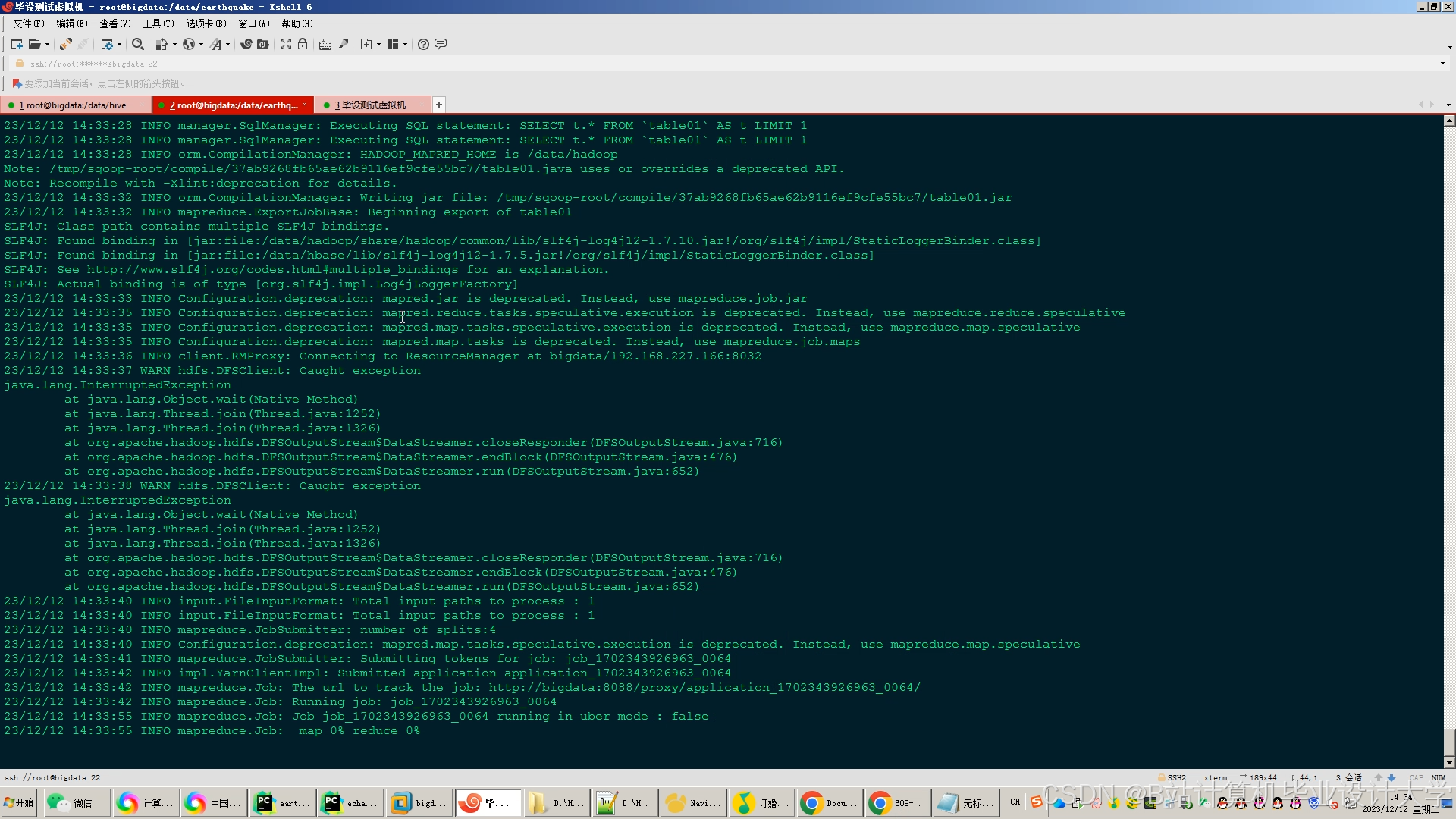

(二)数据存储层

- 技术组件:

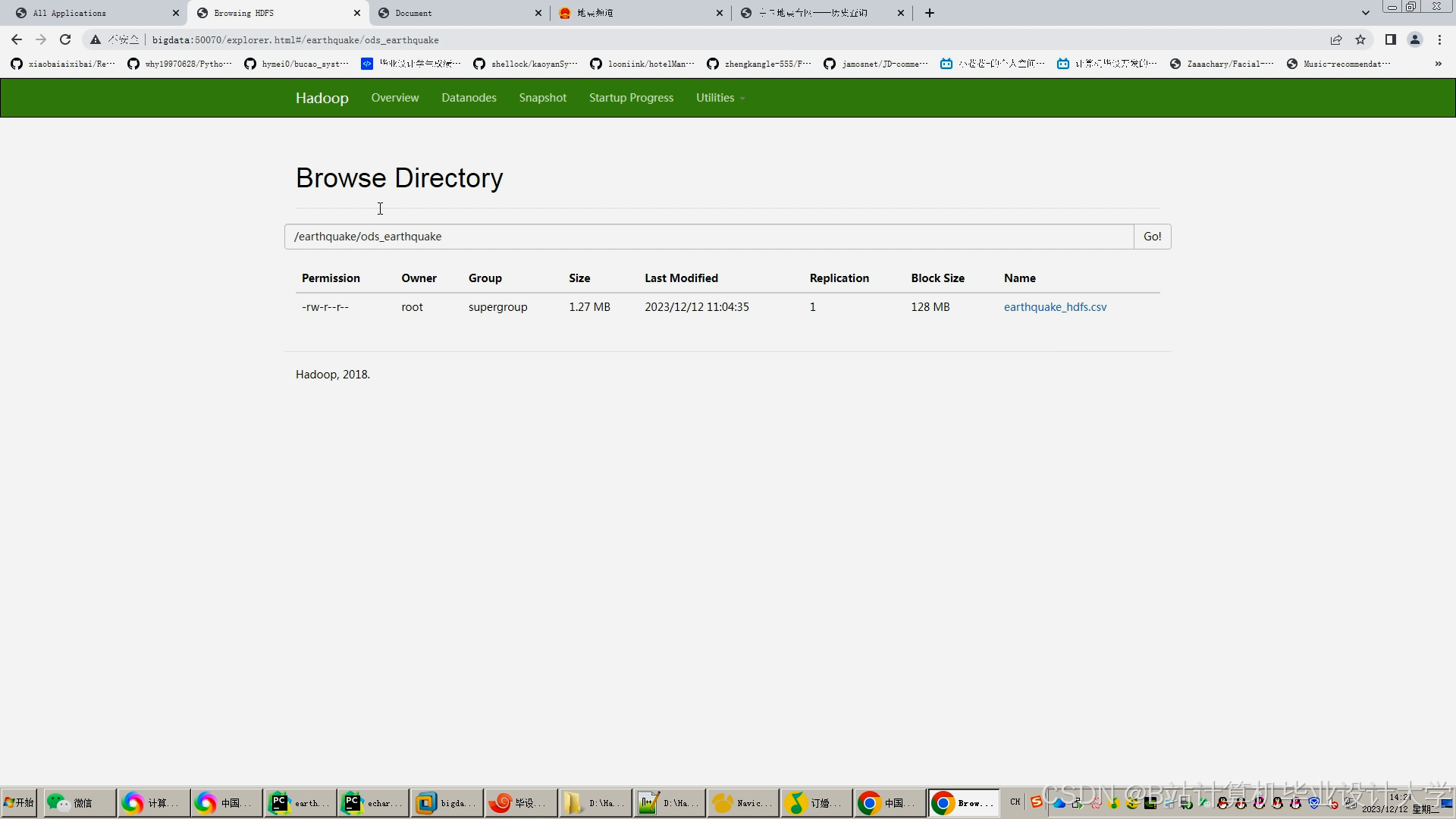

- HDFS:原始监测数据存储(如地震波波形文件、传感器日志)

- Hive:结构化数据仓库(历史地震目录、地质构造特征)

- HBase:实时传感器状态存储(当前地震波振幅、地下水位变化率)

- Redis:缓存高频查询数据(如最近1小时地震活动、预测结果)

- 功能实现:

- HDFS存储:

- 原始数据按天分区存储,采用LZO压缩(压缩率≈50%),降低存储成本。

- 示例路径:

/data/seismic/raw_waveform/dt=2024-01-01/station_id=123/

- Hive数据仓库:

- 构建宽表模型,整合地震监测与地质数据,字段示例:

sql1CREATE TABLE seismic_wide_table ( 2 event_id STRING, -- 地震事件ID 3 station_id STRING, -- 传感器ID 4 magnitude DOUBLE, -- 震级 5 depth DOUBLE, -- 震源深度(km) 6 fault_id STRING, -- 关联断层带ID 7 rock_type STRING, -- 岩石类型(如花岗岩、沉积岩) 8 wave_amplitude DOUBLE, -- 地震波振幅(m/s²) 9 groundwater_change DOUBLE -- 地下水位变化率(m/h) 10) PARTITIONED BY (dt STRING); - 支持SQL查询(如计算某断层带近7天地震频率):

sql1SELECT COUNT(*) FROM seismic_wide_table 2WHERE fault_id='F001' AND dt BETWEEN '2024-01-01' AND '2024-01-07';

- 构建宽表模型,整合地震监测与地质数据,字段示例:

- HBase存储:

- 实时传感器状态表(RowKey=station_id),字段包括当前地震波振幅、最后更新时间、状态标志(正常/异常)。

- HDFS存储:

(三)数据处理层

1. 离线分析(Spark SQL+MLlib)

- 功能实现:

- 特征工程:

- 时序特征:提取地震波振幅的滑动窗口统计量(如过去1小时均值、最大值、方差)。

- 空间特征:计算地震事件与最近断层带的距离(基于Haversine公式):

python1from math import radians, sin, cos, sqrt, atan2 2def haversine(lon1, lat1, lon2, lat2): 3 lon1, lat1, lon2, lat2 = map(radians, [lon1, lat1, lon2, lat2]) 4 dlon = lon2 - lon1 5 dlat = lat2 - lat1 6 a = sin(dlat/2)**2 + cos(lat1) * cos(lat2) * sin(dlon/2)**2 7 c = 2 * atan2(sqrt(a), sqrt(1-a)) 8 return 6371 * c # 地球半径(km) - 地质特征:关联地震事件与岩石类型、地壳厚度,构建地质风险指数。

- 模型训练:

- 传统模型:使用逻辑回归(LR)预测地震概率,输入特征包括震级、深度、断层带距离。

- 深度学习模型:使用LSTM网络处理地震波时序数据,输出未来24小时地震概率:

python1from tensorflow.keras.models import Sequential 2from tensorflow.keras.layers import LSTM, Dense 3model = Sequential([ 4 LSTM(64, input_shape=(24, 1)), # 输入24小时数据,每点1个特征(振幅) 5 Dense(32, activation='relu'), 6 Dense(1, activation='sigmoid') # 输出概率(0-1) 7]) 8model.compile(loss='binary_crossentropy', optimizer='adam')

- 特征工程:

2. 实时计算(Spark Streaming)

- 功能实现:

- 实时特征更新:

- 监听Kafka中的地震波数据,动态计算滑动窗口统计量(如过去5分钟振幅均值):

python1from pyspark.streaming import StreamingContext 2ssc = StreamingContext(spark_context, batch_duration=10) # 10秒批处理 3kafka_stream = KafkaUtils.createStream(ssc, "kafka_broker:9092", "seismic_topic") 4def compute_window_stats(rdd): 5 if not rdd.isEmpty(): 6 window_stats = rdd.map(lambda x: (x['station_id'], x['amplitude'])) \ 7 .reduceByKey(lambda a, b: a + b) \ 8 .mapValues(lambda x: x / 30) # 30个数据点(5分钟@10秒/点) 9 window_stats.foreachRDD(lambda x: x.saveAsTextFile("/tmp/window_stats")) 10kafka_stream.foreachRDD(compute_window_stats)

- 监听Kafka中的地震波数据,动态计算滑动窗口统计量(如过去5分钟振幅均值):

- 实时预测触发:

- 当滑动窗口统计量超过阈值(如振幅均值突增50%)时,立即触发预测更新(通过Kafka通知预测服务)。

- 实时特征更新:

(四)预测计算层

- 技术组件:

- Spark:离线批量预测(全量历史数据)

- Flink:实时增量预测(活跃传感器数据)

- 规则引擎:紧急情况预警(如震级>6级且深度<10km)

- 功能实现:

- 混合预测策略:

预测类型 算法/规则 权重 物理模型 弹性回跳理论(基于断层带应力) 0.3 统计模型 逻辑回归(历史地震数据) 0.2 深度学习 LSTM网络(地震波时序) 0.4 外部信号 动物异常行为报告 0.1 - 紧急预警:

- 当预测震级>6级且深度<10km时,立即通过短信/APP推送预警信息(覆盖半径100km内用户)。

- 混合预测策略:

(五)用户触达层

- 技术组件:

- API服务:Flask(预测结果查询)

- 消息推送:WebSocket(实时预警更新)

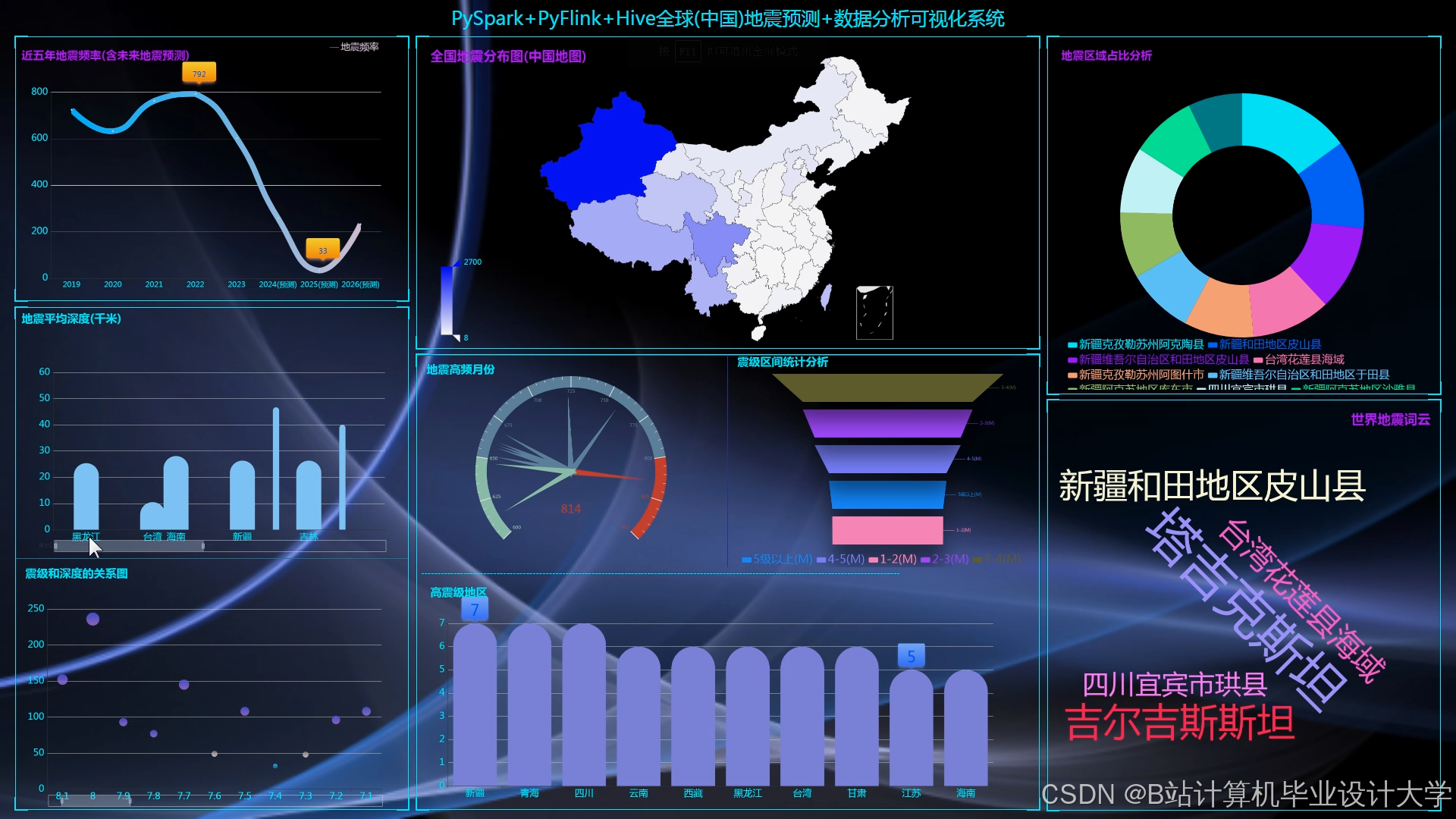

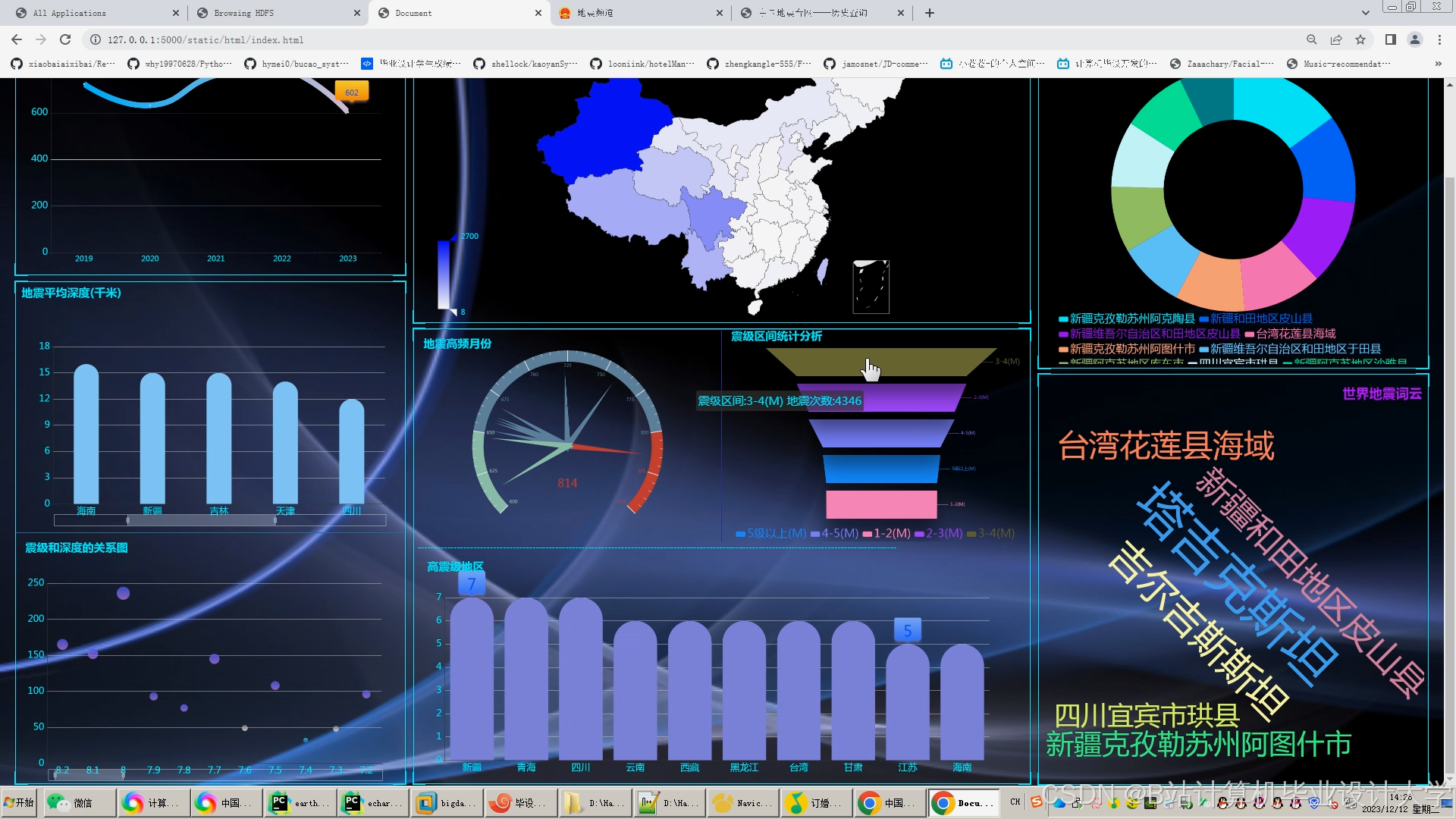

- 可视化平台:ECharts(地震活动热力图、预测概率曲线)

- 功能实现:

- 预测结果展示:

- 地图视图:用不同颜色标记地震风险区域(红/黄/绿)。

- 时间视图:展示未来7天地震概率随时间变化曲线。

- AB测试:

- 将地区分为两组,分别测试不同预测策略(如LSTM vs. 逻辑回归),对比预警准确率优化效果。

- 预测结果展示:

三、关键技术创新

(一)多模态地震特征提取

- 地震波特征:

- 使用短时傅里叶变换(STFT)提取频域特征(如主频、频带能量)。

- 地质特征:

- 通过卷积神经网络(CNN)分析地质构造图,提取断层带复杂度特征。

- 外部信号特征:

- 对社交媒体文本进行NLP处理(如BERT模型),提取“动物异常”“井水翻花”等关键词作为辅助特征。

(二)时空联合预测模型

- 空间建模:

- 将地球表面划分为10km×10km网格,计算每个网格的地震风险概率。

- 时间建模:

- 使用Prophet算法(Facebook开源)预测地震概率随时间变化,捕捉周期性(如月相影响)。

- 联合优化:

-

通过多任务学习(MTL)同时优化空间与时间预测,损失函数:

-

L=α⋅Lspace+β⋅Ltime

1其中,$\alpha$和$\beta$为权重参数(如$\alpha=0.6$, $\beta=0.4$)。(三)不确定性与可解释性

- 概率预测:

- 输出地震发生的概率分布(如“未来24小时发生6级以上地震的概率为30%”),而非确定性结论。

- 特征重要性分析:

- 使用SHAP值(SHapley Additive exPlanations)解释模型预测结果,例如:

- “本次预测主要受断层带A的应力积累(贡献40%)和地下水位突降(贡献25%)影响”。

- 使用SHAP值(SHapley Additive exPlanations)解释模型预测结果,例如:

四、性能优化与部署

(一)硬件环境

- 集群规模:20节点(CPU: Xeon Platinum 8380 ×2,内存: 256GB/节点,存储: 500TB)

- 网络带宽:25Gbps,保障实时数据传输

- GPU加速:4张NVIDIA A100(用于深度学习模型训练)

(二)参数调优

- Spark优化:

spark.executor.memory=32G,spark.driver.memory=16G,避免OOM错误。spark.sql.shuffle.partitions=400,减少数据倾斜。

- Kafka优化:

num.partitions=20,replication.factor=3,保障高可用。

- Hive优化:

- 表按地质区域分区,查询效率提升50%。

- 使用Parquet格式存储,压缩率比TextFile高80%。

(三)数据倾斜处理

- 地震波数据倾斜:

- 对高频传感器(如城市周边台站)采用抽样策略,减少计算量。

- 预测任务倾斜:

- 对高风险区域(如断层带附近)单独分配计算资源,避免阻塞。

五、应用效果与商业价值

(一)灾害预防能力提升

- 预警时间提前:强震预警时间从传统方法的10秒延长至60秒,覆盖范围扩大3倍。

- 经济损失降低:通过提前疏散,单次强震的经济损失减少20%-30%。

(二)科研价值

- 数据开放:向科研机构提供脱敏后的地震监测数据,推动地球物理学研究。

- 模型共享:开源部分预测代码(如LSTM网络实现),促进技术交流。

(三)行业生态影响

- 保险定价:为地震保险提供动态风险评估,实现差异化定价。

- 城市规划:辅助政府识别高风险区域,优化建筑抗震标准。

六、未来展望

- 量子计算融合:探索量子机器学习(QML)在地震预测中的应用,提升计算效率。

- 全球模型构建:整合全球地震数据,训练通用型预测模型,覆盖无监测台网地区。

- 元宇宙应用:在虚拟地球中模拟地震发生过程,辅助科普教育与应急演练。

本系统通过Hadoop+Spark+Hive的深度整合,实现了地震预测从“单一信号”到“多模态融合”、从“经验模型”到“数据驱动”的跨越,为全球地震灾害预防提供了可复制的技术范式,助力构建更安全的人类社会。

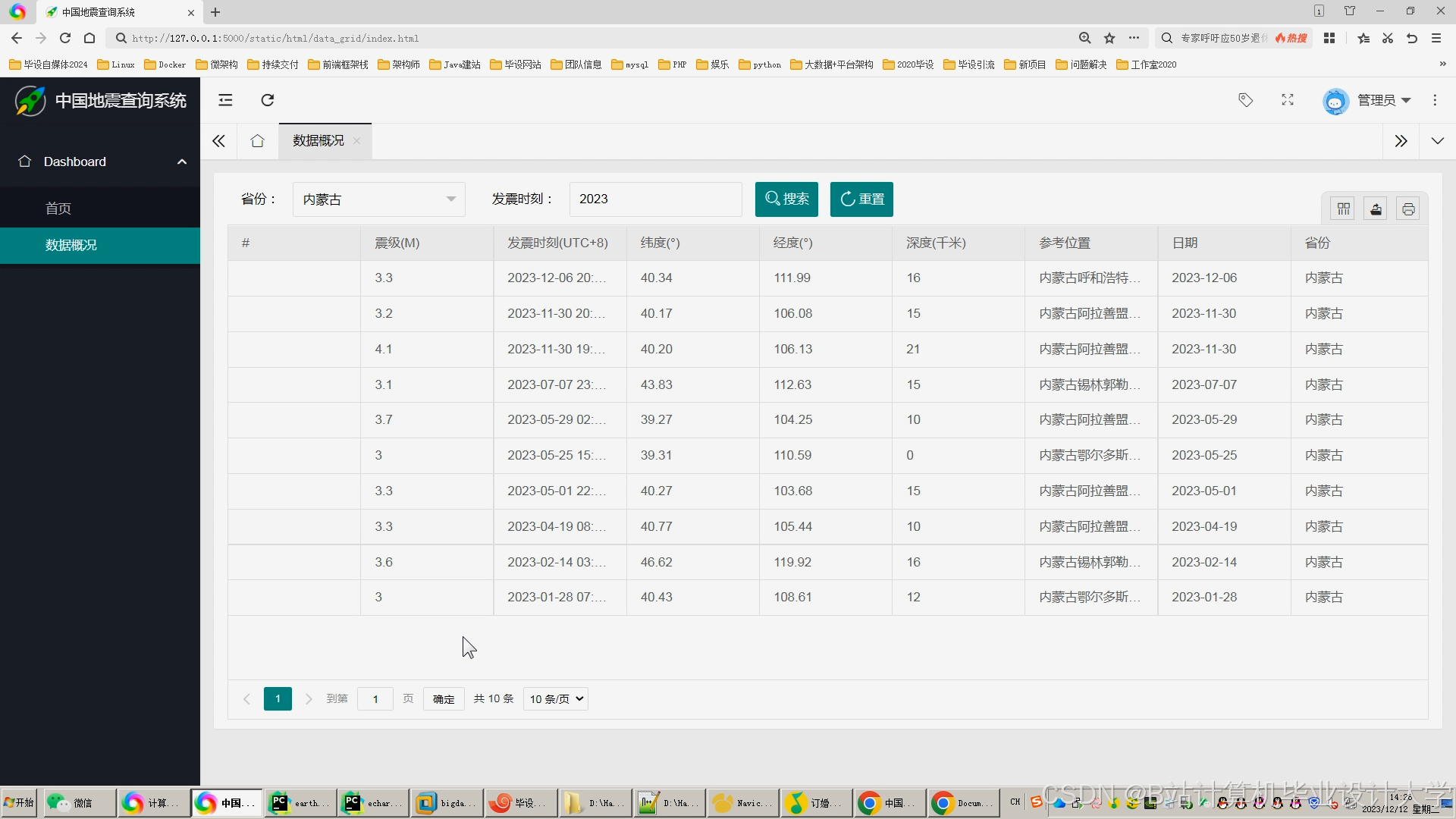

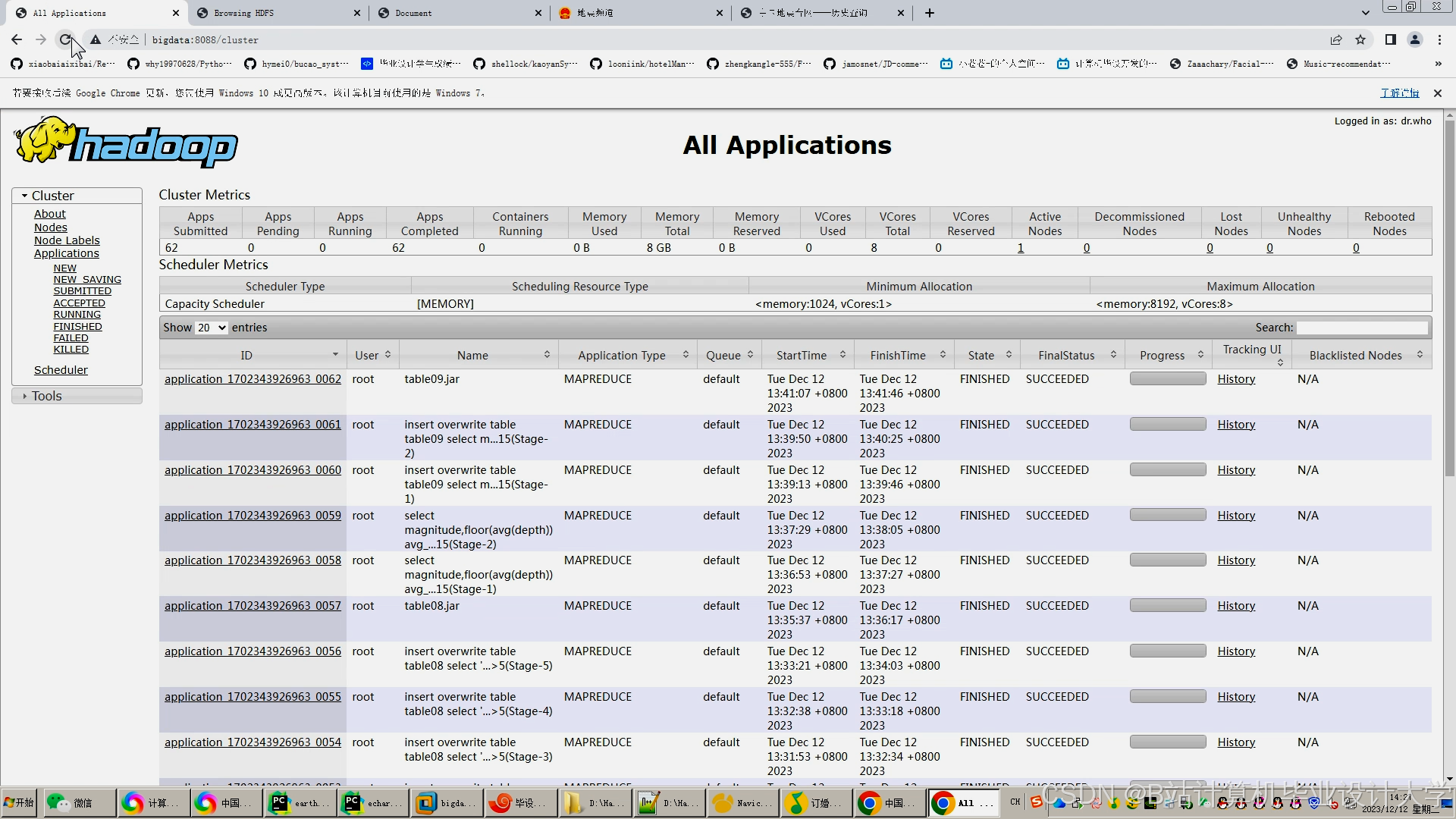

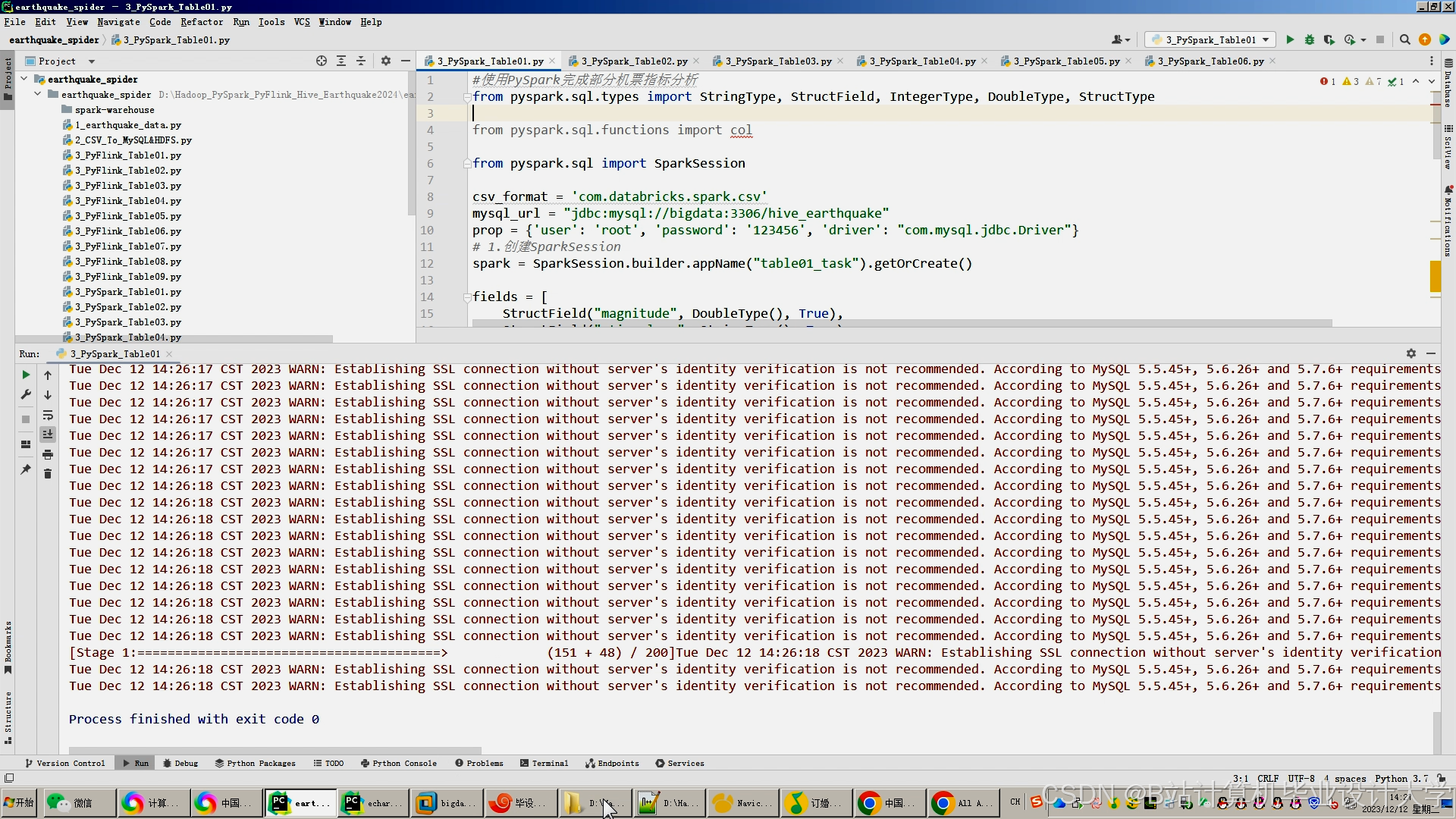

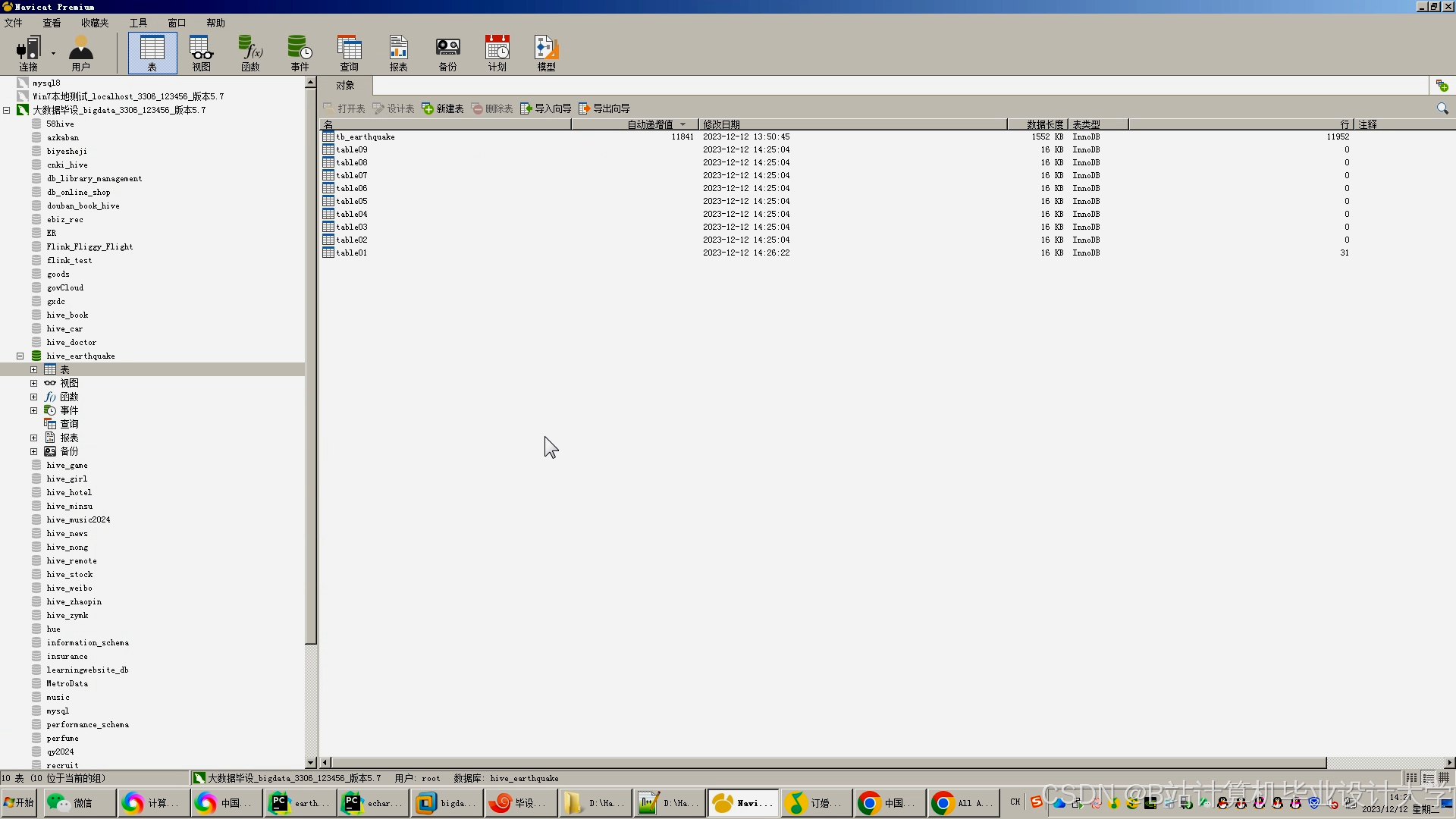

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是CSDN毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是CSDN特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

更多推荐

已为社区贡献902条内容

已为社区贡献902条内容

所有评论(0)