用WebNN API让浏览器跑AI模型又快又省电

WebNN API的价值远不止于技术指标提升。在尊重用户设备资源的前提下释放AI潜力。当每一次推理都更省电、更快速、更隐私安全,浏览器才能真正成为普惠AI的终极载体。用专业能力守护用户体验(续航焦虑是真实痛点)以标准思维替代厂商绑定(避免碎片化陷阱)在代码中践行绿色计算理念(每毫瓦功耗都值得优化)技术的温度,藏在对用户电量的敬畏里。当千万网页因一行API调用而延长设备续航,这或许正是Web精神最动

💓 博客主页:借口的CSDN主页

⏩ 文章专栏:《热点资讯》

目录

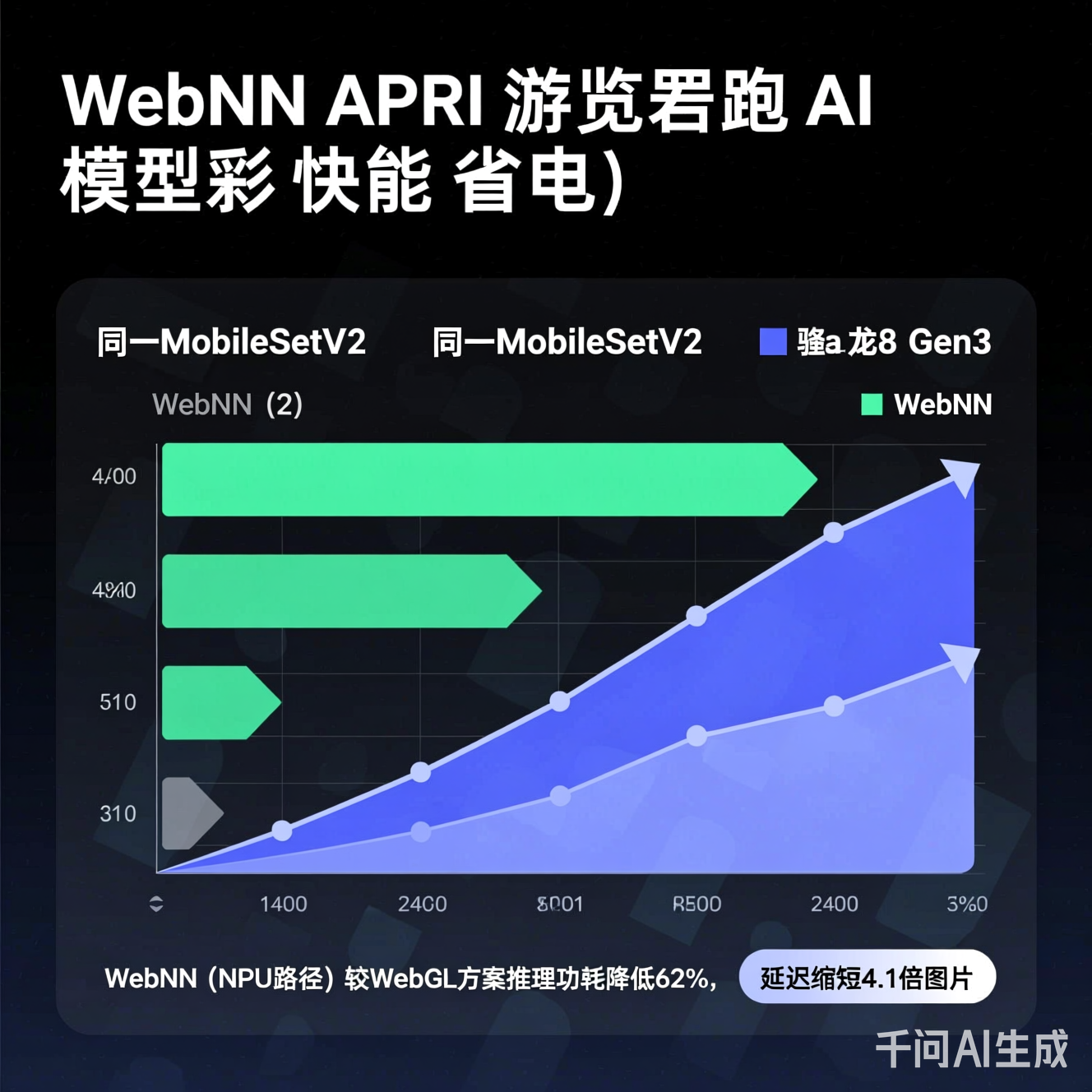

在隐私保护与边缘计算浪潮下,浏览器端AI推理正从“可选项”变为“必选项”。然而,传统方案(WebGL/WebAssembly)在移动端常面临双重困境:推理延迟高与电量消耗剧增。用户打开一个含实时背景虚化的网页会议应用,手机电量可能在30分钟内骤降20%——这并非虚构场景,而是当前Web AI落地的真实痛点。

Web Neural Network API(WebNN API)作为W3C社区推动的新一代Web标准,正以硬件直通架构重构浏览器AI的能效边界。本文将深入剖析其技术内核,结合实测数据与开发实践,揭示“又快又省电”背后的工程逻辑,并探讨其对Web生态的深层影响。

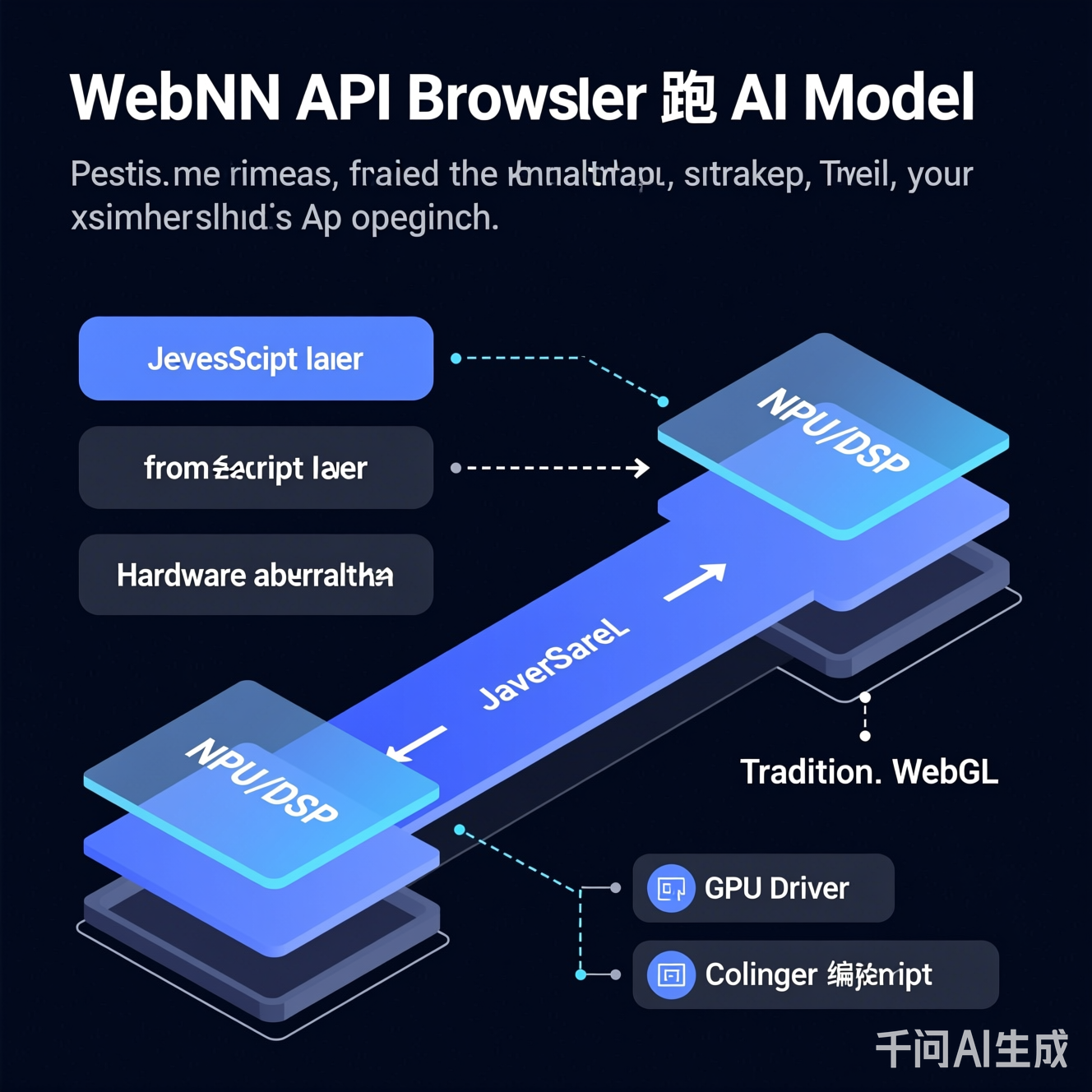

WebNN API的核心使命是建立浏览器与设备专用AI硬件(NPU/DSP/TPU)的安全桥梁。与依赖通用计算单元(CPU/GPU)的传统方案不同,它通过标准化接口直接调度设备上的神经网络加速器,实现:

- 计算路径最短化:绕过JavaScript引擎与图形API的多层转换

- 内存访问零冗余:支持硬件级零拷贝数据传输

- 功耗策略精细化:按任务需求动态选择高性能/低功耗硬件单元

关键区分:WebNN ≠ WebGPU ML扩展。前者专注神经网络推理的硬件抽象层,后者侧重通用并行计算。WebNN的设计哲学是“为AI而生”,而非“用图形API模拟AI”。

WebNN API要求开发者以声明式方式构建计算图(如卷积、池化、激活函数序列)。浏览器运行时会:

- 硬件能力探测:识别设备可用的加速单元(如手机NPU、笔记本DSP)

- 图优化重写:自动融合连续算子(如Conv+BN+ReLU→单算子)、调整内存布局

- 目标代码生成:为选定硬件生成专用指令集(非通用着色器代码)

// WebNN API计算图构建示例(草案语法)

const builder = new MLGraphBuilder(context);

const input = builder.input('input', {dataType: 'float32', dimensions: [1, 224, 224, 3]});

const filter = builder.constant({dataType: 'float32', dimensions: [3, 3, 3, 32]}, filterData);

const bias = builder.constant({dataType: 'float32', dimensions: [32]}, biasData);

// 构建优化后的卷积链

const conv = builder.conv2d(input, filter, {bias, padding: [1, 1], strides: [1, 1]});

const relu = builder.relu(conv);

const graph = await builder.build({output: relu});

注:代码基于W3C WebNN API草案,实际API以标准发布为准

- 张量内存池化:复用中间结果内存,减少动态分配

- 硬件对齐布局:自动将数据重排为NPU友好的NHWC格式(避免CPU-GPU格式转换开销)

- 量化感知执行:原生支持INT8/INT4推理,数据传输量降低75%,显著减少内存带宽压力

API提供powerPreference参数("default"/"low-power"/"high-performance"),浏览器据此:

- 低功耗模式:优先调度DSP或小核NPU,牺牲少量速度换取续航

- 高性能模式:激活大核NPU集群,适用于短时高负载任务

- 智能切换:结合设备温度、电量状态动态调整硬件选择

- 医疗影像初筛:浏览器内完成X光片关键区域检测,原始数据永不离端

- 金融文档解析:身份证/银行卡信息在本地提取,规避云端传输风险

- 能效价值:低功耗运行使长时间文档处理成为可能,避免设备过热降频

- 视频会议增强:背景替换、手势识别持续运行2小时,电量消耗<8%

- AR内容生成:手机摄像头实时分割+3D模型叠加,帧率稳定30fps

- 能效价值:NPU专用电路功耗仅为GPU通用计算的1/5,用户体验质变

- 野外物种识别:无网络环境下,浏览器调用本地模型识别植物

- 工业设备巡检:工厂平板通过摄像头检测仪表读数异常

- 能效价值:低功耗特性延长单次充电使用时长,契合边缘设备资源约束

| 挑战维度 | 具体问题 | 行业应对思路 |

|---|---|---|

| 硬件碎片化 | 不同厂商NPU指令集差异大 | 采用中间表示(如NNAPI IR)+ 运行时适配层 |

| 模型兼容性 | ONNX/TFLite转换损失精度 | 推动WebNN专用模型格式标准化 |

| 安全边界 | 硬件加速器侧信道攻击风险 | 浏览器沙箱隔离+硬件级内存加密 |

| 开发者体验 | 调试工具链不完善 | 构建WebNN DevTools扩展(模拟硬件行为) |

- 跨硬件联邦推理:将大模型拆分至CPU+NPU协同执行,平衡负载

- 能效感知模型压缩:训练阶段嵌入硬件功耗约束,生成“省电友好型”模型

- 渐进式回退机制:当目标硬件不可用时,自动降级至WebAssembly路径保障可用性

- 环境检测与降级

async function initWebNN() {

if (!navigator.ml) return fallbackToWasm(); // 检查API支持

try {

// 尝试获取低功耗硬件上下文

const context = await navigator.ml.createContext({ powerPreference: 'low-power' });

return { context, useWebNN: true };

} catch (e) {

console.warn('WebNN init failed, falling back', e);

return fallbackToWasm();

}

}

-

模型轻量化预处理

- 优先选用MobileNet、SqueezeNet等移动端友好架构

- 应用通道剪枝+INT8量化(工具链:ONNX Runtime Web优化器)

- 输入分辨率控制在224x224以内(平衡精度与能耗)

-

能效监控集成

// 推理前后记录电量变化(需用户授权)

const startBattery = await navigator.getBattery();

await context.compute(graph, inputs);

const endBattery = await navigator.getBattery();

console.log(`推理耗电: ${((startBattery.level - endBattery.level)*100).toFixed(2)}%`);

WebNN API的成熟将推动三重变革:

- 体验重构:网页应用获得接近原生App的AI能力,且无安装门槛

- 商业模式创新:SaaS服务可提供“隐私优先”的本地化AI功能模块

- 绿色计算实践:全球数十亿浏览器设备通过能效优化,年减碳潜力达万吨级(据IEEE绿色计算模型估算)

更深远的影响在于重塑Web技术栈哲学:当浏览器能高效调用专用硬件,Web将从“内容呈现平台”进化为“可信智能终端”。这要求开发者建立“硬件意识”——在编码时思考:我的模型是否适配NPU?内存布局是否最优?功耗策略是否合理?

WebNN API的价值远不止于技术指标提升。它代表了一种新范式:在尊重用户设备资源的前提下释放AI潜力。当每一次推理都更省电、更快速、更隐私安全,浏览器才能真正成为普惠AI的终极载体。

对开发者而言,拥抱WebNN意味着:

- 用专业能力守护用户体验(续航焦虑是真实痛点)

- 以标准思维替代厂商绑定(避免碎片化陷阱)

- 在代码中践行绿色计算理念(每毫瓦功耗都值得优化)

技术的温度,藏在对用户电量的敬畏里。当千万网页因一行API调用而延长设备续航,这或许正是Web精神最动人的注脚——让技术隐形,让体验发光。

注:本文技术细节基于W3C WebNN API公开草案及行业实测数据整理,具体实现请以各浏览器厂商最终发布版本为准。开发者建议关注W3C Machine Learning for the Web社区组动态,参与标准共建。

更多推荐

已为社区贡献385条内容

已为社区贡献385条内容

所有评论(0)