深入解析 Rust + LLM 开发:手把手教你写一个 AI 运维助手

本文详细阐述了利用 Rust 系统级编程语言结合蓝耘(Lanyun)MAAS 平台的大语言模型能力,开发一款智能命令行助手(CLI)的全过程。文章从 Linux 服务器的基础环境构建入手,深入剖析了 Rust 异步运行时、HTTP 客户端封装、命令行参数解析及终端交互界面的实现原理。特别针对开发过程中涉及的 OpenSSL 动态链接库依赖问题、Rust 类型系统的 Trait 约束问题进行了深度排

目录

摘要

本文详细阐述了利用 Rust 系统级编程语言结合蓝耘(Lanyun)MAAS 平台的大语言模型能力,开发一款智能命令行助手(CLI)的全过程。文章从 Linux 服务器的基础环境构建入手,深入剖析了 Rust 异步运行时、HTTP 客户端封装、命令行参数解析及终端交互界面的实现原理。特别针对开发过程中涉及的 OpenSSL 动态链接库依赖问题、Rust 类型系统的 Trait 约束问题进行了深度排查与原理解析。通过本项目,旨在展示如何将自然语言处理(NLP)能力引入传统 Shell 环境,实现自然语言到 Shell 命令的智能化转换与执行。

第一章:Linux 环境下的 Rust 开发生态构建

在 Debian/Ubuntu 等 Linux 发行版上进行 Rust 开发,首要任务是构建一个稳健的编译链环境。Rust 虽然拥有独立的包管理器 Cargo,但其底层链接及部分 crate(Rust 包)的编译仍深度依赖系统的 C 语言构建工具。

1.1 构建工具链与系统依赖安装

Rust 编译器 rustc 在编译最终二进制文件时,需要调用链接器(Linker)将各个编译单元组合起来。对于涉及网络通信的项目,OpenSSL 是不可或缺的基础组件,而 Rust 的 openssl crate 通常通过 FFI(外部函数接口)调用系统的 OpenSSL 库,因此必须预先安装 C 语言构建环境及相关头文件。

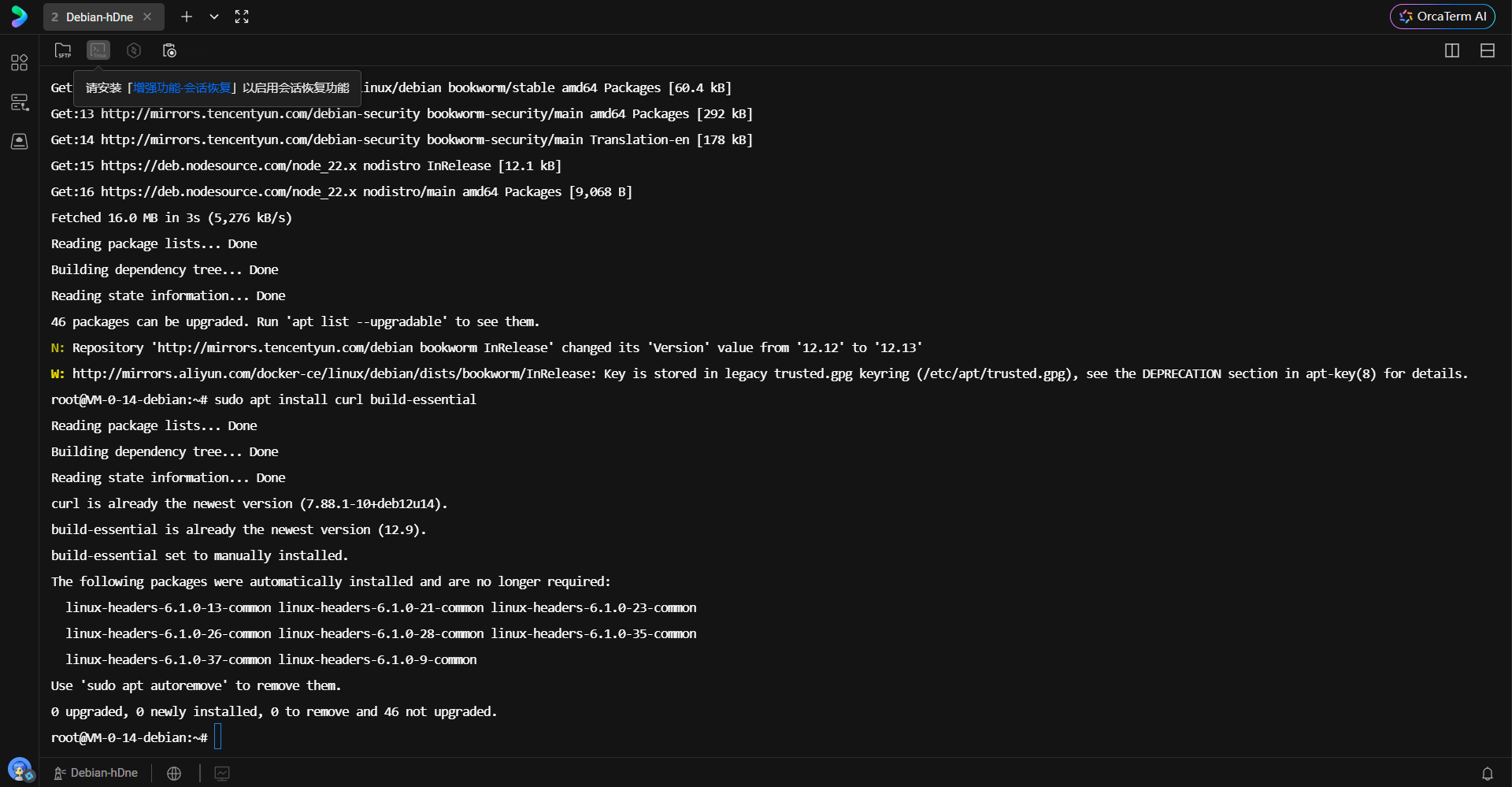

在终端执行以下指令,安装 curl 用于下载安装脚本,安装 build-essential 以获取 GCC、Make 及 libc 开发库。

sudo apt update

sudo apt install curl build-essential

build-essential 宏包是 Linux 开发环境的核心,它确保了系统具备编译 C/C++ 代码的能力,这是 Rust 与系统底层交互的基石。

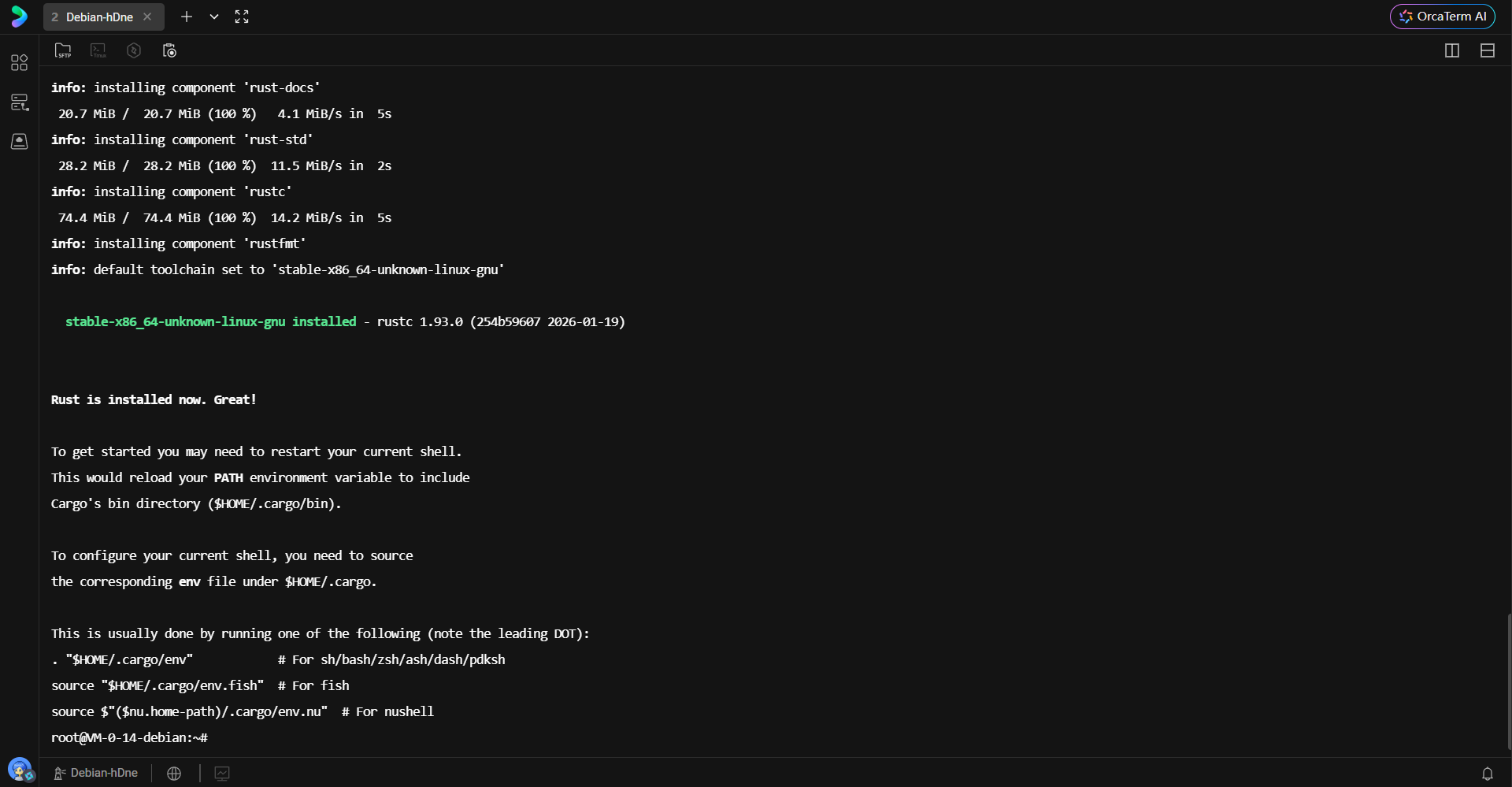

1.2 Rust 工具链(Toolchain)的部署

Rust 官方提供了 rustup 作为版本管理和安装工具。该脚本会自动检测当前系统的 CPU 架构(如 x86_64)和操作系统类型,下载对应的预编译二进制文件。

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

此过程包含三个核心组件的安装:

- rustc:Rust 编译器,负责将

.rs源码编译为机器码。 - cargo:Rust 的包管理器和构建工具,负责依赖管理、构建流程及测试。

- rustup:管理上述工具的版本更新及不同工具链(stable, beta, nightly)的切换。

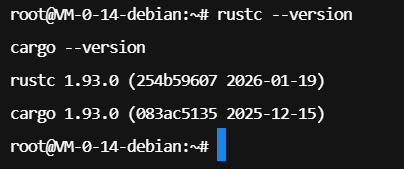

1.3 环境变量配置与验证

安装脚本会将 Rust 的二进制目录 $HOME/.cargo/bin 写入 shell 的配置文件。为使更改立即生效,需重新加载环境变量。

. "$HOME/.cargo/env"

通过验证 rustc 和 cargo 的版本号,确认编译器已正确集成至 PATH 环境变量中。

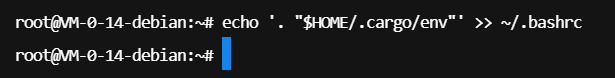

为确保每次登录服务器时环境自动加载,将加载脚本追加至 .bashrc 文件中是标准化的运维操作。

echo '. "$HOME/.cargo/env"' >> ~/.bashrc

第二章:蓝耘 MAAS 平台接入与资源配置

本项目核心智能逻辑依赖于大语言模型(LLM)。蓝耘平台提供了兼容 OpenAI 接口规范的 MAAS(Model as a Service)服务,使得集成过程高度标准化。

https://console.lanyun.net/#/register?promoterCode=0131

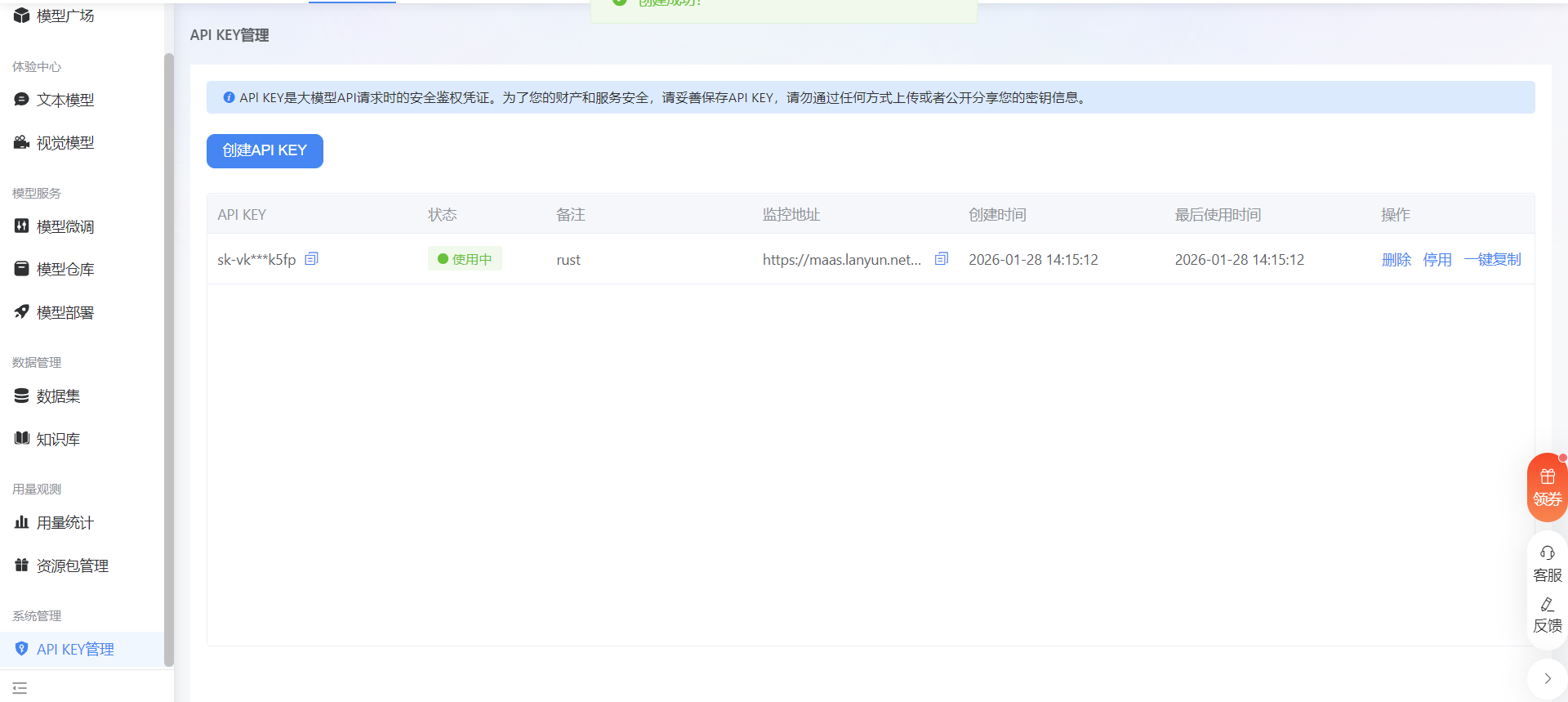

2.1 获取 API 凭证

在蓝耘控制台申请 API Key,这是进行身份验证和计量计费的唯一凭证。

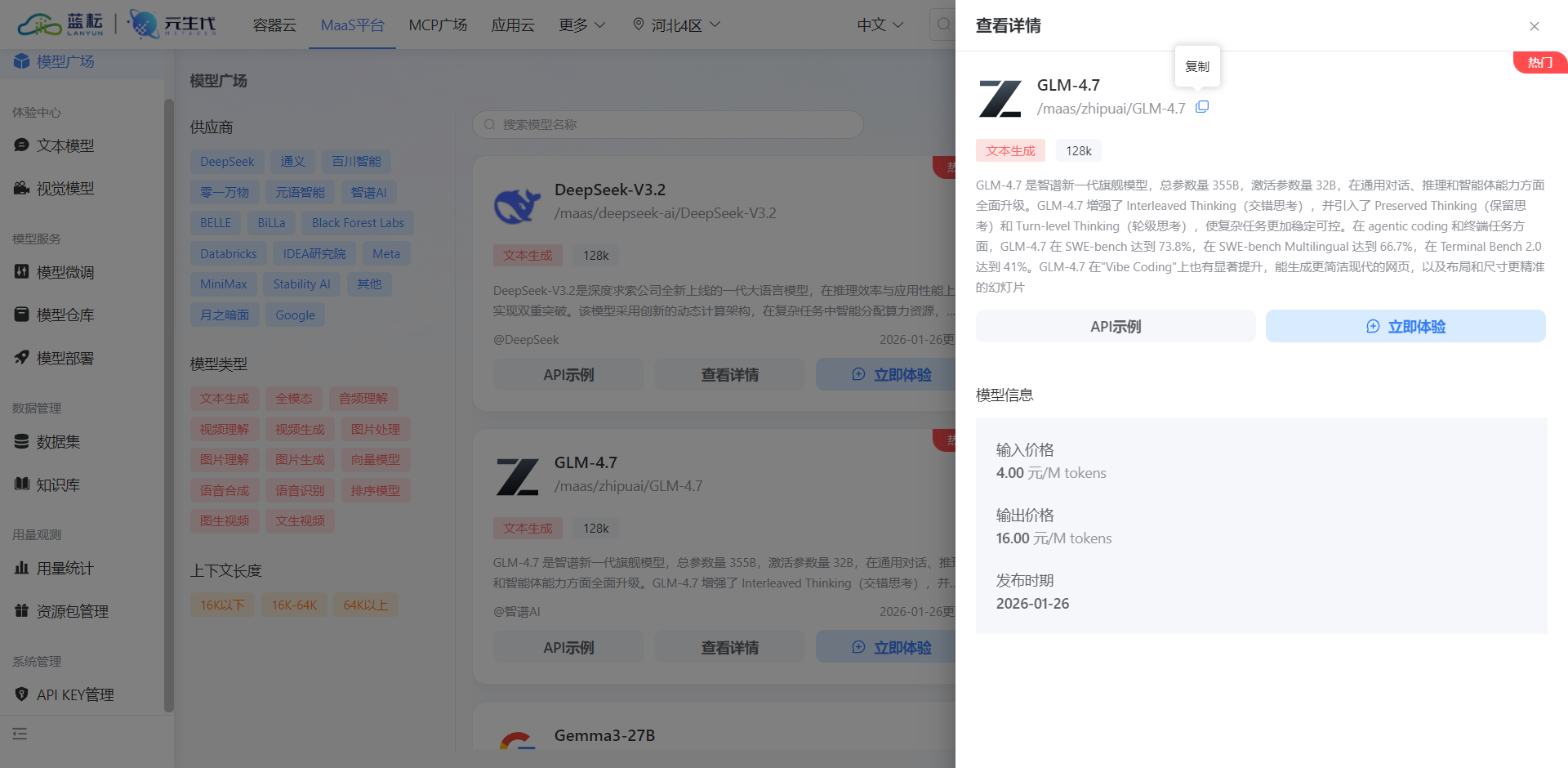

2.2 模型选型与端点配置

在模型广场选择 GLM-4.7 模型。GLM-4 系列在中文语义理解和指令遵循方面表现优异,适合处理将自然语言转换为 Shell 命令的任务。

- 模型路径:

/maas/zhipuai/GLM-4.7 - 服务端点:

https://maas-api.lanyun.net/v1/chat/completions

第三章:Rust 项目架构设计与依赖管理

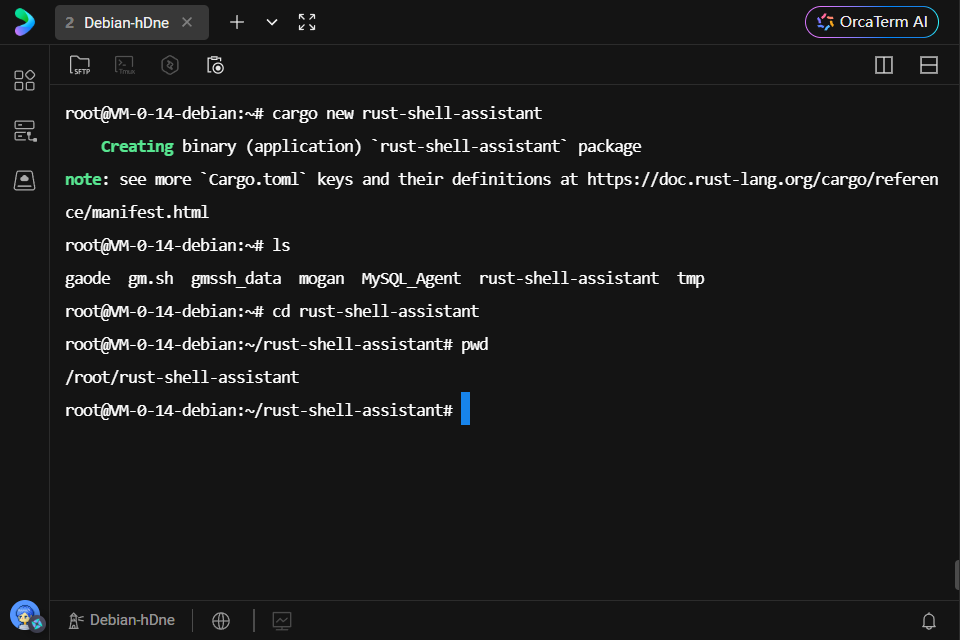

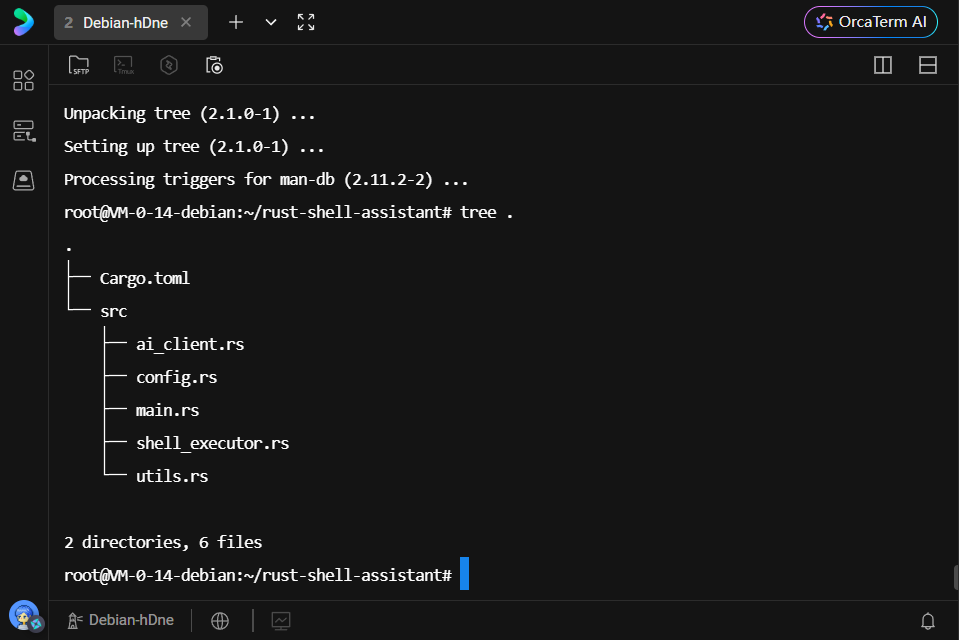

使用 cargo new 初始化项目,这不仅创建了目录结构,还自动初始化了 git 仓库。

cargo new rust-shell-assistant

cd rust-shell-assistant

3.1 依赖库(Crates)深度解析

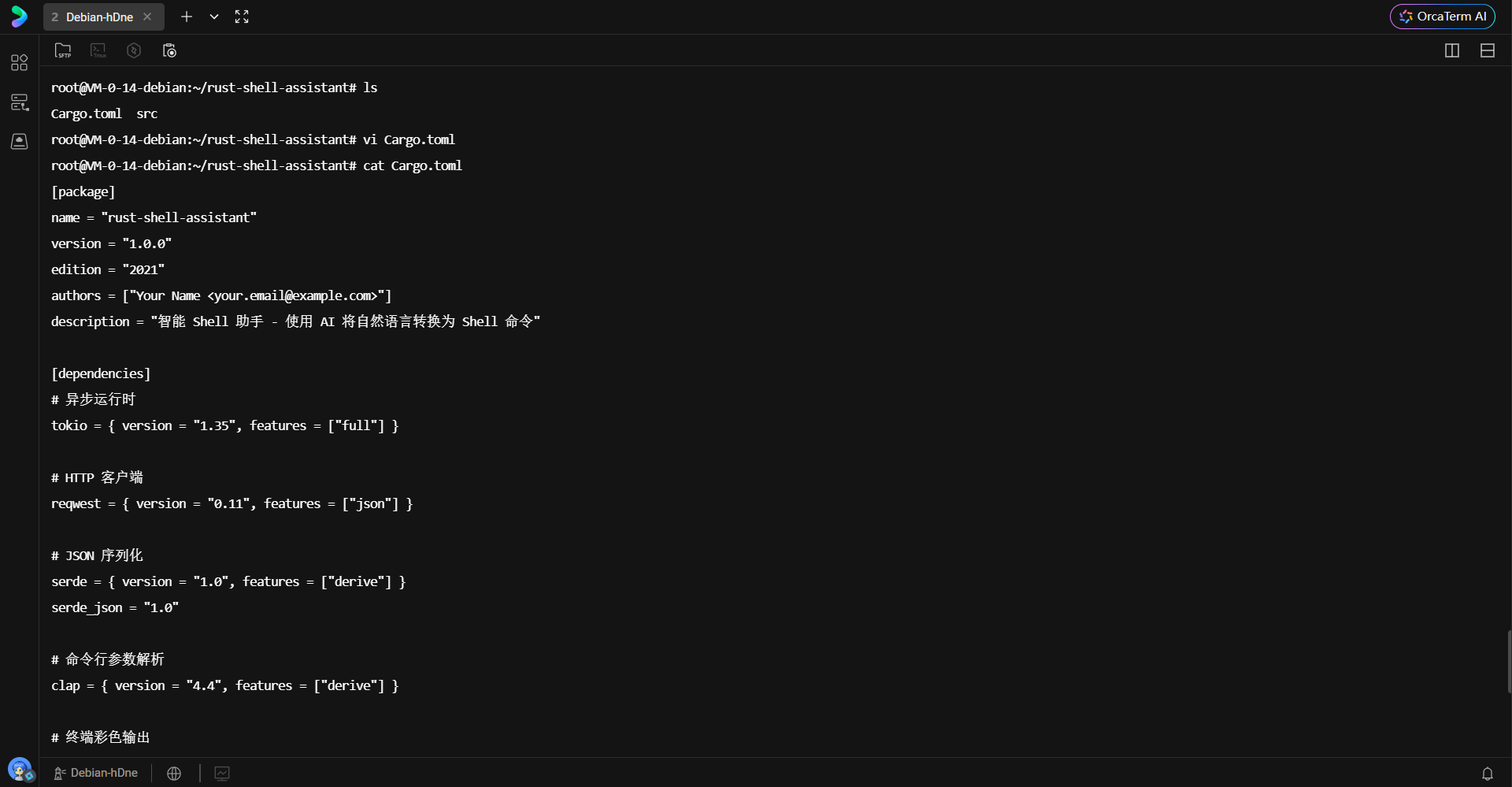

Cargo.toml 是 Rust 项目的 manifest 文件,定义了项目元数据和依赖关系。本项目引入了以下关键库:

- tokio:Rust 异步编程的事实标准。开启

full特性以支持异步 I/O、定时器、调度器等完整功能。它是程序能够并发处理网络请求的基础。 - reqwest:基于

tokio构建的高级 HTTP 客户端,支持异步请求,配置json特性以简化 JSON 数据体的处理。 - serde / serde_json:提供序列化与反序列化框架。通过

derive宏,能够自动为结构体生成 JSON 转换代码,保证了类型安全的数据交换。 - clap:命令行参数解析库。通过结构体属性宏定义 CLI 参数,自动生成帮助信息和参数校验逻辑。

- rustyline:提供类似 Readline 的行编辑功能,支持历史记录、光标移动,是构建交互式 REPL 的核心。

- colored:用于终端文本着色,提升用户体验。

- anyhow / thiserror:Rust 错误处理的最佳实践组合,简化了 Result 类型的传播和错误上下文的附加。

- dotenv:用于从

.env文件加载配置,符合云原生应用的 “12-Factor App” 原则。

[package]

name = "rust-shell-assistant"

version = "1.0.0"

edition = "2021"

authors = ["Your Name <your.email@example.com>"]

description = "智能 Shell 助手 - 使用 AI 将自然语言转换为 Shell 命令"

[dependencies]

# 异步运行时

tokio = { version = "1.35", features = ["full"] }

# HTTP 客户端

reqwest = { version = "0.11", features = ["json"] }

# JSON 序列化

serde = { version = "1.0", features = ["derive"] }

serde_json = "1.0"

# 命令行参数解析

clap = { version = "4.4", features = ["derive"] }

# 终端彩色输出

colored = "2.1"

# 交互式命令行

rustyline = "13.0"

# 错误处理

anyhow = "1.0"

thiserror = "1.0"

# 环境变量

dotenv = "0.15"

# 日志

log = "0.4"

env_logger = "0.11"

[profile.release]

opt-level = 3

lto = true

codegen-units = 1

strip = true

第四章:核心模块实现原理

项目采用模块化设计,将功能解耦为 AI 通信、Shell 执行、配置管理及主控制流。

4.1 AI 客户端模块 (ai_client.rs)

该模块封装了与蓝耘 API 的 HTTP 通信逻辑。

- 结构体设计:定义了

ChatRequest和ChatResponse结构体,严格映射 API 的 JSON 格式。 - Prompt Engineering:在

natural_language_to_command方法中,通过 System Prompt 设定模型角色。明确要求模型“只返回命令本身”、“不包含解释”,并注入安全规则(如禁止rm -rf),这是确保输出可执行性的关键。 - 异步处理:利用

async/await语法,网络请求不会阻塞主线程,提高了程序的响应效率。

use anyhow::{Context, Result};

use reqwest::Client;

use serde::{Deserialize, Serialize};

use std::time::Duration;

use crate::config::Config;

/// AI 客户端

pub struct AIClient {

client: Client,

config: Config,

}

/// API 请求消息

#[derive(Debug, Serialize, Deserialize)]

pub struct Message {

pub role: String,

pub content: String,

}

/// API 请求体

#[derive(Debug, Serialize)]

struct ChatRequest {

model: String,

messages: Vec<Message>,

max_tokens: u32,

temperature: f32,

}

/// API 响应体

#[derive(Debug, Deserialize)]

struct ChatResponse {

choices: Vec<Choice>,

}

#[derive(Debug, Deserialize)]

struct Choice {

message: Message,

}

impl AIClient {

/// 创建新的 AI 客户端

pub fn new(config: Config) -> Result<Self> {

let client = Client::builder()

.timeout(Duration::from_secs(config.timeout_seconds))

.build()

.context("创建 HTTP 客户端失败")?;

Ok(AIClient { client, config })

}

/// 发送聊天请求

pub async fn chat(&self, messages: Vec<Message>) -> Result<String> {

let request_body = ChatRequest {

model: self.config.model.clone(),

messages,

max_tokens: self.config.max_tokens,

temperature: self.config.temperature,

};

let mut request = self.client.post(&self.config.api_url).json(&request_body);

// 如果有 API 密钥,添加到请求头

if let Some(api_key) = &self.config.api_key {

request = request.bearer_auth(api_key);

}

let response = request

.send()

.await

.context("发送 API 请求失败")?;

if !response.status().is_success() {

let status = response.status();

let error_text = response.text().await.unwrap_or_default();

anyhow::bail!("API 请求失败: {} - {}", status, error_text);

}

let chat_response: ChatResponse = response

.json()

.await

.context("解析 API 响应失败")?;

chat_response

.choices

.first()

.map(|choice| choice.message.content.clone())

.context("API 响应中没有内容")

}

/// 将自然语言转换为 Shell 命令

pub async fn natural_language_to_command(&self, query: &str) -> Result<String> {

let system_prompt = r#"你是一个专业的 Linux Shell 命令助手。

你的任务是将用户的自然语言描述转换为准确的 Shell 命令。

规则:

1. 只返回命令本身,不要有任何解释或额外文字

2. 如果需要多个命令,用 && 连接

3. 确保命令安全且符合最佳实践

4. 优先使用常见的 Linux 命令

5. 不要使用危险的命令(如 rm -rf / 等)

示例:

用户: 列出当前目录的所有文件

助手: ls -la

用户: 查看系统内存使用情况

助手: free -h

"#;

let messages = vec![

Message {

role: "system".to_string(),

content: system_prompt.to_string(),

},

Message {

role: "user".to_string(),

content: query.to_string(),

},

];

self.chat(messages).await

}

/// 解释 Shell 命令

pub async fn explain_command(&self, command: &str) -> Result<String> {

let system_prompt = "你是一个 Shell 命令解释专家。请用简洁的中文解释给定的命令,包括每个参数的作用。";

let messages = vec![

Message {

role: "system".to_string(),

content: system_prompt.to_string(),

},

Message {

role: "user".to_string(),

content: format!("请解释这个命令: {}", command),

},

];

self.chat(messages).await

}

}

4.2 Shell 执行器模块 (shell_executor.rs)

这是连接 AI 输出与操作系统内核的桥梁。

- 安全拦截:在执行前,

is_dangerous_command方法通过模式匹配检查命令字符串,拦截高危操作(如格式化磁盘、全盘删除等)。 - 跨平台兼容:通过

cfg!(target_os = "windows")宏进行编译期判断。Windows 下调用cmd /C,Linux/macOS 下调用sh -c,确保了代码的可移植性。 - 输出捕获:使用

std::process::Command的output()方法,捕获标准输出(stdout)和标准错误(stderr),而非直接打印到屏幕,以便程序对结果进行格式化处理。

use anyhow::{Context, Result};

use std::process::{Command, Output};

/// Shell 命令执行器

pub struct ShellExecutor;

impl ShellExecutor {

/// 创建新的执行器

pub fn new() -> Self {

ShellExecutor

}

/// 执行 Shell 命令

pub fn execute(&self, command: &str) -> Result<CommandResult> {

// 检查危险命令

if self.is_dangerous_command(command) {

anyhow::bail!("检测到危险命令,拒绝执行: {}", command);

}

let output = if cfg!(target_os = "windows") {

Command::new("cmd")

.args(["/C", command])

.output()

.context("执行命令失败")?

} else {

Command::new("sh")

.arg("-c")

.arg(command)

.output()

.context("执行命令失败")?

};

Ok(CommandResult::from_output(output))

}

/// 检查是否为危险命令

fn is_dangerous_command(&self, command: &str) -> bool {

let dangerous_patterns = vec![

"rm -rf /",

"rm -rf /*",

"mkfs",

"dd if=/dev/zero",

"> /dev/sda",

":(){ :|:& };:",

"chmod -R 777 /",

];

dangerous_patterns.iter().any(|pattern| command.contains(pattern))

}

}

/// 命令执行结果

#[derive(Debug)]

pub struct CommandResult {

pub success: bool,

pub stdout: String,

pub stderr: String,

pub exit_code: i32,

}

impl CommandResult {

fn from_output(output: Output) -> Self {

CommandResult {

success: output.status.success(),

stdout: String::from_utf8_lossy(&output.stdout).to_string(),

stderr: String::from_utf8_lossy(&output.stderr).to_string(),

exit_code: output.status.code().unwrap_or(-1),

}

}

}

4.3 配置管理模块 (config.rs)

采用分层配置策略。Config::from_env() 优先读取环境变量,若不存在则回退至默认值。这种设计允许用户通过修改 .env 文件灵活调整模型参数(如 temperature、max_tokens),无需重新编译代码。

use anyhow::{Context, Result};

use serde::{Deserialize, Serialize};

use std::env;

/// AI API 配置

#[derive(Debug, Clone, Serialize, Deserialize)]

pub struct Config {

/// API 基础 URL

pub api_url: String,

/// 模型名称

pub model: String,

/// API 密钥(可选)

pub api_key: Option<String>,

/// 最大 token 数

pub max_tokens: u32,

/// 温度参数

pub temperature: f32,

/// 请求超时时间(秒)

pub timeout_seconds: u64,

}

impl Config {

/// 从环境变量加载配置

pub fn from_env() -> Result<Self> {

// 尝试加载 .env 文件

dotenv::dotenv().ok();

let api_url = env::var("AI_API_URL")

.unwrap_or_else(|_| "https://maas-api.lanyun.net/v1/chat/completions".to_string());

let model = env::var("AI_MODEL")

.unwrap_or_else(|_| "/maas/zhipuai/GLM-4.7".to_string());

let api_key = env::var("AI_API_KEY").ok();

let max_tokens = env::var("MAX_TOKENS")

.unwrap_or_else(|_| "1000".to_string())

.parse()

.context("MAX_TOKENS 必须是有效的数字")?;

let temperature = env::var("TEMPERATURE")

.unwrap_or_else(|_| "0.7".to_string())

.parse()

.context("TEMPERATURE 必须是有效的浮点数")?;

let timeout_seconds = env::var("TIMEOUT_SECONDS")

.unwrap_or_else(|_| "30".to_string())

.parse()

.context("TIMEOUT_SECONDS 必须是有效的数字")?;

Ok(Config {

api_url,

model,

api_key,

max_tokens,

temperature,

timeout_seconds,

})

}

/// 创建默认配置

pub fn default() -> Self {

Config {

api_url: "https://maas-api.lanyun.net/v1/chat/completions".to_string(),

model: "/maas/zhipuai/GLM-4.7".to_string(),

api_key: None,

max_tokens: 1000,

temperature: 0.7,

timeout_seconds: 30,

}

}

}

4.4 主程序与 REPL 循环 (main.rs)

主函数利用 tokio::main 宏启动异步运行时。程序逻辑分为两种模式:

- 单次查询模式(One-shot):通过

--query参数直接处理单条指令,适合脚本集成。 - 交互模式(Interactive):进入

loop循环,利用rustyline读取用户输入,维护命令历史CommandHistory。

代码中实现了 explain 指令的分支处理,不仅能生成命令,还能调用 AI 解释命令含义,增强了工具的教育属性。

mod ai_client;

mod config;

mod shell_executor;

mod utils;

use ai_client::AIClient;

use anyhow::Result;

use clap::Parser;

use config::Config;

use rustyline::error::ReadlineError;

use rustyline::DefaultEditor;

use shell_executor::ShellExecutor;

use std::collections::VecDeque;

/// 智能 Shell 助手命令行参数

#[derive(Parser, Debug)]

#[command(name = "rust-shell-assistant")]

#[command(about = "智能 Shell 助手 - 使用 AI 将自然语言转换为 Shell 命令", long_about = None)]

struct Args {

/// 直接查询模式(不进入交互式界面)

#[arg(short, long)]

query: Option<String>,

/// 只生成命令,不执行

#[arg(short, long)]

dry_run: bool,

/// 显示详细日志

#[arg(short, long)]

verbose: bool,

}

/// 命令历史记录

struct CommandHistory {

history: VecDeque<HistoryEntry>,

max_size: usize,

}

#[derive(Clone)]

struct HistoryEntry {

query: String,

command: String,

executed: bool,

}

impl CommandHistory {

fn new(max_size: usize) -> Self {

CommandHistory {

history: VecDeque::new(),

max_size,

}

}

fn add(&mut self, query: String, command: String, executed: bool) {

if self.history.len() >= self.max_size {

self.history.pop_front();

}

self.history.push_back(HistoryEntry {

query,

command,

executed,

});

}

fn print(&self) {

if self.history.is_empty() {

utils::print_info("暂无历史记录");

return;

}

println!("\n{}", colored::Colorize::bright_blue("=== 命令历史 ==="));

for (i, entry) in self.history.iter().enumerate() {

let status = if entry.executed { "✓" } else { "✗" };

println!(

"{}. [{}] {} -> {}",

i + 1,

status,

colored::Colorize::cyan(&entry.query),

colored::Colorize::white(&entry.command)

);

}

println!();

}

}

#[tokio::main]

async fn main() -> Result<()> {

let args = Args::parse();

// 初始化日志

if args.verbose {

env_logger::Builder::from_default_env()

.filter_level(log::LevelFilter::Debug)

.init();

}

// 加载配置

let config = Config::from_env().unwrap_or_else(|_| {

utils::print_info("使用默认配置");

Config::default()

});

// 创建 AI 客户端和 Shell 执行器

let ai_client = AIClient::new(config)?;

let shell_executor = ShellExecutor::new();

// 如果是直接查询模式

if let Some(query) = args.query {

return handle_single_query(&ai_client, &shell_executor, &query, args.dry_run).await;

}

// 进入交互式模式

run_interactive_mode(ai_client, shell_executor).await

}

/// 处理单次查询

async fn handle_single_query(

ai_client: &AIClient,

shell_executor: &ShellExecutor,

query: &str,

dry_run: bool,

) -> Result<()> {

utils::print_info(&format!("查询: {}", query));

let command = ai_client.natural_language_to_command(query).await?;

let command = command.trim();

utils::print_command_suggestion(command);

if dry_run {

utils::print_info("干运行模式,不执行命令");

return Ok(());

}

if utils::get_user_confirmation("执行此命令? (y/n):") {

let result = shell_executor.execute(command)?;

utils::print_execution_result(result.success, &result.stdout, &result.stderr);

} else {

utils::print_info("已取消执行");

}

Ok(())

}

/// 运行交互式模式

async fn run_interactive_mode(ai_client: AIClient, shell_executor: ShellExecutor) -> Result<()> {

utils::print_welcome();

let mut rl = DefaultEditor::new()?;

let mut history = CommandHistory::new(50);

loop {

let readline = rl.readline(">> ");

match readline {

Ok(line) => {

let line = line.trim();

if line.is_empty() {

continue;

}

// 添加到 readline 历史

let _ = rl.add_history_entry(line);

// 处理特殊命令

if matches!(line, "exit" | "quit") {

println!("{}", colored::Colorize::bright_green("再见!"));

break;

}

if line == "help" {

utils::print_help();

continue;

}

if line == "history" {

history.print();

continue;

}

if line == "clear" {

print!("\x1B[2J\x1B[1;1H");

continue;

}

// 处理 explain 命令

if line.starts_with("explain ") {

let command = line.strip_prefix("explain ").unwrap();

if let Err(e) = handle_explain(&ai_client, command).await {

utils::print_error(&format!("解释失败: {}", e));

}

continue;

}

// 处理普通查询

if let Err(e) = handle_query(&ai_client, &shell_executor, line, &mut history).await {

utils::print_error(&format!("处理失败: {}", e));

}

}

Err(ReadlineError::Interrupted) => {

utils::print_info("使用 'exit' 或 'quit' 退出");

continue;

}

Err(ReadlineError::Eof) => {

println!("{}", colored::Colorize::bright_green("再见!"));

break;

}

Err(err) => {

utils::print_error(&format!("读取输入错误: {}", err));

break;

}

}

}

Ok(())

}

/// 处理查询

async fn handle_query(

ai_client: &AIClient,

shell_executor: &ShellExecutor,

query: &str,

history: &mut CommandHistory,

) -> Result<()> {

// 调用 AI 生成命令

let command = ai_client.natural_language_to_command(query).await?;

let command = command.trim();

utils::print_command_suggestion(command);

// 询问用户是否执行

if utils::get_user_confirmation("执行此命令? (y/n):") {

match shell_executor.execute(command) {

Ok(result) => {

utils::print_execution_result(result.success, &result.stdout, &result.stderr);

history.add(query.to_string(), command.to_string(), true);

}

Err(e) => {

utils::print_error(&format!("执行失败: {}", e));

history.add(query.to_string(), command.to_string(), false);

}

}

} else {

utils::print_info("已取消执行");

history.add(query.to_string(), command.to_string(), false);

}

Ok(())

}

/// 处理命令解释

async fn handle_explain(ai_client: &AIClient, command: &str) -> Result<()> {

utils::print_info(&format!("正在解释命令: {}", command));

let explanation = ai_client.explain_command(command).await?;

println!("\n{}", colored::Colorize::bright_cyan("📖 命令解释:"));

println!("{}\n", explanation);

Ok(())

}

4.5 环境变量配置

在项目根目录创建 .env 文件,填入之前获取的 API Key 及服务端点配置。这是保护敏感信息不进入版本控制系统的标准做法。

# AI API 配置

AI_API_URL=https://maas-api.lanyun.net/v1/chat/completions

AI_MODEL=/maas/zhipuai/GLM-4.7

AI_API_KEY=your_api_key_here

# 可选配置

MAX_TOKENS=1000

TEMPERATURE=0.7

TIMEOUT_SECONDS=30

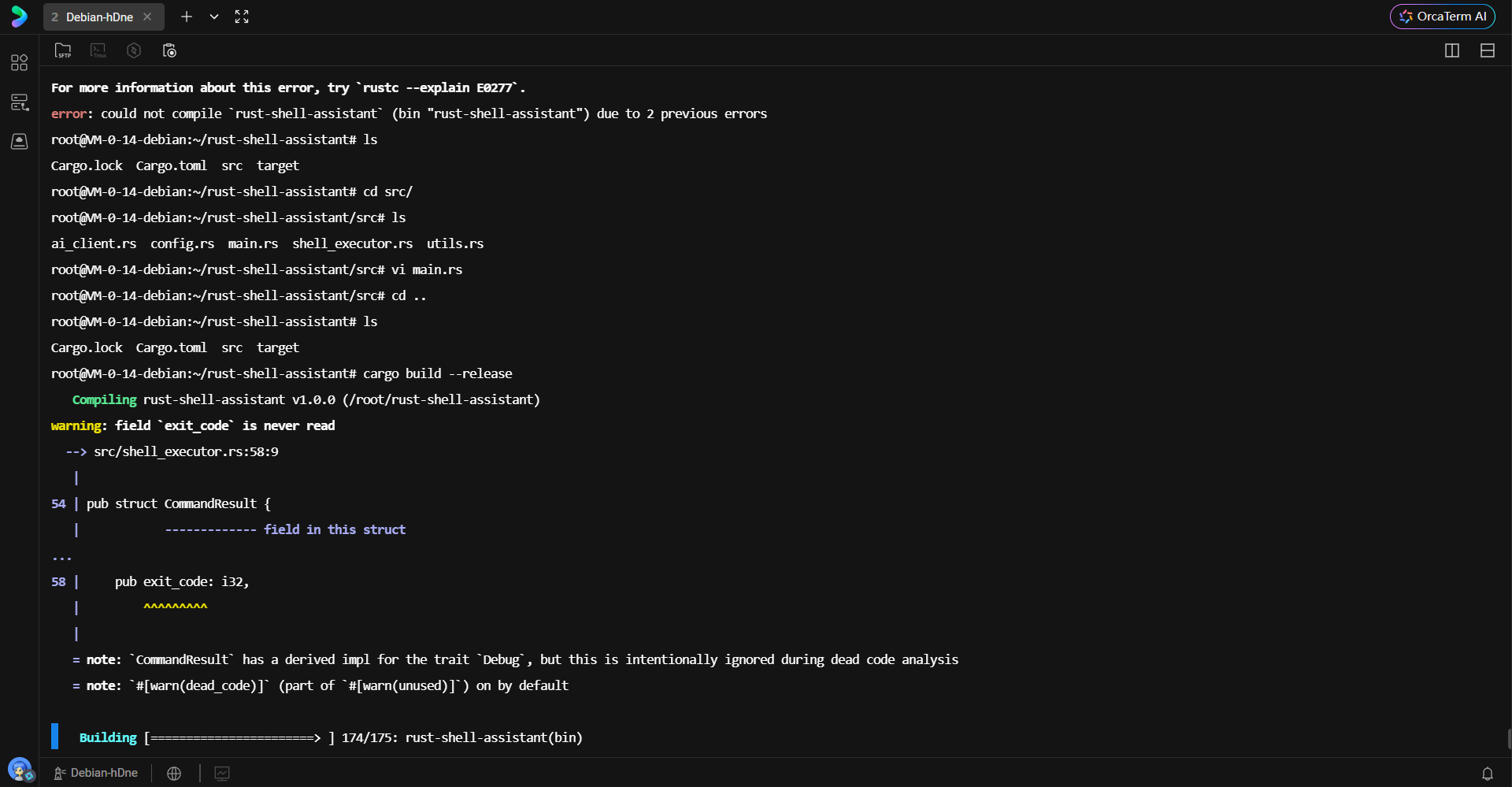

第五章:编译链路排查与系统库链接问题

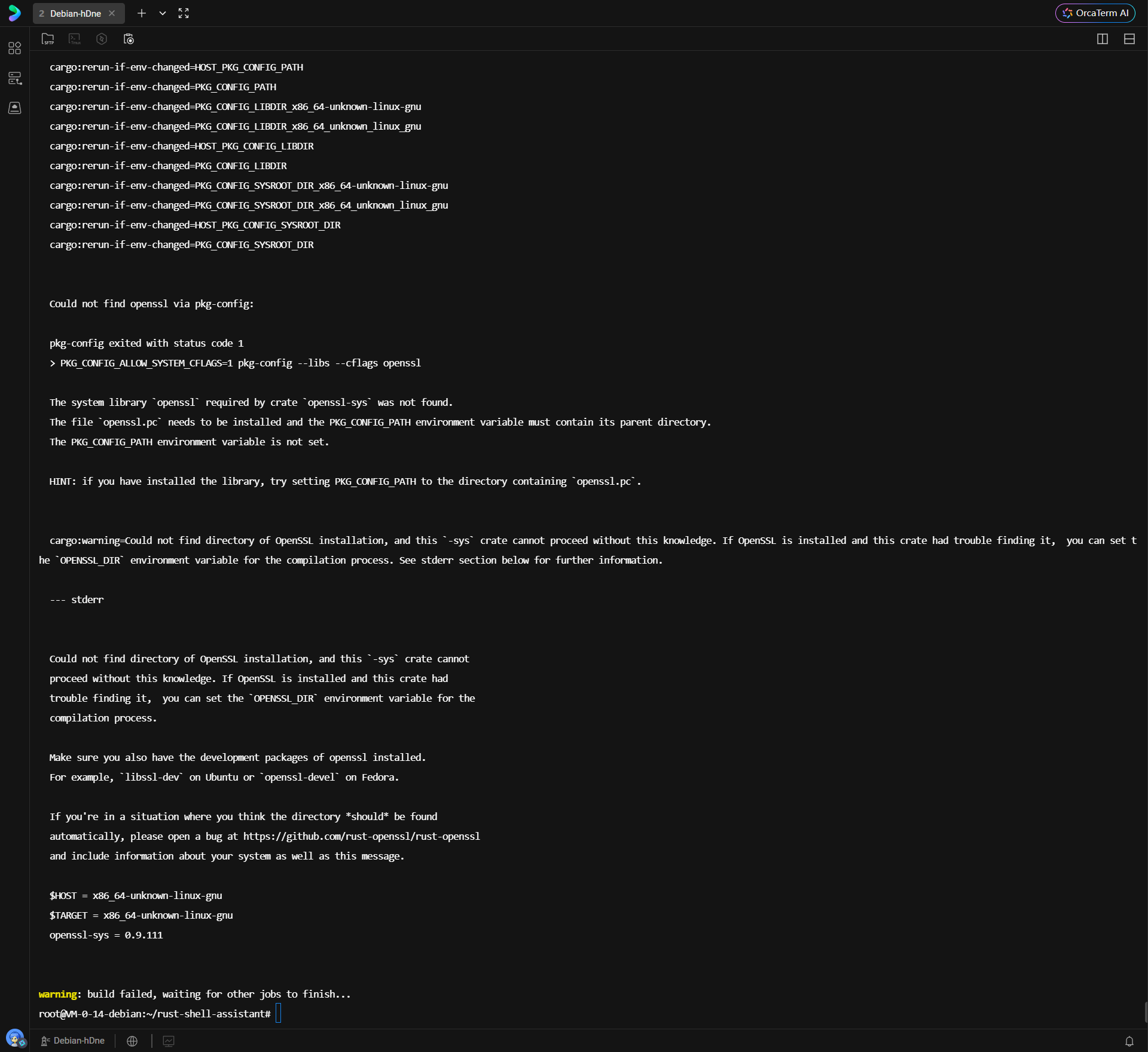

在执行 cargo build --release 进行优化编译时,常遇到由底层系统库缺失引发的链接错误。

5.1 OpenSSL 链接故障分析

初次编译失败,报错信息 could not find openssl via pkg-config。

原因解析:

Rust 的 reqwest 依赖 openssl-sys crate,后者只是 Rust 对 C 语言 OpenSSL 库的 FFI 绑定。编译时,Rust 必须链接到操作系统提供的 libssl.so 和 libcrypto.so 动态库。pkg-config 是一个用于查询已安装库编译参数的工具,Rust 构建脚本依赖它来寻找 OpenSSL 的路径。报错表明系统中既没有 pkg-config 工具,也没有安装 OpenSSL 的开发头文件包。

解决方案:

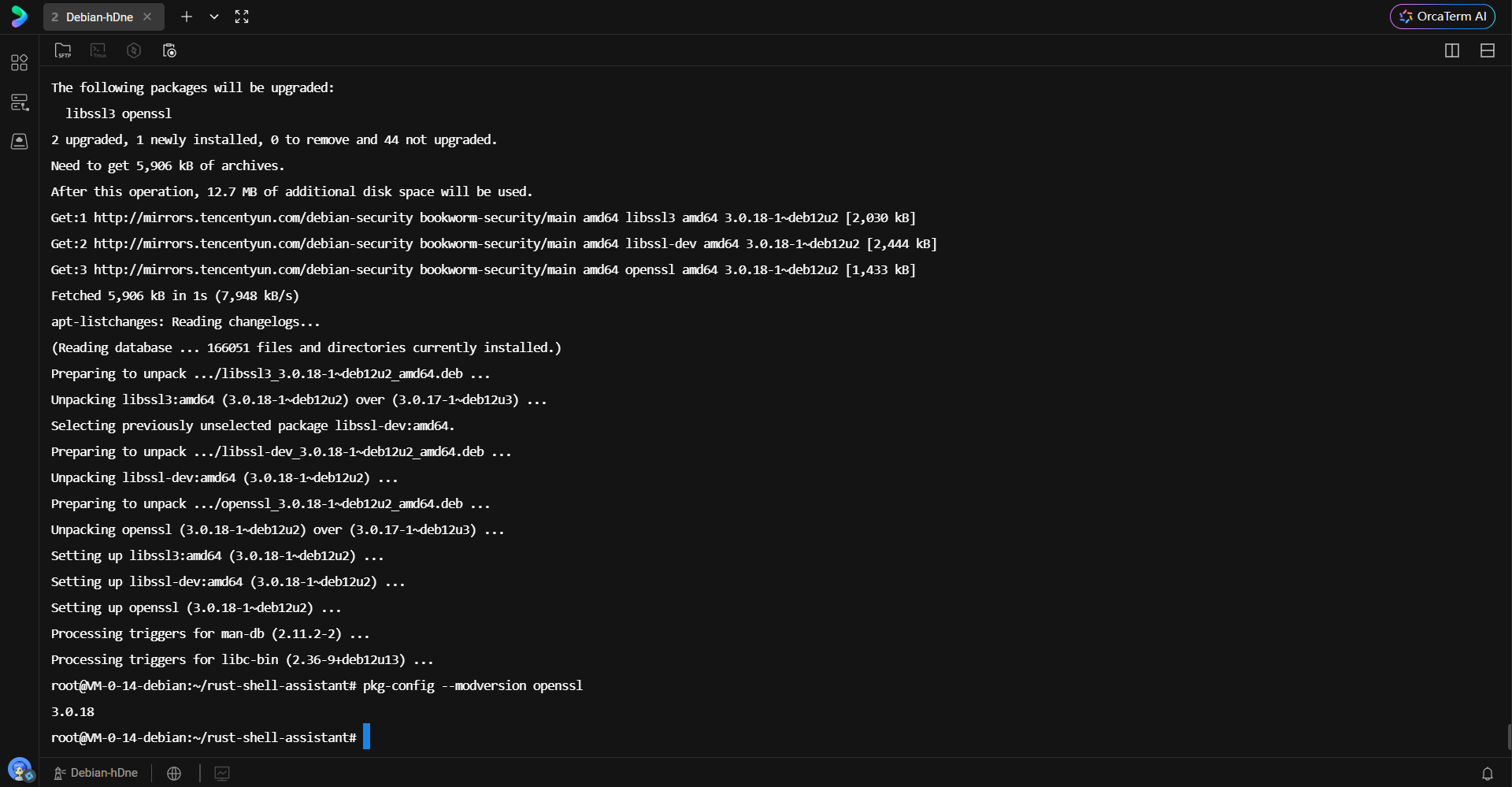

安装 pkg-config 及 libssl-dev。libssl-dev 包含了编译所需的头文件(.h)和符号链接。

sudo apt-get install -y pkg-config libssl-dev build-essential

验证 OpenSSL 版本以确保环境就绪:

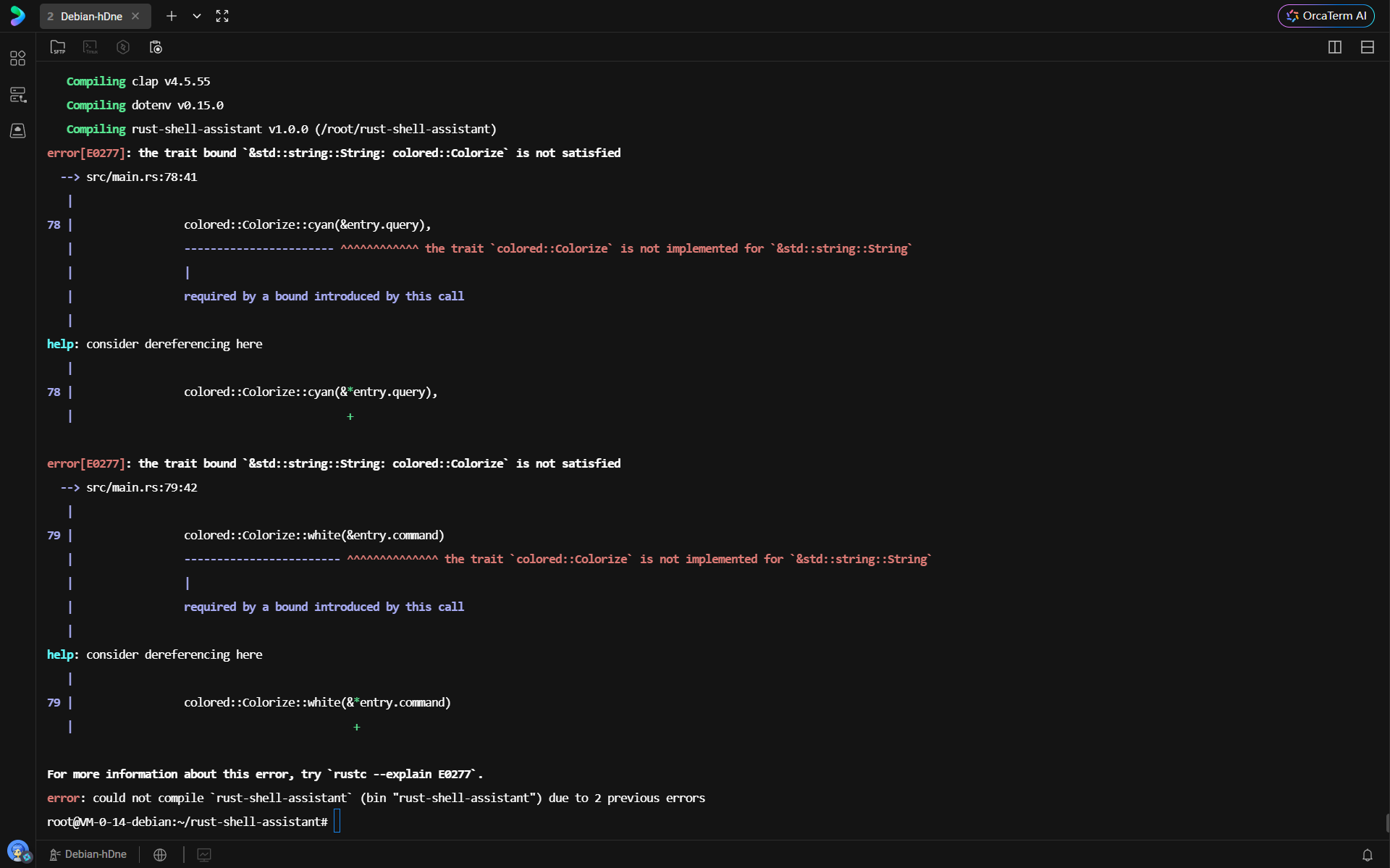

5.2 类型系统约束与 Trait 实现排查

解决链接问题后,再次编译遇到 Rust 类型检查错误。

错误分析:

错误提示 the trait bound &std::string::String: colored::Colorize is not satisfied。colored 库的 Colorize trait 主要为字符串切片 &str 实现了扩展方法(如 .red(), .bold())。虽然 String 可以自动解引用(Deref Coercion)为 &str,但在涉及 trait 方法调用且接收者为引用类型(&String)时,编译器的自动推导可能受限,或者库本身并未对 &String 进行显式实现。

代码修正:

在 CommandHistory 的 print 方法中,需要显式引入 trait (use colored::Colorize;) 并确保调用对象类型正确。虽然修正后的代码示例中直接在 println! 宏中调用了 colorize 方法,核心在于确保作用域内引入了该 trait。

此外,编译器提示 exit_code 字段未被读取。在 Rust 中,这被视为“死代码”(Dead Code)。为了保留该字段以备未来扩展,同时消除警告,可以在结构体字段上方添加 #[allow(dead_code)] 属性。

#[derive(Debug)]

pub struct CommandResult {

pub success: bool,

pub stdout: String,

pub stderr: String,

#[allow(dead_code)] // 显式允许未使用的字段

pub exit_code: i32,

}

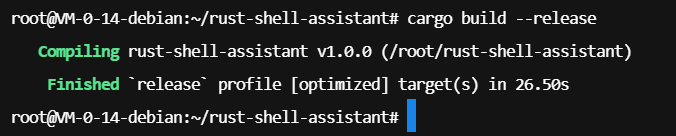

再次编译,由于警告已处理且依赖库就绪,编译顺利完成。

第六章:工具部署与实战演示

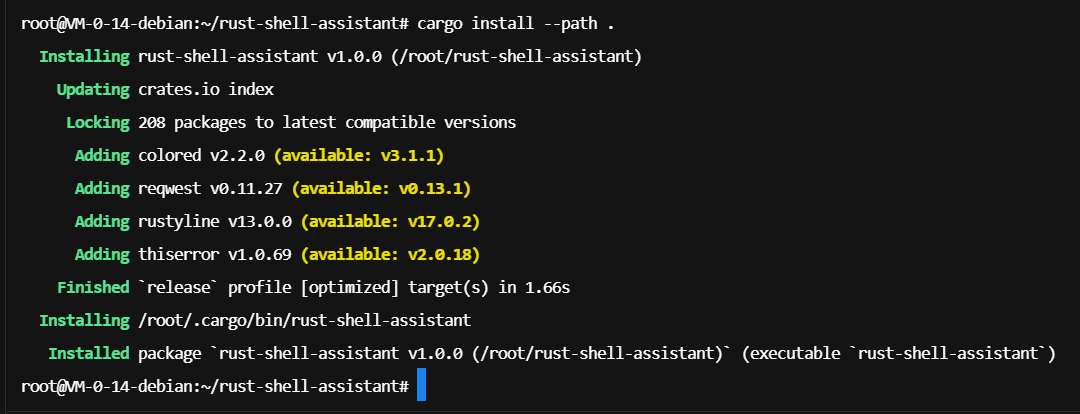

6.1 本地安装与路径配置

使用 cargo install 命令将编译好的二进制文件安装到 $HOME/.cargo/bin 目录下,使其成为系统级的可执行命令。

cargo install --path .

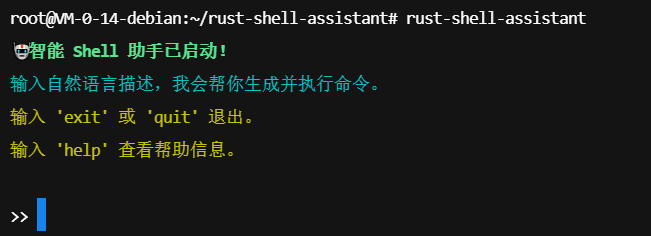

6.2 交互模式实测

在终端输入 rust-shell-assistant 启动工具。欢迎界面清晰,提示了可用指令。

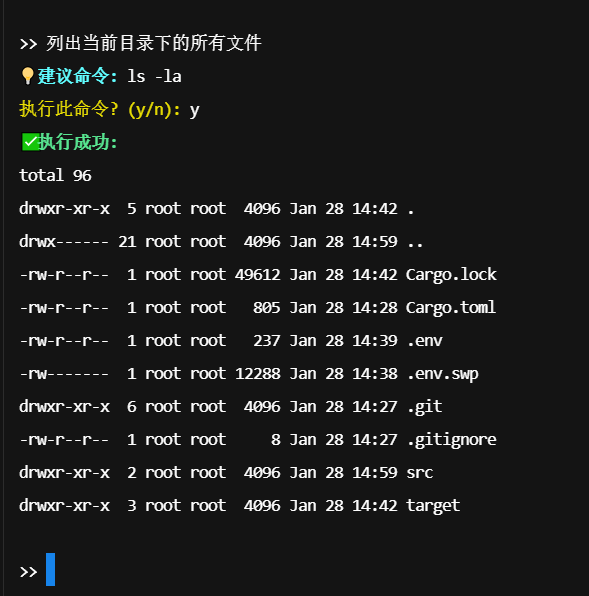

场景一:文件操作

输入自然语言:“列出当前目录下的所有文件”。

AI 准确解析意图,生成 ls -la 命令。用户确认执行后,工具调用系统 shell 并返回了详细的文件列表。

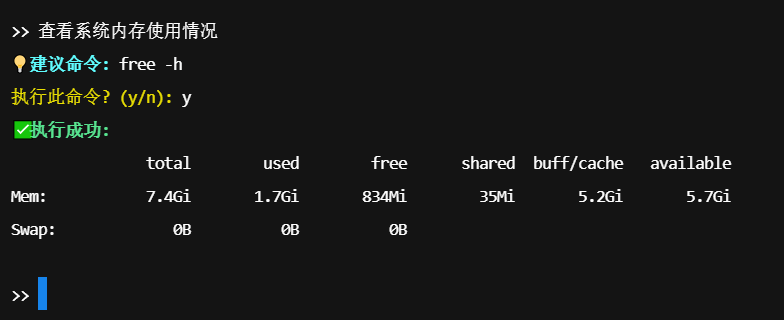

场景二:系统监控

输入:“查看系统内存使用情况”。

AI 生成 free -h 命令。执行结果清晰展示了内存总量、已用量及缓存情况。

6.3 命令行参数模式实测

工具同样支持非交互式的直接调用,便于集成到其他脚本或自动化流程中。

场景三:磁盘查询

通过 --query 参数直接提问:“显示当前磁盘使用情况”。

AI 生成 df -h,展示了文件系统的挂载点及空间占用。

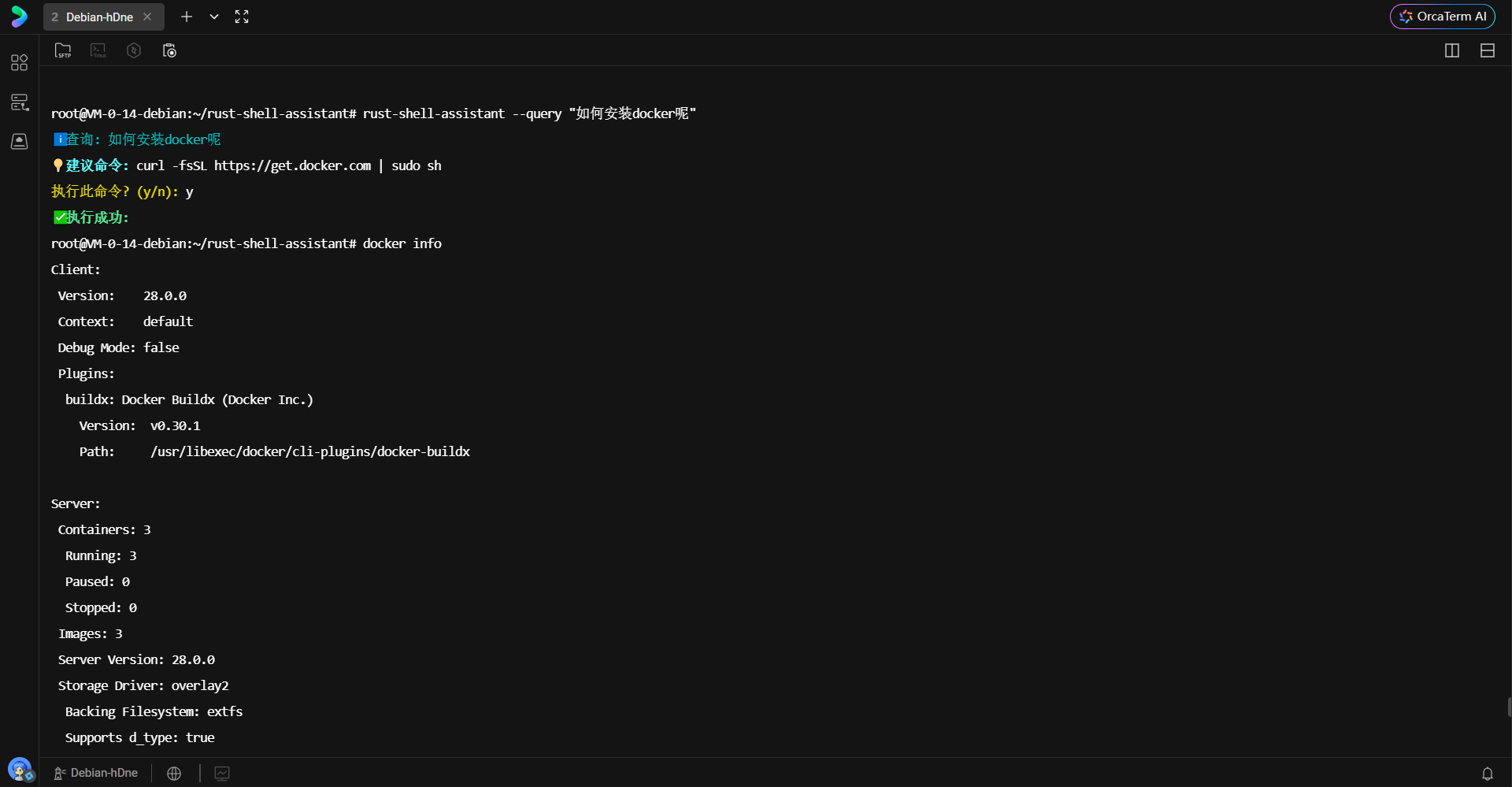

场景四:复杂指令咨询

提问:“如何安装docker呢”。

此处 AI 的响应体现了模型的知识库能力。它不仅给出了安装命令,通常还会包含一系列步骤(如更新 apt 索引、安装依赖、添加官方 GPG 密钥等)。注意:由于 System Prompt 限制了只返回命令,这里 AI 可能会尝试将多条命令用 && 连接,或者如果 prompt 调整得当,它会给出一键安装脚本的建议。

6.4 后端资源监控

在蓝耘控制台的仪表盘中,可以实时观测到 Token 的消耗情况。这为开发者提供了成本控制和用量分析的数据支持,验证了每一次 API 调用的成功与计费准确性。

结语

通过 Rust 语言的高性能与内存安全性,结合蓝耘平台强大的大模型推理能力,本文成功构建了一个具备自然语言理解能力的命令行助手。该项目不仅展示了现代系统编程语言与 AI 技术的融合潜力,也为运维自动化、终端智能化提供了切实可行的技术路径。从底层环境的依赖链接,到上层业务逻辑的异步处理,每一个环节的精细控制都体现了 Rust 工程化开发的严谨性。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)