[特殊字符] UltraRAG v3:低代码构建复杂RAG管道的框架

UltraRAG是一款基于MCP架构的轻量级RAG开发框架,由多所高校和研究机构联合推出。该框架通过YAML配置实现复杂工作流编排,支持模块化扩展与复用,提供统一评估体系。特色功能包括可视化IDE开发环境、智能AI助手辅助调试、一键生成互动对话系统等。安装方式支持本地源码和Docker容器部署,适用于学术研究和工业应用场景。相比Haystack、LangChain等同类项目,UltraRAG在开发

更少的代码、更低的门槛、更快的部署

最新动态 🔥

- 2026.01.23 🎉 UltraRAG 3.0 发布:告别“黑箱”开发——让每一行推理逻辑都清晰可见 👉 | 📖 博客

- 2026.01.20 🎉 AgentCPM-Report 模型发布!DeepResearch终于本地化:8B 端设备写作代理 AgentCPM-Report 开源 👉 | 🤗 模型

关于UltraRAG

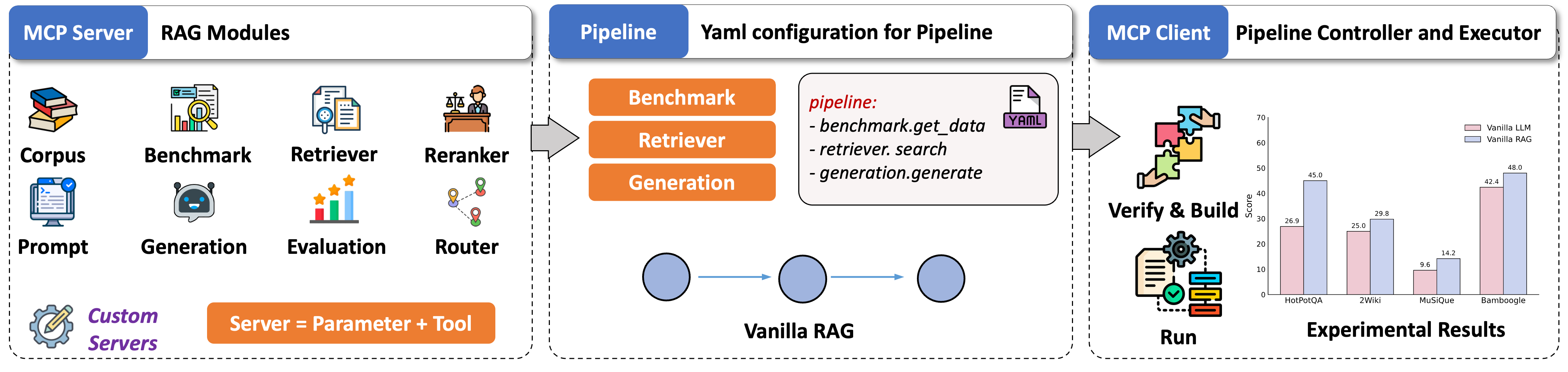

UltraRAG是第一个基于模型上下文协议(MCP)架构设计的轻量级RAG开发框架,由清华大学的THUNLP、东北大学的NEUIR、OpenBMB和AI9stars联合推出。

UltraRAG旨在进行研究探索和工业原型开发,标准化了核心RAG组件(检索、生成等),作为独立的MCP服务器,与强大的工作流编排能力相结合,开发者可以通过YAML配置简单实现复杂控制结构的精确编排,如条件分支和循环。

UltraRAG UI

UltraRAG UI超越了传统聊天界面的局限,演变为一个可视化的RAG集成开发环境(IDE),结合了编排、调试和演示。系统具有强大的内置管道构建器,支持“画布构建”和“代码编辑”之间的双向实时同步,实现管道参数和提示的精细在线调整。此外,系统还引入了智能AI助手,帮助开发生命周期全程,从管道结构设计到参数调优和提示生成。一旦构建,逻辑流可以一键转化为互动对话系统,完美整合知识库管理组件,用户可以构建自定义知识库进行文档问答,真正实现从底层逻辑构建和数据治理到最终应用部署的一站式闭环。

主要亮点

-

🚀 低代码的复杂工作流编排

- 推理编排:原生支持顺序、循环和条件分支等控制结构,开发者只需编写YAML配置文件即可用几十行代码实现复杂的迭代RAG逻辑。

-

⚡ 模块化扩展与复用

- 原子服务器:基于MCP架构,功能解耦为独立服务器。新特性只需注册为功能级工具即可无缝集成到工作流,实现极高的可复用性。

-

📊 统一评估与基准比较

- 研究效率:内置标准化评估工作流,现成可用的主流研究基准。通过统一的指标管理和基线集成,显著提高实验的可重复性和比较效率。

-

✨ 快速互动原型生成

- 一键交付:告别繁琐的UI开发。仅需一条命令,管道逻辑可以瞬间转化为互动对话Web UI,缩短算法到演示的距离。

安装指南

我们提供两种安装方法:本地源代码安装(推荐使用uv进行包管理)和Docker容器部署。

方法一:源代码安装

强烈建议使用 uv 管理Python环境和依赖,以显著提高安装速度。

准备环境

如果尚未安装uv,请执行:

# 直接安装

pip install uv

# 下载

curl -LsSf https://astral.sh/uv/install.sh | sh

下载源代码

git clone https://github.com/OpenBMB/UltraRAG.git --depth 1

cd UltraRAG

安装依赖

根据用例选择一种模式安装依赖:

A: 创建新环境 使用 uv sync 自动创建虚拟环境并同步依赖:

-

核心依赖:如果只需运行基本核心功能,例如仅使用UltraRAG UI:

uv sync -

完整安装:如果希望全面体验UltraRAG的检索、生成、语料处理和评估功能,请运行:

uv sync --all-extras -

按需安装:如果只需运行特定模块,保持相应的

--extra选项,例如:uv sync --extra retriever # 仅检索模块 uv sync --extra generation # 仅生成模块

一旦安装完成,激活虚拟环境:

# Windows CMD

.venv\Scripts\activate.bat

# Windows Powershell

.venv\Scripts\Activate.ps1

# macOS / Linux

source .venv/bin/activate

B: 安装到现有环境 将UltraRAG安装到当前活动的Python环境中,使用 uv pip:

# 核心依赖

uv pip install -e .

# 完整安装

uv pip install -e ".[all]"

# 按需安装

uv pip install -e ".[retriever]"

方法二:Docker容器部署

如果您不希望配置本地Python环境,可以使用Docker进行部署。

获取代码和镜像

# 1. 克隆代码库

git clone https://github.com/OpenBMB/UltraRAG.git --depth 1

cd UltraRAG

# 2. 准备镜像(选择一种)

# 选项A:从Docker Hub拉取

docker pull hdxin2002/ultrarag:v0.3.0-base-cpu # 基础版本(CPU)

docker pull hdxin2002/ultrarag:v0.3.0-base-gpu # 基础版本(GPU)

docker pull hdxin2002/ultrarag:v0.3.0 # 完整版本(GPU)

# 选项B:本地构建

docker build -t ultrarag:v0.3.0 .

启动容器

# 启动容器(端口5050自动映射)

docker run -it --gpus all -p 5050:5050

注意:容器启动后,将自动运行UltraRAG UI。您可以直接在浏览器中访问 http://localhost:5050 来使用。

验证安装

安装完成后,运行以下示例命令检查环境是否正常:

ultrarag run examples/sayhello.yaml

如果看到以下输出,说明安装成功:

Hello, UltraRAG v3!

快速入门

我们提供完整的新手到进阶的教程示例。无论您是在进行学术研究,还是构建工业应用,您都可以在此找到指导。欢迎访问文档以获取更多细节。

研究实验

为研究人员设计,提供数据、实验工作流和可视化分析工具。

- 入门指南:了解如何快速运行基于UltraRAG的标准RAG实验工作流。

- 评估数据:下载RAG领域常用的公共评估数据集和大规模检索语料,直接用于研究基准测试。

- 案例分析:提供可视化案例研究接口,深入追踪工作流的每个中间输出,辅助分析和错误归因。

- 代码集成:了解如何直接在Python代码中调用UltraRAG组件,实现更灵活的定制开发。

演示系统

为开发者和最终用户设计,提供完整的UI交互和复杂的应用案例。

- 快速入门:了解如何启动UltraRAG UI,并熟悉管理员模式下的各种高级配置。

- 部署指南:详细的生产环境部署教程,涵盖检索、生成模型(LLM)和Milvus向量数据库的搭建。

- 深度研究:旗舰案例,部署一个深度研究管道。结合AgentCPM-Report模型,能自动执行多步骤检索和整合,生成数万字的调查报告。

同类项目比较

在当前的RAG(Retrieval-Augmented Generation)领域,还有其他优秀的开源项目,例如:

-

Haystack: 作为一个强大的NLP框架,Haystack支持构建搜索引擎和问答系统,允许用户灵活地选择不同的后端模型,具有优越的文档检索能力。

-

LangChain: LangChain更注重于构建复杂的链式应用,通过多种工具与API整合,实现更加灵活的查询和任务执行。

-

Rasa: Rasa专注于构建对话系统,提供全面的开发工具和定制能力,使用户能够创建智能、可交互的聊天机器人。

这些项目各有特色,适用于不同的应用场景,用户可以根据具体需求选择最合适的框架。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)