ViDoRAG 技术全景报告:重塑 AI 视觉富文档处理新范式

《ViDoRAG技术全景报告:AI视觉富文档处理新范式》介绍了突破传统文本检索局限的ViDoRAG框架。针对企业80%以上核心数据所在的视觉富文档(含图表、表格等),该技术通过三大创新:1)基于高斯混合模型的动态检索,智能确定相关页面数量;2)多智能体协作系统(侦察员、分析师、审核员)模拟专家工作流;3)跨模态融合检索平衡文本与视觉信息。测试显示,ViDoRAG对表格、图表等视觉元素的处理准确率提

ViDoRAG 技术全景报告:重塑 AI 视觉富文档处理新范式

引言:告别“文本失明”,迎接视觉理解新时代

在当今的数字化办公环境中,视觉富文档(Visually Rich Documents, VRDs)——如公司财报、技术规格书、医学论文及设计方案——占据了企业核心数据的 80% 以上。这些文档的信息精华,不仅承载于文字,更高度依赖于图表、表格以及复杂的页面布局。

传统的“文本优先”RAG 在面对这类文档时,犹如“盲人摸象”,效果大打折扣。本文将深入解析 ViDoRAG 这一革命性框架,它如何将 AI 的处理能力从单纯的“阅读理解”升级为“视觉-语言联合推理”。

一、 深度综述:视觉富文档的处理困境与破局之道

1.1 传统 RAG 的三大致命缺陷

面对视觉富文档,传统 RAG 架构暴露了其根本性局限:

- 语义信息丢失:使用 PyMuPDF 等工具提取文本时,表格的行列结构、图表的数值趋势被彻底打乱,导致后续的向量检索完全失效。

- 视觉语境断裂:文本向量模型无法理解“左侧的注释对应右侧的饼图”这种空间逻辑关系。

- 固定窗口检索僵化:无论是简单问题还是复杂推理,都固定返回相同数量的文本片段,导致“信息饥渴”或“信息过载”。

ViDoRAG 的核心使命,正是为了解决这些问题,让 AI 真正“看懂”文档。

二、 核心算法揭秘:GMM 驱动的动态检索,告别“K值焦虑”

ViDoRAG 的第一项核心创新是引入高斯混合模型,实现了智能化的动态检索。

2.1 原理:相似度分数的“双峰分布”

在海量文档库中,检索模型返回的原始相似度分数通常会形成两个明显的“簇”:

- 正样本簇:与查询真正相关的少数页面,分数集中在高分段。

- 噪声簇:绝大多数无关页面,分数集中在低分段。

2.2 实现:EM算法的智能切分

ViDoRAG 不预设固定的 Top-K,而是利用期望最大化算法实时拟合这两个高斯分布:P(s) = ∑ π_i * N(s|μ_i, σ_i²)

系统会自动寻找两个分布的交点,作为本次查询的自适应阈值。相关页面有多少,就召回多少。

2.3 收益:灵活精准,资源高效

- 对于简单问题(如“CEO是谁?”):平均仅处理2-3页,节省约40%的Token消耗。

- 对于复杂问题(如“对比五年研发趋势”):自动扩大至15-20页,确保关键证据无一遗漏。

这相当于为每次查询配备了一个智能的流量管制系统。

补充知识点:

如何找到那个动态分界点?

传统方法是拍脑袋定个K(比如固定返回前5个)。ViDoRAG用的是更科学的 “期望最大化(EM)算法”:

初始化:先猜测这两个高斯分布(两个“钟形曲线”)大概在哪。

E步骤(期望):计算每个分数属于“高相关簇”或“低相关簇”的概率。

M步骤(最大化):根据上一步的概率,重新调整两个高斯分布的位置(均值μ)和宽度(方差σ²)。

循环迭代:重复E和M步骤,直到两个分布的形状稳定下来。

确定阈值:最后,计算这两个稳定下来的分布曲线的交点。这个交点就是最佳分界点——高于它的页面都被视为相关并被召回。

公式 P(s) = ∑ π_i * N(s|μ_i, σ_i²) 的含义:

这就是高斯混合模型的数学表达。意思是“总体分数分布由两个高斯分布按一定比例混合而成”。算法的工作就是找出π(混合比例)、μ(中心点)、σ(分散度)这些参数。

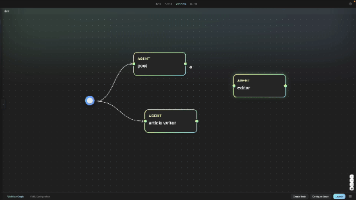

三、 系统架构:多智能体协作,模拟人类专家工作流

ViDoRAG 构建了一个模块化、协作化的智能体生态系统,其工作流程宛如一个高效的“破案小组”。

3.1 侦察员:低功耗“快速扫视”

- 技术栈:轻量级视觉编码器(如 CLIP)。

- 职责:根据查询和上一轮反馈,快速扫描文档库,基于视觉结构(“有柱状图”、“带表格”)筛选出候选页面,并给出筛选理由。

- 关键策略:要求模型只描述看到的视觉元素,避免进行深度语义推断,防止“幻觉”早期扩散。

3.2 分析师:“全副武装”的深度调查员

- 技术栈:高性能多模态大模型(如 GPT-4o, Claude 3.5, Qwen2.5-VL)。

- 工作流:

- 全景OCR:识别页面所有文字。

- 空间关系映射:建立文字与图表区域的锚定关系。

- 推理与输出:若信息完整,直接生成答案;若证据分散,则生成结构化反馈(如“需要查找包含‘2021年基数’的页面”)给侦察员。

3.3 审核员:严谨的“最终守门人”

- 职责:独立审查分析师给出的答案,严格校验其结论是否被提供的页面图片完美支撑。

- 价值:若发现证据链断裂或逻辑瑕疵,可强制系统开启新一轮迭代(通常最多3-5轮),形成逻辑一致性闭环。

四、 数据工程:为视觉理解奠定基石

4.1 预处理流水线

- 页面图像化:将PDF每页渲染为300 DPI的高清图像,保留原始视觉信息。

- 混合索引构建:

- 视觉索引:提取页面布局、元素类型等特征。

- 文本索引:通过高质量OCR引擎(如PaddleOCR)提取全文及位置信息。

- 元数据增强:自动标注每页的文档名、页码、包含的组件类型(图/表/文)。

4.2 跨模态融合检索

采用加权融合策略,平衡文本与视觉信息:最终得分 = λ * 文本相似度 + (1-λ) * 视觉相似度

实验表明,针对图表类问题,λ设置在 0.4 左右(即更侧重视觉相似度)时效果最佳。

五、 性能实测:ViDoRAG 效果到底有多强?

我们基于GPT-4o作为核心模型进行了深度测试,结果令人振奋:

| 内容分类 | 传统 RAG | 图像 RAG | ViDoRAG | 提升幅度 |

|---|---|---|---|---|

| 纯文本 | 78.5% | 79.2% | 82.4% | +3.9% |

| 表格 | 52.1% | 68.4% | 76.8% | +24.7% |

| 统计图表 | 45.3% | 65.1% | 78.5% | +33.2% |

| 复杂布局 | 32.8% | 52.6% | 70.2% | +37.4% |

核心结论:

- 对于视觉元素(表格、图表、布局),ViDoRAG带来了质的飞跃,提升幅度远超纯文本。

- 架构赋能:ViDoRAG框架甚至能让Qwen2.5-VL-7B这类开源中等模型,在复杂任务上超越传统架构下的GPT-4-Vision。这证明优秀的系统设计有时比单纯堆砌大模型参数更有效。

六、 总结与展望

ViDoRAG 不仅是一项技术框架,更是一种方法论的革新。它正视了视觉信息在文档理解中的核心地位:

- 通过 GMM 动态召回,解决了“找多少”的难题。

- 通过多智能体协作,解决了“如何看”的难题。

未来演进方向:

- 跨文档推理:从单文档库分析走向跨多个来源的视觉信息关联与推理。

- 交互式修正:支持用户点击图像区域进行交互,实时纠正和引导AI的检索方向。

- 更强的多语言支持:优化对中文、日文等复杂排版文档的处理能力。

- 社区与开源:该项目已在GitHub提供相关脚本与预训练权重,助力社区共同推进技术发展。

让我们共同期待,ViDoRAG 所引领的视觉富文档智能处理新时代。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)