告别模型选型焦虑:基于AI Ping+Coze搭建智能网关,实现多模型统一调度与成本优化

当前大模型技术快速发展,但模型服务的碎片化成为企业应用的瓶颈。AI Ping作为智能模型网关,通过统一API接口和协议转换,将各厂商API封装为标准OpenAI格式,简化接入流程。其核心智能路由引擎基于实时性能数据(延迟、吞吐量、成本等)实现动态调度,支持价格优先、延迟优先等策略。结合Coze平台,可构建具备故障自愈和成本优化能力的工作流,实现对话、绘图等多功能集成。AI Ping还提供细粒度成本

一、引言

当前,大模型技术正快速从实验室研究走向规模化商业落地。随着智谱、MiniMax、DeepSeek、通义千问等头部厂商在性能、场景与成本上展现出差异化优势,市场呈现百花齐放的繁荣态势,但热闹背后,模型服务的碎片化已成了隐形瓶颈。

对企业来说,问题早已不是“用不用大模型”,而是“怎么用才不踩坑”。选型不再是简单的产品对比,更像是一场需要持续算账的技术博弈:各家服务商的延迟、吞吐量、计费规则千差万别,关键指标往往锁在各自的“黑盒”里,还随时可能因为负载波动而变脸。靠静态的基准测试做决策,无异于用昨天的地图找今天的路,迟早撞墙。

好不容易选定了供应商,工程层面的麻烦才刚刚开始。A 家的 API、B 家的鉴权、C 家的错误码,每接一家就要重写一遍适配逻辑,多供应商容灾更加大了开发复杂度。可如果只绑死一家,又等于把应用的命脉交到了别人手里——稳定性、议价权、灵活性,全成了外部风险。

基于此,构建一个具备治理能力的模型中台或智能模型网关,已成为行业共识。通过智能网关抽象底层差异,用统一接口纳管多源模型,企业才能在享受技术多样性的同时,保持架构的清爽与可控。

本文将以此为背景,深入介绍如何基于 AIping 的统一 API、智能路由能力,结合 Coze平台的 工作流,构建具备故障自愈、成本感知与动态优化能力的工作流。我们将从架构设计出发,以一个真实业务场景为例,系统阐述从技术原理到落地实践的全链路实现方案。

二、技术蓝图:AI Ping 智能模型网关的架构与核心机制

AI Ping正是这样一款一站式 AI 评测与 API 服务智能路由平台,其核心价值在于其作为智能模型网关的角色,它承担着协议转换、性能监控、智能决策和高可用保障的职责。

#

2.1 统一 API 接口与协议转换

AI Ping 将所有主流大模型服务商的私有 API 协议,统一封装为兼容 OpenAI Chat Completion API 的标准接口。这一设计至关重要,它使得任何基于 OpenAI SDK 开发的应用,都能够以极低的成本接入 AI Ping。

开发者只需将 base_url 指向 AI Ping 的统一入口,即可实现对所有聚合模型的访问。当请求到达 AI Ping 网关时,网关会根据内部的路由决策,将标准的 OpenAI 请求实时转换为目标服务商的私有协议,并进行转发。在接收到响应后,网关还会执行响应归一化,确保无论底层模型是哪个厂商,返回的数据结构都是一致的,从而保证了应用层的稳定性和可维护性。

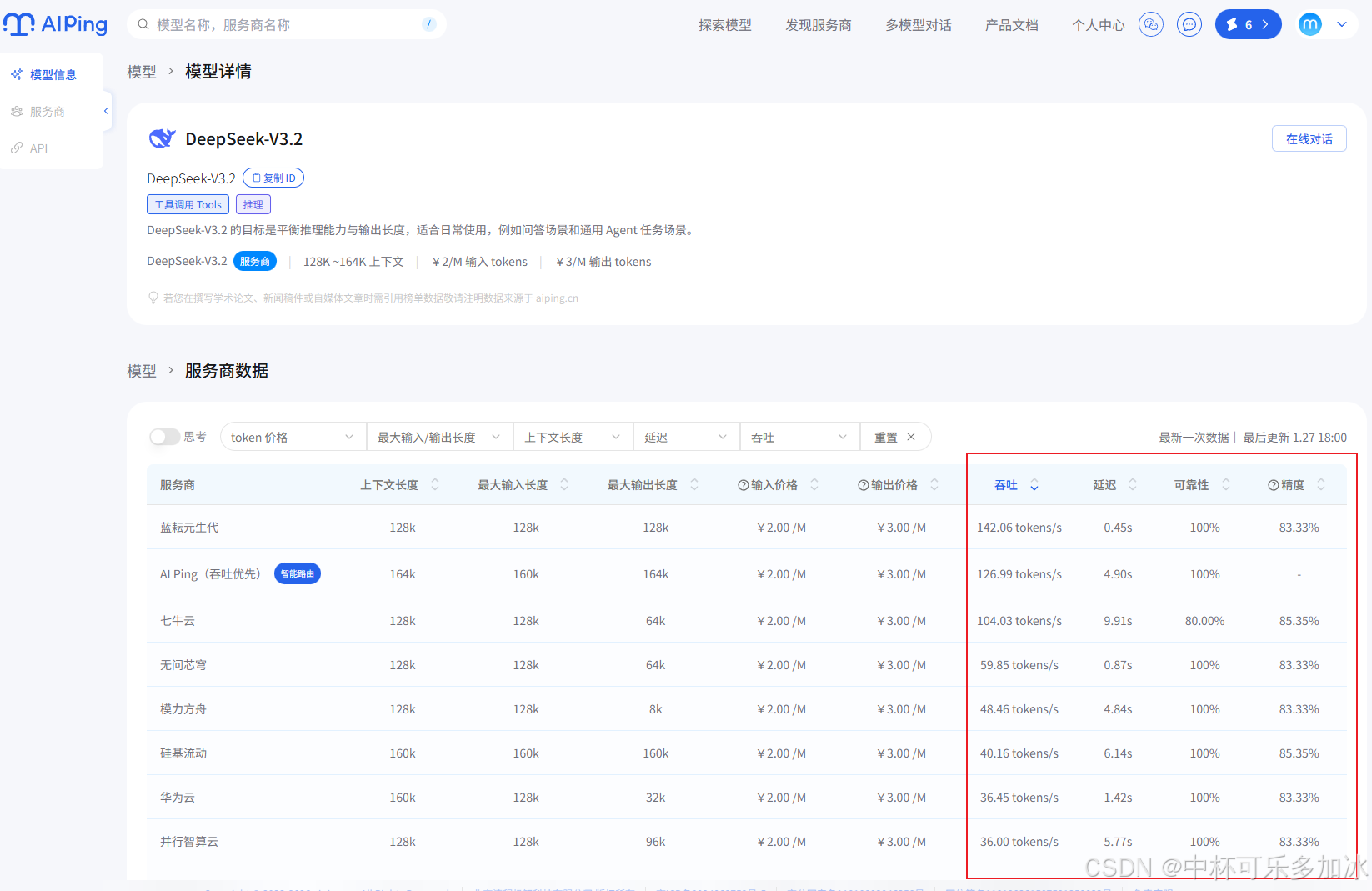

2.2 智能路由引擎与动态调度机制

AI Ping 的智能路由引擎是其技术核心。它并非简单的负载均衡,而是一个基于实时数据驱动的动态调度系统。该引擎持续监控所有集成模型服务商的性能指标,包括延迟(Latency)、吞吐量(Throughput)、服务可靠性以及最新的 Token 价格。

开发者通过在请求体中注入一个扩展字段 extra_body,特别是其中的 provider 对象,来定制路由策略。provider 对象允许开发者定义复杂的调度规则,例如:

- 价格优先:通过

sort: ["output_price", "input_price"]策略,系统将优先选择当前输出价格最低的模型,在价格相同时,再比较输入价格。这适用于对成本敏感的后台任务或高频的日常咨询。 - 延迟优先:通过

sort: "latency"策略,系统将实时查询性能榜单,将请求路由到当前 P90 延迟最低的服务商。这适用于对实时性要求极高的场景,如实时对话或交易决策。 - 多关键字混合策略:例如

sort: ["latency", "throughput"],允许开发者在保证低延迟的前提下,进一步优化吞吐量,实现性能的精细化平衡。

这种机制将复杂的模型选型决策从业务逻辑层彻底剥离,下沉到 AI Ping 的网关层,极大地简化了开发和编排难度,使得业务逻辑能够专注于“做什么”,而不是“用哪个”。

三、基于Coze和AI Ping搭建一站式工作流

基于以上分析,我们接下来尝试使用详细展示如何将 AI Ping 的能力融入 Dify,构建一个具备动态路由和高性能 RAG 能力的生产级应用。

3.1 鉴权获取与环境准备

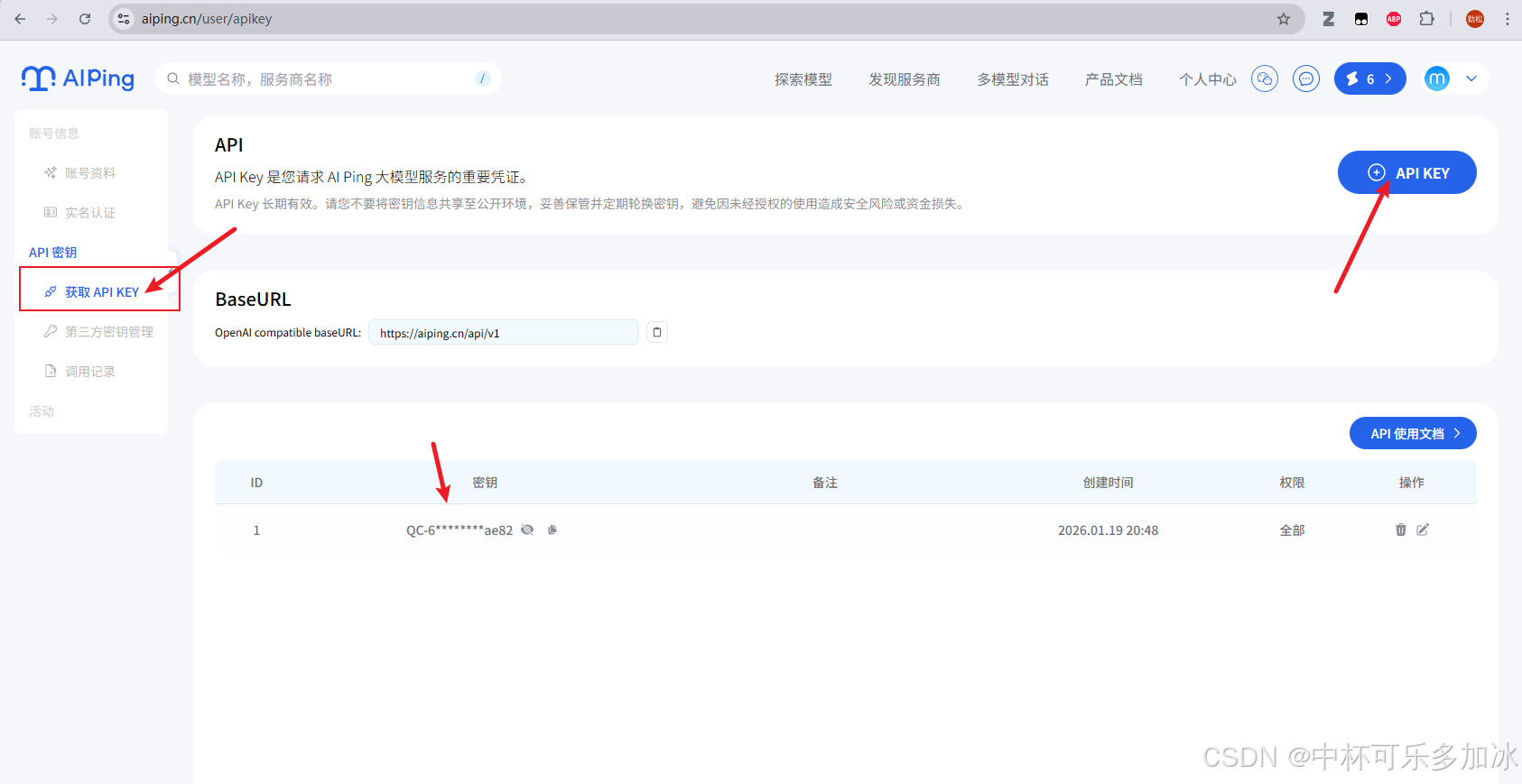

在 AI Ping 平台接入 Coze 之前,需完成基础鉴权配置。需要首先登录 AI Ping 管理后台,点击获取API KEY,可以看到API KEY,注册账号时,系统会默认为您创建一个 API Key。若需新增,点击右上角的 “API KEY” 按钮即可创建新的 API Key:

生成的密钥用于识别调用方身份,并作为后续在 Coze 插件节点中进行模型调度的全局凭证。后续只需要在代码里替换对应的Authorization即可完成调用

import requests

headers = {

'Authorization': '<API_KEY>',

'Content-Type': 'application/json',

}

response = requests.post('https://aiping.cn/api/v1/chat/completions', headers=headers, json={

'model': 'DeepSeek-R1-0528',

'messages': [

{

'role': 'user',

'content': 'What is the meaning of life?'

}

]

}

})

response.encoding = 'utf-8'

print(response.text)

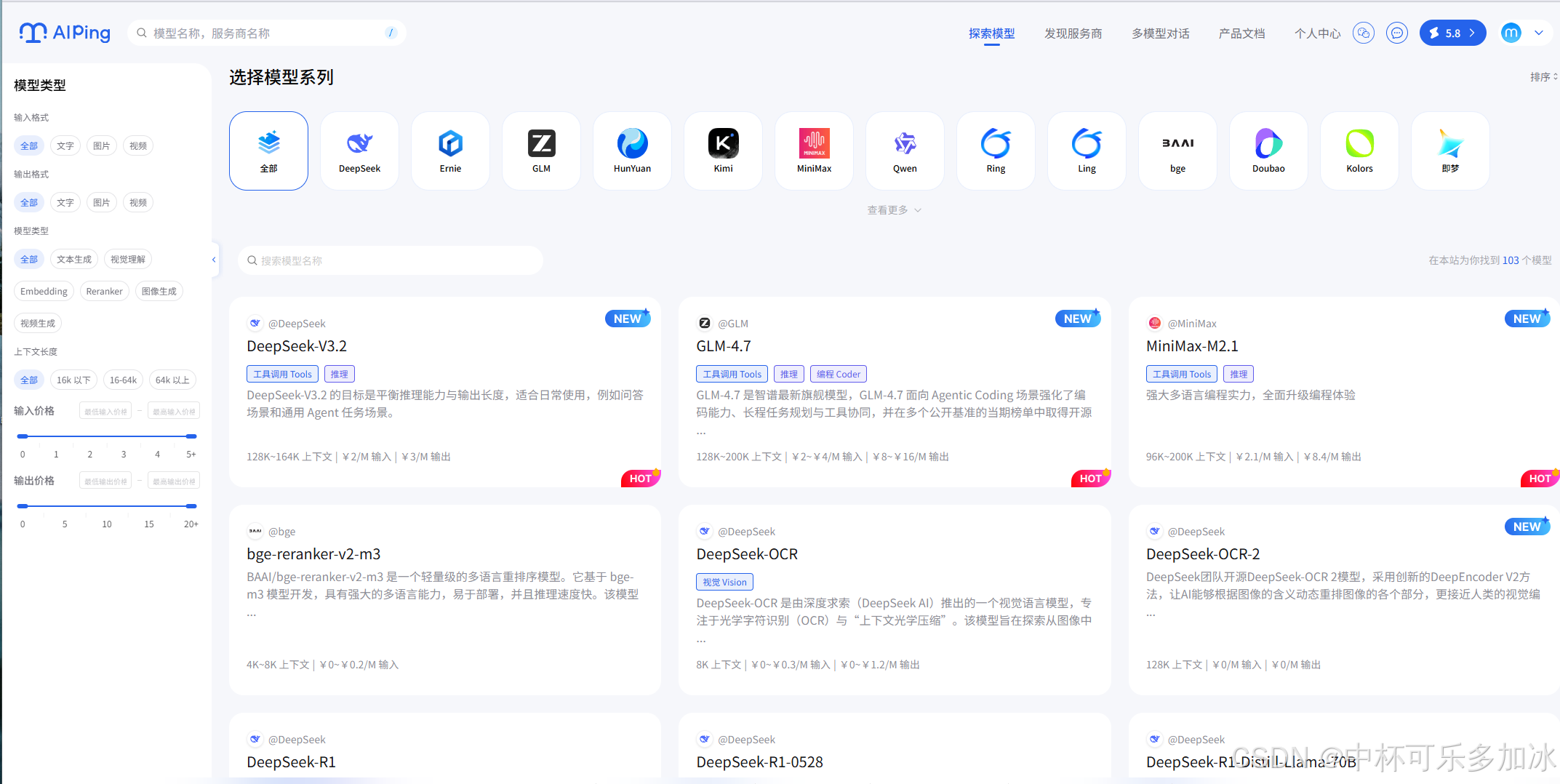

然后我们可以点击首页上方导航栏的探索模型,可以看到 AI Ping 目前已接入的所有模型。可以通过"搜索栏"、"选择模型系列"等功能快速筛选您所需要的模型。查看各模型服务商(如 OpenAI, Anthropic, DeepSeek 等)的实时性能指标,包括延迟(Latency)、吞吐量(Throughput)及单位 Token 成本,作为后续配置路由策略的参考依据。

3.2 Coze 平台接入

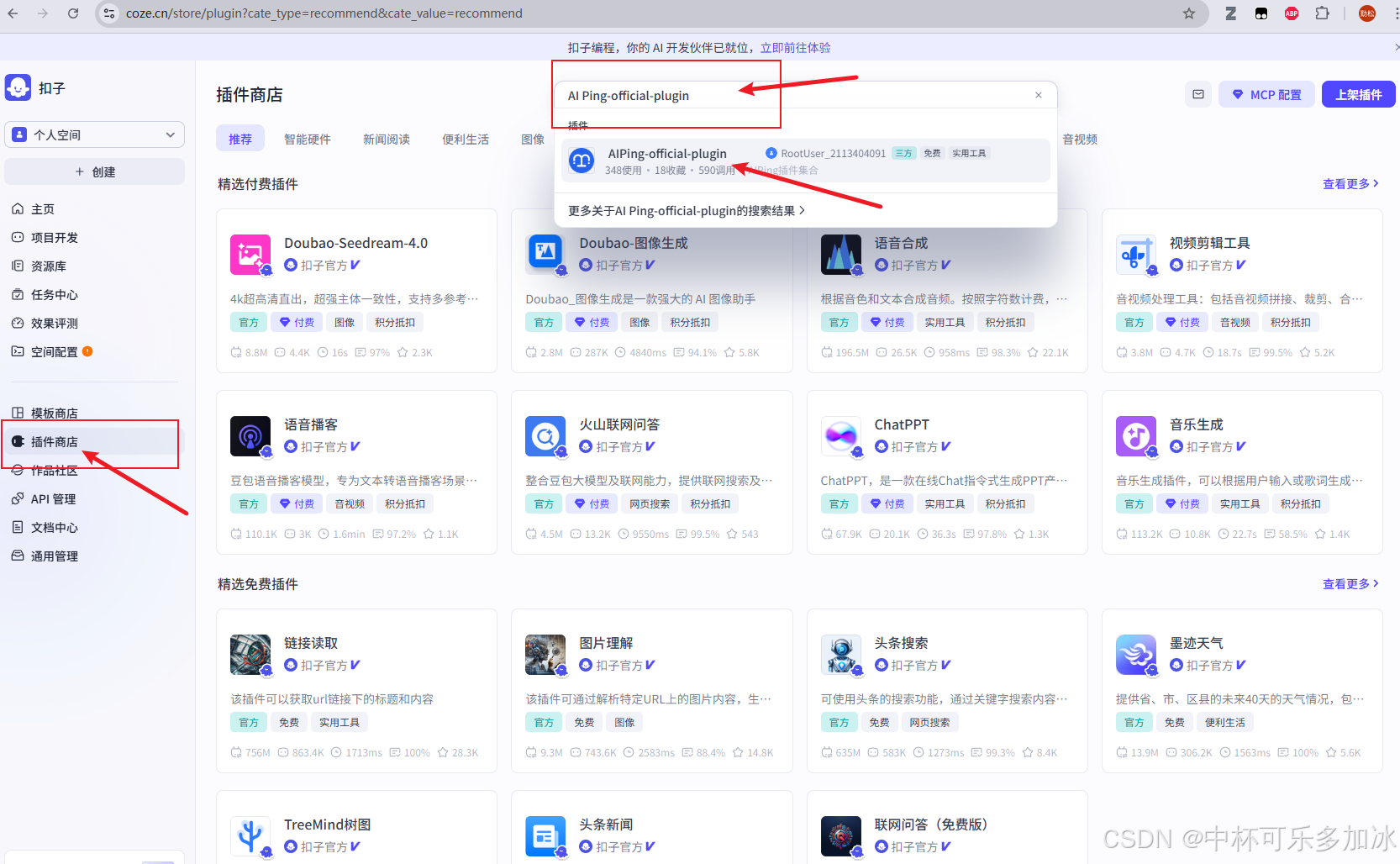

下面,我们在 Coze 环境中,AI Ping 的能力通过插件形式集成。具体操作路径如下:首先点击进入Coze平台https://www.coze.cn/home

进入 Coze 插件市场,检索 AI Ping-official-plugin插件

点击收藏后,该插件及其内置工具集(如 LLM_VLM, Embedding, Reranker)即可在工作流节点中被调用。

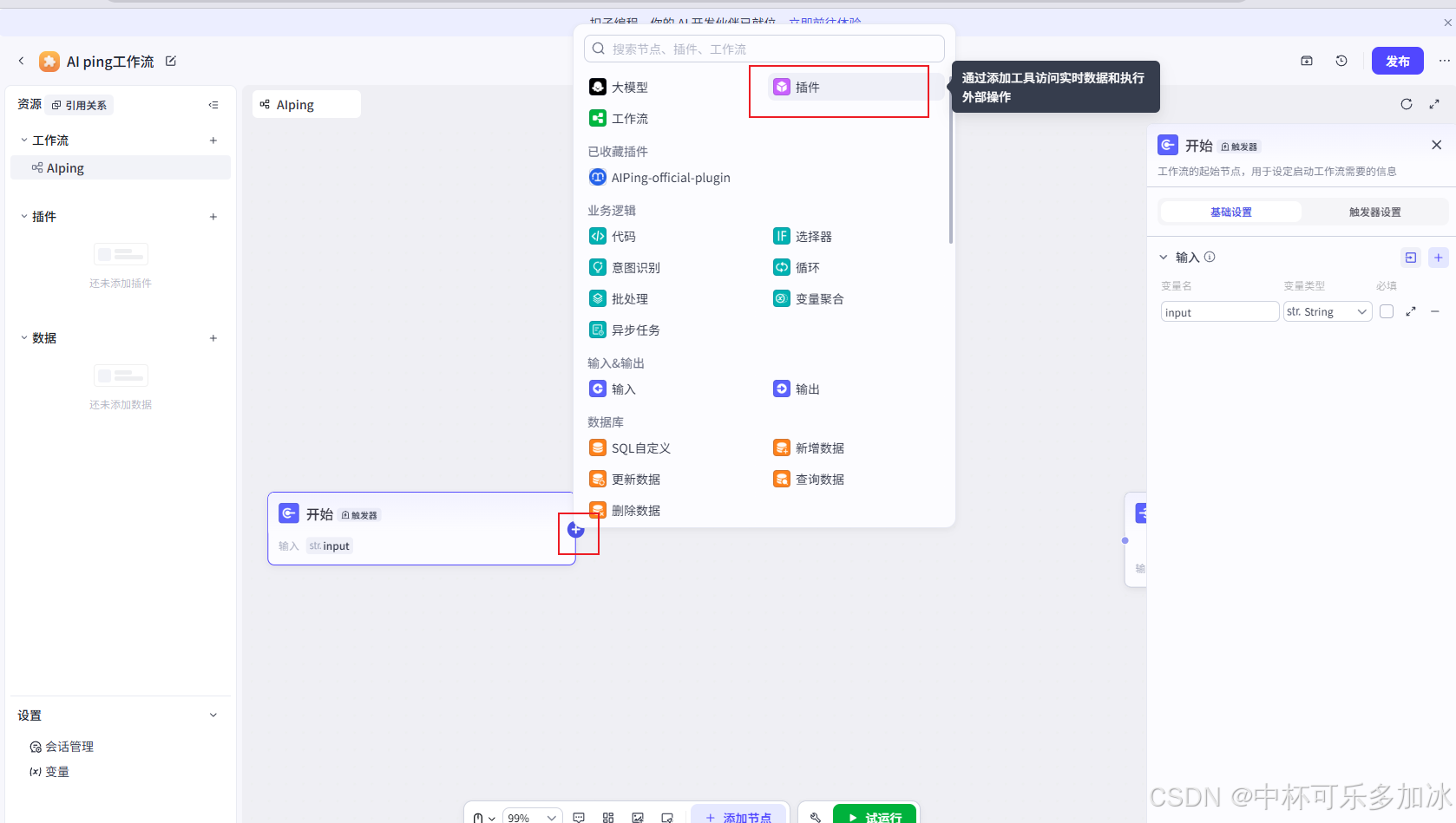

其次,我们创建一个工作流,在其中添加插件节点,选择刚刚收藏的AIPing-official-plugin接入工作流

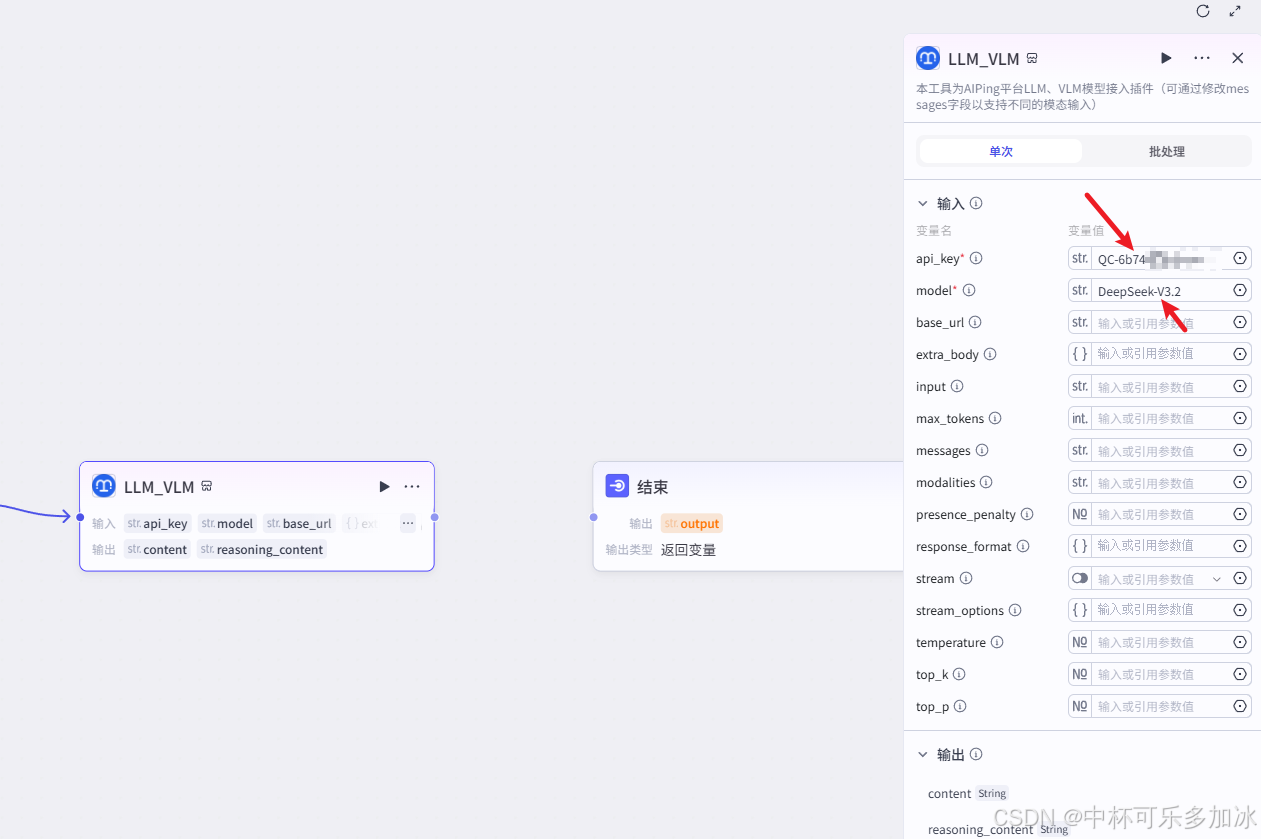

插件中可能包含多个工具,选择需要的工具添加到工作流中使用即可。这里选择最基础的文本生成插件:LLM_VLM

在节点的参数配置界面,将刚刚获取的 api-key 填入对应字段,然后填入model名,这里我选择了DeepSeek模型

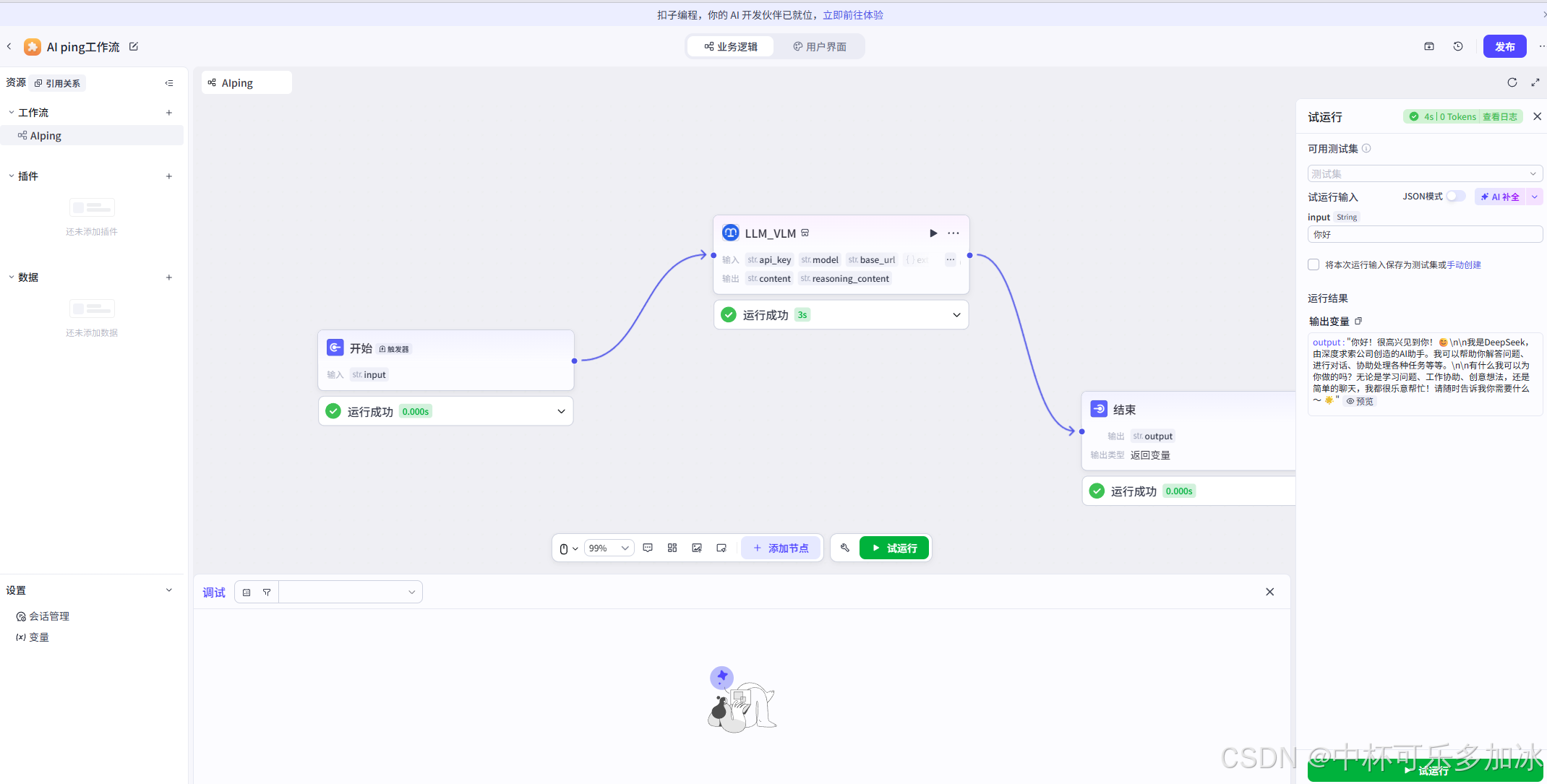

最后将开始节点的input接入到LLM_VLLM的输入input,将LLM_VLLM的输出接入到结束节点的output,就搭建好了一个最基础的对话工作流了,点击试运行就可以看到成功调用到了DeepSeek模型

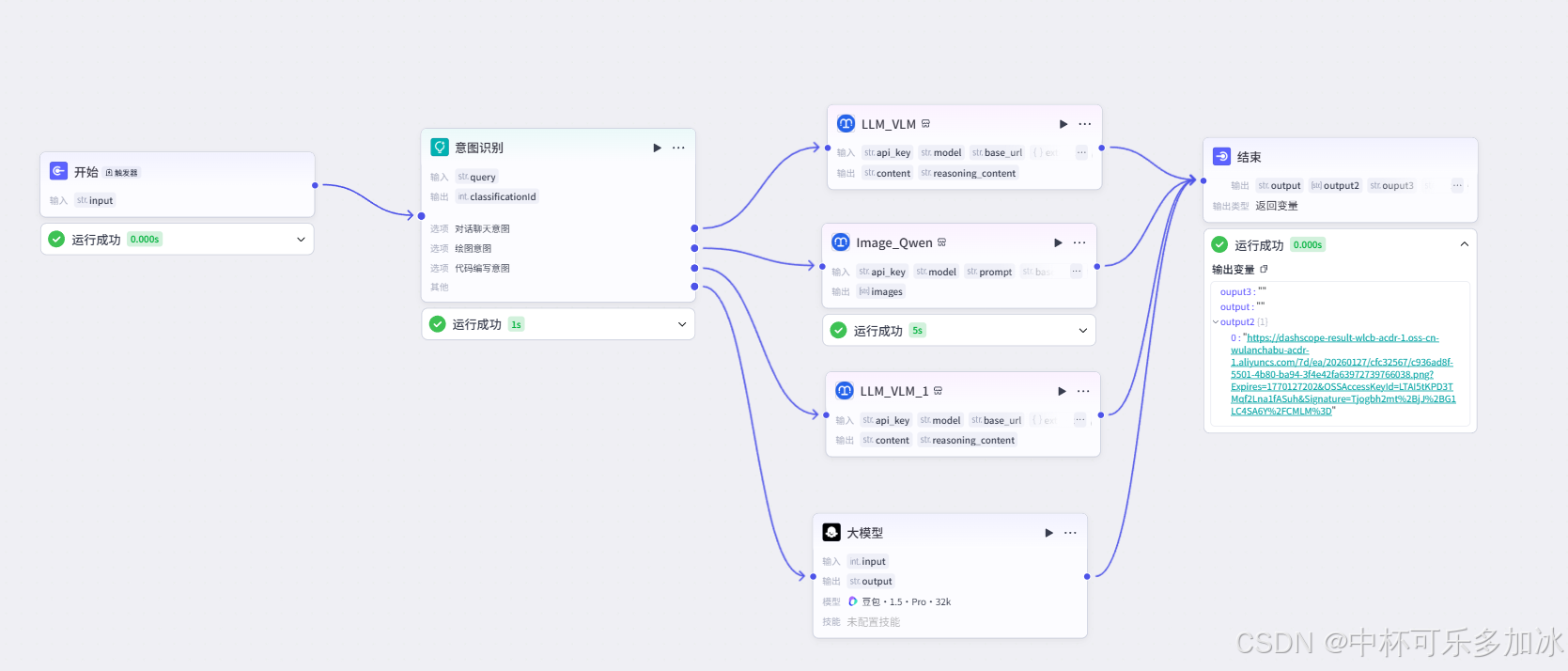

同理我们这里也可以接入AI Ping集成的画图模型比如Qwen-Image和即梦图片生成 4.0模型,用一个一站式 AI 评测与 API 服务智能路由平台集成了所有需要的模型。

基于此,我们可以利用 LLM 节点对用户输入进行语义解析,将任务划分为不同的类别(例如:高时效性查询、长文本分析、低成本批处理)。该节点的输出将作为后续路由逻辑的输入参数,自此,搭建起一个集对话聊天意图、绘图意图、代码编写意图等等于一体的工作流:

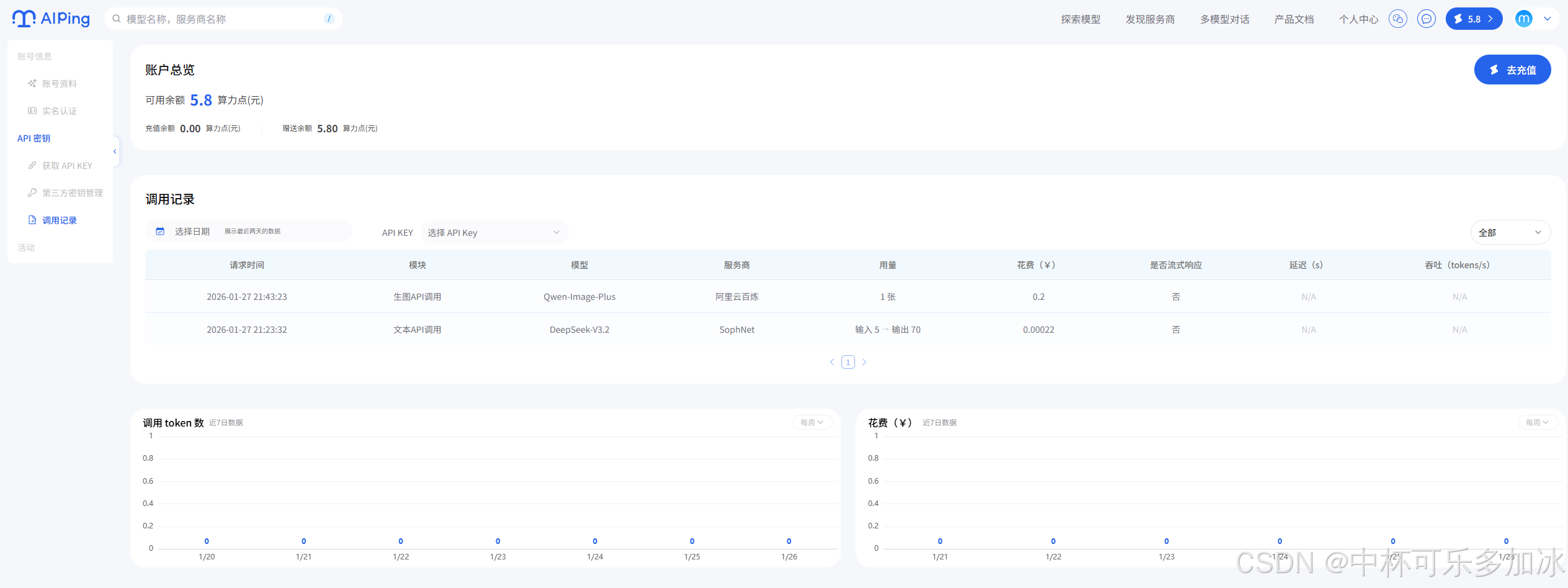

构建 Agent 只是第一步,在生产环境中,持续的模型资产治理和成本性能优化才是决定项目成败的关键。AI Ping 的价值并未止步于实时调度,其提供的个人数据中心功能,为部署后的治理提供了透明、细粒度的数据支撑。

AI Ping 记录了每一次 API 调用的详细信息,包括实际使用的模型、服务商、Token 消耗量(Prompt Token 和 Completion Token)以及实际产生的费用。这种细粒度的数据报表,使得开发者能够进行精确的成本归因分析。我们可以清晰地追踪到 工作流中各自的 Token 消耗占比和成本占比。

除此之外,在传统的单供应商架构中,一旦模型服务商出现 API 响应超时或服务中断(如 502/504 错误),业务端将直接陷入瘫痪。AI Ping 通过其内置的高可用路由机制,彻底解决了这一痛点。在业务高峰期,我们可以通过 AI Ping 设置“性能优先”策略,确保响应速度;而在非核心时段,则自动切换为“成本优先”策略,调用性价比更高的模型。

通过这种方式,企业不再是盲目地“花钱买算力”,而是拥有了一套精细化的模型资产管理工具,让每一分 Token 成本都花在刀刃上。

四、总结与展望

通过 Coze 与 AI Ping 的实战验证,AI Ping 作为智能模型网关,主要解决了企业大模型应用的工程化问题。它在应用层与模型层之间建立了稳定的抽象层,带来三个具体收益:

- 架构解耦。 统一 API 接口将多模型接入的复杂性内化,业务逻辑不再依赖特定供应商的实现细节,降低切换成本

- 动态调度。 智能路由基于实时性能数据,在延迟、成本、可用性之间进行权衡,支持按业务需求(如延迟敏感型或成本优先型)配置策略,优化资源使用效率。

- 运维保障。 故障自愈机制在节点异常时自动切换,配合全链路监控与日志,提供生产环境所需的稳定性和可观测性。

随着大模型能力的进一步增强和多模态应用的爆发,AI 基础设施的复杂性将持续上升。AI Ping 未来将不仅仅是一个简单的路由网关,它更像是一个 AI 时代的“操作系统内核”,负责管理、调度和优化底层异构的算力资源。

对于开发者和企业而言,拥抱 AI Ping 这样的智能治理平台,意味着可以从繁琐的底层适配和运维中解放出来,将更多精力投入到业务场景的创新中。在 AI 普惠的道路上,AI Ping 正在成为连接强大算法与稳定商业应用之间最坚固的桥梁。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)