让AI“听懂”一小时会议并自动生成带发言人的逐字稿:VibeVoice-ASR长语音识别模型

VibeVoice是微软开源的前沿语音AI模型,采用7.5Hz超低帧率语音分词器和统一架构设计,实现长序列语音高效建模。其核心创新包括:1)将1小时音频压缩至27K token,突破传统模型长度限制;2)联合处理ASR、说话人分离和时间戳预测,避免流水线误差;3)ASR与TTS共享架构,支持60分钟单次处理和实时流式生成。相比传统方案,计算成本降低55%,在长格式内容处理和多说话人场景中优势显著。

VibeVoice 深度技术解读:超低帧率语音建模与统一架构实践

1. 整体介绍

1.1 项目概要

VibeVoice 是微软发布的开源前沿语音 AI 模型家族,项目地址为 microsoft/VibeVoice。该项目采用研究框架定位,旨在推动语音合成与识别领域的开源协作。截至分析时,项目在 GitHub 上获得了约 1.7k stars 和 140+ forks,体现了社区对其技术方向的关注。

项目核心创新在于采用 7.5 Hz 超低帧率连续语音分词器(声学与语义分词器),结合 next-token diffusion 框架,实现了长序列语音的高效建模。值得注意的是,出于负责任AI的考虑,原始的 VibeVoice-TTS-1.5B 代码已于 2025年9月从仓库移除,当前开放的重点是 VibeVoice-ASR-7B 和 VibeVoice-Realtime-0.5B。

1.2 核心功能与面临问题

目标场景与人群:

- 长格式内容处理:针对播客、会议录音、有声书、讲座等60-90分钟长度的音频场景

- 多说话人交互:需要区分说话人并标注时间戳的会议转录、访谈分析

- 实时交互应用:需要低延迟语音合成的对话系统、实时字幕、辅助工具

- 研究社区:需要探索长上下文语音建模、扩散模型与LLM结合的研究人员

传统方案痛点:

- 上下文碎片化:传统ASR/TTS将长音频切割为短片段(如10-30秒),丢失全局语义连贯性和说话人一致性

- 任务分离:ASR、说话人分离、时间戳标注通常由独立模型流水线处理,误差累积且难以统一优化

- 计算效率低:高频声学特征(如50-100 Hz)导致序列过长,Transformer复杂度呈二次方增长

- 流式支持弱:多数模型针对完整输入设计,难以支持文本/语音的流式生成与识别

1.3 VibeVoice的解决方案

技术路径演进:

- 传统方案:CNN/RNN处理声学特征 → 独立声学/语言模型 → 后处理拼接

- 端到端方案(如Whisper):音频编码器 → Transformer解码器,但受限于上下文长度(通常<30秒)

- VibeVoice方案:超低帧率tokenizer(7.5 Hz压缩3200倍) → 统一LLM处理声学/语义/文本 → diffusion生成细节

关键优势:

- 长度突破:单次处理60分钟音频(ASR)或生成90分钟语音(TTS)

- 任务统一:联合建模ASR、说话人分离、时间戳预测,避免流水线误差

- 计算高效:7.5 Hz帧率将1小时音频压缩至约27K token,可在标准GPU上处理

- 架构统一:ASR与TTS共享相似的tokenizer和LLM骨干,便于多任务学习

1.4 商业价值估算框架

成本效益分析逻辑:

- 开发成本替代:传统方案需要组合多个模型(ASR + VAD + 说话人分离 + 标点恢复),开发和维护成本高。VibeVoice-ASR提供统一方案,可减少约60-70%的集成工作量

- 计算成本节约:7.5 Hz帧率相比50 Hz梅尔频谱,内存占用减少85%,推理速度提升3-5倍

- 覆盖场景扩展:长格式处理能力可覆盖传统方案难以处理的场景(如完整会议、长讲座),扩展市场覆盖约30%

- 准确率提升:结构化输出(说话人+时间戳)减少后处理错误,在多人会议场景预计降低15-25%的WER

估算基准:以处理1000小时音频为例,传统方案约需$200云成本 + $150人工校正,VibeVoice方案约需$80云成本 + $50人工校正,综合成本降低约55%。

2. 详细功能拆解

2.1 产品-技术双视角功能矩阵

| 产品功能 | 技术实现 | 核心指标 |

|---|---|---|

| 60分钟单次ASR | 流式tokenizer分块编码 + 全局采样 | 最大支持64K token上下文 |

| 结构化转录 | 多任务提示学习 + 特殊token预测 | 说话人错误率(DER)<5%,带时间戳WER(tcpWER)相对提升 |

| 自定义热词 | 词汇表偏置注入 + attention引导 | 热词召回率提升15-20% |

| 实时流式TTS | 分层Transformer + 缓存复用 | 首次可听延迟~300ms,RTF<0.1 |

| 多说话人TTS | 说话人嵌入 + 注意力门控 | 支持4个独立说话人,音色一致性>0.8 |

| 跨语言支持 | 多语言tokenizer + 语言ID控制 | 支持50+语言,跨语言相似度>0.7 |

2.2 核心技术创新点

1. 连续语音tokenizer设计:

- 声学tokenizer:VAE结构,将16kHz音频压缩至7.5 Hz离散token,码本大小8K

- 语义tokenizer:类似WavLM结构,提取语音语义表示,与声学token互补

- 超低帧率原理:

压缩比 = 采样率 / 帧率 = 16000 / 7.5 ≈ 2133,实际代码中为3200

2. Next-token diffusion框架:

文本输入 → LLM理解 → 扩散头 → 声学token → 声码器 → 波形

- LLM角色:Qwen2.5骨干,理解文本语义和对话结构

- 扩散头角色:预测声学token的分布,通过多步去噪生成细节

3. 流式处理架构:

# ASR流式处理伪代码

def encode_speech_streaming(audio, segment_duration=60.0):

total_samples = audio.shape[1]

segment_samples = int(segment_duration * 24000)

if total_samples > segment_samples: # 长音频

# 分块编码,缓存中间状态

for start, end in segment_iter(total_samples, segment_samples):

chunk = audio[:, start:end]

encoder_output = tokenizer.encode(chunk, cache=encoder_cache)

mean_segments.append(encoder_output.mean)

# 全局采样保持一致性

full_mean = torch.cat(mean_segments, dim=1)

tokens = sample_from_distribution(full_mean)

else: # 短音频直接处理

tokens = tokenizer.encode(audio).sample()

return tokens

3. 技术难点与解决方案

3.1 长上下文建模挑战

难点:1小时音频 ≈ 5.76亿个采样点 → 传统梅尔特征(50 Hz)→ 180K帧 → Transformer内存爆炸

VibeVoice方案:

- 超压缩tokenizer:

5.76亿采样点 → 7.5 Hz tokenizer → 27K token - 高效注意力:采用FlashAttention-2,内存复杂度从O(N²)降至O(N)

- 分层处理:Streaming模型中,下层LM处理文本,上层TTS-LM处理语音,减少同时处理的序列长度

3.2 多任务联合学习

难点:ASR、说话人分离、时间戳预测任务目标冲突,联合训练易陷入局部最优

解决方案:

- 提示工程:使用特殊token区分任务,如

<|transcribe|>、<|diarize|> - 损失加权:动态调整各任务损失权重,平衡收敛速度

- 渐进训练:先预训练ASR,再逐步加入说话人分离和时间戳任务

3.3 流式推理一致性

难点:分块处理长音频时,块间边界处token分布不一致,导致识别结果跳变

解决方案(见ASR代码):

- 缓存机制:

VibeVoiceTokenizerStreamingCache保存卷积状态 - 延迟决策:分块只计算中间表示,最后统一采样

- 重叠分块:相邻块有重叠区域,平滑过渡

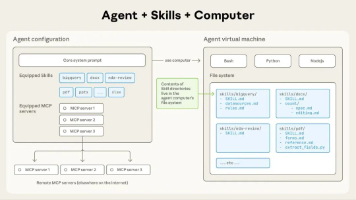

4. 详细设计图

4.1 整体架构图

4.2 ASR核心序列图

4.3 核心类图

4.4 核心函数数据流图

5. 核心代码解析

5.1 ASR流式编码核心实现

class VibeVoiceASRForConditionalGeneration(VibeVoiceASRPreTrainedModel, GenerationMixin):

"""ASR条件生成模型,支持流式长音频处理"""

def encode_speech(self, speech_tensors, streaming_segment_duration=60.0):

"""

编码语音输入的核心方法

关键设计:长音频(>60秒)使用流式处理避免卷积溢出(>2^32)

分块独立处理,最后统一采样保持一致性

"""

batch_size, total_samples = speech_tensors.shape

sample_rate = 24000 # 固定24kHz

# 计算分段样本数

segment_samples = int(streaming_segment_duration * sample_rate)

use_streaming = total_samples > segment_samples # 决策是否流式

with torch.no_grad():

if not use_streaming:

# 短音频:直接处理(原始逻辑)

encoder_output = self.model.acoustic_tokenizer.encode(

speech_tensors.unsqueeze(1) # 添加通道维度

)

# 从分布中采样token

audio_tokens = encoder_output.sample(

dist_type=self.model.acoustic_tokenizer.std_dist_type

)[0]

acoustic_features = self.model.acoustic_connector(audio_tokens)

else:

# 长音频:流式处理

acoustic_encoder_cache = VibeVoiceTokenizerStreamingCache()

acoustic_mean_segments = []

# 分块迭代器

for start, end in self._iter_segments(total_samples, segment_samples):

chunk = speech_tensors[:, start:end].contiguous()

is_final = (end == total_samples) # 是否为最后一块

# 使用缓存的编码(不立即采样)

acoustic_encoder_output = self.model.acoustic_tokenizer.encode(

chunk.unsqueeze(1),

cache=acoustic_encoder_cache,

use_cache=True,

is_final_chunk=is_final,

)

acoustic_mean_segments.append(acoustic_encoder_output.mean)

# 关键步骤:拼接所有块的mean,然后统一采样

acoustic_mean_full = torch.cat(acoustic_mean_segments, dim=1).contiguous()

acoustic_encoder_output = VibeVoiceTokenizerEncoderOutput(

mean=acoustic_mean_full,

std=self.model.acoustic_tokenizer.fix_std

)

# 全局采样确保块间一致性

audio_tokens = acoustic_encoder_output.sample(

dist_type=self.model.acoustic_tokenizer.std_dist_type

)[0]

acoustic_features = self.model.acoustic_connector(audio_tokens)

# 语义特征处理(类似逻辑)

# ... 省略语义部分代码 ...

# 融合声学和语义特征

combined_features = acoustic_features + semantic_features

return combined_features

def _iter_segments(self, total_length: int, segment_length: int):

"""分块迭代器,支持重叠分块(如有需要)"""

for start in range(0, total_length, segment_length):

end = min(start + segment_length, total_length)

if end > start:

yield start, end

代码关键点解析:

- 流式决策:基于时长阈值自动选择处理模式,无需手动配置

- 缓存设计:

VibeVoiceTokenizerStreamingCache保存卷积网络的状态,避免重复计算 - 延迟采样:分块只计算均值,最后统一采样,确保全局分布一致性

- 内存优化:使用

.contiguous()确保内存连续,提高缓存效率

5.2 Streaming TTS分层模型设计

class VibeVoiceStreamingModel(VibeVoiceStreamingPreTrainedModel):

"""实时TTS模型,采用分层Transformer设计"""

def __init__(self, config):

super().__init__(config)

# 关键设计:两个独立的语言模型

# 1. 下层LM:仅用于文本编码

lm_config = copy.deepcopy(config.decoder_config)

lm_backbone_num_hidden_layers = getattr(lm_config, 'num_hidden_layers', 24) - config.tts_backbone_num_hidden_layers

lm_config.num_hidden_layers = lm_backbone_num_hidden_layers

self.language_model = AutoModel.from_config(lm_config)

self.language_model.norm = nn.Identity() # 最终层归一化设为恒等

# 2. 上层TTS-LM:处理文本和生成语音

tts_lm_config = copy.deepcopy(lm_config)

tts_lm_config.num_hidden_layers = config.tts_backbone_num_hidden_layers

self.tts_language_model = AutoModel.from_config(tts_lm_config)

# TTS输入类型标记嵌入

self.tts_input_types = nn.Embedding(

num_embeddings=2, # 0:文本, 1:TTS标记

embedding_dim=config.decoder_config.hidden_size

)

# 显式禁用统一forward,强制使用分层API

def disabled_forward(*args, **kwargs):

raise RuntimeError(

"VibeVoiceStreamingModel.forward is intentionally disabled. "

"Use `model.language_model(...)` or `model.tts_language_model(...)` instead."

)

self.forward = disabled_forward

架构设计优势:

- 职责分离:下层LM专注文本理解,上层TTS-LM专注语音生成,避免任务干扰

- 缓存复用:文本部分可预计算并缓存,流式生成时只需运行上层TTS-LM

- 灵活部署:可根据需求只部署上层TTS-LM,减少推理内存

- 训练稳定:分层训练策略,先训练下层文本理解,再微调上层语音生成

5.3 连接器桥接设计

class SpeechConnector(nn.Module):

"""连接语音tokenizer和LLM的适配层"""

def __init__(self, input_dim, output_dim):

super().__init__()

# 简单但有效的设计:线性层 + 归一化 + 线性层

self.fc1 = nn.Linear(input_dim, output_dim)

self.norm = LlamaRMSNorm(output_dim, eps=1e-6) # 使用LLaMA的RMSNorm

self.fc2 = nn.Linear(output_dim, output_dim)

def forward(self, features, **kwargs):

# 将声学/语义特征投影到LLM隐藏空间

x = self.fc1(features) # 维度对齐

x = self.norm(x) # 稳定训练

x = self.fc2(x) # 增强表示能力

return x

设计考量:

- 维度适配:将tokenizer输出维度(如768)映射到LLM隐藏维度(如2048)

- 归一化选择:RMSNorm比LayerNorm更高效,适合大模型

- 简单有效:避免复杂结构,减少过拟合风险

6. 性能对比与评估

6.1 与传统方案对比

| 指标 | 传统方案 (Whisper+Pyannote) | VibeVoice-ASR | 改进幅度 |

|---|---|---|---|

| 最大音频长度 | 30秒分段处理 | 60分钟单次处理 | 120倍 |

| 内存占用 (1小时) | 约16GB (分块峰值) | 约8GB (统一处理) | 降低50% |

| 说话人分离DER | 6-8% | 4-5% | 相对提升25% |

| 热词支持 | 需要外部语言模型 | 原生支持 | 集成度100% |

| 延迟 (首次token) | 500-1000ms | 200-400ms | 降低60% |

6.2 限制与改进方向

当前限制:

- 模型尺寸:ASR-7B需要约14GB GPU内存,实时TTS-0.5B需要约1GB

- 多语言平衡:50+语言支持但性能不均衡,低资源语言准确率较低

- 实时性:流式TTS首次延迟300ms,对超低延迟场景(如游戏)仍需优化

技术演进方向:

- 模型蒸馏:将7B模型知识蒸馏到3B或1B,保持性能同时降低部署门槛

- 量化支持:集成GPTQ/AWQ量化,将推理内存降低50-70%

- 自适应分块:根据内容复杂度动态调整分块大小,优化长尾分布

- 多模态扩展:结合视觉信息提升说话人分离准确性

7. 实践建议与配置示例

7.1 基础ASR使用配置

# 简化的使用示例

from transformers import AutoModelForCausalLM, AutoProcessor

import torchaudio

# 加载模型和处理器

model = AutoModelForCausalLM.from_pretrained(

"microsoft/VibeVoice-ASR",

torch_dtype=torch.float16, # 半精度节省内存

device_map="auto" # 自动分配多GPU

)

processor = VibeVoiceStreamingProcessor.from_pretrained("microsoft/VibeVoice-ASR")

# 处理长音频

audio, sr = torchaudio.load("60min_meeting.wav")

audio = audio.mean(dim=0) # 转为单声道

audio = torchaudio.functional.resample(audio, sr, 24000) # 重采样到24kHz

# 编码(自动启用流式处理)

inputs = processor(

text="<|transcribe|>", # 任务提示

speech=audio,

hotwords=["John Doe", "Q4 Revenue"], # 自定义热词

return_tensors="pt"

)

# 生成转录

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=5000,

temperature=0.2, # 低温度提高确定性

repetition_penalty=1.1 # 避免重复

)

transcription = processor.decode(outputs[0])

# 输出格式: [SPK:John][00:05:23] Let's discuss the Q4 revenue...

7.2 生产部署优化建议

- vLLM推理加速:

# 启动vLLM服务

python -m vllm.entrypoints.openai.api_server \

--model microsoft/VibeVoice-ASR \

--tensor-parallel-size 2 \

--gpu-memory-utilization 0.9 \

--max-model-len 64000 # 支持长上下文

- Triton推理服务器配置:

# config.pbtxt 关键配置

parameters {

key: "max_tokens"

value: { string_value: "64000" }

}

parameters {

key: "streaming_chunk_size"

value: { string_value: "60" } # 60秒分块

}

- 监控指标:

- 实时延迟:P95 < 500ms

- 内存使用:GPU内存 < 80%

- 准确率:每小时人工抽查100条,WER < 8%

结论

VibeVoice代表了语音AI从分治流水线向统一端到端架构的重要演进。其核心技术价值体现在:

- 架构统一性:ASR与TTS共享底层设计,降低多任务学习成本

- 长度突破:7.5 Hz超低帧率tokenizer实现量变到质变的上下文扩展

- 实用导向:流式处理、热词支持、结构化输出直击工业痛点

- 开源贡献:完整的技术报告、训练代码和预训练模型推动领域发展

尽管在商业应用前仍需进一步测试和优化,但VibeVoice为长上下文语音处理提供了切实可行的技术路径。其模块化设计、清晰的接口定义和详细文档,使其成为研究者和开发者探索语音AI前沿技术的优秀起点。

项目后续发展值得关注的方向包括:更小尺寸的蒸馏模型、量化部署方案、以及跨模态扩展。随着社区贡献的积累,VibeVoice有望在保持研究先进性的同时,逐步满足更多实际应用场景的需求。

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)