UI测试在DevOps流水线中的卡点设计:质量保障的智能防线

本文探讨DevOps环境下UI测试卡点(QualityGates)的设计与实践。UI测试卡点通过自动化检测与人工审核机制,在开发、测试、发布三阶段拦截缺陷,需遵循"自动化优先、分层拦截、数据驱动"原则。建议采用Selenium、Cypress等工具实现分层测试,结合AI与跨团队协作优化流程。未来趋势将向预测性质量管控发展,通过历史数据建模实现动态测试调整,帮助团队在保证质量的同

在DevOps高速交付的背景下,UI测试作为用户体验的最终防线,其卡点(Quality Gates)设计直接决定软件质量与发布效率。卡点通过在流水线关键阶段植入自动化检测或人工审核机制,拦截缺陷流入下游,避免因UI问题导致的用户流失或回滚风险。本文将从卡点定义、核心设计阶段、工具策略及未来趋势四方面展开,为测试从业者提供实操指南。

一、UI测试卡点的核心价值与设计原则

UI测试卡点聚焦于验证用户界面的功能性、兼容性和性能,确保代码变更不影响核心用户体验。在DevOps流水线中,其设计需遵循“自动化优先、分层拦截、数据驱动”原则:

-

自动化优先:将UI测试嵌入CI/CD流水线,实现代码提交后自动触发,减少人工遗漏和等待时间。例如,Selenium或Cypress可自动执行跨浏览器测试,覆盖主流设备场景。

-

分层拦截:采用金字塔策略,UI测试仅占10%比重,重点覆盖关键用户旅程(如登录、支付),而非全量覆盖,以平衡效率与质量。

-

数据驱动:基于历史缺陷率、部署成功率等指标动态调整卡点阈值(如响应时间<500ms),实现持续优化。

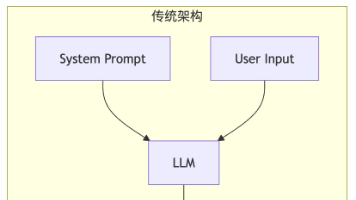

二、DevOps流水线中的关键UI测试卡点阶段

UI测试卡点需贯穿流水线全生命周期,在以下阶段设置强制检查:

-

开发阶段(提交后卡点):

-

目的:预防基础UI缺陷进入测试环境。

-

实施:代码合并前,运行自动化UI冒烟测试,验证核心功能可用性。若测试失败,流水线自动暂停并通知开发者。工具示例:使用Playwright录制用户操作流程,集成到Git钩子中。

-

案例:某电商团队通过此卡点将UI缺陷率降低40%,减少测试返工时间。

-

-

测试阶段(预部署卡点):

-

目的:确保UI兼容性与性能达标,避免部署后故障。

-

实施:在预上线环境执行端到端UI测试,包括:

-

跨浏览器/设备兼容性测试(通过BrowserStack)。

-

性能压测:JMeter模拟高并发用户,验证页面加载时间是否低于阈值。

-

安全扫描:OWASP ZAP检测XSS等漏洞,高危问题必须修复。

-

-

人工干预:设置CheckList卡点,要求测试人员确认关键场景(如支付流程)通过后,方可触发生产部署。

-

-

发布阶段(生产前卡点):

-

目的:最小化线上事故影响。

-

实施:金丝雀发布中,对部分用户流量运行实时UI监控,通过ELK Stack分析用户行为日志,若错误率突增则自动回滚。

-

三、优化卡点效能的工具与创新策略

提升UI测试卡点效率需结合智能工具与跨团队协作:

-

工具链集成:

-

自动化框架:Selenium Grid并行执行测试,配合Allure生成可视化报告。

-

AI赋能:应用AI生成自适应测试用例(如基于代码变更推导测试范围),或实现自愈性脚本(自动修复因UI元素变更导致的失败)。

-

-

协同机制:

-

建立跨职能质量小组(开发、测试、运维),定期复盘卡点规则,避免流程割裂。

-

需求阶段前置卡点:确保UI需求文档(如Figma原型)通过三方评审,明确验收标准,减少开发歧义。

-

四、未来趋势:从卡点到智能质量赋能

随着AI和数据分析的成熟,UI测试卡点正向预测性质量管控演进:

-

风险预测:基于历史数据建模,预测特定代码变更的UI故障概率,动态调整测试强度。

-

持续演进:测试从业者需转型为“质量工程师”,主导卡点设计,推动DevOps文化落地,实现“又快又好”的交付承诺。

结语:UI测试卡点是DevOps流水线的“智能守门员”,其核心价值在于早期风险拦截与资源优化。通过分层自动化、数据驱动和AI集成,测试团队不仅能提升缺陷检出率,还能缩短30%以上的交付周期。未来,卡点设计将更注重预测性与自适应性,成为质量保障的核心竞争力。

精选文章:

更多推荐

已为社区贡献251条内容

已为社区贡献251条内容

所有评论(0)