【报错解决】百分百解决 PyTorch 报错:RuntimeError: CUDA out of memory

RuntimeError: CUDA out of memory 是深度学习训练中常见的显存问题,其根本原因通常是 GPU 显存被占满或分配不合理。通过五重方法可以高效应对:释放或切换 GPU、调小 batch size、定期清理显存、在测试/验证阶段禁用梯度计算,以及调整 DataLoader 的 pin_memory 设置。这些方法既能解决显存不足带来的训练中断,也能优化显存使用效率,保证大模

文章目录

【报错解决】百分百解决 PyTorch 报错:RuntimeError: CUDA out of memory

在训练大模型,尤其是 BERT、GPT 或 Seq2Seq 任务时,开发者经常会遇到这样的报错:

RuntimeError: CUDA out of memory. Tried to allocate XXX MiB ...

显然,这意味着你的 GPU 显存不足,导致 PyTorch 无法分配新的张量空间。本文将结合实战经验,分享 五种高效方法,帮助你在大多数情况下解决这个问题,并保证训练的稳定性。

一、问题背景与原因分析

以 BERT-Seq2Seq 为例,训练过程中报错信息如下:

RuntimeError: CUDA out of memory. Tried to allocate 870.00 MiB (GPU 2; 23.70 GiB total capacity; 19.18 GiB already allocated; 323.81 MiB free; 21.70 GiB reserved in total by PyTorch)

分析可知:

-

GPU 总容量为 23.7 GiB,已经分配了 19.18 GiB,仅剩下 323.81 MiB 空闲显存

-

PyTorch 显存碎片化严重(reserved 显存 21.7 GiB >> allocated 19.18 GiB)

-

典型原因包括:

- GPU 被其他程序占用

- batch size 过大

- 数据加载或内存管理不合理

- 测试/验证阶段没有关闭梯度计算

pin_memory=True导致主机内存过度占用

二、五重方法解决 CUDA 内存不足

方法一:释放 GPU 占用 / 切换 GPU

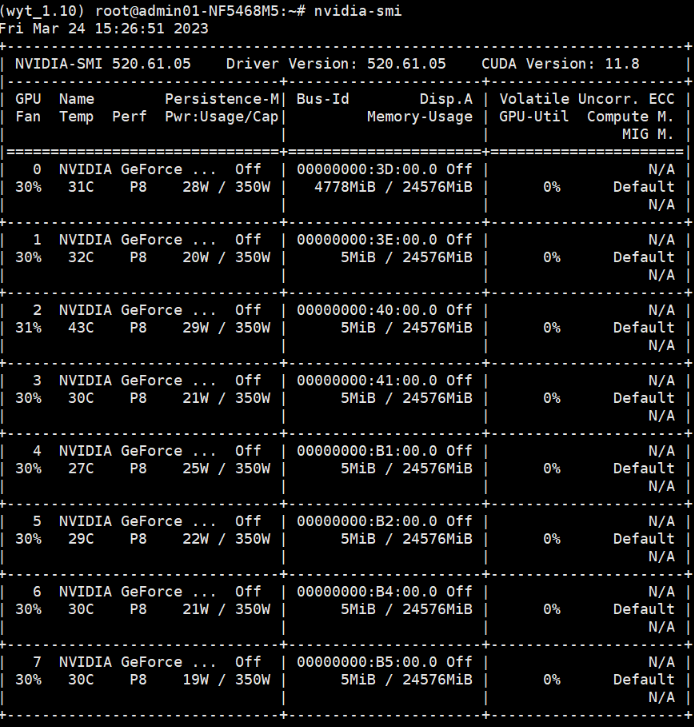

首先确认 GPU 是否被占用:

nvidia-smi

如果发现 GPU 已经有进程占用显存,可以:

- 切换 GPU(假设有多块显卡):

device = torch.device("cuda:2" if torch.cuda.is_available() else "cpu")

- 杀掉占用进程:

- Windows:

taskkill -PID 7072 -F

- Linux:

kill 7072

清理后,再次运行 nvidia-smi 确认 GPU 已空闲。

✅ 适用场景:多卡训练或显存被其他程序占用。

方法二:调小 batch size

显存不足最直接的原因是 batch size 太大,导致训练时张量无法全部放入 GPU。

# 原来 batch_size = 16

batch_size = 4 # 降低 batch_size

经验法则:在显存有限或大模型情况下,batch size 通常越小越安全,但训练时间会增加。

方法三:定期清理显存

PyTorch 在训练时可能会出现显存碎片化。可以在关键节点手动清理:

import torch, gc

# 在一个epoch结束或者大张量使用后

gc.collect()

torch.cuda.empty_cache()

作用:释放 PyTorch 保留的显存,减少碎片化,提高显存利用率。

方法四:在测试/验证阶段禁用梯度计算

测试或验证阶段不需要反向传播,关闭梯度计算可以显著减少显存占用:

def validate(model, dataloader):

model.eval()

with torch.no_grad(): # 关闭梯度

for batch in dataloader:

outputs = model(**batch)

...

注意:

torch.no_grad()可以减少显存占用,尤其在大模型验证阶段。

方法五:调整 DataLoader 的 pin_memory 设置

某些情况下,pin_memory=True 会导致主机内存占用过高,并间接影响显存分配。

kwargs = {'num_workers': 6, 'pin_memory': False} if torch.cuda.is_available() else {}

dataloader = DataLoader(dataset, **kwargs)

原理说明:

pin_memory=True:会将数据放入锁页内存,提高 GPU 访问速度- 问题:如果主机内存不足或显存紧张,可能触发

CUDA out of memory

如果显卡显存足够且主机内存充裕,

pin_memory=True是有益的,否则设置为 False 更安全。

三、综合策略

- 先检查 GPU 占用并释放(方法一)

- 调小 batch size(方法二)

- 关键节点清理显存(方法三)

- 测试/验证阶段禁用梯度(方法四)

- 根据硬件情况调整 DataLoader pin_memory(方法五)

建议按顺序尝试,从显存占用到代码优化,保证最小化改动和最高成功率。

四、总结

RuntimeError: CUDA out of memory 是 PyTorch 大模型训练中最常见的显存问题。

通过本文的 五重方法:

- 释放 GPU / 切换显卡

- 调整 batch size

- 定期清理显存

- 禁用测试/验证梯度计算

- 调整 DataLoader

pin_memory

可以 大概率解决显存不足问题,保证训练稳定进行。

掌握这些技巧,不仅适用于 BERT-Seq2Seq,也适用于 GPT、Transformer、CV 大模型训练,让显存管理更加高效。

RuntimeError: CUDA out of memory 是深度学习训练中常见的显存问题,其根本原因通常是 GPU 显存被占满或分配不合理。通过五重方法可以高效应对:释放或切换 GPU、调小 batch size、定期清理显存、在测试/验证阶段禁用梯度计算,以及调整 DataLoader 的 pin_memory 设置。这些方法既能解决显存不足带来的训练中断,也能优化显存使用效率,保证大模型训练的稳定性和可持续性。掌握显存管理策略,是深度学习工程师必备的技能之一。

更多推荐

已为社区贡献36条内容

已为社区贡献36条内容

所有评论(0)