一天一个开源项目(第4篇):OpenCode - 专为终端打造的强大 AI 编程代理

OpenCode是一个专为终端构建的强大 AI 编程代理。它提供了一个现代化的终端用户界面(TUI,Terminal User Interface),这是一种在终端中使用文本字符创建图形化交互的技术,让开发者可以在不离开终端的情况下,享受类似 GUI 应用的流畅交互体验和 AI 辅助编程的便利。项目解决的核心问题开发者需要在多个工具间切换(终端、IDE、浏览器)缺乏终端原生的 AI 编程助手需要统

引言

“如果 AI 编程助手能在终端中工作,让你无需切换窗口就能获得智能辅助,那该多好?”

这是"一天一个开源项目"系列的第4篇文章。今天带你了解的项目是 OpenCode(GitHub)。

想象一下,你正在终端中编写代码,突然遇到一个复杂的问题。传统方式可能需要切换到浏览器搜索,或者打开 IDE 的 AI 插件。但有了 OpenCode,你只需要在终端中输入问题,AI 助手就会立即响应,帮助你理解代码、修复错误、甚至编写新功能——所有这一切都在终端中完成。

为什么选择这个项目?

- 🖥️ 终端原生:专为终端设计,无需离开命令行环境

- 🎨 美观的 TUI:现代化的终端用户界面

- 🔌 协议支持:支持 MCP、LSP 等标准协议

- 🤖 多模型支持:支持 OpenAI、Claude 等多种 LLM

- ⚠️ 重要提示:项目已于 2025年9月归档,但仍可作为学习和参考

你将学到什么

- OpenCode 的核心概念和架构设计

- 如何在终端中使用 AI 编程助手

- MCP(Model Context Protocol)和 LSP(Language Server Protocol)的集成

- 自定义命令系统的使用

- 与其他 AI 编程工具的对比分析

- 项目归档的原因和启示

前置知识

- 基本的终端使用经验

- 对 AI 辅助编程有基本了解

- 熟悉 Go 语言(可选,用于理解源码)

- 了解 LSP 和 MCP 协议(可选)

项目背景

项目简介

OpenCode 是一个专为终端构建的强大 AI 编程代理。它提供了一个现代化的终端用户界面(TUI,Terminal User Interface),这是一种在终端中使用文本字符创建图形化交互的技术,让开发者可以在不离开终端的情况下,享受类似 GUI 应用的流畅交互体验和 AI 辅助编程的便利。

项目解决的核心问题:

- 开发者需要在多个工具间切换(终端、IDE、浏览器)

- 缺乏终端原生的 AI 编程助手

- 需要统一的接口来访问不同的 LLM 提供商

- 希望将 AI 能力集成到现有的开发工作流中

面向的用户群体:

- 喜欢在终端工作的开发者

- 需要快速 AI 辅助的开发者

- 希望集成 AI 能力到工作流的团队

- 对终端工具感兴趣的开发者

作者/团队介绍

团队:opencode-ai

- 背景:专注于 AI 辅助开发工具的开源团队

- 贡献者:27 位贡献者,包括 @kujtimiihoxha、@ezynda3、@rekram1-node 等

- 特别致谢:

- @isaacphi:提供了 mcp-language-server 项目,为 LSP 客户端实现奠定了基础

- @adamdottv:提供了设计方向和 UI/UX 架构

项目创建时间:2024年(从 GitHub 提交历史可以看出)

重要信息:项目已于 2025年9月18日归档,现在是只读状态。这可能是因为:

- 项目方向调整

- 资源限制

- 或者被其他项目替代

尽管如此,OpenCode 仍然是一个值得学习的优秀项目,展示了如何在终端中构建 AI 编程助手的完整方案。

项目数据

- ⭐ GitHub Stars: 10.6k+(归档前持续增长)

- 🍴 Forks: 965+

- 📦 版本: v0.0.55(最新版本,2025年6月27日发布)

- 📄 License: MIT(完全开源)

- 🌐 官网: 无独立官网,GitHub 为主要入口

- 📚 文档: GitHub README 和代码注释

- 💬 社区: GitHub Issues 和 Discussions(归档后只读)

- ⚠️ 状态: 已归档(2025年9月18日)

项目发展历程:

- 2024年:项目启动,初步版本发布

- 2024-2025年:快速发展,添加核心功能

- 2025年6月:v0.0.55 发布,最后一个版本

- 2025年9月:项目归档,转为只读状态

主要功能

核心作用

OpenCode 的核心作用是在终端中提供强大的 AI 编程辅助能力,让开发者能够:

- 终端原生体验:无需离开终端,即可使用 AI 辅助编程

- 多模型支持:统一接口访问不同的 LLM 提供商

- 协议集成:支持 MCP、LSP 等标准协议,扩展能力强

- 自定义命令:支持用户自定义命令,快速执行常用操作

- 会话管理:智能的会话管理和上下文维护

使用场景

-

终端开发工作流

- 在终端中编写代码时快速获得帮助

- 理解复杂的代码逻辑

- 快速修复错误和问题

-

代码审查和重构

- 分析代码质量和潜在问题

- 提供重构建议

- 生成测试代码

-

学习和探索

- 学习新的编程语言或框架

- 理解开源项目的代码

- 探索最佳实践

-

快速原型开发

- 快速生成代码片段

- 实现功能原型

- 验证想法

-

自动化脚本编写

- 生成 Shell 脚本

- 编写 CI/CD 配置

- 创建工具脚本

快速开始

安装

# 使用安装脚本(推荐)

curl -fsSL https://raw.githubusercontent.com/opencode-ai/opencode/main/install | bash

# 或从源码构建

git clone https://github.com/opencode-ai/opencode.git

cd opencode

go build -o opencode

基本使用

# 启动 OpenCode

opencode

# 在 TUI 中:

# 1. 输入你的问题或需求

# 2. AI 助手会分析并响应

# 3. 可以使用内置工具(READ, WRITE, RUN 等)

# 4. 查看代码建议和修改

配置 LLM 提供商

创建配置文件 ~/.config/opencode/opencode.json:

{

"providers": {

"openai": {

"apiKey": "your-openai-api-key"

},

"claude": {

"apiKey": "your-claude-api-key"

}

},

"agents": {

"coder": {

"model": "gpt-4",

"reasoningEffort": "high"

}

}

}

核心特性

-

终端用户界面(TUI)

- 什么是 TUI? TUI(Terminal User Interface,终端用户界面)是一种在终端中提供图形化交互体验的技术。与传统的命令行界面(CLI)不同,TUI 使用文本字符和 ANSI 转义序列来创建窗口、菜单、按钮等图形元素,让终端应用也能拥有类似 GUI 的交互体验,但完全在终端中运行。

- 现代化的终端界面:OpenCode 的 TUI 提供了清晰的布局和导航

- 支持键盘快捷键:高效的键盘操作,无需鼠标

- 实时更新:界面元素可以动态更新,提供流畅的交互体验

-

多 LLM 提供商支持

- OpenAI(GPT-3.5, GPT-4)

- Anthropic Claude

- 自托管模型(OpenAI 兼容接口)

-

内置工具集

READ:读取文件内容WRITE:写入文件RUN:执行命令SEARCH:搜索代码DIAGNOSTICS:代码诊断(通过 LSP)

-

MCP(Model Context Protocol)支持

- 集成外部工具和服务

- 标准化的协议接口

- 支持 stdio 和 SSE 连接

-

LSP(Language Server Protocol)集成

- 多语言支持

- 实时错误检查

- 代码诊断和建议

-

自定义命令系统

- 用户级命令(

user:前缀) - 项目级命令(

project:前缀) - 支持命令参数和子目录组织

- 用户级命令(

-

会话管理

- 智能会话上下文维护

- 会话压缩和总结

- 项目记忆文件(OpenCode.md)

-

GitHub Copilot 支持(实验性)

- 集成 GitHub Copilot Chat

- 支持 VSCode、Neovim 等插件

- 通过 GitHub CLI 访问

项目优势

OpenCode 可以作为 Claude Code 的平替方案,特别适合喜欢终端工作流的开发者。与其他 AI 编程工具相比:

| 对比项 | OpenCode | Claude Code | GitHub Copilot | Cursor |

|---|---|---|---|---|

| 终端原生 | ⭐⭐⭐⭐⭐ 完全终端 | ⭐⭐⭐⭐⭐ 完全终端 | ⭐ 需要 IDE | ⭐⭐ 需要 IDE |

| TUI 体验 | ⭐⭐⭐⭐⭐ 现代化界面 | ⭐ 无 | ⭐ 无 | ⭐⭐ IDE 集成 |

| 多模型支持 | ⭐⭐⭐⭐⭐ 统一接口 | ⭐⭐⭐⭐ 多种模型 | ⭐⭐ 仅 Copilot | ⭐⭐⭐ 多种模型 |

| 协议支持 | ⭐⭐⭐⭐⭐ MCP+LSP | ⭐⭐⭐⭐ MCP 支持 | ⭐⭐ 有限 | ⭐⭐⭐ 部分支持 |

| 自定义命令 | ⭐⭐⭐⭐⭐ 完整支持 | ⭐⭐⭐⭐ 支持 | ⭐ 无 | ⭐⭐ 有限 |

| 学习成本 | ⭐⭐⭐ 中等 | ⭐⭐⭐ 中等 | ⭐⭐⭐⭐ 低 | ⭐⭐⭐ 中等 |

| 项目状态 | ⚠️ 已归档 | ⭐⭐⭐⭐⭐ 活跃 | ⭐⭐⭐⭐⭐ 活跃 | ⭐⭐⭐⭐⭐ 活跃 |

为什么选择 OpenCode 作为 Claude Code 的平替?

- ✅ 终端原生:如果你更喜欢在终端工作,OpenCode 提供了完整的终端体验

- ✅ 协议支持:与 Claude Code 类似,支持 MCP 和 LSP 协议,扩展能力强

- ✅ 统一接口:一个工具访问多个 LLM 提供商,灵活选择模型

- ✅ 自定义能力:支持自定义命令系统,可以快速执行常用操作

- ✅ 轻量级:相比 IDE 集成的方案,OpenCode 更加轻量,资源占用更少

- ⚠️ 注意:项目已归档,适合学习和参考。如果需要生产环境使用,建议考虑 Claude Code 或其他活跃项目

项目详细剖析

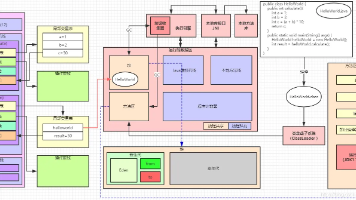

架构设计

OpenCode 采用模块化架构,核心组件清晰分离:

┌─────────────────────────────────────┐

│ cmd/ (CLI 接口) │

│ - Cobra 命令行框架 │

└──────────────┬──────────────────────┘

│

┌──────────────▼──────────────────────┐

│ internal/app (核心应用服务) │

│ - 应用逻辑编排 │

└──────────────┬──────────────────────┘

│

┌──────────┴──────────┐

│ │

┌───▼────┐ ┌─────▼─────┐

│ config │ │ session │

│ (配置) │ │ (会话管理) │

└────────┘ └───────────┘

│ │

┌───▼─────────────────────▼─────┐

│ internal/llm (LLM 集成) │

│ - OpenAI │

│ - Claude │

│ - 自托管模型 │

└──────────────┬──────────────────┘

│

┌──────────┴──────────┐

│ │

┌───▼────┐ ┌─────▼─────┐

│ mcp │ │ lsp │

│ (协议) │ │ (协议) │

└────────┘ └───────────┘

│ │

┌───▼─────────────────────▼─────┐

│ internal/tui (终端界面) │

│ - 布局和组件 │

│ - 用户交互 │

└────────────────────────────────┘

核心模块详解

1. LLM 集成层(internal/llm)

功能:统一接口访问不同的 LLM 提供商

支持的提供商:

- OpenAI(GPT-3.5, GPT-4)

- Anthropic Claude

- 自托管模型(OpenAI 兼容接口)

设计特点:

- 统一的接口抽象

- 配置驱动的提供商选择

- 支持流式响应

2. MCP 集成(Model Context Protocol)

功能:通过标准协议集成外部工具和服务

连接类型:

- Stdio:通过标准输入/输出通信

- SSE:通过 Server-Sent Events 通信

配置示例:

{

"mcpServers": {

"example": {

"type": "stdio",

"command": "path/to/mcp-server",

"env": [],

"args": []

},

"web-example": {

"type": "sse",

"url": "https://example.com/mcp",

"headers": {

"Authorization": "Bearer token"

}

}

}

}

设计特点:

- 标准化的协议接口

- 自动工具发现

- 权限控制系统

3. LSP 集成(Language Server Protocol)

功能:提供代码智能功能

支持的语言:

- Go(gopls)

- TypeScript(typescript-language-server)

- 其他支持 LSP 的语言

配置示例:

{

"lsp": {

"go": {

"disabled": false,

"command": "gopls"

},

"typescript": {

"disabled": false,

"command": "typescript-language-server",

"args": ["--stdio"]

}

}

}

功能:

- 实时错误检查

- 代码诊断

- 文件变更通知

设计特点:

- 完整的 LSP 客户端实现

- 多语言服务器支持

- 目前仅暴露 diagnostics 给 AI 助手

4. 自定义命令系统

命令类型:

-

用户级命令(

user:前缀)- 位置:

~/.config/opencode/commands/或~/.opencode/commands/ - 全局可用

- 位置:

-

项目级命令(

project:前缀)- 位置:

<PROJECT_DIR>/.opencode/commands/ - 仅当前项目可用

- 位置:

命令格式:

- Markdown 文件(

.md) - 文件名(不含扩展名)成为命令 ID

- 支持子目录组织

示例命令:

# 文件:~/.config/opencode/commands/prime-context.md

RUN git ls-files

READ README.md

命令参数:

- 使用

$NAME格式的占位符 - 执行时提示输入值

- 支持多次使用同一参数

示例:

# 文件:~/.config/opencode/commands/fetch-issue.md

# Fetch Context for Issue $ISSUE_NUMBER

RUN gh issue view $ISSUE_NUMBER --json title,body,comments

RUN git grep --author="$AUTHOR_NAME" -n .

5. 终端用户界面(TUI)

功能:提供现代化的终端界面

组件:

- 消息输入区域

- 对话历史显示

- 工具执行结果

- 状态栏和快捷键提示

设计特点:

- 清晰的布局

- 键盘导航

- 实时更新

关键技术实现

1. 会话管理

挑战:如何维护长对话的上下文?

解决方案:

- 会话状态持久化

- 智能压缩和总结

- 项目记忆文件(OpenCode.md)

工作流程:

- 新会话开始时加载项目记忆

- 对话过程中维护上下文

- 会话压缩时创建摘要

- 更新项目记忆文件

2. 工具权限系统

挑战:如何控制 AI 助手对工具的访问?

解决方案:

- 用户批准机制

- 工具执行前请求权限

- 权限记录和审计

3. 多协议集成

挑战:如何统一管理不同的协议(MCP、LSP)?

解决方案:

- 协议抽象层

- 统一的配置管理

- 异步通信处理

扩展机制

1. 自定义命令

用户可以创建自定义命令来快速执行常用操作:

# 创建命令文件

mkdir -p ~/.config/opencode/commands

cat > ~/.config/opencode/commands/my-command.md << EOF

# My Custom Command

RUN echo "Hello from custom command"

READ important-file.txt

EOF

# 在 OpenCode 中使用

# 按 Ctrl+K,选择 user:my-command

2. MCP 服务器集成

集成外部 MCP 服务器扩展功能:

{

"mcpServers": {

"custom-tool": {

"type": "stdio",

"command": "/path/to/custom-mcp-server"

}

}

}

3. 自托管模型

使用自托管模型替代云服务:

# 设置环境变量

export LOCAL_ENDPOINT=http://localhost:1235/v1

# 配置模型

{

"agents": {

"coder": {

"model": "local.granite-3.3-2b-instruct@q8_0"

}

}

}

项目地址与资源

官方资源

- 🌟 GitHub: https://github.com/opencode-ai/opencode

- 📚 文档: GitHub README

- 🐛 Issues: GitHub Issues(归档后只读)

- 📦 Releases: GitHub Releases

- ⚠️ 状态: 项目已归档(2025年9月18日)

适用人群

适合学习:

- 对终端工具感兴趣的开发者

- 想了解 AI 编程助手实现的开发者

- 需要参考 TUI 设计的开发者

- 学习协议集成(MCP、LSP)的开发者

不适合生产使用:

- ⚠️ 项目已归档,不再维护

- 建议使用活跃的替代项目

- 或 Fork 后自行维护

欢迎来我中的个人主页找到更多有用的知识和有趣的产品

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)