最近很多人聊 Clawdbot,我带大家认识一下最Clawdbot 开源 AI 智能体

Clawdbot是一个工程导向的AI智能体容器,定位介于大模型和智能体框架之间。它不提供模型能力,而是专注于组织和约束大模型行为,使其在真实系统中表现得更像一个可控组件。相比追求全自动化的智能体框架,Clawdbot更强调可接管性和稳定性,适合长期维护的AI服务。其核心价值在于将AI能力工程化,通过清晰的规则划分和透明决策过程,解决大模型在复杂场景中的不可控问题。虽然不适合简单场景,但对需要稳定运

最近在社区里,经常能看到 Clawdbot 这个名字。

但说实话,第一次看到的时候,我自己也有点疑惑:

它到底是个机器人?框架?还是又一个“套壳大模型”?

真正把它跑起来、接进系统之后,我才发现Clawdbot 的定位,其实和很多人想的不一样。

一、先说一句大实话:Clawdbot 不是大模型

这是我觉得最容易被误解的一点。

Clawdbot 本身并不提供模型能力,它不会替代 GPT、Claude,也不会让模型“突然变聪明”。

如果用一句话概括:

“Clawdbot 是用来“组织和约束大模型行为”的,而不是用来生成内容的”

换句话说,它更偏向于工程层的智能体实现,而不是算法或模型层。

如果你期待的是:

“接入 Clawdbot 之后,回答立刻比 GPT-4 好很多”

那大概率会失望。

最近一段时间,能明显感觉到一个趋势:

大家开始不太满足于“直接调用大模型”了。

不管是做聊天机器人、Copilot,还是内部工具,都会聊到三个词:

- 大型语言模型(LLM)

- AI 智能体(Agent)

- Clawdbot

尤其是 Clawdbot,这段时间出现频率很高,但说实话,很多文章要么偏概念,要么偏宣传,看完之后还是不知道它在工程里到底“站在哪”。

这篇文章不打算讲官方定义,也不打算画太多炫酷架构图,而是结合我最近的一些实践,从一个开发者视角聊聊:

- 普通大模型到底解决了什么

- AI 智能体多做了哪些事

- Clawdbot 适合放在什么位置

- 为什么我现在更倾向于用 Clawdbot,而不是“自己拼一个 Agent”

二、Clawdbot 想解决的,其实是工程问题

在没有 Clawdbot 之前,我们接入大模型通常是这样:

一开始还能接受,但随着场景复杂度提升,很快就会遇到几个问题:

- Prompt 越写越长

- 聊天上下文越来越乱

- 模型有时候“自作主张”

- 工具调用开始不可控

所以你会发现,“单模型聊天”非常依赖 prompt 工程,而且 prompt 一旦复杂,维护成本就直线上升。

Clawdbot 试图解决的,并不是“模型能力不足”,而是:

其实是:

如何让大模型在真实系统里,表现得更像一个可控组件。

怎么把大模型,变成一个能长期跑在系统里的东西。

三、AI 智能体:方向是对的,但工程不一定稳

三、AI 智能体:方向是对的,但工程不一定稳

后来大家开始引入 AI 智能体(Agent),思路其实很自然:

既然模型不会规划,那就让它“学会做事”。

于是我们开始看到:

• Planner

• Tool Calling

• Memory

• Reflection

这些概念本身都没问题,但在实际使用中,我最大的感受是:

很多 Agent 框架更像“研究项目”,而不是工程组件。

3.1 通用智能体的几个现实问题

以聊天系统为例,常见痛点包括:

• 行为不可预测(有时想太多)

• Tool 调用不稳定

• Debug 成本高

• 一旦出问题,很难兜底

尤其是在高频聊天场景下,你会发现:

智能体越“聪明”,越难控制。

四、Clawdbot 的定位:一个“克制”的智能体

这是我觉得 Clawdbot 最不一样的地方。

它并没有试图成为一个“全能 Agent”,而是刻意做了很多限制。

我更愿意把它理解成:

一个工程友好的 Agent 容器,而不是 AI 大脑。

从设计思路上,Clawdbot 并没有追求“全自动”,而是做了比较清晰的拆分。

结合我的理解,它大致可以看成由这几部分组成:

4.1 Clawdbot 的核心特点(个人理解)

结合实际使用,我总结了几个比较明显的点:

• 不强行自动化一切

• 决策过程相对透明

• 更强调“可接管”

• 更适合放在服务端

它不会替你决定业务逻辑,而是帮你把模型能力组织起来。

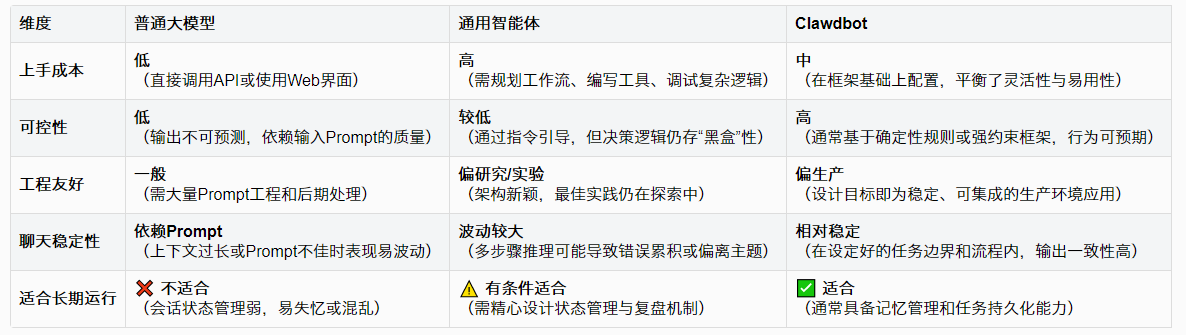

五、Clawdbot vs 普通大模型 vs 智能体

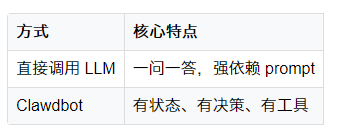

如果只是直接调用大模型,你更像是在“问问题”;

而用了 Clawdbot 之后,更像是在“驱动一个有规则的执行体”。

举个简单的对比:

在聊天场景中,这个差异会被无限放大。

如果一定要对比,我更倾向于用“工程适配度”来划分。

Clawdbot 并不是能力最强的,但是“最像后端服务”的。

六、为什么在聊天系统里,我更愿意用 Clawdbot

这是一个很个人的判断。

聊天系统有几个特点:

• 请求多、频率高

• 用户输入不可预测

• 一旦出问题,体验非常明显

在这种情况下,我反而不希望 Agent 太“自由”。

6.1 一个很现实的需求:兜底

在 Clawdbot 里,我经常会做这样的判断:

if agent.confidence < 0.7:

return fallback_answer()

这种代码听起来很“传统”,但它非常重要。

因为在工程里,稳定性永远优先于聪明。

七、Clawdbot + 大模型,更像“搭档”而不是“替代”

为什么最近 Clawdbot 会被频繁提起

我个人觉得,原因不在于它“突然变强了”,而在于:

大家开始从“玩 AI”,转向“用 AI 做系统

当系统规模变大之后,以下问题会变得非常现实:

- 成本控制

- 稳定性

- 可维护性

- 多人协作

而 Clawdbot 的设计,恰好踩在这个时间点上。

我现在的看法是:

• 大模型:负责语言与推理

• Clawdbot:负责组织与约束

• 业务代码:负责兜底与规则

三者缺一不可。

如果只用模型,系统会失控;

如果只靠规则,又发挥不出模型价值。

当你发现:

- prompt 已经不好维护

- 模型行为开始失控

- 聊天逻辑越来越复杂

那 Clawdbot 这种“工程导向”的智能体,反而会显得很顺眼。

八、一些不太“完美”的真实感受

说点不那么好听的。

- 如果你只是玩聊天机器人

- 如果你不打算长期维护

- 学习成本依然存在

- 不适合极简单场景

如果你只是做一个“玩具聊天机器人”,完全没必要上 Clawdbot。

但如果你在做的是:

• 企业内部聊天系统

• 长期维护的 AI 服务

• 需要多人协作的工程

那它会比“手搓 Agent”省心很多。

九、写在最后

最近 Clawdbot 被频繁提起,我反而觉得这是个好事,说明大家开始从“能不能用 AI”,转向思考:

AI 应该如何被放进系统里。

在我看来,Clawdbot 的价值不在于“更智能”,而在于:

它让 AI 看起来更像一个合格的后端组件。

这可能不是最性感的方向,但很实用。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)