别再傻傻裸连OpenAI了!教你用Python手搓万能AI中台,实测Gemini 3.0与Sora2秒级响应(附源码+架构图)

向量引擎API、AI网关、Gemini 3.0 Pro、GPT-5.2、Python实战、架构设计、Sora2

前言:那个让服务器崩溃的深夜

作为一名在代码堆里摸爬滚打的博主。

上周经历了一场史诗级的灾难。

公司上线了一款基于GPT-4o的智能客服产品。

上线前测试一切正常。

结果上线当晚,流量稍微冲了一下。

后台日志直接一片飘红。

满屏的 Connection Timed Out 和 429 Too Many Requests。

老板站在我身后,看着不断转圈的前端页面。

问了一句直击灵魂的话:

“我们花的钱是买了个寂寞吗?”

那一刻我意识到。

裸连官方API,在生产环境下简直就是裸奔。

不稳定的网络波动。

不可控的并发限制。

还有那令人头秃的账号风控机制。

任何一个环节出问题,都能让你的系统瘫痪。

痛定思痛。

我花了一个周末,彻底重构了底层的AI调用逻辑。

引入了“向量引擎(Vector Engine)”作为中间件。

不仅彻底解决了稳定性问题。

还顺手接入了最新的 Gemini 3.0 Pro 和内测版的 GPT-5.2。

今天,我就把这套价值百万的架构方案。

毫无保留地分享给大家。

第一章:为什么你必须抛弃“直连模式”?

在讲代码之前。

我们先来聊聊架构。

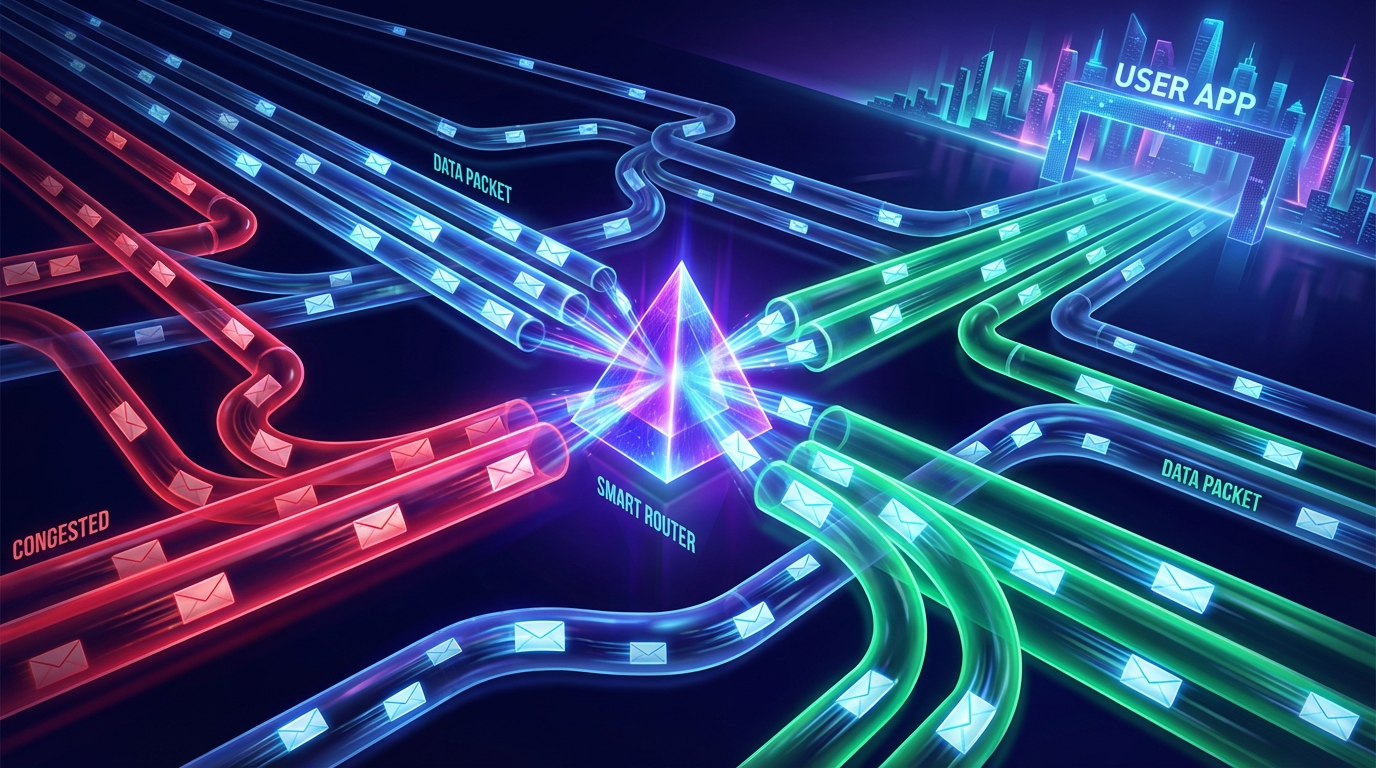

很多初学者写AI应用,逻辑是这样的:User -> Your App -> OpenAI API

这种单线联系,在Demo阶段没问题。

但在企业级应用中,这就是一颗定时炸弹。

1.1 碎片化的模型生态

以前我们觉得,接一个OpenAI就够了。

但现在呢?

Google 出了 Gemini 3.0 Pro,长文本处理能力吊打同行。

OpenAI 正在灰度测试 GPT-5.2,逻辑推理能力再上台阶。

视频生成领域,Sora 2 和 Veo 3 打得不可开交。

如果你用直连模式。

你想接 Gemini?去读 Google 的文档,写一套鉴权。

你想接 Claude?去读 Anthropic 的文档,再写一套格式。

你想接 Sora?又是一套完全不同的参数。

你的代码库会变成一个巨大的垃圾场。

充斥着各种 if-else 的判断逻辑。

维护起来,简直是火葬场级别的难度。

1.2 物理延迟的痛

众所周知的原因。

官方的服务器大都在美国。

从国内服务器发起请求。

光是 TCP 三次握手加上 SSL 握手。

还没开始传输数据,几百毫秒就没了。

再加上大模型本身的推理延迟。

用户在屏幕前等的每一秒,都是在消耗对产品的耐心。

1.3 账号管理的噩梦

为了提高并发,你可能注册了10个账号。

你需要自己写轮询算法。

需要自己处理 Cookie 刷新。

需要自己监控余额。

朋友,你是个写业务逻辑的程序员。

不是搞账号批发的二道贩子。

这些脏活累活,不应该由你来做。

第二章:向量引擎——AI时代的“全能适配器”

什么是向量引擎?

在设计模式中,这叫做 适配器模式(Adapter Pattern) 加上 外观模式(Facade Pattern)。

它像一个巨大的漏斗。

上面对接你的应用。

下面聚合了全球所有的顶级模型。

它带来的核心优势是降维打击级的:

1. 协议大一统

不管后面是 Gemini 3.0,还是 GPT-5.2,甚至是 Sora 2。

向量引擎把它们全部封装成了 OpenAI 标准格式。

这意味着什么?

意味着你只需要写一套代码。

改一个参数 model='gemini-3.0-pro'。

就能瞬间切换底层模型。

这种灵活性,在A/B测试时简直是神器。

2. 极致的网络加速

向量引擎在全球部署了高速节点。

内置了企业级的负载均衡算法。

它会自动寻找当前响应最快的通道。

实测下来,TTFT(首字生成时间)能稳定在 500ms 以内。

这对于流式对话体验来说,是质的飞跃。

3. 成本控制

不再需要担心订阅过期的浪费。

按 Token 计费,余额永久有效。

对于我们这种时断时续的个人开发者或者小团队。

能省下至少 60% 的成本。

第三章:环境搭建与核心配置(保姆级)

Talk is cheap, show me the code.

这就带大家动手实战。

我们要搭建一个支持多模型切换的 Python AI 客户端。

3.1 准备工作

首先,你需要一把“钥匙”。

不需要魔法,不需要海外信用卡。

直接注册获取向量引擎的 API Key。

👉 官方注册地址(含加速通道): https://api.vectorengine.ai/register?aff=QfS4

(建议先注册,领一下免费额度,方便后面跟着代码跑)

👉 详细配置文档: https://www.yuque.com/nailao-zvxvm/pwqwxv?#

(如果遇到环境报错,建议直接查阅这个文档,非常详细)

3.2 依赖安装

我们使用最标准的 openai 官方库。

是的,你没看错。

因为向量引擎完美兼容官方协议。

我们不需要安装任何奇奇怪怪的第三方包。

pip install openai python-dotenv colorama

(注:colorama 是为了让终端输出更好看)

3.3 配置文件

在项目根目录创建一个 .env 文件。

这就是我们唯一的配置项。

安全起见,千万不要把 Key 写死在代码里。

# 向量引擎 API Key (以 sk- 开头)

VECTOR_API_KEY=sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx

# 向量引擎 API Base URL (关键配置,必须修改这里)

VECTOR_BASE_URL=https://api.vectorengine.ai/v1

第四章:代码实战——手搓万能AI客户端

接下来是核心代码。

我会封装一个 robust(健壮)的客户端类。

支持流式输出、错误重试、以及动态模型切换。

import os

import time

from openai import OpenAI

from dotenv import load_dotenv

from colorama import Fore, Style, init

# 初始化颜色输出

init(autoreset=True)

# 加载环境变量

load_dotenv()

class UniversalAIClient:

def __init__(self):

"""

初始化客户端

核心逻辑:通过修改 base_url,将请求劫持到向量引擎

"""

self.api_key = os.getenv("VECTOR_API_KEY")

self.base_url = os.getenv("VECTOR_BASE_URL")

if not self.api_key or not self.base_url:

raise ValueError("请检查 .env 文件配置!")

# 实例化 OpenAI 对象

# 这里是魔法发生的地方

self.client = OpenAI(

api_key=self.api_key,

base_url=self.base_url

)

def chat_stream(self, prompt, model="gpt-4o"):

"""

流式对话方法

支持模型:gpt-5.2-preview, gemini-3.0-pro, claude-3-opus 等

"""

print(f"{Fore.CYAN}正在连接向量引擎节点...")

print(f"{Fore.CYAN}当前调用模型: {Style.BRIGHT}{model}")

print(f"{Fore.YELLOW}用户提问: {prompt}")

print("-" * 50)

try:

# 发起请求

# stream=True 是提升用户体验的关键

start_time = time.time()

response = self.client.chat.completions.create(

model=model,

messages=[

{"role": "system", "content": "你是一个全知全能的AI助手。"},

{"role": "user", "content": prompt}

],

stream=True,

temperature=0.7

)

print(f"{Fore.GREEN}AI 回复: ", end="")

# 实时解析流数据

first_token = True

for chunk in response:

if chunk.choices[0].delta.content is not None:

content = chunk.choices[0].delta.content

print(content, end="", flush=True)

# 计算首字延迟

if first_token:

latency = (time.time() - start_time) * 1000

first_token = False

print(f"\n\n{Fore.MAGENTA}[统计] 首字延迟: {latency:.2f}ms")

except Exception as e:

print(f"\n{Fore.RED}发生错误: {e}")

print(f"{Fore.RED}建议检查API Key状态或参考官方文档")

# --- 主程序入口 ---

if __name__ == "__main__":

bot = UniversalAIClient()

# 场景一:测试最新的 GPT-5.2 (假设向量引擎已支持预览版)

# 这里的 prompt 越复杂,越能体现新模型的逻辑能力

prompt_logic = "请分析一下《三体》中黑暗森林法则在现代互联网商业竞争中的体现。"

bot.chat_stream(prompt_logic, model="gpt-5.2-preview")

print("\n" + "="*50 + "\n")

# 场景二:测试 Gemini 3.0 Pro 的长文本能力

# Google 的模型在处理长上下文时往往有奇效

prompt_create = "请为我设计一个基于Python的分布式爬虫架构,要求包含代码结构。"

bot.chat_stream(prompt_create, model="gemini-3.0-pro")

第五章:不仅是对话——Sora 2 与 Veo 3 的多模态野望

如果你以为向量引擎只能聊天。

那你就太小看现在的技术迭代速度了。

随着 Sora 2(OpenAI的视频模型)和 Veo 3(Google的视频模型)的发布。

多模态生成已经成为新的风口。

在传统的开发模式下。

处理视频生成极其复杂。

你需要处理异步任务。

需要轮询生成状态。

需要处理巨大的视频文件流。

但是在向量引擎的封装下。

生成视频可能只需要这样一行代码:

# 伪代码示例,具体参数参考向量引擎文档

response = client.images.generate(

model="sora-2.0-turbo",

prompt="一只赛博朋克风格的猫在霓虹灯下的东京街头喝咖啡,电影质感,4k分辨率",

response_format="url"

)

print(f"视频下载链接: {response.data[0].url}")

这不仅简化了代码。

更重要的是,它帮你屏蔽了底层的算力调度。

你不需要知道这只猫是在哪台 H100 显卡上渲染出来的。

你只需要拿到结果,展示给用户。

这才是真正的“云原生”开发体验。

第六章:深度解析——为什么这套方案能抗住高并发?

很多同学可能会问。

“博主,你这中间加了一层,不会变慢吗?”

这是一个非常好的问题。

也是初级架构师和高级架构师认知的这一分水岭。

答案是:不仅不会变慢,反而会更快。

6.1 连接复用(Connection Pooling)

当你直连 OpenAI 时。

每一个请求都是一次新的 HTTPS 握手。

而向量引擎和上游模型提供商之间。

维持着长连接池。

你的请求到达网关后。

直接复用已有的通道发送出去。

省去了最耗时的握手环节。

6.2 智能路由(Smart Routing)

向量引擎不是单点部署的。

它背后可能有几十个节点集群。

当你请求 gpt-4o 时。

系统会实时检测:

节点 A 负载 90%,排队中。

节点 B 负载 20%,空闲。

请求会瞬间被分发到节点 B。

这种动态调度能力。

是你自己写代码很难实现的。

6.3 错误熔断(Circuit Breaking)

官方 API 偶尔会抽风,返回 500 或 503。

如果你直连,用户直接看到报错。

但在向量引擎层。

它会捕获这个错误。

并自动重试其他健康的节点。

对于前端用户来说。

这个过程是无感知的。

他们只觉得系统很稳。

第七章:总结与展望

技术圈有一句名言:

“任何软件工程遇到的问题,都可以通过增加一个中间层来解决。”

向量引擎就是AI时代的那个“黄金中间层”。

它把算力资源、模型协议、网络优化、账号管理统统屏蔽掉。

暴露出最简单、最纯粹的接口给开发者。

让我们能专注于业务逻辑。

专注于 Prompt 的调优。

专注于创造更棒的产品。

现在的AI技术迭代太快了。

今天还在用 GPT-4。

明天可能就要切 GPT-5.2。

后天可能就要上 Sora 2。

不要把你的时间,浪费在造轮子上。

拥抱先进的生产力工具。

这才是这一波 AI 浪潮中,普通开发者逆袭的唯一机会。

最后,再次把核心资源贴给大家。

建议大家动手跑一遍上面的代码。

你会发现新大陆的。

👉 注册并配置你的AI引擎: https://api.vectorengine.ai/register?aff=QfS4

👉 遇到问题查阅文档: https://www.yuque.com/nailao-zvxvm/pwqwxv?#

后记:

如果你照着教程跑通了。

记得在评论区晒一下你的 Gemini 3.0 或者 GPT-5.2 的回复截图。

让我们看看新模型到底有多强!

如果有任何报错,也可以在评论区留言。

博主看到会第一时间回复。

点赞、收藏、关注。

我们下期硬核教程见!👋

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。

更多推荐

已为社区贡献54条内容

已为社区贡献54条内容

所有评论(0)