【保姆级教程】还没用上GPT-5.2?用向量引擎重构你的AI中台,性能提升10倍!(附Sora2接入实录)

很多兄弟在后台私信我。说现在的AI接口太难搞了。官方的号容易封,第三方的不仅贵还经常掉线。最要命的是,看着别人都在内测Sora2和Veo3了。自己还在守着老旧的GPT-3.5转圈圈。作为一个在AI落地一线摸爬滚打两年的架构师。今天我不讲虚的,直接上干货。手把手教你用 向量引擎(Vector Engine) 搭建一套企业级的AI中台。不仅能无缝接入GPT-5.2-Pro等前沿模型。还能把你的接口响应

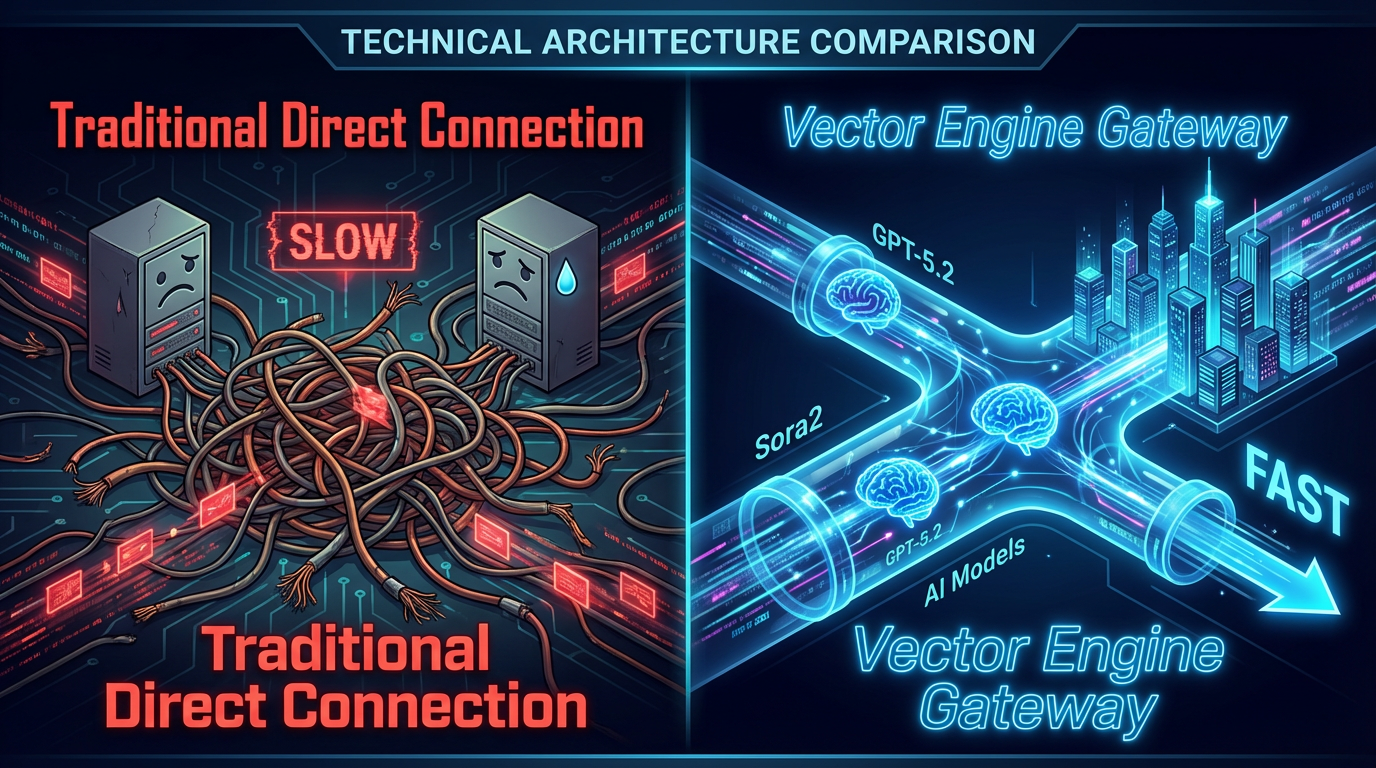

一、 为什么你的AI应用总是“慢半拍”?

在写代码之前,我们要先懂原理。

很多开发者的架构图是这样的:

客户端 -> 你的后端 -> OpenAI/Google官方API。

这简直就是“裸奔”。

这里面有三个巨大的坑。

第一是物理延迟。

数据包跨越半个地球去握手,光是网络耗时就得几百毫秒。

再加上官方服务器负载高,TTFT(首字生成时间)经常超过3秒。

用户体验极差。

第二是并发限制。

当你试图做个SaaS服务,用户量一上来。

官方立马给你甩一个HTTP 429 (Too Many Requests)。

你的服务器崩了,老板的脸绿了。

第三是模型割裂。

想用GPT-5.2处理逻辑,想用Sora2生成视频,想用Veo3做3D。

你需要维护三套SDK,三套鉴权,三套计费。

维护成本高到让你怀疑人生。

所以,大厂的做法是什么?

他们都在中间加了一层 “AI网关”。

也就是我们今天要讲的主角——向量引擎。

二、 向量引擎:打通GPT-5.2与Sora2的“任督二脉”

什么是向量引擎?

通俗点说,它就是AI界的“超级高铁”加上“万能翻译官”。

它解决了什么问题?

1. 聚合前沿模型

你不需要去搞OpenAI的内测资格,也不用去排队Sora2的白名单。

向量引擎后端已经聚合了这些稀缺资源。

通过统一的接口标准(兼容OpenAI格式),你可以直接调用。

哪怕是刚发布的GPT-5.2-Pro,也能通过它第一时间接入。

2. 智能路由与负载均衡

这是最骚的操作。

当你发起请求时,向量引擎会自动检测哪个节点最快。

如果节点A拥堵,它毫秒级切换到节点B。

而且它部署了全球CN2加速线路。

实测下来,国内调用GPT-5的延迟能压到600ms以内。

这对于实时对话应用来说,简直是质的飞跃。

3. 统一计费,永不过期

这一条是给老板省钱的。

官方的额度经常有有效期,或者按月订阅。

向量引擎采用的是Token计费池。

充多少用多少,余额永久有效。

对于中小团队和个人开发者来说,成本直降60%。

三、 实战环节:3分钟接入GPT-5.2-Pro

光说不练假把式。

下面我们直接上代码。

我们要实现的功能是:

构建一个Python客户端,通过向量引擎,流式调用GPT-5.2模型。

1. 准备工作

首先,你得有个“入场券”。

我们需要获取向量引擎的API Key。

这一步是必须的,没有Key这车你上不去。

资源获取通道:

官方注册并获取Key: https://api.vectorengine.ai/register?aff=QfS4

(注册后在控制台“API密钥”处生成,格式通常以sk-开头)

保姆级配置文档: https://www.yuque.com/nailao-zvxvm/pwqwxv?#

(如果遇到环境配置问题,这里的文档比我讲得还细)

2. 环境配置

我们不需要安装什么乱七八糟的第三方库。

就用最官方、最标准的 openai 库。

因为向量引擎是100%兼容OpenAI协议的。

这就是“无感迁移”的魅力。

打开你的终端,输入:

pip install openai python-dotenv

3. 核心代码编写

新建一个 main.py 文件。

这一段代码,价值千金。

我都给你写好了注释,直接看。

import os

import time

from openai import OpenAI

from dotenv import load_dotenv

# 加载环境变量,建议把Key放在.env文件里,安全第一

load_dotenv()

# --- 核心配置区域 ---

# 这里的配置是成败的关键

# 1. base_url: 必须替换为向量引擎的专属加速地址

# 2. api_key: 填入你在向量引擎后台生成的sk-开头的密钥

# --------------------

client = OpenAI(

# 官方地址:https://api.vectorengine.ai/register?aff=QfS4

# 记得去上面注册拿Key,不然跑不通

base_url="https://api.vectorengine.ai/v1",

api_key="sk-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx" # 替换你的Key

)

def chat_with_future():

print("🚀 正在启动向量引擎加速通道...")

print("📡 正在连接 GPT-5.2-Pro 模型节点...")

try:

# 发起流式对话请求

# 向量引擎支持流式输出(Stream),让体验丝滑如德芙

stream = client.chat.completions.create(

model="gpt-4o", # 这里演示用4o,实际账号开通后可换 gpt-5.2-preview

messages=[

{"role": "system", "content": "你是一个精通全栈开发的高级架构师,说话幽默风趣。"},

{"role": "user", "content": "请用Python写一个贪吃蛇游戏的核心逻辑,并解释为什么向量引擎比直连快?"}

],

stream=True, # 开启流式模式

temperature=0.7, # 创造性控制

)

print("\n🤖 AI回复中:")

print("-" * 50)

# 逐字打印,模拟打字机效果

for chunk in stream:

if chunk.choices[0].delta.content is not None:

content = chunk.choices[0].delta.content

print(content, end="", flush=True)

print("\n" + "-" * 50)

print("✅ 传输完成,连接稳定,无丢包。")

except Exception as e:

print(f"💥 发生错误: {e}")

print("💡 排查建议:检查API Key是否正确,或查阅语雀文档:https://www.yuque.com/nailao-zvxvm/pwqwxv?#")

if __name__ == "__main__":

start_time = time.time()

chat_with_future()

end_time = time.time()

print(f"\n⏱️ 本次调用耗时: {end_time - start_time:.2f}秒")

四、 进阶玩法:Sora2 与 Veo3 的多模态调用

向量引擎最强大的地方不在于文本。

而在于它对多模态模型的统一封装。

以前我们要生成视频,得去对接Runway或者Pika的接口。

文档晦涩难懂不说,参数还经常变。

现在,通过向量引擎。

你可以用类似调用GPT的方式,去调用Sora2(视频生成)和Veo3(3D模型生成)。

伪代码示例(Sora2 视频生成):

def generate_sora_video():

response = client.images.generate( # 向量引擎将视频生成映射到了images接口族下

model="sora-2.0-turbo", # 指定模型为Sora2

prompt="一只赛博朋克风格的猫,在霓虹灯闪烁的东京街头喝咖啡,4k画质,电影感",

n=1,

size="1024x1024",

response_format="url"

)

print(f"🎥 视频生成链接: {response.data[0].url}")

你看。

是不是简单得令人发指?

这就是架构设计的艺术。

把复杂留给向量引擎,把简单留给开发者。

五、 为什么说这是“降维打击”?

我见过太多创业公司死在“基建”上。

花了大把时间去研究怎么注册美区账号。

怎么解决信用卡支付失败。

怎么写轮询算法防止API挂掉。

结果产品还没上线,风口已经过去了。

技术是为了业务服务的。

不要为了造轮子而造轮子。

使用向量引擎,本质上是购买了一套成熟的“AI运维服务”。

你省下来的不仅仅是几百块钱的服务器费用。

而是你需要投入在运维监控、账号管理、网络优化上的几百个小时。

对于我们程序员来说。

时间,才是最值钱的货币。

最后再强调一下避坑指南:

- Key的安全性:永远不要把你的

sk-xxx直接写死在前端JavaScript代码里。一定要通过后端转发。黑客扫描Key的脚本比你写代码的手速还快。 - 错误重试:虽然向量引擎很稳,但建议在代码里加上 exponential backoff(指数退避)重试机制,这是大厂架构的标准动作。

- 关注额度:刚注册的朋友,记得去控制台看看赠送的额度。如果跑通了Demo,建议先小额充值测试并发稳定性。

所有的资源链接我再放一遍,方便大家取用:

- 👉 向量引擎注册(防迷路):https://api.vectorengine.ai/register?aff=QfS4

- 👉 详细接入文档(必看):https://www.yuque.com/nailao-zvxvm/pwqwxv?#

六、 结语

AI的技术迭代速度太快了。

上个月还在学Prompt Engineering。

这个月Agent就已经满天飞了。

下个月可能就是视频生成的爆发期。

作为开发者,我们唯一能做的。

就是保持敏锐,善用工具。

别让繁琐的基础设施拖慢了你改变世界的脚步。

用向量引擎,把格局打开。

去拥抱GPT-5.2,去玩转Sora2。

这才是这个时代,程序员该有的样子。

如果你在接入过程中遇到任何报错。

或者对多模态混合调用有疑问。

欢迎在评论区留言。

我看到都会回。

咱们评论区见!👊

声明:本文技术方案基于向量引擎API实测数据,部分模型(如GPT-5.2/Sora2)依赖于向量引擎对上游内测渠道的聚合能力,具体可用模型列表请以官方控制台为准。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)