技术报告:在 AMD ROCm 环境下部署代码助手的可行方案

摘要: 本文探讨了在AMD ROCm环境下部署Qwen3-30B-A3B代码助手的方案,采用Docker和vLLM框架实现私有化高效推理。该模型开源可定制,支持复杂代码生成,但工程级修复能力弱于顶尖闭源模型(如GPT-5),且需较高GPU资源(81GB显存)。相比闭源方案,其优势在于数据安全与灵活部署,适合企业定制需求,但需结合Agent框架提升工程闭环能力。商业上,该方案契合企业私有化趋势,但面

技术报告:在 AMD ROCm 环境下部署代码助手的可行方案

1. 项目背景

在当前的人工智能应用中,大模型在工程开发中的辅助作用越来越重要。尤其是对于代码生成和修复的需求,模型的应用逐渐从传统的单一生成任务拓展到复杂的工程流程中。这种背景下,企业需要寻找高效的方式来部署和利用这些大模型,特别是在自己的私有化环境中进行部署,确保数据安全与系统的高效运行。

2. 部署环境与需求

为了在私有环境中高效运行大模型,本文详细介绍了在 AMD ROCm 环境下部署代码助手(以 Qwen3-30B-A3B 为例)的可行方案。该方案基于以下几个关键技术:

- AMD ROCm 环境:为高效的 AI 计算提供支持。

- Docker:容器化技术可确保部署环境的一致性,并且简化了与硬件环境的交互。

- vLLM:这是一个支持高效推理的大模型推理框架,优化了与 GPU 的配合,特别是适用于 AMD ROCm 环境。

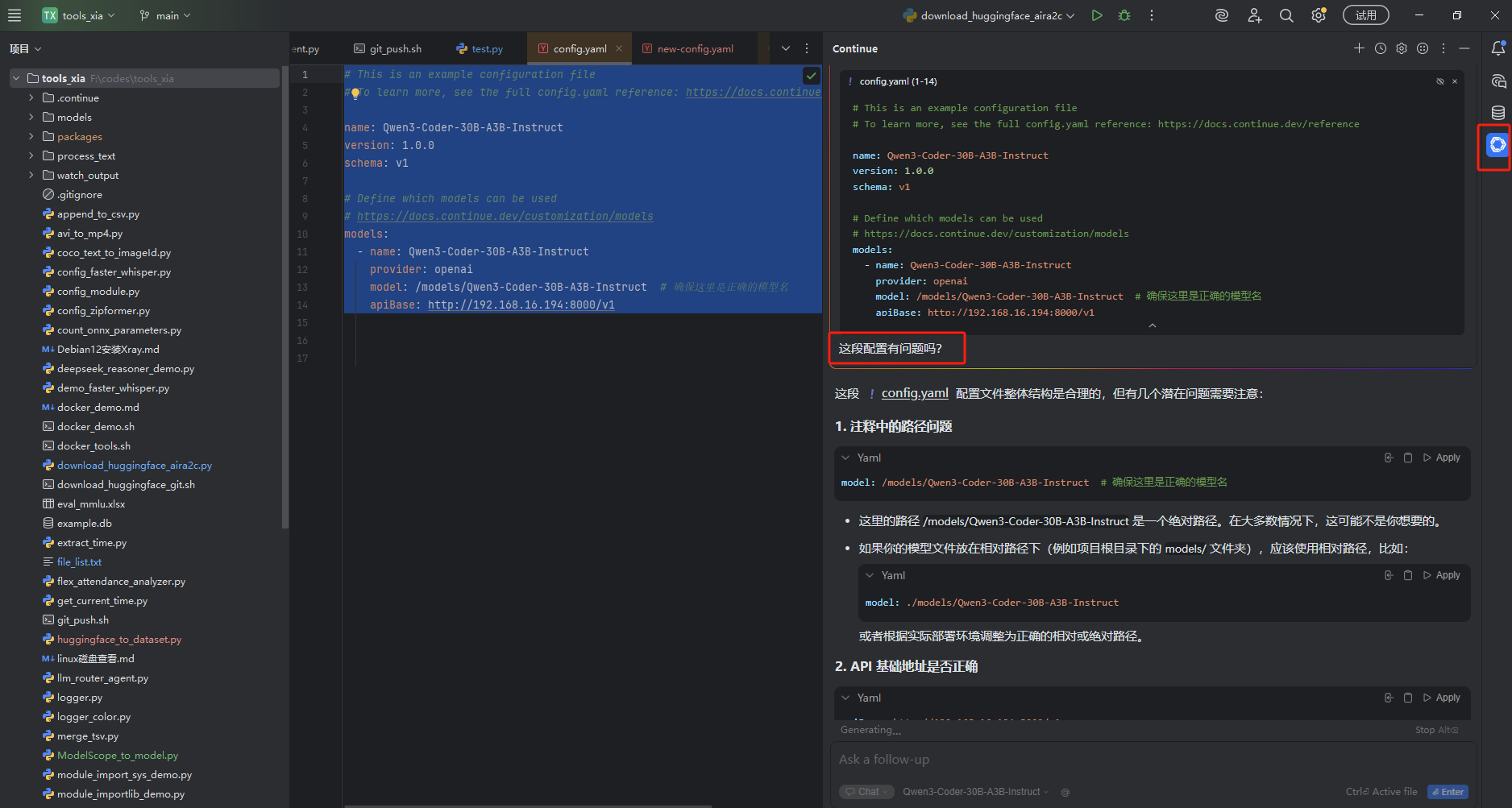

3. 测试模型展示

4. 性能评估

优点

- 开源且可定制

- 相比闭源模型(如 CodeBuddy、Doubao‑Seed‑Code 闭源版本),Qwen3‑Coder‑30B‑A3B 权重开源,可根据企业业务需求定制、优化和二次训练。

- 与 Meta 的 Code Llama 等开源模型类似,具有灵活部署和本地优化优势。

- 良好的工程级代码生成基础能力

- 在标准代码生成任务上表现不错,能理解复杂结构和多文件上下文。

- 相比一些小型开源模型(如 mini‑SWE‑agent + GPT‑5 nano、Qwen2.5‑Coder 32B 等),能处理更大规模语义和上下文。

- 部署灵活,可结合私有化推理平台

- 与闭源云 API 方案不同(需要依赖第三方服务),本模型可在私有化环境(例如 ROCm + vLLM)离线部署,更适合企业数据安全要求。

缺点

- SWE‑bench 工程任务解决率不高

- 在 SWE‑bench 排行榜中,EntroPO + R2E + Qwen3‑Coder‑30B‑A3B 的解决率为 52.20%,低于国际顶尖组合如 TRAE + Doubao‑Seed‑Code(78.80%)、Gemini 3 Pro(77.40%)、Refact.ai(74.40%)、OpenHands + GPT‑5(71.80%)等。

- 说明在完整工程级修复、测试与闭环场景下性能不如更成熟的系统。

- 整体系统能力弱于高级 Agent + 大模型组合

- 类似 Code Llama、Doubao‑Seed‑Code、Gemini 等在 Agent 框架配合下(如与 SWE‑agent、TRAE 等集成)表现通常更好,而单独 Qwen3‑Coder‑30B‑A3B 在纯模型能力上欠缺系统调度、测试验证等工程闭环逻辑。

- 资源与成本

- 30B 参数量仍需大量 GPU 资源支持,比一些轻量级模型部署成本高。

- 与闭源大模型(Gemini、GPT‑5 系列)相比,在云端推理效率和优化路线仍稍弱。

- 需要辅助系统来提升工程实用性

- 虽然模型本身具备强代码生成能力,但缺乏自动定位、全流程测试、失败重试等工程闭环功能,这些通常由 Agent 框架提供。

对比总结

| 特性/模型 | Qwen3‑Coder‑30B‑A3B | Code Llama(如 34B/70B) | Doubao‑Seed‑Code | GPT‑5 系列 |

|---|---|---|---|---|

| 是否开源 | ✅ | 受条款开源 | ❌ | ❌ |

| 私有化部署 | 易 | 易 | 难 | 依托云 |

| 代码生成基础能力 | 良好 | 良好 | 很强 | 很强 |

| 工程级修复综合能力 | 中等 | 高 | 高 | 高 |

| 与 Agent 整合表现 | 需完善 | 强 | 强 | 强 |

| 资源要求 | 高 | 高 | 极高 | 极高 |

| 商业成本 | 可控 | 可控 | 高 | 高 |

硬件使用情况

MEM_USAGE:

TOTAL_VRAM: 98304 MB

USED_VRAM: 81442 MB

FREE_VRAM: 16862 MB

TOTAL_VISIBLE_VRAM: 98304 MB

USED_VISIBLE_VRAM: 81442 MB

FREE_VISIBLE_VRAM: 16862 MB

TOTAL_GTT: 15861 MB

USED_GTT: 37 MB

FREE_GTT: 15824 MB

| 模型名称 | 参数量 | AMD显存需求 | 结论 |

|---|---|---|---|

| Qwen3-Coder-30B-A3B | 30B(300亿参数) | 81GB 及以上 | 可以在当前系统(96GB 显存)上运行,但接近显存上限,可能需要优化资源管理。 |

| GLM-4.5 | 355B(3550亿参数) | 958GB 及以上 | 需要多显卡或分布式计算,无法在单显卡系统上运行。 |

| GLM-4.6 | 355B(3550亿参数) | 958GB 及以上 | 需要多显卡或分布式计算,无法在单显卡系统上运行。 |

| Qwen3-Coder-480B/A35B | 480B(4800亿参数) | 1296GB 及以上 | 需要多显卡或分布式计算,无法在单显卡系统上运行。 |

结论

- 优势:开源、可部署于私有化环境、代码理解能力较好,适合企业自定义场景和离线部署。

- 不足:工程级整体表现不如一些顶尖闭源模型组合(如GPT‑5、Doubao‑Seed‑Code),需要结合更完善的 Agent 和流程策略来提升实际效能;资源消耗较高。

- 适用场景:适合需要私有化、可控、定制化的企业部署;不适合追求顶尖工程自动化效果且依赖最优闭源模型的场景。

5. 商业价值与前景评估

5.1. 市场需求

随着人工智能的发展,企业对代码生成与修复的需求不断增长,尤其是在软件开发的高效化和自动化方面。对于人工智能芯片硬件公司,提供能对接大模型推理的芯片产品,能够大幅度提升产品的市场吸引力,尤其是在数据密集型领域。

5.2. 部署的可行性与风险

可行性:在 AMD ROCm 环境下的 vLLM 部署可以有效支持高性能大模型的推理任务。该方案已经在多个平台上成功实现,因此具有较高的可行性。

- 风险:

- 竞争对手风险:面临强劲的国际和本土竞争者,如英伟达、华为等。

- 销售失败风险:市场接受度和客户购买意愿可能不高。

- 法规与合规性风险:数据隐私、出口限制等可能带来法律风险。

5.3. 商业前景

- 高效的软件开发工具:企业在软件开发过程中,尤其是在开发过程中,越来越依赖于AI工具来提高效率,减少错误。部署像 Qwen3-Coder 这样的大模型可以极大提升代码编写的自动化水平,减少开发时间。

- 企业私有化部署:随着企业数据隐私要求的提升,私有化部署逐渐成为趋势。为企业提供支持大模型推理的硬件平台,不仅能够提升自身的硬件市场份额,还能够为企业带来新的服务业务收入。

6. 结论

总结

随着人工智能的发展,大模型在代码生成和修复中发挥着越来越重要的作用,特别是在工程开发的复杂流程中。为了在私有化环境中高效部署大模型,本文介绍了在 AMD ROCm 环境下部署 Qwen3-30B-A3B 代码助手的方案。该方案利用 Docker 和 vLLM 推理框架,确保模型在私有环境中的高效运行和数据安全。

优点:Qwen3-30B-A3B 开源且可定制,支持企业根据需求优化和二次训练,适合私有化部署。其在代码生成任务中具有较好的表现,尤其是在复杂结构和多文件上下文处理上。

缺点:相比一些顶尖的闭源模型,Qwen3-30B-A3B 在工程级修复和综合能力上有所不足,且资源消耗较高,需要更多 GPU 支持。此外,缺乏完整的工程闭环功能,需与 Agent 框架等其他系统结合使用。

商业前景:随着企业对私有化部署的需求增加,支持大模型推理的硬件平台将获得市场优势。尽管面临竞争和法规风险,Qwen3-30B-A3B 仍具有广泛的应用前景,特别是在数据隐私要求高的行业中。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)