AI大模型应用开发-大模型工具:Ollama 安装与使用(拉取小模型)、Streamlit 基础(搭建简单网页)

AI大模型应用开发-大模型工具:Ollama 安装与使用(拉取小模型)、Streamlit 基础(搭建简单网页)

一、 第一部分:Ollama 安装与使用(拉取小模型,Windows 环境)

核心目标

完成 Ollama 安装,学会拉取轻量大模型、交互式运行模型,实现 “终端提问→模型回复” 的基础功能,小白优先选择低显存占用的小模型,避免电脑卡顿。

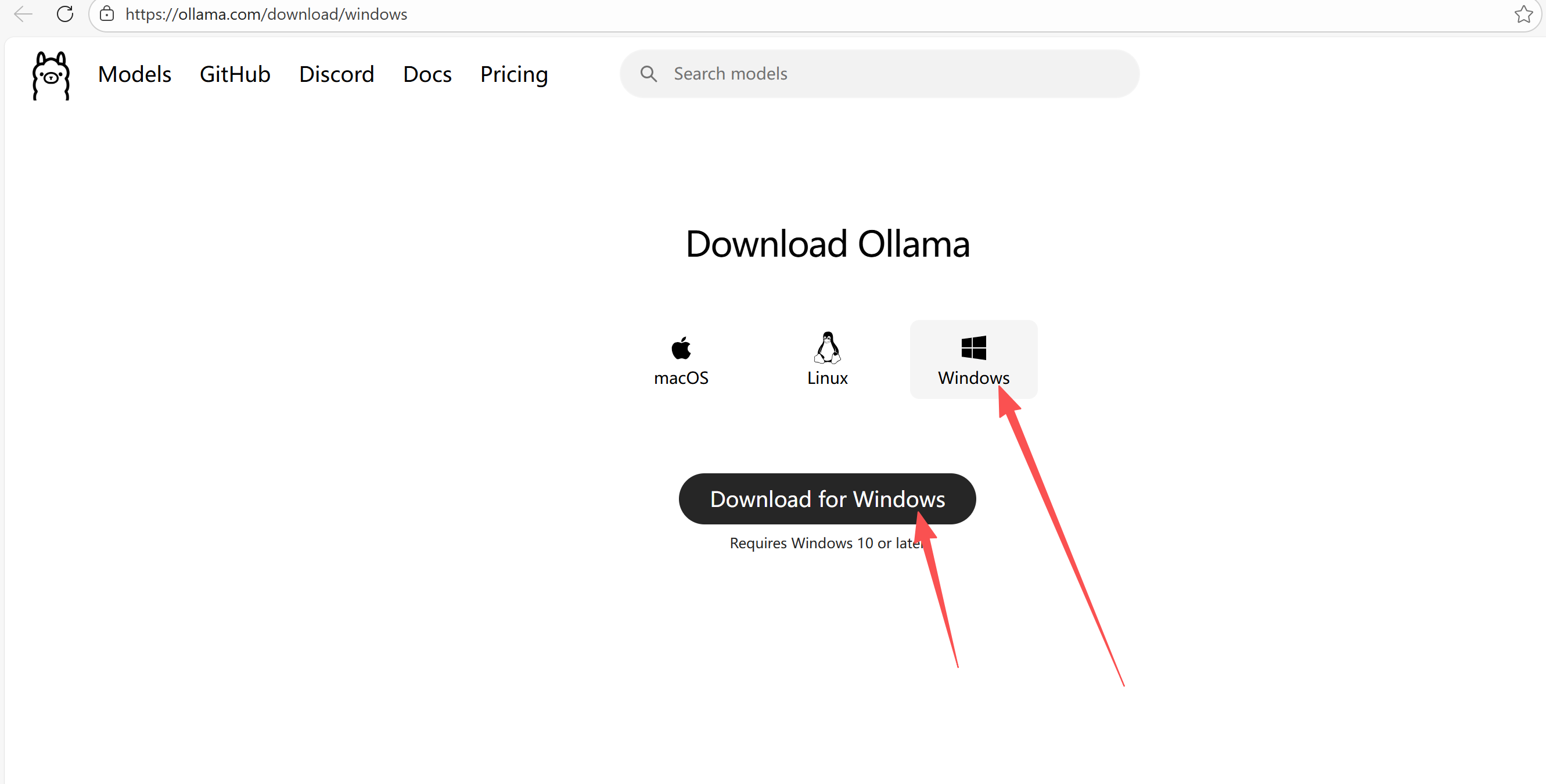

步骤 1:Ollama 下载与安装

-

官网下载(安全无捆绑)直接访问 Ollama 官方下载页:Ollama Windows 下载小白避坑:下载完成后得到

.exe安装包(文件名OllamaSetup.exe),无需纠结版本,官网默认提供最新稳定版。

-

安装步骤(全程无脑下一步,关键避坑)

- 双击

OllamaSetup.exe,弹出安装窗口,点击「Next」。 - 同意许可协议,点击「Next」。

- 选择安装路径:建议安装在非 C 盘(比如

D:\Software\Ollama),路径无中文、无空格(避免后续运行报错)。 - 点击「Install」,等待安装完成(约 1-2 分钟,安装包较小)。

- 安装完成后,点击「Finish」,Ollama 会自动后台运行(Windows 任务栏右下角会出现 Ollama 图标,说明启动成功)。

- 双击

-

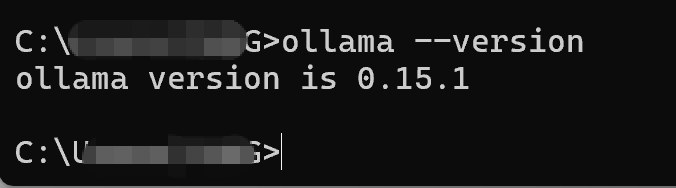

验证 Ollama 安装是否成功

- 打开 Windows 命令提示符(Win+R,输入

cmd,回车)。 - 输入验证命令:

ollama --version - 运行结果:显示

ollama version x.x.x(比如ollama version 0.1.29),说明安装成功且配置了环境变量;若提示「'ollama' 不是内部或外部命令」,重启电脑即可(Ollama 安装后会自动配置环境变量,重启生效)。

- 打开 Windows 命令提示符(Win+R,输入

步骤 2:拉取轻量大模型(小白首选,低显存占用)

前置说明

- 优先选择 0.5B/1B 参数的小模型(B = 参数规模,数值越小,显存占用越低,Windows 普通电脑(8G/16G 内存)也能流畅运行)。

- 推荐模型:

qwen2:0.5b(通义千问轻量版,中文支持好,适合小白),无需额外配置,终端一条命令即可拉取。

拉取操作(全程在 cmd 中执行)

- 打开 cmd,输入拉取命令(直接复制,回车执行):

ollama pull qwen2:0.5b - 等待下载完成:Ollama 会自动下载模型文件(约几百 MB,下载速度取决于网络),cmd 会显示下载进度条(

pulling manifest→pulling weights→success)。 - 小白避坑:

- 下载慢 / 卡住:无需手动干预,耐心等待,Ollama 会自动断点续传。

- 无网络无法下载:若后续电脑无网络,需提前在有网环境下拉取完成,模型文件会保存在 Ollama 安装目录,离线也能运行。

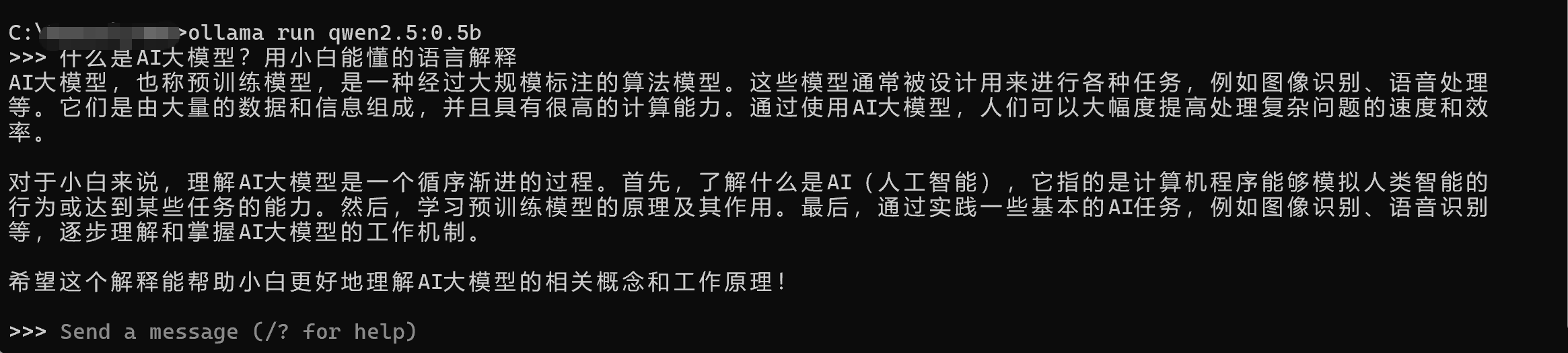

步骤 3:运行 Ollama 模型(交互式聊天,小白易上手)

- 启动模型:cmd 中输入运行命令,回车:

ollama run qwen2:0.5b - 验证启动成功:cmd 显示

>>>提示符,说明模型已就绪,可开始提问。 - 交互式聊天示例(直接在 cmd 中输入问题,回车即可得到回复):

- 输入:

什么是AI大模型?用小白能懂的语言解释 - 等待:模型会快速生成回复(小模型响应速度快,约 1-3 秒)。

- 继续提问:回复完成后,仍会显示

>>>,可继续输入下一个问题。

- 输入:

- 退出模型:输入

/bye,回车,即可退出交互式聊天,回到 cmd 默认提示符。

小白常见 Ollama 问题解决

- 模型运行卡顿:关闭电脑上其他大型软件(比如浏览器多标签、视频播放器),释放内存。

- 无法启动模型:检查 Ollama 后台是否运行(任务栏右下角有无 Ollama 图标),无则双击 Ollama 安装目录下的

ollama.exe启动。 - 回复乱码:模型本身支持中文,无需额外配置,乱码多为 cmd 编码问题,可右键 cmd 窗口→「属性」→「字体」,选择「Consolas」即可。

二、 第二部分:Streamlit 基础(搭建简单网页,Windows 环境 )

核心目标

用 Python+pip 安装 Streamlit,学会编写简单网页、运行网页,实现 “浏览器可视化界面”,为后续搭建聊天机器人界面铺路。

前置准备:验证 Python 与 pip(无 Anaconda 必备)

需确保电脑已单独安装 Python(且配置了环境变量),Streamlit 通过 pip 安装(Python 自带 pip 工具)。

- 打开 cmd,输入以下两个命令,验证是否可用:

# 验证Python python --version # 验证pip pip --version - 运行结果:显示对应版本号(比如

Python 3.10.13、pip 23.2.1),说明可用;若提示命令不识别,需先安装 Python(小白建议安装 Python 3.9/3.10,官网下载后勾选 “Add Python to PATH”)。

步骤 1:安装 Streamlit(pip 直接安装)

- 打开 cmd,输入安装命令(小白推荐使用国内镜像源,下载速度更快,避免超时失败):

pip install streamlit -i https://pypi.tuna.tsinghua.edu.cn/simple - 等待安装完成:cmd 会显示安装进度,最后提示

Successfully installed streamlit-x.x.x,说明安装成功。 - 小白避坑:

- 安装报错「Permission denied」:以 “管理员身份” 打开 cmd,重新执行安装命令。

- 提示 pip 版本过低:先升级 pip,输入

python -m pip install --upgrade pip -i https://pypi.tuna.tsinghua.edu.cn/simple,再安装 Streamlit。

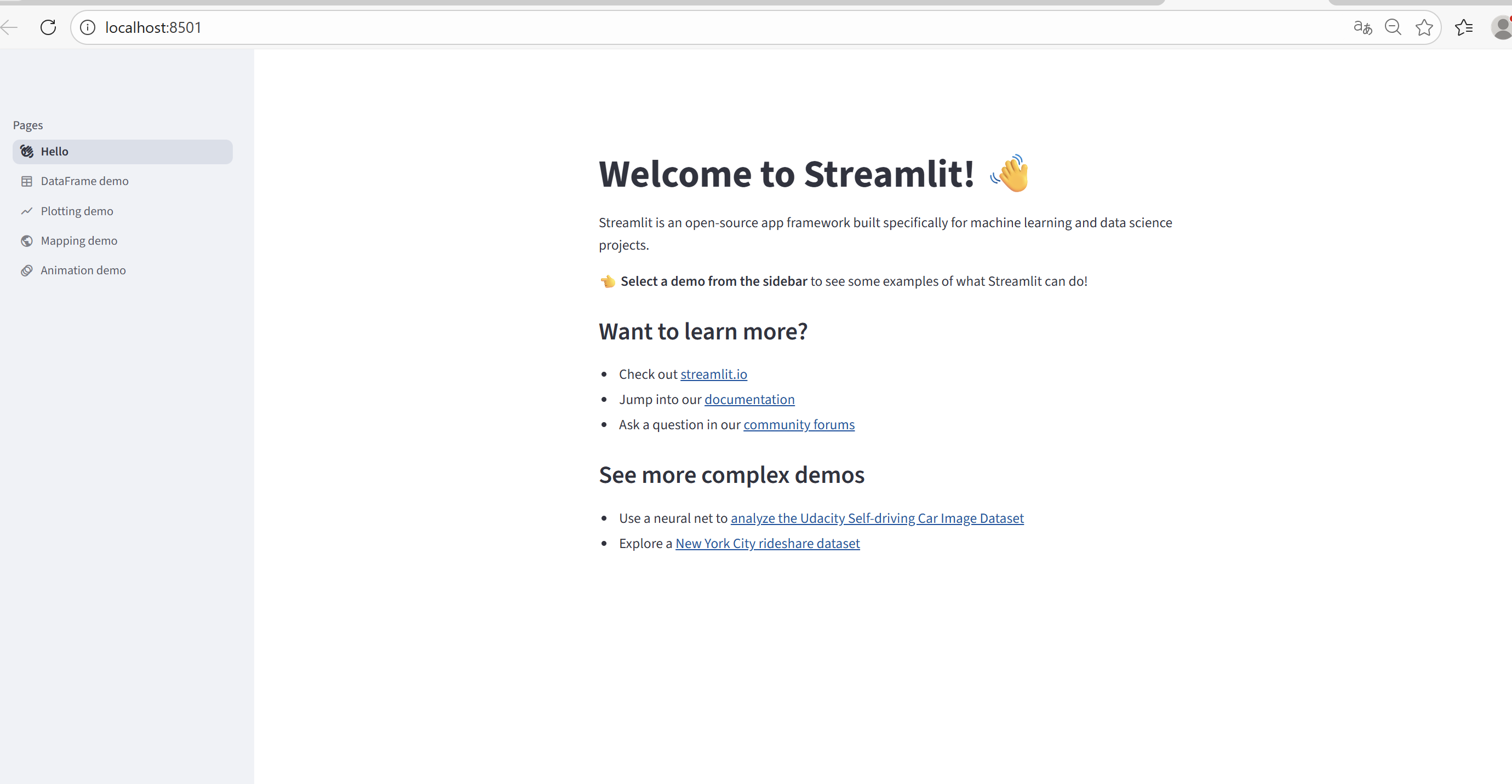

步骤 2:验证 Streamlit 安装(运行默认演示网页)

- cmd 中输入验证命令,回车:

streamlit hello - 自动执行流程:

- Streamlit 会自动启动本地服务(显示

You can now view your Streamlit app in your browser)。 - 自动打开默认浏览器,显示 Streamlit 演示网页(包含多个示例功能,比如绘图、数据展示)。

- Streamlit 会自动启动本地服务(显示

- 验证成功:浏览器能正常打开演示网页,且无报错,说明 Streamlit 安装完成且可正常运行。

- 关闭演示网页:

- 浏览器直接关闭即可。

- 回到 cmd,按

Ctrl + C,输入y回车,停止 Streamlit 服务。

步骤 3:编写第一个简单 Streamlit 网页(小白友好,无复杂逻辑)

核心说明

Streamlit 的核心优势:无需懂 HTML/CSS/JS,只用 Python 代码,就能搭建可视化网页,小白只需掌握几个基础函数,就能实现简单界面。

-

创建 Python 脚本文件

- 新建一个文件夹(存放 Streamlit 脚本,比如

D:\AI_Study\Streamlit_Projects,路径无中文、空格)。 - 在该文件夹中,右键→「新建」→「文本文档」,重命名为

first_streamlit_web.py(后缀必须改为.py,不是.txt,小白注意:需先显示文件扩展名,Windows 文件夹选项中勾选 “文件扩展名”)。

- 新建一个文件夹(存放 Streamlit 脚本,比如

-

编写网页代码(直接复制,注释详细)打开

first_streamlit_web.py,粘贴以下代码,保存文件(Ctrl+S):# 导入Streamlit库,简写为st(小白固定写法,无需修改) import streamlit as st # 1. 设置网页标题(显示在浏览器标签栏) st.set_page_config(page_title="小白学AI第一个网页") # 2. 添加网页大标题(一级标题,居中显示) st.title("✨ 小白AI学习网页演示") # 3. 添加普通文本内容(支持换行、格式化) st.write("这是用Streamlit搭建的第一个简单网页,无需懂前端知识!") st.write("对应大纲中的「搭建简单网页」学习目标,后续可升级为聊天机器人界面。") # 4. 添加输入框(获取用户输入的姓名) user_name = st.text_input("请输入你的姓名:") # 5. 添加按钮(点击按钮后,显示问候语) if st.button("点击获取问候"): # 判断用户是否输入了姓名 if user_name: st.success(f"你好,{user_name}!祝你顺利掌握AI大模型开发~") else: st.warning("请先输入你的姓名哦!") # 6. 添加分隔线和备注文本 st.divider() st.caption("Streamlit基础演示 | 零基础小白友好") -

运行 Streamlit 网页

- 打开 cmd,切换到脚本所在文件夹(比如

D:\AI_Study\Streamlit_Projects),输入切换目录命令(修改为你的文件夹路径):cd D:\AI_Study\Streamlit_Projects - 输入运行命令,回车:

streamlit run first_streamlit_web.py

- 打开 cmd,切换到脚本所在文件夹(比如

-

查看运行结果

- Streamlit 自动启动本地服务,打开默认浏览器,显示你编写的网页。

- 实操测试:输入姓名,点击按钮,查看是否显示成功问候语,体验网页交互流程。

-

核心基础语法总结(小白入门必备)

Streamlit 函数 作用 st.title()添加一级标题,突出核心主题 st.write()添加普通文本、数据,支持格式化 st.text_input()添加文本输入框,获取用户输入 st.button()添加交互按钮,点击触发逻辑 st.success()/st.warning()显示带颜色的提示信息

步骤 4:关闭 Streamlit 服务

- 浏览器关闭网页后,回到 cmd,按

Ctrl + C,输入y回车,即可停止本地服务,恢复 cmd 默认状态。

小白常见 Streamlit 问题解决

- 运行命令报错「No such file or directory」:检查

cd命令是否切换到了脚本所在文件夹,或脚本文件名是否输入正确(区分大小写)。 - 浏览器无法打开网页:cmd 中显示的网址(比如

http://localhost:8501),手动复制到浏览器地址栏,回车访问。 - 网页无响应:关闭其他占用内存的软件,按

Ctrl + C停止服务,重新运行脚本。

三、 综合实操:整合 Ollama 与 Streamlit(简易聊天界面预览)

核心目标

简单整合两者,让你直观看到 “网页界面调用本地 Ollama 模型” 的效果,后续深入学习可完善该功能,对应大纲中的「本地聊天机器人」项目。

-

创建整合脚本:在

Streamlit_Projects文件夹中,新建ollama_streamlit_chat.py,粘贴以下代码:import streamlit as st import subprocess # 设置网页标题 st.set_page_config(page_title="小白简易AI聊天机器人") st.title("🤖 本地大模型聊天界面(Ollama+Streamlit)") # 输入框:获取用户提问 user_question = st.text_input("请输入你的问题:") # 按钮:提交问题,调用Ollama模型 if st.button("发送提问"): if user_question: st.info("模型正在思考中...") # 调用Ollama模型(qwen2:0.5b),获取回复 try: # 执行Ollama命令,获取输出结果 result = subprocess.run( ["ollama", "run", "qwen2:0.5b", user_question], capture_output=True, text=True, encoding="utf-8" ) # 显示模型回复 st.success("模型回复:") st.write(result.stdout) except Exception as e: st.error(f"出错啦:{str(e)}") else: st.warning("请先输入你的问题哦!") -

运行整合脚本:

- cmd 切换到脚本文件夹,输入命令:

streamlit run ollama_streamlit_chat.py - 浏览器打开网页后,输入问题(比如「什么是 LoRA 微调?」),点击「发送提问」,等待模型回复。

- cmd 切换到脚本文件夹,输入命令:

-

注意事项:该脚本为简易版本,仅作演示,后续可学习优化(比如持续聊天、格式美化等),核心是让你理解 “网页工具调用本地大模型” 的逻辑。

总结

- Ollama 核心:Windows 安装无脑下一步,拉取轻量模型(

qwen2:0.5b),运行命令ollama run 模型名,交互式聊天用/bye退出。 - Streamlit 核心:无 Anaconda 时用

pip安装(搭配国内镜像源),核心命令streamlit run 脚本名.py,入门只需掌握st.title()/st.text_input()等基础函数。 - 关键避坑:所有路径无中文 / 空格,cmd 命令验证安装是否成功,运行报错优先检查命令拼写和环境变量。

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)