AI原生应用API编排:从入门到精通的完整教程

AI原生应用:不是“把AI嵌到传统应用里”,而是以AI为核心驱动力的应用。比如ChatGPT插件、Claude的Tool Use、字节的豆包企业版,它们的核心逻辑是“AI根据用户需求,自主调用工具(API)完成任务”。传统API整合:更关注“功能拼接”(比如把支付API加到电商系统);而AI原生API编排更关注“AI驱动的协同”——LLM需要理解用户意图,决定调用哪些API,处理非结构化输出,再生

AI原生应用API编排:从入门到精通的完整教程

1. 引入与连接:为什么API编排是AI原生应用的“神经中枢”?

1.1 一个真实的痛点场景

想象你是一家电商公司的AI产品经理,正在推动“智能购物助手”项目:

用户发送语音“我想买一件适合周末爬山的防水外套,预算500以内”,系统需要完成以下步骤:

- 语音转文字(调用ASR API,比如阿里通义听悟);

- 意图识别(用LLM提取关键信息:周末爬山、防水外套、预算500);

- 商品检索(调用电商平台的商品API,筛选“防水外套+价格≤500”);

- 库存校验(调用库存API,排除缺货商品);

- 推荐生成(用LLM整合商品信息,生成自然语言回复:“为你推荐3款符合需求的防水外套,其中XX款今天下单立减50,库存仅剩12件”);

- 语音输出(调用TTS API,把文字转成拟人化语音)。

如果没有API编排,你需要写大量胶水代码:处理每个API的请求/响应、管理上下文(比如用户的预算)、处理错误(比如ASR识别失败)、协调并行调用(比如同时查商品和库存)。代码会变成“意大利面”——混乱、难维护、易出错。

而API编排就是解决这个问题的“魔法工具”:它像一个“AI应用的指挥家”,把零散的API整合成协同工作的系统,让复杂流程变得可管理、可扩展。

1.2 为什么是“AI原生应用”?

在继续之前,我们需要明确两个关键概念:

- AI原生应用:不是“把AI嵌到传统应用里”,而是以AI为核心驱动力的应用。比如ChatGPT插件、Claude的Tool Use、字节的豆包企业版,它们的核心逻辑是“AI根据用户需求,自主调用工具(API)完成任务”。

- 传统API整合:更关注“功能拼接”(比如把支付API加到电商系统);而AI原生API编排更关注“AI驱动的协同”——LLM需要理解用户意图,决定调用哪些API,处理非结构化输出,再生成符合需求的结果。

1.3 本教程的学习价值

学完这篇教程,你将掌握:

- 从0到1设计AI原生应用的API编排流程;

- 解决API编排中的核心问题(上下文、错误、性能);

- 用主流工具(LangChain、LlamaIndex、AWS Step Functions)落地真实项目;

- 理解AI原生应用的未来趋势(自动编排、多模态)。

接下来,我们从“概念地图”开始,逐步搭建知识体系。

2. 概念地图:AI原生API编排的核心框架

2.1 核心概念全景图

先看一张AI原生API编排的概念图谱,帮你建立整体认知:

AI原生应用

├─ 核心目标:AI驱动的任务自动化

├─ 关键组件:

│ ├─ 输入层:用户请求(语音/文本/图像)、数据库、第三方系统

│ ├─ AI能力层:LLM(GPT-4、通义千问)、ASR/TTS(语音)、CV(图像识别)、Embedding(向量生成)

│ ├─ 工具层:第三方API(天气、支付、商品)、内部服务(库存、订单)

│ ├─ 编排层:编排引擎(LangChain、LlamaIndex)、工作流管理(AWS Step Functions)

│ └─ 输出层:用户界面(APP/小程序)、API接口、报告文档

└─ 核心逻辑:

├─ 意图理解(LLM解析用户需求)

├─ 工具选择(LLM决定调用哪些API)

├─ 流程编排(按顺序/分支/并行调用API)

├─ 结果整合(LLM把API输出转化为自然语言)

└─ 反馈优化(根据用户反馈调整流程)

2.2 关键术语定义

为避免歧义,先明确几个高频术语:

- API编排(API Orchestration):将多个API(AI/非AI)按特定逻辑组合,实现复杂任务的过程。核心是“协同”而非“堆叠”。

- 编排引擎(Orchestration Engine):实现API编排的工具,比如LangChain(专注LLM+工具)、Apache Camel(企业级集成)、Prefect(工作流管理)。

- 工具调用(Tool Calling):LLM根据用户需求,自主调用外部API的能力(比如GPT-4的Function Call、Claude 3的Tool Use)。

- 上下文管理(Context Management):保存用户对话历史、API调用记录等信息,让LLM能理解“前后文”(比如用户之前说过“预算500”,后续不需要再重复)。

3. 基础理解:用“餐厅后厨”类比API编排

3.1 生活化类比:API编排=餐厅后厨的“协同流程”

如果你没接触过API编排,不妨用“餐厅后厨”来类比:

- 用户订单:相当于“用户请求”(比如“我要一份番茄鸡蛋面+冰可乐”);

- 服务员:相当于“API网关”(接收订单,传给后厨);

- 厨师:相当于“各个API”(比如做面的厨师=商品API,做可乐的厨师=饮料API);

- 配菜员:相当于“编排引擎”(把做好的面和可乐组合起来,确保顺序正确);

- 传菜员:相当于“输出层”(把最终结果传给用户)。

这个类比能帮你快速理解:API编排不是“让每个API单独工作”,而是“让它们按规则协同,共同完成用户需求”。

3.2 最简API编排示例:天气查询助手

我们用一个极简案例,让你直观感受API编排的工作流程:

需求:用户输入“北京明天的天气怎么样?”,系统返回“北京明天晴,气温15-25℃,适合户外活动”。

编排流程:

- 输入处理:用户输入文本“北京明天的天气怎么样?”;

- 意图识别:用LLM提取关键词“北京”(地点)、“明天”(时间);

- 工具调用:调用天气API(比如OpenWeatherMap),传入“北京+明天”;

- 结果整合:LLM把API返回的JSON(比如

{"city":"北京","date":"2024-05-20","weather":"晴","temp_min":15,"temp_max":25})转化为自然语言; - 输出:返回用户“北京明天晴,气温15-25℃,适合户外活动”。

这个案例虽简单,但包含了API编排的核心要素:意图解析→工具选择→结果整合。

3.3 常见误解澄清

-

❌ 误解1:API编排就是“按顺序调用API”?

不对。编排还包括分支(根据条件选API)、并行(同时调用多个API)、循环(重复调用直到满足条件)。比如用户问“杭州和上海明天的天气”,需要并行调用两个天气API,再整合结果。 -

❌ 误解2:只有AI API需要编排?

不对。非AI API(比如支付、库存)是AI原生应用的“基础设施”。比如智能购物助手需要同时调用“商品API(AI)”和“库存API(非AI)”。 -

❌ 误解3:编排引擎会取代程序员?

不对。编排引擎是“辅助工具”,程序员需要设计流程逻辑、处理边界条件(比如API调用失败)、优化性能。

4. 层层深入:从“流程设计”到“底层逻辑”

4.1 第一步:明确API编排的“四要素”

设计任何API编排流程前,都要先明确四个核心要素:

- 目标(Goal):你要解决什么问题?比如“帮用户生成周末旅行计划”。

- 输入(Input):用户提供什么信息?比如“目的地=杭州,时间=周末,预算=2000”。

- 工具(Tools):需要调用哪些API?比如天气API、景点API、酒店API、LLM。

- 输出(Output):给用户返回什么?比如“分点的旅行计划+酒店推荐链接”。

4.2 第二步:掌握API编排的“四种模式”

API编排的核心是“流程逻辑”,常见有四种模式:

模式1:顺序编排(Sequential)

定义:按固定顺序调用API,前一个API的输出是后一个的输入。

示例:语音助手→ASR(语音转文字)→LLM(理解意图)→TTS(文字转语音)。

适用场景:流程步骤固定,无分支的任务。

模式2:分支编排(Branching)

定义:根据条件选择不同的API调用路径。

示例:智能客服→用户问“订单状态”→调用订单API→如果“已发货”→调用物流API;如果“未发货”→调用库存API。

实现方式:用if-else逻辑或规则引擎(比如Drools)。

模式3:并行编排(Parallel)

定义:同时调用多个API,再合并结果。

示例:新闻摘要→同时调用纽约时报API、BBC API→LLM整合两条新闻的摘要。

优势:减少总延迟(比如两个API各需1秒,并行只需1秒,顺序需2秒)。

注意:需要处理“结果对齐”(比如两个API返回的时间格式不一致)。

模式4:循环编排(Loop)

定义:重复调用某个API,直到满足条件。

示例:智能写作→用户要求“把文章改得更口语化”→调用LLM改写→如果用户不满意→再次调用LLM→直到用户确认。

注意:需要设置“终止条件”(比如最多重试3次),避免死循环。

4.3 第三步:解决API编排的“三大核心问题”

掌握模式后,你需要解决三个最常见的挑战:

问题1:上下文管理——让AI“记得之前的对话”

场景:用户先问“北京明天天气”,再问“那上海呢?”,如果没有上下文管理,LLM会误以为“上海明天天气”是独立请求,但实际上用户是问“上海明天的天气(和北京对比)”。

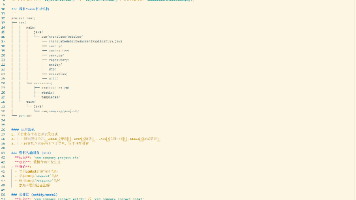

解决方案:用“记忆组件”保存对话历史,比如LangChain的ConversationBufferMemory:

from langchain.memory import ConversationBufferMemory

from langchain.chains import ConversationChain

from langchain_openai import OpenAI

# 初始化记忆组件(保存最近5轮对话)

memory = ConversationBufferMemory(k=5)

# 初始化LLM

llm = OpenAI(temperature=0)

# 构建对话链(整合LLM和记忆)

conversation = ConversationChain(llm=llm, memory=memory)

# 第一次对话

response1 = conversation.predict(input="北京明天天气怎么样?")

# 第二次对话(上下文:用户之前问过北京)

response2 = conversation.predict(input="那上海呢?")

原理:每次调用LLM时,ConversationBufferMemory会把之前的对话历史一起传给LLM,让它理解上下文。

问题2:错误处理——API调用失败怎么办?

场景:调用天气API时,网络超时或API密钥过期,导致流程中断。

解决方案:设计“容错机制”,常见策略:

- 重试(Retry):比如重试3次,每次间隔1秒(用

tenacity库实现); - 降级(Fallback):如果天气API失败,返回“暂时无法获取天气信息,建议稍后重试”;

- 熔断(Circuit Breaker):如果API连续失败5次,暂时停止调用(用

pybreaker库实现)。

示例(用LangChain的重试机制):

from langchain.tools import tool

from tenacity import retry, stop_after_attempt, wait_exponential

@tool

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=1, max=10))

def get_weather(city: str, date: str) -> str:

"""调用天气API获取指定城市的天气"""

# 模拟API调用失败

if city == "北京":

raise Exception("天气API超时")

return f"{city} {date} 晴,气温15-25℃"

问题3:性能优化——如何减少总延迟?

场景:调用3个API,每个需1秒,顺序调用需3秒,用户等待时间太长。

解决方案:

- 并行调用:用

asyncio或编排引擎的并行功能(比如LangChain的ParallelToolCall); - 缓存:把频繁调用的结果缓存(比如“北京今天天气”,1小时内不需要重复调用);

- 轻量化API:选择响应更快的API(比如用国内的天气API替代国外的)。

示例(LangChain并行调用):

from langchain.tools import Tool

from langchain.agents import initialize_agent, AgentType

from langchain_openai import OpenAI

# 定义两个工具(并行调用)

tool1 = Tool(

name="GetWeather",

func=lambda city: f"{city} 晴",

description="获取城市天气"

)

tool2 = Tool(

name="GetAttraction",

func=lambda city: f"{city} 热门景点:西湖",

description="获取城市热门景点"

)

# 初始化Agent(支持并行调用)

agent = initialize_agent(

[tool1, tool2],

OpenAI(temperature=0),

agent=AgentType.STRUCTURED_CHAT_ZERO_SHOT_REACT_DESCRIPTION,

verbose=True

)

# 并行调用两个工具

response = agent.run("告诉我杭州的天气和热门景点")

4.4 第四步:理解API编排的“底层逻辑”

到这一步,你已经能设计基本的编排流程,但要“精通”,还需要理解底层逻辑:

逻辑1:API编排的“契约”——接口标准化

API编排的前提是接口标准化:每个API的请求/响应格式要一致(比如用JSON),参数要明确(比如city是字符串,date是YYYY-MM-DD)。

反例:天气API1返回{"city":"北京","temp":15},天气API2返回{"location":"上海","temperature":20},整合时需要额外处理格式差异。

解决方案:用“API网关”(比如Apigee、阿里云API网关)统一接口格式。

逻辑2:AI原生编排的“灵魂”——LLM的意图理解

传统API编排的核心是“流程规则”(比如if 订单状态=已发货 then 调用物流API),而AI原生编排的核心是“LLM的意图理解”——LLM需要根据用户的自然语言请求,自主决定调用哪些API。

示例:用户说“我想周末去杭州玩,推荐几个适合拍照的景点”,LLM需要:

- 提取意图:“周末杭州拍照景点推荐”;

- 分析需要的工具:天气API(查周末天气)、景点API(查适合拍照的景点);

- 决定调用顺序:先查天气(如果下雨,推荐室内景点),再查景点。

逻辑3:编排的“边界”——什么该编,什么不该编?

不是所有API都需要编排:

- 该编:需要协同的API(比如ASR→LLM→TTS)、需要上下文的API(比如对话历史);

- 不该编:独立的、无依赖的API(比如获取用户头像)。

5. 多维透视:从“历史”到“未来”的API编排

5.1 历史视角:API编排的演进之路

API编排不是新事物,它的演进经历了三个阶段:

- 传统企业集成(2000-2010):用企业服务总线(ESB)整合企业内部系统(比如ERP→CRM),核心是“中心化集成”;

- 云原生API管理(2010-2020):用API网关(比如AWS API Gateway)管理云服务API,核心是“分布式集成”;

- AI原生编排(2020-至今):用LLM驱动的编排引擎(比如LangChain)整合AI/非AI API,核心是“智能协同”。

5.2 实践视角:主流工具的对比与选择

现在有很多API编排工具,我们对比最常用的5个,帮你选择:

| 工具 | 定位 | 优势 | 劣势 | 适用场景 |

|---|---|---|---|---|

| LangChain | LLM+工具编排 | 专注AI原生应用,文档全,社区大 | 企业级功能弱(比如权限管理) | 快速搭建智能助手、聊天机器人 |

| LlamaIndex | 数据+LLM编排 | 擅长连接私有数据(比如知识库) | 工具调用功能不如LangChain | 企业知识库问答、个性化推荐 |

| AWS Step Functions | 云原生工作流管理 | 可靠、可扩展,整合AWS服务 | 学习成本高,不适合快速原型 | 企业级自动化工作流(比如订单处理) |

| Apache Camel | 企业级集成框架 | 支持200+协议,高度自定义 | 配置复杂,不适合AI原生应用 | 传统企业系统集成 |

| Prefect | 数据管道编排 | 可视化界面,监控功能强 | 不擅长LLM工具调用 | 数据处理流程(比如ETL) |

5.3 批判视角:API编排的“痛点”

API编排不是银弹,它有自己的局限性:

- 兼容性问题:不同API的接口格式、参数命名不一致,需要额外适配;

- 成本问题:多个API的费用叠加(比如调用GPT-4+天气API+商品API,每用户请求成本可能高达0.1元);

- 可解释性问题:LLM自主调用工具时,很难解释“为什么选这个API”(比如用户问“为什么推荐这个酒店”,系统可能无法给出明确理由);

- 性能问题:并行调用多个API时,总延迟可能比顺序调用高(比如网络拥堵时)。

5.4 未来视角:API编排的“进化方向”

API编排的未来会向四个方向发展:

- 自动编排(Auto-Orchestration):LLM自主设计编排流程,不需要人工干预。比如用户说“帮我做一个周末旅行计划”,LLM自己决定调用哪些API,设计流程;

- 多模态编排(Multimodal Orchestration):整合文本、图像、语音、视频API。比如用户上传一张风景照,系统调用CV API识别地点,再调用天气API查当地天气,最后用LLM生成旅行建议;

- 边缘编排(Edge Orchestration):在边缘设备(比如手机、IoT设备)上做轻量化编排,减少云端延迟。比如手机上的语音助手,本地调用ASR和TTS,云端调用LLM;

- 联邦编排(Federated Orchestration):跨组织的API协同。比如银行和电商合作,共同编排支付API和商品API,实现“一键购物+分期支付”。

6. 实践转化:用LangChain搭建“智能旅行助手”

6.1 项目背景与目标

背景:用户需要一个“智能旅行助手”,输入“周末去杭州玩,预算2000”,系统返回:

- 杭州周末天气;

- 3个热门景点推荐;

- 2个符合预算的酒店推荐;

- 一份详细的行程安排。

目标:用LangChain编排天气API、景点API、酒店API和OpenAI LLM,实现上述功能。

6.2 技术栈选择

- LLM:OpenAI GPT-3.5-turbo(成本低,响应快);

- 天气API:OpenWeatherMap(免费,全球覆盖);

- 景点API:高德地图API(国内数据全);

- 酒店API:飞猪API(覆盖国内酒店);

- 编排工具:LangChain(专注LLM+工具,文档全)。

6.3 具体实现步骤

步骤1:安装依赖库

pip install langchain langchain-openai python-dotenv requests

步骤2:配置API密钥

创建.env文件,保存API密钥:

OPENAI_API_KEY=your-openai-key

OPENWEATHERMAP_API_KEY=your-openweathermap-key

AMAP_API_KEY=your-amap-key

FLIGGY_API_KEY=your-fliggy-key

步骤3:定义工具函数

用LangChain的@tool装饰器定义工具:

import os

import requests

from dotenv import load_dotenv

from langchain.tools import tool

# 加载环境变量

load_dotenv()

# 1. 天气工具(调用OpenWeatherMap)

@tool

def get_weather(city: str, date: str) -> str:

"""获取指定城市指定日期的天气,date格式为YYYY-MM-DD"""

url = f"https://api.openweathermap.org/data/2.5/forecast?q={city}&appid={os.getenv('OPENWEATHERMAP_API_KEY')}&units=metric"

response = requests.get(url)

data = response.json()

# 提取指定日期的天气(简化处理)

for item in data["list"]:

if item["dt_txt"].startswith(date):

weather = item["weather"][0]["description"]

temp_min = item["main"]["temp_min"]

temp_max = item["main"]["temp_max"]

return f"{city} {date} 的天气:{weather},气温{temp_min}~{temp_max}℃"

return f"无法获取{city} {date}的天气"

# 2. 景点工具(调用高德地图)

@tool

def get_attractions(city: str, num: int = 3) -> str:

"""获取指定城市的热门景点,num为推荐数量"""

url = f"https://restapi.amap.com/v3/place/text?keywords=景点&city={city}&output=json&key={os.getenv('AMAP_API_KEY')}&offset={num}"

response = requests.get(url)

data = response.json()

attractions = [poi["name"] for poi in data["pois"]]

return f"{city}的热门景点:{', '.join(attractions)}"

# 3. 酒店工具(调用飞猪API,简化模拟)

@tool

def get_hotels(city: str, budget: int, num: int = 2) -> str:

"""获取指定城市符合预算的酒店,budget为预算(元/晚),num为推荐数量"""

# 模拟飞猪API返回结果

hotels = [

{"name": "杭州西湖宾馆", "price": 450, "distance": "距西湖1km"},

{"name": "杭州武林广场酒店", "price": 380, "distance": "距地铁站500m"},

{"name": "杭州滨江酒店", "price": 320, "distance": "距景点2km"}

]

# 筛选符合预算的酒店

filtered = [h for h in hotels if h["price"] <= budget]

# 取前num个

top = filtered[:num]

# 格式化输出

return "\n".join([f"- {h['name']}:{h['price']}元/晚,{h['distance']}" for h in top])

步骤4:初始化LLM和Agent

用LangChain的initialize_agent初始化Agent,支持工具调用:

from langchain_openai import ChatOpenAI

from langchain.agents import initialize_agent, AgentType

from langchain.memory import ConversationBufferMemory

# 初始化LLM(GPT-3.5-turbo)

llm = ChatOpenAI(model_name="gpt-3.5-turbo", temperature=0.7)

# 初始化记忆组件(保存对话历史)

memory = ConversationBufferMemory(memory_key="chat_history", return_messages=True)

# 初始化Agent(结构化聊天Agent,支持工具调用)

agent = initialize_agent(

tools=[get_weather, get_attractions, get_hotels],

llm=llm,

agent=AgentType.CHAT_CONVERSATIONAL_REACT_DESCRIPTION,

memory=memory,

verbose=True # 打印调试信息

)

步骤5:测试运行

调用Agent,输入用户请求:

# 用户请求:周末去杭州玩,预算2000

user_input = "我想周末(2024-06-15至2024-06-16)去杭州玩,预算2000元,帮我做一个旅行计划"

# 运行Agent

response = agent.run(user_input)

# 打印结果

print("===== 智能旅行计划 =====")

print(response)

步骤6:结果示例

Agent的输出会类似:

===== 智能旅行计划 =====

以下是为你定制的杭州周末旅行计划:

**一、天气情况**

杭州 2024-06-15 的天气:晴,气温20~28℃;

杭州 2024-06-16 的天气:多云,气温19~27℃。

整体天气适宜户外活动,建议携带防晒用品。

**二、景点推荐**

1. 西湖(热门景点,推荐骑行游览);

2. 灵隐寺(佛教圣地,适合祈福);

3. 宋城(大型宋代主题公园,有精彩演出)。

**三、酒店推荐**

- 杭州西湖宾馆:450元/晚,距西湖1km(适合想靠近景点的用户);

- 杭州武林广场酒店:380元/晚,距地铁站500m(交通便利)。

**四、行程安排**

- **Day1(6.15)**:上午逛西湖(骑行),中午吃西湖醋鱼,下午去灵隐寺,晚上住西湖宾馆;

- **Day2(6.16)**:上午去宋城看演出,中午吃宋城小吃,下午返程。

总预算约1800元(酒店450*2 + 景点门票300 + 餐饮500 + 交通100),符合你的预算需求。

6.4 常见问题排查

- 工具调用失败:检查API密钥是否正确,网络是否通畅,参数格式是否符合要求;

- 结果不准确:调整LLM的

temperature(降低=更准确,升高=更多样),优化工具的description(让LLM更清楚工具的功能); - 上下文丢失:确保

memory组件正确初始化,并且memory_key与Agent的要求一致。

7. 整合提升:从“会用”到“精通”的思维升级

7.1 核心观点回顾

- AI原生应用的核心:不是“用AI”,而是“让AI驱动协同”——API编排是实现这一目标的关键;

- API编排的本质:是“规则+智能”的结合——规则确保流程稳定,智能(LLM)确保灵活性;

- 设计原则:先明确目标与输入,再选择工具,最后设计流程;

- 关键能力:上下文管理、错误处理、性能优化是区分“入门”与“精通”的关键。

7.2 知识体系重构

学完本教程后,你可以用以下框架重构API编排的知识体系:

API编排知识体系

├─ 基础层:概念(API编排、编排引擎)、类比(餐厅后厨)、示例(天气查询)

├─ 流程层:四要素(目标、输入、工具、输出)、四种模式(顺序、分支、并行、循环)

├─ 技术层:上下文管理(ConversationBufferMemory)、错误处理(重试/降级)、性能优化(并行/缓存)

├─ 工具层:LangChain(LLM+工具)、AWS Step Functions(云原生)、LlamaIndex(数据+LLM)

├─ 实践层:智能旅行助手(LangChain实现)、常见问题排查

└─ 未来层:自动编排、多模态编排、边缘编排

7.3 拓展任务:挑战更复杂的项目

为了巩固知识,你可以尝试以下拓展任务:

- 任务1:给智能旅行助手添加“美食推荐”功能,调用大众点评API;

- 任务2:将智能旅行助手部署成API接口(用FastAPI),供前端调用;

- 任务3:用LlamaIndex连接私有知识库(比如公司的旅行攻略文档),让助手能回答更个性化的问题;

- 任务4:用AWS Step Functions替换LangChain,实现企业级的旅行计划流程(比如添加审批步骤)。

7.4 学习资源推荐

- 官方文档:LangChain Docs(https://python.langchain.com/)、OpenAI Tool Calling Docs(https://platform.openai.com/docs/guides/function-calling);

- 书籍:《LangChain for LLM Application Development》(作者:Hamel Husain)、《Building AI-Powered Applications》(作者:David Blank-Edelman);

- 社区:LangChain Discord(https://discord.gg/langchain)、知乎“AI原生应用”话题;

- 课程:Coursera《AI for Everyone》、Udemy《LangChain: Build Powerful LLM Applications》。

结语:API编排是AI原生应用的“桥梁”

AI原生应用的未来,在于“AI与现实世界的连接”——而API编排就是这座连接的“桥梁”。它让LLM能调用工具,让工具能协同工作,让用户需求能快速转化为实际价值。

从入门到精通的过程,不是“学习更多工具”,而是“理解更底层的逻辑”:如何让AI更智能地协同工具,如何让流程更稳定地运行,如何让用户更高效地获得价值。

现在,拿起你的代码编辑器,开始搭建属于自己的AI原生应用吧——API编排会成为你最有力的武器。

下一步行动:打开LangChain的文档,尝试修改“智能旅行助手”的代码,添加一个新的工具(比如美食推荐)。你会发现,API编排的世界,比你想象的更精彩。

更多推荐

已为社区贡献125条内容

已为社区贡献125条内容

所有评论(0)