【热梗】大模型团队不需要“打工人“!Multi-Agent架构新思路:让AI化身“数字分身“,记忆决定角色!

Multi-Agent系统中的角色分工被过度强调,真正的价值在于"上下文分片"。AI技能边界是弹性的,不像人类受学习时间约束,多Agent的本质是"分心"而非"分工",通过隔离记忆保证注意力密度。Agent间通过消息传递而非共享记忆协作,未来个人AI助手将是由多个"只记得某一方面生活的自己"组成的团队,让记忆决定角色,让消息连接分身。

在关于 Multi-Agent 的讨论里,总是充斥着各种"角色设定":Planner、Coder、Reviewer、Writer……

这些角色像流水线工位一样被精心分配,专业的Agent做专业的事,人类团队就是这么协作的,专业的分工产生效率已经成为了默认的事实。

但如果我们的思考再深入一层,人类的分工是要解决什么问题呢?

一、 被高估的"技能",被低估的"记忆"

让我们先承认一个让很多 Agent 框架尴尬的事实:AI 其实是"全能"的。

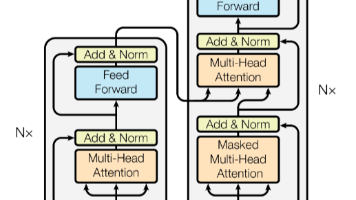

你给一个 LLM 装上代码解释器,它能写代码;装上浏览器,它能上网调研;装上计算器,它能做数学。所谓的"Coder Agent"和"Researcher Agent",在底层能力上并没有本质区别——它们都是同一个大模型,只是被塞进了不同的 System Prompt。

这和人类团队截然不同。

人类之所以需要分工,是因为学习时间的刚性约束:一个人不可能同时精通心脏外科和刑事辩护。我们用"技能"来切分职责,是迫不得已——因为技能的边界是刚性的,需要数年甚至数十年才能跨越。

但 AI 的技能边界是弹性的。你只需要换一套提示词,“刑事律师"就能瞬间变成"心脏外科顾问”(当然,你不会真的让它给你开刀)。

那么问题来了:既然技能可以随时切换,我们为什么还需要多个 Agent?

答案藏在另一个地方:不是技能,是记忆。

二、 记忆即身份

可以思考一下这个问题:一个在公司干了五年的"老员工",和一个刚入职的"行业专家",谁更可靠?

从技能栈来看,行业专家可能更强——更新的方法论,更广的视野,更漂亮的履历。

但任何在真实组织里待过的人都知道:老员工可靠,不是因为会得多,而是因为他见证过系统是怎么一步步长成这样的。

他知道那个看起来很蠢的 if-else 是为了修复三年前的一个生产事故;他记得那次重构为什么最后放弃了;他清楚这个客户有哪些雷区不能踩。

这些东西,没法写进文档,没法通过培训传递。它们是不可压缩的经历。

技能可以复制粘贴,但"踩过的坑"没法转让。

定义一个专家的,从来不是他的技能栈(Skill Set),而是他的经历(Memory)。

而这个类比对于 Agent,同样适用。

三、 上下文分片:多 Agent 的真正价值

回到我们的问题:既然一个 LLM 什么都能干,为什么还要拆成多个 Agent?

答案是:为了隔离上下文。

这里的"上下文",指的是 Agent 的 Context Window——它在处理当前任务时,能"看到"和"记住"的所有信息。

在之前的文章《软件设计的第一性原理》里,我提出过一个观点:无论是人类大脑还是 AI 模型,处理能力都受限于上下文窗口。 即使是号称百万 Token 的超长上下文模型,研究表明其"有效上下文"远小于宣称值——注意力会稀释,噪声会累积。

这就引出了多 Agent 的真正价值:Context Sharding(上下文分片)。

想象一下:

- Project Agent:它的记忆里只有代码库、PR 记录、架构文档、技术决策的历史。

- Life Agent:它的记忆里只有你的日程、家人的喜好、健康数据、待办事项。

它们的"能力"是一样的——都能写代码、都能联网、都能做规划。但它们的"注意力焦点"被物理隔离了。

当你问 Project Agent "这个功能怎么实现"时,它调取的是项目历史,给出的是符合代码风格的方案——而不会突然幻觉出你的购物清单。

当你问 Life Agent “周末带女儿去哪玩"时,它调取的是家庭偏好,推荐的是她喜欢的地方——而不会用 Clean Architecture 的术语来分析游乐场的"关注点分离”。

隔离记忆,就是隔离噪声。

四、 从"分工"到"分心"

人类团队的协作模式,建立在一个假设之上:每个人的脑容量有限,且不可并发。

所以我们需要开会同步信息,需要文档传递上下文,需要"接口人"在部门之间翻译。组织架构的本质,是在有限带宽下的信息路由方案。

但 AI 不一样。AI 可以并发,可以克隆,可以瞬间切换。

那为什么我们还需要"多个"Agent,而不是一个"超级大脑"装下所有信息?

原因和人类一样:注意力是稀缺资源。

哪怕上下文窗口再大,当信息量超过某个阈值,模型的推理质量就会下降。不是因为"找不到",而是因为"用不好"。就像你在一个嘈杂的酒吧里,哪怕听力完好,也很难专注于一场深度对话。·

多 Agent 的本质,不是"分工"(Division of Labor),而是**“分心”(Division of Attention)**:

- 把庞大的世界信息切分成高内聚的"上下文块"

- 每个 Agent 守护一个块,保证在这个块内的注意力密度最高

- 需要跨块协作时,通过消息传递(而非共享记忆)来交换信息

这就像人脑的"专注模式":当你深度写代码时,你的意识里没有晚饭吃什么的信息——不是忘了,而是被暂时"屏蔽"了。多 Agent 架构,就是在帮 AI 也做到这件事。

五、 聊天:最自然的协作界面

如果每个 Agent 都是一个"上下文孤岛",它们之间怎么协作?

答案是:通过消息传递,而非共享记忆。

通俗的说就是聊天,你可以跟每个Agent有个聊天窗口,也可以关于一个任务把几个Agent拉到一个群里。它们不共享上下文,但可以通过你——人类——来传递必要的信息。

你可能会问:那如果我需要一个 Agent 访问另一个 Agent 的记忆呢?

答案是:你需要显式地"搬运"。

这看起来像是一种"退化"——为什么不直接打通所有记忆?但这恰恰是设计的核心:强制显式的信息传递,就是在强制你思考"什么信息是真正必要的"。

就像微服务用 API 而非共享数据库来通信一样。网络带宽的限制,逼迫你定义清楚"什么可以传递,什么不应该传递"。

IM 变成了不同上下文块之间交换信息的总线。

六、 结语:你的"数字分身"团队

未来的个人 AI 助手,不会是一个无所不能的"全知全能者"。

它会是一个团队——由多个"只记得某一面生活的你自己"组成。

- 那个极致专注代码的自己

- 那个体贴入微的父亲自己

- 那个天马行空的研究者自己

它们共享能力,但各守一片记忆。它们不需要"开会"同步信息,因为需要跨域的信息自然会通过你的对话流动到该去的地方。

我们不需要组建一个由"陌生人"组成的团队——那些叫 Planner、Reviewer、Writer 的"工位标签"。

我们需要的,是不同状态下的自己。

让记忆决定角色,让消息连接分身。

学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献597条内容

已为社区贡献597条内容

所有评论(0)