从“一句话描述”到“专业级画作”:文生图、图生图、局部重绘、智能扩图一站式搞定

AUTOMATIC1111/stable-diffusion-webui 技术摘要 该项目是基于Gradio框架构建的Stable Diffusion模型Web图形界面,大幅降低了使用AI生成模型的技术门槛。核心价值在于提供本地化、一体化、可扩展的操作环境,解决了传统方案配置复杂、操作门槛高、功能分散等问题。 技术架构分为四层:Web界面层(Gradio)、应用逻辑层(脚本回调/队列控制)、核心服

AUTOMATIC1111/stable-diffusion-webui 深度技术解读

1. 整体介绍

1.1 项目概况

AUTOMATIC1111/stable-diffusion-webui 是基于 Gradio 框架构建的 Stable Diffusion 模型 Web 图形界面,是目前 GitHub 上最受欢迎的 Stable Diffusion 前端实现之一(截至当前,GitHub stars 超过 100k,forks 超过 20k)。项目通过将复杂的命令行操作封装为直观的 Web 界面,大幅降低了使用先进生成式 AI 模型的技术门槛。

1.2 核心功能定位

- 核心价值:提供本地化、一体化、可扩展的 Stable Diffusion 操作环境

- 技术定位:介于原始 Stable Diffusion 代码库与云端服务之间的中间层

- 用户界面:基于 Gradio 构建的响应式 Web 界面,支持实时交互

1.3 解决的核心问题

传统方案痛点:

- 配置复杂:原始 Stable Diffusion 需要手动安装 PyTorch、配置 CUDA、管理依赖版本

- 操作门槛高:依赖命令行参数和 Python 脚本,非技术用户难以使用

- 功能分散:图像生成、模型管理、后处理等工具分散在不同项目中

- 扩展困难:社区贡献难以集成,用户需要手动合并代码

本项目解决方案:

- 一体化安装:通过

launch.py自动处理环境依赖和模型下载 - 可视化操作:将命令行参数转化为 Web 表单控件

- 模块化架构:通过插件系统支持功能扩展

- 标准化接口:提供统一的 API 和配置管理

1.4 商业价值分析

开发成本估算:

- 核心框架开发:约 6-8 人月

- Gradio 深度集成:约 2-3 人月

- 扩展系统设计:约 3-4 人月

- 测试与优化:约 2-3 人月

- 总计估算:约 13-18 人月的高级开发投入

效益分析逻辑:

- 用户时间节省:相比手动配置,每个用户平均节省 4-8 小时初始化时间

- 技术门槛降低:使非专业开发者能够使用先进 AI 模型

- 社区生态价值:通过扩展系统形成正反馈循环,吸引开发者贡献

- 模型普及推动:加速 Stable Diffusion 生态发展,间接促进硬件和云服务需求

2. 详细功能拆解

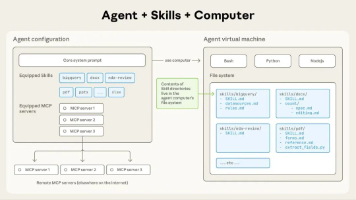

2.1 技术架构分层

┌─────────────────────────────────────┐

│ Web 界面层 │

│ (Gradio Blocks + 自定义组件) │

├─────────────────────────────────────┤

│ 应用逻辑层 │

│ (脚本回调 + 状态管理 + 队列控制) │

├─────────────────────────────────────┤

│ 核心服务层 │

│ (模型加载 + 图像处理 + 扩展管理) │

├─────────────────────────────────────┤

│ 基础设施层 │

│ (环境管理 + 依赖安装 + 配置持久化) │

└─────────────────────────────────────┘

2.2 核心功能模块

1. 启动与环境管理 (launch_utils.py)

- 自动检测 Python 版本和 CUDA 环境

- 智能安装 PyTorch 和依赖包

- Git 子模块管理和版本控制

- 扩展插件自动安装

2. Web 服务器与路由 (webui.py)

- Gradio 应用生命周期管理

- API 服务器模式支持

- 中间件配置(CORS、GZip)

- 会话状态持久化

3. 全局状态管理 (shared.py)

- 单例模式管理模型实例

- 配置选项的集中存储

- 线程安全的进度状态跟踪

- 主题和界面偏好管理

4. 模块初始化系统 (initialize.py)

- 延迟加载优化启动时间

- 动态模块导入和错误处理

- 配置恢复和状态回滚

- 钩子系统用于扩展点

3. 技术难点与解决方案

3.1 环境依赖复杂性管理

难点:Stable Diffusion 依赖特定版本的 PyTorch、xformers、CUDA 工具链,版本冲突常见。

解决方案:

# launch_utils.py 中的版本适配逻辑

def prepare_environment():

# 根据平台和硬件自动选择 torch 安装命令

if args.use_ipex:

if platform.system() == "Windows":

# Windows + Intel Arc GPU 的特殊处理

torch_command = "pip install 定制化IPEX包..."

else:

# Linux 的官方 IPEX 包

torch_command = "pip install torch==2.0.0a0 intel-extension-for-pytorch..."

else:

# 标准 NVIDIA CUDA 安装

torch_index_url = "https://download.pytorch.org/whl/cu121"

torch_command = f"pip install torch==2.1.2 torchvision==0.16.2 --extra-index-url {torch_index_url}"

# 执行安装并验证

run(torch_command, "Installing torch and torchvision", "Couldn't install torch", live=True)

3.2 模型热加载与内存管理

难点:大模型(通常 2-7GB)加载耗时,多个模型切换时内存容易溢出。

解决方案:

# shared.py 中的模型状态管理

class SharedState:

def __init__(self):

self.sd_model = None # 当前加载的模型

self.models_cache = {} # 模型缓存(可选)

self.current_model_hash = None

def load_model(self, checkpoint_path):

# 卸载当前模型释放显存

if self.sd_model is not None:

self.unload_model()

# 加载新模型

model = load_model_from_checkpoint(checkpoint_path)

# 应用优化(xformers、注意力优化等)

if args.xformers:

apply_xformers_optimizations(model)

self.sd_model = model

self.current_model_hash = calculate_hash(checkpoint_path)

3.3 扩展系统设计与安全性

难点:支持第三方扩展的同时保证系统稳定性和安全性。

解决方案:

# launch_utils.py 中的扩展安装器

def run_extension_installer(extension_dir):

path_installer = os.path.join(extension_dir, "install.py")

if not os.path.isfile(path_installer):

return

try:

# 隔离环境运行安装脚本

env = os.environ.copy()

env['PYTHONPATH'] = f"{script_path}{os.pathsep}{env.get('PYTHONPATH', '')}"

# 执行安装并捕获输出

stdout = run(f'"{python}" "{path_installer}"',

errdesc=f"Error running install.py for extension {extension_dir}",

custom_env=env).strip()

if stdout:

print(stdout) # 日志记录安装过程

except Exception as e:

# 优雅的错误处理,不破坏主程序

errors.report(str(e))

3.4 实时进度反馈与队列管理

难点:长时间图像生成任务需要实时进度更新,同时支持并发请求。

解决方案:

# webui.py 中的队列和进度管理

def webui():

from modules.call_queue import queue_lock

# 创建 Gradio 界面

shared.demo = ui.create_ui()

# 配置任务队列

if not cmd_opts.no_gradio_queue:

shared.demo.queue(64) # 允许最多64个并发请求

# 进度API设置

progress.setup_progress_api(app)

# 实时状态更新循环

while True:

server_command = shared.state.wait_for_server_command(timeout=5)

if server_command == "stop":

break

elif server_command == "restart":

# 优雅重启逻辑

handle_restart()

4. 详细设计图

4.1 系统架构图

4.2 启动序列图

4.3 核心类图

5. 核心函数解析

5.1 环境准备函数 (prepare_environment)

def prepare_environment():

"""核心环境初始化函数,处理所有前置依赖"""

# 1. 配置 Torch 安装源和版本

torch_index_url = os.environ.get('TORCH_INDEX_URL', "https://download.pytorch.org/whl/cu121")

torch_command = os.environ.get('TORCH_COMMAND',

f"pip install torch==2.1.2 torchvision==0.16.2 --extra-index-url {torch_index_url}")

# 2. 硬件特定优化(Intel IPEX)

if args.use_ipex:

if platform.system() == "Windows":

# Windows + Intel Arc 的特殊构建

url_prefix = "https://github.com/Nuullll/intel-extension-for-pytorch/releases/download/..."

torch_command = f"pip install {url_prefix}/torch-2.0.0a0...whl"

# 3. 基础依赖检查与安装

if not args.skip_torch_cuda_test and not check_run_python("import torch; assert torch.cuda.is_available()"):

raise RuntimeError('Torch is not able to use GPU')

# 4. 克隆必要的模型仓库

git_clone(assets_repo, repo_dir('stable-diffusion-webui-assets'), "assets", assets_commit_hash)

git_clone(stable_diffusion_repo, repo_dir('stable-diffusion-stability-ai'),

"Stable Diffusion", stable_diffusion_commit_hash)

# 5. 安装 Python 依赖包

requirements_file = os.environ.get('REQS_FILE', "requirements_versions.txt")

if not requirements_met(requirements_file):

run_pip(f"install -r \"{requirements_file}\"", "requirements")

# 6. 扩展插件安装

if not args.skip_install:

run_extensions_installers(settings_file=args.ui_settings_file)

5.2 模块初始化函数 (initialize)

def initialize():

"""核心模块初始化,实现按需加载"""

from modules import initialize_util

# 1. 系统级修复和配置

initialize_util.fix_torch_version() # 修复 torch 版本字符串

initialize_util.fix_asyncio_event_loop_policy() # 修复异步事件循环

initialize_util.configure_sigint_handler() # 配置信号处理

# 2. 模型系统初始化

from modules import sd_models

sd_models.setup_model() # 设置模型加载路径和缓存

# 3. 后处理模型加载(按需)

from modules import codeformer_model, gfpgan_model

codeformer_model.setup_model(cmd_opts.codeformer_models_path)

gfpgan_model.setup_model(cmd_opts.gfpgan_models_path)

# 4. 扩展系统初始化

initialize_rest(reload_script_modules=False)

def initialize_rest(*, reload_script_modules=False):

"""辅助初始化函数,支持重载"""

from modules import scripts, extensions, sd_models

# 1. 加载采样器配置

from modules import sd_samplers

sd_samplers.set_samplers()

# 2. 扩展脚本动态加载

with startup_timer.subcategory("load scripts"):

scripts.load_scripts() # 从 extensions_dir 加载用户脚本

# 3. 模型列表刷新

if not shared.cmd_opts.ui_debug_mode:

sd_models.list_models() # 扫描 models 目录

# 4. 后台线程加载主模型(优化启动体验)

if not shared.cmd_opts.skip_load_model_at_start:

Thread(target=load_model).start() # 异步加载避免界面卡顿

5.3 Gradio 应用启动函数 (webui)

def webui():

"""主 Web UI 启动函数,管理完整的应用生命周期"""

from modules.shared_cmd_options import cmd_opts

launch_api = cmd_opts.api

# 1. 系统初始化

initialize.initialize()

# 2. 创建 Gradio 界面组件

from modules import shared, ui, script_callbacks

shared.demo = ui.create_ui() # 构建所有UI标签页和控件

# 3. 配置任务队列(支持并发)

if not cmd_opts.no_gradio_queue:

shared.demo.queue(64) # 设置队列大小

# 4. 启动 Gradio 服务器

app, local_url, share_url = shared.demo.launch(

share=cmd_opts.share, # 是否生成公网链接

server_name=initialize_util.gradio_server_name(), # 绑定地址

server_port=cmd_opts.port, # 端口号

auth=gradio_auth_creds, # 身份验证

inbrowser=auto_launch_browser, # 自动打开浏览器

prevent_thread_lock=True, # 不阻塞主线程

root_path=f"/{cmd_opts.subpath}" if cmd_opts.subpath else ""

)

# 5. 安全加固:移除过于宽松的 CORS 设置

app.user_middleware = [x for x in app.user_middleware

if x.cls.__name__ != 'CORSMiddleware']

initialize_util.setup_middleware(app) # 应用自定义中间件

# 6. 注册 API 端点

if launch_api:

create_api(app) # 创建 RESTful API

# 7. 扩展回调系统

script_callbacks.app_started_callback(shared.demo, app)

# 8. 主事件循环(支持重启)

try:

while True:

server_command = shared.state.wait_for_server_command(timeout=5)

if server_command == "stop":

break

elif server_command == "restart":

handle_restart() # 优雅重启逻辑

except KeyboardInterrupt:

print('Caught KeyboardInterrupt, stopping...')

# 9. 清理资源

shared.demo.close()

6. 同类技术对比

6.1 与 ComfyUI 对比

| 特性 | AUTOMATIC1111 WebUI | ComfyUI |

|---|---|---|

| 学习曲线 | 较低,传统表单界面 | 较高,节点式工作流 |

| 扩展性 | 插件系统,Python脚本 | 节点系统,可视化编程 |

| 性能 | 优化良好,支持低显存 | 需要更多显存,但流程更灵活 |

| 社区生态 | 极活跃,扩展丰富 | 增长迅速,工作流分享多 |

| 适用场景 | 常规图像生成、快速迭代 | 复杂流程、批量处理、研究 |

6.2 与 DiffusionBee (macOS) 对比

| 维度 | WebUI | DiffusionBee |

|---|---|---|

| 安装复杂度 | 中等,需要Python环境 | 简单,直接安装 |

| 功能完整性 | 完整,支持所有高级功能 | 基础,核心生成功能 |

| 可定制性 | 极高,完全开源可修改 | 有限,闭源软件 |

| 跨平台 | Windows/Linux/macOS | macOS 专属 |

| 更新频率 | 每日更新,快速迭代 | 较慢,稳定发布 |

7. 技术演进建议

7.1 架构优化方向

- 模块解耦:进一步分离界面逻辑与生成逻辑

- 微服务化:考虑将模型服务、UI服务、扩展服务分离部署

- 配置即代码:支持声明式配置,便于版本控制和团队协作

7.2 性能提升建议

- 模型预热:后台预加载常用模型减少等待时间

- 结果缓存:实现生成结果的智能缓存和复用

- 渐进式加载:超大界面按需加载组件,提升初次打开速度

7.3 安全增强

- 扩展沙箱:对第三方脚本运行环境隔离

- 输入验证:加强提示词和参数的安全检查

- 访问控制:更细粒度的权限管理系统

总结

AUTOMATIC1111/stable-diffusion-webui 通过精心设计的模块化架构和稳健的工程实现,成功地将复杂的 Stable Diffusion 模型封装为易用的 Web 应用。其核心价值不仅在于功能丰富性,更在于:

- 工程完备性:从环境管理到错误处理都体现了生产级软件的考量

- 扩展友好性:设计良好的回调系统和配置管理支持生态发展

- 渐进式复杂度:界面设计既满足初学者也能服务高级用户

- 社区驱动:开源协作模式确保了快速迭代和问题修复

项目在技术实现上平衡了易用性与灵活性,通过合理的抽象层设计,使得底层模型升级和界面功能扩展能够相对独立地进行,这是其能够长期保持活跃和领先的关键架构优势。

更多推荐

已为社区贡献23条内容

已为社区贡献23条内容

所有评论(0)