生产环境中MCP与传统API调用的比较:优势、风险及正确使用方式

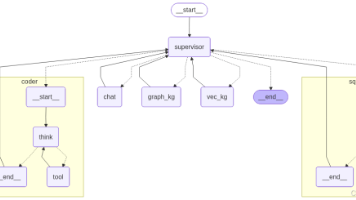

从本质上看,MCP 是 AI 智能体与外部世界之间的“通用适配器”,可以理解为 AI 的 USB-C 接口。也正因为如此,一些团队开始尝试把 MCP 从“原型工具”推进到“生产替代方案”,甚至想用它全面替代传统 API 调用:既然 AI 能通过 MCP 调工具,那还要写确定性代码做 API 编排干什么?在实现层面,MCP Server 通常会把现有 API 或业务动作封装成“模型友好”的形式(包括

MCP 是什么?它解决了什么问题?

模型上下文协议(Model Context Protocol,MCP)是一个相对较新的开放标准(由 Anthropic 于 2024 年底提出),用于让大语言模型(LLM)通过统一接口与外部工具、服务和数据交互。

从本质上看,MCP 是 AI 智能体与外部世界之间的“通用适配器”,可以理解为 AI 的 USB-C 接口。开发者不再需要为每个外部 API、数据库写一套硬编码集成或依赖厂商插件,而是把这些能力通过 MCP Server 暴露出来,让 AI 智能体(MCP Client)在运行时发现并调用。

在实现层面,MCP Server 通常会把现有 API 或业务动作封装成“模型友好”的形式(包括 schema、描述等),但真正执行工作仍然是由传统 API 调用或 Server 内部代码完成。

MCP 解决的核心问题是:AI 模型连接外部系统的摩擦成本太高。过去如果你希望聊天机器人或 AI 助手能够“发送邮件”或“查询 CRM”,通常需要为每个工具写定制代码,并长期维护。每增加一个工具,就多一套集成与维护负担。

MCP 通过标准化接口解决这个问题:任何符合 MCP 的客户端都可以连接任何 MCP Server,让集成变得可替换、可复用。你可以把它理解为 AI 能力的“即插即用”——用一个统一标准连接,替代过去几十种定制连接器。

这套标准化也会促进生态繁荣:例如某团队实现了一个数据库 MCP Server,那么任何支持 MCP 的 AI 智能体都可以在无需定制代码的情况下查询该数据库。理论上,只要提供对应 MCP Server,一个智能体就能获得成千上万种工具能力(从 Web 搜索到 SQL 执行,再到云 API 调用)。

最终目标是让 AI 拥有“可控的行动力”:能在安全、统一的框架下,代表用户执行动作并获取信息,而不是把所有逻辑都提前写死在智能体里。

MCP 的核心能力概览

总结来说,MCP 主要提供以下能力:

-

标准化协议

LLM 与工具 API 之间通过统一的 JSON 格式请求/响应通信(常见传输方式为 HTTP 或 STDIO),通常遵循 JSON-RPC 2.0 风格。协议包含能力发现握手:AI 可以先问“你能做什么?”,得到可用工具列表,然后用一致的调用格式执行这些工具。 -

AI 与工具解耦

AI 不需要了解服务实现细节,只需要知道 MCP 接口。只要 MCP 合约保持不变,你可以升级或替换后端 API,而无需重训模型或重写智能体逻辑。 -

动态工具使用

AI 在运行时决定是否、何时调用工具。比如用户问“上季度销售额是多少?”,AI 可以选择调用analytics.query工具获取数据再回答;如果用户问的是不需要外部数据的问题,AI 可能完全不调用工具。与传统 API 编排“提前写死调用顺序”不同,这种按需决策是 MCP 的关键差异之一。

通过解决这些问题,MCP 打开了更强“智能体化 AI 系统”的可能性——模型不仅能推理,还能行动。它让复杂工作流的原型开发变得非常快:你只要为内部 API 搭建 MCP Server,就能快速让一个类似 ChatGPT 的智能体使用这些能力,而无需为每个新动作写一堆胶水代码。

也正因为如此,一些团队开始尝试把 MCP 从“原型工具”推进到“生产替代方案”,甚至想用它全面替代传统 API 调用:既然 AI 能通过 MCP 调工具,那还要写确定性代码做 API 编排干什么?这听起来很诱人——但下一部分会解释为什么这种做法在生产环境往往会翻车。

诱惑:在生产环境用 MCP 替代 API 调用

团队很容易把 MCP 当成标准 API 调用的替代品:它抽象层级更高,集成方式更自然——只要告诉 AI 有哪些工具,AI 就能在对话上下文中自行调用。

这会让人产生一种“AI 自动处理所有调用逻辑”的错觉。对开发者而言,这个前景很吸引人:把服务暴露为 MCP 工具,然后让 AI 自己搞定调用流程,模型充当编排器。驱动这种冲动的常见理由包括:

-

减少硬编码逻辑

不再为每一步写明确的 API 调用逻辑,只提供工具箱,让 AI 自己决定调用什么、何时调用。对于快速变化的项目,这看起来更灵活。 -

更快集成新服务

如果内部有大量 API,把它们包装成 MCP Server 后,一个 AI 助手理论上就能统一访问,不用再写 SDK、客户端、集成中间件。 -

自然语言驱动的工作流

用户一句话(例如“库存低于阈值就补货”),AI 就能自动拆解成多次 API 调用(查库存 → 下订单)。相比让用户或前端代码直接调用多个 API,这种体验更“顺滑”。 -

减少用户的上下文切换

用户不需要在多个系统之间跳转,也不需要前端聚合多个服务结果,AI 可以在一次对话里完成端到端流程。

但把 MCP 工具调用当成普通 API 调用,本质上是一种误解。MCP 的目的从来不是替代 RPC/REST 的确定性调用,更不是保证“给定输入必然得到可重复的输出”。事实上 MCP 底层经常仍然依赖 API/RPC,只是加了一层让非确定性智能体能够更安全地使用这些能力。

正如 Docker 团队的观点所说:

“MCP 不是 API,它不会替代 RPC。它经常在底层使用 API,但目的是让这些能力能被非确定性智能体安全使用。”

这种误解也很容易理解:大多数 MCP 演示都呈现为“智能体调用工具 → 得到结果”,表面上看起来就像一个普通函数调用。习惯 API 集成思维的工程师很自然会用熟悉的模型来理解 MCP,于是把它当成可替代传统编排代码的机制。

现实例子

想象一个电商公司处理退货的固定流程是:

(1)调用订单 API 获取订单信息

(2)调用支付 API 退款

(3)调用邮件 API 通知用户

传统做法是业务逻辑按固定顺序编排这些调用。如果他们用 MCP 替代 API 编排,会做三件事:

-

为订单、支付、邮件分别搭 MCP Server

-

指令 LLM 智能体接管“退货”端到端流程

-

智能体实时决定调用顺序并执行

理论上可行,也很诱人:同一个 AI 还能动态处理更多流程,不用开发者逐条写流程代码。

但这种方法在生产中往往带来更多麻烦:可靠性下降、成本上升、排障困难。下面我们具体拆解原因。

为什么“用 MCP 替代 API”在生产中经常失败?

用 AI + MCP 替代直接 API 调用,会引入一系列在 demo 里不明显、但在生产里致命的问题。主要原因包括:非确定性、新的故障模式、错误恢复困难、延迟与成本上升、运维复杂度增加等。

下面逐条展开。

一、非确定性行为(不可预测性)

传统 API 调用是确定性的:在相同请求与系统状态下,响应可预测、可复现。

但通过 MCP 驱动的 LLM 行为天然是非确定性的:它基于概率推理,会受到措辞、上下文长度、历史信息甚至运行时细节影响。

这意味着:同一个用户请求,有时 AI 会调用工具,有时可能跳过;有时调用正确工具,有时会换另一个工具;即使输入几乎一样,也可能产生不同的工具调用序列或参数格式。

Jeremiah Lowin 将这种风险称为“随机性(stochasticity)”带来的问题:

“能成功一次不代表下一次还会成功。你无法把可靠系统建立在‘也许’之上。”

对生产关键流程而言,这种不稳定非常致命:

-

测试难以覆盖(你很难写出“输入 X 必然调用工具 Y”的断言)

-

行为可能漂移(随着上下文变化、版本变化,智能体流程悄悄偏离预期)

-

下游系统难以依赖(参数格式变化就可能触发异常)

你当然可以用 system prompt、temperature=0、few-shot 等手段降低随机性,但“从概率系统得到确定性保证”本身就非常困难。对于金融交易、合规操作等必须严格一致的场景,这几乎不可接受。

因此很多专家强调:MCP 应该增强确定性逻辑,而不是替代它。更好的实践是保留“确定性的最后一公里”:AI 可以规划,但关键执行必须校验与约束,确保确定性落地。

二、故障点级联(链路变长,风险倍增)

用 AI + MCP 替代一个简单 API 调用,相当于把“一个请求”变成“多步分布式链路”。故障点会显著增多,例如:

-

AI 没判断出应该调用工具

-

AI 调错工具或参数错误

-

MCP Server 自身故障或不可用

-

AI Client → MCP Server 的网络问题

-

MCP Server 包装的底层 API 失败

-

工具返回结果复杂,AI 误读或误用

-

后续行动/回复被错误结果带偏

链路的强度取决于最弱的一环,而现在弱点变多了。更糟糕的是,排障难度极高:

如果 AI 说“我已发送邮件”,但实际没发送,你很难快速定位问题在哪:

-

AI 根本没调用工具?

-

调用了但参数错被拒?

-

邮件服务失败但 AI 忽略?

-

工具报错信息不清晰导致 AI 误判?

如果没有完善的可观测性,你会处于“盲飞状态”。早期实践也发现,MCP 原生并不强调微服务级别的日志与监控,这会让定位问题变得极其困难。

此外,错误传播也更复杂:传统集成代码会明确写 retry、fallback、返回码处理;但 AI 的错误处理取决于模型是否“理解”错误并采取正确行动。它可能会重试,也可能误读错误当成成功结果,甚至直接放弃。

因此生产级 MCP 系统必须引入大量工程化能力:集中日志、链路追踪、健康检查、关联 ID 等,才能把可靠性拉回可接受水平。但这本身就是额外成本。

三、错误处理与恢复困难(隐式逻辑更脆弱)

在传统系统里,API 失败会进入明确的异常处理分支:重试、降级、提示用户、回滚等都由代码控制。

在 AI + MCP 模式下,错误恢复往往是隐式的、非结构化的、依赖提示词的。

常见问题包括:

-

工具返回复杂错误信息(多行、堆栈),AI 可能没正确识别为错误

-

AI 无法准确判断错误原因,重试也无效

-

智能体可能陷入循环(不断重复同一个失败调用),成本暴涨但无进展

-

半完成状态更常见(例如邮件已发出但后续写入失败,系统无法保证事务一致性)

因此很多团队不得不引入额外机制:

-

超时限制

-

循环检测(失败次数上限)

-

关键操作人工审批

-

更严格的错误结构(例如统一返回

{"error": ...})

但你会发现:这些机制本质上是在用另一种形式“重新实现传统代码里的 try/catch 和状态机”。这说明 MCP 替代 API 并没有消灭显式逻辑,只是把它变得更难维护。

四、延迟更高、Token/算力成本更贵

直接 API 调用通常是一次网络请求。

而 MCP 驱动的智能体调用至少包含:

一次 LLM 推理(决定是否调用工具 + 生成参数)

-

一次工具调用

-

可能还有一次 LLM 推理(整合结果并生成回复)

因此它几乎必然更慢、更贵,主要体现在:

-

延迟增加

多一步推理就多一段等待;多工具串行调用会累积延迟。原本 500ms 的 API 可能变成几秒甚至超时。

如果使用 SSE 等长连接,还会对网络基础设施提出更高要求。 -

冷启动与扩展问题

如果 MCP Server 运行在 serverless(例如 Lambda),冷启动可能达到数秒级,交互体验不可接受。生产中往往需要常驻服务,这意味着更多运维成本。 -

Token 成本增加

工具越多,描述越长,prompt 越大,每次推理成本越高、速度越慢。

如果你把 30 个工具一次性塞给模型,光工具说明就可能几千 token,每一轮都要付费。 -

隐藏的 API 调用次数增加

智能体可能为了“思考与验证”多次调用工具,而人写的 API 编排往往一次就能拿到结果。最终你没有减少 API 调用,反而可能放大调用量,导致 rate limit 与成本压力。 -

吞吐受限

高并发下,LLM 推理与工具调用一起爆发,系统扩展难度远高于传统 API 服务。

因此,专家普遍建议:不要用 MCP 做“本来一个 API 就能完成的确定性任务”。如果不需要 AI 的推理与灵活性,直接调用 API 永远更快、更便宜、更可靠。

当然,你可以通过缩小工具集、让工具做更多聚合计算、缓存结果等方式优化成本,但这些又回到了传统工程优化路径,并不“省事”。

五、运维与架构复杂度显著上升

当你在生产里运行 MCP 智能体,你实际上在运行一个新的分布式系统:

-

多个 MCP Server

-

可能还需要 MCP Gateway / 工具注册中心

-

LLM 服务本身

-

认证、权限、密钥、审计、监控等配套设施

相比之下,直接 API 集成通常只是你应用代码的一部分,不需要额外运行一堆新服务。

典型复杂度来源包括:

-

服务发现与编排问题

MCP 本身不提供全局工具目录或路由,你需要告诉 AI 哪个工具在哪个 URL。工具多了之后,配置会爆炸。

团队往往不得不引入 MCP Gateway 作为统一入口与工具注册中心。 -

安全与权限问题

生产环境必须解决多层安全:AI 是否能访问敏感数据?MCP 通道如何鉴权?底层 API 如何授权?

还要考虑“代表用户执行”的权限透传,避免 User A 的智能体访问 User B 数据。 -

监控与调试工具调用

你必须记录每次工具调用的输入输出、上下文、关联 ID,用于事后分析与合规审计。

这并不是 MCP 默认就提供的能力。 -

维护提示词与工具契约

MCP 的“接口”不仅是 schema,还有 prompt 指令。工具一旦变化(参数、行为、返回结构),你需要同步更新并确保智能体正确使用。

这变成一种新的软件资产维护工作。 -

升级与回归测试更难

你不仅要测 MCP Server 本身,还要测“智能体是否仍能正确调用”。这需要更多自动化测试与模拟机制。

总之,在生产中使用 MCP 并不是“接上就能跑”。你最终会把它当成一个严肃的分布式系统去运营,否则就会失控。很多团队低估了这一点,以为 AI 会自动处理更多问题,但现实往往相反:你需要更多工程化护栏来让它可靠。

MCP 什么时候值得用?如何正确使用?

看到这里,你可能会觉得 MCP 很麻烦。但问题并不在 MCP 本身,而在“把 MCP 当 API 替代品”这种用法。正确的问题是:MCP 在什么场景能提供不可替代的价值?

下面是 MCP 真正有意义的场景与正确使用方式。

一、复杂、非固定的 AI 驱动工作流

当问题空间足够复杂、路径无法提前写死时,MCP 的价值才会显现。

例如 IT 支持助手需要处理各种请求:

-

重置密码(调用 AD 工具)

-

申请虚拟机(调用云 API 工具)

-

解释错误(可能不需要工具,只查文档)

这种场景很难用确定性代码覆盖所有路径,AI 的灵活性是必要的。你不需要它每次走完全一致的流程,只要最终解决问题即可。此时非确定性是可接受的,甚至是优势。

二、多系统、多宿主的企业集成

企业往往拥有复杂系统网络:数据库、SaaS、内部微服务。用传统方式做统一 API 编排很难,脚本化跨系统流程也很脆弱。

MCP 的价值在于提供统一桥梁,让智能体用一致协议连接多个系统。比如“AI 助理”可以:

查日历 → 查 CRM → 发邮件

这些工具可能在不同服务器、不同云环境,但对 AI 来说都是同一种调用方式。

此外,MCP 作为开放标准,也可以让你复用第三方或社区提供的工具能力(例如天气、股票、搜索等)。它不是替代你已有能力,而是扩展你能做的事。

三、为复杂 API 提供自然语言入口

某些 API 本身复杂到不适合直接暴露给用户。MCP 可以让 LLM 成为自然语言前端:用户用中文提问,AI 翻译成结构化调用。

经典例子是数据分析:

用户问“按地区统计销售额”,AI 通过 MCP 调用分析工具生成参数化 SQL 并执行,结果由数据库保证确定性。

这种模式的关键是:

AI 负责理解意图

工具负责确定性执行

从而把非确定性限制在可控范围内。

四、快速原型与迭代探索

即使最终你会写稳定的 API 集成,MCP 在原型阶段依然极其高效:

你可以快速接入多个内部 API,观察 AI 实际会用哪些工具、怎么用,再决定哪些路径需要后续优化为直连 API。

很多成熟系统最终都会形成混合架构:

-

MCP 用于复杂、低频、动态决策任务

-

直连 API 用于高频、确定性、成本敏感路径

五、带监督的 AI 自动化(用治理把风险降下来)

当你希望 AI 自动执行任务,但又必须保证安全与合规时,MCP 可以成为一个结构化的治理入口。

例如 Peta 这类平台提供:

-

MCP Gateway(统一入口与路由)

-

Secrets Vault(服务端注入密钥,AI 不接触明文凭证)

-

Policy Enforcement(按工具/智能体/环境做权限控制)

-

Human Approval(高风险动作需要人工审批)

这种能力能把“智能体工具调用的野蛮生长”变成“可治理的生产系统”,尤其适合企业场景。

什么时候不该用 MCP?

下面是一些明确不适合用 MCP 的场景:

-

简单确定性任务

一个 API 5ms 能完成的事,不要让 AI 介入增加推理成本与风险。 -

必须严格一致、不能出错的核心操作

金融交易、合规校验、关键写操作应保持确定性。AI 可以辅助解释,但不应直接执行核心动作。 -

规模化性能与成本极度敏感的热路径

如果是百万级小请求,AI 介入的 token 与延迟成本可能让系统不可持续。 -

团队无法承担运维与治理成本

如果你没有监控、日志、权限体系、升级机制,部署 MCP 智能体会比传统系统更难控、更难修。

结论:正确的视角与推荐做法

MCP 是强大的能力层,但它不是用来替代所有 API 的“AI 魔法”。如果把 MCP 当成确定性 API 编排的替代品,很可能得到一个脆弱、昂贵、难排障的系统。

但在真正需要 AI 灵活性、多系统协作、自然语言入口的场景里,MCP 的价值非常大。关键是“用在对的地方”,并且用工程化护栏控制风险。

建议遵循以下平衡原则:

-

用 MCP 做 AI 擅长的事:理解模糊意图、跨系统协调、动态决策

-

关键执行保持确定性:敏感动作必须校验、约束或人工审批

-

用网关与平台补齐生产能力:安全、审计、权限、密钥注入、监控缺一不可

-

逐步优化与混合架构:高频路径可下沉为直连 API,复杂路径保留 MCP

-

持续监控与迭代:记录工具调用、延迟、失败率、循环行为,持续加护栏

最终,MCP 最好的定位是:传统 API 的补充层,而不是替代品。把确定性工程与 AI 的适应性结合起来,才能同时获得可靠性与智能化——这是单独依靠任何一方都很难达到的效果。

参考资料

ByteBridge(Medium)《What It Takes to Run MCP in Production》(2026-01-05)

Codecademy Team《MCP vs APIs: Architecture & Use Cases》

Docker Blog(Jim Clark)《You Are Doing MCP Wrong: 3 Big Misconceptions》(2025-09-03)

Jeremiah Lowin《Stop Vibe-Testing Your MCP Server》(2025-05-21)

Tinybird(Jorge Sancha)《MCP vs APIs: When to Use Which》(2025-06-09)

DomAIn Labs(NexaForge)《MCP Isn’t Dead, But Bloated Agentic Workflows Are》

ByteBridge(Medium)《MCP and MCP Gateway: Essential Building Blocks for Modern AI (with Peta)》

Meagan Palmer《Semantic Layers, MCP Servers, and the Fear of Non-Determinism》(2025-08-27)

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)