ollama v0.15.1更新:全面优化 GLM-4.7-Flash 性能、增强 Claude 与 OpenCode 集成、提升跨平台构建效率

Ollama v0.15.1 不只是一次修复版本,而是一场性能、生态与开发体验的综合升级。从模型底层优化到工具链集成,从跨平台编译加速到文档统一更新,这次迭代让 Ollama 离“本地通用 AI 工作平台”的愿景更近了一步。

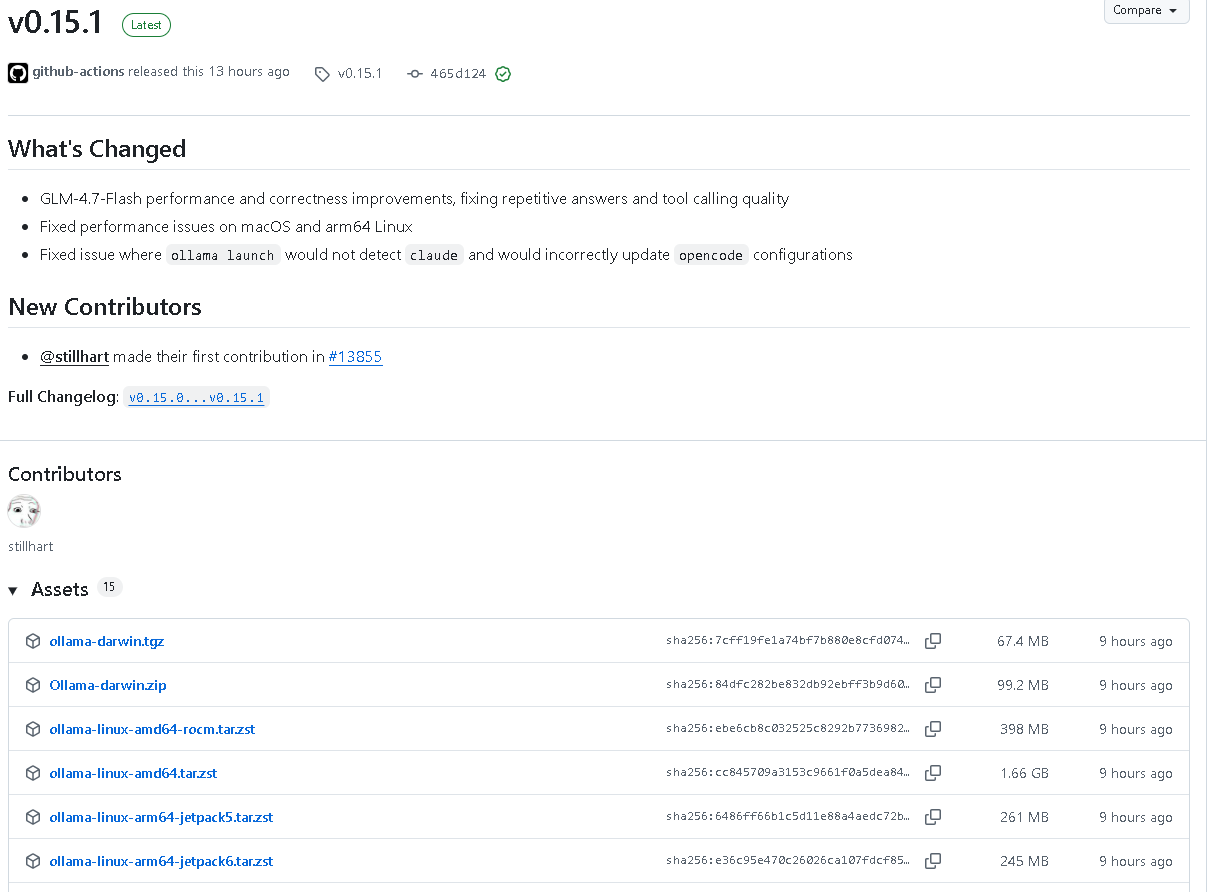

2026年1月25日,Ollama 发布了最新版本 v0.15.1。这一版本在性能优化、工具集成、跨平台兼容性和文档完善方面带来了显著提升,标志着该项目在本地大模型运行环境上的又一次重要进步。本文将带你全面了解此版本的全部更新点。

一、GLM-4.7-Flash 模型优化

本次更新对 GLM-4.7-Flash 模型进行了大幅性能优化与正确性修复,解决了部分重复回答与工具调用质量问题。同时,在量化策略上进行了改进:

- 量化更多张量为

q8_0格式。 - 避免了双重 BOS Token 的问题。

- 修复了注意力机制中

scale计算的错误,提升注意力计算精度和生成稳定性。

此外,server/quantization.go 中针对多头注意力(MLA)相关权重进行了精度提升,确保模型在高压缩量化下仍能保持高质量输出。

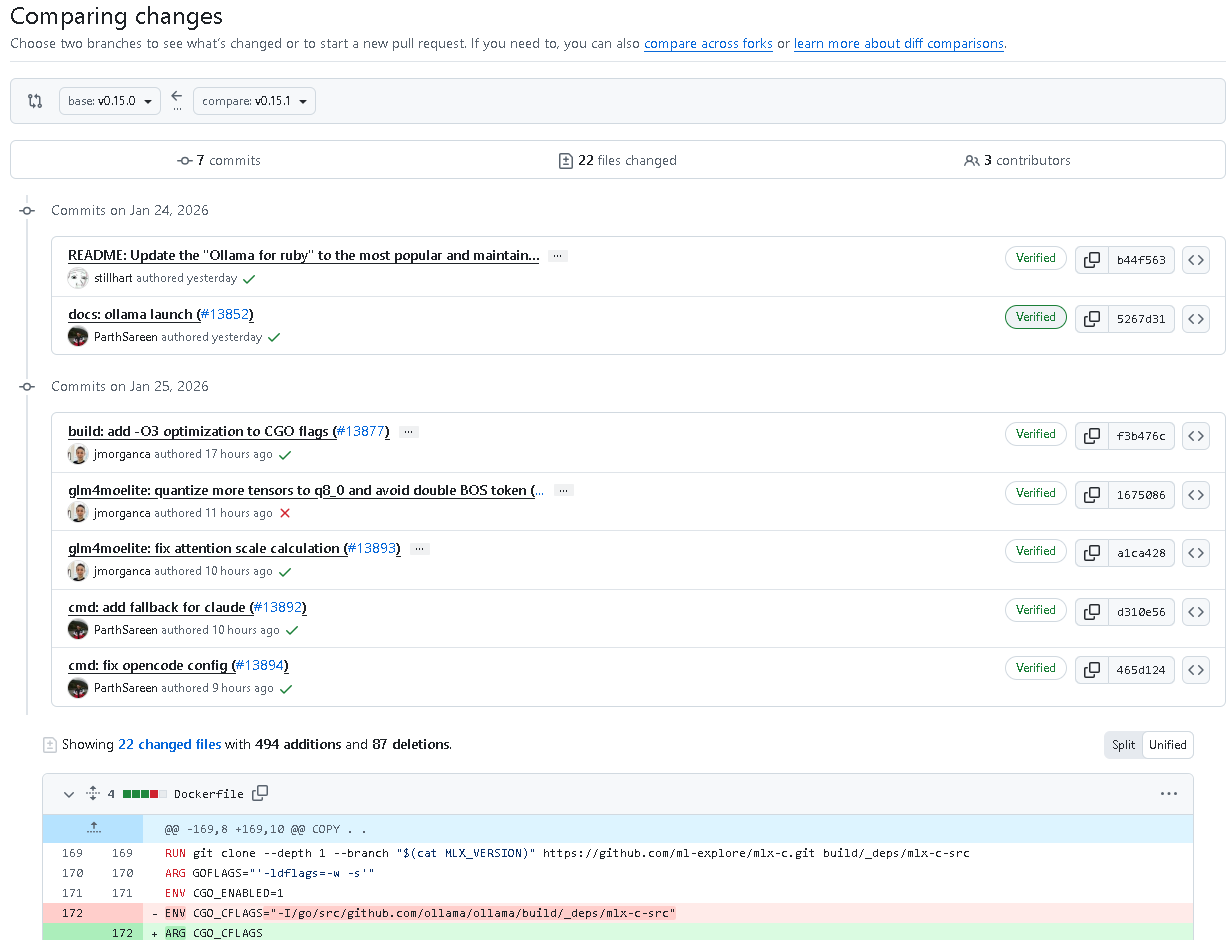

二、跨平台性能改进

Ollama v0.15.1 修复了 macOS 与 arm64 Linux 上的性能问题,并在各平台构建脚本中增加了高效优化编译参数:

- CGO 优化标志: 增加

-O3编译优化。 - macOS 构建脚本(scripts/build_darwin.sh):

启用-O3优化并保持-mmacosx-version-min限定版本。 - Windows 构建脚本(scripts/build_windows.ps1):

若没有手动设置,会自动为CGO_CFLAGS与CGO_CXXFLAGS添加-O3优化。

这些改动显著提升了编译后可执行文件的运行效率。

三、工具集成:Claude 与 OpenCode 全新增强

本次更新最大亮点之一,是对 Claude Code 与全新集成项目 OpenCode 的支持完善。

1. Claude Code 一键启动优化

- 新增

ollama launch claude命令的 智能路径检测机制:

可在系统 PATH 未找到claude时自动回退查找~/.claude/local/claude(Windows 系统为claude.exe)。 - 若仍无法找到,将提示用户从官方站点下载安装。

- 测试文件

claude_test.go覆盖了 PATH 检测、fallback 查找以及异常路径三种场景,确保健壮性。

2. OpenCode 集成正式登场

新版本引入了 OpenCode 这一开源终端 AI 编码助手,并提供完整的 Ollama 集成方案。

命令行支持:

ollama launch opencode

或仅配置不启动:

ollama launch opencode --config

配置文件(~/.config/opencode/opencode.json)示例中默认支持添加本地与云端模型:

- 本地模型示例:

qwen3-coder - 云端模型示例:

glm-4.7:cloud

对应逻辑实现涵盖:

- 避免重复条目;

- 保留用户自定义字段;

- 自动将旧

[Ollama]后缀条目迁移为_launch标记; - 精确区分由 Ollama 管理的模型条目。

四、命令行增强:新增 launch 命令全面指南

文档提供了详细 CLI 使用说明:

ollama launch

支持的集成:

- OpenCode – 开源代码助手

- Claude Code – Anthropic 编码智能体

- Codex – OpenAI 编码助手

- Droid – Factory AI 编码代理

可快速使用指定模型和配置项:

ollama launch claude --model qwen3-coder

ollama launch droid --config

五、文档体系大跃进

文档部分更新极为丰富,帮助开发者快速上手并接入主流开发工具,主要包括以下几个方面:

1. Anthropic API 兼容性更新

- 明确推荐模型:

glm-4.7,minimax-m2.1,qwen3-coder。 - 环境变量统一使用:

export ANTHROPIC_AUTH_TOKEN=ollama export ANTHROPIC_API_KEY=ollama export ANTHROPIC_BASE_URL=http://localhost:11434 - 新增对

ollama launch claude自动配置的说明。

2. 上下文长度提升

上下文窗口默认推荐调整至 64000 tokens,更适用于 web 搜索、AI agents 和大型代码模型。

设置示例:

OLLAMA_CONTEXT_LENGTH=64000 ollama serve

3. Quickstart 新增编程模型说明

- 推荐使用

glm-4.7-flash作为本地编程模型(23GB 显存需求)。 - 支持云模型

glm-4.7:cloud。 - 新增 “快速接入编程助手” 分节,引导使用

ollama launch快速集成多款工具。

六、README 与构建说明同步更新

README.md替换为更受欢迎的 Ruby 客户端链接。Dockerfile和app/README.md更新增加-O3优化参数。- 修复启动时 Claude 检测失败 及 OpenCode 配置误更新 问题。

七、小结

代码地址:github.com/ollama/ollama

Ollama v0.15.1 是一次全方位的优化版本,重点围绕以下核心展开:

- 性能与精度升级: GLM-4.7-Flash 模型深度优化。

- 跨平台支持增强: macOS 与 Linux arm64 性能修复,构建优化全面升级。

- 生态集成扩展: 新增 OpenCode 一键集成,完善 Claude 启动逻辑。

- 开发体验提升: CLI 命令增强与文档体系全面进化。

这次更新不仅让 Ollama 在模型执行效率上更进一步,也让其在 AI 编程助手生态中更具连接性与易用性。

总结

Ollama v0.15.1 不只是一次修复版本,而是一场性能、生态与开发体验的综合升级。从模型底层优化到工具链集成,从跨平台编译加速到文档统一更新,这次迭代让 Ollama 离“本地通用 AI 工作平台”的愿景更近了一步。

更多推荐

已为社区贡献41条内容

已为社区贡献41条内容

所有评论(0)