从零到一:五分钟快速部署轻量化 AI 知识库模型(GTE + SeqGPT)

本文介绍了在AI应用开发中部署RAG(检索增强生成)系统的实战步骤,重点围绕两个核心模型:GTE-Chinese-Large语义向量模型和SeqGPT-560m轻量化生成模型。文章详细说明了环境准备、依赖安装、使用aria2加速模型下载的方法,并提供了避开常见错误的解决方案。通过Python代码示例展示了如何实现语义搜索功能和文本生成任务,包括知识库检索和Prompt优化技巧。最后总结了部署过程中

0. 前言

在 AI 应用开发中,最经典的组合莫过于 RAG(检索增强生成)。本文将带你实战部署两个核心模型:

- GTE-Chinese-Large:目前语义向量(Embedding)领域的顶级模型,负责让 AI “理解”文档。

- SeqGPT-560m:超轻量化生成模型,负责“总结”和“对话”。

环境要求: PyTorch 2.x、Python 3.10+、建议有 GPU(CPU 也可跑)。

1. 环境准备:扫清依赖障碍

ModelScope 的 NLP 模型依赖较多,我们先一次性补齐所有可能缺失的底层库,避免“打地鼠”式的报错。

# 进入你的虚拟环境 (例如 torch29)

pip install modelscope -U

# 解决版本冲突的关键:datasets 必须限制在 3.0 以下,transformers 使用稳定版

pip install "datasets<3.0.0" "transformers>=4.40.0" -U

# 补齐 ModelScope 的隐藏依赖

pip install simplejson sortedcontainers oss2 addict pyyaml accelerate sentencepiece

2. 暴力加速:使用 aria2 快速获取权重

模型文件通常几百 MB 到几 GB,默认下载速度极慢。我们使用 aria2 开启 16 线程下载,将 30 分钟的等待缩短至 1 分钟。

2.1 安装 aria2

sudo apt-get update && sudo apt-get install aria2 -y

2.2 下载 GTE 向量模型 (约 620MB)

mkdir -p /root/.cache/modelscope/hub/models/iic/nlp_gte_sentence-embedding_chinese-large

cd /root/.cache/modelscope/hub/models/iic/nlp_gte_sentence-embedding_chinese-large

aria2c -s 16 -x 16 -k 1M -o pytorch_model.bin "https://www.modelscope.cn/api/v1/models/iic/nlp_gte_sentence-embedding_chinese-large/repo?Revision=master&FilePath=pytorch_model.bin"

2.3 下载 SeqGPT 生成模型 (约 1.04GB)

mkdir -p /root/.cache/modelscope/hub/models/iic/nlp_seqgpt-560m

cd /root/.cache/modelscope/hub/models/iic/nlp_seqgpt-560m

aria2c -s 16 -x 16 -k 1M -o pytorch_model.bin "https://www.modelscope.cn/api/v1/models/iic/nlp_seqgpt-560m/repo?Revision=master&FilePath=pytorch_model.bin"

注意: 下载完成后,记得回到你的工作目录

cd ~/workspace/your_project。

3. 模型部署:避开 is_decoder 报错

由于 ModelScope 内部代码与新版 Transformers 存在兼容性问题(常报 is_decoder 错误),我们推荐使用 Transformers 原生加载方式。

3.1 部署 GTE 语义搜索

完整代码

新建 search.py,这个脚本能实现“模糊语义搜索”,即问“显存不够”,它能找到“升级硬件”的资料。

import torch

import torch.nn.functional as F

from transformers import AutoTokenizer, AutoModel

model_path = "/root/.cache/modelscope/hub/models/iic/nlp_gte_sentence-embedding_chinese-large"

tokenizer = AutoTokenizer.from_pretrained(model_path)

model = AutoModel.from_pretrained(model_path)

def get_emb(text):

inputs = tokenizer(text, padding=True, truncation=True, return_tensors='pt', max_length=512)

with torch.no_grad():

out = model(**inputs)

return F.normalize(out.last_hidden_state[:, 0], p=2, dim=1)

# --- 模拟你的知识库 ---

knowledge_base = [

"1. 升级服务器显存到24GB可以运行更大的模型。",

"2. 北京明天的天气是晴转多云,建议穿薄外套。",

"3. 鱼香肉丝是一道经典川菜,主要食材是猪肉和木耳。",

"4. Python是一种广泛应用于人工智能领域的编程语言。",

"5. 使用aria2c工具可以大幅提升大文件的下载速度。"

]

# 计算库里所有资料的坐标(向量)

kb_embs = get_emb(knowledge_base)

def smart_search(user_query):

query_emb = get_emb([user_query])

# 计算相似度百分比

scores = (query_emb @ kb_embs.T) * 100

print(f"\n🔍 搜索问题: 【{user_query}】")

print("-" * 50)

# 将结果排序输出

results = sorted(zip(scores[0].tolist(), knowledge_base), reverse=True)

for score, text in results:

# 只显示相关度较高的

star = "⭐" * int(score/20) # 满分5颗星

print(f"[{score:.1f}%] {star} | {text}")

# --- 进行几次有趣的测试 ---

smart_search("我想学AI,用什么语言好?")

smart_search("显存不够大怎么办?")

smart_search("明天出门需要带雨伞吗?")

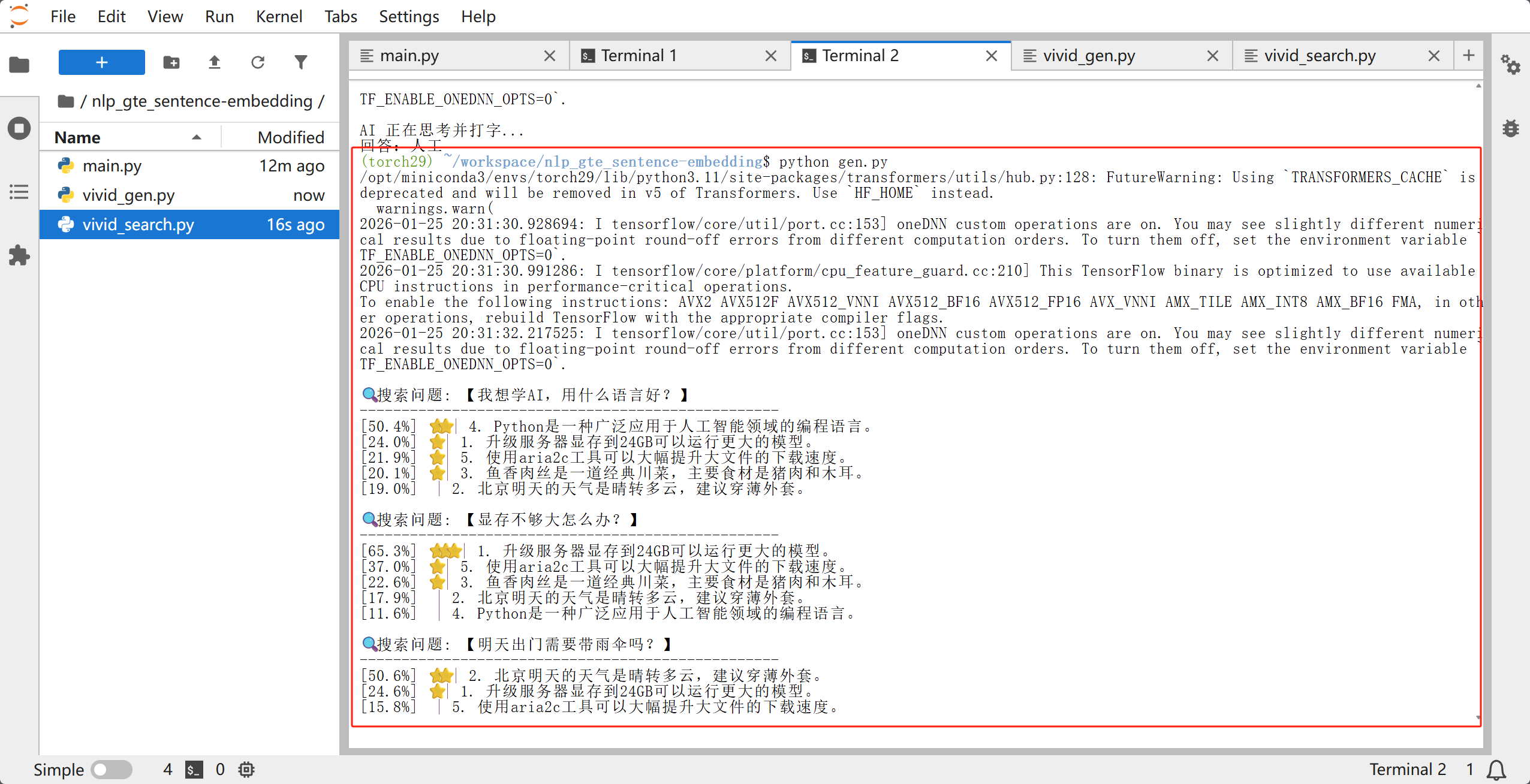

效果演示

3.2 部署 SeqGPT 文案助手

对于 560M 这样的小模型,Prompt(提示词)格式至关重要。

新建 gen.py:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_path = "/root/.cache/modelscope/hub/models/iic/nlp_seqgpt-560m"

tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True).to('cpu')

def ask_ai(task, content):

# 强制使用【任务-输入-输出】结构

prompt = f"任务:{task}\n输入:{content}\n输出:"

inputs = tokenizer(prompt, return_tensors="pt")

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=64,

do_sample=True,

temperature=0.8,

repetition_penalty=1.2

)

full_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

return full_text.split("输出:")[-1].strip()

print(f"AI 回复:{ask_ai('给这段话写一个标题', '今天我们成功在服务器上部署了两个AI模型')}")

4. 常见坑点总结

- ModuleNotFoundError:

- 缺少

simplejson或sortedcontainers?直接pip install。 - 报错

cannot import name 'ALL_ALLOWED_EXTENSIONS'?是因为datasets版本太新,执行pip install "datasets<3.0.0"即可解决。

- 缺少

- 下载到一半卡住:

- 这是服务器单线程限速。立刻切换到

aria2c多线程下载,或者设置环境变量export MODELSCOPE_PARALLEL_DOWNLOAD_COUNT=16。

- 这是服务器单线程限速。立刻切换到

- 输出结果为空或重复:

- 检查

max_new_tokens是否设置。 - 检查 Prompt 格式,SeqGPT 这类小模型非常依赖特定的触发词(如“输出:”)。

- 检查

5. 结语

恭喜!你已经成功部署了语义搜索和文本生成两个基础模型。有了这两个“乐高积木”,你可以开始构建自己的企业级私有知识库客服了。

本文记录于 2026年1月25日 部署实战,环境 PyTorch 2.9,ModelScope 1.20+。

更多推荐

已为社区贡献22条内容

已为社区贡献22条内容

所有评论(0)