突破AI Infra开发困境,文档驱动的Vibe Coding实践之道

阿里妈妈技术团队针对Vibe Coding在AI基础设施开发中的局限性,提出文档驱动的改进方法。研究发现,对话式交互在复杂系统开发中存在上下文丢失、决策偏离和质量不稳定三大痛点。团队通过结构化设计文档将关键决策体系化,使开发者专注于高层设计,由AI处理实现细节。该方法在Agentic RL资源调度场景验证有效,通过GPU池动态分配机制解决利用率问题,相比传统方案显著提升性能。文档驱动模式将开发重心

在AI技术飞速迭代的当下,大模型相关开发工具正不断革新开发者的工作模式。Andrej Karpathy大神力荐的Vibe Coding(氛围编程)便是其中的佼佼者,这种“只需聊一聊,AI就能写出功能代码”的轻量化交互方式,极大提升了简单开发任务的效率,迅速成为开发者圈的新宠。但当我们将目光从简单功能开发转向复杂的系统构建,尤其是AI Infra(AI基础设施)这类高复杂度、高工程约束的领域时,Vibe Coding却常常陷入“水土不服”的困境,原本的效率优势被一系列问题稀释,甚至成为开发过程中的阻碍。

阿里妈妈技术团队在实践中发现,Vibe Coding应用于AI Infra开发时,核心痛点集中在三个方面。首先是上下文丢失问题,在多轮交互过程中,对话历史会被系统压缩,前期讨论的关键设计决策、架构思路会逐渐被遗忘,导致后续AI生成的代码与初始需求和核心设计脱节,出现“前言不搭后语”的情况。其次是决策偏离困境,AI Infra系统开发需要在架构选择、接口设计、错误处理策略等多个维度做出大量技术决策,这些决策往往需要结合业务场景、系统兼容性、性能需求等多重因素综合考量,而AI在自主决策时很容易偏离开发者的核心意图,生成的代码难以符合实际工程要求。最后是质量不稳定挑战,即便开发者提供了完整的需求描述,AI生成代码的质量也会出现较大波动,同样的需求在不同时间、不同交互语境下,可能得到截然不同的实现方案,这对于需要长期维护、高稳定性的AI Infra系统来说,无疑是致命的隐患。

深入剖析这些问题背后的根源,我们会发现核心矛盾在于AI Infra系统的复杂性与Vibe Coding原生特性的不匹配。AI Infra作为支撑AI模型训练、推理的核心基础设施,往往涉及数万行代码,包含成百上千个相互关联的决策点,这些决策点环环相扣,牵一发而动全身。而当前的Vibe Coding依赖于对话式交互,缺乏持久化、结构化的决策管理机制,模糊且不稳定的“氛围”难以支撑严肃复杂的基础设施开发工作。但这并不意味着Vibe Coding在AI Infra领域就毫无用武之地,其高效交互、降低编码门槛的核心优势依然具有重要价值,关键在于如何找到一种适配机制,让Vibe Coding能够适配复杂系统开发的需求。

基于这一思考,阿里妈妈技术团队联合阿里巴巴未来生活实验室与智能引擎团队,实践了一种文本驱动的Vibe Coding方法,核心思路是通过设计文档将所有关键决策体系化、持久化,让复杂系统的开发变得有章可循。这种方法的核心逻辑的是,将复杂系统的关键决策前置到设计阶段,开发者不再需要陷入繁琐的编码、调试细节,而是专注于高层设计决策的梳理与确认,通过结构化的设计文档与AI达成共识,之后由AI负责代码实现的细节工作。这种模式不仅能够实现“几乎不写一行代码,就可以完成复杂功能”的高效开发,更能通过详细的设计规范和代码逻辑约束AI的生成过程,确保最终实现符合预期,同时提升系统的健壮性。

理论的有效性需要通过真实场景的验证来佐证,而AI Infra中的资源调度系统,尤其是面向Agentic RL(智能体强化学习)的资源调度场景,正是一个理想的试验场。该场景下的系统是一个包含数万行代码的分布式训练系统,核心挑战在于GPU利用率的优化,涉及大量核心调度逻辑的改动,兼具高复杂度、强工程约束和真实业务价值,能够充分检验文档驱动的Vibe Coding方法的实际效果。要理解这一场景的复杂性,我们首先需要明确Agentic RL中的GPU利用率挑战到底体现在哪里。

在Agentic RL的采样过程中,随着智能体需要处理的任务越来越复杂,系统需要支持越来越高的交互轮数,让智能体有足够的时间与环境交互以学习复杂任务的处理逻辑。但这一趋势却给GPU资源调度带来了显著挑战,核心问题出在智能体执行任务的时间分布特征上。实际采样过程中,智能体执行任务的时间呈现典型的长尾特征,绝大多数样本能够在较少的交互轮数内快速完成采样并得出结果,而只有少数复杂样本需要执行到最大轮数限制才能终止。这种极不均匀的执行分布,成为了GPU资源高效利用的核心瓶颈。

这一问题的本质,是分布式计算中经典的“落后者效应”(Straggler Effect)。在分布式训练流程中,无论有多少样本已经完成采样,系统都必须等待最慢的那个样本执行完毕,才能进入下一个阶段。这种等待过程不仅成为了整个训练流程的性能瓶颈,更造成了大量GPU资源的浪费——很多GPU在快速完成自身任务后,只能处于闲置状态等待长尾样本,宝贵的计算资源无法得到有效利用。为了解决这一问题,业界已经形成了两种主流的解决方案,但这两种方案都存在根本性的缺陷,无法从根本上突破GPU利用率的瓶颈。

第一种方案是共置方案,采用严格的串行执行策略,所有GPU首先统一投入rollout(采样)阶段,等待全部样本采样完成后,再统一切换至training(训练)模式。这种方案的效率问题十分突出,主要体现在两个方面。一方面是阶段内的资源闲置,在rollout阶段,由于落后者效应的存在,大量GPU在完成短样本的采样任务后,就进入了漫长的闲置等待状态,无法参与后续工作,资源利用率大打折扣。另一方面是阶段间的严格串行限制,rollout和training两个核心阶段完全无法并行执行,training阶段必须等待rollout阶段完全结束才能开始,这就导致整个训练迭代的时间被显著拉长,无法实现高效迭代。

第二种方案是异步分离方案,通过静态分配专用的rollout GPU和training GPU,实现流水线并行。从理论上来说,这种方案能够缩短单轮迭代的时间,但在实际应用中却引入了严重的“双边空泡”问题。在rollout侧,短样本快速完成采样后,rollout GPU会进入闲置状态,等待长尾样本执行完毕才能开始下一轮工作;在training侧,训练任务完成后,需要等待新一轮的rollout数据生成,training GPU同样会处于闲置状态。这种双向的资源闲置,使得理论上的并行优势在实际运行中大打折扣,GPU利用率依然无法得到有效提升。

针对这两种方案的缺陷,我们提出了时分复用方案,通过GPU池动态分配机制,从根本上解决GPU资源闲置的问题。这一方案的核心创新,基于一个关键洞察:在异步训练过程中,rollout对GPU资源的需求呈现明显的动态波动特征。具体来说,在training触发前,大量样本已经进入完成阶段,系统处于样本数目的低谷期,此时对GPU资源的需求自然下降;相反,在训练结束后,新一轮的大量样本会涌入系统,对GPU资源的需求会急剧激增,形成明显的高峰期。基于这一波动规律,我们设计了智能资源调度机制,在采样需求低谷期,将部分GPU资源分配给训练任务,从而实现需求波动与资源调度的有效匹配,让GPU资源在不同阶段都能得到充分利用。

为了实现这一设计理念,系统采用了两阶段执行流程。第一阶段是全力采样阶段,所有GPU协同处理大多数样本,快速推进系统至需求低谷状态。当采样完成度达到训练要求时,系统会执行缩容操作,释放固定数量的rollout GPU资源,并将其转入训练模式。第二阶段是并行执行阶段,被释放的GPU专门执行训练任务,充分利用低谷期的闲置资源;而剩余的GPU则继续处理长尾样本,确保采样任务不会中断。当训练任务完成后,系统会立即执行扩容操作,回收所有GPU资源,恢复全力采样状态,为应对下一轮的需求高峰做好准备。这种基于工作负载特征的智能时分复用策略,并非简单的资源分割,而是将训练的快速执行特性与rollout的需求波动在时间维度上进行巧妙匹配,从而实现整体GPU资源利用效率的提升。

以4GPU系统为例,通过对比共置方案、异步分离方案和时分复用方案的任务执行时间线,能够清晰地看到时分复用方案的优势。共置方案中,4GPU先全部执行rollout任务,等待所有样本完成后再执行training任务,整体耗时最长;异步分离方案中,2GPU固定执行rollout,2GPU固定执行training,但双方都会出现闲置等待的情况;而时分复用方案中,4GPU先全力执行rollout,当达到训练触发条件后,2GPU切换至training模式,与剩余2GPU处理长尾样本的过程并行,整体耗时显著缩短,GPU利用率大幅提升。

值得注意的是,时分复用方案的核心挑战在于系统复杂度的显著提升。为了追求更高的性能,需要设计精细复杂的控制机制,这些机制在分布式高并发的系统中实现起来尤其困难。相比共置方案的串行执行和异步分离方案的静态资源分配,时分复用方案的动态调度引入了诸多技术难点,比如分布式环境下的精确同步控制、扩缩容操作的原子性保证,以及并发场景下样本状态的无缝迁移等。在一个包含数万行代码的分布式RL系统中,仅仅依靠手工编码来实现这些复杂逻辑,不仅开发周期长,而且很容易引入隐蔽的状态不一致bug,传统的开发方式已经难以应对这种“高价值、高复杂度”的功能迭代需求。也正是在这一背景下,我们创新性地采用了文档驱动的Vibe Coding方法论,通过系统化的设计文档驱动开发流程,试图在提升开发效率的同时,保证代码质量和系统稳定性。

前文提到的Vibe Coding三大痛点,上下文丢失、决策偏离、质量不稳定,其根源都指向同一个问题,那就是缺乏持久化、结构化的决策管理机制。要理解设计文档如何解决这一问题,我们首先需要明确代码实现的本质——代码并非孤立的指令集合,而是由成百上千个相互关联的决策点构成的有机整体。从顶层的架构选择、接口设计,到底层的变量命名、错误处理,每一个决策都影响着最终的代码质量和系统性能。在理想情况下,如果AI已经掌握了完整的代码改动逻辑,比如代码迁移任务,它可以直接复制执行这些修改。但在实际开发中,我们需要解决的往往是全新的问题,比如本文中的“训练-推理时分复用优化”功能,此前从未有过成熟的实现方案,AI也无法直接获取可参考的代码逻辑。

既然没有现成的代码可以参考,那么退而求其次,如果我们能够系统化地枚举出所有决策点,明确每个决策的核心要求和约束条件,AI就可以按照这些明确的决策逐步生成代码。而设计文档,正是实现这一目标的关键工具。它通过结构化的方式,将高层的设计思路逐步细化为具体的代码改动方案,完整记录每一个决策点的思考过程、选择依据和最终结论。经过程序员审阅的设计文档,意味着人与AI在关键决策上达成了一致,这就从根本上解决了Vibe Coding的三大痛点:持久化的文档消除了上下文丢失的问题,明确的决策点避免了AI偏离开发者意图,标准化的规范和清晰的代码逻辑确保了生成代码的质量稳定。

这种模式带来了工作方式的根本转变,开发者的核心工作不再是编码、调试、测试等执行层面的任务,而是转向与AI讨论设计方案,通过设计文档明确各个决策点,直到双方完全对齐认知,之后由AI负责具体的代码实现。同时,设计文档还会记录实施进度、遇到的问题及解决方案,确保整个开发过程的可追溯性。更重要的是,设计文档本身也可以由AI辅助管理,开发者只需要把控核心决策,AI可以协助完成文档的结构化组织、细节补充和迭代优化,大大降低了设计文档的编写门槛,提升了整体开发效率。

为了更清晰地对比这种新模式与传统开发方式的差异,我们可以从工作流程、核心角色、效率表现、质量保障四个维度进行分析。传统的手工编码模式中,开发者需要独立完成从设计到编码、调试、测试的全流程工作,效率较低,质量依赖个人经验;传统的Vibe Coding模式中,开发者通过对话与AI交互,直接生成代码,效率较高但质量不稳定,上下文易丢失;而文档驱动的Vibe Coding模式中,以设计文档为核心,开发者把控决策,AI负责编码,既保证了效率,又通过标准化的决策管理确保了质量,同时解决了上下文丢失的问题。三种开发方式的优缺点对比十分明显,文档驱动的Vibe Coding模式,无疑更适合AI Infra这类复杂系统的开发需求。

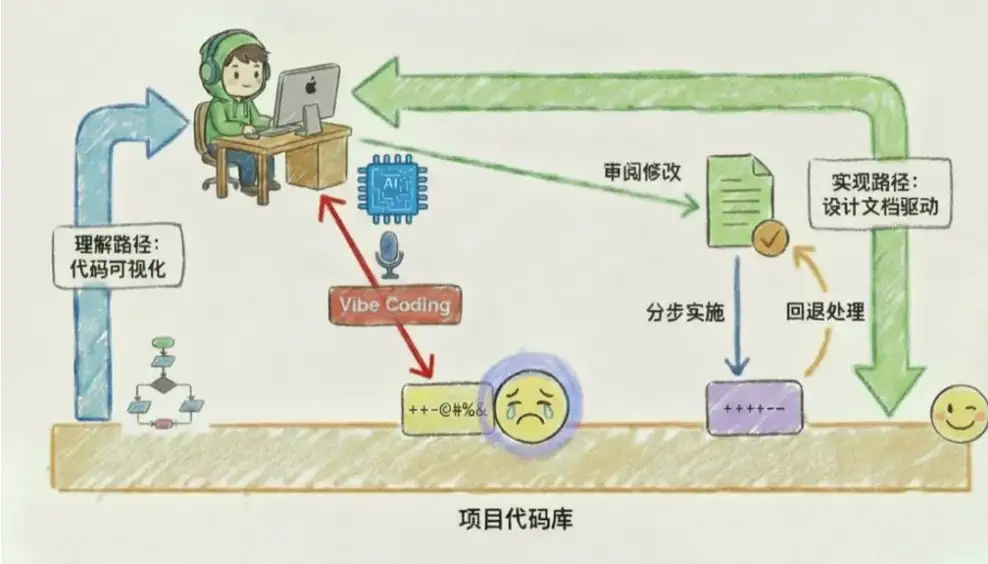

在明确了设计文档的必要性后,我们需要建立一套系统化的方法论来指导实际操作,这就是设计文档驱动开发方法论。这种方法论不仅仅是简单的编写文档,更是一种全新的开发范式,核心在于通过结构化的文档组织决策过程,通过迭代审阅确保决策质量,通过分步实施降低实现风险。整个方法论将复杂的系统开发问题分解为三个可管理的环节:内容组织、审阅修改、分步实施,每个环节都有明确的操作流程和质量标准,确保整个开发过程的可控性和可预测性。

首先来看流程概览,设计文档的审阅是一个迭代优化的过程,需要人和AI协同配合来确保文档质量。我们建立的系统化审阅流程,通常包含四个步骤:第一步是开发者提出初步的设计思路和核心决策点,形成文档初稿;第二步是AI根据初稿,补充细节内容,完善决策体系,形成第一版完整文档;第三步是开发者逐章节审阅文档,指出其中的问题、不合理的决策及改进方向;第四步是AI根据开发者的反馈,修改完善文档,并同步调整后续章节的相关决策,确保文档内部逻辑一致。之后重复第三、四步,直到文档达到实施标准,双方在所有关键决策点上达成共识。

在内容组织环节,核心是开发者与AI共同完成决策体系的构建。如前所述,代码实现的结果是由一系列自顶向下的决策决定的,顶层的关键决策包括新功能如何融入已有架构、核心流程如何设计等,底层的决策则包括是否需要增加成员变量、接口参数如何定义、错误处理如何实现等。组织设计文档的核心目的,就是系统性地跟进这些决策点,并逐步完善解决方案。由于底层决策往往依赖于顶层或上层决策,设计文档需要层次化地拆解决策,形成清晰的决策体系。开发者需要按照章节的先后顺序和目录层次结构,审阅文档中的自顶向下的决策过程,当指出前面顶层设计的错误时,AI会自动修改后面章节的中层和下层决策,以保持文档内部逻辑的一致性。

具体来说,我们的设计文档模板包含六个核心部分:第一部分是功能概述,明确新功能的核心目标、应用场景和价值;第二部分是架构设计,阐述新功能如何融入现有系统架构,核心模块划分及模块间的交互关系;第三部分是核心流程设计,详细描述新功能的关键执行流程,包括正常流程和异常流程;第四部分是接口设计,定义需要新增或修改的接口,包括接口参数、返回值、数据类型等;第五部分是实现细节设计,细化每个接口和核心函数的实现逻辑,明确关键决策点;第六部分是实施计划,规划代码实现的步骤、依赖关系和验证标准。这种结构化的模板,能够确保设计文档的完整性和逻辑性,为后续的开发工作奠定坚实基础。

在审阅修改环节,核心挑战在于如何高效解决审阅过程中反复出现的场景化问题。前文描述的逐章节审阅对齐的过程,在理论上已经完备,但在实践中会遇到一系列挑战,比如AI对现有系统架构的理解不充分,导致设计方案与现有系统不兼容;或者对复杂决策点的考虑不全面,遗漏关键约束条件;又或者文档中的决策逻辑存在矛盾,无法指导实际编码。为了应对这些挑战,我们建立了多层次的文档质量保证机制,其中最核心的是复用iFlow CLI的prompt模板。

iFlow CLI是阿里巴巴未来生活实验室推出的一款终端AI智能体,支持通过自然语言进行交互,能够高效分析代码仓库、完成各类编程任务,并准确理解特定的上下文需求。由于审阅过程中的很多场景会反复出现,我们利用iFlow CLI的Sub Command功能,将不同场景的指令逻辑固化成了自定义的prompt模板。比如,针对“设计方案与现有系统架构不兼容”的场景,我们制定了专门的prompt模板,明确要求AI在修改设计方案时,必须先分析现有系统的架构约束,确保新方案能够无缝集成;针对“决策逻辑不全面”的场景,模板会引导AI从业务需求、性能要求、兼容性、错误处理等多个维度完善决策逻辑。通过这些固化的prompt模板,能够显著提升审阅修改的效率,确保设计文档的质量。

当设计文档完成所有API和实现细节的设计后,就进入了实施阶段,核心是如何将设计转化为可执行的代码。这一转化过程分为两个阶段:首先规划实施步骤,然后进入AI辅助的增量开发循环。规划实施步骤的核心目标,是将设计文档中定义的方法拆解为依赖有序的小步骤,降低单次开发的复杂度,同时便于验证和回退。我们首先会分析每个方法的依赖关系,识别底层辅助方法和高层协调方法之间的依赖,绘制出完整的依赖图。在拆解步骤时,我们遵循“每步越小越好”的原则,通常一个步骤包含3-5个相互关联的方法,避免单个步骤包含过多方法导致难以验证。

步骤的排序严格遵循依赖关系:第一步通常是基础设施的搭建,包括配置文件、常量定义、基础类的实现等;第二步到第N步按照从底层到高层的顺序排列,逐步实现核心业务逻辑;最后一个步骤负责功能集成和端到端测试。每个步骤都定义了清晰的验证点和测试用例覆盖范围,确保每个步骤完成后都可以独立验证,一旦出现问题能够快速定位并回退。规划完成后,我们会得到一个清晰的依赖图,这个依赖图会成为后续增量开发的核心指导,确保开发过程有序推进。

规划完成后,就进入了增量开发循环阶段。对于每个步骤,AI首先会读取实施计划中该步骤的目标和依赖关系,以及设计文档中相关方法的签名和实现细节,然后按照docstring的要求生成具体代码,同时将设计文档中预留的验证占位符展开为实际的验证逻辑。AI完成编码后,会自动更新实施计划中该步骤的状态,将方法从“未开始”改为“已完成”。接下来是人工代码审查环节,我们使用IDE的本地历史功能查看当前步骤的代码改动,重点检查代码是否符合设计文档的要求、是否正确实现了验证逻辑和断言、是否存在明显的bug。如果发现问题,会进行小范围修正,或者进入专门的错误处理流程;如果审查通过,就创建一个git提交,提交信息遵循“Step N:[步骤描述]”的格式,然后继续下一个步骤,重复这个循环直到所有步骤完成。

在分布式AI训练环境中,系统的健壮性至关重要,微小的错误都可能触发级联故障,而异步操作和资源调度的复杂性,使得问题追溯变得十分困难。更糟糕的是,AI编程往往倾向于主动做错误处理,这种“善意”的处理机制有时会弄巧成拙,掩盖了真实的错误信息,导致问题定位更加复杂。我们真正需要的是防御性编程,让错误主动暴露而不是被掩盖,从而快速定位并解决问题。然而,传统的防御性编程开发繁琐,在进度压力下常常被开发人员选择性忽略,导致系统健壮性完全依赖个人自觉。

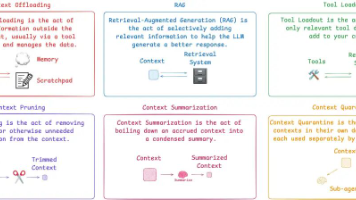

为了解决这一问题,我们将防御性思维前置到设计阶段,通过三个核心手段实现系统健壮性的提升:建立统一的验证模式库、在设计阶段进行验证标注、由AI自动展开验证逻辑。首先,我们维护了一个包含常用验证模式的库,每个模式都有唯一的ID和标准化的实现,遵循“单一定义,多处复用”的原则。当需要在代码中增加某个验证逻辑时,只需在注释中加入模式库中的对应ID,AI在实施时会按ID查表展开,确保整个代码库中相同验证逻辑的一致性。其次,在设计文档的实现细节部分,我们不直接编写完整的验证代码,而是用标准化的注释标注验证需求。比如在shrink_sampler函数中,通过VALINTRANGE标注GPU列表的合法性验证,通过ASTPOSTCONDITION标注返回结果的有效性检查,这种标注方式既清晰表达了验证意图,又保持了设计文档的简洁性。最后,当AI根据设计文档生成代码时,会自动将标注中的模式ID展开为具体的验证逻辑,参数范围验证会展开为完整的条件检查语句,后置条件会生成带有详细错误信息的assert语句,这种自动展开机制避免了人工编码时的遗漏和不一致。

对于超过10行的复杂验证逻辑,内联展开会让代码变得臃肿难读。针对这类复杂验证,我们在设计文档中定义专门的验证函数,详细描述验证项、错误处理策略和返回结果。比如_validate_gpu_allocation函数,专门负责验证GPU分配逻辑的完整性,包括检查目标GPU列表非空、确保GPU ID在有效范围内、验证GPU资源是否可用等。在实施计划中,我们会安排专门的步骤来实现这些复杂验证函数,为后续的核心逻辑步骤提供坚实的基础,确保整个系统的健壮性。

理论和方法论的价值,最终需要通过生产环境的验证来体现。为了检验时分复用方案的实际效果,同时验证文档驱动的Vibe Coding方法论的可行性,我们在生产级别的大规模集群上开展了专项实验。实验环境采用160卡GPU集群,选择了具有代表性的SWE Agentic工作负载作为测试场景,这种工作负载能够充分模拟真实的智能体强化学习任务。模型方面,我们使用了Qwen3-235B-A22B,这是一个具有2350亿参数规模、220亿激活参数的大规模语言模型,其训练过程对计算资源的需求极高,能够充分体现真实生产环境的计算压力。

为了模拟真实的智能体长时交互场景,我们将实验中的最大交互轮数设置为100轮,最大token长度为64K,batch size设置为512。同时,我们将异步训练的async ratio设置为1,这种配置能够最大限度地还原真实生产环境的复杂性和挑战性。在对比方案设置上,我们将时分复用方案与传统的异步分离方案进行对比,其中基准方案(baseline)采用128卡用于training、32卡用于rollout的静态分配策略,而时分复用方案则采用128卡training、160卡rollout的动态调度策略,通过动态调整GPU资源的分配,实现资源利用效率的优化。

实验结果显示,时分复用方案的rollout吞吐率相比基准方案提升了3.5倍。从任务执行时间线来看,时分复用方案的rollout阶段几乎始终比完全分离的基准方案更快,甚至在某些情况下,训练任务无需等待rollout阶段完成即可开始,整体性能提升十分明显。这一结果充分证明了时分复用方案在提升资源利用效率方面的优势,通过动态调度GPU资源,有效解决了传统方案中存在的资源闲置问题。

更值得关注的是任务完成率的提升。在基准方案的完全分离模式中,由于rollout资源受限,仅有32卡用于采样任务,导致采样速度较慢,大量任务触发了环境默认的超时限制,采样轨迹的timeout比例居高不下。而时分复用方案通过动态释放更多GPU资源用于rollout任务,显著加快了采样速度,完全避免了timeout情况的发生,不仅提升了整体训练的稳定性,更提高了样本的利用效率。在大规模强化学习训练中,样本的有效利用直接影响模型的训练效果,timeout比例的降低能够让模型获得更充分的训练数据,从而提升模型性能。

在评估一个新方案时,除了关注性能提升,还需要仔细分析其引入的系统开销,确保方案的整体可行性。我们对时分复用方案的系统开销进行了详细分析,主要包括参数同步开销和缩容操作开销两个方面。参数同步开销方面,由于时分复用方案需要在更多的GPU之间进行参数同步,相比基准方案会产生额外的通信开销,但通过实际测试发现,这一开销在整体训练时间中占比极小,不足1%,对整体性能几乎没有影响。

缩容操作的开销主要来自于rollout模型参数的offload过程。当系统需要将部分GPU从rollout模式切换到training模式时,需要从显存中将rollout参数释放,为训练任务腾出显存空间。实测数据显示,这一过程的耗时在秒级,通常在2-3秒之间。尽管这一操作引入了额外的同步点,但由于缩容操作的开销极低,且只会在阶段切换时执行,因此并未成为性能瓶颈。综合来看,时分复用方案通过智能的资源调度策略,在引入极小系统开销的前提下,显著提升了GPU利用率和训练效率,特别是在降低timeout率方面表现突出,充分证明了该方案在大规模Agentic RL训练中的实用价值。

本文所呈现的成果,是ROCK & ROLL团队使用iFlow CLI在开源框架实践中的探索成果,后续相关功能将持续迭代并陆续发布。ROCK & ROLL团队由阿里巴巴未来生活实验室与智能引擎团队联合打造,核心使命是开拓强化学习(RL)的未来,探索面向未来的创新生活方式。其中,ROLL是一个灵活高效的Agentic RL训练框架,支持从十亿到千亿参数大模型的优化训练,能够满足不同规模强化学习任务的需求;ROCK则是一个易用、可扩展的沙箱环境管理器,可在分钟级内拉起海量环境,为强化学习训练提供高效的环境支撑。

我们始终坚持工程系统与算法协同创新的理念,一方面深耕强化学习算法研究,不断提升模型的性能和效率;另一方面注重工程化落地,通过优化基础设施、开发高效工具,为RL在不同场景中的规模化落地提供坚实支撑。同时,我们持续关注RL社区的发展,积极分享开源实践,希望与社区开发者共同推动强化学习技术的进步。iFlow CLI作为我们自主研发的终端AI智能体,正是这一理念的具体体现,它能够通过自然语言交互,帮助开发者高效完成各类编程任务,将复杂工作流自动化,显著提升开发者的工作效率。

AI Infra的开发之路充满挑战,复杂的系统架构、严苛的工程约束、高昂的开发成本,都成为了技术落地的阻碍。而文档驱动的Vibe Coding方法论,为我们提供了一种全新的解决思路,通过设计文档将复杂决策体系化、持久化,实现了开发者与AI的高效协同,既发挥了Vibe Coding的高效优势,又解决了其在复杂系统开发中的痛点问题。时分复用方案在大规模Agentic RL训练中的成功实践,不仅验证了该方法论的可行性,更为AI Infra领域的高效开发提供了可借鉴的范例。

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)