robobrain ManualVLA具身智能思路 “感知-认知-决策-控制”全链路闭环

我做mod需要这个区域感知,因为要标头发,制作3d模型和具身智能思路差不多

【仉尚航 北京大学】如何让机器人像人一样思考?_哔哩哔哩_bilibili

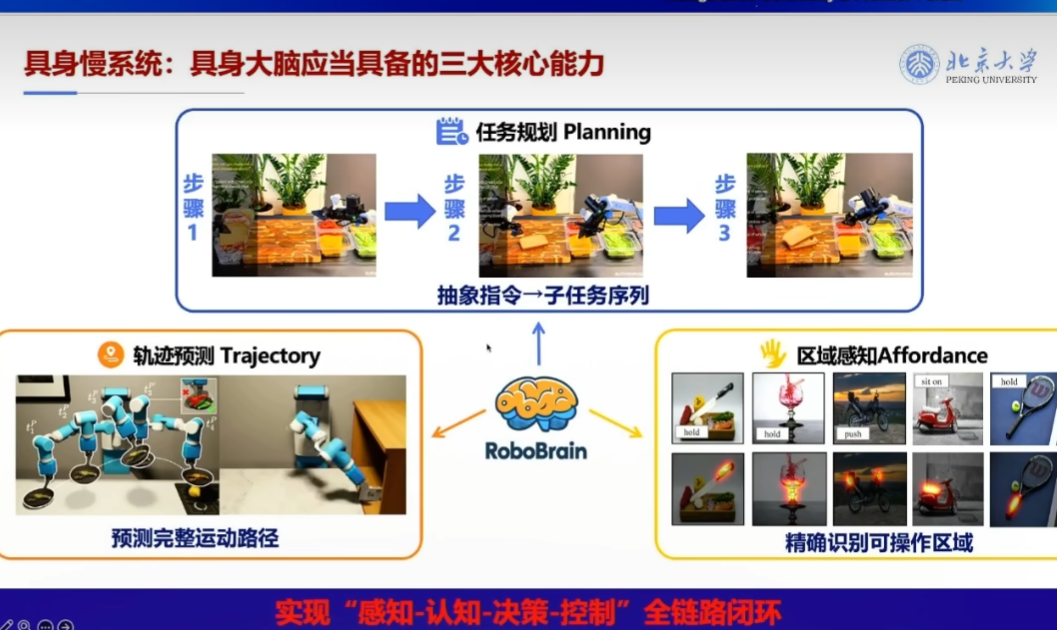

这张图展示了北京大学提出的“具身智能系统”(Embodied Intelligence System)中,RoboBrain 作为核心大脑所应具备的三大核心能力,旨在实现机器人从“感知-认知-决策-控制”的全链路闭环。以下是该思路的详细解析:

🎯 核心目标:实现“感知-认知-决策-控制”全链路闭环

这是具身智能的关键挑战——让机器人不仅能感知环境,还能理解任务、规划行为,并精确执行动作。

🔧 RoboBrain 的三大核心能力

1️⃣ 任务规划(Planning)

功能:将抽象指令分解为可执行的子任务序列

- 输入:一个高层抽象指令,例如:“切菜并装盘”

- 输出:一系列具体步骤(如:拿刀 → 切菜 → 放盘)

- 示例流程:

- 步骤1:识别场景与物体

- 步骤2:生成中间状态(如拿起刀)

- 步骤3:完成最终动作(如切好菜)

✅ 关键点:从自然语言或高层指令到低层动作的语义解耦与任务分解,是机器人自主性的基础。

2️⃣ 轨迹预测(Trajectory Prediction)

功能:预测完整运动路径,确保动作安全、高效

- 展示了一个机械臂在不同阶段的运动轨迹模拟。

- 能够提前预测整个操作过程中的位姿变化和空间占用。

- 有助于避免碰撞、优化路径、提高执行成功率。

✅ 关键点:结合物理模型与学习方法,实现对连续动作的动态建模与仿真,支撑高精度操控。

3️⃣ 区域感知(Affordance)

功能:精准识别环境中可操作的区域与方式

- “Affordance”(可操作性)指物体提供的潜在交互方式。

- 图中展示多种典型例子:

- 可“hold”(抓握)的杯子、球拍

- 可“push”(推动)的小车

- 可“sit on”(坐上)的椅子

- 可“cut”(切割)的食物表面等

➡️ 通过视觉+语义理解,识别出每个物体的可用操作接口,提升机器人对复杂环境的理解能力。

✅ 关键点:从“看到物体”到“知道能做什么”,实现语义级交互理解。

💡 RoboBrain 的角色定位

RoboBrain 是一个中央智能体,整合以上三种能力:

text

编辑

[感知] → [认知] → [决策] → [控制]

↑ ↑ ↑

视觉/触觉 Affordance Trajectory

↓ ↓ ↓

RoboBrain ←←←←←←←←←←←←←←←←←←

↑ ↑ ↑

Planning ←←←←←←←←←←←←←←←←←←它负责:

- 理解任务意图(Planning)

- 分析环境可能性(Affordance)

- 规划最优路径(Trajectory)

- 协调执行动作(Control)

✅ 总结:RoboBrain 具身智能思路的核心理念

表格

| 维度 | 内容 |

|---|---|

| 目标 | 实现类人级的通用机器人智能 |

| 架构 | 中央大脑 + 多模态感知 + 动作生成 |

| 关键技术 | 任务分解、轨迹预测、可操作性识别 |

| 闭环逻辑 | 感知 → 认知 → 决策 → 控制 → 反馈 |

🔮 未来展望

这种“具身大脑”框架不仅适用于家庭服务机器人,也可扩展至工业自动化、医疗辅助、人机协作等领域。其本质是构建一个具有常识推理与适应能力的机器人认知系统,迈向真正的通用人工智能(AGI)在物理世界中的落地。

📌 关键词总结:

具身智能、RoboBrain、任务规划、轨迹预测、Affordance、感知-认知-决策-控制闭环

这正是北大团队在具身智能方向上的代表性研究范式之一。

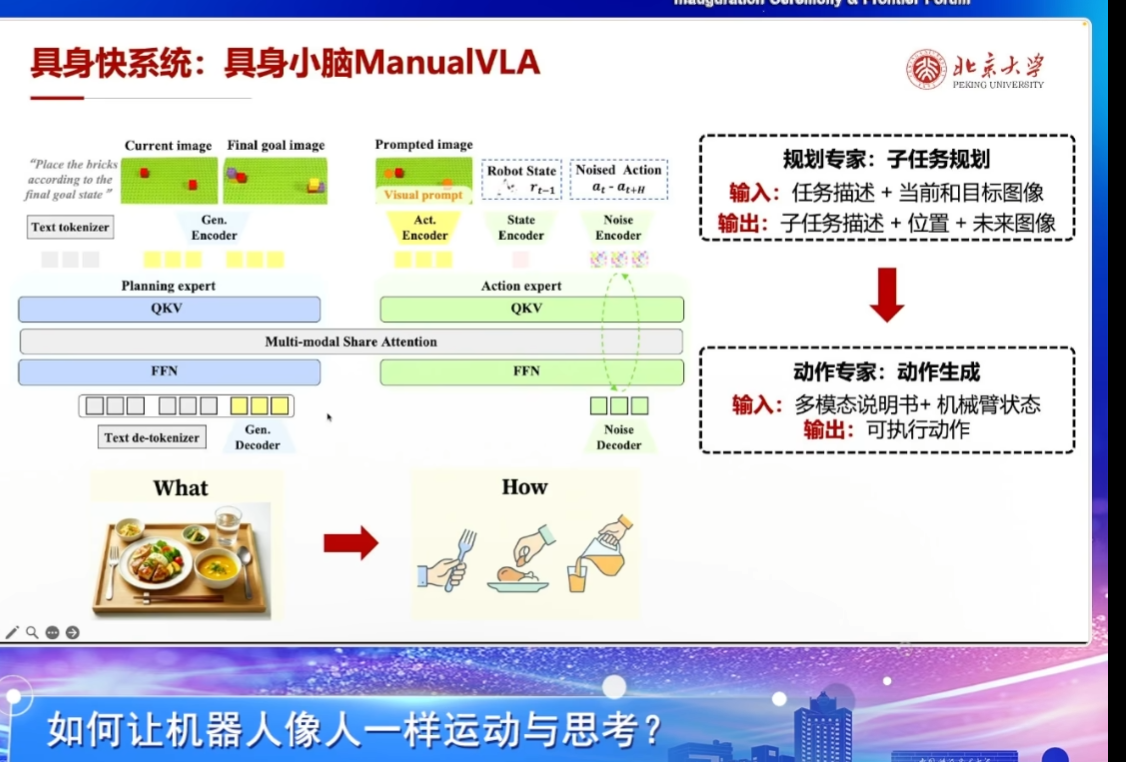

这张图片展示的是北京大学在“具身快系统:具身小脑ManualVLA”方面的研究成果,旨在解决“如何让机器人像人一样运动与思考?”这一核心问题。以下是该图的详细解析:

1. 标题与主题

- 标题:具身快系统:具身小脑ManualVLA

- 目标:构建一个能够像人类一样进行感知、规划和执行动作的机器人系统。

- 核心理念:通过多模态信息融合(视觉、语言、状态等)实现机器人对任务的理解与执行。

2. 系统架构

整个系统分为两个主要模块:

(1) 规划专家(Planning Expert)

- 输入:

- 任务描述(如文本:“Place the bricks according to the final goal state”)

- 当前图像(Current image)

- 目标图像(Final goal image)

- 功能:

- 将任务分解为一系列子任务。

- 输出包括子任务描述、位置信息以及未来可能的状态图像。

- 技术组件:

- Text tokenizer:将自然语言转换为token序列。

- Gen. Encoder:编码当前和目标图像。

- QKV:查询(Query)、键(Key)、值(Value),用于注意力机制。

- Multi-modal Share Attention:跨模态共享注意力机制,整合不同模态的信息。

- FFN:前馈网络,处理特征。

- Gen. Decoder:解码生成最终的规划结果。

(2) 动作专家(Action Expert)

- 输入:

- 多模态说明书(包含任务描述、图像提示等)

- 机械臂当前状态(Robot State)

- 噪声动作(Noised Action,可能是为了增强鲁棒性而引入的扰动)

- 功能:

- 根据规划专家提供的信息,生成可执行的具体动作。

- 技术组件:

- Visual prompt:提供视觉引导。

- Act. Encoder:编码动作相关的信息。

- State Encoder:编码机器人当前状态。

- Noise Encoder:编码噪声动作。

- QKV + FFN:类似规划专家,但专注于动作生成。

- Noise Decoder:解码噪声动作,辅助生成更稳定的动作。

3. “What” 与 “How” 的关系

- What:表示任务的目标或意图,例如“吃一顿饭”。

- 图中展示了一盘食物,象征着任务的最终目标。

- How:表示实现目标的具体方法,即动作序列。

- 图中展示了使用叉子夹食物、倒饮料等具体操作步骤。

- 连接:红色箭头表示从“What”到“How”的转化过程,即从任务理解到动作执行的过程。

4. 关键技术亮点

- 多模态融合:

- 结合文本、图像、状态等多种信息源,提升系统的理解和决策能力。

- 分层设计:

- 分为“规划专家”和“动作专家”,分别负责高层任务分解和底层动作生成。

- 注意力机制:

- 使用QKV和共享注意力机制,确保不同模态之间的有效交互。

- 噪声增强:

- 引入噪声动作,提高模型在实际环境中的鲁棒性和泛化能力。

5. 应用场景

- 机器人操作:如装配、搬运、烹饪等需要精细操作的任务。

- 智能助手:帮助人类完成日常家务或复杂任务。

- 自动驾驶:结合视觉和语义理解,实现更安全的驾驶行为。

6. 总结

该系统通过“具身小脑”概念,实现了机器人在复杂环境中像人类一样进行思考和行动的能力。其核心在于:

- 利用多模态信息进行任务理解;

- 分阶段完成任务规划和动作生成;

- 强调“What”(目标)与“How”(方法)的统一。

这不仅是人工智能领域的前沿探索,也为未来机器人技术的发展提供了重要方向。

如果你有更多关于这个系统的问题,比如具体的算法细节、实验结果或者应用场景,欢迎继续提问!

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)