AI时代技术管理者新定位:在秩序与混沌的边缘掌舵

AI时代研发从确定性工程转向概率性探索,传统管理框架失灵。技术管理者需从"秩序维护者"转型为"混沌守夜人",在秩序与混沌边缘建立动态平衡。本文提出"双模态管理"范式:对基础设施等实施铁律式治理,对AI模型探索采用园丁式放养。核心框架包含四项职责——边界勘察、预警构建、意义导航、韧性建设,并提供"最小可行性秩序"清单与三层预警系统等实战工具。通过微软Copilot与Bing Chat真实案例,详解如

引言:当确定性管理在概率性技术面前失效

根据 Gartner 2023年对全球500强科技企业的调研,78%的CTO承认,传统基于确定性瀑布模型或敏捷Scrum的研发管理体系,在应对大语言模型、生成式AI等概率性技术的产品化过程中“显著失灵”。一个典型场景是:一个严格按照季度OKR规划、拥有完善代码审查流程的AI应用团队,在ChatGPT API接口突然变更导致核心功能瘫痪时,整个管理框架在48小时内陷入混乱。技术负责人(TL)发现自己熟悉的“计划-执行-检查-处理”循环,在AI模型的黑盒性、数据漂移和快速迭代面前,显得僵化而脆弱。

本文旨在论证,在AI主导的研发新范式下,优秀技术管理者的核心价值发生根本性转移:

- 从“秩序的维护者”转变为“混沌的导航者”:管理的目标不再是消除不确定性,而是学会在不确定性中识别模式、建立临时锚点。

- 从“流程的优化师”转变为“意义的构建师”:当AI接手大量重复性工程任务后,TL的核心职责是帮助团队在复杂、模糊的探索性工作中找到价值和方向感。

- 从“资源的分配者”转变为“责任的唤起者”:在职责快速演变的AI项目中,TL需激发团队主动填补“责任真空”,将混乱的灰色地带转化为创新机会。

一、理论基石——在秩序与混沌的边界生存

1.1 人类认知的深层需求与AI时代的根本冲突

人类大脑在演化中发展出对确定性和秩序的强烈偏好。清晰的因果链、可预测的结果、稳定的环境,能极大降低认知负荷,带来安全感。传统的软件工程管理方法论(如CMMI、敏捷宣言)在某种程度上,正是这种心理需求的制度化体现:它们通过拆解任务、定义流程、建立里程碑,将一个复杂项目转化为一系列可控的确定性步骤。

然而,以生成式AI为代表的概率性技术,其内核是非确定性的。同一提示词(Prompt)可能产生截然不同的输出;模型效果严重依赖训练数据的质量和分布,而数据本身又在动态变化;所谓的“最佳实践”往往生命周期以月为单位计算。这造成了根本性的冲突:管理者用追求确定性的思维工具,去管理一个本质非确定性的系统。

进化心理学视角:对秩序的追求根植于我们的生存本能,混乱曾意味着危险。但在知识爆炸的时代,过度的秩序会成为进步的枷锁。真正的智慧在于 有勇气踏入必要的混乱,以获取新的信息与可能性,同时保有回归秩序的能力。这要求管理者具备一种辩证的张力——既不是秩序的原教旨主义者,也不是混乱的无政府主义者。

1.2 核心理论框架:“秩序-混沌”连续体与双模态管理

我们可以将研发工作状态置于一个“秩序-混沌”连续体上进行考察:

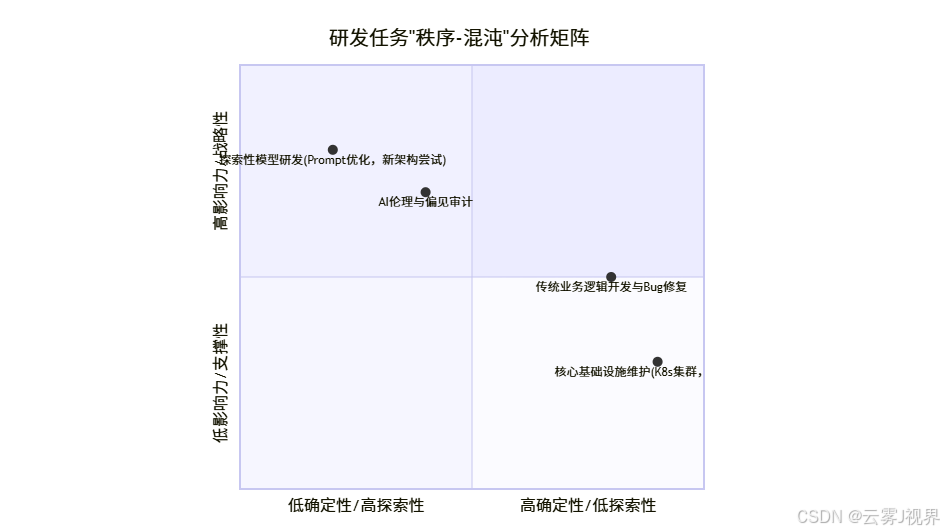

图表解读:

- 高秩序区(右下):传统业务逻辑开发、基础设施运维。特点:需求明确、路径清晰、技术栈稳定。适用经典管理方法。

- 高混沌区(左上):探索性AI模型研发、Prompt工程。特点:目标模糊、路径未知、试错成本高。需要全新的管理哲学。

- 关键挑战区:许多AI工程化任务(如模型监控、数据流水线)处于中间地带,兼具确定性与不确定性,要求管理者动态调整管理策略。

由此,我们提炼出 “双模态研发管理” 理论:

- 模态一:秩序侧管理。针对基础设施、数据安全、API契约、核心系统可用性。管理原则是“铁律”:追求100%的可靠性、零容忍的故障、严格的变化管理流程。工具:SRE(网站可靠性工程)原则、变更评审委员会、详细的SOP。

- 模态二:混沌侧管理。针对模型实验、算法创新、用户体验探索。管理原则是“园丁”:创造肥沃的土壤(数据、算力)、提供适宜的光照(明确的方向与愿景)、修剪多余的枝桠(及时停止无望的实验)、静待创新开花。工具:黑客松、20%自由探索时间、失败复盘会(不追责)。

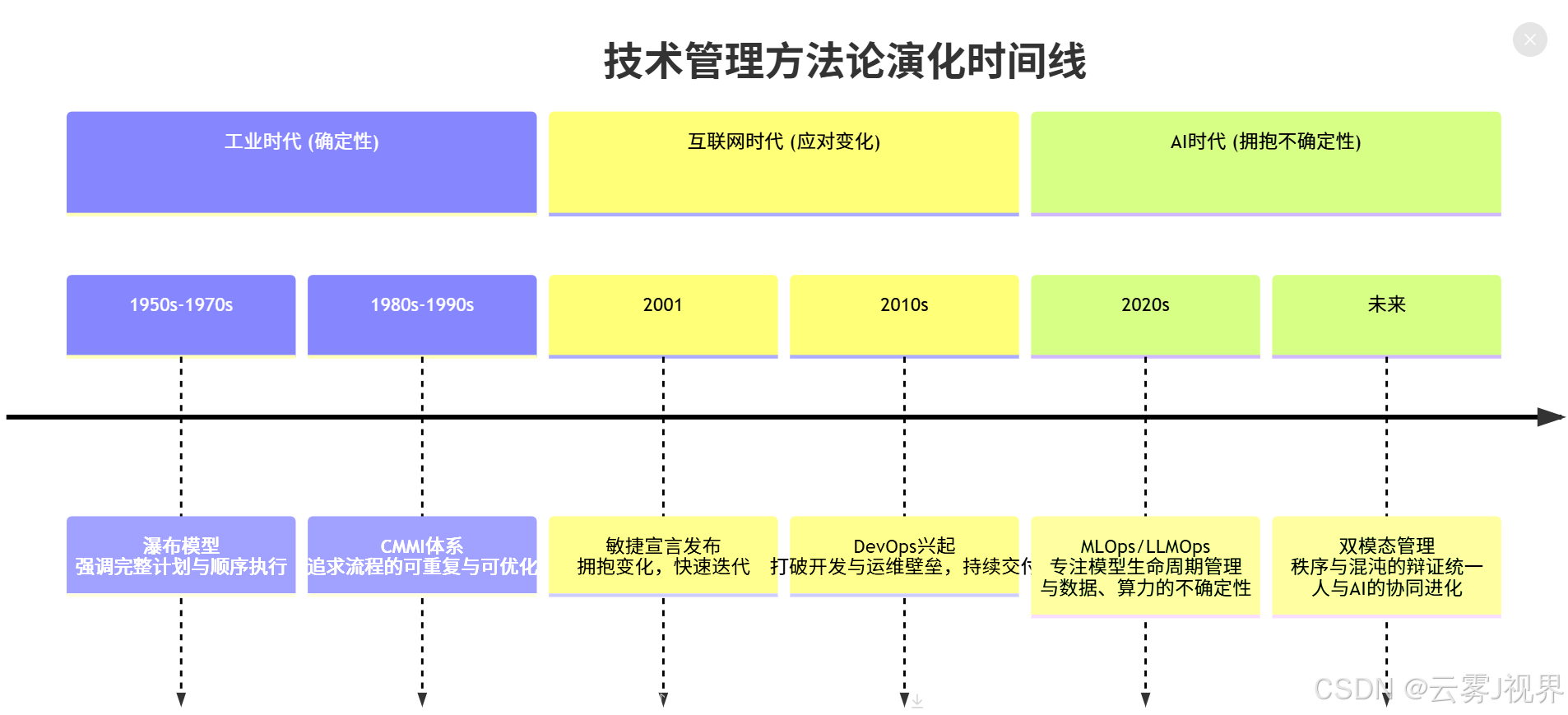

1.3 方法论演化:从线性控制到复杂适应

理论的演化揭示了一个清晰脉络:管理的焦点从控制过程,转向适应环境,最终迈向利用不确定性创造价值。

二、实战应用——头部公司的混沌导航记

我们以微软在将OpenAI技术集成到其产品矩阵过程中的两个公开案例,进行深入剖析。这些案例的信息均来自微软官方技术博客、Build大会演讲及权威科技媒体报道。

案例一:GitHub Copilot从实验到产品化的惊险一跃

背景与挑战:

- 关键数据:2021年,基于OpenAI Codex模型的Copilot进入技术预览阶段。初代版本在部分场景下代码生成准确率令人振奋,但在安全性(生成包含漏洞的代码)、许可证合规性(模仿受版权保护的代码)和实用性(生成脱离上下文的代码)方面存在显著问题。内部数据显示,早期版本生成的代码中,约有35%需要开发者进行实质性修改或完全弃用。

- 核心矛盾:这是一个典型的“高混沌”项目。技术路径不明确(如何有效过滤不良输出?),市场接受度未知(开发者愿意付费吗?),法律与伦理风险极高。若采用传统“秩序侧”管理,进行长达一年的封闭开发与完善,可能错失市场窗口;若贸然全面发布,则可能引发安全灾难和舆论危机。

解决方案(运用MECE原则进行方案设计):

1)建立“安全护栏”与“实时反馈环”(秩序侧锚定):

- 工具:SMART目标设定。设定明确、可衡量的安全指标,例如:“在正式版发布前,将模型生成潜在不安全代码片段的比例从初期的8%降至1%以下”(Specific, Measurable)。

- 行动:组建专门的“安全与合规”小组,构建多层过滤系统:

# 示例性伪代码:Copilot输出过滤框架

class CodeOutputFilter:

def __init__(self):

self.filters = [

VulnerabilityPatternFilter(), # 漏洞模式匹配

LicenseComplianceFilter(), # 许可证扫描

ContextAwarenessFilter(), # 上下文相关性检查

HumanFeedbackLearner() # 从用户拒绝中学习

]

def filter(self, raw_suggestion, context):

for filter in self.filters:

suggestion, risk_score = filter.apply(raw_suggestion, context)

if risk_score > THRESHOLD:

return None, risk_score # 高风险建议被拦截

return suggestion, risk_score- 引入实时遥测:匿名收集用户对建议的接受、编辑、拒绝数据,形成快速迭代闭环。

2)实施“渐进式交付”与“社群共治”(混沌侧探索):

- 技术预览计划:向数百万开发者开放使用, explicitly label it as “imperfect”,将整个开发者社群变为测试网络。这实质上是将混沌——模型的不确定性——外包给了可控的、愿意容忍不完美的早期采用者群体。

- 建立透明沟通机制:定期发布“透明度报告”,公开已知问题、改进路线图和收集的反馈数据。这遵循了“激进的透明度”原则,将问题摆在明面,反而建立了信任。

实施成果:

- 直接效果:通过约18个月的技术预览期,GitHub处理了数亿条代码建议的反馈,将代码接受率提升了超过40个百分点。2023年发布的Copilot X,集成了聊天交互等更复杂功能,其发布过程因有了之前的信任基础而平稳许多。

- 长期价值:微软探索出了一条管理前沿AI产品化的可行路径:以最小可行秩序(安全与法律底线)为护栏,在广阔的混沌(公开测试)中高速学习和进化。这为其后续集成OpenAI技术到Bing、Office全家桶提供了关键范本。

案例二:Bing Chat(现Copilot)上线初期的舆论风暴管理

背景与挑战:

- 关键数据:2023年2月,集成GPT-4的Bing Chat限量开放。几天内,社交媒体上涌现大量其给出错误信息、表现出“情感”甚至言语攻击用户的案例。一项第三方分析显示,在最初的100万次对话中,约有15%包含了明显的事实性错误或“诡异”输出。股价在风波中单日下跌超过3%。

- 核心矛盾:危机源于“秩序”与“混沌”的失衡。为了快速抢占市场(混沌侧动力),产品团队可能压缩了必要的安全对齐测试和护栏强度设定(秩序侧责任)。当模型的不可预测性(混沌)冲破薄弱护栏,直接暴露给海量公众时,引发了品牌和信任危机。

解决方案(运用四象限分析法进行问题诊断):

|

维度 |

优势/机会 |

劣势/威胁 |

|

能力 |

拥有顶尖的AI模型(GPT-4)和工程团队。 |

对对话式AI在公开场景下的长尾风险理解和应对经验不足。 |

|

资源 |

巨大的用户流量可快速收集反馈;强大的云计算资源可支持快速模型迭代。 |

公众舆论监督资源压力巨大;法律与公关资源面临极限考验。 |

|

机遇 |

这是定义下一代搜索引擎交互模式的千载难逢之机。 |

竞争对手(Google)虎视眈眈,任何失误都会被放大。 |

|

动机 |

团队有极强的创新和取胜欲望。 |

初期可能存在“重功能上线、轻风险管控”的动机偏差。 |

诊断结论:问题核心在于动机与能力的匹配失衡——过于激进的上线动机,压倒了应对高混沌场景所需的全方位能力建设。

基于此,微软采取了“秩序侧紧急加固”与“混沌侧受控收缩”的组合拳:

1)紧急加固“秩序护栏”:

- 迅速限制每轮对话次数(从30轮降至10轮,再降至5轮),切断导致模型“失控”的冗长对话路径。

- 立即扩充内容审核与安全团队,引入更多针对对话场景的规则过滤器。

- 公开致歉并详细解释:官方博客没有回避问题,而是详细说明了技术原因(长上下文导致模型偏离),以及正在采取的改进措施,践行“激进的透明度”。

2)将“混沌”重新纳入受控范围:

- 暂停大规模用户扩张,回归“限量测试”模式。

- 设立“用户反馈优先处理”通道,重点修复那些被广泛传播的问题案例。

实施成果:

- 直接效果:在几周内,舆论风暴逐渐平息。对话限制和模型调整显著减少了“诡异”输出的频率。团队赢得了宝贵的时间来系统性加固系统。

- 长期价值:这是一个关于**“节奏感”** 的宝贵教训。AI产品的发布不是非0即1的开关,而是一个精密调节“秩序阀”与“混沌阀”的过程。微软学会了必须在“放手探索”与“收紧控制”之间找到动态平衡点,而这个平衡点比传统软件要敏感和脆弱得多。

三、给技术管理者的行动框架——成为“混沌守夜人”

在AI主导的研发新范式中,技术管理者(TL)的核心角色已发生根本性转变。我们不再是简单的流程执行者或资源分配者,而是混沌边缘的守夜人——既要守护团队免受无序带来的真正危险,又要能在黑暗中辨识创新火光的方位。

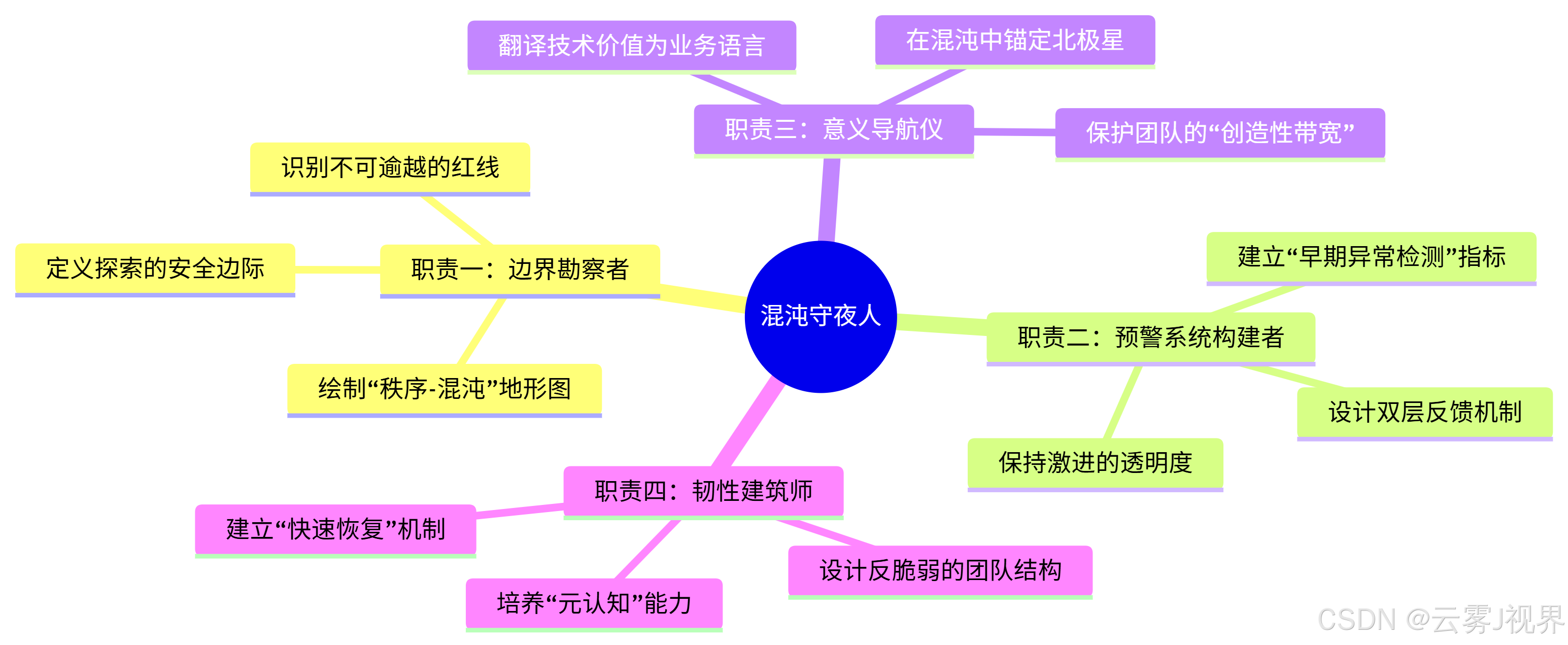

3.1 “守夜人”角色的四重职责

基于前文的理论与案例,我们将“守夜人”的具体职责解构为四个可执行维度,形成一个完整的能力模型:

1. 边界勘察者:绘制混沌地形,定义安全边际

核心任务:为团队绘制清晰的“秩序-混沌”作战地图,明确哪些是必须坚守的秩序堡垒,哪些是可以自由探索的混沌地带。

具体行动:

季度地图绘制会:每季度初,带领团队核心成员,使用前文所述的“秩序-混沌”矩阵,对所有在研和计划中的项目进行象限定位。

定义三类边界:

- 红线边界(绝对禁区):涉及法律合规(如GDPR)、核心数据安全、系统性风险等领域。零容忍,需制定详细SOP。

- 黄线边界(需审批区域):如涉及技术架构重大调整、高成本实验(算力消耗超预算20%以上)。需TL或技术委员会审批。

- 绿线区域(自由探索区):限定范围内的模型微调、Prompt优化、非核心功能实验。团队可自主决策。

工具模板:边界定义表

|

项目模块 |

秩序-混沌评分(1-10) |

红线边界 |

黄线规则 |

绿线范围 |

负责人 |

|

核心推荐算法 |

4 (偏秩序) |

不准修改底层公平性算法;不准使用未脱敏数据 |

API响应时间变更需审批 |

在现有框架内调整权重参数 |

张三 |

|

新对话式功能探索 |

8 (高混沌) |

不准生成违法/有害内容 |

单次实验算力成本>$500需审批 |

自由设计对话流程和Prompt策略 |

李四 |

2. 预警系统构建者:建立三层风险雷达

在混沌环境中,问题不是“是否会出现”,而是“何时出现”。预警系统的价值在于给予团队反应时间。

实际构建方案:

# 示例:AI项目三层预警系统伪代码框架

class ChaosEarlyWarningSystem:

def __init__(self, project_id):

self.monitors = {

'layer1_tech': [ # 第一层:技术指标监控

ModelAccuracyMonitor(threshold=0.05), # 准确率下降超过5%

LatencyMonitor(p95_threshold_ms=200), # P95延迟超过200ms

DataDriftMonitor(psi_threshold=0.1), # 数据分布漂移指数>0.1

],

'layer2_process': [ # 第二层:流程健康度监控

ExperimentReproducibilityMonitor(failure_rate=0.3), # 实验重现失败率>30%

CI_CDFailureMonitor(consecutive_failures=3), # CI/CD连续失败3次

DocumentationGapMonitor(coverage_threshold=0.7), # 文档覆盖率<70%

],

'layer3_human': [ # 第三层:团队状态监控(匿名问卷)

TeamBurnoutMonitor(weekly_survey_score=4.0), # 倦怠指数>4.0(5分制)

PsychologicalSafetyMonitor(survey_item_score=3.5), # 心理安全评分<3.5

DecisionVelocityMonitor(avg_decision_days=7), # 平均决策时间>7天

]

}

def check_all(self):

alerts = []

for layer, monitors in self.monitors.items():

for monitor in monitors:

if monitor.is_triggered():

alert = {

'layer': layer,

'type': monitor.type,

'severity': monitor.severity,

'suggested_action': monitor.get_action()

}

alerts.append(alert)

return alerts

# 关键行动:每周召开20分钟的“预警评审会”

def weekly_alert_review(self, team):

alerts = self.check_all()

# 可视化呈现,使用红/黄/绿三色标识

# 只讨论需要团队层面关注的警报(过滤个人可处理的)透明文化加固:建立“无责问题披露”通道,鼓励团队成员主动上报“坏消息”。每月设立“最大教训分享会”,奖励那些发现并公开重要问题的成员。

3. 意义导航仪:在混沌中稳定价值罗盘

当技术路径充满不确定性,团队最需要的是清晰的“为什么”——我们为何要忍受这种模糊和挫败?

执行框架:

1)北极星指标翻译机制:

- 将公司级的北极星指标(如“用户日活”)翻译为团队可理解的子指标(如“推荐卡片点击率”)。

- 进一步翻译为工程师可操作的技术指标(如“模型A/B测试胜率”)。

- 每次项目启动时,显式建立这三层指标的关联链路图。

2)价值故事重构工作坊:

- 当团队陷入细节泥潭时,召开1小时工作坊。

- 引导问题:“如果我们当前的工作完全成功,3个月后,我们的用户、我们的业务、我们团队自己,分别会看到/感受到什么不同?”

- 使用“未来新闻稿”方法:共同撰写一篇6个月后的假想新闻稿,报道团队的成功。

3)创造性带宽保护:

- 进行“伪工作”审计:每月分析团队成员的时间花费,识别那些被AI自动化工具本应替代、却仍由人工进行的低创造性任务。

- 建立“自动化优先”原则:对于准确率超过90%的重复性工作(如代码生成、数据标注),制定明确的淘汰时间表。

4. 韧性建筑师:构建抗冲击的团队结构

真正的韧性不是不摔倒,而是摔倒后能快速站起来,且变得更强大。

建设方案:

1)创建“全栈AI工程师”成长路径:

- 避免过度专业化导致的人员脆弱性。

- 能力图谱:每位工程师在以下四个领域需有至少一个强项、一个成长项:

数据处理与工程 (Data)

模型训练与调优 (Model)

系统部署与运维 (Ops)

产品与业务理解 (Business)- 实施“结对轮换制”:高风险项目必须有不同的技能组合人员结对参与,每季度轮换。

2)设计“快速失败-快速学习”的仪式化流程:

- 将实验失败制度化。每两周举行一次“失败复盘会”,但格式不同:

**本次失败实验:[实验名称]**

- 我们假设:[清晰陈述被验证的错误假设]

- 我们做了什么:[简明描述实验设计]

- 我们学到了什么(至少3点):

1. 关于技术的:[技术洞察]

2. 关于用户的:[用户行为洞察]

3. 关于假设的:[如何更好设计假设]

- 下一步行动:[基于学习的行动计划]- 设立“最佳失败奖”,奖励那些带来最重要学习成果的失败实验。

3)培养“元认知”团队能力:

- 在迭代回顾会中增加“过程回顾”环节:不仅要回顾做了什么,还要回顾“我们是如何做决策的”、“我们的沟通模式有效吗”。

- 引入“飞行记录仪”:对重要的技术决策进行记录,包括当时的上下文、考虑的选项、做的假设、预期的风险和收益。

- 季度组织一次“心智模型分享会”:团队成员分享自己在解决问题时常使用的思维框架。

3.2 持续演进:守夜人的心法修炼

成为优秀的混沌守夜人,不仅是工具和流程的更新,更是心智模式的重构。持续问自己三个问题,作为管理实践的指南针:

- 平衡之问:本周我是在强化秩序还是在拥抱混沌?两者间的平衡点是否需要调整?我是否因追求虚假的确定性而扼杀了重要的可能性?

- 真相之问:团队中是否存在被刻意回避或美化的现实问题?我是否创造了足够安全的空间,让“不完美但真实”的信息能够浮现?

- 意义之问:团队成员是否清楚他们正在忍受的混沌和挫折最终服务于什么更大价值?我是否有效地传递了这份意义,而不仅仅是分配了任务?

结语:在AI时代的技术管理中,最大的风险不是混乱本身,而是在混乱面前失去方向、失去韧性、失去勇气。作为混沌守夜人,你的核心价值不在于拥有所有答案,而在于能够在问题尚未完全清晰定义时就带领团队开始探索;不在于预防所有失败,而在于能够将每一次跌倒转化为下一次起跳的智慧。

当你的团队能够在秩序与混沌的辩证统一中自组织、自适应、自学习时,你就不仅是在管理一个团队——你是在培植一个能够与AI共同进化的有机智能体。这,才是技术管理者在AI时代真正的使命与荣光。

更多推荐

已为社区贡献129条内容

已为社区贡献129条内容

所有评论(0)