全谱系神经网络模型发展脉络

神经网络发展经历了从单模型突破到跨架构融合的递进过程,核心遵循"线性建模→循环时序建模→注意力并行建模→大模型融合建模"的技术主线。从1943年M-P神经元模型开始,历经感知机、RNN、LSTM等关键突破,最终在2017年迎来Transformer的革命性创新。Transformer融合注意力机制和前馈网络,实现全并行计算,彻底改变了神经网络的发展方向,开启了大模型时代。后续B

·

从人工神经元雏形到大模型时代的Transformer变体,神经网络的发展是单模型突破→衍生改进→跨架构融合的递进过程,核心遵循**“线性建模→循环时序建模→注意力并行建模→大模型融合建模”**的技术主线。

以下梳理从1940s至今所有核心模型,明确每个模型的前身(技术源头)+ 后继(衍生/改进模型),按时间顺序排列,同时标注核心创新+历史定位,让前身后继关系一目了然(覆盖你关注的RNN、LSTM、Transformer全溯源)。

核心说明

- 前身:指模型的核心技术源头/直接设计依据(如LSTM前身是RNN,指LSTM基于RNN的循环结构改进);

- 后继:指模型的直接衍生/改进/升级版本(如RNN后继是双向RNN+LSTM,指两者均基于RNN核心结构优化);

- 跨架构继承:部分模型无直接单前身,而是融合多个模型的核心思想(如Transformer融合“注意力机制+前馈网络”,标注为多源头融合);

- 时间节点:标注首次提出/落地实用的关键年份,部分模型后续有优化但以“首次突破”为准。

全谱系模型发展脉络(按时间排序,前身后继清晰标注)

第一阶段:人工神经元雏形(1943-1969)—— 神经网络的“细胞级”发明

1. 1943年:M-P神经元模型

- 前身:神经科学的生物神经元原理(人类神经元的“接收-整合-输出”模式);

- 后继:感知机、Adaline(所有人工神经网络的终极源头,无任何人工模型前置);

- 核心创新:首次用数学公式定义人工神经元,模拟“阈值激活”规则,实现基础逻辑运算(与/或/非);

- 历史定位:神经网络的起点,所有模型的“共同祖先”。

2. 1958年:感知机(Perceptron)

- 前身:M-P神经元模型(直接基于其阈值激活逻辑改进);

- 后继:Adaline、Madaline、单层线性神经网络;

- 核心创新:提出首个可训练的人工神经元,实现权重自动迭代更新,无需人工设定;

- 历史定位:从“理论神经元”到“可训练模型”的首次突破,解决简单线性二分类问题。

3. 1960s:Adaline/Madaline(自适应线性神经元/多线性神经元)

- 前身:感知机(继承其“权重训练”核心,替换激活函数);

- 后继:传统前馈神经网络(FNN)、线性回归神经网络;

- 核心创新:将阶跃激活改为线性激活,提出LMS最小均方误差算法,支持回归任务+多分类任务;

- 历史定位:前馈网络雏形,首次实现“多神经元前馈组合”,信息单向流动的核心特征确立。

4. 1960s:带延迟的感知机

- 前身:感知机+时序数据建模需求(为感知机增加时间延迟单元,无直接人工模型前身);

- 后继:霍普菲尔德网络、Elman/Jordan网络(现代RNN);

- 核心创新:首次为神经网络引入时间维度,让模型能参考历史输入,是时序建模的原始尝试;

- 历史定位:从“静态建模”到“动态时序建模”的第一个探索者。

第二阶段:传统前馈+早期循环雏形(1982-1986)—— 两大架构(FNN/RNN)正式奠基

5. 1982年:霍普菲尔德网络(Hopfield Network)

- 前身:带延迟的感知机+反馈机制(继承时序建模思路,引入“输出反馈到输入”的闭环结构);

- 后继:Elman/Jordan网络(现代RNN)、玻尔兹曼机;

- 核心创新:提出全连接反馈结构+能量函数,让模型具备“联想记忆”能力,是循环结构的核心灵感来源;

- 历史定位:非严格意义的RNN,但为后续RNN的循环连接思想提供了关键依据。

6. 1985年:玻尔兹曼机(Boltzmann Machine)

- 前身:霍普菲尔德网络+概率统计理论(继承反馈结构,引入概率分布处理噪声数据);

- 后继:受限玻尔兹曼机(RBM)、深度置信网络(DBN);

- 核心创新:引入隐变量,将神经元输出改为概率值,能处理带噪声的复杂数据;

- 历史定位:概率建模的突破,为后续RNN的“隐藏状态”提供设计灵感。

7. 1986年:传统前馈神经网络(FNN)+ BP反向传播算法

- 前身:Adaline/Madaline(继承前馈结构,引入隐藏层+非线性激活);

- 后继:卷积神经网络(CNN)、所有深度前馈网络(DFN);

- 核心创新:提出BP误差反向传播算法,引入隐藏层+非线性激活函数(Sigmoid),解决多层网络的训练问题;

- 历史定位:前馈网络正式成型,深度学习的“架构基石”,后续CNN/Transformer均包含前馈网络组件。

8. 1986年:Elman网络/Jordan网络

- 前身:霍普菲尔德网络+带延迟的感知机(融合反馈结构+时序建模,首次定义现代RNN的核心);

- 后继:双向RNN(BRNN)、LSTM、GRU(现代RNN的正式起点,后续所有循环模型均基于此);

- 核心创新:提出循环连接+隐藏状态,让模型能自动捕捉时序依赖,处理变长序列,无需人工设定延迟步数;

- 历史定位:现代RNN正式诞生,确立“隐藏状态为短期记忆”的核心设计逻辑。

第三阶段:循环时序建模黄金期(1997-2014)—— RNN家族的迭代与实用化

9. 1997年:双向RNN(BRNN)

- 前身:Elman/Jordan网络(标准RNN)(直接基于单向RNN改进,无其他源头);

- 后继:双向LSTM(Bi-LSTM)、双向GRU(Bi-GRU);

- 核心创新:提出正向+反向并行的双循环结构,让模型能捕捉双向上下文依赖(如文本的前文+后文);

- 历史定位:RNN的上下文能力增强版,为后续双向时序模型奠定结构基础。

10. 1997年:长短期记忆网络(LSTM)

- 前身:标准RNN(Elman网络)(继承循环结构+隐藏状态,解决其核心痛点);

- 后继:GRU、堆叠LSTM、LSTM+Attention;

- 核心创新:引入门控机制(遗忘/输入/输出门)+细胞状态,从根本上解决RNN的梯度消失/爆炸问题,实现长序列建模;

- 历史定位:RNN实用化的里程碑,让循环神经网络从“理论可行”走向“工业应用”,2010-2017年时序建模的绝对主流。

11. 2006年:卷积神经网络(CNN)—— 前馈网络的分支突破

- 前身:传统前馈神经网络(FNN)(继承前馈结构,改进连接方式);

- 后继:深度CNN(AlexNet/ResNet)、循环卷积网络(RCNN)、CNN+LSTM;

- 核心创新:提出局部连接+权值共享+池化,大幅减少参数数量,增强对图像/语音的变换鲁棒性(平移/旋转/缩放);

- 历史定位:前馈网络的核心变体,计算机视觉的“开山鼻祖”,与RNN形成“视觉/时序”两大架构分野。

12. 2014年:门控循环单元(GRU)

- 前身:LSTM(直接基于LSTM的门控机制简化,继承细胞状态的核心思想);

- 后继:双向GRU、GRU+Attention、轻量级时序模型;

- 核心创新:将LSTM的3个门简化为更新门+重置门,去掉独立细胞状态,参数减少1/3,训练速度大幅提升;

- 历史定位:LSTM的轻量化版本,低算力/实时场景的时序建模首选,性能与LSTM持平。

第四阶段:注意力机制崛起+Transformer范式革命(2015-2017)—— 从循环到并行的跨代突破

13. 2015年:RNN+Attention/LSTM+Attention

- 前身:LSTM/GRU + 注意力机制(机器翻译领域的原始注意力)(多源头融合,无单一前身);

- 后继:Transformer、注意力机制的全场景落地;

- 核心创新:为循环模型引入动态注意力权重,让模型能聚焦长序列的关键信息,解决LSTM/GRU的“记忆平均分配”问题;

- 历史定位:注意力机制与循环模型的首次融合,为Transformer的出现提供核心技术基础(注意力机制的工程验证)。

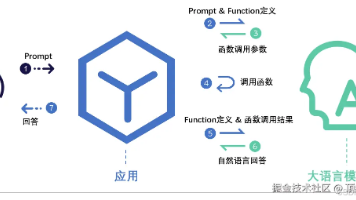

14. 2017年:Transformer—— 跨架构的范式革命

- 前身:RNN+Attention + 传统前馈神经网络(FNN)(多源头融合,无单一直接前身:继承注意力机制的“聚焦能力”,用FNN替代循环结构,实现全并行);

- 后继:BERT/GPT/Informer/Transformer-XL,所有大模型的共同核心;

- 核心创新:彻底抛弃循环结构,提出自注意力机制+位置编码+多头注意力,实现序列的全并行计算,完美解决长距离依赖,训练速度比LSTM提升一个数量级;

- 历史定位:神经网络的跨代突破,开启大模型时代,彻底取代RNN/LSTM的主流地位,成为NLP/时序/视觉等全场景的通用架构。

第五阶段:Transformer大模型时代(2018-至今)—— 变体迭代+跨架构融合

本阶段所有模型均以Transformer为核心前身,通过结构优化/多架构融合/规模扩张实现突破,分为NLP大模型、时序预测变体、跨模态融合模型三大分支,核心前身后继关系为Transformer→基础变体→大模型/融合模型。

15. 2018年:BERT/Transformer-XL/Informer(Transformer首批核心变体)

- 前身:Transformer(直接基于原始Transformer改进,无其他源头);

- 后继:ALBERT/RoBERTa(BERT变体)、Longformer(超长序列)、各类行业定制化Transformer;

- 核心创新:

- BERT:双向自注意力,解决原始Transformer的“单向编码”问题,成为NLP理解任务的基础;

- Transformer-XL:引入分段循环机制,支持超长序列建模;

- Informer:提出稀疏注意力,解决Transformer在时序预测中的“计算爆炸”问题;

- 历史定位:Transformer的场景化落地,让通用架构适配NLP/时序等具体任务。

16. 2018年:GPT-1/2(生成式Transformer)

- 前身:Transformer(继承解码器部分,采用单向自注意力);

- 后继:GPT-3/4/文心一言/通义千问(所有大语言模型);

- 核心创新:聚焦生成式任务,通过“预训练+微调”的范式,让模型具备文本生成能力;

- 历史定位:大语言模型(LLM)的起点,确立“预训练+微调”的大模型核心范式。

17. 2019-至今:大模型/融合模型(GPT-3/4、CLIP、CNN+Transformer、LSTM+Transformer)

- 前身:Transformer + 各传统架构(CNN/LSTM)/多模态数据(多源头融合,Transformer为核心);

- 后继:大模型微调/量化/轻量化版本(如GPT-Q、Llama);

- 核心创新:

- 大语言模型(GPT-3/4):千亿/万亿级参数规模,通过海量数据预训练实现“通用人工智能”雏形;

- 跨模态模型(CLIP/BLIP):融合Transformer与CNN,实现图像/文本/语音的跨模态理解;

- 混合时序模型(LSTM+Transformer/CNN+Transformer):取长补短,兼顾局部特征(CNN)、短期时序(LSTM)、长距离依赖(Transformer);

- 历史定位:神经网络的当前最高形态,从“单任务模型”走向“通用大模型”,实现全场景适配。

核心模型前身后继极简梳理(聚焦你关注的RNN/LSTM/Transformer)

1. RNN全溯源

M-P神经元→带延迟的感知机→霍普菲尔德网络→Elman/Jordan网络(现代RNN)→双向RNN/LSTM→GRU→LSTM+Attention→Transformer

- 核心:RNN的直接前身是霍普菲尔德网络,终极源头是M-P神经元;直接后继是双向RNN和LSTM,跨代后继是Transformer(继承其时序建模需求,用注意力替代循环)。

2. LSTM全溯源

M-P神经元→RNN(Elman)→LSTM→GRU→LSTM+Attention→Transformer

- 核心:LSTM的唯一直接前身是RNN,核心改进是门控机制,直接后继是GRU,跨代后继是Transformer。

3. Transformer全溯源

M-P神经元→FNN(前馈网络)+ RNN+Attention(注意力机制)→Transformer→所有大模型

- 核心:Transformer无单一直接前身,是多源头融合的产物(核心为注意力机制+传统前馈网络),其注意力机制的工程验证来自LSTM+Attention,时序建模需求继承自RNN/LSTM。

全脉络时间轴极简版(按技术阶段划分)

- 1943-1969:神经元雏形 → M-P神经元→感知机→带延迟的感知机

- 1982-1986:两大架构奠基 → 霍普菲尔德网络→玻尔兹曼机→FNN(BP算法)→Elman/Jordan网络(RNN)

- 1997-2014:循环+卷积双雄 → 双向RNN→LSTM→CNN→GRU

- 2015-2017:注意力崛起+范式革命 → LSTM+Attention→Transformer

- 2018-至今:大模型时代 → BERT/GPT→GPT-3/4→跨模态/混合模型

更多推荐

已为社区贡献125条内容

已为社区贡献125条内容

所有评论(0)