AI专栏 | Hello AI World, Hello LLM !

本文介绍了大型语言模型(LLM)的核心概念与应用。LLM通过自然语言交互方式降低了AI使用门槛,具备对话、信息提取、分类等多种能力。文章重点分析了LLM的关键能力维度,包括指令遵循、推理能力等,并提出了"拟人化协作"的使用理念。在选型方面,强调以业务场景驱动的实测表现为核心依据。最后通过Python代码示例演示了如何调用LLM接口,并简要回顾了AI发展历程。文章为开发者提供了L

AI专栏 | Hello AI World, Hello LLM !

难度系数:★☆☆☆☆

本章知识:

- AI与LLM

- LLM能做什么

- LLM重要能力 [重点 ★★★☆☆]

- 用好LLM [重点 ★★★★★]

- 如何选择LLM [重点 ★★★★★]

- Hello LLM [实战]

- AI发展史 [扩展]

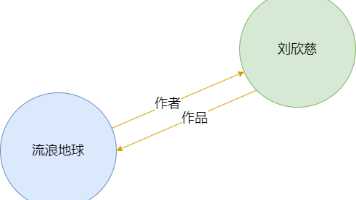

AI与LLM

今天大多数人谈论的 AI,本质上都是在使用 LLM。

LLM 让 AI 被普通群体熟知,核心不在于“第一次足够聪明”,而在于能力形态与交互方式的改变。

在 LLM 之前,AI 多为窄域智能,能力被封装在搜索、推荐、识别等系统内部,普通用户只能感知结果,无法直接接触“智能本身”。而 LLM 以自然语言作为通用接口,让任何人通过对话即可调用复杂能力,几乎没有学习成本。

同时,LLM 的智能是可见的、可评估的:它能直接生成完整文本、解释思路、模仿角色,这种表现高度贴近人类认知,极易形成震撼体验并被传播。

叠加云计算与算力基础设施成熟,LLM 成为第一个可规模化、可对话、可展示的表现出通用能力的 AI,因此真正进入大众视野。

LLM能做什么

对话

信息提取

分类

聚类

内容格式化

持续互动、上下文记忆

编码

…持续挖掘

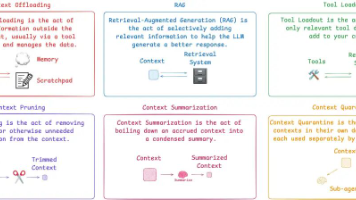

LLM重要能力

在AI应用开发时,影响LLM选型的重要能力包括:

| 能力维度 | 当人看 | 要求 | 影响内容 |

|---|---|---|---|

| 指令遵循 | 听懂并执行明确指令的能力(如助理理解老板的要求) | 必备能力 | 基础可用性 |

| 推理能力 | 逻辑思维与解决问题的能力(如分析师推导因果关系) | 核心能力 | 任务复杂度天花板 |

| 幻觉控制 | 诚实可靠、不说瞎话的品质(如专家只说有依据的事实) | 核心能力 | 上线可信度与事实风险 |

| 长上下文处理能力 | 良好的记忆力与信息整合能力(如律师阅读整份合同后总结要点) | 复杂任务增强能力 | 支持长文档、多轮深度交互 |

| 工具调用 | 会使用工具完成任务(如工程师调用计算器、查数据库) | Agent架构依赖能力 | 自动化与扩展性 |

| 成本与延迟 | 效率与性价比(如员工既快又省薪) | 商业可行性约束 | 可规模化程度 |

| 稳定性 | 可靠、不出错、情绪稳定(如资深员工始终如一地交付) | 生产环境底线要求 | 运维与SLA保障成本 |

用好LLM

核心思想:把AI当人看,拟人化协作思维,把LLM当作一位知识渊博、耐心细致、但需要明确指引的合作伙伴,而不是一个万能问答机。

- 用「当人看」来理解 AI

- 用「当人看」来控制 AI

- 用「当人看」来说服别人正确看待 AI 的不足

如何选择LLM

在 AI 应用开发中,应以业务场景驱动的实测表现为核心选型依据,而非依赖公开榜单。

具体做法:

- 明确业务场景:定义任务类型、输入输出格式、质量与性能要求;

- 制定评估标准:梳理“优秀回答”范例,建立可量化的评分维度(如准确性、安全性、流畅性);

- 构建测试集:基于真实数据构造覆盖典型、边界、困难案例的评测集;

- 多维度实测:通过自动化 demo 工程,在 zero-shot / few-shot 等不同 prompt 策略下,对候选模型进行打分;

- 综合决策:结合功能表现、推理成本、延迟、上下文长度、部署方式等,选择最优模型。

Hello LLM

开发语言: Python

工具支撑: pyenv、uv、openai-sdk

代码开源: https://gitcode.com/miasdz/ai-column-code.git

# pyenv

# https://github.com/pyenv/pyenv?tab=readme-ov-file#a-getting-pyenv

curl -fsSL https://pyenv.run | bash

# uv

# https://docs.astral.sh/uv/getting-started/installation/

curl -LsSf https://astral.sh/uv/install.sh | sh

# 安装python

pyenv install 3.10

# 创建项目目录

mkdir ai-column-code

# 创建环境

cd ai-column-code

pyenv local 3.10

# 创建虚拟环境

uv venv

# 初始化项目

uv init

# 安装依赖包

uv add openai

from openai import OpenAI

import configparser

# llm类型配置文件加载

llm_type_config_path = 'conf/llm.ini'

llm_type_config = configparser.ConfigParser()

llm_type_config.read(llm_type_config_path)

# llm server配置文件加载

llm_type = llm_type_config['llm']['server']

server_config_path = f"conf/server-{llm_type}.ini"

server_config = configparser.ConfigParser()

server_config.read(server_config_path)

# llm server配置读取

api_key = server_config["config"]['api-key']

base_url = server_config["config"]['base-url']

model = server_config["config"]['model']

# 核实配置文件正确性

print(llm_type, base_url)

# openai客户端初始化

client = OpenAI(

base_url=base_url,

api_key=api_key

)

# 对话消息

messages = [

{

"role": "system",

"content": "你是公众号[猿猿长成记]AI助手小猿,AI专栏计划每周更新一篇。"

},

{

"role": "user",

"content": "更新频率是什么?"

}

]

# 调用llm接口

chat_completion = client.chat.completions.create(

model=model,

messages=messages

)

# 输出llm输出结果

print(chat_completion.choices[0].message.content)

扩展:AI发展史

人工智能(Artificial Intelligence, AI)作为一个独立研究领域,于 1956 年由 John McCarthy 在达特茅斯会议中正式提出,其核心目标是研究和构建能够表现出人类智能行为的机器系统。早期 AI 研究主要采用符号主义方法,通过人工编写的规则、逻辑推理和搜索算法来实现智能行为,这一阶段的系统在结构化问题和受限规则空间中表现良好,但缺乏学习能力与泛化能力。

随着问题规模和复杂度的提升,研究者逐渐认识到仅依赖人工规则难以刻画真实世界的不确定性与多样性。1959 年,Arthur Samuel 首次提出‘机器学习(Machine Learning, ML)’这一术语,标志着研究范式开始从‘显式编程智能’向‘通过数据学习智能’转变。机器学习强调利用统计方法和优化算法,使模型能够从数据中自动学习规律,这一思想在 1990 年代至 2000 年代通过统计学习理论和大规模数据应用逐步成熟。

进入 2010 年代,**深度学习(Deep Learning)**在算力提升、大规模数据和神经网络结构创新的推动下取得突破,使模型能够自动学习多层次、高维度的特征表示。深度学习显著提升了语音识别、计算机视觉和自然语言处理等感知任务的性能,为更通用的智能系统奠定了基础。

在此背景下,大型语言模型(Large Language Models, LLM)于 2018年前后 逐渐形成。LLM 以深度神经网络(尤其是 Transformer 架构)为基础,通过大规模自监督预训练学习语言的统计规律与语义表示,并展现出强大的跨任务泛化能力。与早期针对特定任务设计的模型不同,LLM 以自然语言为统一接口,能够灵活支持文本生成、逻辑推理、多轮对话及多种复杂任务的协同执行。

总体而言,AI → ML → LLM 的演进体现了人工智能研究从“规则驱动”向“数据驱动”,再向“表征与泛化驱动”的范式转变。LLM 并非人工智能的最终形态,而是机器学习与深度学习发展到特定阶段后所形成的一种通用任务模型形态,代表了当前人工智能在通用性与可扩展性方面的重要进展。

关注本专栏,让我们一起掌握方法、实践落地、共同发展。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)