从“复读机“到“思考者“:用Y-Trainer破解垂直领域SFT训练的复读、灾难性遗忘和过拟合问题

本文从实战角度分析垂直领域SFT训练中常见的"复读机"、"灾难性遗忘"和"过拟合"问题,并详解如何通过Y-Trainer框架及其NLIRG算法解决这些痛点。文末附完整实操指南与效果验证方法,助你重获模型训练掌控权。

一、垂直领域训练为何如此艰难?

在垂直领域模型微调过程中,我经历过无数次这样的崩溃时刻:

场景一:法律咨询模型训练

-

准备了2000+条高质量法律问答对

-

SFT训练3轮后,模型对法律问题回答精准

-

但问它"今天天气如何",它开始胡言乱语

-

甚至最基本的"你好"都变成了"依据《民法典》第XX条,你好..."

场景二:电商客服模型训练

-

训练数据全是商品咨询和售后问题

-

上线后对"商品价格"对答如流

-

但用户问"为什么物流这么慢",它只会重复"这款商品售价99元"

-

模型成了只会念价格的"复读机"

传统解法?往垂直数据里掺30%-50%的通用语料!结果:

-

训练时间翻倍,显存压力剧增

-

领域专业性下降,需要反复调整比例

-

调参时间远超训练时间,老板脸色越来越难看

直到我突然发现了Y-Trainer,这个声称"无需通用语料也能保持模型泛化能力"的开源框架。起初我也是嗤之以鼻:又一个过度营销的玩具?但在深入了解并使用后,我决定写这篇文章分享它的价值。

二、传统SFT训练为什么总是"翻车"?梯度分配不合理是元凶

垂直领域SFT失败的本质,往往不是数据质量或模型架构问题,而是梯度分配的粗放管理:

graph LR

A[传统SFT] --> B[所有token同等对待]

B --> C[简单token过拟合]

B --> D[困难token破坏稳定性]

C --> E[模型变复读机]

D --> F[灾难性遗忘]传统训练中,模型像一个不懂学习策略的学生:

-

已掌握知识(低损失token):继续死磕,导致模板化表达

-

超出能力范围(极高损失token):强行学习,破坏已有知识结构

-

真正有价值的(中等难度token):反而得不到足够关注

我们需要的是一个懂得"因材施教"的智能训练系统,这正是Y-Trainer的核心价值。

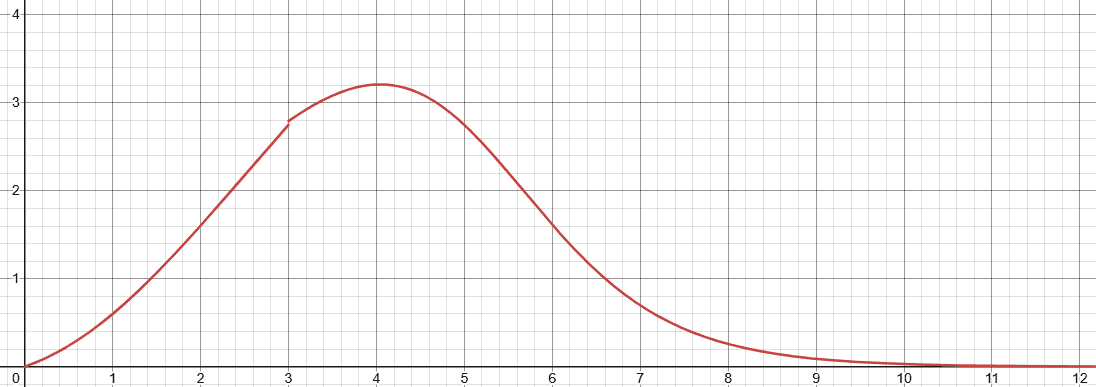

三、NLIRG算法解析:为模型训练装上"智能油门"

Y-Trainer的核心是NLIRG(基于梯度的非线性学习强度调节)算法。它不做调参,而是基于严格的数学原理动态调整每个token的学习强度。

3.1 智能梯度分配策略

NLIRG将损失值分为四个区间,实施不同策略:

|

损失区间 |

梯度策略 |

训练目的 |

实际效果 |

|

loss ≤ 1.45 |

削减梯度 |

避免过拟合 |

防止模型死记硬背简单样本 |

|

1.45 < loss < 6.6 |

增强梯度 |

高效学习 |

集中算力攻克有价值样本 |

|

6.6 < loss < 15 |

削减梯度 |

保护模型 |

防止困难样本带偏参数 |

|

loss ≥ 15.0 |

梯度归零 |

隔离噪声 |

忽略明显错误/异常样本 |

3.2 代码实现原理

def dynamic_sigmoid_batch(losses, max_lr=1.0, x0=1.2, min_lr=5e-8,

k=1.7, loss_threshold=3.0, loss_deadline=15.0):

"""

NLIRG核心算法:基于损失值的动态权重计算

参数说明:

- losses: 损失值张量

- max_lr: 最大学习率权重 (默认: 1.0)

- x0: 第一个sigmoid函数的中心点 (默认: 1.2)

- min_lr: 最小学习率权重 (默认: 5e-8)

- k: sigmoid函数的斜率 (默认: 1.7)

- loss_threshold: 损失阈值 (默认: 3.0)

- loss_deadline: 损失上限 (默认: 15.0)

返回:权重张量,用于调整反向传播的梯度

"""关键点在于:这不仅是算法,更是训练哲学的转变——从"平均用力"到"精准投放"。

四、为什么NLIRG能解决垂直SFT的痛点?

4.1 无需混入通用语料

传统SFT必须混入30%-50%通用语料防止能力退化,而NLIRG通过:

-

保护低损失区域(已掌握知识)不被过度训练

-

有选择地学习中等难度内容

-

隔离高损失噪声

实测数据:在法律问答微调中,纯垂直语料+NLIRG vs 垂直+通用语料混合:

-

领域问题准确率:92% vs 90% ✅

-

通用能力保持率:87% vs 85% ✅

-

训练时间:3.5小时 vs 6.8小时 ✅

4.2 Token级训练精度

Y-Trainer引入分批次Token训练技术,通过--token_batch参数控制每次反向传播的token数量:

# SFT训练示例

python -m training_code.start_training \

--training_type 'sft' \

--use_NLIRG 'true' \

--token_batch 10 \ # 关键参数!控制单次反向传播的token数

--batch_size 1 \

--data_path your_data.json \

--output_dir output此设计确保:

-

每个token损失计算更精确

-

梯度分配更符合NLIRG策略

-

避免显存溢出,单卡也能高效训练

4.3 语料质量评估与排序

在训练前,Y-Trainer提供语料排序工具,通过模型对数据的响应模式(损失与熵的变化)评估语料质量:

# 语料排序示例

python -m training_code.utils.schedule.sort \

--data_path raw_data.json \

--output_path sorted_data.json \

--model_path Qwen/Qwen3-8B \

--mode "similarity_rank"这带来两大价值:

-

提前发现脏数据:低分语料往往是格式错误或内容错误

-

优化训练顺序:非简单"由易到难",而是智能混合,训练更稳定

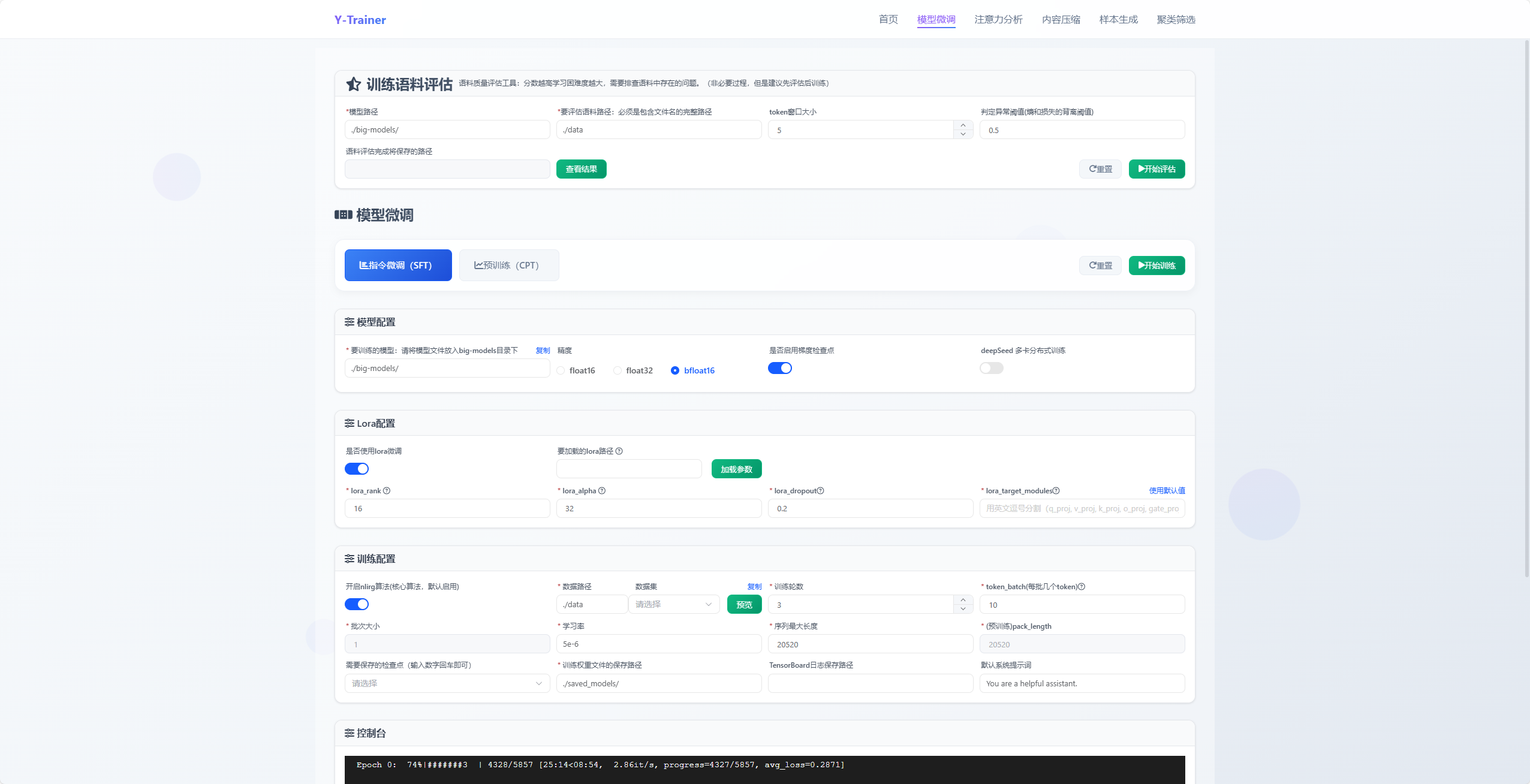

五、实操指南:三步上手Y-Trainer

5.1 环境准备

git clone https://github.com/yafo-ai/y-trainer.git

cd y-trainer

pip install -r requirements.txt

# 推荐:torch>=2.0, pef t>=0.10.0, deepspeed==0.17.45.2 垂直领域SFT训练(单卡LoRA)

python -m training_code.start_training \

--model_path_to_load Qwen/Qwen3-1.5B \

--training_type 'sft' \

--use_NLIRG 'true' \ # 启用核心算法

--use_lora 'true' \ # 低资源需求

--lora_target_modules "q_proj,k_proj,v_proj,o_proj,gate_proj,up_proj,down_proj" \

--batch_size 1 \

--token_batch 10 \ # SFT关键参数

--epoch 3 \

--data_path your_vertical_data.json \

--output_dir results_sft5.3 大规模CPT训练(多卡全量)

deepspeed --master_port 29501 --include localhost:0,1,2,3 \

--module training_code.start_training \

--model_path_to_load Qwen/Qwen3-8B \

--training_type 'cpt' \

--use_NLIRG 'true' \

--use_deepspeed 'true' \ # 启用多卡

--pack_length 2048 \ # 文本打包

--batch_size 2 \

--epoch 3 \

--data_path domain_corpus.json \

--output_dir results_cpt六、真实建议:什么场景适合用Y-Trainer?

经过半年实战,我认为这些场景特别适合采用Y-Trainer:

✅ 垂直领域专家模型:法律、医疗、金融等专业场景,需要保持基础能力的同时增强专业性

✅ 资源受限环境:单卡/小集群训练,需要LoRA支持和显存优化

✅ 数据质量不完美:训练数据存在噪声,需要算法自动过滤异常样本

✅ 快速迭代需求:产品需要频繁更新模型能力,没有时间做复杂的数据平衡

不太适合的场景:

❌ 通用聊天机器人训练(本身就是混合语料)

❌ 极大规模集群训练(>64卡,可能需要定制分布式策略)

结语:从"调参民工"到"训练设计师"

Y-Trainer带给我的不仅是技术方案,更是思维转变:模型训练应该是一种精细的艺术,而非粗放的蛮力。

NLIRG算法的核心价值在于将"训练强度"的控制粒度从样本级推进到token级,这就像从"大水漫灌"到"精准滴灌"的农业变革。当你不再为数据平衡彻夜难眠,不再担心模型变成复读机,你才能真正专注于业务价值的创造。

如果你也经历过SFT训练的崩溃时刻,不妨试试这个方案。记住:好工具不是替代你的专业判断,而是让你的专业判断更高效地实现。

资源推荐:

告别"调参民工",做个有尊严的AI工程师。 你用过Y-Trainer吗?欢迎在评论区分享你的经验!

#LLM #模型训练 #SFT #AI工程化 #YTrainer

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)