AI智能体“浮光行为”深度解析:机制、挑战与工程边界

摘要:本文探讨了大语言模型智能体(Agent)在复杂任务中出现的"浮光行为"(Glimmer Behavior)现象,即智能体在长期运行或多步推理时产生的短暂不合理决策。研究从Transformer注意力机制底层原理出发,揭示了这种现象源于注意力熵异常和KVCache噪声累积,表现为高置信度但缺乏逻辑支撑的瞬时决策。文章分析了浮光行为对AI系统稳定性的危害,并提出了动态注意力剪

摘要 (Abstract)

随着大语言模型(LLM)向智能体(Agent)形态的演进,开发者在处理复杂任务流时发现了一种特殊的现象:智能体在长期运行或多步推理中,偶尔会出现看似合理但缺乏底层逻辑支撑的瞬时决策,随后又迅速修正或彻底迷失。这种现象在工程界被称为**“浮光行为”(Glimmer Behavior / Floating Light Phenomenon)**。本文将从Transformer注意力机制的底层原理出发,剖析“浮光行为”的成因,探讨其对Agent稳定性的影响,并提供基于RAG和CoT(思维链)优化的工程解决方案。

1. 什么是AI智能体的“浮光行为”?

在构建Autonomous Agents(自主智能体)的过程中,我们定义**“浮光行为”**是指:智能体在执行连续决策任务时,注意力权重(Attention Weights)在非关键特征上产生的瞬时高响应,导致智能体产生短暂的幻觉式推理或路径偏离,如同水面浮光,虽有亮度但无深度。

与传统的“幻觉”(Hallucination)不同,“浮光行为”具有以下特征:

-

瞬时性(Transient): 它往往发生在中间推理步骤,可能被后续步骤自我修正,也可能导致蝴蝶效应。

-

高置信度伪装(High Confidence Camouflage): 智能体对该步骤的Logits输出通常表现出较高的置信度。

-

上下文敏感(Context-Sensitive): 通常由长上下文窗口中的噪声(Noise)引发。

1.1 现象示例

在一个自动化代码Review Agent中,智能体突然针对一行毫无错误的注释进行了长篇大论的“优化建议”,但在下一轮对话中又完全忽略了这个问题。这种对无关信息的过度聚焦,即典型的“浮光行为”。

2. 技术原理:从数学角度看“浮光”

要理解这一行为,我们需要回到Transformer架构的核心——注意力机制。

2.1 注意力熵(Attention Entropy)的坍塌

标准的自注意力机制计算如下:

$$Attention(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V$$

当Context Window(上下文窗口)随着Agent的历史记忆不断增长时,$K$(Key)矩阵变得极度稀疏。“浮光行为”的本质是注意力分布的熵值异常。

当模型在处理模糊指令时,无法通过强相关的 $Q \cdot K^T$ 锁定关键信息,Softmax函数会将概率强行分配给局部出现的、但在语义上微弱相关的Token。这在数学上表现为注意力矩阵中的**“幽灵激活”(Ghost Activation)**。

2.2 KV Cache 中的噪声累积

在Multi-Agent系统中,由于多轮对话的累积,KV Cache中存储了大量非结构化噪声。

$$H_t = f(H_{t-1}, x_t) + \epsilon_{noise}$$

随着 $t$ 的增加,如果不进行有效的记忆剪枝(Memory Pruning),$\epsilon_{noise}$ 会在某些特定维度的嵌入空间中形成“伪特征”,诱导Agent将其误判为关键指令,从而产生“浮光”。

3. “浮光行为”的工程危害

在企业级AI应用中,忽视这一现象会导致严重后果:

-

任务死循环(Loop of Death): Agent在两个错误的中间状态反复横跳。

-

资源浪费(Token Consumption): 为解释一个错误的“浮光”决策,Agent会消耗大量Token进行辩解。

-

安全对齐失效: 极端的浮光行为可能绕过系统的Prompt Injection防御层。

4. 解决方案与工程实践

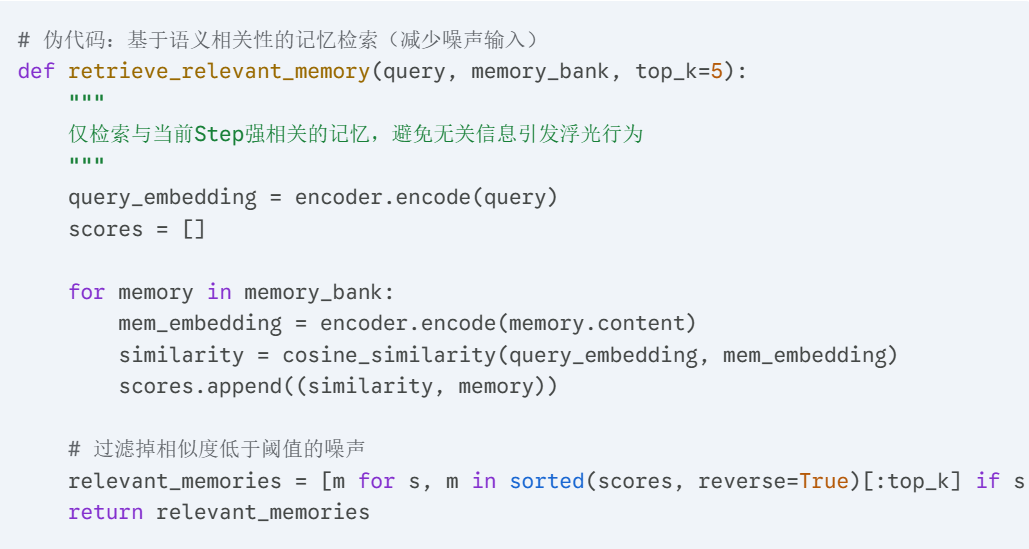

为了抑制“浮光行为”,提升Agent的鲁棒性,建议采用以下三种策略:

4.1 动态注意力剪枝(Dynamic Attention Pruning)

不要将所有历史记录无差别地塞入Context。使用滑动窗口或关键信息摘要技术。

4.2 结构化思维链(Structured CoT)

强制Agent在行动前输出明确的推理路径,并引入**Critic Agent(批评者智能体)**进行校验。如果推理步骤中出现逻辑跳跃(即浮光点),Critic应立即打断并重置。

-

架构设计: Actor-Critic Loop

-

提示词策略: "Before taking action, explain logically why this specific context is relevant."

4.3 引入不确定性量化(Uncertainty Quantification)

在Agent输出决策时,监控其Token的Perplexity(困惑度)。

$$PPL(X) = \exp \left( -\frac{1}{t} \sum_{i=1}^{t} \log P(x_i | x_{<i}) \right)$$

如果某一步骤的PPL突然异常升高或方差过大,系统应识别为潜在的“浮光行为”,并强制Agent回退(Rollback)到上一步状态。

5. 总结与展望

“浮光行为”是LLM向AGI迈进过程中,因模型对长尾分布(Long-tail distribution)数据处理能力的局限而产生的必然现象。它既是挑战,也是优化模型架构的契机。

未来的Agent架构将不再单纯依赖更大的上下文窗口,而是转向**更高效的显式记忆管理(Explicit Memory Management)和元认知(Metacognition)**能力,让智能体不仅“知道”,还能“知道自己是否在胡思乱想”。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)